Modelos de clasificación de la biblioteca Scikit-learn y su exportación a ONNX

El desarrollo de la tecnología ha llevado al surgimiento de un enfoque fundamentalmente nuevo para la construcción de algoritmos de procesamiento de datos. Antes, resolver cada problema individual requería una formalización clara y el desarrollo de los algoritmos correspondientes.

En el aprendizaje automático, la propia computadora aprende a encontrar las mejores formas de procesar datos. Los modelos de aprendizaje automático son capaces de resolver con éxito problemas de clasificación (hay un conjunto fijo de clases, y debemos encontrar la probabilidad de que un conjunto dado de características pertenezca a cada clase) y de regresión (para un conjunto dado de características, debemos estimar el valor numérico de la variable objetivo). A partir de estos vínculos básicos, podemos construir modelos de procesamiento de datos más complejos.

Existen muchas herramientas disponibles en la biblioteca Scikit-learn tanto para clasificación como para regresión. La elección de métodos y modelos específicos depende de las características de los datos, ya que diferentes métodos pueden tener diferente eficiencia y ofrecer resultados distintos según la tarea.

En el comunicado de prensa "ONNX Runtime is now open source" se afirma que ONNX Runtime también ofrece soporte al perfil ONNX-ML:

El perfil ONNX-ML es una parte de ONNX creada específicamente para modelos de aprendizaje automático (ML). Está diseñado para describir y representar varios tipos de modelos de ML, como la clasificación, la regresión, la clusterización y otros en una forma cómoda que se pueda usar en diversas plataformas y entornos compatibles con ONNX. El perfil ONNX-ML facilita la comunicación, implementación y ejecución de modelos de aprendizaje automático, haciendo estos más accesibles y portátiles.

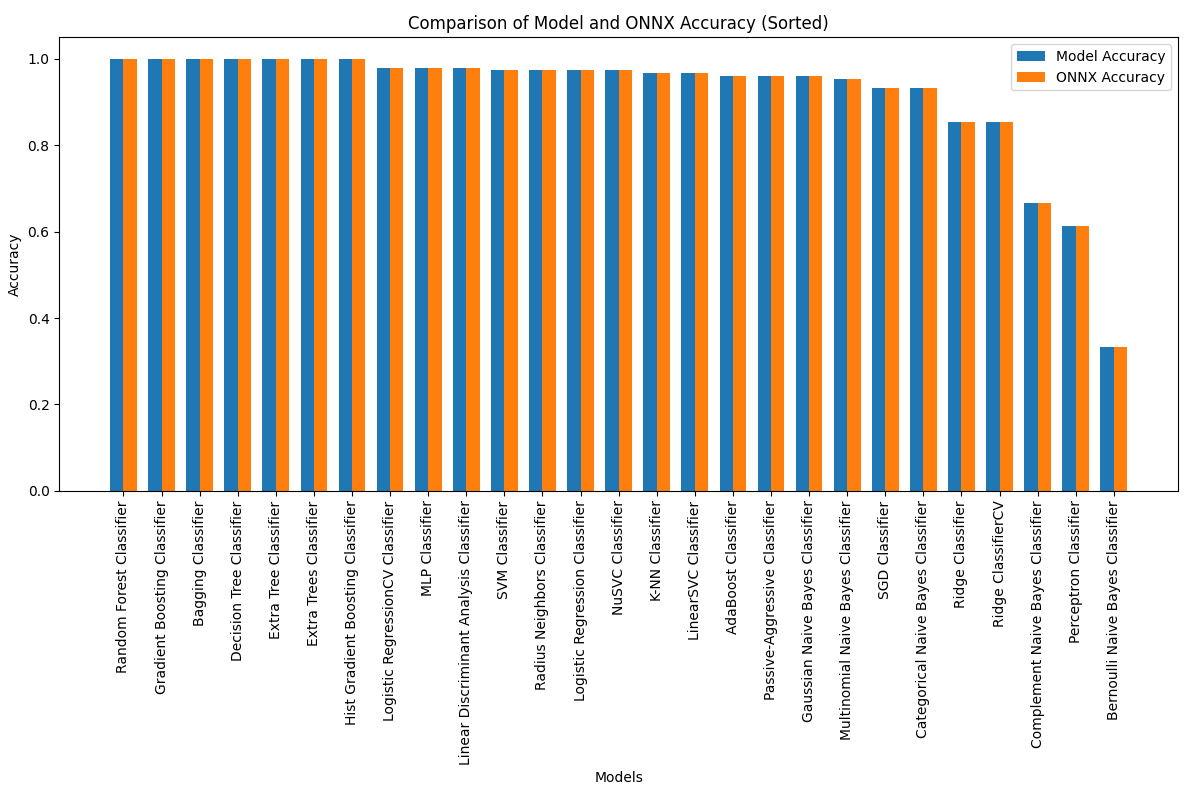

En este artículo, analizaremos el uso de todos los modelos de clasificación del paquete Scikit-learn para resolver el problema de la clasificación de los iris de Fisher; asimismo, intentaremos convertir estos al formato ONNX y usar los modelos resultantes en programas MQL5.

También compararemos la precisión de los modelos originales y sus versiones ONNX en el conjunto de datos completo Iris dataset.

Contenido

- 1. Iris de Fisher

- 2. Modelos para la clasificación.

Lista de clasificadores del paquete Scikit-learn

Representación distinta de los datos de salida para los modelos iris.mqh - 2.1. SVC Classifier

2.1.1. Código de creación del modelo SVC Classifier

2.1.2. Código MQL5 para trabajar con el modelo SVC Classifier

2.1.3. Representación ONNX del modelo SVC Classifier - 2.2. LinearSVC Classifier

2.2.1. Código de creación del modelo LinearSVC Classifier

2.2.2. Código MQL5 para trabajar con el modelo LinearSVC Classifier

2.2.3. Representación ONNX del modelo LinearSVC Classifier - 2.3. NuSVC Classifier

2.3.1. Código de creación del modelo NuSVC Classifier

2.3.2. Código MQL5 para trabajar con el modelo NuSVC Classifier

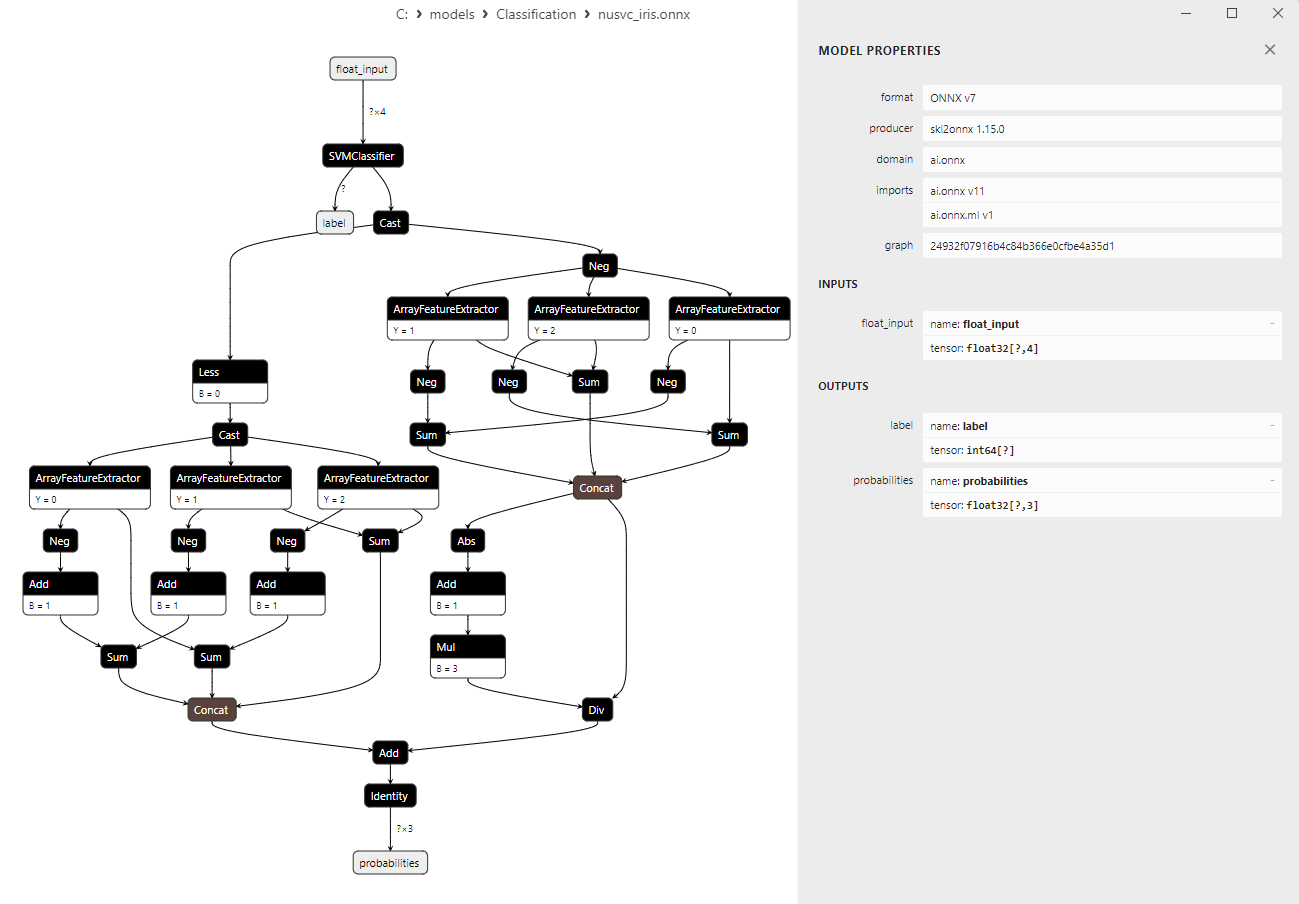

2.3.3. Representación ONNX del modelo NuSVC Classifier - 2.4. Radius Neighbors Classifier

2.4.1. Código de creación del modelo Radius Neighbors Classifier

2.4.2. Código MQL5 para trabajar con el modelo Radius Neighbors Classifier

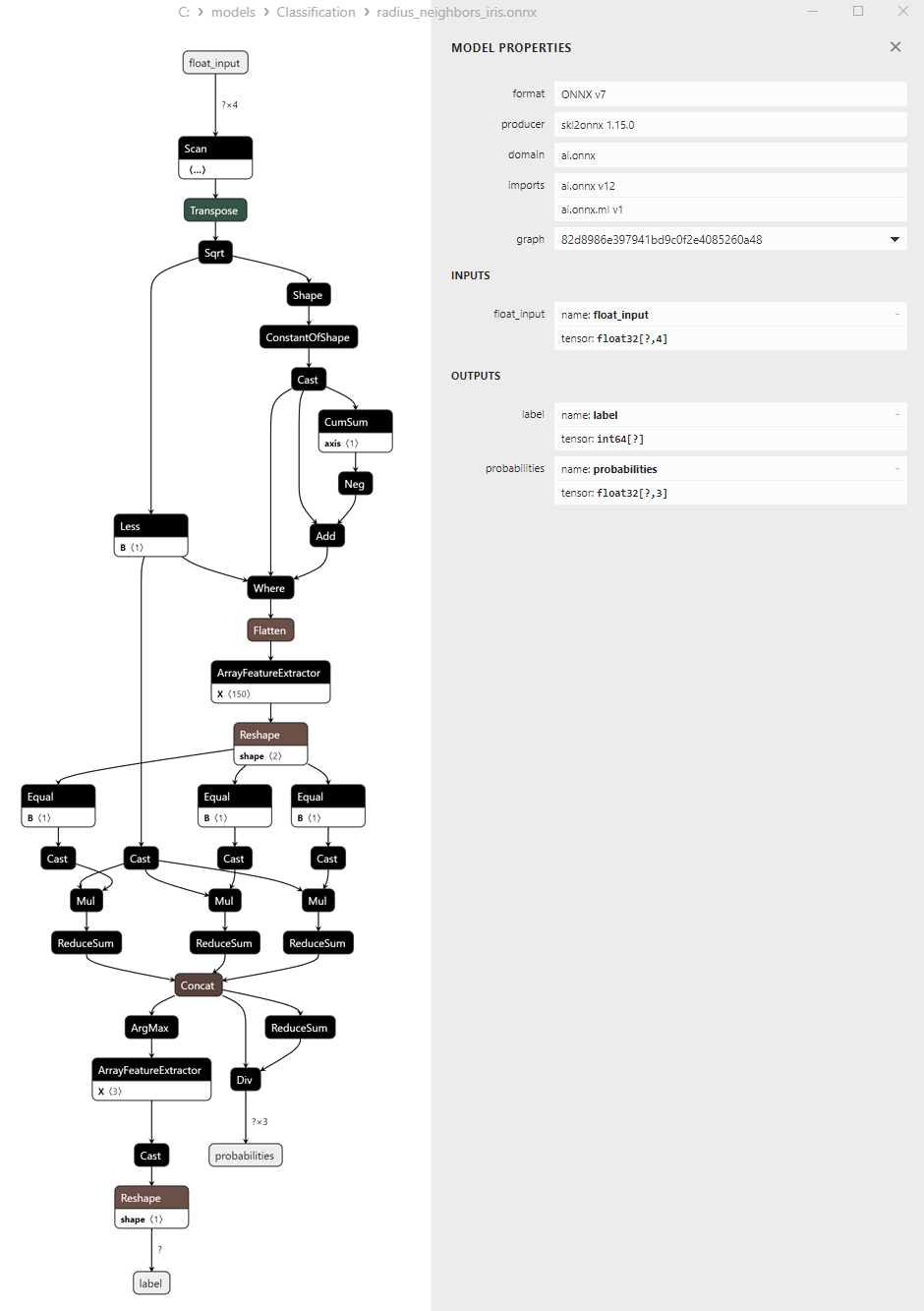

2.3.3. Representación ONNX del modelo NuSVC Classifier - 2.5. Ridge Classifier

2.5.1. Código de creación del modelo Ridge Classifier

2.5.2. Código MQL5 para trabajar con el modelo Ridge Classifier

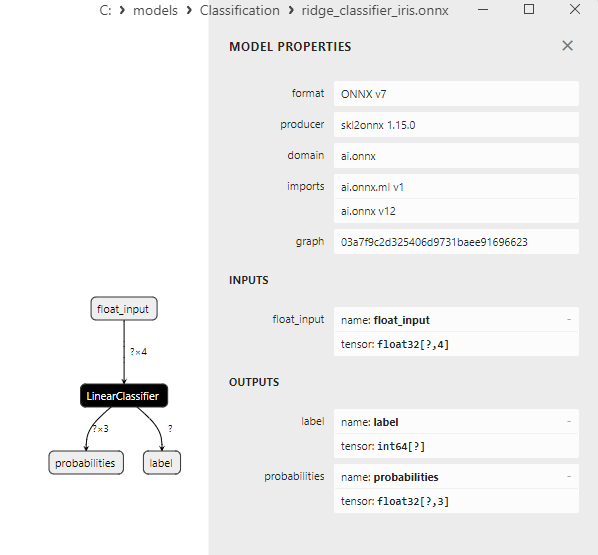

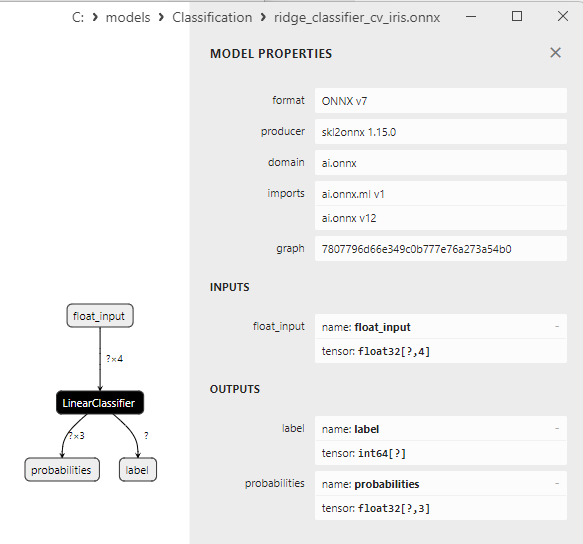

2.5.3. Representación ONNX del modelo Ridge Classifier - 2.6. RidgeClassifierCV

2.6.1. Código de creación del modelo RidgeClassifierCV

2.6.2. Código MQL5 para trabajar con el modelo RidgeClassifierCV

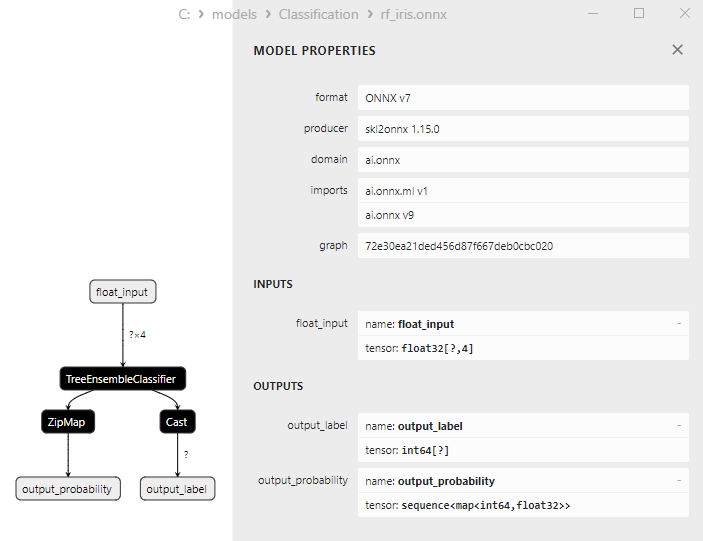

2.6.3. Representación ONNX del modelo RidgeClassifierCV - 2.7. Random Forest Classifier

2.7.1. Código de creación del modelo Random Forest Classifier

2.7.2. Código MQL5 para trabajar con el modelo Random Forest Classifier

2.7.3. Representación ONNX del modelo Random Forest Classifier - 2.8. Gradient Boosting Classifier

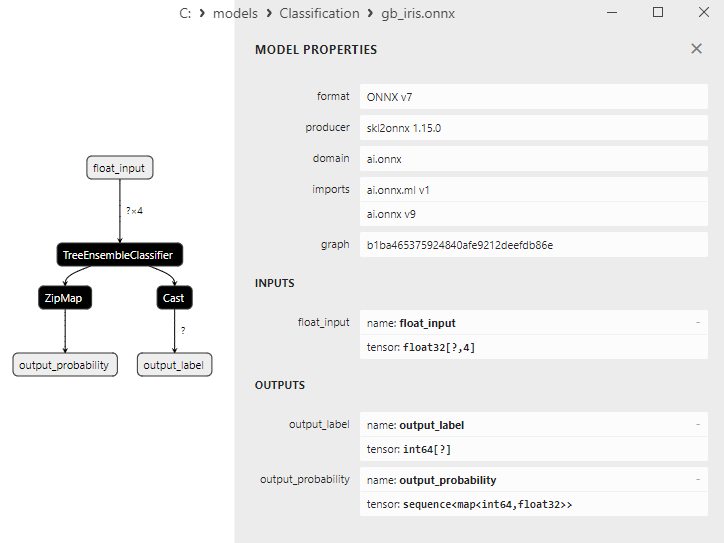

2.8.1. Código de creación del modelo Gradient Boosting Classifier

2.8.2. Código MQL5 para trabajar con el modelo Gradient Boosting Classifier

2.8.3. Representación ONNX del modelo Gradient Boosting Classifier - 2.9. Adaptive Boosting Classifier

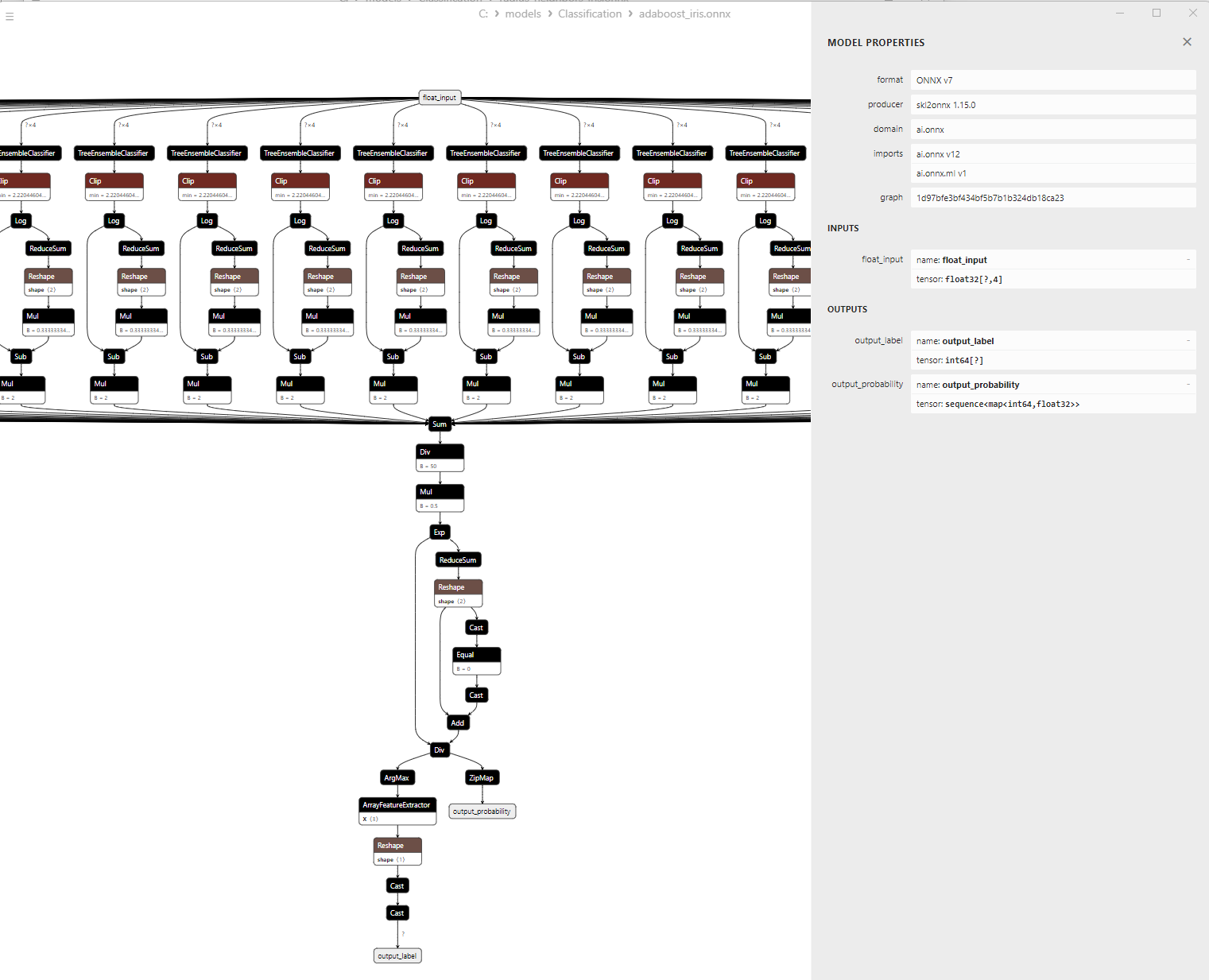

2.9.1. Código de creación del modelo Adaptive Boosting Classifier

2.9.2. Código MQL5 para trabajar con el modelo Adaptive Boosting Classifier

2.9.3. Representación ONNX del modelo Adaptive Boosting Classifier - 2.10. Bootstrap Aggregating Classifier

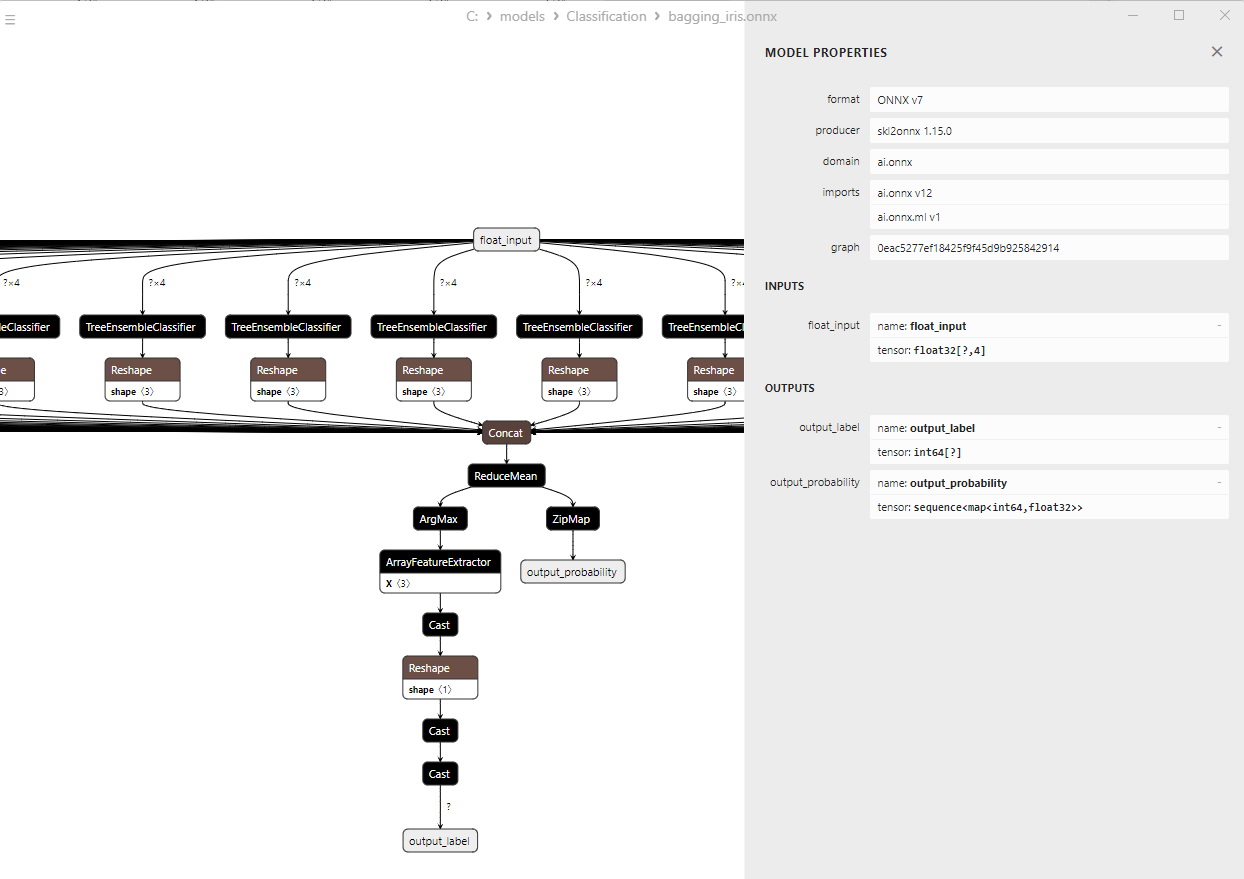

2.10.1. Código de creación del modelo Bootstrap Aggregating Classifier

2.10.2. Código MQL5 para trabajar con el modelo Bootstrap Aggregating Classifier

2.10.3. Representación ONNX del modelo Bootstrap Aggregating Classifier - 2.11. K-Nearest Neighbors (K-NN) Classifier

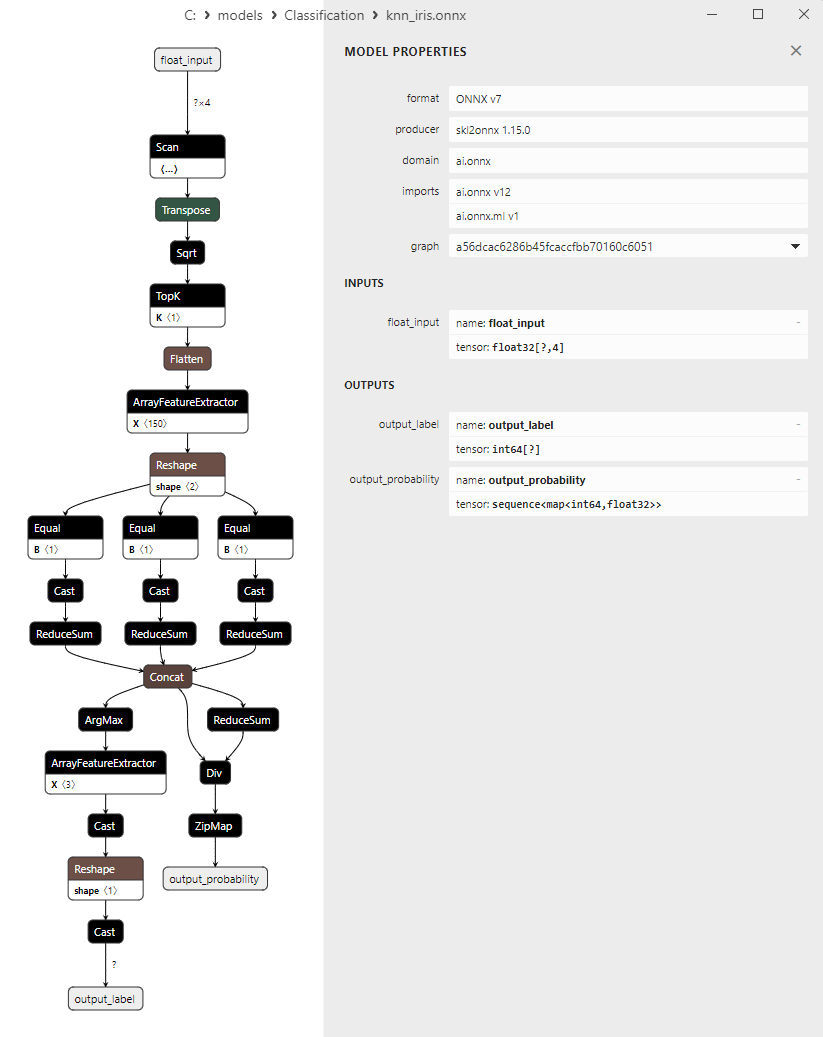

2.11.1. Código de creación del modelo K-Nearest Neighbors (K-NN) Classifier

2.11.2. Código MQL5 para trabajar con el modelo K-Nearest Neighbors (K-NN) Classifier

2.11.3. Representación ONNX del modelo K-Nearest Neighbors (K-NN) Classifier - 2.12. Decision Tree Classifier<

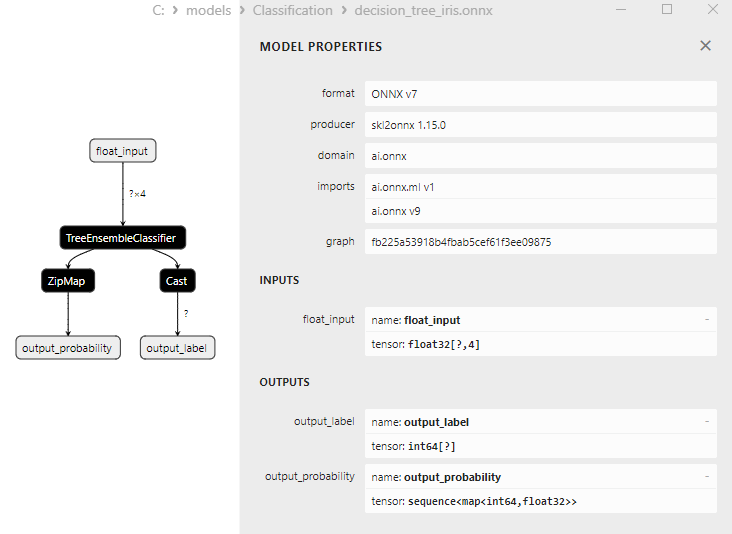

2.12.1. Código de creación del modelo Decision Tree Classifier

2.12.2. Código MQL5 para trabajar con el modelo Decision Tree Classifier

2.12.3. Representación ONNX del modelo Decision Tree Classifier - 2.13. Logistic Regression Classifier

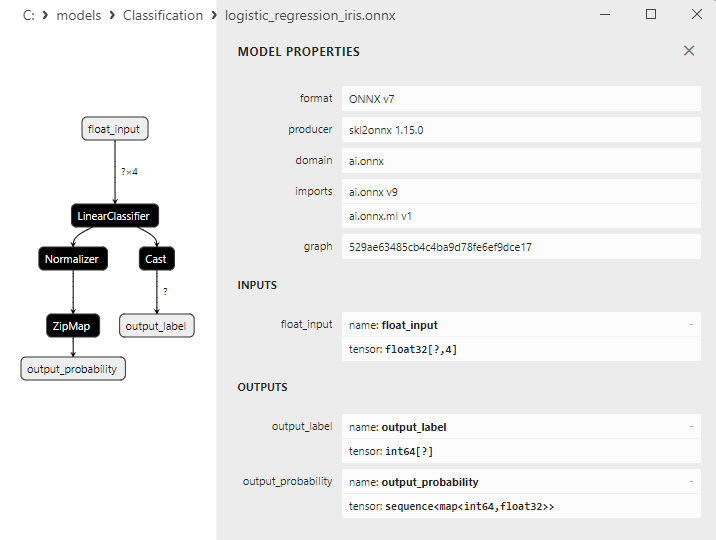

2.13.1. Código de creación del modelo Logistic Regression Classifier

2.13.2. Código MQL5 para trabajar con el modelo Logistic Regression Classifier

2.13.3. Representación ONNX del modelo Logistic Regression Classifier - 2.14. LogisticRegressionCV Classifier

2.14.1. Código de creación del modelo LogisticRegressionCV Classifier

2.14.2. Código MQL5 para trabajar con el modelo LogisticRegressionCV Classifier

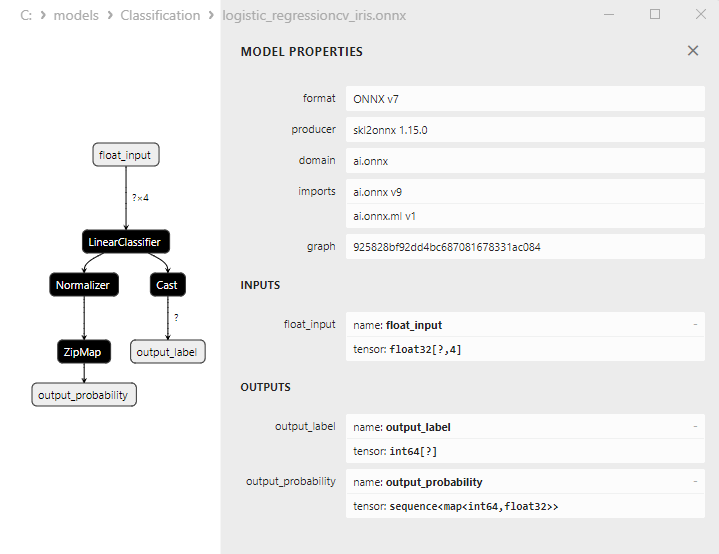

2.14.3. Representación ONNX del modelo LogisticRegressionCV Classifier - 2.15. Passive-Aggressive (PA) Classifier

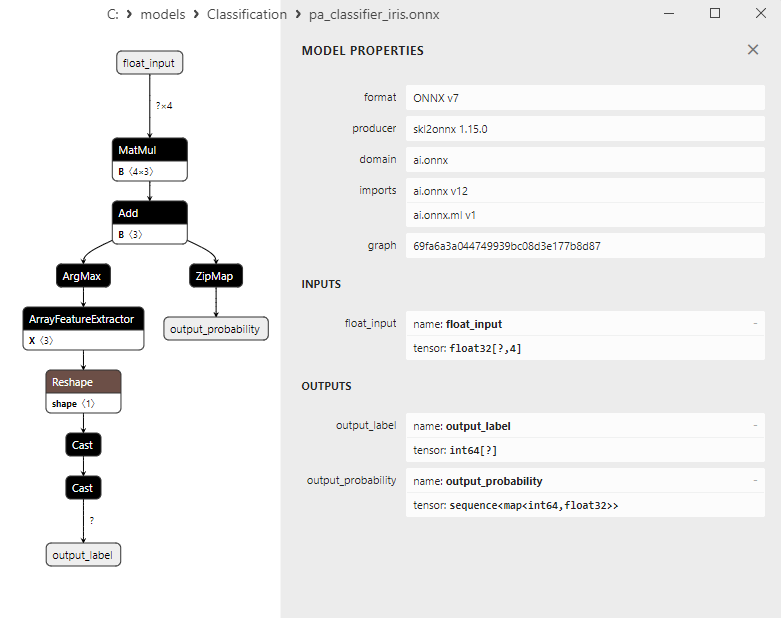

2.15.1. Código de creación del modelo Passive-Aggressive (PA) Classifier

2.15.2. Código MQL5 para trabajar con el modelo Passive-Aggressive (PA) Classifier

2.15.3. Representación ONNX del modelo Passive-Aggressive (PA) Classifier - 2.16. Perceptron Classifier

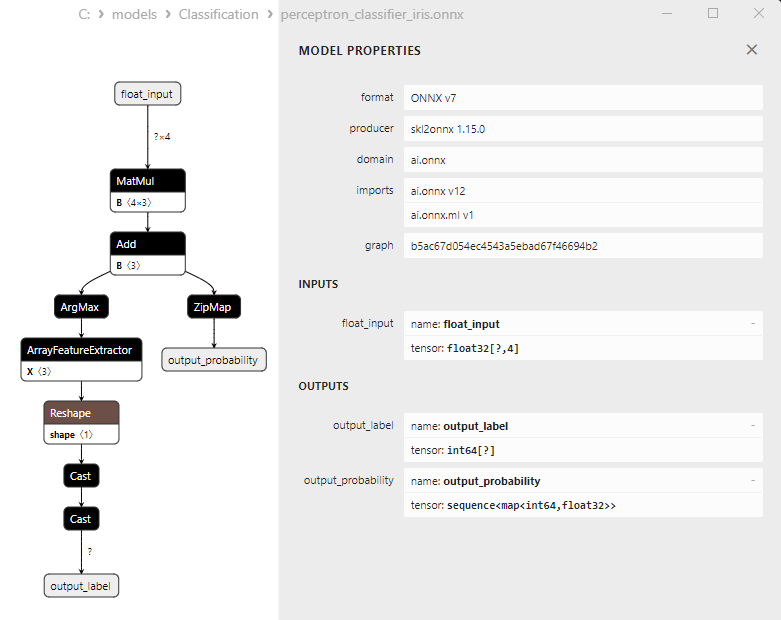

2.16.1. Código de creación del modelo Perceptron Classifier

2.16.2. Código MQL5 para trabajar con el modelo Perceptron Classifier

2.16.3. Representación ONNX del modelo Perceptron Classifier - 2.17. Stochastic Gradient Descent Classifier

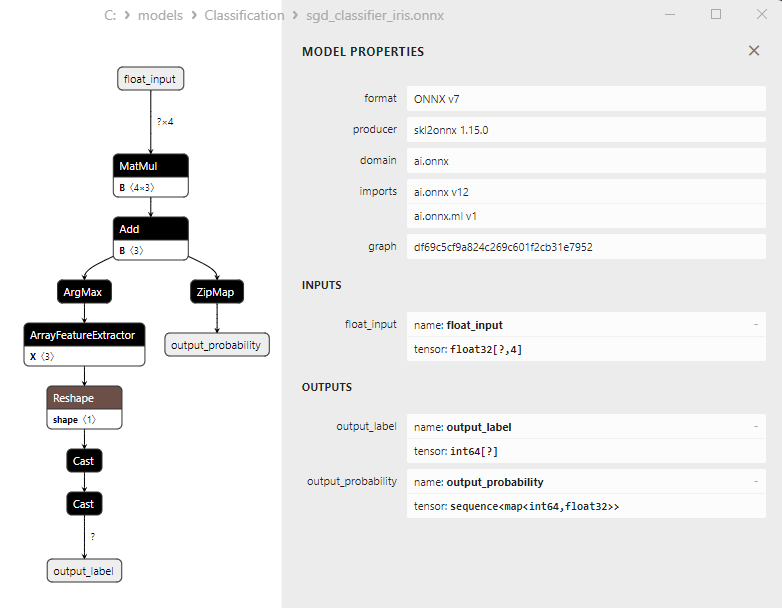

2.17.1. Código de creación del modelo Stochastic Gradient Descent Classifier

2.17.2. Código MQL5 para trabajar con el modelo Stochastic Gradient Descent Classifier

2.17.3. Representación ONNX del modelo Stochastic Gradient Descent Classifier - 2.18. Gaussian Naive Bayes (GNB) Classifier

2.18.1. Código de creación del modelo Gaussian Naive Bayes (GNB) Classifier

2.18.2. Código MQL5 para trabajar con el modelo Gaussian Naive Bayes (GNB) Classifier

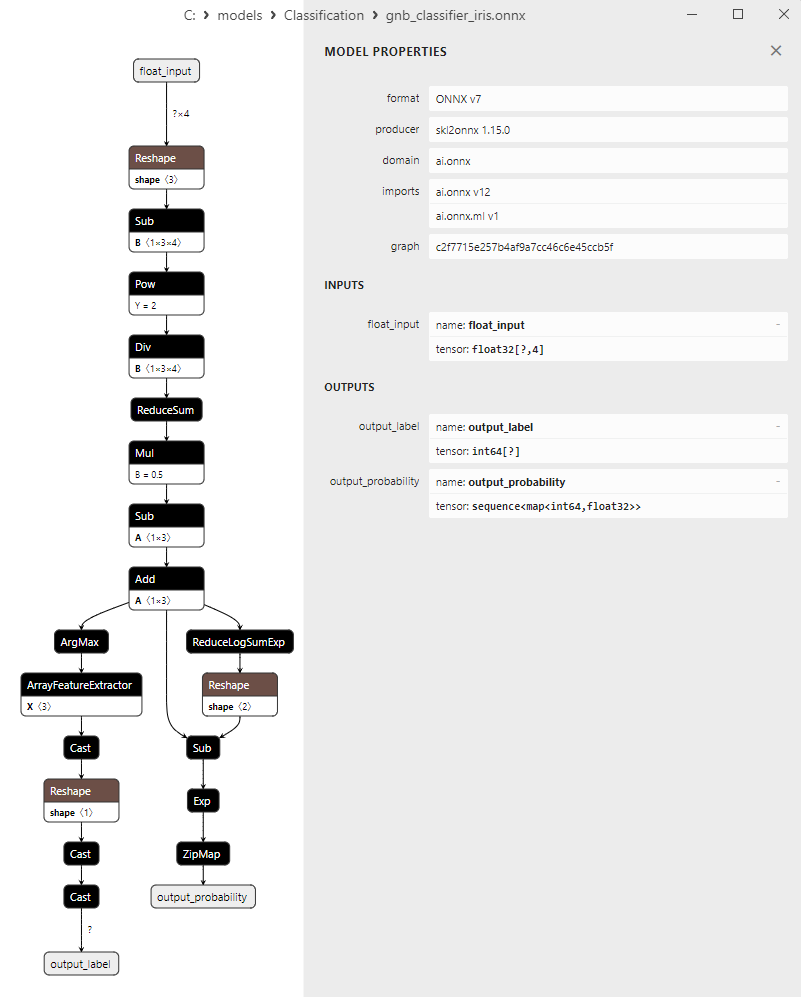

2.18.3. Representación ONNX del modelo Gaussian Naive Bayes (GNB) Classifier - 2.19. Multinomial Naive Bayes (MNB) Classifier

2.19.1. Código de creación del modelo Multinomial Naive Bayes (MNB) Classifier

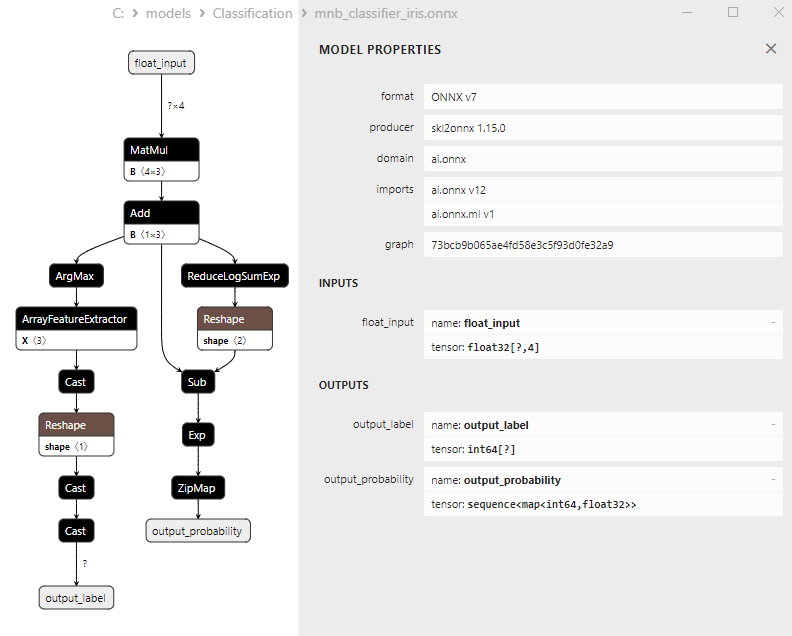

2.19.2. Código MQL5 para trabajar con el modelo Multinomial Naive Bayes (MNB) Classifier

2.19.3. Representación ONNX del modelo Multinomial Naive Bayes (MNB) Classifier - 2.20. Complement Naive Bayes (CNB) Classifier

2.20.1. Código de creación del modelo Complement Naive Bayes (CNB) Classifier

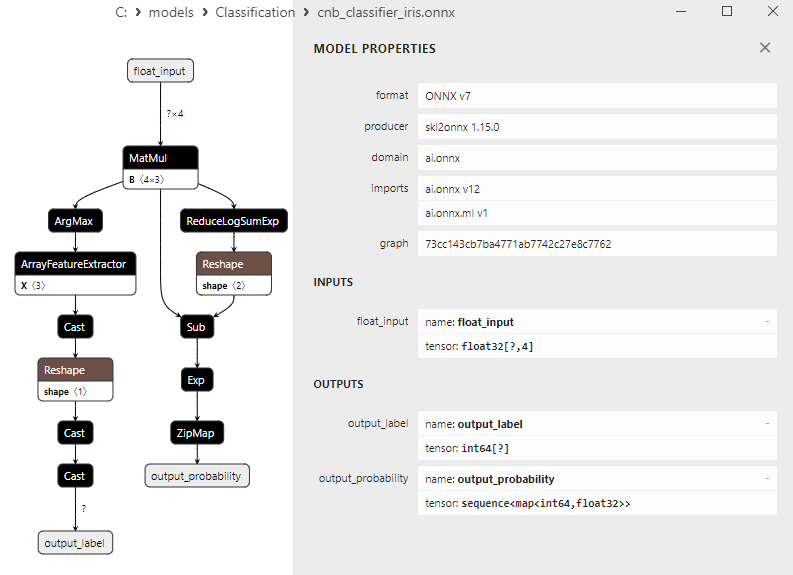

2.20.2. Código MQL5 para trabajar con el modelo Complement Naive Bayes (CNB) Classifier

2.20.3. Representación ONNX del modelo Complement Naive Bayes (CNB) Classifier - 2.21. Bernoulli Naive Bayes (BNB) Classifier

2.21.1. Código de creación del modelo Bernoulli Naive Bayes (BNB) Classifier

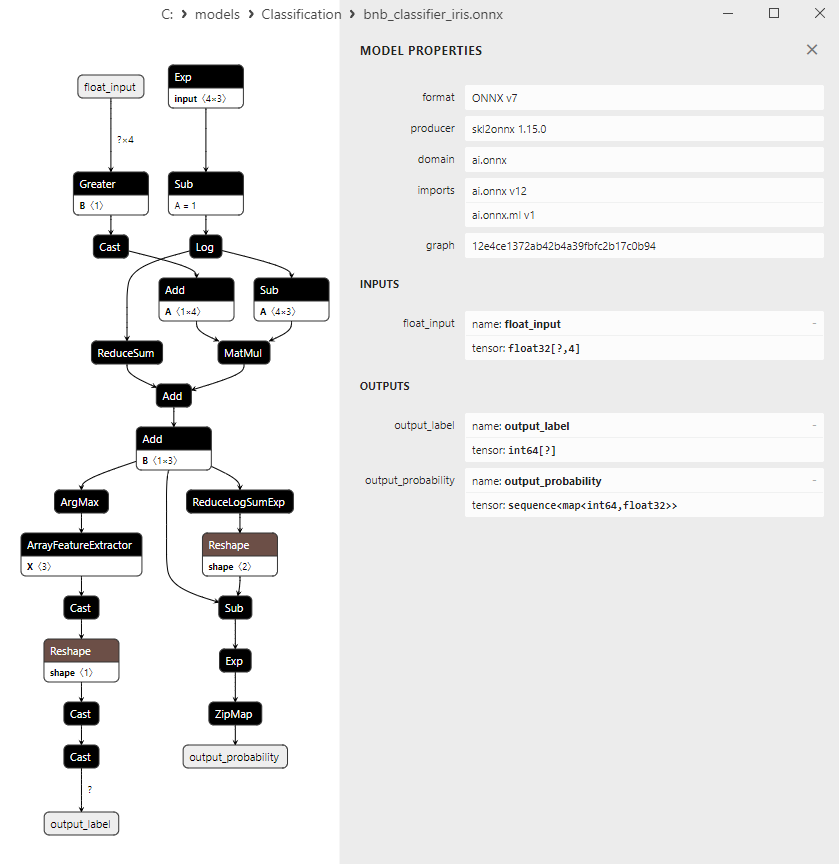

2.21.2. Código MQL5 para trabajar con el modelo Bernoulli Naive Bayes (BNB) Classifier

2.21.3. Representación ONNX del modelo Bernoulli Naive Bayes (BNB) Classifier - 2.22. Multilayer Perceptron Classifier

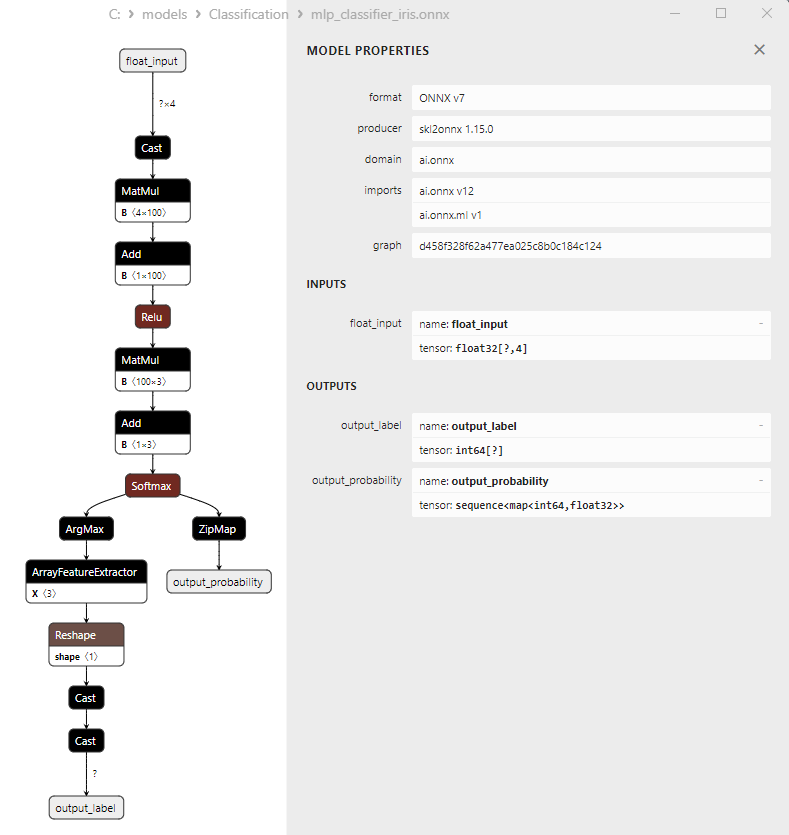

2.22.1. Código de creación del modelo Multilayer Perceptron Classifier

2.22.2. Código MQL5 para trabajar con el modelo Multilayer Perceptron Classifier

2.22.3. Representación ONNX del modelo Multilayer Perceptron Classifier - 2.23. Linear Discriminant Analysis (LDA) Classifier

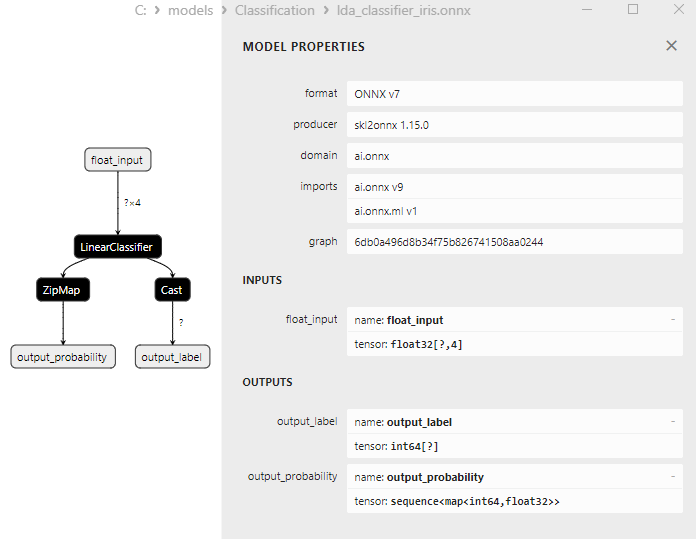

2.23.1. Código de creación del modelo Linear Discriminant Analysis (LDA) Classifier

2.23.2. Código MQL5 para trabajar con el modelo Linear Discriminant Analysis (LDA) Classifier

2.23.3. Representación ONNX del modelo Linear Discriminant Analysis (LDA) Classifier - 2.24. Hist Gradient Boosting

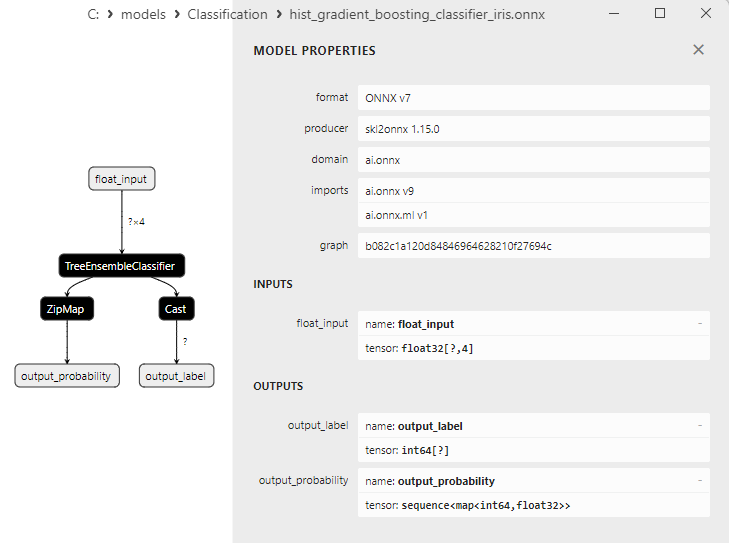

2.24.1. Código para crear el modelo Histogram-Based Gradient Boosting Classifier

2.24.2. Código MQL5 para trabajar con el modelo Histogram-Based Gradient Boosting Classifier

2.24.3. Representación ONNX del modelo Histogram-Based Gradient Boosting Classifier - 2.25. CategoricalNB Classifier

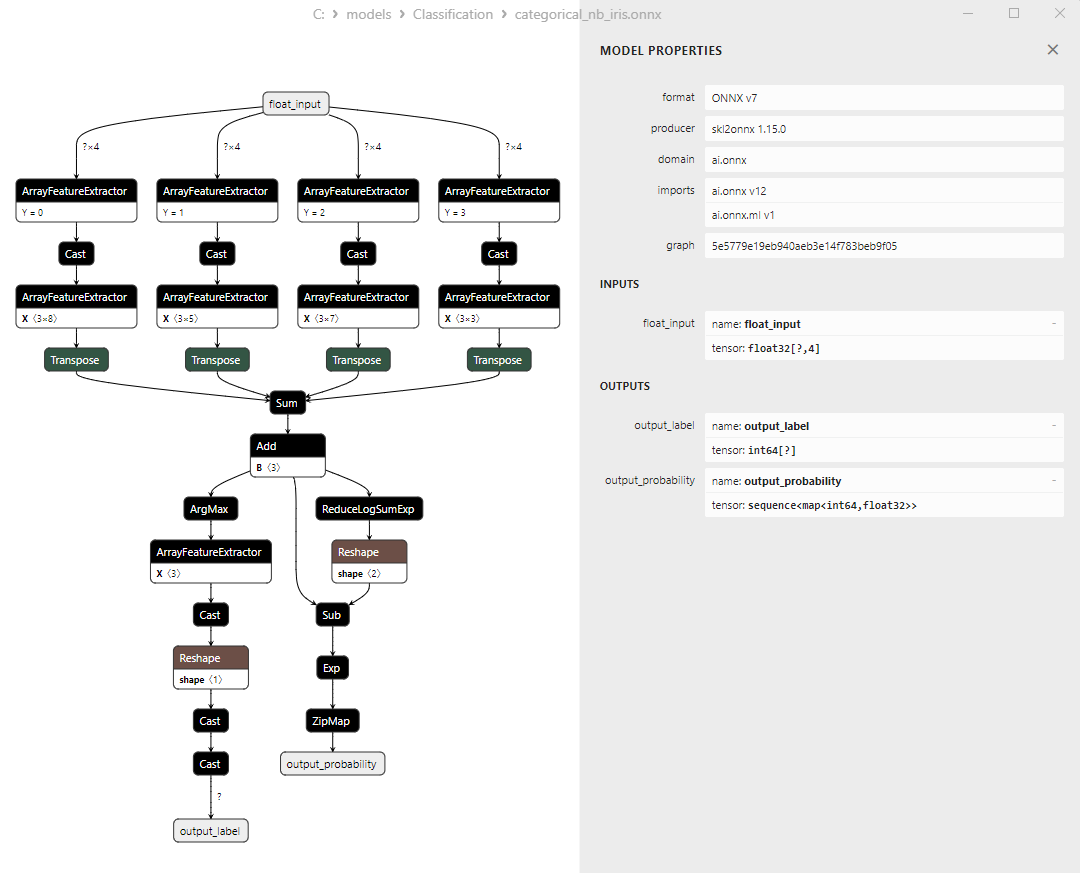

2.25.1. Código para crear el modelo CategoricalNB Classifier

2.23.2. Código MQL5 para trabajar con el modelo CategoricalNB Classifier

2.23.3. Representación ONNX del modelo CategoricalNB Classifier - 2.26. ExtraTreeClassifier

2.26.1. Código de creación del modelo ExtraTreeClassifier

2.26.2. Código MQL5 para trabajar con el modelo ExtraTreeClassifier

2.26.3. Representación ONNX del modelo ExtraTreeClassifier - 2.27. ExtraTreesClassifier

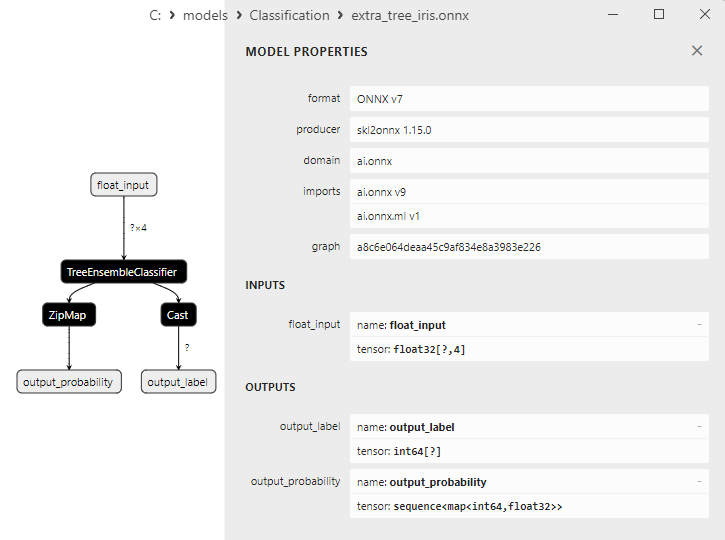

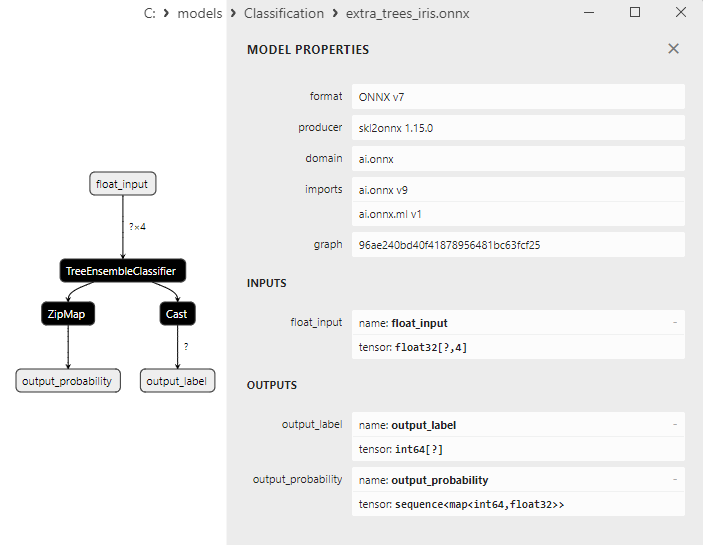

2.27.1. Código de creación del modelo ExtraTreesClassifier

2.27.2. Código MQL5 para trabajar con el modelo ExtraTreesClassifier

2.27.3. Representación ONNX del modelo ExtraTreesClassifier - 2.28. Comparación de la precisión de todos los modelos

2.28.1. Código para calcular todos los modelos y trazar un esquema comparativo de precisión

2.28.2. Código MQL5 para ejecutar todos los modelos ONNX - 2.29. Modelos de clasificación de Sckikit-Learn que no se han podido convertir a ONNX

- 2.29.1. DummyClassifier

2.29.1.1. Código de creación del modelo DummyClassifier - 2.29.2. GaussianProcessClassifier

2.29.2.1. Código de creación del modelo GaussianProcessClassifier - 2.29.3. LabelPropagation Classifier

2.29.3.1. Código de creación del modelo LabelPropagationClassifier - 2.29.4. LabelSpreading Classifier

2.29.4.1. Código de creación del modelo LabelSpreadingClassifier - 2.29.5. NearestCentroid Classifier

2.29.5.1. Código de creación del modelo NearestCentroid Classifier - 2.29.6. Quadratic Discriminant Analysis Classifier

2.29.6.1.Código de creación del modelo Quadratic Discriminant Analysis - Conclusiones

1. Iris de Fisher

El Iris dataset es uno de los conjuntos de datos más famosos y usados en el mundo del aprendizaje automático. Fue introducido por primera vez en 1936 por el estadístico y biólogo R.A. Fisher y desde entonces se ha convertido en un conjunto de datos clásico para problemas de clasificación.

El Iris dataset es un conjunto de mediciones de sépalos y pétalos de tres especies de iris: Iris setosa, Iris virginica e Iris versicolor.

Figura 1. Iris setosa

Figura 2. Iris virginica

Fig. 3. Iris versicolor

El conjunto de datos de Iris consta de 150 especímenes de iris, 50 especímenes de cada una de las tres especies. Cada ejemplar posee cuatro características numéricas (en centímetros):

- Longitud del sépalo

- Anchura del sépalo

- Longitud del pétalo

- Anchura del pétalo

Cada ejemplar posee además una clase correspondiente que indica el tipo de iris (Iris setosa, Iris virginica o Iris versicolor). Este atributo de clasificación hace que el Iris Dataset sea un conjunto de datos ideal para tareas de aprendizaje automático como clasificación y clusterización.

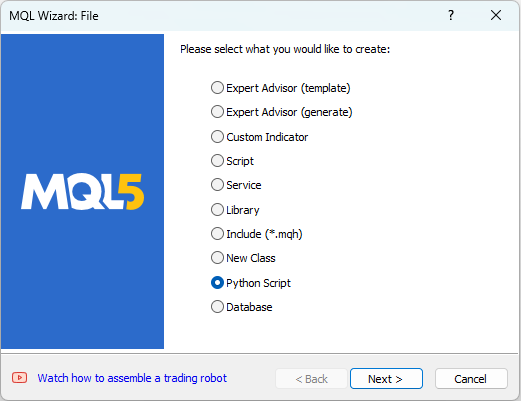

El MetaEditor nos permite trabajar con scripts en Python. Para crear un script de Python, seleccionaremos "Nuevo" en el menú "Archivo" del MetaEditor. Allí aparecerá una ventana de diálogo para seleccionar el objeto a crear (fig. 4).

Fig.4. Creamos un script en Python en el MQL5 Wizard - Paso 1

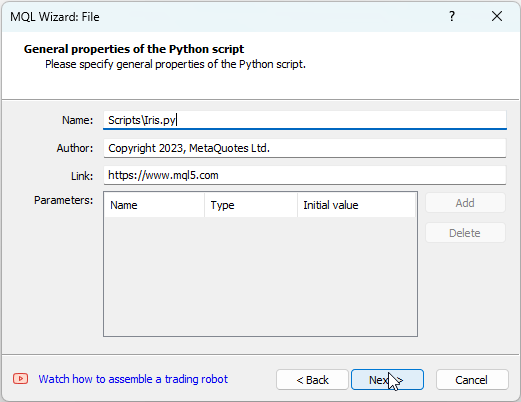

A continuación deberemos especificar el nombre del script, por ejemplo IRIS.py

Fig.5. Creamos un script en Python en el MQL5 Wizard - Paso 2 - Nombre del script

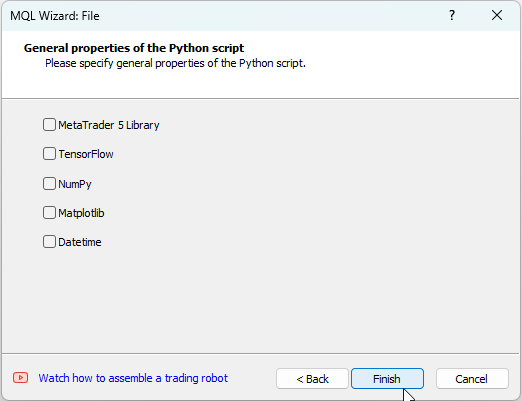

Después de esto, podremos especificar qué bibliotecas se utilizarán; en nuestro caso, dejaremos estos campos vacíos.

Fig.6. Creamos un script en Python en el MQL5 Wizard - Paso 3

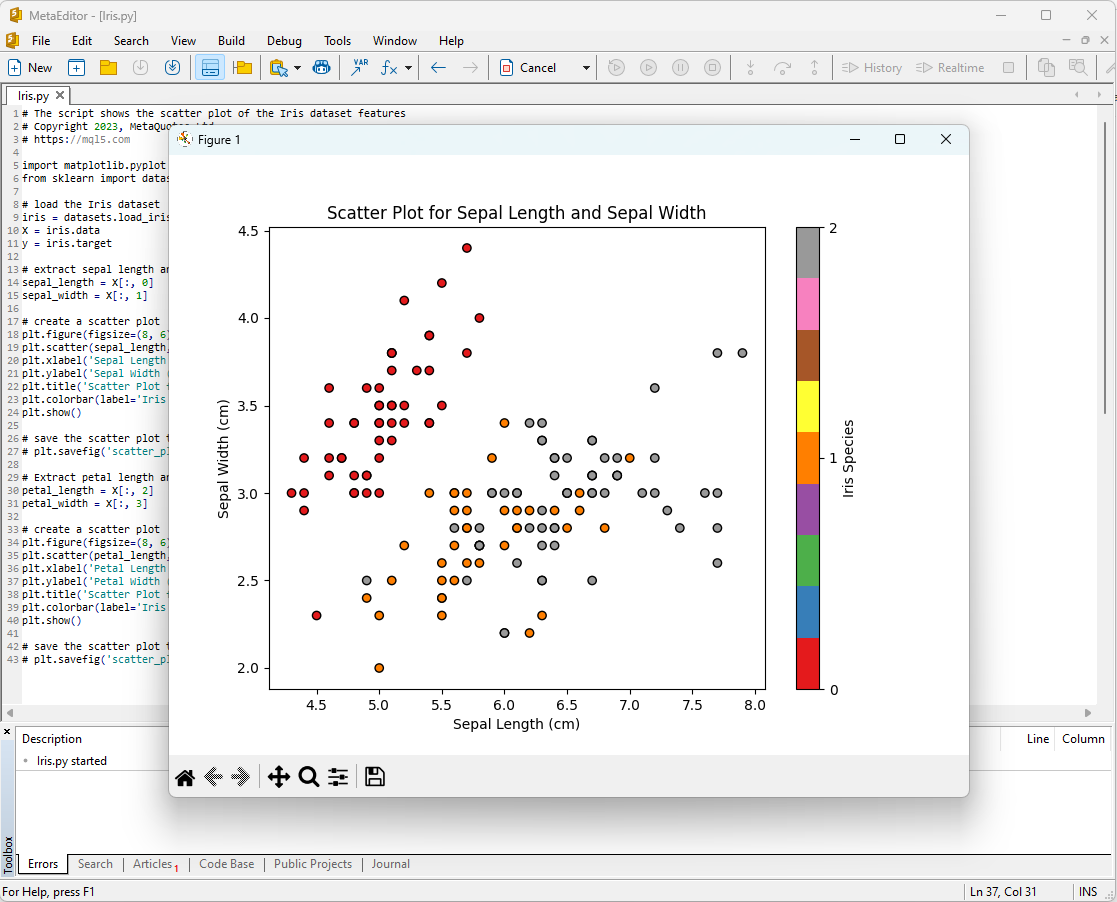

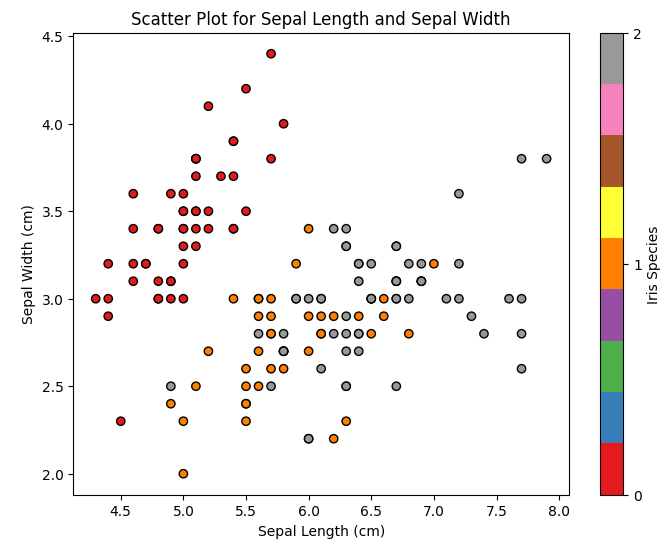

Una forma de comenzar a analizar el conjunto de datos de Iris será visualizar los datos. La representación gráfica nos permitirá comprender mejor la estructura de los datos y las relaciones entre las características.

Por ejemplo, podemos trazar un diagrama de dispersión (scatter plot) para ver cómo se distribuyen los diferentes tipos de iris en el espacio de características.

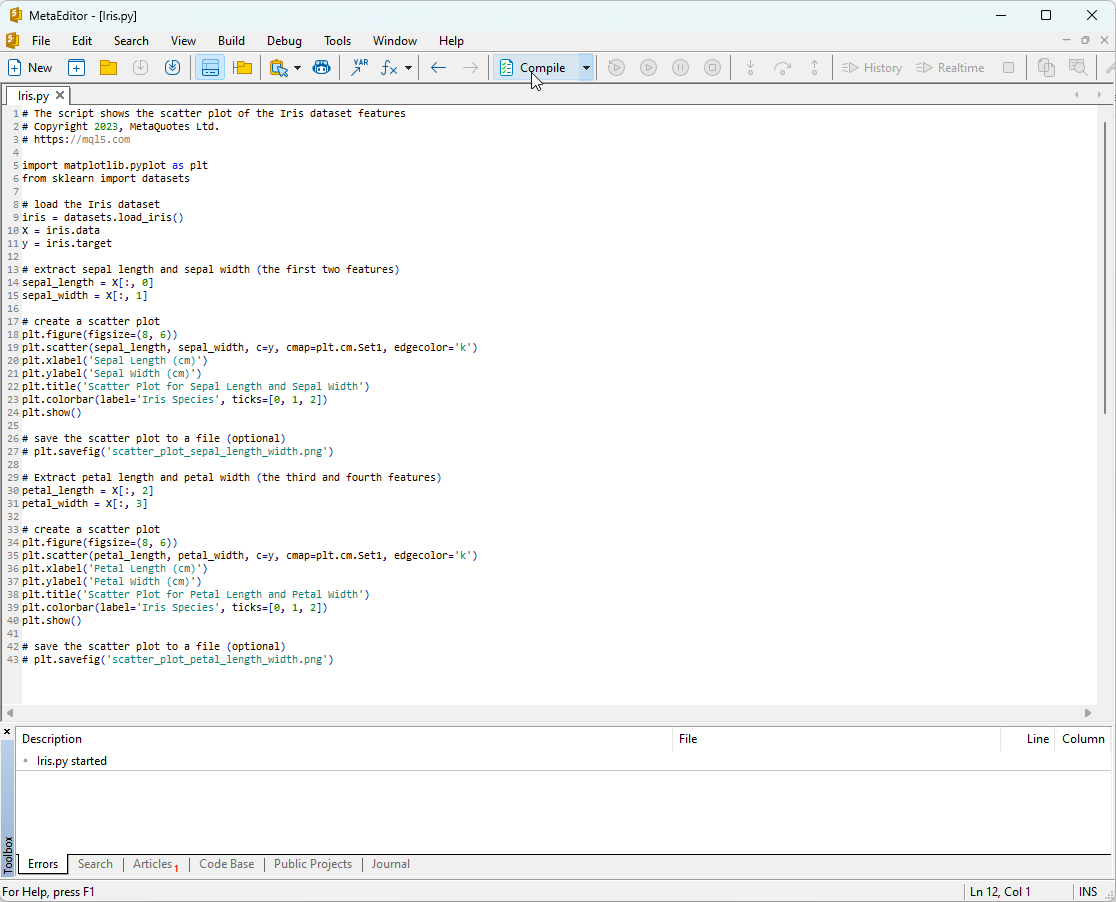

Código de secuencia de comandos de Python:

# The script shows the scatter plot of the Iris dataset features # Copyright 2023, MetaQuotes Ltd. # https://mql5.com import matplotlib.pyplot as plt from sklearn import datasets # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # extract sepal length and sepal width (the first two features) sepal_length = X[:, 0] sepal_width = X[:, 1] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(sepal_length, sepal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Sepal Length (cm)') plt.ylabel('Sepal Width (cm)') plt.title('Scatter Plot for Sepal Length and Sepal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_sepal_length_width.png') # Extract petal length and petal width (the third and fourth features) petal_length = X[:, 2] petal_width = X[:, 3] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(petal_length, petal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Petal Length (cm)') plt.ylabel('Petal Width (cm)') plt.title('Scatter Plot for Petal Length and Petal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_petal_length_width.png')

Para ejecutar este script, deberemos copiarlo en el MetaEditor (Fig. 7) y hacer clic en "Compilar".

Fig.7. Script IRIS.py en el MetaEditor

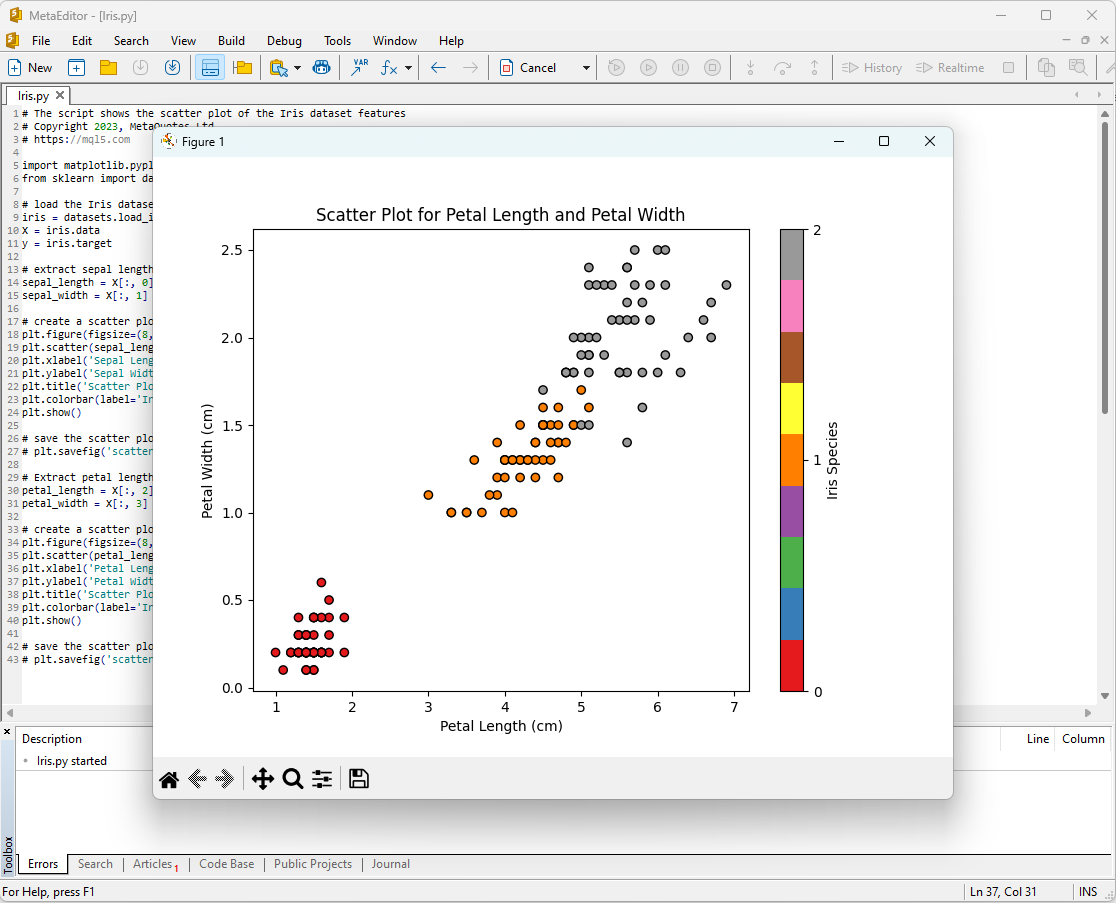

Después de esto, aparecerán en pantalla los siguientes gráficos:

Fig.8. Script IRIS.py en el MetaEditor con gráfico de longitud de sépalo/anchura de sépalo

Fig.9. Script IRIS.py en el MetaEditor con gráfico de longitud de pétalo/anchura de pétalo

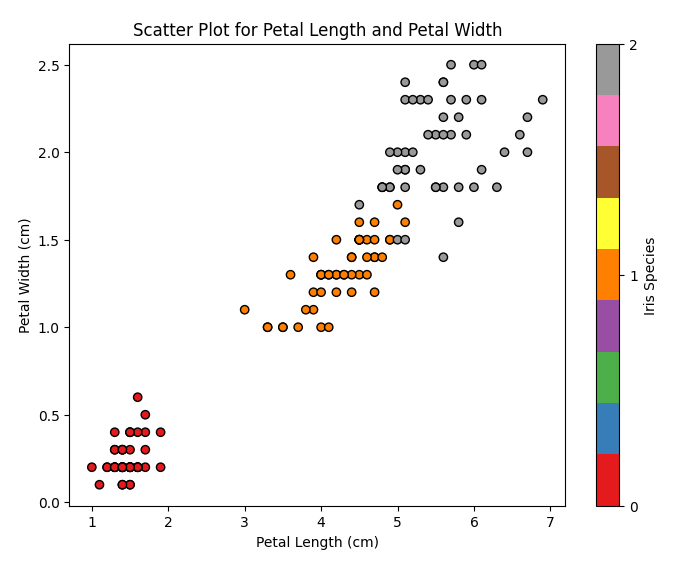

Veamos las descripciones más de cerca.

Fig. 10. Gráfico de dispersión Longitud del sépalo versus anchura del sépalo (Scatter Plot Sepal Length vs Sepal Width)

En este diagrama veremos cómo se distribuyen los diferentes tipos de iris según el largo y la anchura del sépalo. Podemos ver que Iris setosa generalmente tiene sépalos más cortos y anchos que las otras dos especies.

Fig. 11. Diagrama de dispersión longitud del pétalo vs anchura del pétalo (Scatter Plot Petal Length vs Petal Width)

En este diagrama vemos cómo se distribuyen los diferentes tipos de iris según el largo y la anchura del pétalo. Podemos observar que el Iris setosa tiene los pétalos más cortos y estrechos, el Iris virginica los más largos y anchos, y el Iris versicolor se encuentra en medio.

El Iris dataset es ideal para entrenar y probar modelos de aprendizaje automático. Lo utilizaremos para analizar el rendimiento de los modelos de aprendizaje automático en la tarea de clasificación.

2. Modelos para la clasificación

La tarea de clasificación es una de las principales tareas del aprendizaje automático y su objetivo es dividir los datos en diferentes categorías o clases en función de algunos atributos.

Vamos a analizar los principales modelos de aprendizaje automático del paquete scikit-learn.

Lista de clasificadores del paquete Scikit-learn

Podemos utilizar un script para obtener una lista de los clasificadores Scikit-learn disponibles:

# ScikitLearnClassifiers.py # The script lists all the classification algorithms available in scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn classifiers from sklearn.utils import all_estimators classifiers = all_estimators(type_filter='classifier') for index, (name, ClassifierClass) in enumerate(classifiers, start=1): print(f"Classifier {index}: {name}")

Resultado:

Python The scikit-learn version is 1.2.2.

Python Classifier 1: AdaBoostClassifier

Python Classifier 2: BaggingClassifier

Python Classifier 3: BernoulliNB

Python Classifier 4: CalibratedClassifierCV

Python Classifier 5: CategoricalNB

Python Classifier 6: ClassifierChain

Python Classifier 7: ComplementNB

Python Classifier 8: DecisionTreeClassifier

Python Classifier 9: DummyClassifier

Python Classifier 10: ExtraTreeClassifier

Python Classifier 11: ExtraTreesClassifier

Python Classifier 12: GaussianNB

Python Classifier 13: GaussianProcessClassifier

Python Classifier 14: GradientBoostingClassifier

Python Classifier 15: HistGradientBoostingClassifier

Python Classifier 16: KNeighborsClassifier

Python Classifier 17: LabelPropagation

Python Classifier 18: LabelSpreading

Python Classifier 19: LinearDiscriminantAnalysis

Python Classifier 20: LinearSVC

Python Classifier 21: LogisticRegression

Python Classifier 22: LogisticRegressionCV

Python Classifier 23: MLPClassifier

Python Classifier 24: MultiOutputClassifier

Python Classifier 25: MultinomialNB

Python Classifier 26: NearestCentroid

Python Classifier 27: NuSVC

Python Classifier 28: OneVsOneClassifier

Python Classifier 29: OneVsRestClassifier

Python Classifier 30: OutputCodeClassifier

Python Classifier 31: PassiveAggressiveClassifier

Python Classifier 32: Perceptron

Python Classifier 33: QuadraticDiscriminantAnalysis

Python Classifier 34: RadiusNeighborsClassifier

Python Classifier 35: RandomForestClassifier

Python Classifier 36: RidgeClassifier

Python Classifier 37: RidgeClassifierCV

Python Classifier 38: SGDClassifier

Python Classifier 39: SVC

Python Classifier 40: StackingClassifier

Python Classifier 41: VotingClassifier

Para mayor comodidad, aparecerán resaltados en distintos colores en esta lista de calificadores. Los modelos que requieran clasificadores básicos aparecerán resaltados en amarillo, mientras que los restantes podrán utilizarse de forma independiente.

De cara al futuro, debemos observar que el color verde indicará los modelos que se han exportado correctamente al formato ONNX, mientras que el color rojo indicará los modelos que presentan errores durante la conversión en la versión actual de scikit-learn 1.2.2.

Representación distinta de los datos de salida para los modelos

Hay que tener en cuenta que los distintos modelos representan la información de salida de forma diferente, por lo que hay que tener cuidado al trabajar con modelos convertidos a ONNX.

Para el problema de clasificación del iris de Fisher, los tensores de entrada tienen la misma forma para todos estos modelos:

1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Los tensores de salida de los modelos ONNX son distintos.

1. Modelos que no requieren procesamiento posterior

- SVC Classifier;

- LinearSVC Classifier;

- NuSVC Classifier;

- Radius Neighbors Classifier;

- Ridge Classifier;

- Ridge Classifier CV.

1. Name: label, Data Type: tensor(int64), Shape: [None]

2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Retornan el resultado (número de clase) explícitamente en la primera etiqueta entera de salida tensor(int64) sin requerir procesamiento posterior.

2. Modelos cuyos resultados requieren un procesamiento posterior:

- Random Forest Classifier;

- Gradient Boosting Classifier;

- AdaBoost Classifier;

- Bagging Classifier;

- K-NN_Classifier;

- Decision Tree Classifier;

- Logistic Regression Classifier;

- Logistic Regression CV Classifier;

- Passive-Aggressive Classifier;

- Perceptron Classifier;

- SGD Classifier;

- Gaussian Naive Bayes Classifier;

- Multinomial Naive Bayes Classifier;

- Complement Naive Bayes Classifier;

- Bernoulli Naive Bayes Classifier;

- Multilayer Perceptron Classifier;

- Linear Discriminant Analysis Classifier;

- Hist Gradient Boosting Classifier;

- Categorical Naive Bayes Classifier;

- ExtraTree Classifier;

- ExtraTrees Classifier.

1. Name: output_label, Data Type: tensor(int64), Shape: [None]

2. Name: output_probability, Data Type: seq(map(int64,tensor(float))), Shape: []

En la salida retornan una lista de clases y las probabilidades de pertenencia a cada clase.

Para obtener el resultado en estos casos, se requiere un procesamiento posterior como seq(map(int64,tensor(float) (encontrar el elemento con máxima probabilidad).

Por lo tanto, deberemos tener cuidado y considerar estos puntos al trabajar con modelos ONNX. En el script 2.28.2.1 se presenta un ejemplo de procesamiento diferente de resultados.

iris.mqh

Para probar los modelos en el iris dataset completo en MQL5, será necesario formar los datos del conjunto de datos, para ello se utilizará la función PrepareIrisDataset().

Lo más cómodo es poner estas funciones en el archivo iris.mqh

//+------------------------------------------------------------------+ //| Iris.mqh | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" //+------------------------------------------------------------------+ //| Structure for the IRIS Dataset sample | //+------------------------------------------------------------------+ struct sIRISsample { int sample_id; // sample id (1-150) double features[4]; // SepalLengthCm,SepalWidthCm,PetalLengthCm,PetalWidthCm string class_name; // class ("Iris-setosa","Iris-versicolor","Iris-virginica") int class_id; // class id (0,1,2), calculated by function IRISClassID }; //--- Iris dataset sIRISsample ExtIRISDataset[]; int Exttotal=0; //+------------------------------------------------------------------+ //| Returns class id by class name | //+------------------------------------------------------------------+ int IRISClassID(string class_name) { //--- if(class_name=="Iris-setosa") return(0); else if(class_name=="Iris-versicolor") return(1); else if(class_name=="Iris-virginica") return(2); //--- return(-1); } //+------------------------------------------------------------------+ //| AddSample | //+------------------------------------------------------------------+ bool AddSample(const int Id,const double SepalLengthCm,const double SepalWidthCm,const double PetalLengthCm,const double PetalWidthCm, const string Species) { //--- ExtIRISDataset[Exttotal].sample_id=Id; //--- ExtIRISDataset[Exttotal].features[0]=SepalLengthCm; ExtIRISDataset[Exttotal].features[1]=SepalWidthCm; ExtIRISDataset[Exttotal].features[2]=PetalLengthCm; ExtIRISDataset[Exttotal].features[3]=PetalWidthCm; //--- ExtIRISDataset[Exttotal].class_name=Species; ExtIRISDataset[Exttotal].class_id=IRISClassID(Species); //--- Exttotal++; //--- return(true); } //+------------------------------------------------------------------+ //| Prepare Iris Dataset | //+------------------------------------------------------------------+ bool PrepareIrisDataset(sIRISsample &iris_samples[]) { ArrayResize(ExtIRISDataset,150); Exttotal=0; //--- AddSample(1,5.1,3.5,1.4,0.2,"Iris-setosa"); AddSample(2,4.9,3.0,1.4,0.2,"Iris-setosa"); AddSample(3,4.7,3.2,1.3,0.2,"Iris-setosa"); AddSample(4,4.6,3.1,1.5,0.2,"Iris-setosa"); AddSample(5,5.0,3.6,1.4,0.2,"Iris-setosa"); AddSample(6,5.4,3.9,1.7,0.4,"Iris-setosa"); AddSample(7,4.6,3.4,1.4,0.3,"Iris-setosa"); AddSample(8,5.0,3.4,1.5,0.2,"Iris-setosa"); AddSample(9,4.4,2.9,1.4,0.2,"Iris-setosa"); AddSample(10,4.9,3.1,1.5,0.1,"Iris-setosa"); AddSample(11,5.4,3.7,1.5,0.2,"Iris-setosa"); AddSample(12,4.8,3.4,1.6,0.2,"Iris-setosa"); AddSample(13,4.8,3.0,1.4,0.1,"Iris-setosa"); AddSample(14,4.3,3.0,1.1,0.1,"Iris-setosa"); AddSample(15,5.8,4.0,1.2,0.2,"Iris-setosa"); AddSample(16,5.7,4.4,1.5,0.4,"Iris-setosa"); AddSample(17,5.4,3.9,1.3,0.4,"Iris-setosa"); AddSample(18,5.1,3.5,1.4,0.3,"Iris-setosa"); AddSample(19,5.7,3.8,1.7,0.3,"Iris-setosa"); AddSample(20,5.1,3.8,1.5,0.3,"Iris-setosa"); AddSample(21,5.4,3.4,1.7,0.2,"Iris-setosa"); AddSample(22,5.1,3.7,1.5,0.4,"Iris-setosa"); AddSample(23,4.6,3.6,1.0,0.2,"Iris-setosa"); AddSample(24,5.1,3.3,1.7,0.5,"Iris-setosa"); AddSample(25,4.8,3.4,1.9,0.2,"Iris-setosa"); AddSample(26,5.0,3.0,1.6,0.2,"Iris-setosa"); AddSample(27,5.0,3.4,1.6,0.4,"Iris-setosa"); AddSample(28,5.2,3.5,1.5,0.2,"Iris-setosa"); AddSample(29,5.2,3.4,1.4,0.2,"Iris-setosa"); AddSample(30,4.7,3.2,1.6,0.2,"Iris-setosa"); AddSample(31,4.8,3.1,1.6,0.2,"Iris-setosa"); AddSample(32,5.4,3.4,1.5,0.4,"Iris-setosa"); AddSample(33,5.2,4.1,1.5,0.1,"Iris-setosa"); AddSample(34,5.5,4.2,1.4,0.2,"Iris-setosa"); AddSample(35,4.9,3.1,1.5,0.2,"Iris-setosa"); AddSample(36,5.0,3.2,1.2,0.2,"Iris-setosa"); AddSample(37,5.5,3.5,1.3,0.2,"Iris-setosa"); AddSample(38,4.9,3.6,1.4,0.1,"Iris-setosa"); AddSample(39,4.4,3.0,1.3,0.2,"Iris-setosa"); AddSample(40,5.1,3.4,1.5,0.2,"Iris-setosa"); AddSample(41,5.0,3.5,1.3,0.3,"Iris-setosa"); AddSample(42,4.5,2.3,1.3,0.3,"Iris-setosa"); AddSample(43,4.4,3.2,1.3,0.2,"Iris-setosa"); AddSample(44,5.0,3.5,1.6,0.6,"Iris-setosa"); AddSample(45,5.1,3.8,1.9,0.4,"Iris-setosa"); AddSample(46,4.8,3.0,1.4,0.3,"Iris-setosa"); AddSample(47,5.1,3.8,1.6,0.2,"Iris-setosa"); AddSample(48,4.6,3.2,1.4,0.2,"Iris-setosa"); AddSample(49,5.3,3.7,1.5,0.2,"Iris-setosa"); AddSample(50,5.0,3.3,1.4,0.2,"Iris-setosa"); AddSample(51,7.0,3.2,4.7,1.4,"Iris-versicolor"); AddSample(52,6.4,3.2,4.5,1.5,"Iris-versicolor"); AddSample(53,6.9,3.1,4.9,1.5,"Iris-versicolor"); AddSample(54,5.5,2.3,4.0,1.3,"Iris-versicolor"); AddSample(55,6.5,2.8,4.6,1.5,"Iris-versicolor"); AddSample(56,5.7,2.8,4.5,1.3,"Iris-versicolor"); AddSample(57,6.3,3.3,4.7,1.6,"Iris-versicolor"); AddSample(58,4.9,2.4,3.3,1.0,"Iris-versicolor"); AddSample(59,6.6,2.9,4.6,1.3,"Iris-versicolor"); AddSample(60,5.2,2.7,3.9,1.4,"Iris-versicolor"); AddSample(61,5.0,2.0,3.5,1.0,"Iris-versicolor"); AddSample(62,5.9,3.0,4.2,1.5,"Iris-versicolor"); AddSample(63,6.0,2.2,4.0,1.0,"Iris-versicolor"); AddSample(64,6.1,2.9,4.7,1.4,"Iris-versicolor"); AddSample(65,5.6,2.9,3.6,1.3,"Iris-versicolor"); AddSample(66,6.7,3.1,4.4,1.4,"Iris-versicolor"); AddSample(67,5.6,3.0,4.5,1.5,"Iris-versicolor"); AddSample(68,5.8,2.7,4.1,1.0,"Iris-versicolor"); AddSample(69,6.2,2.2,4.5,1.5,"Iris-versicolor"); AddSample(70,5.6,2.5,3.9,1.1,"Iris-versicolor"); AddSample(71,5.9,3.2,4.8,1.8,"Iris-versicolor"); AddSample(72,6.1,2.8,4.0,1.3,"Iris-versicolor"); AddSample(73,6.3,2.5,4.9,1.5,"Iris-versicolor"); AddSample(74,6.1,2.8,4.7,1.2,"Iris-versicolor"); AddSample(75,6.4,2.9,4.3,1.3,"Iris-versicolor"); AddSample(76,6.6,3.0,4.4,1.4,"Iris-versicolor"); AddSample(77,6.8,2.8,4.8,1.4,"Iris-versicolor"); AddSample(78,6.7,3.0,5.0,1.7,"Iris-versicolor"); AddSample(79,6.0,2.9,4.5,1.5,"Iris-versicolor"); AddSample(80,5.7,2.6,3.5,1.0,"Iris-versicolor"); AddSample(81,5.5,2.4,3.8,1.1,"Iris-versicolor"); AddSample(82,5.5,2.4,3.7,1.0,"Iris-versicolor"); AddSample(83,5.8,2.7,3.9,1.2,"Iris-versicolor"); AddSample(84,6.0,2.7,5.1,1.6,"Iris-versicolor"); AddSample(85,5.4,3.0,4.5,1.5,"Iris-versicolor"); AddSample(86,6.0,3.4,4.5,1.6,"Iris-versicolor"); AddSample(87,6.7,3.1,4.7,1.5,"Iris-versicolor"); AddSample(88,6.3,2.3,4.4,1.3,"Iris-versicolor"); AddSample(89,5.6,3.0,4.1,1.3,"Iris-versicolor"); AddSample(90,5.5,2.5,4.0,1.3,"Iris-versicolor"); AddSample(91,5.5,2.6,4.4,1.2,"Iris-versicolor"); AddSample(92,6.1,3.0,4.6,1.4,"Iris-versicolor"); AddSample(93,5.8,2.6,4.0,1.2,"Iris-versicolor"); AddSample(94,5.0,2.3,3.3,1.0,"Iris-versicolor"); AddSample(95,5.6,2.7,4.2,1.3,"Iris-versicolor"); AddSample(96,5.7,3.0,4.2,1.2,"Iris-versicolor"); AddSample(97,5.7,2.9,4.2,1.3,"Iris-versicolor"); AddSample(98,6.2,2.9,4.3,1.3,"Iris-versicolor"); AddSample(99,5.1,2.5,3.0,1.1,"Iris-versicolor"); AddSample(100,5.7,2.8,4.1,1.3,"Iris-versicolor"); AddSample(101,6.3,3.3,6.0,2.5,"Iris-virginica"); AddSample(102,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(103,7.1,3.0,5.9,2.1,"Iris-virginica"); AddSample(104,6.3,2.9,5.6,1.8,"Iris-virginica"); AddSample(105,6.5,3.0,5.8,2.2,"Iris-virginica"); AddSample(106,7.6,3.0,6.6,2.1,"Iris-virginica"); AddSample(107,4.9,2.5,4.5,1.7,"Iris-virginica"); AddSample(108,7.3,2.9,6.3,1.8,"Iris-virginica"); AddSample(109,6.7,2.5,5.8,1.8,"Iris-virginica"); AddSample(110,7.2,3.6,6.1,2.5,"Iris-virginica"); AddSample(111,6.5,3.2,5.1,2.0,"Iris-virginica"); AddSample(112,6.4,2.7,5.3,1.9,"Iris-virginica"); AddSample(113,6.8,3.0,5.5,2.1,"Iris-virginica"); AddSample(114,5.7,2.5,5.0,2.0,"Iris-virginica"); AddSample(115,5.8,2.8,5.1,2.4,"Iris-virginica"); AddSample(116,6.4,3.2,5.3,2.3,"Iris-virginica"); AddSample(117,6.5,3.0,5.5,1.8,"Iris-virginica"); AddSample(118,7.7,3.8,6.7,2.2,"Iris-virginica"); AddSample(119,7.7,2.6,6.9,2.3,"Iris-virginica"); AddSample(120,6.0,2.2,5.0,1.5,"Iris-virginica"); AddSample(121,6.9,3.2,5.7,2.3,"Iris-virginica"); AddSample(122,5.6,2.8,4.9,2.0,"Iris-virginica"); AddSample(123,7.7,2.8,6.7,2.0,"Iris-virginica"); AddSample(124,6.3,2.7,4.9,1.8,"Iris-virginica"); AddSample(125,6.7,3.3,5.7,2.1,"Iris-virginica"); AddSample(126,7.2,3.2,6.0,1.8,"Iris-virginica"); AddSample(127,6.2,2.8,4.8,1.8,"Iris-virginica"); AddSample(128,6.1,3.0,4.9,1.8,"Iris-virginica"); AddSample(129,6.4,2.8,5.6,2.1,"Iris-virginica"); AddSample(130,7.2,3.0,5.8,1.6,"Iris-virginica"); AddSample(131,7.4,2.8,6.1,1.9,"Iris-virginica"); AddSample(132,7.9,3.8,6.4,2.0,"Iris-virginica"); AddSample(133,6.4,2.8,5.6,2.2,"Iris-virginica"); AddSample(134,6.3,2.8,5.1,1.5,"Iris-virginica"); AddSample(135,6.1,2.6,5.6,1.4,"Iris-virginica"); AddSample(136,7.7,3.0,6.1,2.3,"Iris-virginica"); AddSample(137,6.3,3.4,5.6,2.4,"Iris-virginica"); AddSample(138,6.4,3.1,5.5,1.8,"Iris-virginica"); AddSample(139,6.0,3.0,4.8,1.8,"Iris-virginica"); AddSample(140,6.9,3.1,5.4,2.1,"Iris-virginica"); AddSample(141,6.7,3.1,5.6,2.4,"Iris-virginica"); AddSample(142,6.9,3.1,5.1,2.3,"Iris-virginica"); AddSample(143,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(144,6.8,3.2,5.9,2.3,"Iris-virginica"); AddSample(145,6.7,3.3,5.7,2.5,"Iris-virginica"); AddSample(146,6.7,3.0,5.2,2.3,"Iris-virginica"); AddSample(147,6.3,2.5,5.0,1.9,"Iris-virginica"); AddSample(148,6.5,3.0,5.2,2.0,"Iris-virginica"); AddSample(149,6.2,3.4,5.4,2.3,"Iris-virginica"); AddSample(150,5.9,3.0,5.1,1.8,"Iris-virginica"); //--- ArrayResize(iris_samples,150); for(int i=0; i<Exttotal; i++) { iris_samples[i]=ExtIRISDataset[i]; } //--- return(true); } //+------------------------------------------------------------------+

Nota sobre los métodos de clasificación: SVC, LinearSVC y NuSVC

Compararemos tres métodos de clasificación populares: SVC (Support Vector Classification), LinearSVC (Linear Support Vector Classification) y NuSVC (Nu Support Vector Classification).

Principios de funcionamiento:

- SVC (Support Vector Classification)

Principio de funcionamiento: El SVC es un método de clasificación basado en la maximización de la diferencia entre clases. Busca un hiperplano de separación óptimo que mantenga las clases lo más separadas posible y conserva los vectores de soporte, que son los puntos más cercanos al hiperplano.

Funciones de núcleo: El SVC puede usar varias funciones de núcleo, como la lineal, la función de base radial (RBF), la polinómica y otras. La función de núcleo define la forma en que se transforman los datos para encontrar el hiperplano óptimo. - LinearSVC (Linear Support Vector Classification)

Principio de funcionamiento: LinearSVC es una variante de SVC especializada en la clasificación lineal. Busca el hiperplano de separación lineal óptimo sin usar funciones de núcleo. Esto la hace más rápida y eficaz a la hora de procesar grandes cantidades de datos. - NuSVC (Nu Support Vector Classification)

Principio de funcionamiento: NuSVC también se basa en el método de vectores de soporte, pero introduce un parámetro Nu (nu) que controla la complejidad del modelo y la proporción de vectores de soporte. El valor de Nu está comprendido entre 0 y 1 y determina qué parte de los datos puede usarse para los vectores de soporte y los errores.

Ventajas:

- SVC

Potente algoritmo: El SVC puede realizar tareas de clasificación complejas y trabajar con datos no lineales mediante el uso de funciones de núcleo.

Resistencia a los valores atípicos: El SVC es fiable frente a los valores atípicos en los datos porque utiliza vectores de soporte para construir un hiperplano de separación. - LinearSVC

Alta eficiencia: LinearSVC es más rápido y eficiente al trabajar con grandes cantidades de datos, especialmente cuando hay muchos datos y un hiperplano de separación lineal resulta apropiado para la tarea.

Clasificación lineal: Si el problema se puede dividir bien de forma lineal, LinearSVC puede dar buenos resultados sin necesidad de funciones de núcleo complejas. - NuSVC

Control de la complejidad del modelo: El parámetro Nu de NuSVC permite controlar la complejidad del modelo y el equilibrio entre el ajuste a los datos y la capacidad de generalización.

Resistencia a los valores atípicos: Al igual que el SVC, el NuSVC es resistente a los valores atípicos, lo cual lo hace útil para tareas con datos imprecisos.

Limitaciones:

- SVC

Complejidad computacional: El SVC puede ser lento con grandes cantidades de datos y/o cuando se usan funciones de núcleo complejas.

Sensibilidad a la selección del núcleo: Seleccionar la función de núcleo adecuada puede ser una tarea compleja y afectar en gran medida al rendimiento de un modelo. - LinearSVC

Limitación de la linealidad: LinearSVC se limita a la separación lineal de los datos y puede ofrecer malos resultados en caso de relaciones no lineales entre las características y la variable objetivo. - NuSVC

Ajuste del parámetro Nu: El ajuste del parámetro Nu puede requerir tiempo y experimentación para lograr resultados óptimos.

Dependiendo de las características del problema y de la cantidad de datos, cada uno de estos métodos puede resultar la mejor opción. Es importante realizar experimentos y seleccionar el método que mejor se adapte a los requisitos específicos de la tarea de clasificación.

2.1. SVC Classifier

El método de clasificación Support Vector Classification (SVC) es un potente algoritmo de aprendizaje automático muy utilizado para resolver problemas de clasificación.

Principios de funcionamiento:

- Encontrar el hiperplano de separación óptimo

Principio de funcionamiento: La idea básica del SVC es encontrar el hiperplano de separación óptimo en el espacio de características. Este hiperplano debe separar al máximo los objetos de clases diferentes y debe soportar los vectores de soporte, que son los puntos de datos más cercanos al hiperplano.

Maximización del espacio libre: El SVC trata de maximizar la brecha entre clases, es decir, la distancia desde los vectores de soporte hasta el hiperplano. Esto permite que el método resulte resistente a los valores atípicos y se generalice bien a los nuevos datos. - Uso de funciones de núcleo

Funciones de núcleo: El SVC puede usar varias funciones de núcleo, como la lineal, la función de base radial (RBF), la polinómica y otras. La función de núcleo permite proyectar los datos en un espacio de mayor dimensionalidad en el que el problema se vuelve lineal, aunque no exista separabilidad lineal en el espacio de datos original.

Selección del núcleo: La elección de la función de núcleo adecuada puede afectar en gran medida al rendimiento de un modelo SVC. Un hiperplano lineal no siempre es la solución óptima.

Ventajas:

- Potente algoritmo: Gestión de tareas complejas: El SVC es capaz de resolver problemas de clasificación complejos, incluidos problemas con relaciones no lineales entre las características y la variable objetivo.

- Resistencia a los valores atípicos: El uso de vectores de soporte hace que el método sea robusto frente a valores atípicos en los datos. No depende de toda la muestra, sino solo de los vectores de soporte.

- Flexibilidad en la selección del núcleo. Adaptabilidad de los datos: La posibilidad de usar diferentes funciones de núcleo nos permite adaptar el método SVC a datos específicos y buscar dependencias no lineales.

- Buena capacidad de generalización. Generalización a nuevos datos: El modelo SVC es capaz de generalizarse a nuevos datos, lo cual lo hace útil para tareas de previsión.

Limitaciones:

- Complejidad computacional: Tiempo de entrenamiento: El entrenamiento del SVC puede ser lento, sobre todo cuando se utilizan grandes cantidades de datos o funciones de núcleo complejas.

- Selección del núcleo: Selección de la función de núcleo óptima: La elección de la función de núcleo correcta puede requerir experimentación y depende de las características de los datos.

- Sensibilidad a la escala de características. Normalización de datos: El SVC es sensible a la escala de las características, por lo que se recomienda normalizar o estandarizar los datos antes del entrenamiento.

- Interpretación del modelo. Dificultad de interpretación: Los modelos SVC pueden ser difíciles de interpretar debido al uso de núcleos no lineales y múltiples vectores de soporte.

Dependiendo de la tarea específica y de la cantidad de datos, el método SVC puede ser una potente herramienta para resolver problemas de clasificación. No obstante, es importante tener en cuenta sus limitaciones y ajustar los parámetros para obtener resultados óptimos.

2.1.1. Código de creación del modelo SVC Classifier

Este código demuestra el proceso de entrenamiento del modelo SVC Classifier con el Iris dataset, exportándolo al formato ONNX, y realizando una clasificación que usa el modelo ONNX. También evalúa la precisión tanto del modelo original como del modelo ONNX.

# Iris_SVCClassifier.py # The code demonstrates the process of training SVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import SVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create an SVC Classifier model with a linear kernel svc_model = SVC(kernel='linear', C=1.0) # train the model on the entire dataset svc_model.fit(X, y) # predict classes for the entire dataset y_pred = svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of SVC Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path +"svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of SVC Classifier model in ONNX format:", accuracy_onnx)

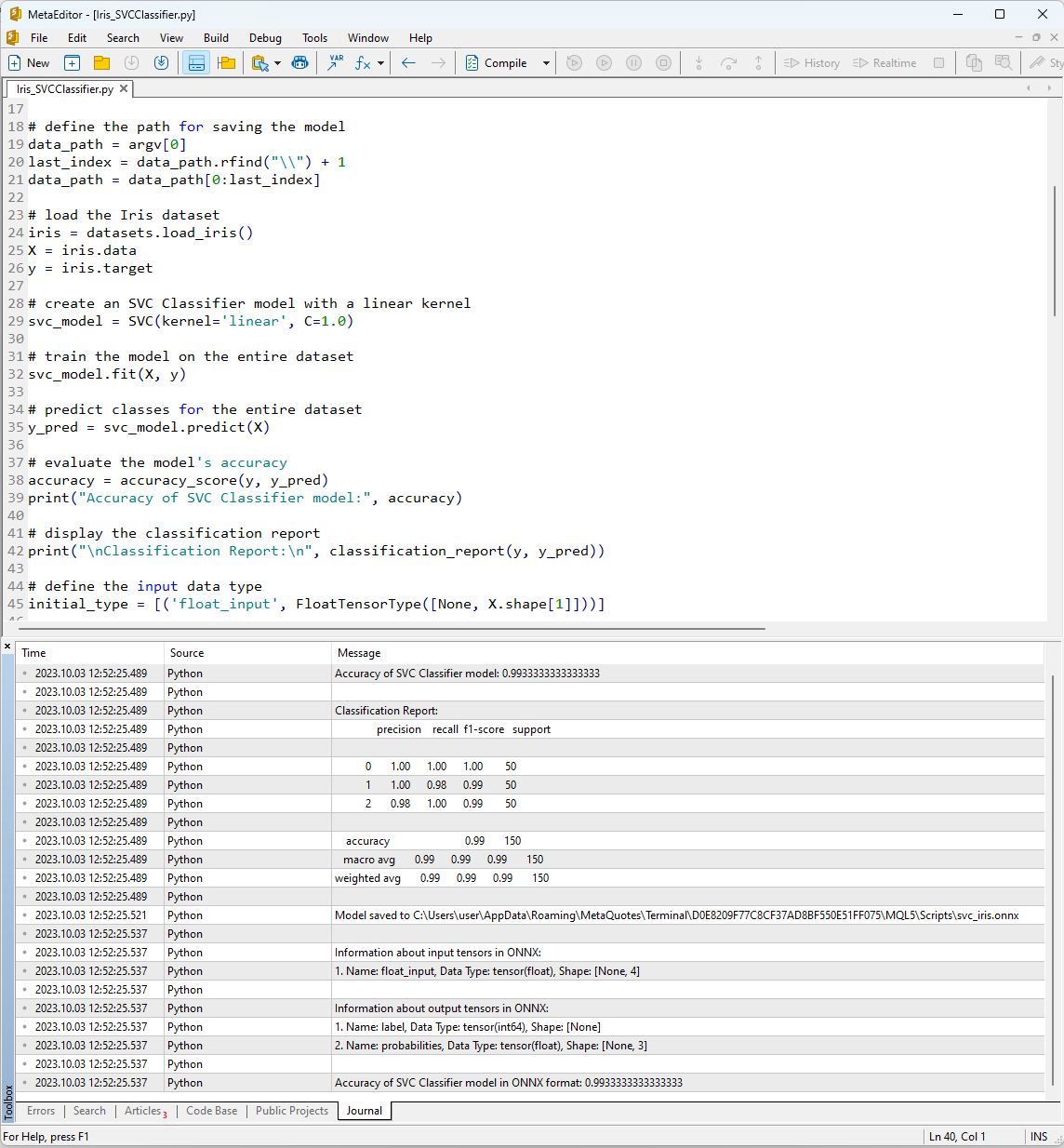

Tras ejecutar el script en el MetaEditor utilizando el botón "Compile" en la pestaña Journal, podemos ver los resultados de su trabajo.

Fig. 12. Resultados del script Iris_SVMClassifier.py en el MetaEditor

Resultados del script Iris_SVCClassifier.py:

Python Accuracy of ExtraTreesClassifier model: 0.9933333333333333

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 1.00 0.98 0.99 50

Python 2 0.98 1.00 0.99 50

Python

Python accuracy 0.99 150

Python macro avg 0.99 0.99 0.99 150

Python weighted avg 0.99 0.99 0.99 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1 0.98 1.00 0.99 50 Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1 0.98 1.00 0.99 50 Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of SVC Classifier model in ONNX format: 0.9933333333333333

Aquí podemos encontrar información sobre la ruta en la que se ha guardado el modelo ONNX, los tipos de parámetros de entrada y salida del modelo ONNX y la precisión de la descripción de los datos del Iris dataset.

La precisión de la descripción del conjunto de datos mediante el clasificador SVM es del 99%; el modelo exportado al formato ONNX muestra una precisión similar.

Ahora vamos a comprobar estos resultados de MQL5 ejecutando el modelo construido para cada una de las 150 muestras de datos. Además, en el script hay un ejemplo de tratamiento de datos por lotes.

2.1.2. Código en MQL5 para trabajar con el modelo SVC Classifier

//+------------------------------------------------------------------+ //| Iris_SVCClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="SVCClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Los resultados del script se muestran en la pestaña "Experts" del terminal MetaTrader 5.

Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier correct results: 99.33% Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier all samples accuracy=0.993333 Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier batch test accuracy=1.000000

El modelo SVC ha sido capaz de distinguir correctamente 149 muestras de 150, lo que supone un resultado muy bueno. El modelo solo ha cometido un error de clasificación en el Iris dataset, al predecir la clase 2 (versicolor) en lugar de la clase 1 (virginica) para la muestra nº 84.

Observe que la precisión del modelo ONNX exportado en el conjunto completo del Iris dataset es del 99,33%, lo cual coincide con la precisión del original.

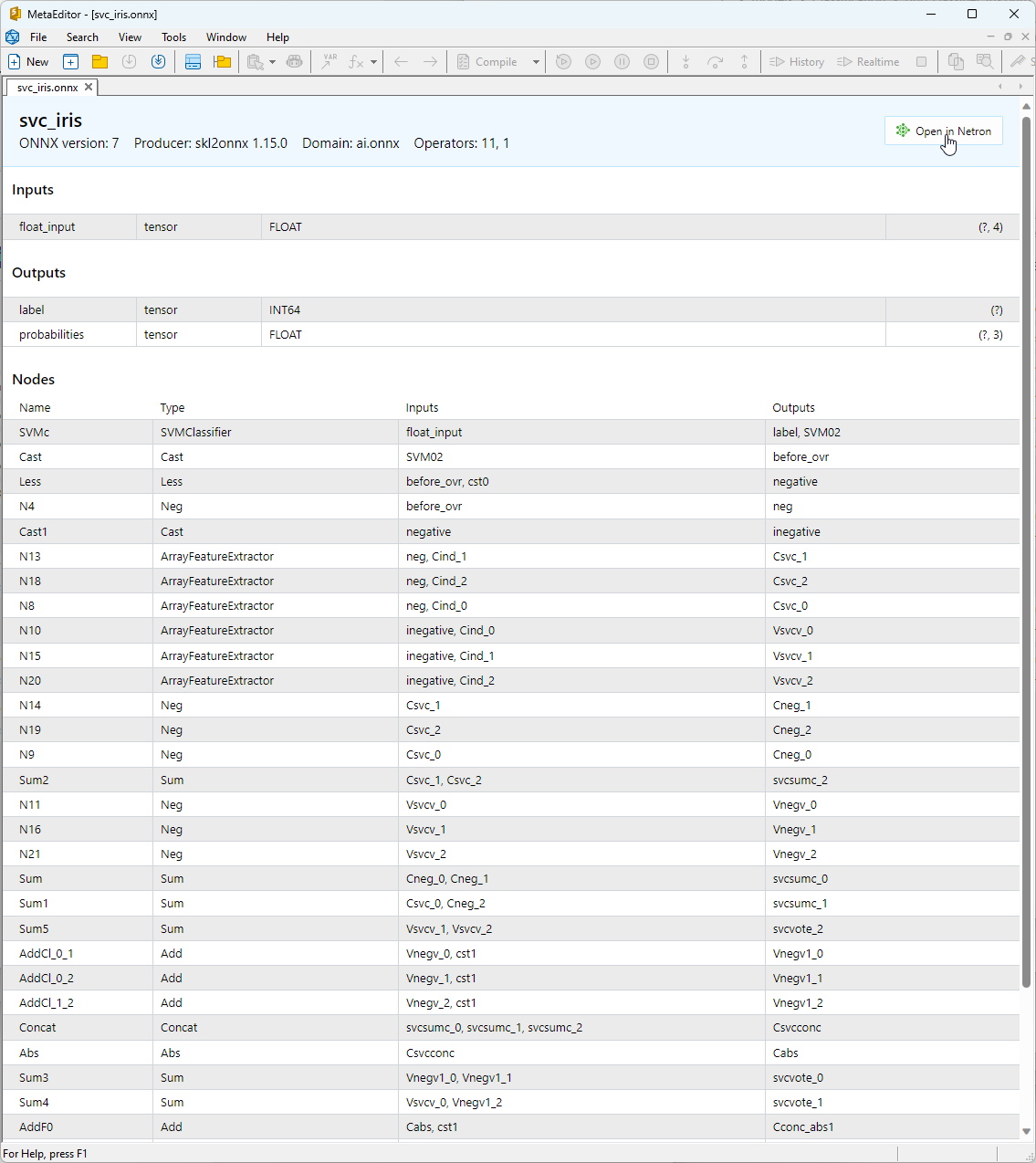

2.1.3. Representación ONNX del modelo SVC Classifier

El modelo ONNX creado puede visualizarse en el MetaEditor:

Fig. 13. Modelo ONNX svc_iris.onnx en el MetaEditor

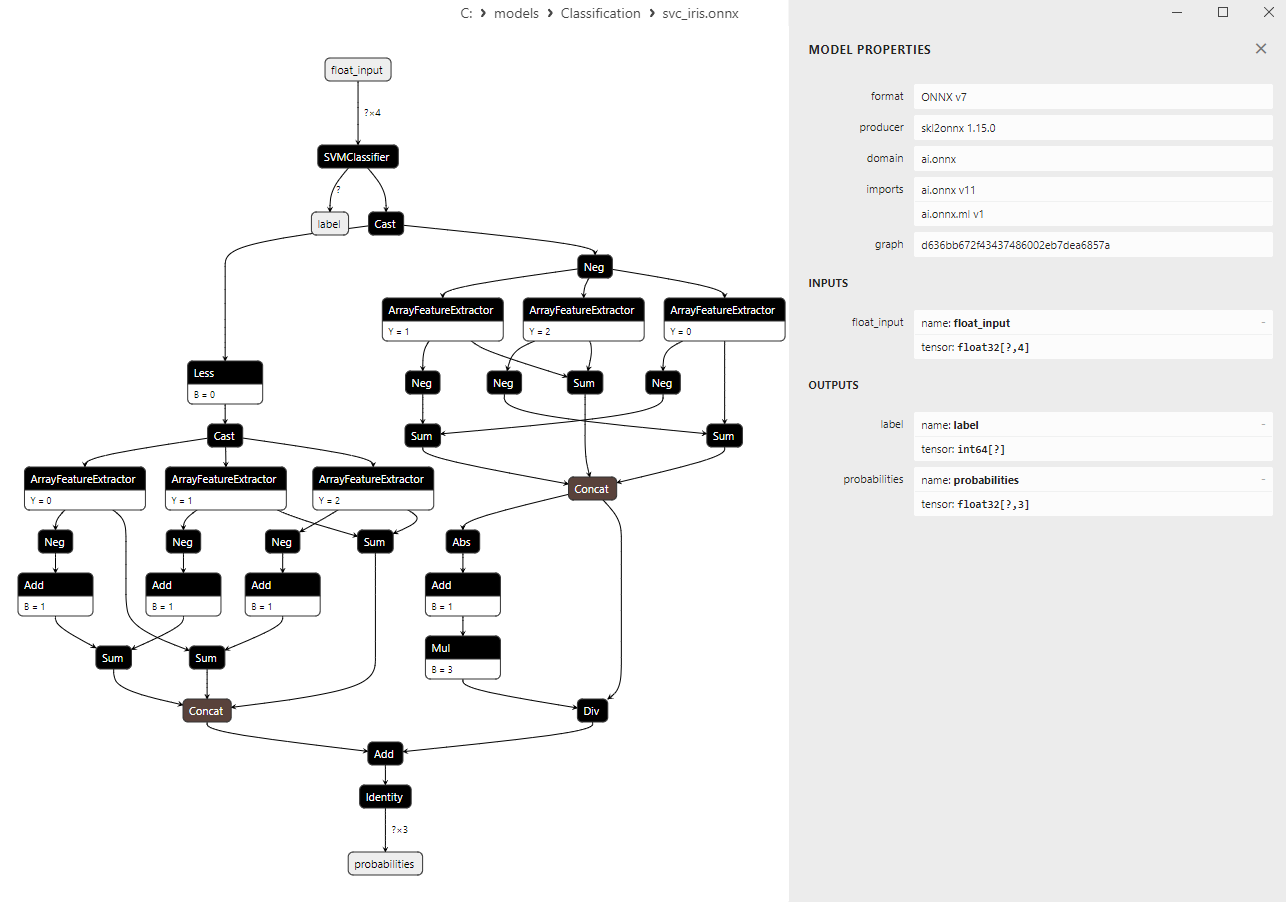

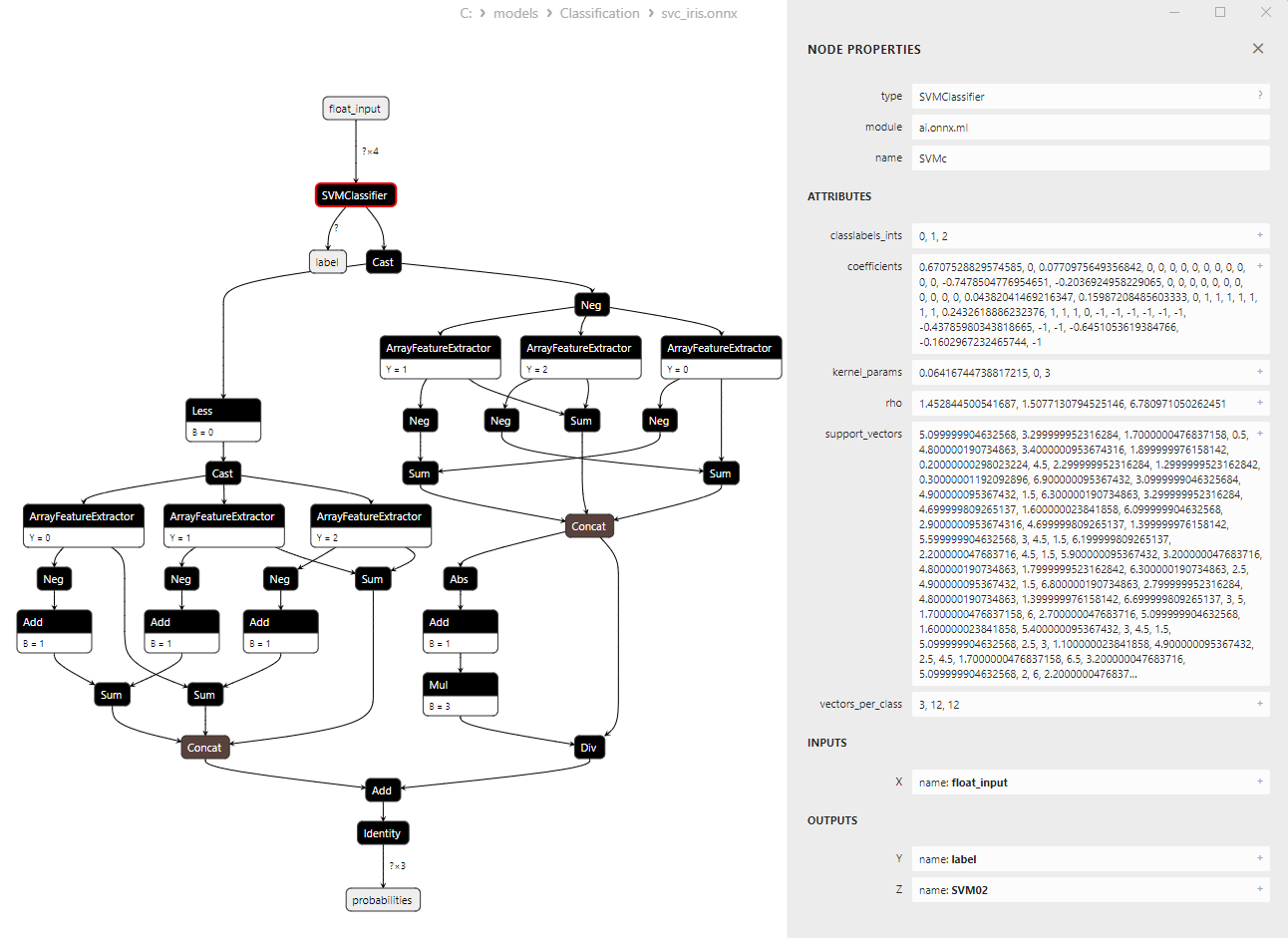

Podemos ver información más detallada sobre la arquitectura del modelo utilizando Netron, para ello en la descripción del modelo en el MetaEditor debemos pulsar el botón "Open in Netron".

Fig. 14. Modelo ONNX svc_iris.onnx en Netron

Fig. 15. Modelo ONNX svc_iris.onnx en Netron (parámetros del operador ONNX SVMClassifier)

2.2. LinearSVC Classifier

LinearSVC (Linear Support Vector Classification, método lineal de vectores de soporte) es un potente algoritmo de aprendizaje automático utilizado para tareas de clasificación binarias y multiclase. Se basa en la idea de encontrar el hiperplano que mejor separe los datos.

Principios de LinearSVC:

- Encontrar el hiperplano de separación óptimo La idea básica de LinearSVC consiste en encontrar el hiperplano óptimo que separe al máximo dos clases de datos. Un hiperplano es un plano multidimensional que se define como una ecuación lineal.

- Minimización de márgenes: LinearSVC trata de minimizar los márgenes (distancia de los puntos de datos hasta el hiperplano). Cuanto mayores sean los márgenes, más fiable será el hiperplano para separar las clases.

- Trabajo con datos linealmente inseparables: LinearSVC puede trabajar con datos que no pueden dividirse linealmente en el espacio original, mediante el uso de funciones de núcleo (kernel trick) que permiten proyectar los datos en un espacio de mayor dimensionalidad en el que pueden dividirse linealmente.

Ventajas de LinearSVC:

- Buena capacidad de generalización. LinearSVC tiene una buena capacidad de generalización y puede dar buenos resultados con datos nuevos, no vistos previamente.

- Eficiencia: LinearSVC se ejecuta rápidamente en grandes conjuntos de datos y requiere relativamente pocos recursos informáticos.

- Trabajo con datos linealmente inseparables: Usando características de núcleo, LinearSVC puede resolver problemas de clasificación con datos linealmente indivisibles.

- 6) Escalabilidad: LinearSVC puede usarse eficazmente en tareas con un gran número de características y grandes cantidades de datos.

Limitaciones de LinearSVC:

- Solo hiperplanos de separación lineales: LinearSVC solo construye hiperplanos de separación lineales, lo cual puede no ser suficiente para problemas de clasificación complejos con dependencias no lineales.

- Selección de parámetros: La selección de los parámetros correctos (por ejemplo, el parámetro de regularización) puede requerir de conocimientos expertos o validación cruzada.

- Sensibilidad a los valores atípicos: LinearSVC puede ser sensible a los valores atípicos en los datos, lo que puede afectar a la calidad de la clasificación.

- Interpretación del modelo: Los modelos creados con LinearSVC pueden ser menos interpretables que otros métodos.

LinearSVC es un potente algoritmo de clasificación con una buena capacidad de generalización, alta eficiencia y soporte para manejar datos linealmente indivisibles. Encuentra aplicación en diversos problemas de clasificación, especialmente cuando los datos pueden separarse mediante un hiperplano lineal. No obstante, conviene considerar que para problemas complejos que requieran modelar dependencias no lineales, LinearSVC puede ser una opción menos adecuada, y en tales casos debería considerarse el uso de métodos con superficies de separación más complejas.

2.2.1. Código de creación del modelo LinearSVC Classifier

Este código demuestra el proceso de entrenamiento del modelo LinearSVC Classifier con el Iris dataset, exportándolo al formato ONNX, y efectuando una clasificación que usa el modelo ONNX. También evalúa la precisión tanto del modelo original como del modelo ONNX.

# Iris_LinearSVC.py # The code demonstrates the process of training LinearSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import LinearSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a LinearSVC model linear_svc_model = LinearSVC(C=1.0, max_iter=10000) # train the model on the entire dataset linear_svc_model.fit(X, y) # predict classes for the entire dataset y_pred = linear_svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of LinearSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(linear_svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "linear_svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of LinearSVC model in ONNX format:", accuracy_onnx)

Resultado:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.94 0.95 50

Python 2 0.94 0.96 0.95 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\linear_svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of LinearSVC model in ONNX format: 0.9666666666666667

2.2.2. Código en MQL5 para trabajar con el modelo LinearSVC Classifier

//+------------------------------------------------------------------+ //| Iris_LinearSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "linear_svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="LinearSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Resultado:

Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=71 FAILED [class=2, true class=1] features=(5.90,3.20,4.80,1.80] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=85 FAILED [class=2, true class=1] features=(5.40,3.00,4.50,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=130 FAILED [class=1, true class=2] features=(7.20,3.00,5.80,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=134 FAILED [class=1, true class=2] features=(6.30,2.80,5.10,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC correct results: 96.67% Iris_LinearSVC (EURUSD,H1) model=LinearSVC all samples accuracy=0.966667 Iris_LinearSVC (EURUSD,H1) model=LinearSVC batch test accuracy=1.000000

Observe que la precisión del modelo ONNX exportado en el conjunto completo del Iris dataset es del 96,67%, lo cual coincide con la precisión del original.

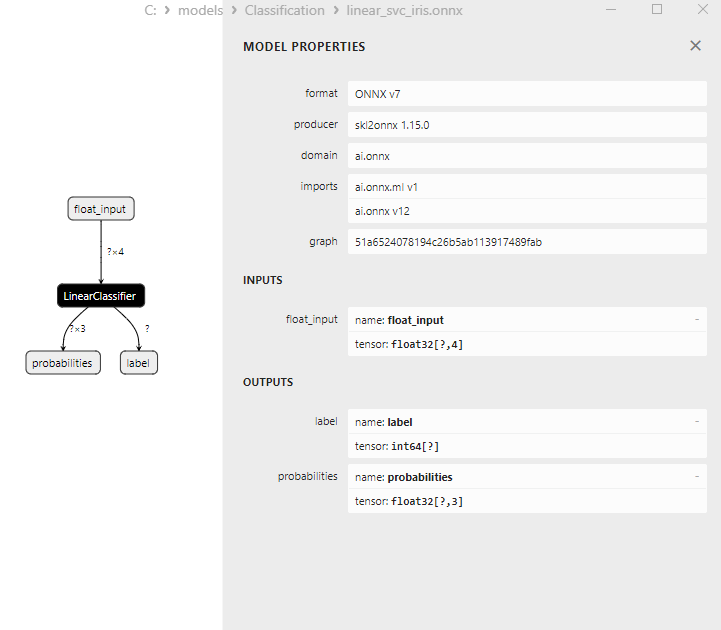

2.2.3. Representación ONNX del modelo LinearSVC Classifier

Fig. 16. Representación ONNX del modelo LinearSVC Classifier en Netron

2.3. NuSVC Classifier

El método Nu-Support Vector Classification (NuSVC) es un potente algoritmo de aprendizaje automático basado en el método de vectores de soporte (Support Vector Machine, SVM).

Principios de funcionamiento de NuSVC:

- Método de vectores de soporte (SVM) NuSVC es un tipo de SVM que se usa para resolver problemas de clasificación binarios y multiclase. El principio básico de la SVM es encontrar el hiperplano de separación óptimo que maximice la separación entre clases y tenga la máxima separación entre ellas.

- Parámetro Nu: Uno de los parámetros clave de NuSVC es el parámetro Nu (nu), que controla la complejidad del modelo y determina la proporción de la muestra que puede usarse como vectores de soporte y errores. El valor de Nu está comprendido entre 0 y 1, donde 0,5 significa que aproximadamente la mitad de la muestra se utilizará como vectores de referencia y errores.

- Selección de parámetros: Determinar los valores óptimos del parámetro Nu y otros hiperparámetros puede requerir validación cruzada y encontrar los mejores valores en los datos de entrenamiento.

- Funciones de núcleo: El SVC puede usar varias funciones de núcleo, como la lineal, la función de base radial (RBF), la polinómica y otras. La función de núcleo define el modo en que se transforma el espacio de características para encontrar el hiperplano de separación.

Ventajas de NuSVC:

- Eficiencia en espacios multidimensionales: NuSVC puede trabajar eficientemente en espacios de alta dimensionalidad, lo que lo hace adecuado para tareas con un gran número de características.

- Resistencia a los valores atípicos: SVM y NuSVC en particular son fiables respecto a los valores atípicos en los datos debido al uso de vectores de soporte.

- Control de la complejidad del modelo: El parámetro Nu nos permite controlar la complejidad del modelo y gestionar el equilibrio entre el ajuste a los datos y la capacidad de generalización.

- Buena capacidad de generalización. SVM y NuSVC, en particular, tienen una buena capacidad de generalización, lo cual permite obtener buenos resultados en datos nuevos, no vistos previamente.

Limitaciones de NuSVC:

- Ineficacia con grandes cantidades de datos: NuSVC puede resultar ineficaz en el entrenamiento con grandes cantidades de datos debido a la complejidad computacional.

- Necesidad de seleccionar parámetros: Configurar los parámetros Nu y la función de núcleo puede conllevar tiempo y recursos informáticos.

- Linealidad de la función de núcleo: La eficiencia de NuSVC puede depender en gran medida de la elección de la función del núcleo, y para algunas tareas puede que tengamos que experimentar con diferentes funciones.

- Dificultad de interpretación: SVM y NuSVC ofrecen buenos resultados, pero sus modelos pueden ser difíciles de interpretar, especialmente cuando se utilizan núcleos no lineales.

Nu-Support Vector Classification (NuSVC) es un potente método de clasificación basado en SVM que presenta varias ventajas, como la robustez frente a valores atípicos y su buena capacidad de generalización. No obstante, su eficacia puede depender de la elección de los parámetros y de la función de núcleo, y puede no resultar eficaz en entrenamientos con grandes cantidades de datos. Resulta importante elegir cuidadosamente los parámetros del método y adaptarlo a las tareas específicas de clasificación.

2.3.1. Código de creación del modelo NuSVC Classifier

Este código demuestra el proceso de entrenamiento del modelo NuSVC Classifier con el Iris dataset, exportándolo al formato ONNX, y realizando una clasificación que usa el modelo ONNX. También evalúa la precisión tanto del modelo original como del modelo ONNX.

# Iris_NuSVC.py # The code demonstrates the process of training NuSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import NuSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a NuSVC model nusvc_model = NuSVC(nu=0.5, kernel='linear') # train the model on the entire dataset nusvc_model.fit(X, y) # predict classes for the entire dataset y_pred = nusvc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of NuSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(nusvc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "nusvc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of NuSVC model in ONNX format:", accuracy_onnx)

Resultado:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.96 0.96 50

Python 2 0.96 0.96 0.96 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\nusvc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of LinearSVC model in ONNX format: 0.9733333333333334

2.3.2. Código en MQL5 para trabajar con el modelo NuSVC Classifier