Scikit-Learnライブラリの分類器モデルとONNXへの書き出し

技術の発展により、データ処理アルゴリズムを構築するための根本的に新しいアプローチが生まれました。以前は、それぞれの特定のタスクを解決するには、対応するアルゴリズムの明確な形式化と開発が必要でした。

機械学習では、コンピュータはデータを処理するための最良の方法を自ら見つけることを学習します。機械学習モデルは、分類タスク(クラスのセットが固定されており、特定の特徴セットが各クラスに属する確率を見つけることが目的)と回帰タスク(特定の特徴セットに基づいてターゲット変数の数値を推定することが目的)を正常に解決できます。これらの基本コンポーネントに基づいて、より複雑なデータ処理モデルを構築できます。

Scikit-learnライブラリには、分類と回帰の両方のための多数のツールがあります。特定の方法とモデルの選択は、データの特性によって異なります。異なる方法は、タスクに応じて効果が異なり、異なる結果をもたらす可能性があるためです。

プレスリリース「ONNX Runtime is now open source」では、ONNXランタイムでONNX-MLプロファイルがサポートされると主張されています。

ONNX-MLプロファイルは、機械学習(ML)モデル専用に設計されたONNXの一部です。これは、分類、回帰、クラスタリングなどのさまざまな種類のMLモデルを、ONNXをサポートするさまざまなプラットフォームや環境で使用できる便利な形式で記述および表現することを目的としています。ONNX-MLプロファイルは、機械学習モデルの送信、展開、実行を簡素化し、モデルのアクセス性と移植性を高めます。

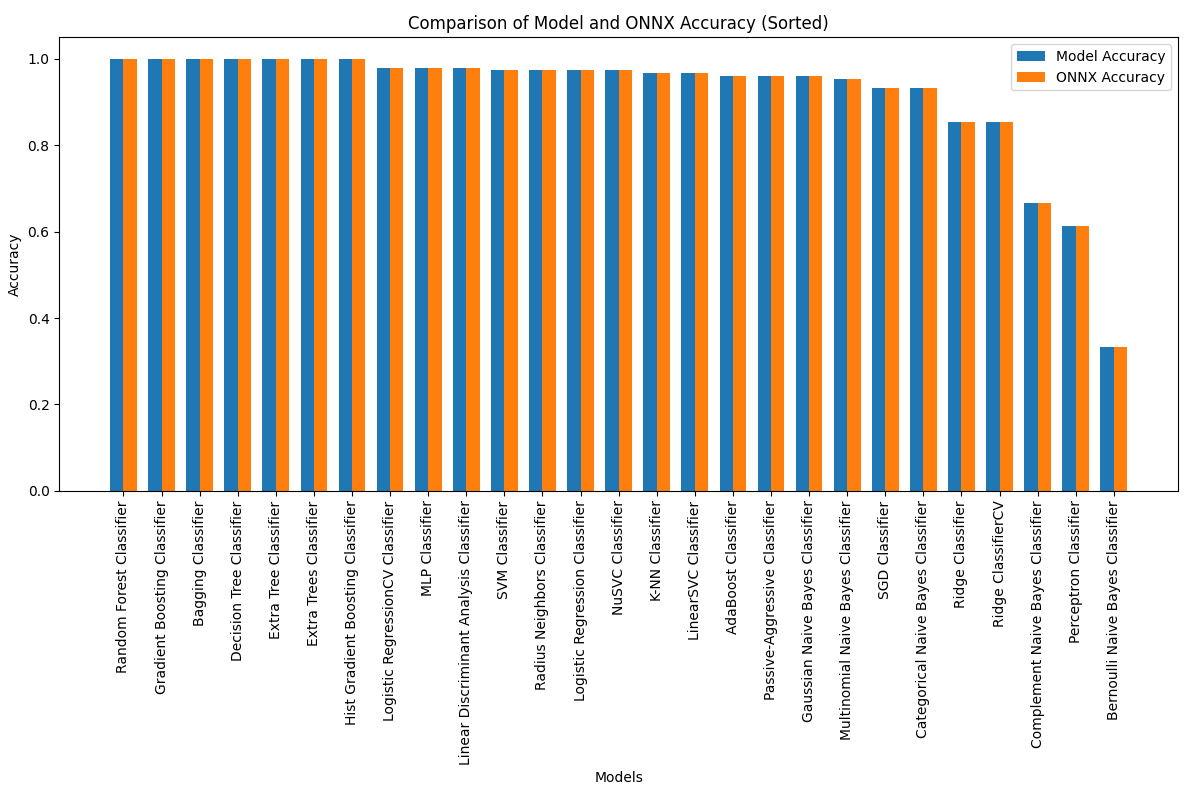

この記事では、フィッシャーのIris分類タスクを解決するために、Scikit-learnパッケージ内のすべての分類器モデルを適用する方法について説明します。また、これらのモデルをONNX形式に変換し、結果のモデルをMQL5プログラムで使用することも試みます。

さらに、完全なIrisデータセットで元のモデルとONNXバージョンの精度を比較します。

目次

- 1.フィッシャーのIris

- 2.分類器モデル

Scikit-learn分類器のリスト

モデルの異なる出力表現 iris.mqh - 2.1.SVC分類器

2.1.1.SVC分類器モデルを作成するためのコード

2.1.2.SVC分類器モデルを操作するためのMQL5コード

2.1.3.SVC分類器モデルのONNX表現 - 2.2.LinearSVC分類器

2.2.1.LinearSVC分類器モデルを作成するためのコード

2.2.2.LinearSVC分類器モデルを操作するためのMQL5コード

2.2.3.LinearSVC分類器モデルのONNX表現 - 2.3.NuSVC分類器

2.3.1.NuSVC分類器モデルを作成するためのコード

2.3.2.NuSVC分類器モデルを操作するためのMQL5コード

2.3.3.NuSVC分類器モデルのONNX表現 - 2.4.RadiusNeighborsClassifier

2.4.1.RadiusNeighborsClassifierモデルを作成するためのコード

2.4.2.RadiusNeighborsClassifierモデルを操作するためのMQL5コード

2.3.3.RadiusNeighborsClassifierモデルのONNX表現 - 2.5.RidgeClassifier

2.5.1.RidgeClassifierモデルを作成するためのコード

2.5.2.RidgeClassifierモデルを操作するためのMQL5コード

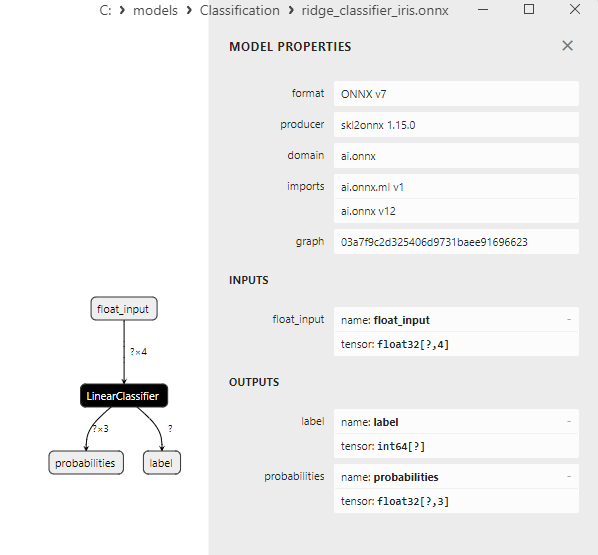

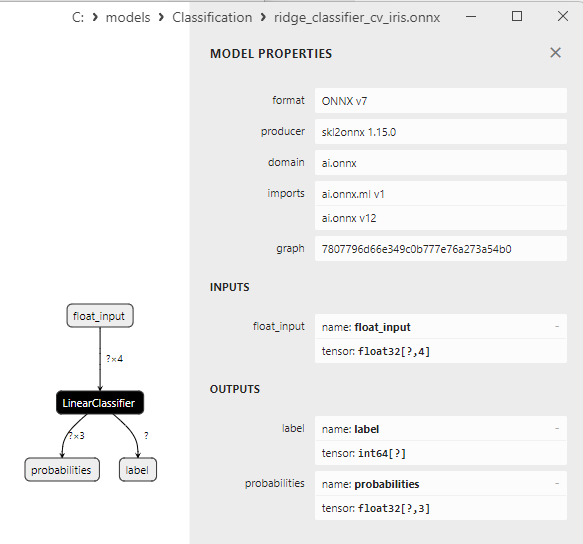

2.5.3.RidgeClassifierモデルのONNX表現 - 2.6.RidgeClassifierCV

2.6.1.RidgeClassifierCVモデルを作成するためのコード

2.6.2.RidgeClassifierCVモデルを操作するためのMQL5コード

2.6.3.RidgeClassifierCVモデルのONNX表現 - 2.7.RandomForestClassifier

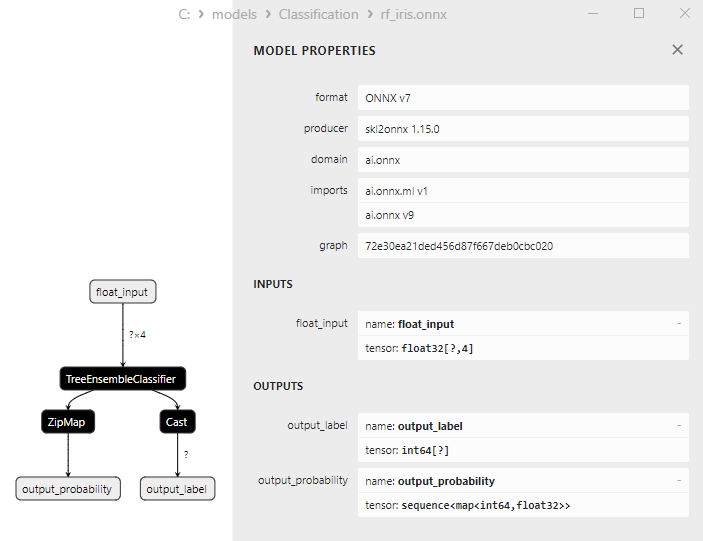

2.7.1.RandomForestClassifierモデルを作成するためのコード

2.7.2.RandomForestClassifierモデルを操作するためのMQL5コード

2.7.3.RandomForestClassifierモデルのONNX表現 - 2.8.GradientBoostingClassifier

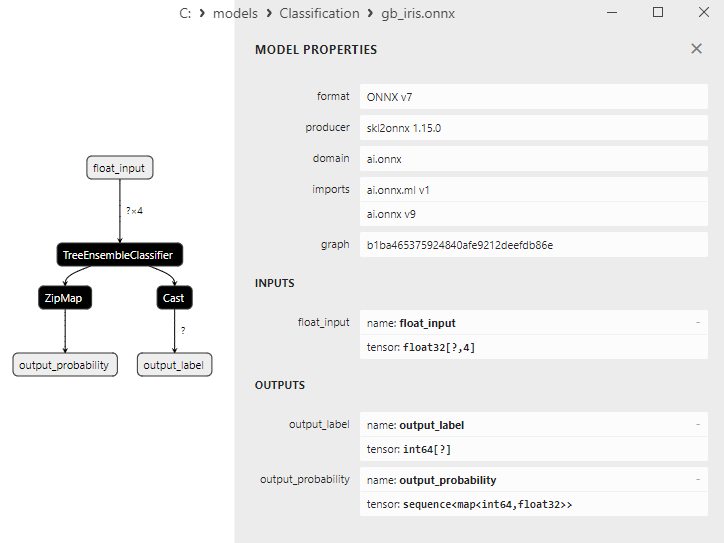

2.8.1.GradientBoostingClassifierモデルを作成するためのコード

2.8.2.GradientBoostingClassifierモデルを操作するためのMQL5コード

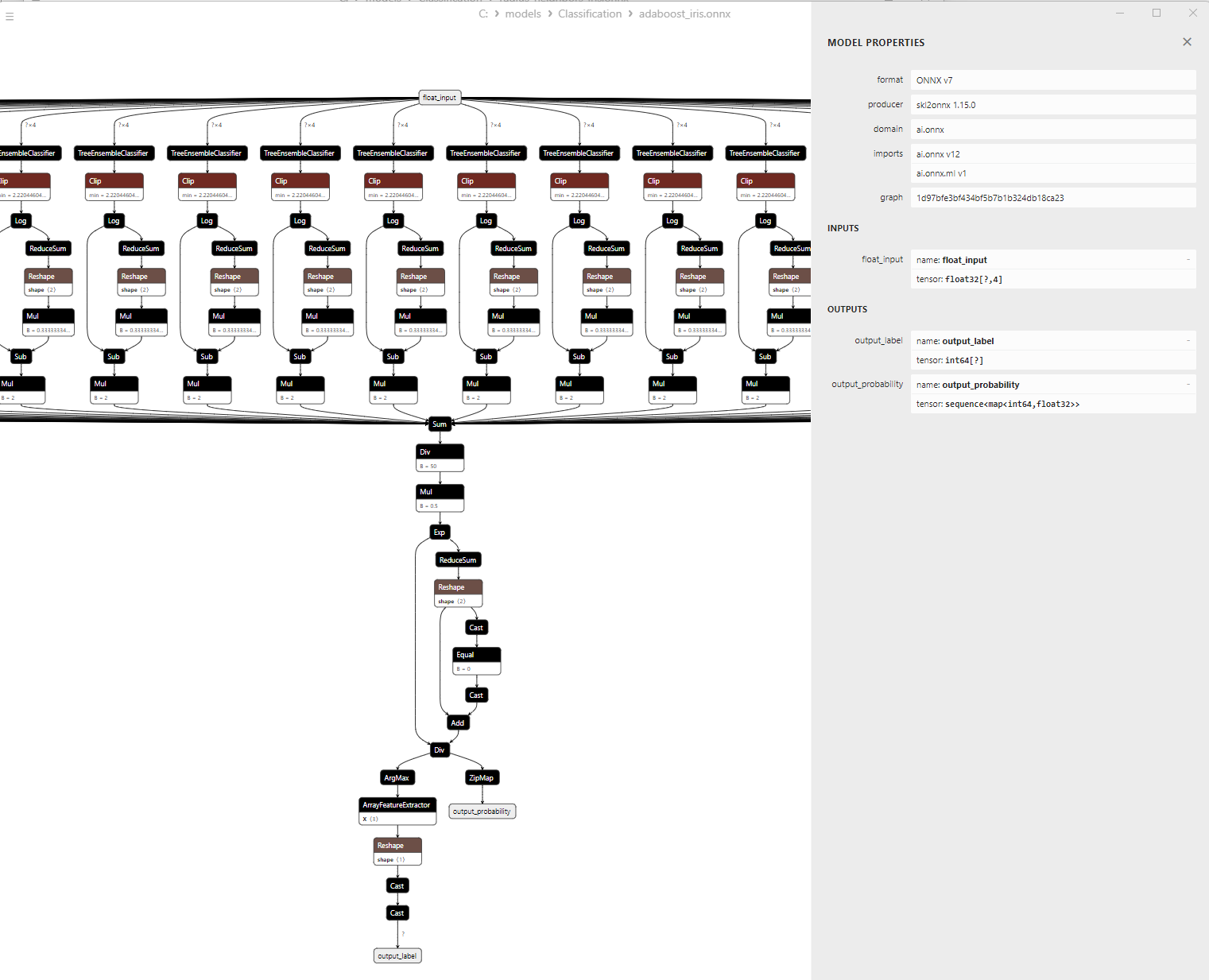

2.8.3.GradientBoostingClassifierモデルのONNX表現 - 2.9.AdaBoostClassifier

2.9.1.AdaBoostClassifierモデルを作成するためのコード

2.9.2.AdaBoostClassifierモデルを操作するためのMQL5コード

2.9.3.AdaBoostClassifierモデルのONNX表現 - 2.10.BaggingClassifier

2.10.1.BaggingClassifierモデルを作成するためのコード

2.10.2.BaggingClassifierモデルを操作するためのMQL5コード

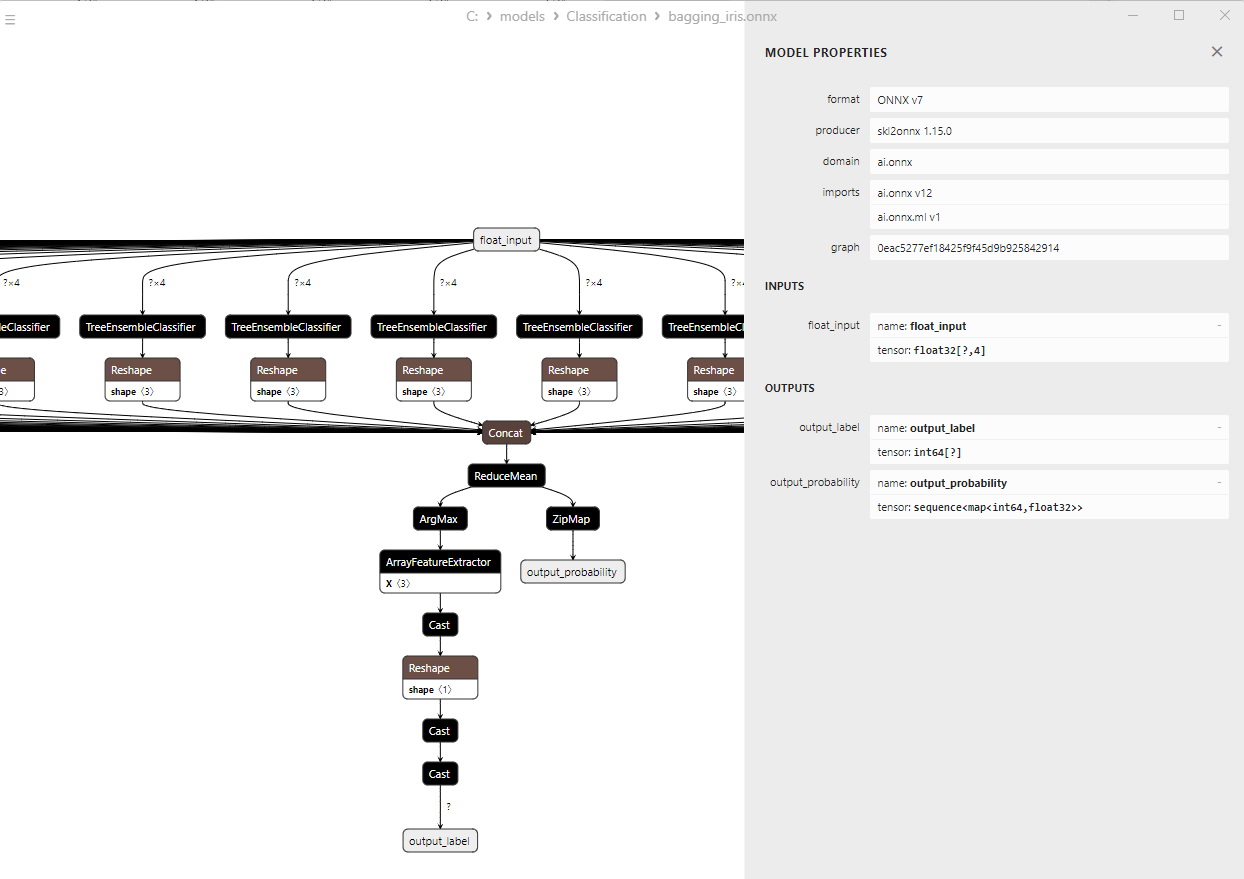

2.10.3.BaggingClassifierモデルのONNX表現 - 2.11.KNeighborsClassifier

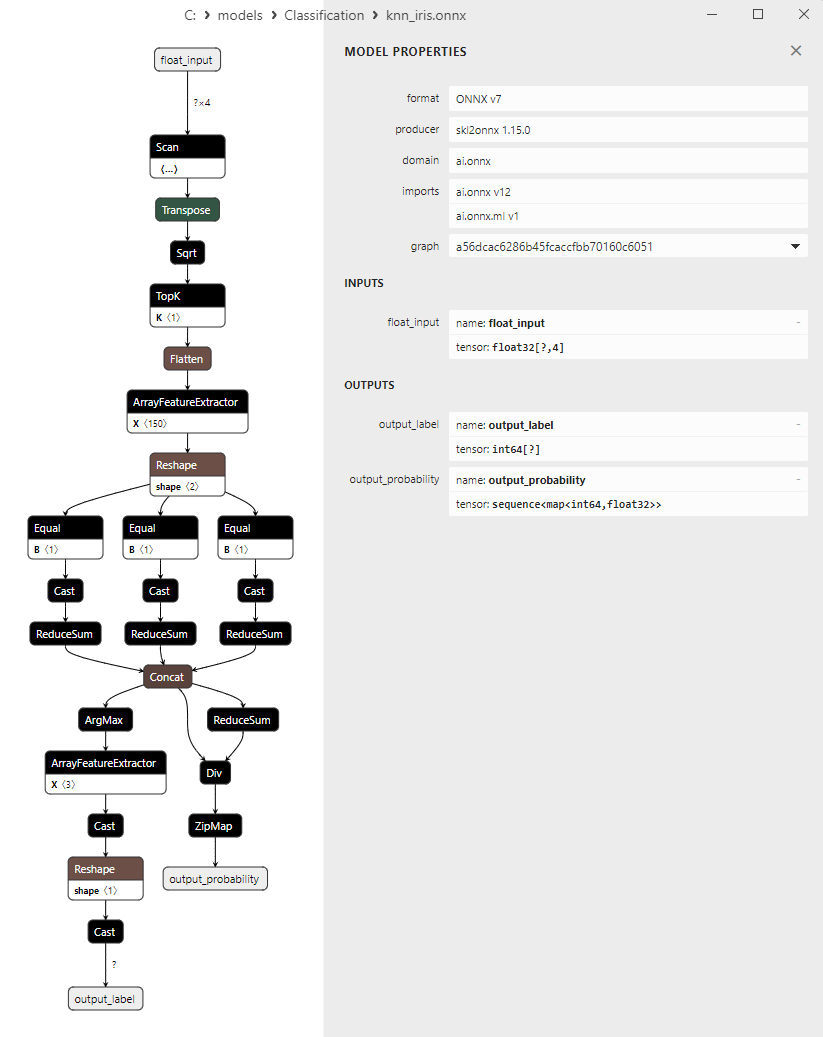

2.11.1.KNeighborsClassifierモデルを作成するためのコード

2.11.2.KNeighborsClassifierモデルを操作するためのMQL5コード

2.11.3.KNeighborsClassifierモデルのONNX表現 - 2.12.DecisionTreeClassifier

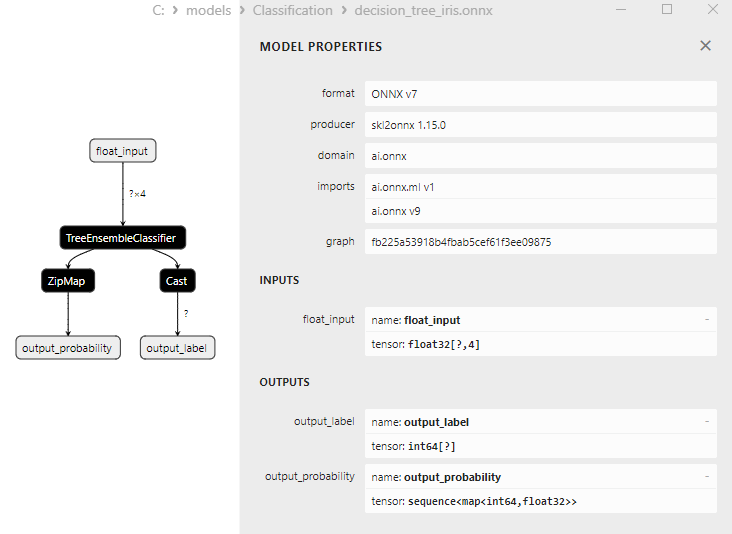

2.12.1.DecisionTreeClassifierモデルを作成するためのコード

2.12.2.DecisionTreeClassifierモデルを操作するためのMQL5コード

2.12.3.DecisionTreeClassifierモデルのONNX表現 - 2.13.LogisticRegressionClassifier

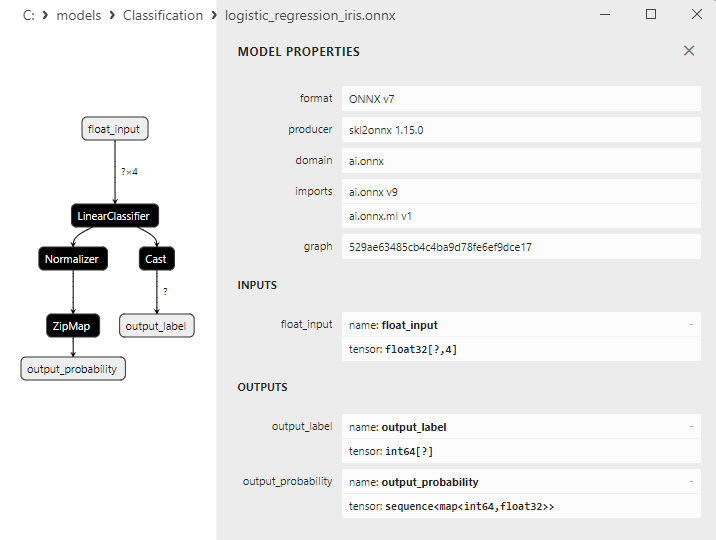

2.13.1.LogisticRegressionClassifierモデルを作成するためのコード

2.13.2.LogisticRegressionClassifierモデルを操作するためのMQL5コード

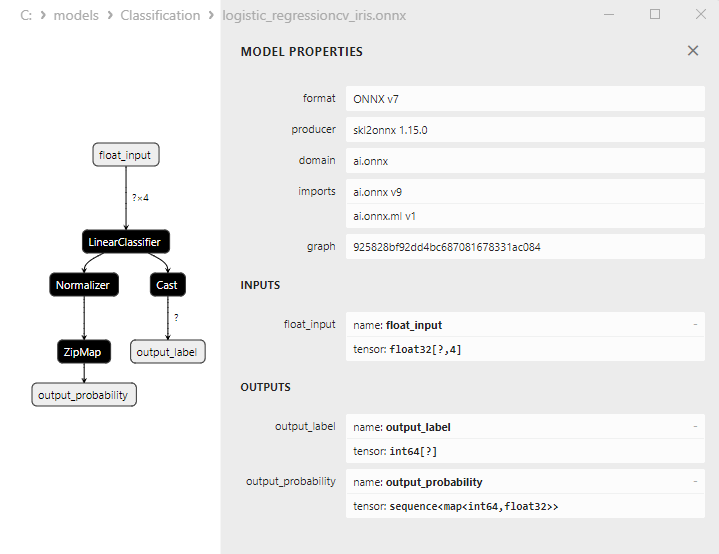

2.13.3.LogisticRegressionClassifierモデルのONNX表現 - 2.14.LogisticRegressionCV分類器

2.14.1.LogisticRegressionCV分類器モデルを作成するためのコード

2.14.2.LogisticRegressionCV分類器モデルを操作するためのMQL5コード

2.14.3.LogisticRegressionCV分類器モデルのONNX表現 - 2.15.PassiveAggressiveClassifier

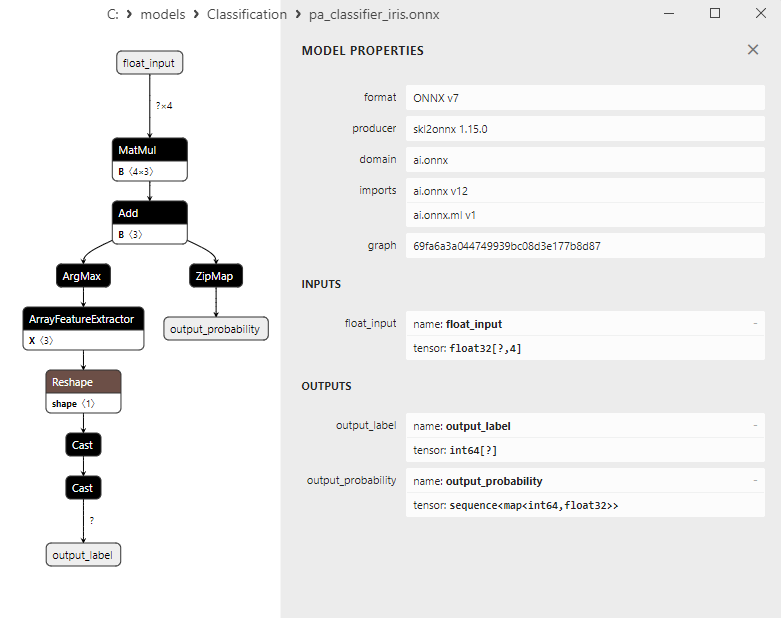

2.15.1.PassiveAggressiveClassifierモデルを作成するためのコード

2.15.2.PassiveAggressiveClassifierモデルを操作するためのMQL5コード

2.15.3.PassiveAggressiveClassifierモデルのONNX表現 - 2.16.Perceptron分類器

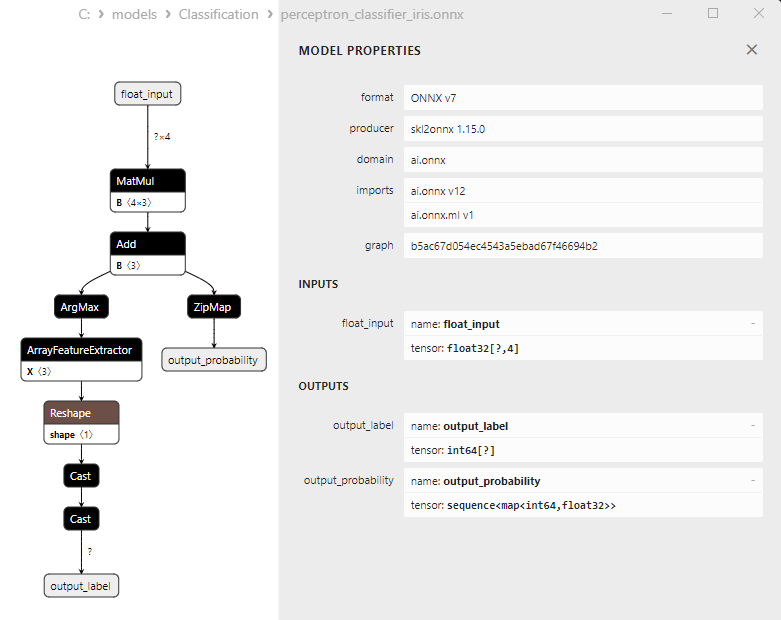

2.16.1.Perceptron分類器モデルを作成するためのコード

2.16.2.Perceptron分類器モデルを操作するためのMQL5コード

2.16.3.Perceptron分類器モデルのONNX表現 - 2.17.SGDClassifier

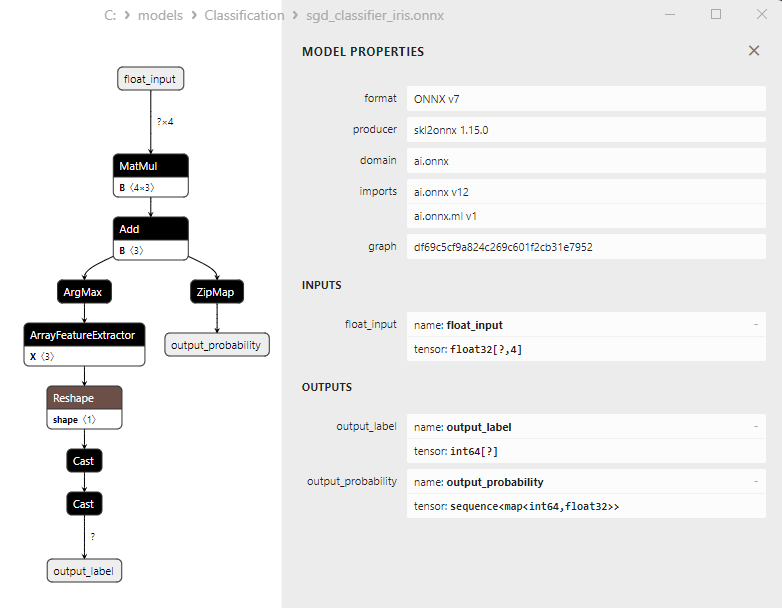

2.17.1.SGDClassifierモデルを作成するためのコード

2.17.2.SGDClassifierモデルを操作するためのMQL5コード

2.17.3.SGDClassifierモデルのONNX表現 - 2.18.GaussianNB分類器

2.18.1.GaussianNB分類器モデルを作成するためのコード

2.18.2.GaussianNB分類器モデルを操作するためのMQL5コード

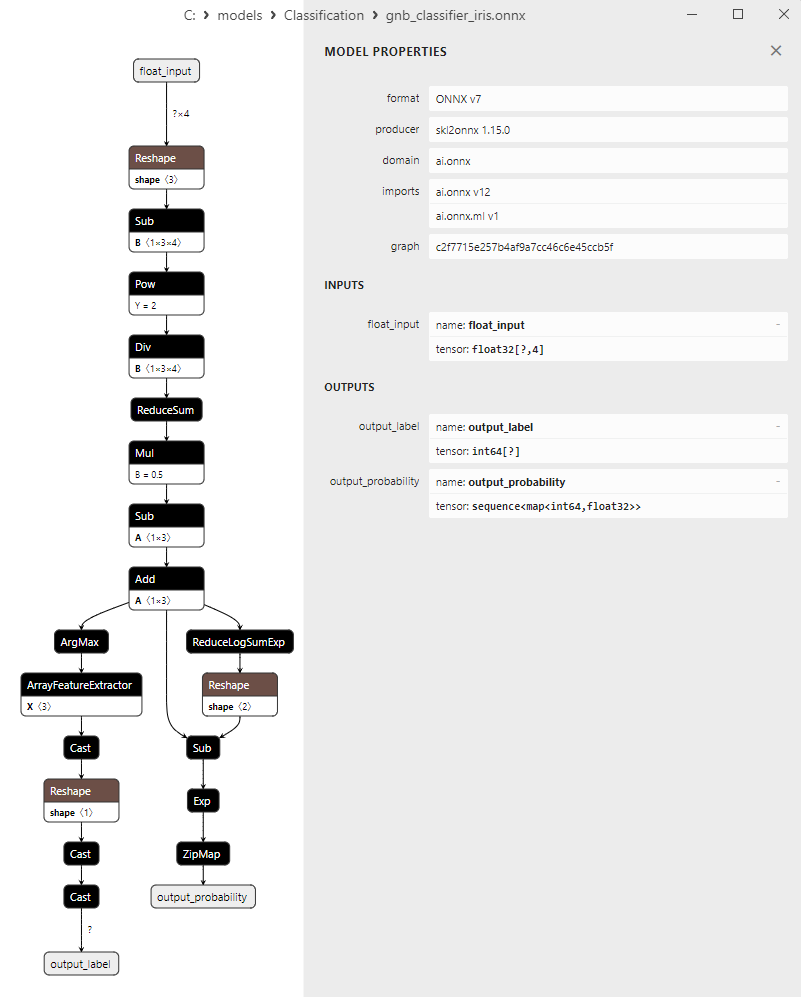

2.18.3.GaussianNB分類器モデルのONNX表現 - 2.19.MultinomialNB分類器

2.19.1.MultinomialNB分類器モデルを作成するためのコード

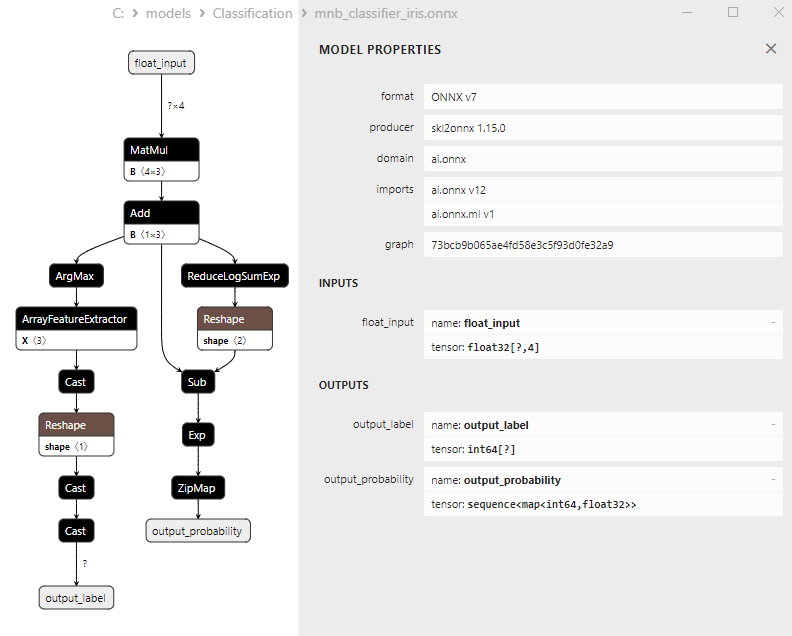

2.19.2.MultinomialNB分類器モデルを操作するためのMQL5コード

2.19.3.MultinomialNB分類器モデルのONNX表現 - 2.20.ComplementNB分類器

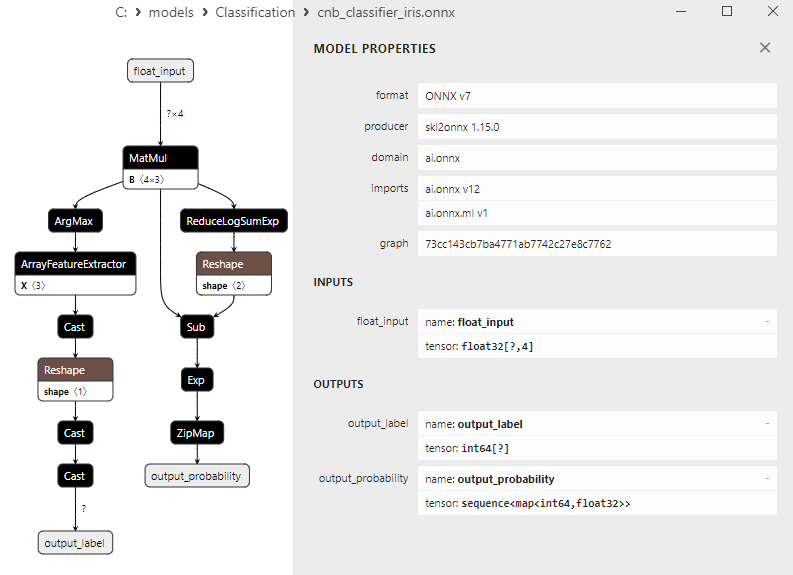

2.20.1.ComplementNB分類器モデルを作成するためのコード

2.20.2.ComplementNB分類器モデルを操作するためのMQL5コード

2.20.3.ComplementNB分類器モデルのONNX表現 - 2.21.BernoulliNB分類器

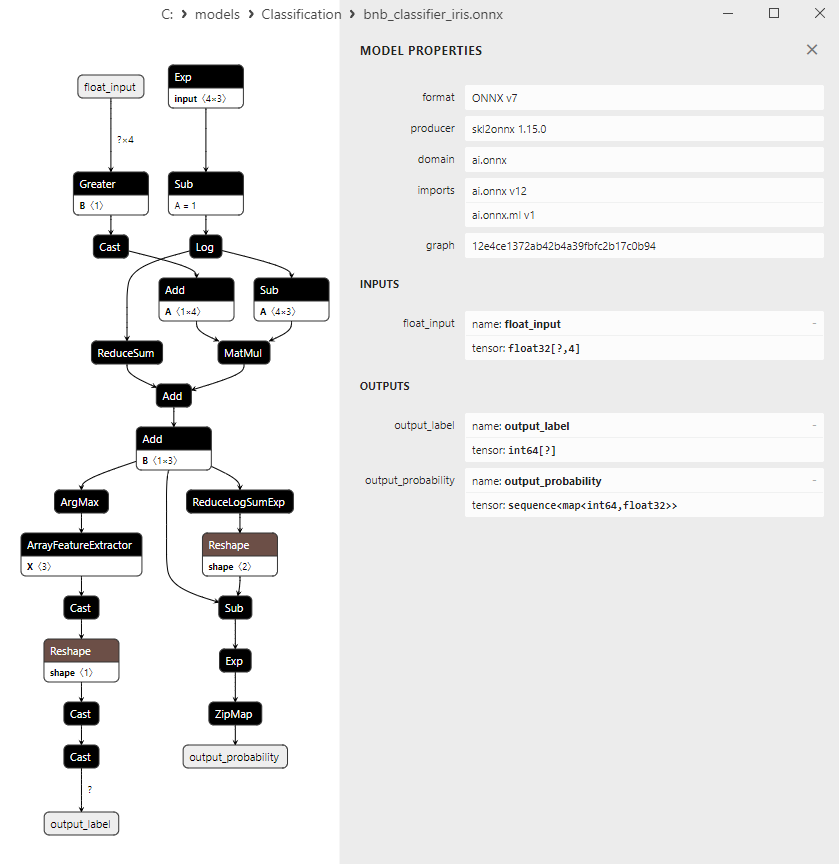

2.21.1.BernoulliNB分類器モデルを作成するためのコード

2.21.2.BernoulliNB分類器モデルを操作するためのMQL5コード

2.21.3.BernoulliNB分類器モデルのONNX表現 - 2.22.MLPClassifier

2.22.1.MLPClassifierモデルを作成するためのコード

2.22.2.MLPClassifierモデルを操作するためのMQL5コード

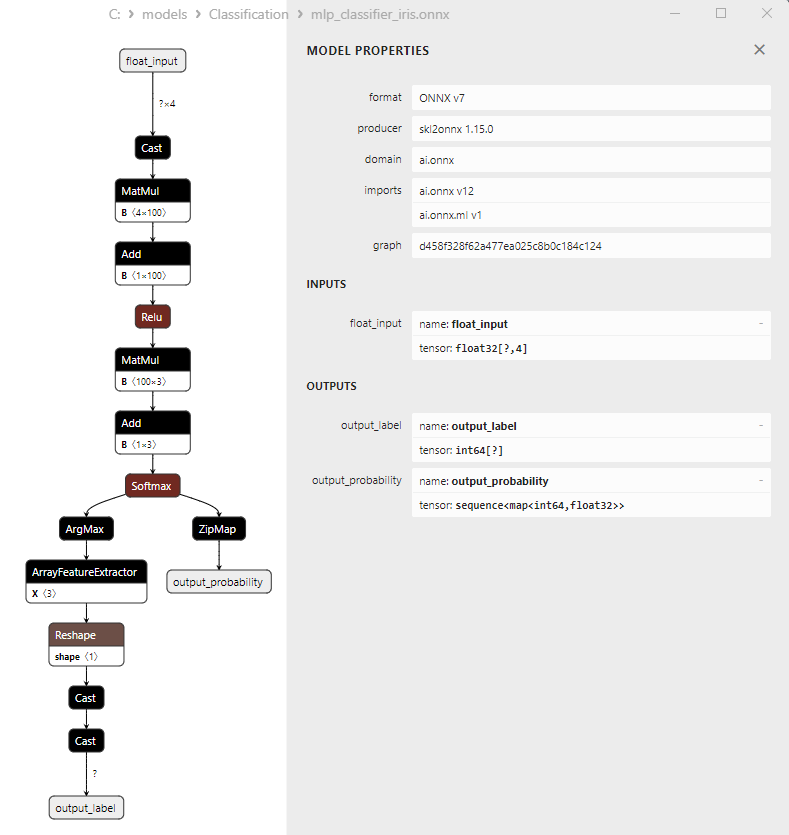

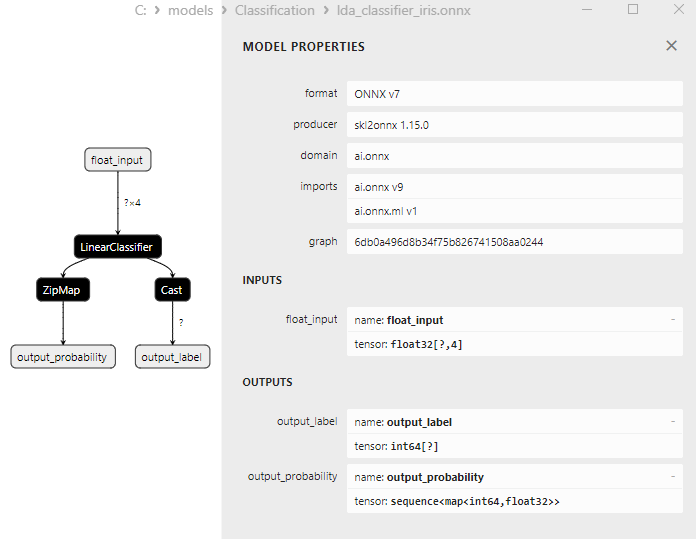

2.22.3.MLPClassifierモデルのONNX表現 - 2.23.LinearDiscriminantAnalysis分類器

2.23.1.LinearDiscriminantAnalysis分類器モデルを作成するためのコード

2.23.2.LinearDiscriminantAnalysis分類器モデルを操作するためのMQL5コード

2.23.3.LinearDiscriminantAnalysis分類器モデルのONNX表現 - 2.24.HistGradientBoostingClassifier

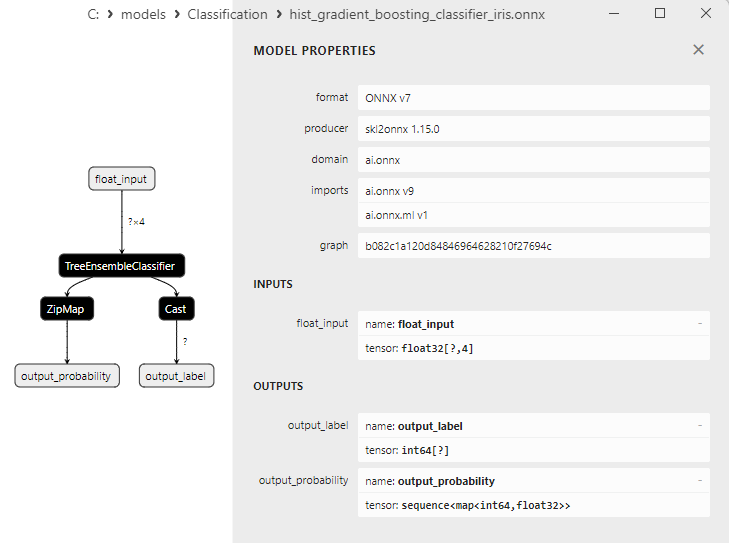

2.24.1.HistGradientBoostingClassifierモデルを作成するためのコード

2.24.2.HistGradientBoostingClassifierモデルを操作するためのMQL5コード

2.24.3.HistGradientBoostingClassifierモデルのONNX表現 - 2.25.CategoricalNB分類器

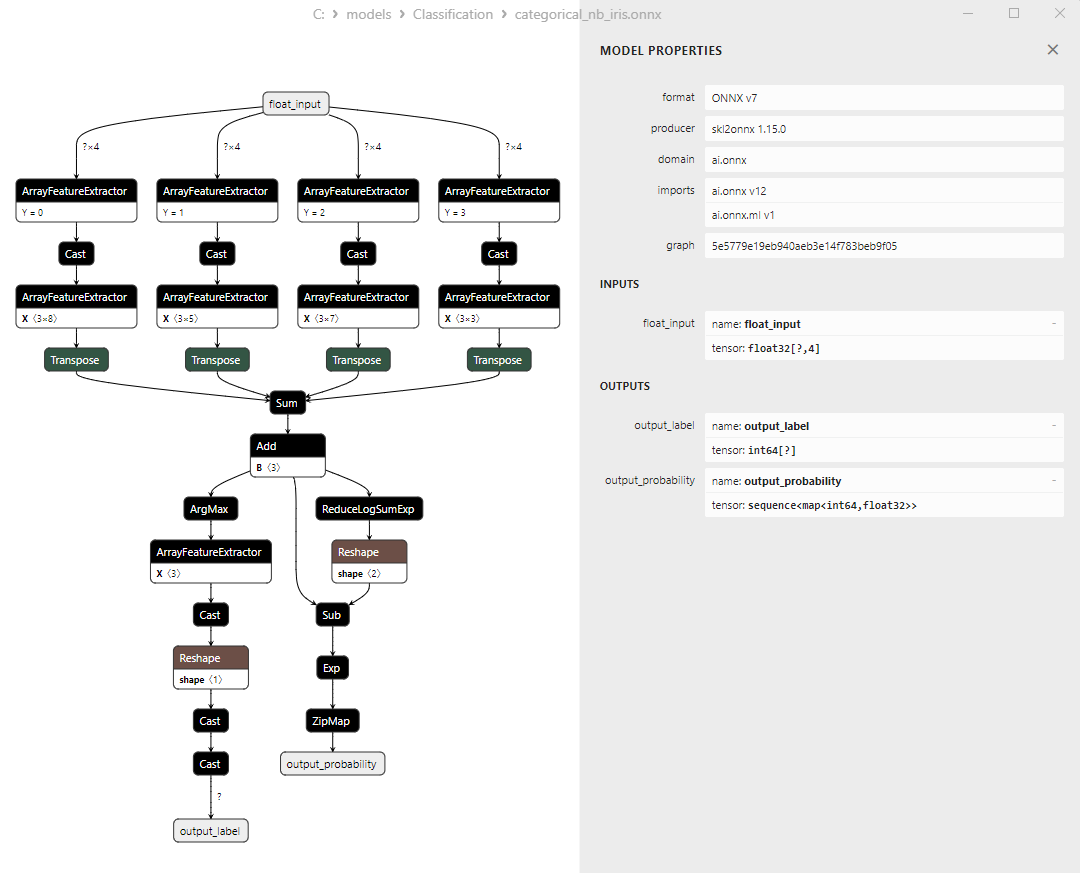

2.25.1.CategoricalNB分類器モデルを作成するためのコード

2.23.2.CategoricalNB分類器モデルを操作するためのMQL5コード

2.23.3.CategoricalNB分類器モデルのONNX表現 - 2.26.ExtraTreeClassifier

2.26.1.ExtraTreeClassifierモデルを作成するためのコード

2.26.2.ExtraTreeClassifierモデルを操作するためのMQL5コード

2.26.3.ExtraTreeClassifierモデルのONNX表現 - 2.27.ExtraTreesClassifier

2.27.1.ExtraTreesClassifierモデルを作成するためのコード

2.27.2.ExtraTreesClassifierモデルを操作するためのMQL5コード

2.27.3.ExtraTreesClassifierモデルのONNX表現 - 2.28.すべてのモデルの精度の比較

2.28.1.すべてのモデルを計算し、精度比較チャートを作成するコード

2.28.2.すべてのONNXモデルを実行するためのMQL5コード - 2.29.ONNXに変換できなかったScikit-Learn分類器モデル

- 2.29.1.DummyClassifier

2.29.1.1.DummyClassifierモデルを作成するためのコード - 2.29.2.GaussianProcessClassifier

2.29.2.1.GaussianProcessClassifierモデルを作成するためのコード - 2.29.3.LabelPropagation分類器

2.29.3.1.LabelPropagation分類器モデルを作成するためのコード - 2.29.4.LabelSpreading分類器

2.29.4.1.LabelSpreading分類器モデルを作成するためのコード - 2.29.5.NearestCentroid分類器

2.29.5.1.NearestCentroidモデルを作成するためのコード - 2.29.6.QuadraticDiscriminantAnalysis分類器

2.29.6.1.QuadraticDiscriminantAnalysisモデルを作成するためのコード - 終わりに

1.フィッシャーのIris

Irisデータセットは、機械学習の分野で最も有名で広く使用されているデータセットの1つです。1936年に統計学者かつ生物学者のR.A.フィッシャーによって紹介され、それ以来分類タスクの典型的なデータセットとなっています。

Irisデータセットは、Iris setosa、Iris virginica、Iris versicolorの3種のIrisの萼片と花弁の測定値で構成されています。

図1:Iris setosa

図2:Iris virginica

図3:Iris versicolor

Irisデータセットは、3種のIrisそれぞれ50個ずつ、合計150個のIrisのインスタンスで構成されています。各インスタンスには4つの数値特徴(センチメートル単位で測定)があります。

- 萼片の長さ

- 萼片の幅

- 花弁の長さ

- 花弁幅

各インスタンスには、Irisの種(Iris setosa、Iris virginica、またはIris versicolor)を示す対応するクラスもあります。この分類属性により、Irisデータセットは分類やクラスタリングなどの機械学習タスクに最適なデータセットになります。

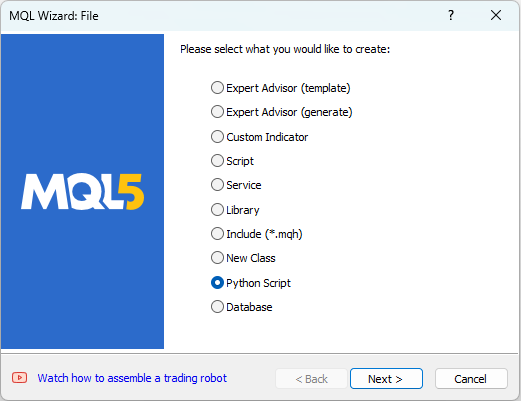

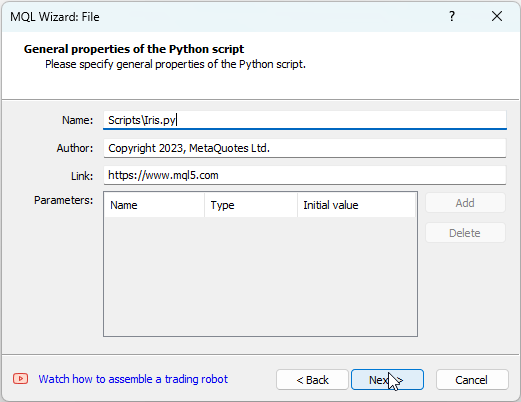

MetaEditorではPythonスクリプトを操作できます。Pythonスクリプトを作成するには、MetaEditorの「ファイル」メニューから[新規]を選択すると、作成するオブジェクトを選択するためのダイアログが表示されます(図4を参照)。

図4:MQL5ウィザードでPythonスクリプトを作成する - 手順1

次に、スクリプトの名前(例:IRIS.py)を指定します(図5を参照)。

図5:MQL5ウィザードでPythonスクリプトを作成する - 手順2 - スクリプト名

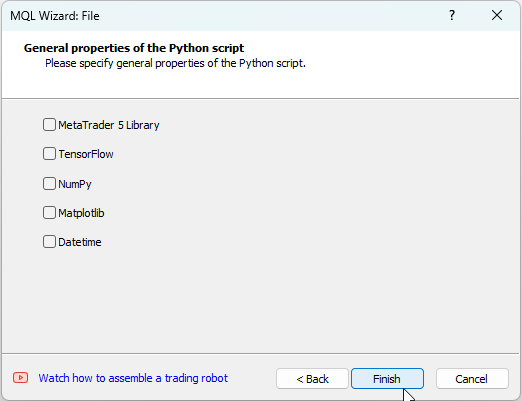

その後、使用するライブラリを指定できます。この例では、これらのフィールドは空のままにします(図6を参照)。

図6:MQL5ウィザードでPythonスクリプトを作成する - 手順3

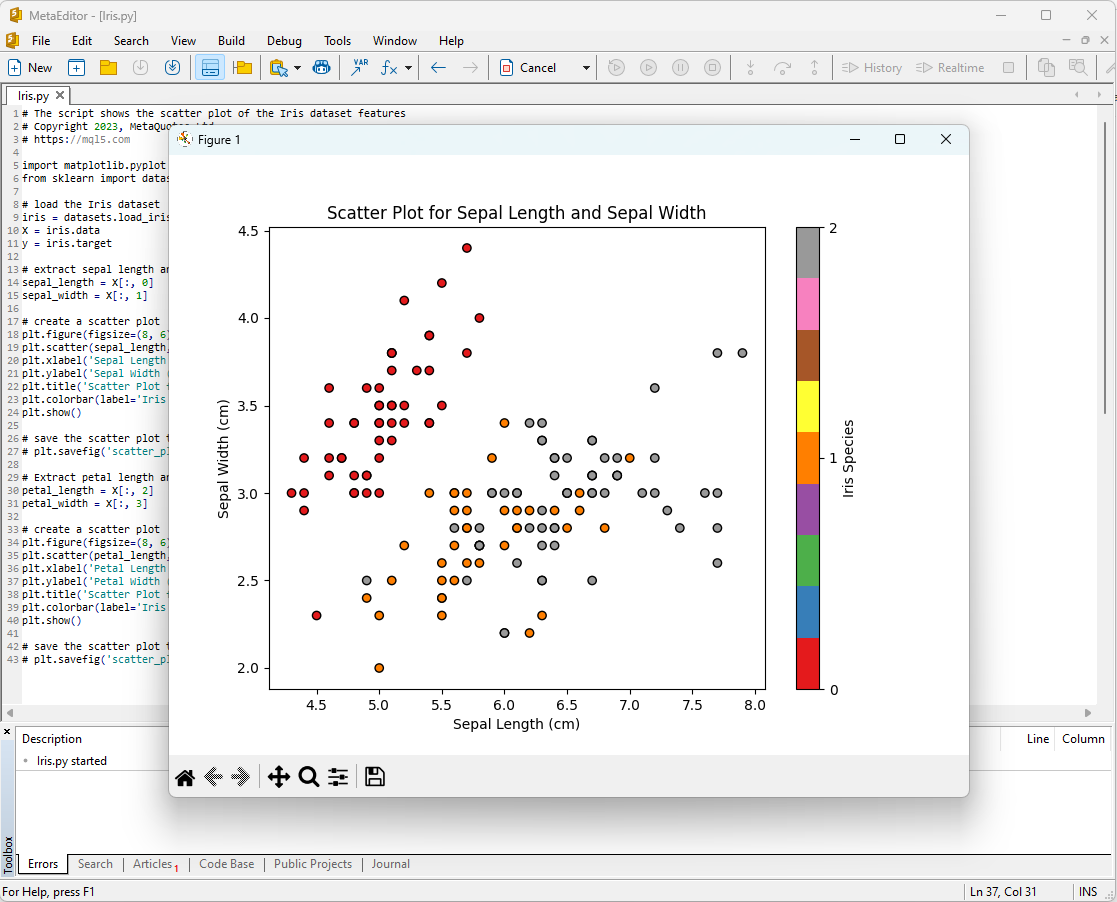

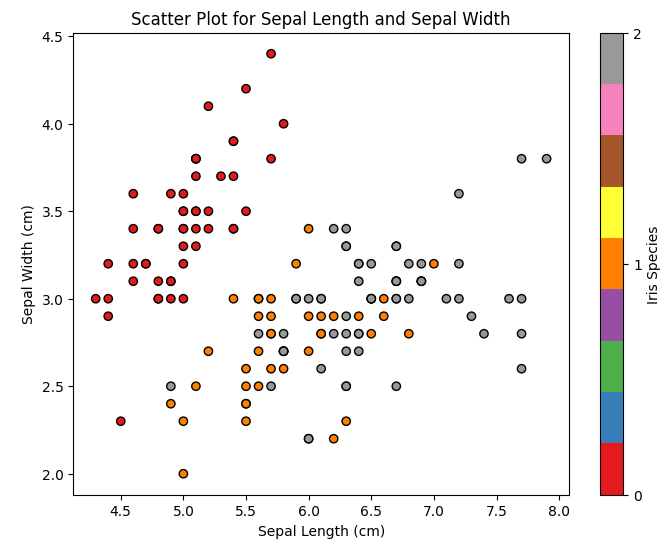

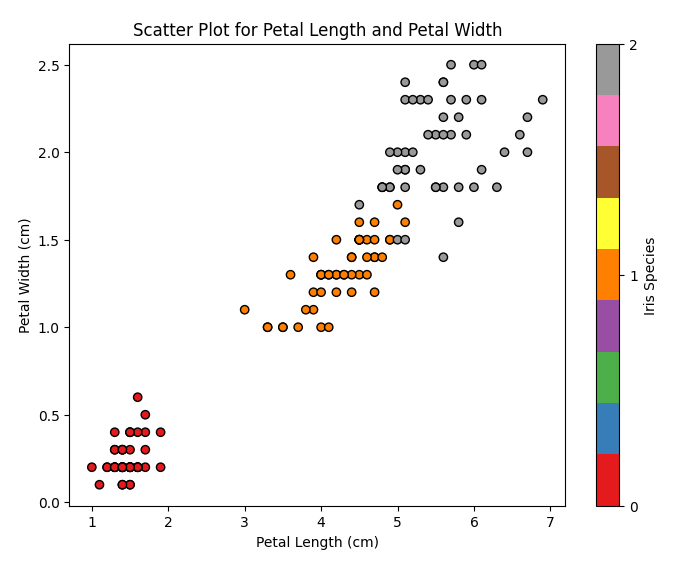

Irisデータセットの分析を開始する方法の1つは、データを視覚化することです。グラフィカルな表現により、データの構造と特徴間の関係をよりよく理解できます。

たとえば、散布図を作成して、さまざまな種類のアヤメが特徴空間内でどのように分布しているかを確認できます。

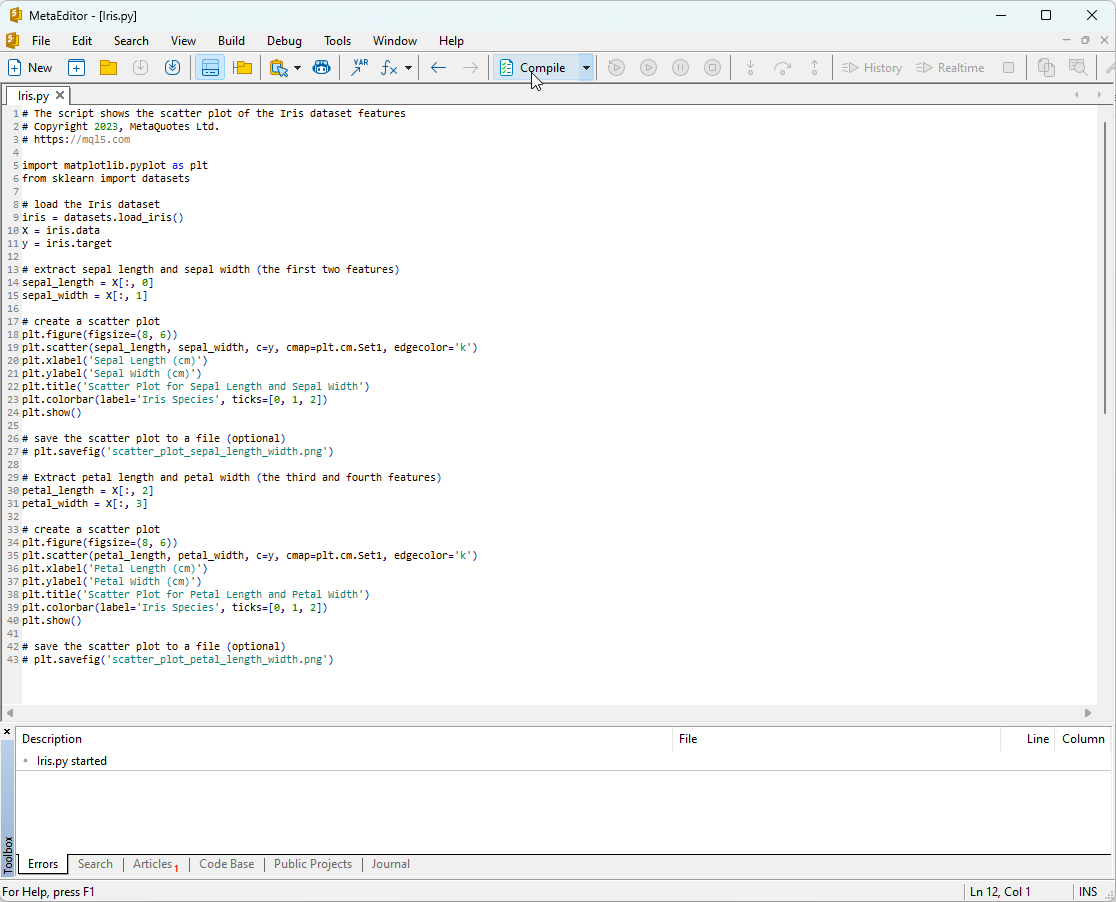

以下は、Pythonスクリプトコードです。

# The script shows the scatter plot of the Iris dataset features # Copyright 2023, MetaQuotes Ltd. # https://mql5.com import matplotlib.pyplot as plt from sklearn import datasets # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # extract sepal length and sepal width (the first two features) sepal_length = X[:, 0] sepal_width = X[:, 1] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(sepal_length, sepal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Sepal Length (cm)') plt.ylabel('Sepal Width (cm)') plt.title('Scatter Plot for Sepal Length and Sepal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_sepal_length_width.png') # Extract petal length and petal width (the third and fourth features) petal_length = X[:, 2] petal_width = X[:, 3] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(petal_length, petal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Petal Length (cm)') plt.ylabel('Petal Width (cm)') plt.title('Scatter Plot for Petal Length and Petal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_petal_length_width.png')

このスクリプトを実行するには、スクリプトをMetaEditorにコピーし(図7を参照)、[コンパイル]をクリックしてください。

図7:MetaEditorでのIRIS.pyスクリプト

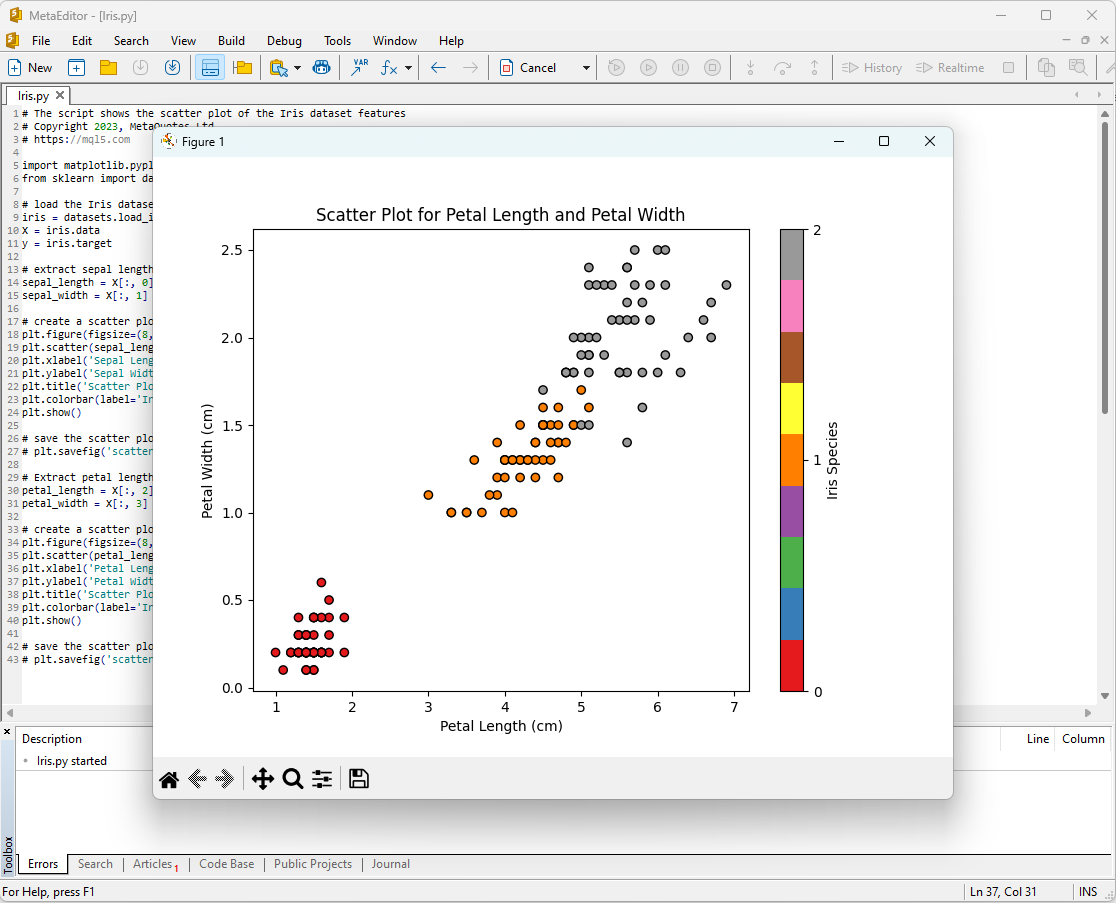

その後、プロットが画面に表示されます。

図8:萼片の長さ/萼片の幅のプロットを含むMetaEditorでのIRIS.pyスクリプト

図9:花弁の長さ/花弁の幅のプロットを含むMetaEditorでのIRIS.pyスクリプト

詳しく見てみましょう。

図10:萼片の長さと萼片の幅の散布図

この図では、萼片の長さと萼片の幅に基づいて、さまざまなアヤメの種がどのように分布しているかがわかります。Iris setosaは、他の2種と比較して、萼片が一般的に短く、幅が広いことがわかります。

図11:花弁の長さと花弁の幅の散布図

この図では、花弁の長さと幅に基づいて、さまざまなIrisの種がどのように分布しているかがわかります。Iris setosaの花弁は最も短くて幅が狭く、Iris virginicaの花弁は最も長くて幅が広く、Iris versicolorはその中間であることが分かります。

Irisデータセットは、機械学習モデルの訓練とテストに最適なデータセットです。これを使用して、分類タスクに対する機械学習モデルの有効性を分析します。

2.分類器モデル

分類は機械学習における基本的なタスクの1つであり、その目的は特定の特徴に基づいてデータをさまざまなカテゴリまたはクラスに分類することです。

scikit-learnパッケージの主な機械学習モデルを調べてみましょう。

Scikit-learn分類器のリスト

scikit-learnで利用可能な分類器のリストを表示するには、次のスクリプトを使用できます。

# ScikitLearnClassifiers.py # The script lists all the classification algorithms available in scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn classifiers from sklearn.utils import all_estimators classifiers = all_estimators(type_filter='classifier') for index, (name, ClassifierClass) in enumerate(classifiers, start=1): print(f"Classifier {index}: {name}")

出力:

Python The scikit-learn version is 1.2.2.

Python Classifier 1:AdaBoostClassifier

Python Classifier 2:BaggingClassifier

Python Classifier 3:BernoulliNB

Python Classifier 4:CalibratedClassifierCV

Python Classifier 5:CategoricalNB

Python Classifier 6:ClassifierChain

Python Classifier 7:ComplementNB

Python Classifier 8:DecisionTreeClassifier

Python Classifier 9:DummyClassifier

Python Classifier 10:ExtraTreeClassifier

Python Classifier 11:ExtraTreesClassifier

Python Classifier 12:GaussianNB

Python Classifier 13:GaussianProcessClassifier

Python Classifier 14:GradientBoostingClassifier

Python Classifier 15:HistGradientBoostingClassifier

Python Classifier 16:KNeighborsClassifier

Python Classifier 17:LabelPropagation

Python Classifier 18:LabelSpreading

Python Classifier 19:LinearDiscriminantAnalysis

Python Classifier 20:LinearSVC

Python Classifier 21:LogisticRegression

Python Classifier 22:LogisticRegressionCV

Python Classifier 23:MLPClassifier

Python Classifier 24:MultiOutputClassifier

Python Classifier 25:MultinomialNB

Python Classifier 26:NearestCentroid

Python Classifier 27:NuSVC

Python Classifier 28:OneVsOneClassifier

Python Classifier 29:OneVsRestClassifier

Python Classifier 30:OutputCodeClassifier

Python Classifier 31:PassiveAggressiveClassifier

Python Classifier 32:Perceptron

Python Classifier 33:QuadraticDiscriminantAnalysis

Python Classifier 34:RadiusNeighborsClassifier

Python Classifier 35:RandomForestClassifier

Python Classifier 36:RidgeClassifier

Python Classifier 37:RidgeClassifierCV

Python Classifier 38:SGDClassifier

Python Classifier 39:SVC

Python Classifier 40:StackingClassifier

Python Classifier 41:VotingClassifier

便宜上、この分類器のリストでは、分類器が異なる色で強調表示されています。黄色で強調表示されているのは基本分類器を必要とするモデルです。他のモデルは独立して使用できます。

今後、緑色のモデルはONNX形式に正常に書き出されているのに対し、赤色のモデルは現在のバージョンのscikit-learn1.2.2で変換中にエラーが発生する点に注目してください。

モデルにおける出力データの異なる表現

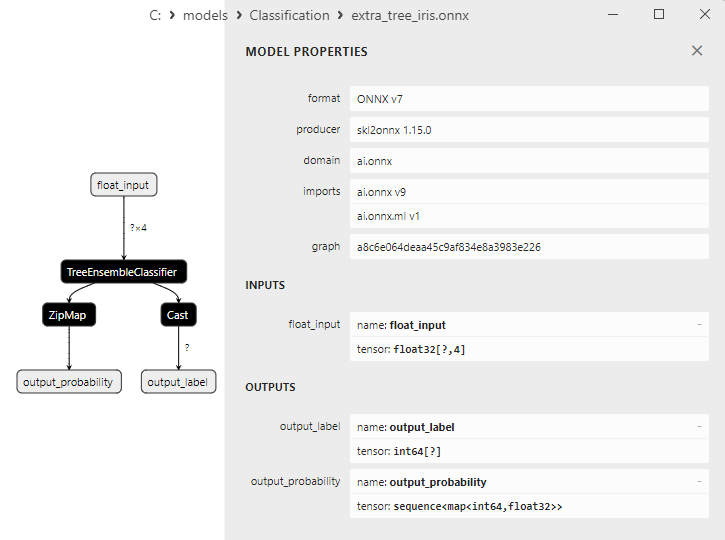

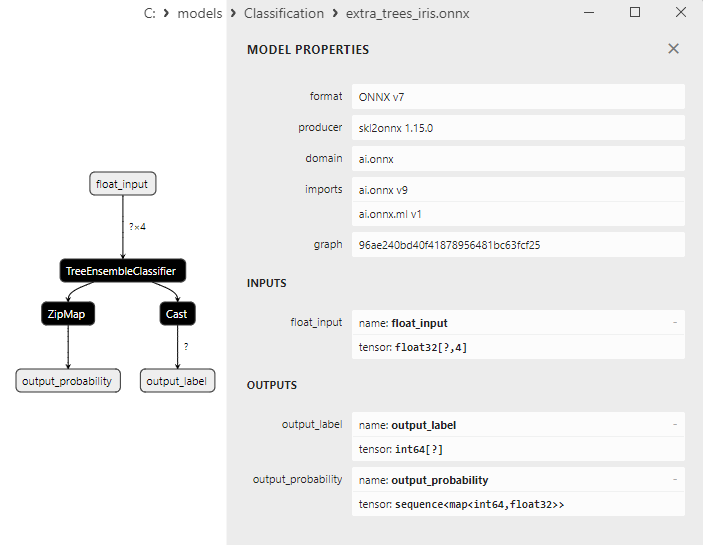

モデルによって出力データの表現方法が異なるため、ONNXに変換されたモデルを扱う場合は注意が必要です。

フィッシャーのIris分類タスクの場合、入力テンソルはこれらすべてのモデルに対して同じ形式になります。

1.名前:float_input、データ型:tensor(float)、形状:[なし、4]

ONNXモデルの出力テンソルは異なります。

1.後処理を必要としないモデル

- SVC分類器

- LinearSVC分類器

- NuSVC分類器

- RadiusNeighborsClassifier

- RidgeClassifier

- RidgeClassifierCV

1.名前:label、データ型:tensor(int64)、形状:[なし]

2.名前:probabilities、データ型:tensor(float)、形状:[なし、3]

これらのモデルは、後処理を必要とせずに、最初の出力整数テンソル「label」で結果(クラス番号)を明示的に返します。

2.結果に後処理が必要なモデル

- RandomForestClassifier

- GradientBoostingClassifier

- AdaBoostClassifier

- BaggingClassifier

- KNeighborsClassifier

- DecisionTreeClassifier

- LogisticRegression分類器

- LogisticRegressionCV分類器

- PassiveAggressiveClassifier

- Perceptron分類器

- SGD分類器

- GaussianNB分類器

- MultinomialNB分類器

- ComplementNB分類器

- BernoulliNB分類器

- MLPClassifier

- LinearDiscriminantAnalysis分類器

- HistGradientBoostingClassifier

- CategoricalNB分類器

- ExtraTreeClassifier

- ExtraTreesClassifier

1.名前:output_label、データ型:tensor(int64)、形状:[なし]

2.名前:output_probability、データ型: seq(map(int64,tensor(float)))、形状:[]

これらのモデルは、クラスのリストと各クラスに属する確率を返します。

このような場合に結果を得るには、seq(map(int64,tensor(float))(最も確率の高い要素を見つける)などの後処理が必要です。

したがって、ONNXモデルを使用するときは、これらの側面に注意して考慮することが重要です。異なる結果処理の例は、2.28.2.1のスクリプトに示されています。

iris.mqh

MQL5の完全なIrisデータセットでモデルをテストするには、データの準備が必要です。この目的のために、関数PrepareIrisDataset()が使用されます。

これらの関数をiris.mqhファイルに移動すると便利です。

//+------------------------------------------------------------------+ //| Iris.mqh | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" //+------------------------------------------------------------------+ //| Structure for the IRIS Dataset sample | //+------------------------------------------------------------------+ struct sIRISsample { int sample_id; // sample id (1-150) double features[4]; // SepalLengthCm,SepalWidthCm,PetalLengthCm,PetalWidthCm string class_name; // class ("Iris-setosa","Iris-versicolor","Iris-virginica") int class_id; // class id (0,1,2), calculated by function IRISClassID }; //--- Iris dataset sIRISsample ExtIRISDataset[]; int Exttotal=0; //+------------------------------------------------------------------+ //| Returns class id by class name | //+------------------------------------------------------------------+ int IRISClassID(string class_name) { //--- if(class_name=="Iris-setosa") return(0); else if(class_name=="Iris-versicolor") return(1); else if(class_name=="Iris-virginica") return(2); //--- return(-1); } //+------------------------------------------------------------------+ //| AddSample | //+------------------------------------------------------------------+ bool AddSample(const int Id,const double SepalLengthCm,const double SepalWidthCm,const double PetalLengthCm,const double PetalWidthCm, const string Species) { //--- ExtIRISDataset[Exttotal].sample_id=Id; //--- ExtIRISDataset[Exttotal].features[0]=SepalLengthCm; ExtIRISDataset[Exttotal].features[1]=SepalWidthCm; ExtIRISDataset[Exttotal].features[2]=PetalLengthCm; ExtIRISDataset[Exttotal].features[3]=PetalWidthCm; //--- ExtIRISDataset[Exttotal].class_name=Species; ExtIRISDataset[Exttotal].class_id=IRISClassID(Species); //--- Exttotal++; //--- return(true); } //+------------------------------------------------------------------+ //| Prepare Iris Dataset | //+------------------------------------------------------------------+ bool PrepareIrisDataset(sIRISsample &iris_samples[]) { ArrayResize(ExtIRISDataset,150); Exttotal=0; //--- AddSample(1,5.1,3.5,1.4,0.2,"Iris-setosa"); AddSample(2,4.9,3.0,1.4,0.2,"Iris-setosa"); AddSample(3,4.7,3.2,1.3,0.2,"Iris-setosa"); AddSample(4,4.6,3.1,1.5,0.2,"Iris-setosa"); AddSample(5,5.0,3.6,1.4,0.2,"Iris-setosa"); AddSample(6,5.4,3.9,1.7,0.4,"Iris-setosa"); AddSample(7,4.6,3.4,1.4,0.3,"Iris-setosa"); AddSample(8,5.0,3.4,1.5,0.2,"Iris-setosa"); AddSample(9,4.4,2.9,1.4,0.2,"Iris-setosa"); AddSample(10,4.9,3.1,1.5,0.1,"Iris-setosa"); AddSample(11,5.4,3.7,1.5,0.2,"Iris-setosa"); AddSample(12,4.8,3.4,1.6,0.2,"Iris-setosa"); AddSample(13,4.8,3.0,1.4,0.1,"Iris-setosa"); AddSample(14,4.3,3.0,1.1,0.1,"Iris-setosa"); AddSample(15,5.8,4.0,1.2,0.2,"Iris-setosa"); AddSample(16,5.7,4.4,1.5,0.4,"Iris-setosa"); AddSample(17,5.4,3.9,1.3,0.4,"Iris-setosa"); AddSample(18,5.1,3.5,1.4,0.3,"Iris-setosa"); AddSample(19,5.7,3.8,1.7,0.3,"Iris-setosa"); AddSample(20,5.1,3.8,1.5,0.3,"Iris-setosa"); AddSample(21,5.4,3.4,1.7,0.2,"Iris-setosa"); AddSample(22,5.1,3.7,1.5,0.4,"Iris-setosa"); AddSample(23,4.6,3.6,1.0,0.2,"Iris-setosa"); AddSample(24,5.1,3.3,1.7,0.5,"Iris-setosa"); AddSample(25,4.8,3.4,1.9,0.2,"Iris-setosa"); AddSample(26,5.0,3.0,1.6,0.2,"Iris-setosa"); AddSample(27,5.0,3.4,1.6,0.4,"Iris-setosa"); AddSample(28,5.2,3.5,1.5,0.2,"Iris-setosa"); AddSample(29,5.2,3.4,1.4,0.2,"Iris-setosa"); AddSample(30,4.7,3.2,1.6,0.2,"Iris-setosa"); AddSample(31,4.8,3.1,1.6,0.2,"Iris-setosa"); AddSample(32,5.4,3.4,1.5,0.4,"Iris-setosa"); AddSample(33,5.2,4.1,1.5,0.1,"Iris-setosa"); AddSample(34,5.5,4.2,1.4,0.2,"Iris-setosa"); AddSample(35,4.9,3.1,1.5,0.2,"Iris-setosa"); AddSample(36,5.0,3.2,1.2,0.2,"Iris-setosa"); AddSample(37,5.5,3.5,1.3,0.2,"Iris-setosa"); AddSample(38,4.9,3.6,1.4,0.1,"Iris-setosa"); AddSample(39,4.4,3.0,1.3,0.2,"Iris-setosa"); AddSample(40,5.1,3.4,1.5,0.2,"Iris-setosa"); AddSample(41,5.0,3.5,1.3,0.3,"Iris-setosa"); AddSample(42,4.5,2.3,1.3,0.3,"Iris-setosa"); AddSample(43,4.4,3.2,1.3,0.2,"Iris-setosa"); AddSample(44,5.0,3.5,1.6,0.6,"Iris-setosa"); AddSample(45,5.1,3.8,1.9,0.4,"Iris-setosa"); AddSample(46,4.8,3.0,1.4,0.3,"Iris-setosa"); AddSample(47,5.1,3.8,1.6,0.2,"Iris-setosa"); AddSample(48,4.6,3.2,1.4,0.2,"Iris-setosa"); AddSample(49,5.3,3.7,1.5,0.2,"Iris-setosa"); AddSample(50,5.0,3.3,1.4,0.2,"Iris-setosa"); AddSample(51,7.0,3.2,4.7,1.4,"Iris-versicolor"); AddSample(52,6.4,3.2,4.5,1.5,"Iris-versicolor"); AddSample(53,6.9,3.1,4.9,1.5,"Iris-versicolor"); AddSample(54,5.5,2.3,4.0,1.3,"Iris-versicolor"); AddSample(55,6.5,2.8,4.6,1.5,"Iris-versicolor"); AddSample(56,5.7,2.8,4.5,1.3,"Iris-versicolor"); AddSample(57,6.3,3.3,4.7,1.6,"Iris-versicolor"); AddSample(58,4.9,2.4,3.3,1.0,"Iris-versicolor"); AddSample(59,6.6,2.9,4.6,1.3,"Iris-versicolor"); AddSample(60,5.2,2.7,3.9,1.4,"Iris-versicolor"); AddSample(61,5.0,2.0,3.5,1.0,"Iris-versicolor"); AddSample(62,5.9,3.0,4.2,1.5,"Iris-versicolor"); AddSample(63,6.0,2.2,4.0,1.0,"Iris-versicolor"); AddSample(64,6.1,2.9,4.7,1.4,"Iris-versicolor"); AddSample(65,5.6,2.9,3.6,1.3,"Iris-versicolor"); AddSample(66,6.7,3.1,4.4,1.4,"Iris-versicolor"); AddSample(67,5.6,3.0,4.5,1.5,"Iris-versicolor"); AddSample(68,5.8,2.7,4.1,1.0,"Iris-versicolor"); AddSample(69,6.2,2.2,4.5,1.5,"Iris-versicolor"); AddSample(70,5.6,2.5,3.9,1.1,"Iris-versicolor"); AddSample(71,5.9,3.2,4.8,1.8,"Iris-versicolor"); AddSample(72,6.1,2.8,4.0,1.3,"Iris-versicolor"); AddSample(73,6.3,2.5,4.9,1.5,"Iris-versicolor"); AddSample(74,6.1,2.8,4.7,1.2,"Iris-versicolor"); AddSample(75,6.4,2.9,4.3,1.3,"Iris-versicolor"); AddSample(76,6.6,3.0,4.4,1.4,"Iris-versicolor"); AddSample(77,6.8,2.8,4.8,1.4,"Iris-versicolor"); AddSample(78,6.7,3.0,5.0,1.7,"Iris-versicolor"); AddSample(79,6.0,2.9,4.5,1.5,"Iris-versicolor"); AddSample(80,5.7,2.6,3.5,1.0,"Iris-versicolor"); AddSample(81,5.5,2.4,3.8,1.1,"Iris-versicolor"); AddSample(82,5.5,2.4,3.7,1.0,"Iris-versicolor"); AddSample(83,5.8,2.7,3.9,1.2,"Iris-versicolor"); AddSample(84,6.0,2.7,5.1,1.6,"Iris-versicolor"); AddSample(85,5.4,3.0,4.5,1.5,"Iris-versicolor"); AddSample(86,6.0,3.4,4.5,1.6,"Iris-versicolor"); AddSample(87,6.7,3.1,4.7,1.5,"Iris-versicolor"); AddSample(88,6.3,2.3,4.4,1.3,"Iris-versicolor"); AddSample(89,5.6,3.0,4.1,1.3,"Iris-versicolor"); AddSample(90,5.5,2.5,4.0,1.3,"Iris-versicolor"); AddSample(91,5.5,2.6,4.4,1.2,"Iris-versicolor"); AddSample(92,6.1,3.0,4.6,1.4,"Iris-versicolor"); AddSample(93,5.8,2.6,4.0,1.2,"Iris-versicolor"); AddSample(94,5.0,2.3,3.3,1.0,"Iris-versicolor"); AddSample(95,5.6,2.7,4.2,1.3,"Iris-versicolor"); AddSample(96,5.7,3.0,4.2,1.2,"Iris-versicolor"); AddSample(97,5.7,2.9,4.2,1.3,"Iris-versicolor"); AddSample(98,6.2,2.9,4.3,1.3,"Iris-versicolor"); AddSample(99,5.1,2.5,3.0,1.1,"Iris-versicolor"); AddSample(100,5.7,2.8,4.1,1.3,"Iris-versicolor"); AddSample(101,6.3,3.3,6.0,2.5,"Iris-virginica"); AddSample(102,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(103,7.1,3.0,5.9,2.1,"Iris-virginica"); AddSample(104,6.3,2.9,5.6,1.8,"Iris-virginica"); AddSample(105,6.5,3.0,5.8,2.2,"Iris-virginica"); AddSample(106,7.6,3.0,6.6,2.1,"Iris-virginica"); AddSample(107,4.9,2.5,4.5,1.7,"Iris-virginica"); AddSample(108,7.3,2.9,6.3,1.8,"Iris-virginica"); AddSample(109,6.7,2.5,5.8,1.8,"Iris-virginica"); AddSample(110,7.2,3.6,6.1,2.5,"Iris-virginica"); AddSample(111,6.5,3.2,5.1,2.0,"Iris-virginica"); AddSample(112,6.4,2.7,5.3,1.9,"Iris-virginica"); AddSample(113,6.8,3.0,5.5,2.1,"Iris-virginica"); AddSample(114,5.7,2.5,5.0,2.0,"Iris-virginica"); AddSample(115,5.8,2.8,5.1,2.4,"Iris-virginica"); AddSample(116,6.4,3.2,5.3,2.3,"Iris-virginica"); AddSample(117,6.5,3.0,5.5,1.8,"Iris-virginica"); AddSample(118,7.7,3.8,6.7,2.2,"Iris-virginica"); AddSample(119,7.7,2.6,6.9,2.3,"Iris-virginica"); AddSample(120,6.0,2.2,5.0,1.5,"Iris-virginica"); AddSample(121,6.9,3.2,5.7,2.3,"Iris-virginica"); AddSample(122,5.6,2.8,4.9,2.0,"Iris-virginica"); AddSample(123,7.7,2.8,6.7,2.0,"Iris-virginica"); AddSample(124,6.3,2.7,4.9,1.8,"Iris-virginica"); AddSample(125,6.7,3.3,5.7,2.1,"Iris-virginica"); AddSample(126,7.2,3.2,6.0,1.8,"Iris-virginica"); AddSample(127,6.2,2.8,4.8,1.8,"Iris-virginica"); AddSample(128,6.1,3.0,4.9,1.8,"Iris-virginica"); AddSample(129,6.4,2.8,5.6,2.1,"Iris-virginica"); AddSample(130,7.2,3.0,5.8,1.6,"Iris-virginica"); AddSample(131,7.4,2.8,6.1,1.9,"Iris-virginica"); AddSample(132,7.9,3.8,6.4,2.0,"Iris-virginica"); AddSample(133,6.4,2.8,5.6,2.2,"Iris-virginica"); AddSample(134,6.3,2.8,5.1,1.5,"Iris-virginica"); AddSample(135,6.1,2.6,5.6,1.4,"Iris-virginica"); AddSample(136,7.7,3.0,6.1,2.3,"Iris-virginica"); AddSample(137,6.3,3.4,5.6,2.4,"Iris-virginica"); AddSample(138,6.4,3.1,5.5,1.8,"Iris-virginica"); AddSample(139,6.0,3.0,4.8,1.8,"Iris-virginica"); AddSample(140,6.9,3.1,5.4,2.1,"Iris-virginica"); AddSample(141,6.7,3.1,5.6,2.4,"Iris-virginica"); AddSample(142,6.9,3.1,5.1,2.3,"Iris-virginica"); AddSample(143,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(144,6.8,3.2,5.9,2.3,"Iris-virginica"); AddSample(145,6.7,3.3,5.7,2.5,"Iris-virginica"); AddSample(146,6.7,3.0,5.2,2.3,"Iris-virginica"); AddSample(147,6.3,2.5,5.0,1.9,"Iris-virginica"); AddSample(148,6.5,3.0,5.2,2.0,"Iris-virginica"); AddSample(149,6.2,3.4,5.4,2.3,"Iris-virginica"); AddSample(150,5.9,3.0,5.1,1.8,"Iris-virginica"); //--- ArrayResize(iris_samples,150); for(int i=0; i<Exttotal; i++) { iris_samples[i]=ExtIRISDataset[i]; } //--- return(true); } //+------------------------------------------------------------------+

3つの一般的な分類方法を比較してみましょう。SVC(サポートベクトル分類)、LinearSVC(線形サポートベクトル分類)、およびNuSVC(Nuサポートベクトル分類)です。

動作原理

SVC(サポートベクトル分類)

動作原理:SVCは、クラス間のマージンを最大化することに基づいた分類方法です。クラスを最大限に分離し、サポートベクトル(超平面に最も近い点)をサポートする最適な分離超平面を探します。

カーネル関数:SVCは、線形、放射基底関数(RBF)、多項式などのさまざまなカーネル関数を使用できます。カーネル関数は、最適な超平面を見つけるためにデータをどのように変換するかを決定します。

LinearSVC(線形サポートベクトル分類)

動作原理:LinearSVCは、線形分類に特化したSVCのバリエーションです。カーネル関数を使用せずに最適な線形分離超平面を探します。これにより、大量のデータを処理する際の処理速度と効率が向上します。

NuSVC(Nuサポートベクトル分類)

動作原理:NuSVCもサポートベクトルメソッドに基づいていますが、モデルの複雑さとサポートベクトルの割合を制御するパラメータNu (nu)が導入されています。Nu値は0から1の範囲にあり、サポートベクトルとエラーに使用できるデータの量を決定します。

長所

SVC

強力なアルゴリズム:SVCはカーネル関数を使用することで、複雑な分類タスクを処理し、非線形データを処理できます。

外れ値に対する頑健性:SVCは、サポートベクトルを使用して分離超平面を構築するため、データの外れ値に対して堅牢です。

リニアSVC

高効率:LinearSVCは、大規模なデータセットを処理する場合、特にデータが大きく、線形分離がタスクに適している場合に、より高速かつ効率的です。

線形分類:問題が十分に線形に分離可能な場合、LinearSVCは複雑なカーネル関数を必要とせずに良好な結果をもたらすことができます。

NuSVC

モデルの複雑さの制御:NuSVCのNuパラメータを使用すると、モデルの複雑さと、データの適合と一般化の間のトレードオフを制御できます。

外れ値に対する頑健性:SVCと同様に、NuSVCは外れ値に対して堅牢であるため、ノイズの多いデータを扱うタスクに役立ちます。

制約

SVC

計算の複雑さSVCは、大規模なデータセットや複雑なカーネル関数を使用する場合に遅くなる可能性があります。

カーネル感度:適切なカーネル関数を選択することは困難な作業であり、モデルのパフォーマンスに大きな影響を与える可能性があります。

LinearSVC

直線性制約:LinearSVCは線形データ分離によって制約され、特徴とターゲット変数の間に非線形依存関係がある場合にはパフォーマンスが低下する可能性があります。

NuSVC

Nuパラメータチューニング:Nuパラメータを調整するには、最適な結果を得るために時間と実験が必要になる場合があります。

タスクの特性とデータ量に応じて、これらの各方法が最適な選択肢となる場合があります。実験を実施し、特定の分類タスクの要件に最適な方法を選択することが重要です。

2.1.SVC分類器

サポートベクトル分類(SVC)分類方法は、分類タスクを解決するために広く使用されている強力な機械学習アルゴリズムです。

動作原理

- 最適分離超平面

動作原理:SVCの背後にある主な考え方は、特徴空間内で最適な分離超平面を見つけることです。この超平面は、異なるクラスのオブジェクト間の分離を最大化し、超平面に最も近いデータポイントであるサポートベクトルをサポートする必要があります。

マージンの最大化:SVCは、クラス間のマージン、つまりサポートベクトルから超平面までの距離を最大化することを目的としています。これにより、この方法は外れ値に対して堅牢になり、新しいデータに適切に一般化できるようになります。 - カーネル関数の活用

カーネル関数:SVCは、線形、放射基底関数(RBF)、多項式などのさまざまなカーネル関数を使用できます。カーネル関数を使用すると、元のデータ空間に線形分離性がない場合でも、タスクが線形になる高次元空間にデータを投影できます。

カーネルの選択:適切なカーネル関数を選択すると、SVCモデルのパフォーマンスに大きな影響を与える可能性があります。線形超平面は常に最適な解であるとは限りません。

長所

- 強力なアルゴリズム:複雑なタスクの処理:SVCは、特徴とターゲット変数の間に非線形依存関係があるタスクを含む、複雑な分類タスクを解決できます。

- 外れ値に対する頑健性:サポートベクトルを使用すると、データの外れ値に対しても堅牢な方法になります。データセット全体ではなく、サポートベクトルに依存します。

- カーネルの柔軟性:データへの適応性:さまざまなカーネル関数を使用できることにより、SVCは特定のデータに適応し、非線形関係を発見できます。

- 優れた一般化:新しいデータへの一般化:SVCモデルは新しいデータにうまく一般化できるため、予測タスクに役立ちます。

制約

- 計算の複雑さ:訓練の時間SVCは、特に大量のデータや複雑なカーネル関数を扱う場合には、訓練に時間がかかることがあります。

- カーネルの選択:適切なカーネル関数の選択 - 正しいカーネル関数を選択するには実験が必要になる場合があり、データの特性によって異なります。

- 特徴スケーリングに対する感度:データの正規化 - SVCは特徴のスケーリングに敏感なので、訓練の前にデータを正規化または標準化することをお勧めします。

- モデルの解釈可能性:解釈の複雑さ - SVCモデルは、非線形カーネルと多数のサポートベクトルの使用により、解釈が複雑になる場合があります。

特定のタスクとデータ量に応じて、SVCメソッドは分類タスクを解決するための強力なツールになります。ただし、最適な結果を得るには、その制限を考慮し、パラメータを調整することが重要です。

2.1.1.SVC分類器モデルを作成するためのコード

このコードは、IrisデータセットでSVC分類器モデルを訓練し、それをONNX形式に書き出し、ONNXモデルを使用して分類を実行するプロセスを示しています。また、元のモデルとONNXモデルの両方の精度も評価します。

# Iris_SVCClassifier.py # The code demonstrates the process of training SVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import SVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create an SVC Classifier model with a linear kernel svc_model = SVC(kernel='linear', C=1.0) # train the model on the entire dataset svc_model.fit(X, y) # predict classes for the entire dataset y_pred = svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of SVC Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path +"svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of SVC Classifier model in ONNX format:", accuracy_onnx)

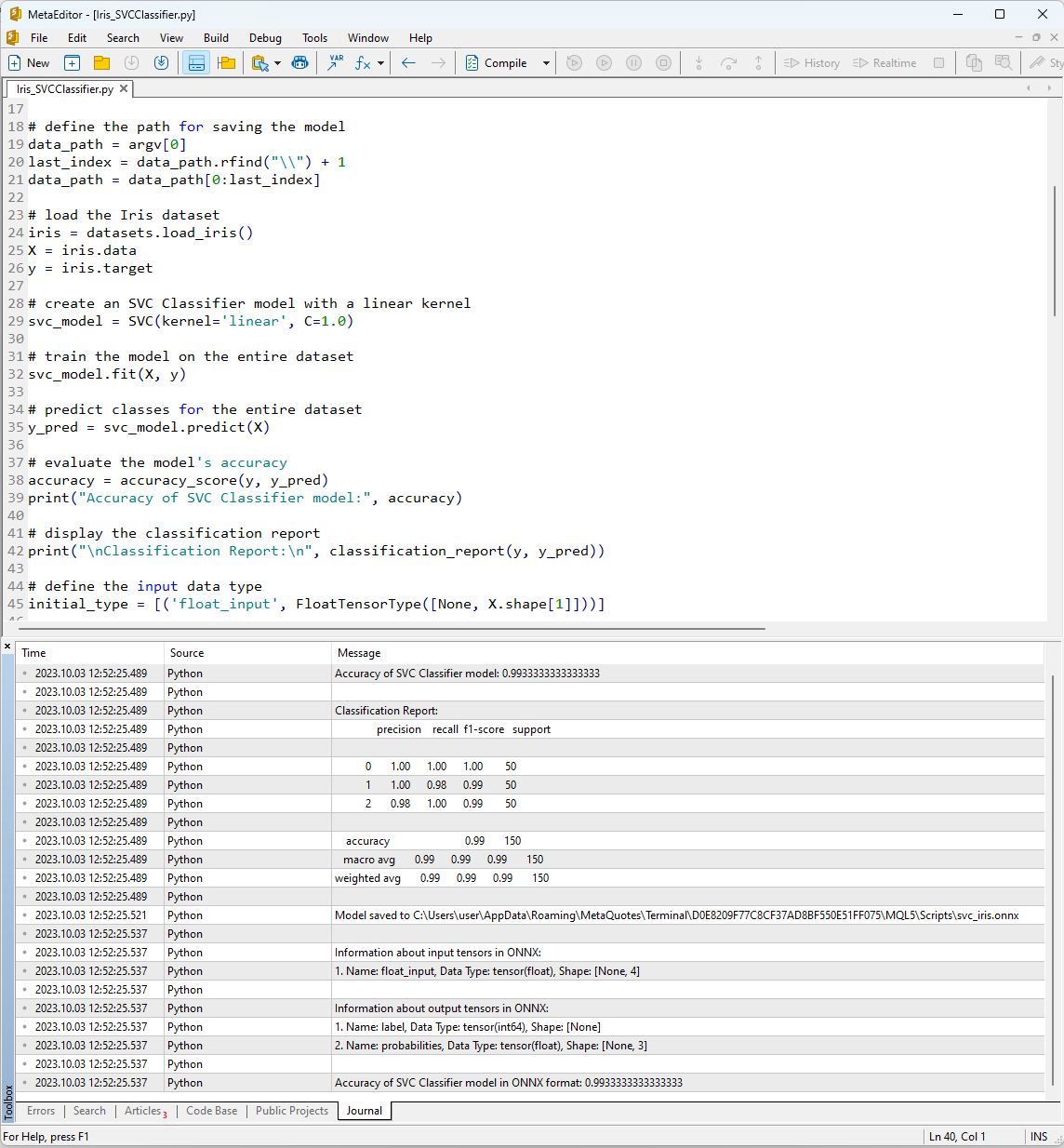

「コンパイル」ボタンを使用してMetaEditorでスクリプトを実行した後、実行結果をジャーナルタブで表示できます。

図12 MetaEditorでのIris_SVMClassifier.pyスクリプトの結果

Iris_SVCClassifier.pyスクリプトの出力:

Python Accuracy of SVC Classifier model:0.9933333333333333

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 1.00 0.98 0.99 50

Python 2 0.98 1.00 0.99 50

Python

Python accuracy 0.99 150

Python macro avg 0.99 0.99 0.99 150

Python weighted avg 0.99 0.99 0.99 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1.Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1.Name: label, Data Type: tensor(int64), Shape: [None]

Python 2.Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of SVC Classifier model in ONNX format:0.9933333333333333

ここでは、ONNXモデルが保存されたパス、ONNXモデルの入力および出力パラメータの種類、およびIrisデータセットの記述の精度に関する情報を確認できます。

SVM分類器を使用してデータセットを記述する精度は99%であり、ONNX形式に書き出されたモデルは同じレベルの精度を示します。

ここで、構築したモデルを150個のデータサンプルごとに実行して、MQL5でこれらの結果を検証します。さらに、スクリプトにはバッチデータ処理の例が含まれています。

2.1.2.SVC分類器モデルを操作するためのMQL5コード

//+------------------------------------------------------------------+ //| Iris_SVCClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="SVCClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

スクリプトの実行結果は、MetaTrader 5ターミナルの「EA」タブに表示されます。

Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier correct results: 99.33% Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier all samples accuracy=0.993333 Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier batch test accuracy=1.000000

SVCモデルは150個のサンプルのうち149個を正しく分類しました。これは優れた結果です。モデルは、Irisデータセットで1つの分類エラーのみを犯し、サンプル#84に対してクラス1(virginica)ではなくクラス2(versicolor)を予測しました。

完全なIrisデータセットで書き出されたONNXモデルの精度は99.33%であり、元のモデルの精度と一致していることは注目に値します。

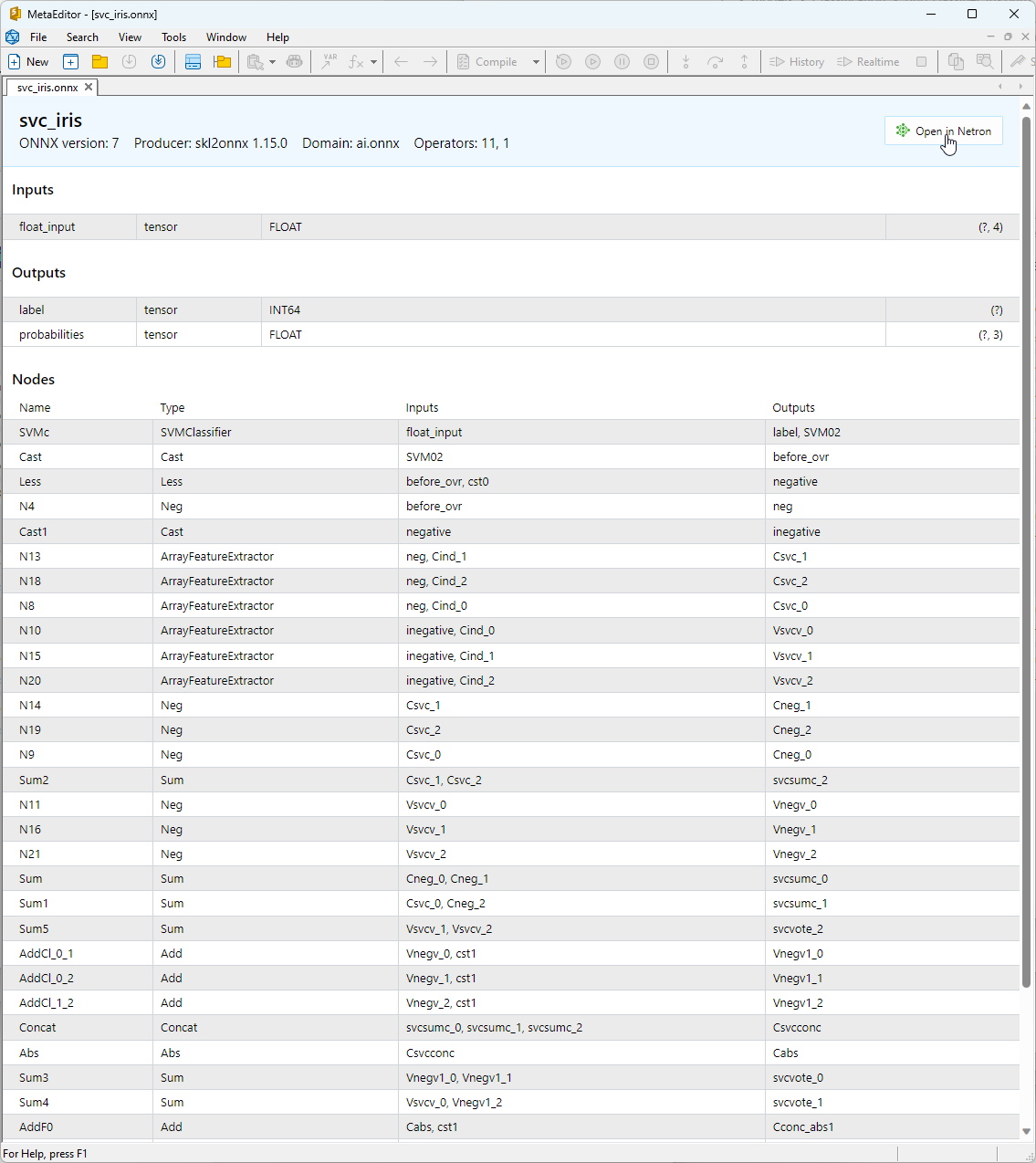

2.1.3.SVC分類器モデルのONNX表現

構築されたONNXモデルはMetaEditorで表示できます。

図13。MetaEditorのONNXモデルsvc_iris.onnx

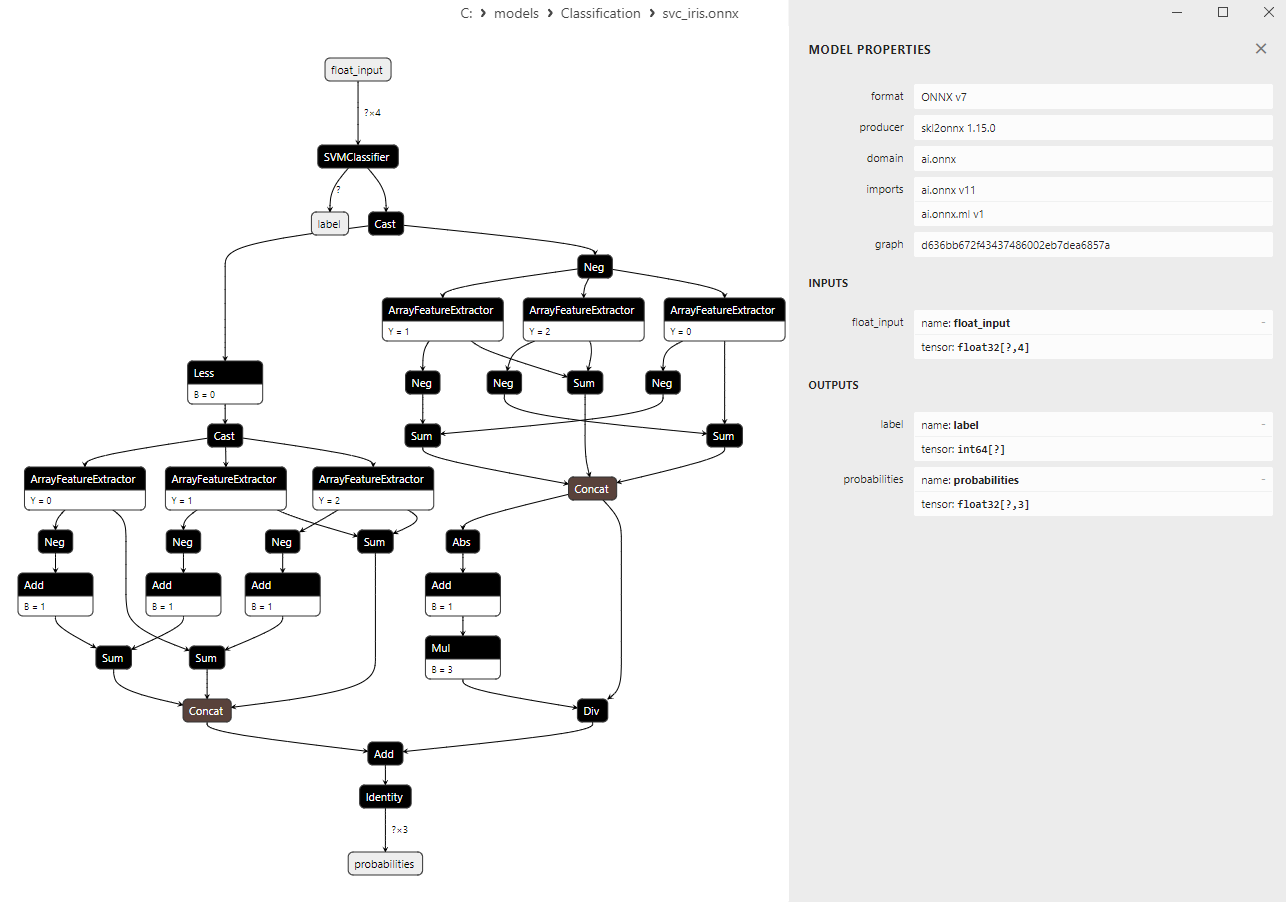

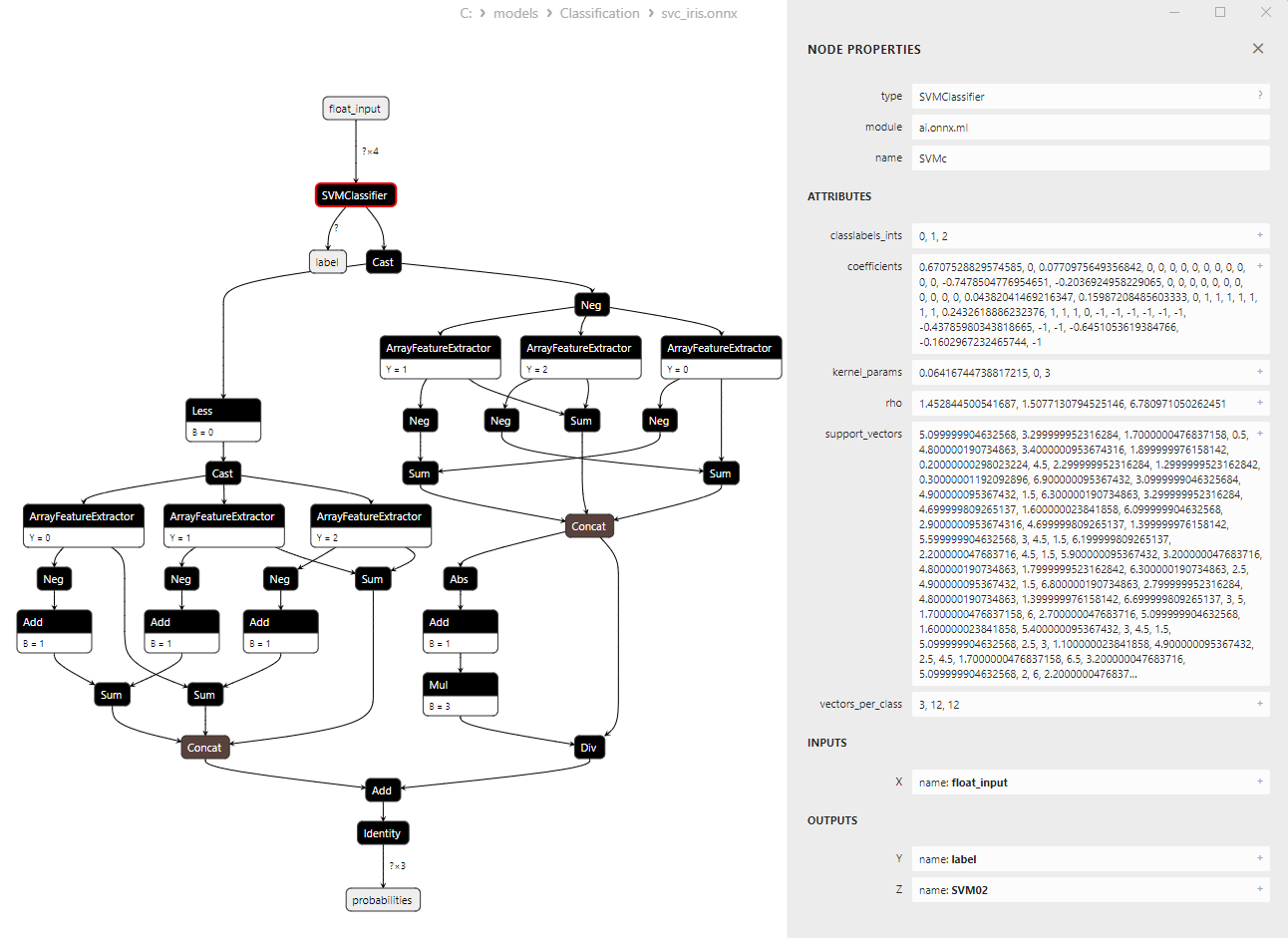

モデルのアーキテクチャに関する詳細な情報については、Netronを使用できます。これを行うには、MetaEditorのモデルの説明にある「Netronで開く」ボタンをクリックします。

図14:NetronのONNXモデルsvc_iris.onnx

図15:NetronのONNXモデルsvc_iris.onnx(SVMClassifierONNX演算子パラメータ)

2.2.リニアSVC分類器

LinearSVC(LinearSupportVectorClassification)は、バイナリおよびマルチクラス分類タスクに使用される強力な機械学習アルゴリズムです。これは、データを最も適切に分離する超平面を見つけるという考えに基づいています。

LinearSVCの原理

- 最適な超平面を見つけるLinearSVCの主な考え方は、2つのデータクラスを最大限に分離する最適な超平面を見つけることです。超平面は線形方程式によって定義される多次元平面です。

- マージンの最小化LinearSVCは、マージン(データポイントと超平面間の距離)を最小化することを目的としています。マージンが大きいほど、超平面はクラスをより効果的に分離します。

- 線形分離不可能なデータの処理LinearSVCは、データを線形に分離できる高次元空間に投影するカーネル関数(カーネルトリック)を使用することで、元の特徴空間では線形に分離できないデータでも処理できます。

LinearSVCの利点

- 良い一般化:LinearSVCは優れた一般化能力を備えており、新しい未知のデータに対しても優れたパフォーマンスを発揮します。

- 効率:LinearSVCは大規模なデータセットでも迅速に動作し、比較的少ない計算リソースしか必要としません。

- 線形分離不可能なデータの処理カーネル関数を使用すると、LinearSVCは線形に分離できないデータによる分類タスクに対処できます。

- スケーラビリティLinearSVCは、多数の機能と大量のデータを持つタスクで効率的に使用できます。

LinearSVCの制限

- 線形分離超平面のみLinearSVCは線形分離超平面のみを構築しますが、これは非線形依存関係を持つ複雑な分類タスクには不十分な場合があります。

- パラメータ選択:適切なパラメータ(例:正規化パラメータ)を選択するには、専門知識や相互検証が必要になる場合があります。

- 外れ値に対する感度:LinearSVCはデータ内の外れ値の影響を受けやすく、分類の品質に影響を与える可能性があります。

- モデルの解釈可能性:LinearSVCを使用して作成されたモデルは、他の方法と比較して解釈が難しい場合があります。

LinearSVCは、一般化、効率性、線形に分離できないデータの処理に優れた強力な分類アルゴリズムです。これは、特にデータを線形超平面で分離できる場合に、さまざまな分類タスクに応用できます。ただし、非線形依存関係のモデリングを必要とする複雑なタスクの場合、LinearSVCはあまり適していない可能性があります。このような場合には、より複雑な決定境界を持つ代替方法を検討する必要があります。

2.2.1.LinearSVC分類器モデルを作成するためのコード

このコードは、IrisデータセットでLinearSVC分類器モデルを訓練し、それをONNX形式に書き出し、ONNXモデルを使用して分類を実行するプロセスを示しています。また、元のモデルとONNXモデルの両方の精度も評価します。

# Iris_LinearSVC.py # The code demonstrates the process of training LinearSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import LinearSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a LinearSVC model linear_svc_model = LinearSVC(C=1.0, max_iter=10000) # train the model on the entire dataset linear_svc_model.fit(X, y) # predict classes for the entire dataset y_pred = linear_svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of LinearSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(linear_svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "linear_svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of LinearSVC model in ONNX format:", accuracy_onnx)

出力:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.94 0.95 50

Python 2 0.94 0.96 0.95 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\linear_svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1.Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1.Name: label, Data Type: tensor(int64), Shape: [None]

Python 2.Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of LinearSVC model in ONNX format:0.9666666666666667

2.2.2.LinearSVC分類器モデルを操作するためのMQL5コード

//+------------------------------------------------------------------+ //| Iris_LinearSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "linear_svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="LinearSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

出力:

Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=71 FAILED [class=2, true class=1] features=(5.90,3.20,4.80,1.80] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=85 FAILED [class=2, true class=1] features=(5.40,3.00,4.50,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=130 FAILED [class=1, true class=2] features=(7.20,3.00,5.80,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=134 FAILED [class=1, true class=2] features=(6.30,2.80,5.10,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC correct results: 96.67% Iris_LinearSVC (EURUSD,H1) model=LinearSVC all samples accuracy=0.966667 Iris_LinearSVC (EURUSD,H1) model=LinearSVC batch test accuracy=1.000000

完全なIrisデータセット上で書き出されたONNXモデルの精度は96.67%で、これは元のモデルの精度に相当します。

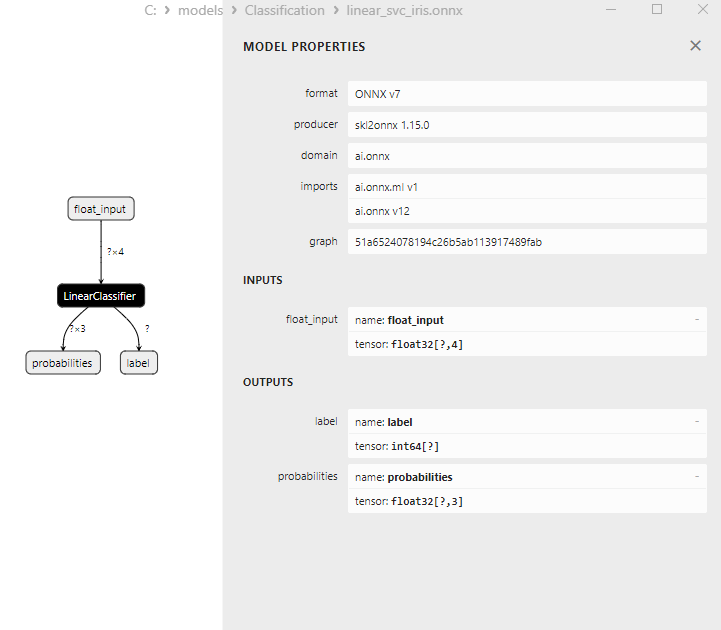

2.2.3.LinearSVC分類器モデルのONNX表現

図16:NetronにおけるLinearSVC分類器モデルのONNX表現

2.3.NuSVC分類器

Nuサポートベクトル分類(NuSVC)メソッドは、サポートベクトルマシン(SVM)アプローチに基づく強力な機械学習アルゴリズムです。

NuSVCの原則

- サポートベクトルマシン(SVM)NuSVCは、バイナリおよびマルチクラス分類タスクに使用されるSVMのバリエーションです。SVMの基本原理は、最大マージンを維持しながらクラスを最大限に分離する最適な分離超平面を見つけることです。

- Nuパラメータ:NuSVCの重要なパラメータはNuパラメータ(nu)です。これはモデルの複雑さを制御し、サポートベクトルとエラーとして使用できるサンプルの割合を定義します。Nuの値の範囲は0~1で、0.5はサンプルのおよそ半分がサポートベクトルとエラーとして使用されることを意味します。

- パラメータ調整:Nuパラメータやその他のハイパーパラメータの最適値を決定するには、クロス検証と訓練データ上の最適値の検索が必要になる場合があります。

- カーネル関数:NuSVCは、線形、ラジアル基底関数(RBF)、多項式などのさまざまなカーネル関数を使用できます。カーネル関数は、分離超平面を見つけるために特徴空間をどのように変換するかを決定します。

NuSVCの利点

- 高次元空間における効率性:NuSVCは高次元空間で効率的に動作できるため、多数の機能を持つタスクに適しています。

- 外れ値に対する頑健性:SVM、特にNuSVCは、サポートベクトルの使用により、データ内の外れ値に対して堅牢です。

- モデルの複雑さの制御Nuパラメータを使用すると、モデルの複雑さを制御し、データの適合と一般化のバランスをとることができます。

- 良い一般化:特に、SVMとNuSVCは優れた一般化を示し、これまでに見たことのない新しいデータに対して優れたパフォーマンスを発揮します。

NuSVCの制限

- 大量のデータによる非効率性:NuSVCは、計算の複雑さにより、大量のデータで訓練する場合、効率が悪くなる可能性があります。

- 必要なパラメータ調整:Nuパラメータとカーネル関数の調整には、時間と計算リソースが必要になる場合があります。

- カーネル関数の線形性:NuSVCの有効性はカーネル関数の選択に大きく依存する可能性があり、一部のタスクでは異なる関数の実験が必要になる場合があります。

- モデルの解釈可能性:SVMとNuSVCは優れた結果をもたらしますが、特に非線形カーネルが使用されている場合、モデルの解釈が複雑になる可能性があります。

Nu-SupportVectorClassification(NuSVC)は、外れ値に対する堅牢性や優れた一般化など、いくつかの利点を備えたSVMに基づく強力な分類方法です。ただし、その有効性はパラメータとカーネル関数の選択に依存し、大量のデータに対しては非効率的になる可能性があります。パラメータを慎重に選択し、特定の分類タスクに合わせて方法を適応させることが重要です。

2.3.1.NuSVC分類器モデルを作成するためのコード

このコードは、IrisデータセットでNuSVC分類器モデルを訓練し、それをONNX形式に書き出し、ONNXモデルを使用して分類を実行するプロセスを示しています。また、元のモデルとONNXモデルの両方の精度も評価します。

# Iris_NuSVC.py # The code demonstrates the process of training NuSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import NuSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a NuSVC model nusvc_model = NuSVC(nu=0.5, kernel='linear') # train the model on the entire dataset nusvc_model.fit(X, y) # predict classes for the entire dataset y_pred = nusvc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of NuSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(nusvc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "nusvc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of NuSVC model in ONNX format:", accuracy_onnx)

出力:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.96 0.96 50

Python 2 0.96 0.96 0.96 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\nusvc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1.Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1.Name: label, Data Type: tensor(int64), Shape: [None]

Python 2.Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of NuSVC model in ONNX format:0.9733333333333334

2.3.2.NuSVC分類器モデルを操作するためのMQL5コード

//+------------------------------------------------------------------+ //| Iris_NuSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "nusvc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="NuSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

出力:

Iris_NuSVC (EURUSD,H1) model:NuSVC sample=78 FAILED [class=2, true class=1] features=(6.70,3.00,5.00,1.70] Iris_NuSVC (EURUSD,H1) model:NuSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_NuSVC (EURUSD,H1) model:NuSVC sample=107 FAILED [class=1, true class=2] features=(4.90,2.50,4.50,1.70] Iris_NuSVC (EURUSD,H1) model:NuSVC sample=139 FAILED [class=1, true class=2] features=(6.00,3.00,4.80,1.80] Iris_NuSVC (EURUSD,H1) model:NuSVC correct results: 97.33% Iris_NuSVC (EURUSD,H1) model=NuSVC all samples accuracy=0.973333 Iris_NuSVC (EURUSD,H1) model=NuSVC batch test accuracy=1.000000

完全なIrisデータセットに対する書き出されたONNXモデルの精度は97.33%で、これは元のモデルの精度に相当します。

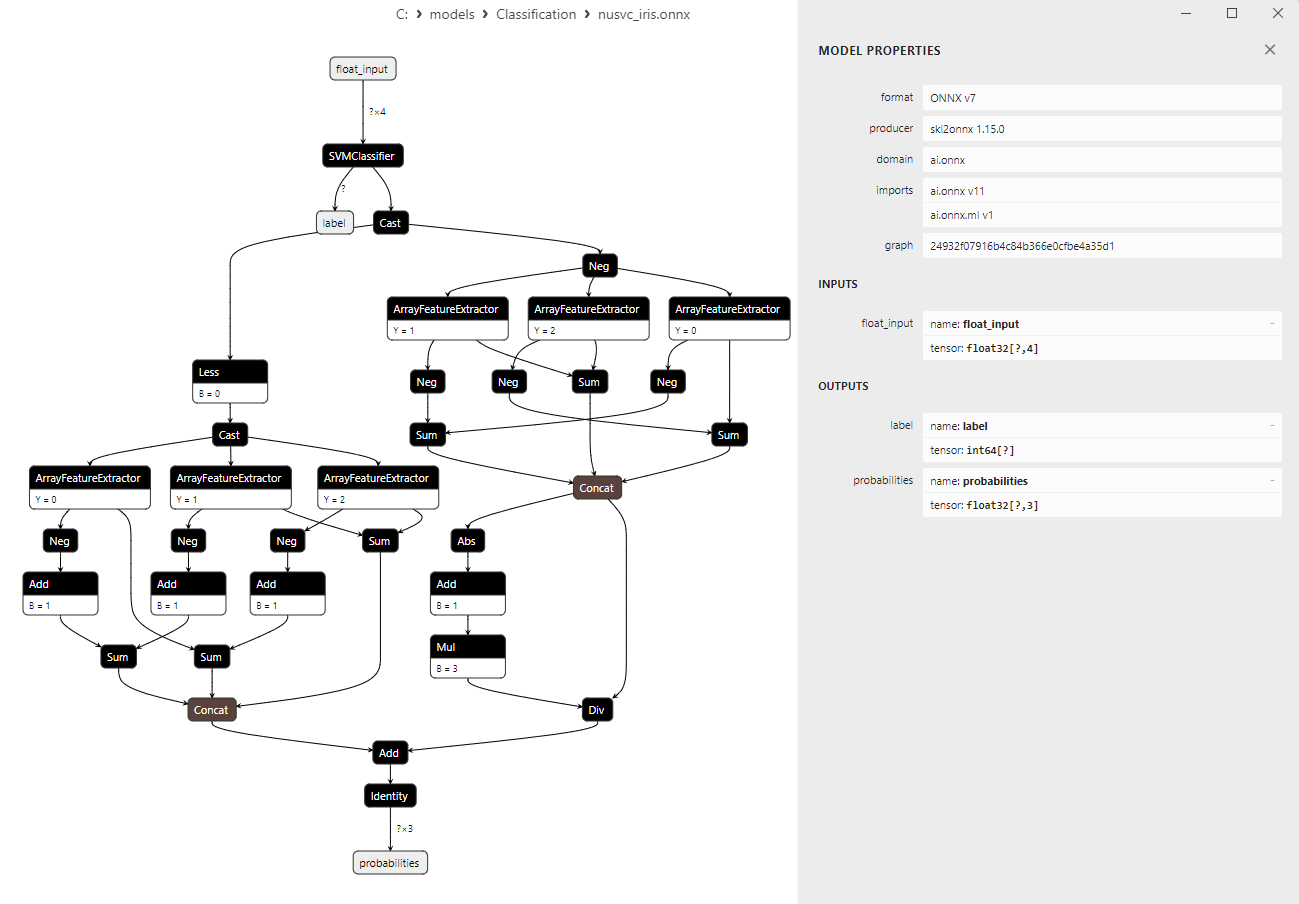

2.3.3.NuSVC分類器モデルのONNX表現

図17:NetronにおけるNuSVC分類器モデルのONNX表現

2.4.RadiusNeighborsClassifier

RadiusNeighborsClassifierは、オブジェクト間の近接性の原理に基づいて分類タスクに使用される機械学習手法です。固定数の近傍点(K)が選択される従来のKNeighborsClassifierとは異なり、RadiusNeighborsClassifierでは、指定された半径内の近傍点までの距離に基づいてオブジェクトが分類されます。RadiusNeighborsClassifierの原理

- 半径の決定:RadiusNeighborsClassifierの主なパラメータは半径です。半径は、オブジェクトとその近隣オブジェクト間の最大距離を定義し、近隣クラスに近いと見なされます。

- 最も近い隣人を見つける:訓練データセット内の他のすべてのオブジェクトまでの距離が、オブジェクトごとに計算されます。指定された半径内に位置するオブジェクトは、オブジェクトの隣接オブジェクトとみなされます。

- 投票:RadiusNeighborsClassifierは、近傍オブジェクト間の多数決を使用してオブジェクトのクラスを決定します。たとえば、近傍オブジェクトの大多数がクラスAに属している場合、オブジェクトもクラスAとして分類されます。

- データ密度への適応性:RadiusNeighborsClassifierは、異なる特徴空間領域のデータ密度が変化する可能性があるタスクに適しています。

- さまざまなクラス形状で作業する機能:この方法は、クラスが複雑で非線形の形状を持つタスクでうまく機能します。

- 外れ値のあるデータに適しています:RadiusNeighborsClassifierは、指定された半径を超える近傍を無視するため、K-NNよりも外れ値に対して堅牢です。

- 半径の選択に対する感度:最適な半径値を選択することは簡単な作業ではなく、調整が必要です。

- 大規模なデータセットでの非効率性:大規模なデータセットの場合、すべてのオブジェクトまでの距離を計算すると、計算コストが高くなる可能性があります。

- データ密度への依存:この方法は、特徴空間内のデータの密度が均一でない場合、効率が低下する可能性があります。

RadiusNeighborsClassifierは、オブジェクトの近接性が重要であり、クラスの形状が複雑になる可能性がある状況で役立つ機械学習手法です。画像解析、自然言語処理など、さまざまな分野に応用できます。

2.4.1.RadiusNeighborsClassifierモデルを作成するためのコード

このコードは、IrisデータセットでRadiusNeighborsClassifierモデルを訓練し、それをONNX形式で書き出し、ONNXモデルを使用して分類を実行するプロセスを示しています。また、元のモデルとONNXモデルの両方の精度も評価します。

# Iris_RadiusNeighborsClassifier.py # The code demonstrates the process of training an Radius Neughbors model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023 MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.neighbors import RadiusNeighborsClassifier from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a Radius Neighbors Classifier model radius_model = RadiusNeighborsClassifier(radius=1.0) # train the model on the entire dataset radius_model.fit(X, y) # predict classes for the entire dataset y_pred = radius_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of Radius Neighbors Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(radius_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "radius_neighbors_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of Radius Neighbors Classifier model in ONNX format:", accuracy_onnx)

スクリプトIris_RadiusNeighbors.pyの結果:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.94 0.98 0.96 50

Python 2 0.98 0.94 0.96 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\radius_neighbors_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1.Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1.Name: label, Data Type: tensor(int64), Shape: [None]

Python 2.Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of RadiusNeighborsClassifier model in ONNX format:0.9733333333333334

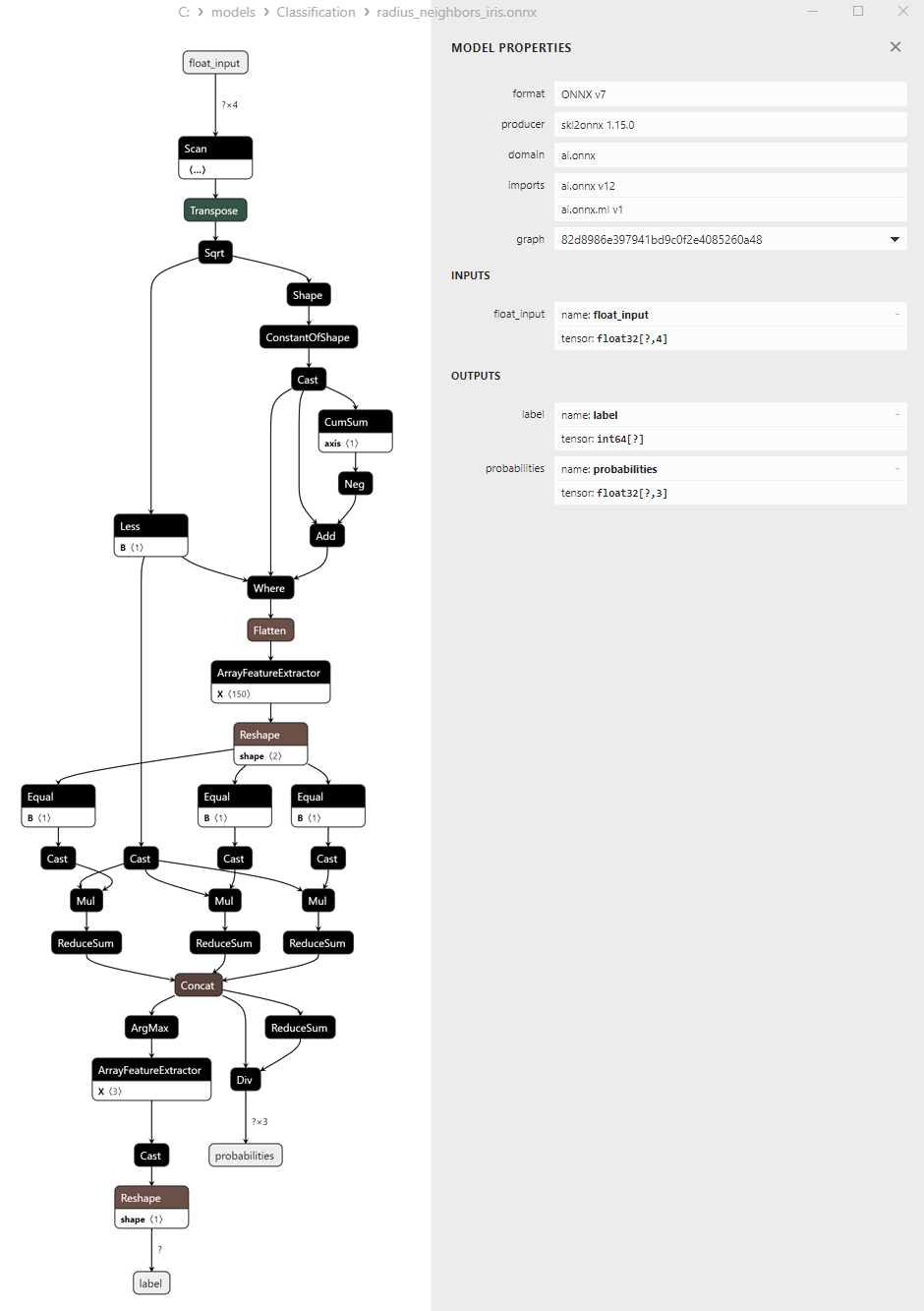

元のモデルの精度とONNX形式で書き出されたモデルの精度は同じです。

2.4.2.RadiusNeighborsClassifierモデルを操作するためのMQL5コード

//+------------------------------------------------------------------+ //| Iris_RadiusNeighborsClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "radius_neighbors_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="RadiusNeighborsClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

出力: