Modelos de regresión de la biblioteca Scikit-learn y su exportación a ONNX

ONNX (Open Neural Network Exchange) es un formato para describir e intercambiar modelos de aprendizaje automático, proporcionando la capacidad de transferir modelos entre diferentes marcos de aprendizaje automático. En el aprendizaje profundo y las redes neuronales, los tipos de datos como float32 se utilizan con frecuencia. Se aplican ampliamente porque suelen proporcionar una precisión y eficiencia aceptables para el entrenamiento de modelos de aprendizaje profundo.

Algunos modelos clásicos de aprendizaje automático son difíciles de representar como operadores ONNX. Por lo tanto, se introdujeron operadores ML adicionales (ai.onnx.ml) para implementarlos en ONNX. Cabe destacar que, según la especificación de ONNX, los operadores clave de este conjunto (LinearRegressor, SVMRegressor, TreeEnsembleRegressor) pueden aceptar varios tipos de datos de entrada (tensor(float), tensor(double), tensor(int64), tensor(int32)), pero siempre devuelven el tipo tensor(float) como salida. La parametrización de estos operadores también se realiza utilizando números de coma flotante, lo que puede limitar la precisión de los cálculos, especialmente si se utilizaron números de doble precisión para definir los parámetros del modelo original.

Esto puede provocar una pérdida de precisión al convertir modelos o utilizar distintos tipos de datos en el proceso de conversión y procesamiento de datos en ONNX. Mucho depende del conversor, como veremos más adelante; algunos modelos consiguen saltarse estas limitaciones y garantizan la plena portabilidad de los modelos ONNX, permitiendo trabajar con ellos en doble precisión sin perder exactitud. Es importante tener en cuenta estas características al trabajar con modelos y su representación en ONNX, especialmente en los casos en los que la precisión de la representación de los datos es importante.

Scikit-learn es una de las librerías para aprendizaje automático más populares y utilizadas en la comunidad Python. Ofrece una amplia gama de algoritmos, una interfaz fácil de usar y una buena documentación. El artículo anterior, "Modelos de clasificación de la biblioteca Scikit-learn y su exportación a ONNX", trataba sobre los modelos de clasificación.

En este artículo, exploraremos la aplicación de modelos de regresión en el paquete Scikit-learn, calcularemos sus parámetros con doble precisión para el conjunto de datos de prueba, intentaremos convertirlos al formato ONNX para flotación y doble precisión, y utilizaremos los modelos obtenidos en programas en MQL5. Adicionalmente, compararemos la precisión de los modelos originales y sus versiones ONNX para precisión flotante y doble. Además, examinaremos la representación ONNX de los modelos de regresión, lo que permitirá comprender mejor su estructura interna y su funcionamiento.

Contenido

- Si te molesta, eres bienvenido a contribuir.

- 1. Conjunto de datos de prueba

El script para mostrar el conjunto de datos de prueba - 2. Modelos de regresión

2.0. Lista de modelos de regresión de Scikit-learn - 2.1. Modelos de regresión de Scikit-learn que se convierten en modelos ONNX float y double

- 2.1.1. sklearn.linear_model.ARDRegression

2.1.1.1. Código para crear la ARDRegression

el 2.1.1.2. Código MQL5 para ejecutar modelos ONNX

2.1.1.3. Representación ONNX de ard_regression_float.onnx y ard_regression_double.onnx - 2.1.2. sklearn.linear_model.BayesianRidge

2.1.2.1. Código para crear el modelo BayesianRidge y exportarlo a ONNX para float y double

2.1.2.2. Código MQL5 para ejecutar modelos ONNX

2.1.2.3. Representación ONNX de bayesian_ridge_float.onnx y bayesian_ridge_double.onnx - 2.1.3. sklearn.linear_model.ElasticNet

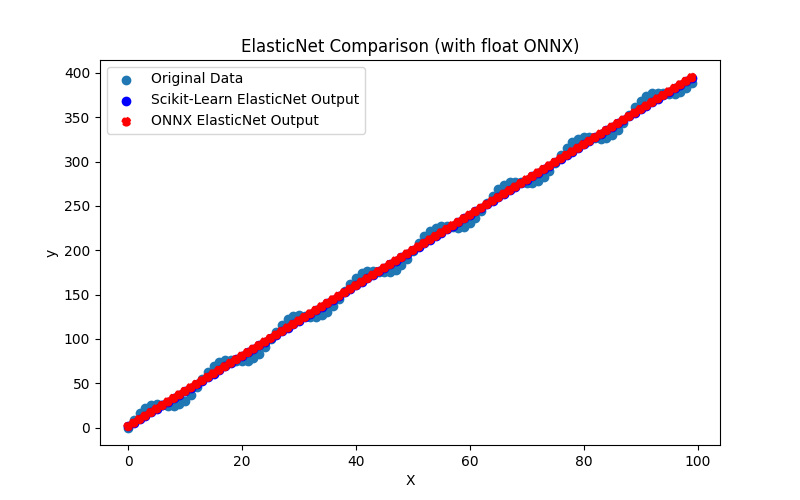

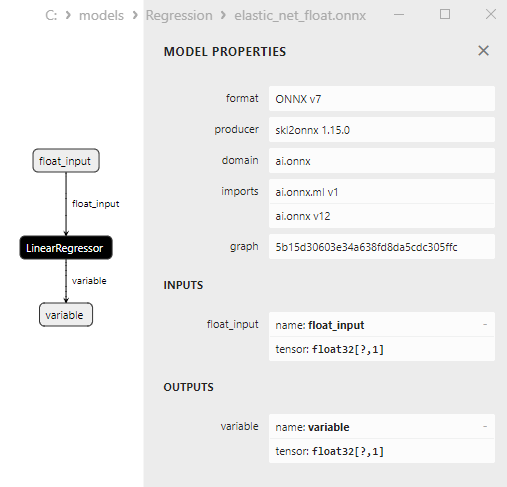

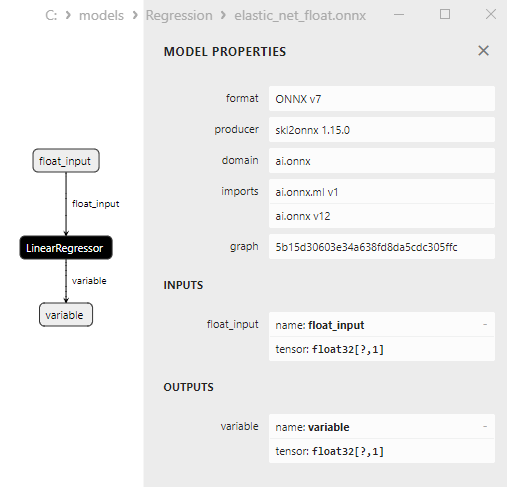

2.1.3.1. Código para crear el modelo ElasticNet y exportarlo a ONNX para float y double

2.1.3.2. Código MQL5 para ejecutar modelos ONNX

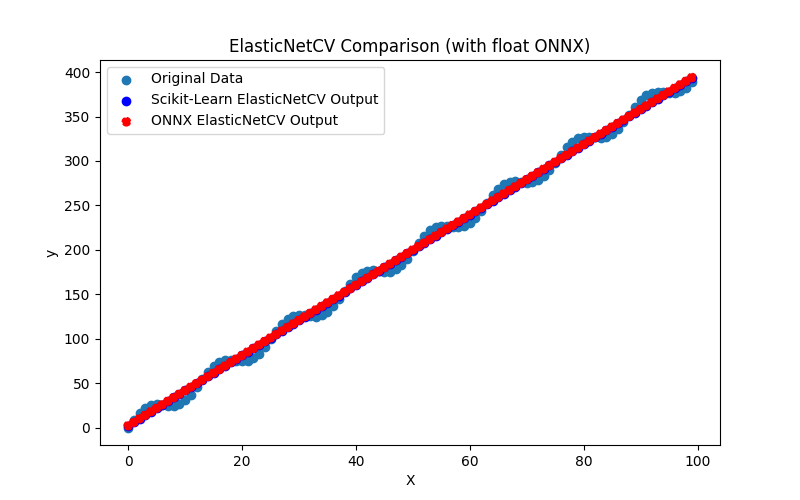

2.1.3.3. Representación ONNX de elastic_net_float.onnx y elastic_net_double.onnx - 2.1.4. sklearn.linear_model.ElasticNetCV

2.1.4.1. Código para crear el modelo ElasticNet y exportarlo a ONNX para float y double

2.1.4.2. Código MQL5 para ejecutar modelos ONNX

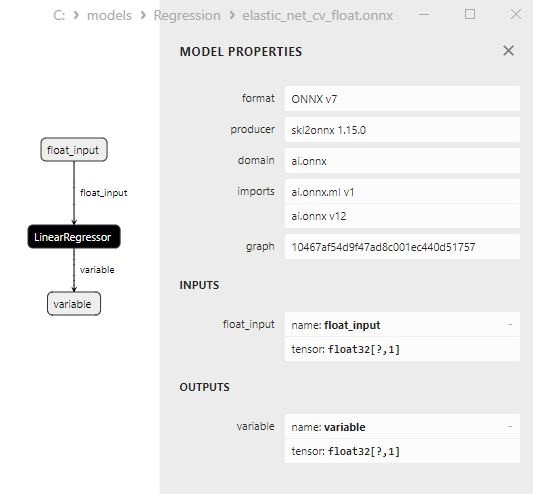

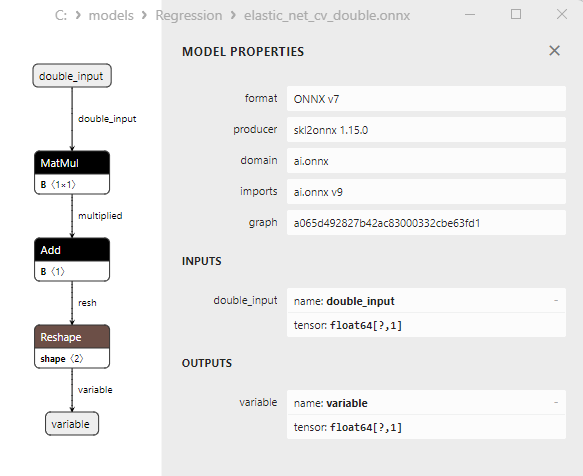

2.1.4.3. Representación ONNX de elastic_net_cv_float.onnx y elastic_net_cv_double.onnx - 2.1.5. sklearn.linear_model.HuberRegressor

2.1.5.1. Código para crear el modelo HuberRegressor y exportarlo a ONNX para float y double

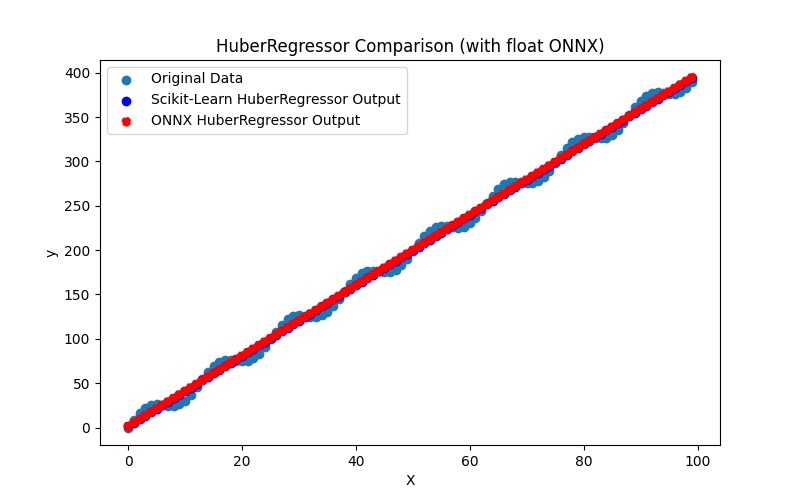

2.1.5.2. Código MQL5 para ejecutar modelos ONNX

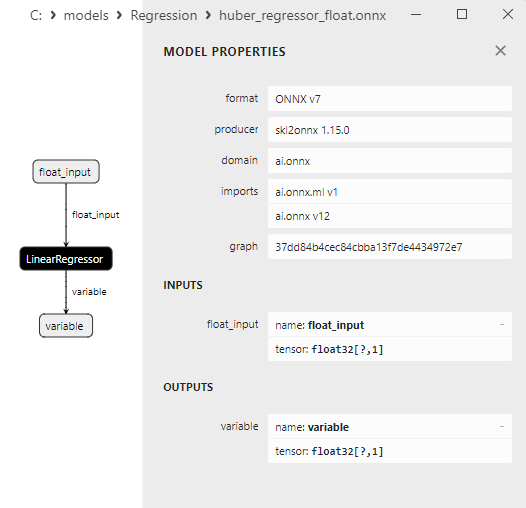

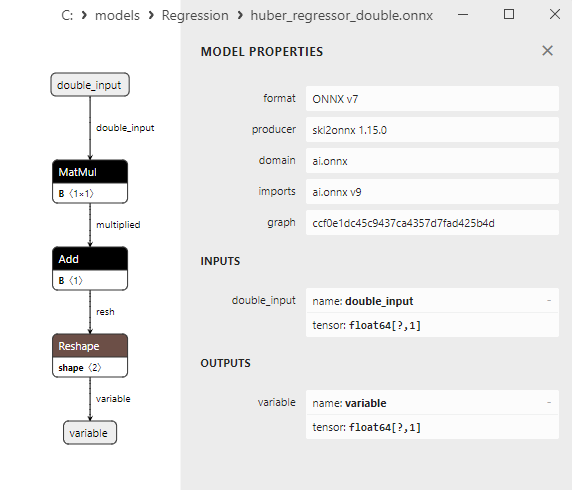

2.1.5.3. Representación ONNX de huber_regressor_float.onnx y huber_regressor_double.onnx - 2.1.6. sklearn.linear_model.Lars

2.1.6.1. Código para crear el modelo Lars y exportarlo a ONNX para float y double

2.1.6.2. Código MQL5 para ejecutar modelos ONNX

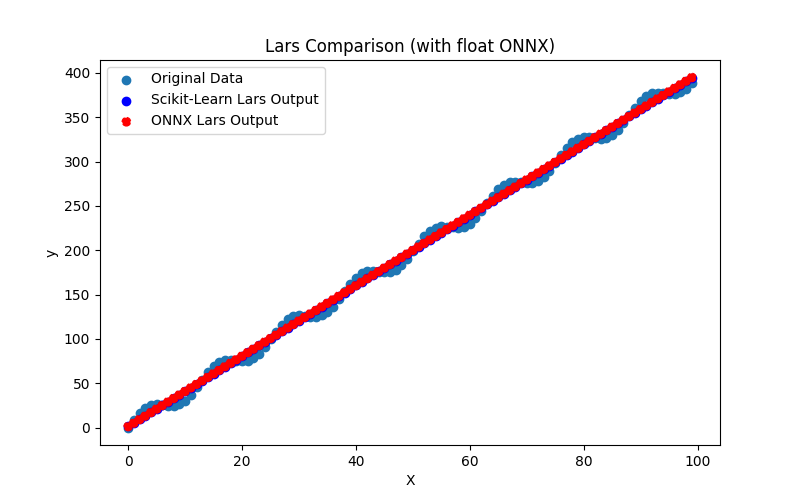

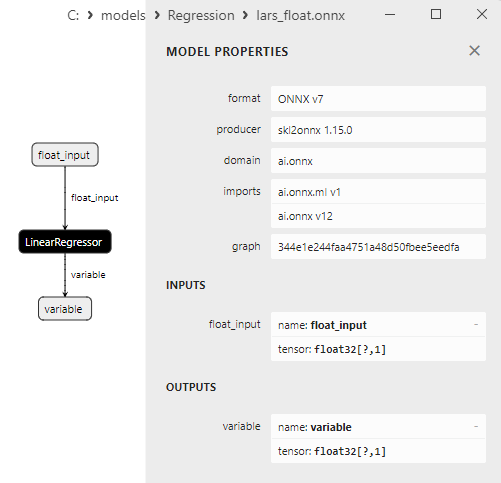

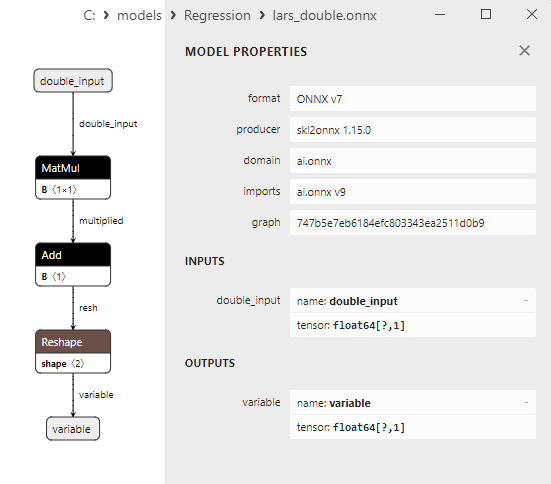

2.1.6.3. Representación ONNX de lars_float.onnx y lars_double.onnx - 2.1.7. sklearn.linear_model.LarsCV

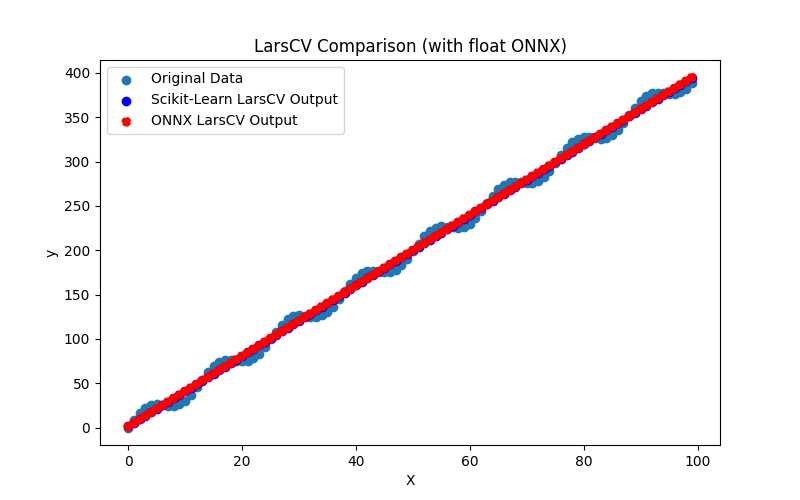

2.1.7.1. Código para crear el modelo LarsCV y exportarlo a ONNX para float y double

2.1.7.2. Código MQL5 para ejecutar modelos ONNX

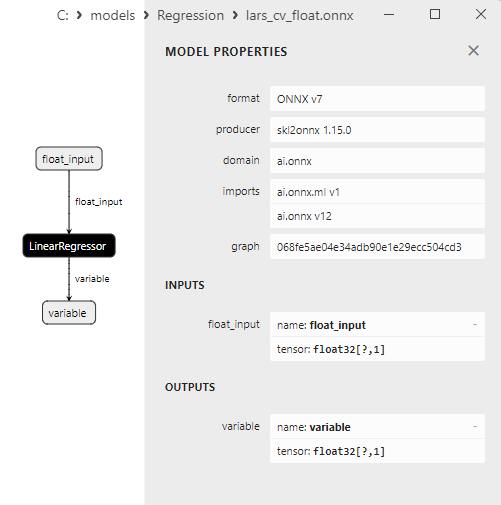

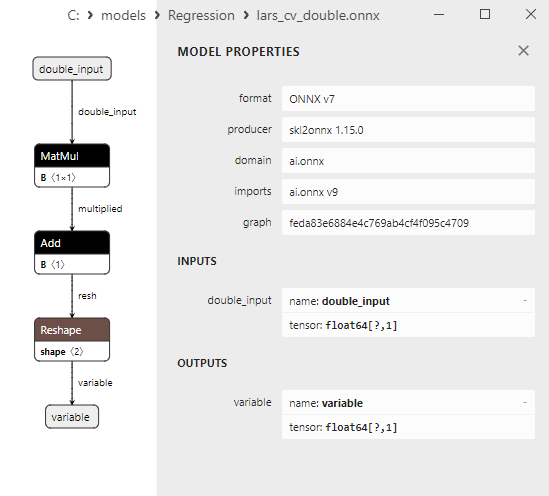

2.1.7.3. Representación ONNX de lars_cv_float.onnx y lars_cv_double.onnx - 2.1.8. sklearn.linear_model.Lasso

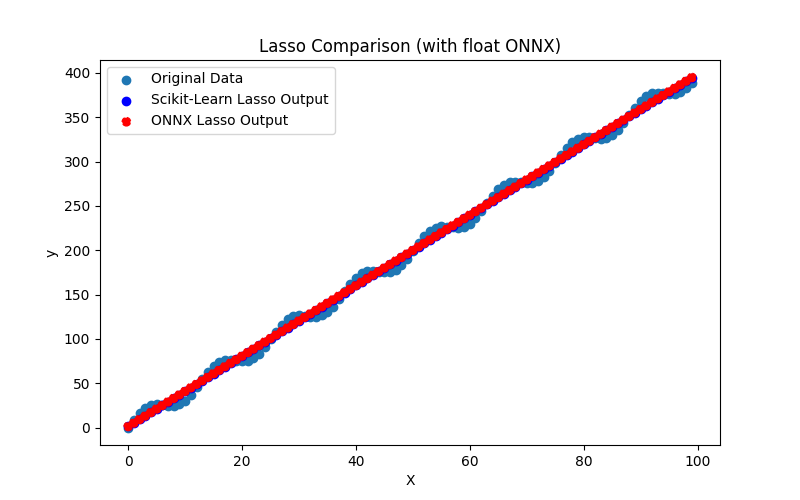

2.1.8.1. Código para crear el modelo Lasso y exportarlo a ONNX para float y double

2.1.8.2. Código MQL5 para ejecutar modelos ONNX

2.1.8.3. Representación ONNX de lasso_float.onnx y lasso_double.onnx - 2.1.9. sklearn.linear_model.LassoCV

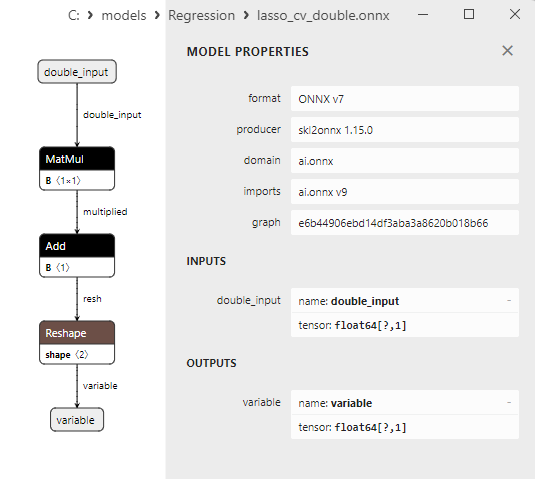

2.1.9.1. Código para crear el modelo LassoCV y exportarlo a ONNX para float y double

2.1.9.2. Código MQL5 para ejecutar modelos ONNX

2.1.9.3. Representación ONNX de lasso_cv_float.onnx y lasso_cv_double.onnx - 2.1.10. sklearn.linear_model.LassoLars

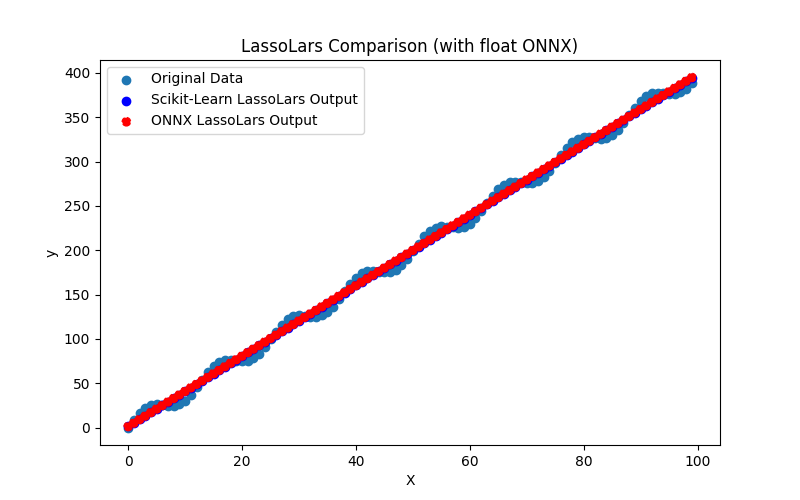

2.1.10.1. Código para crear el modelo LassoLars y exportarlo a ONNX para float y double

2.1.10.2. Código MQL5 para ejecutar modelos ONNX

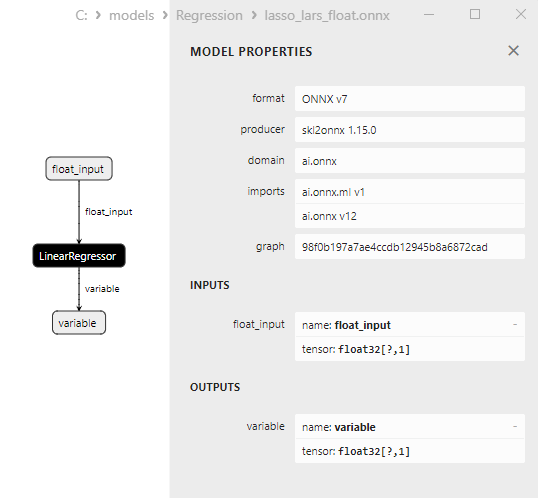

2.1.10.3. Representación ONNX de lasso_lars_float.onnx y lasso_lars_double.onnx - 2.1.11. sklearn.linear_model.LassoLarsCV

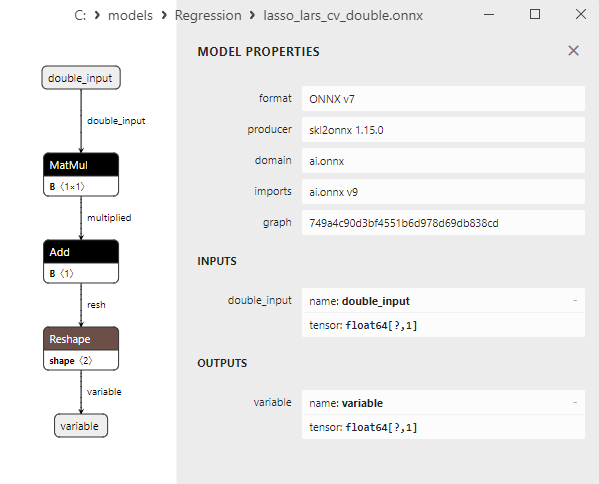

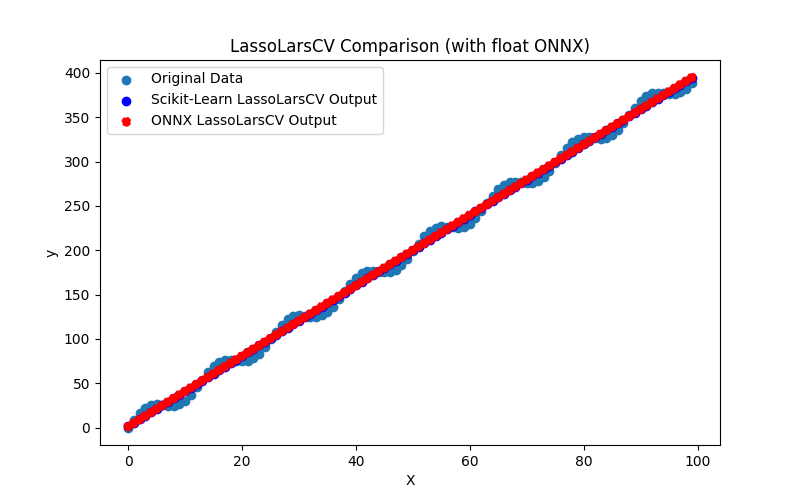

2.1.11.1. Código para crear el modelo LassoLarsCV y exportarlo a ONNX para float y double

2.1.11.2. Código MQL5 para ejecutar modelos ONNX

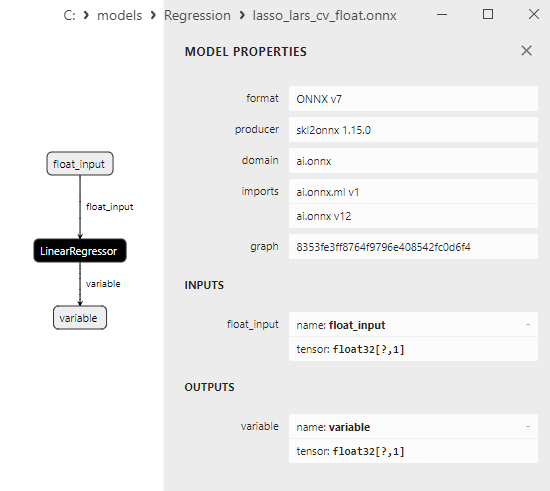

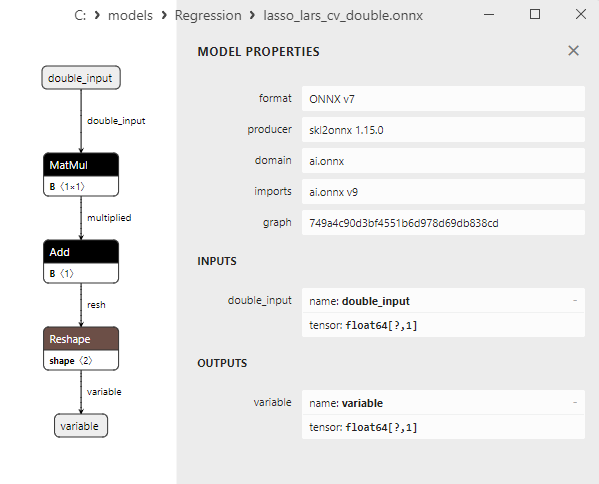

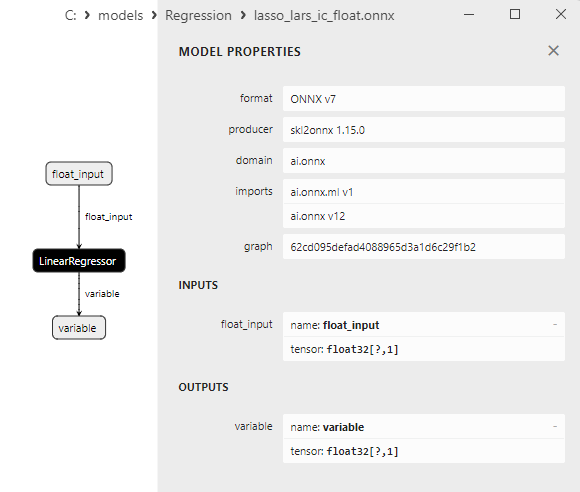

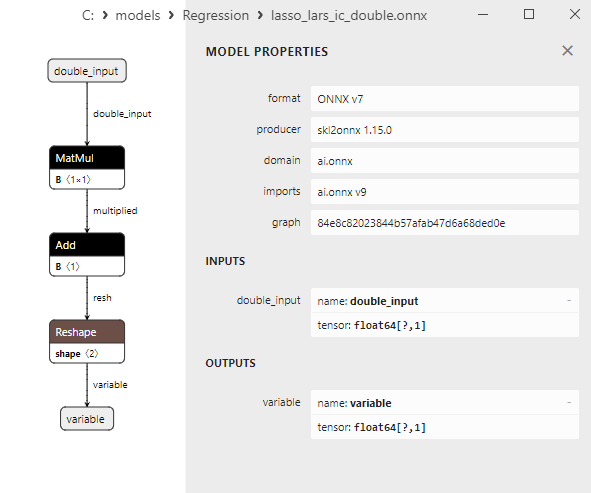

2.1.11.3. Representación ONNX de lasso_lars_cv_float.onnx y lasso_lars_cv_double.onnx - 2.1.12. sklearn.linear_model.LassoLarsIC

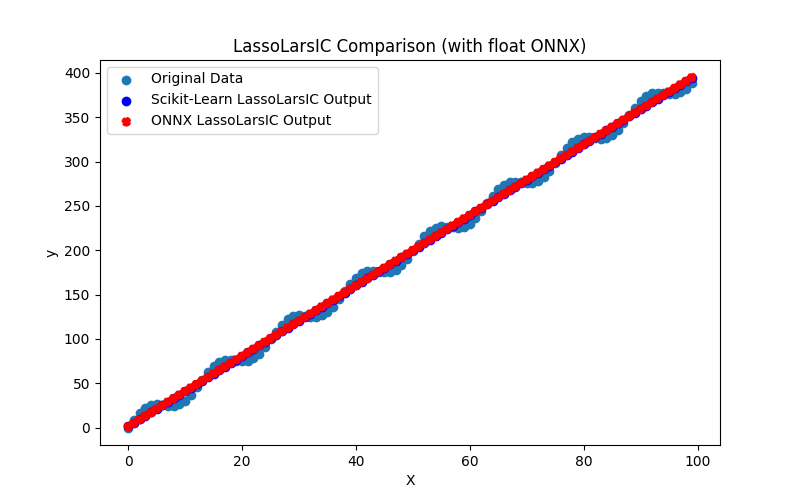

2.1.12.1. Código para crear el modelo LassoLarsIC y exportarlo a ONNX para float y double

2.1.12.2. Código MQL5 para ejecutar modelos ONNX

2.1.12.3. Representación ONNX de lasso_lars_ic_float.onnx y lasso_lars_ic_double.onnx - 2.1.13. sklearn.linear_model.LinearRegression

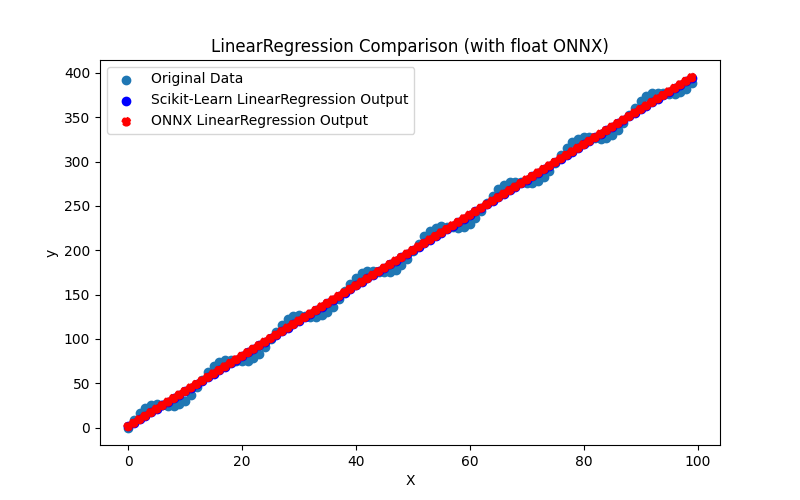

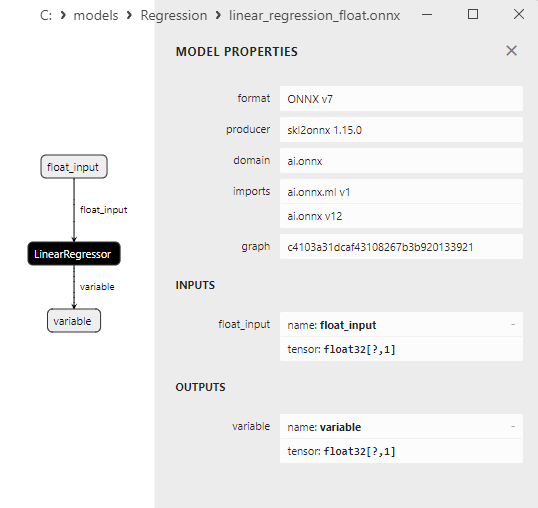

2.1.13.1. Código para crear el modelo LinearRegression y exportarlo a ONNX para float y double

2.1.13.2. Código MQL5 para ejecutar modelos ONNX

2.1.13.3. Representación ONNX de linear_regression_float.onnx y linear_regression_double.onnx - 2.1.14. sklearn.linear_model.Ridge

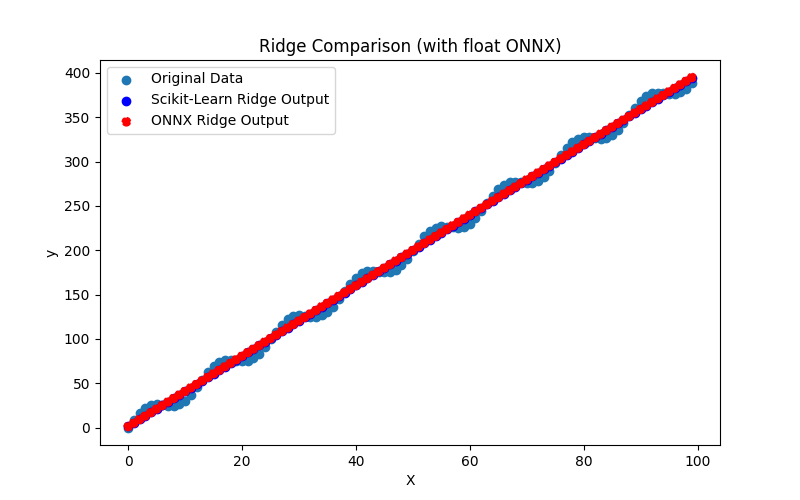

2.1.14.1. Código para crear el modelo Ridge y exportarlo a ONNX para float y double

2.1.14.2. Código MQL5 para ejecutar modelos ONNX

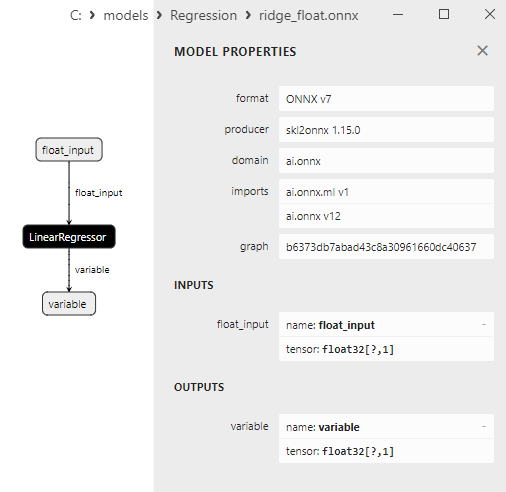

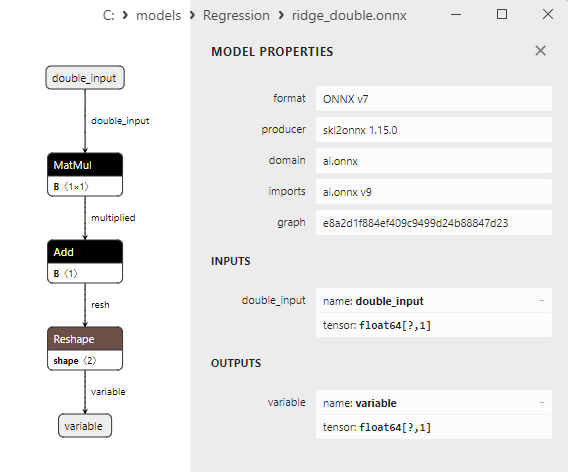

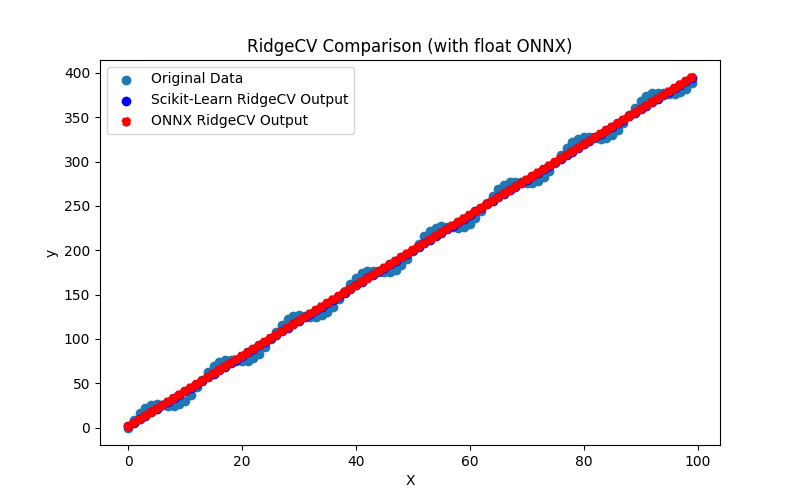

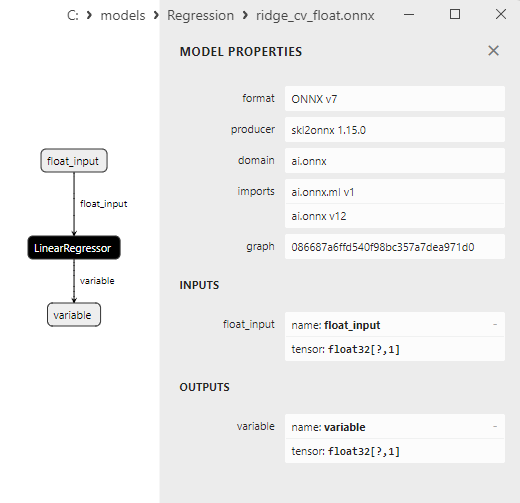

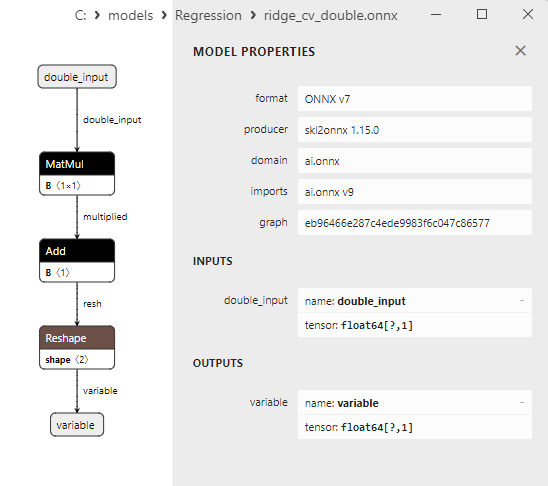

2.1.14.3. Representación ONNX de ridge_float.onnx y ridge_double.onnx - 2.1.15. sklearn.linear_model.RidgeCV

2.1.15.1. Código para crear el modelo RidgeCV y exportarlo a ONNX para float y double

2.1.15.2. Código MQL5 para ejecutar modelos ONNX

2.1.15.3. Representación ONNX de ridge_cv_float.onnx y ridge_cv_double.onnx - 2.1.16. sklearn.linear_model.OrthogonalMatchingPursuit

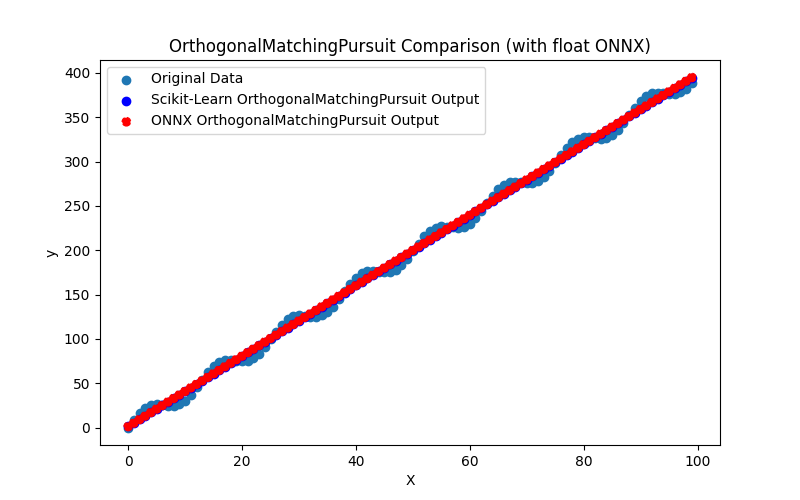

2.1.16.1. Código para crear el modelo OrthogonalMatchingPursuit y exportarlo a ONNX para float y double

2.1.16.2. Código MQL5 para ejecutar modelos ONNX

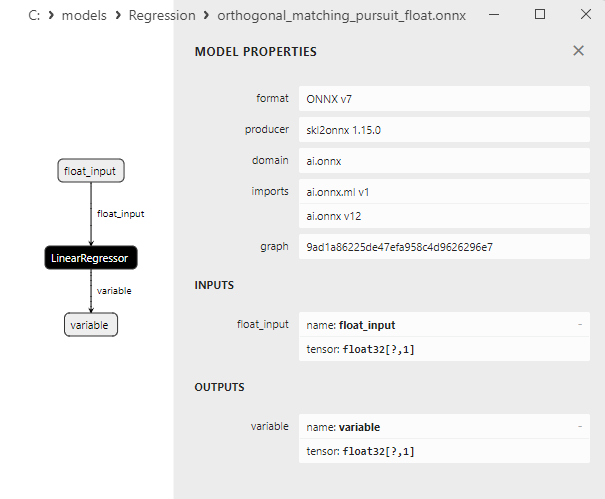

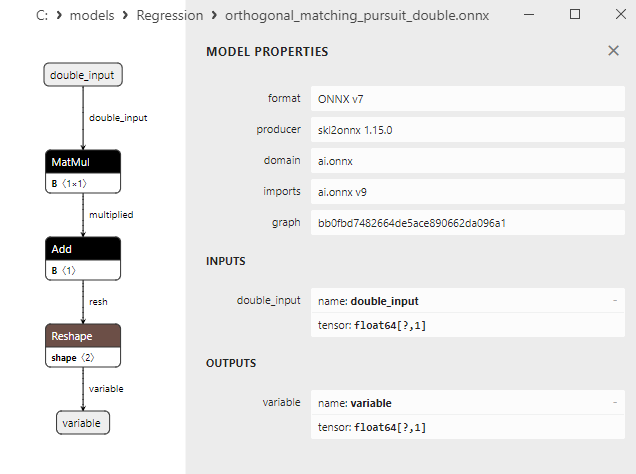

2.1.16.3. Representación ONNX de orthogonal_matching_pursuit_float.onnx y orthogonal_matching_pursuit_double.onnx - 2.1.17. sklearn.linear_model.PassiveAggressiveRegressor

2.1.17.1. Código para crear el modelo PassiveAggressiveRegressor y exportarlo a ONNX para float y double

2.1.17.2. Código MQL5 para ejecutar modelos ONNX

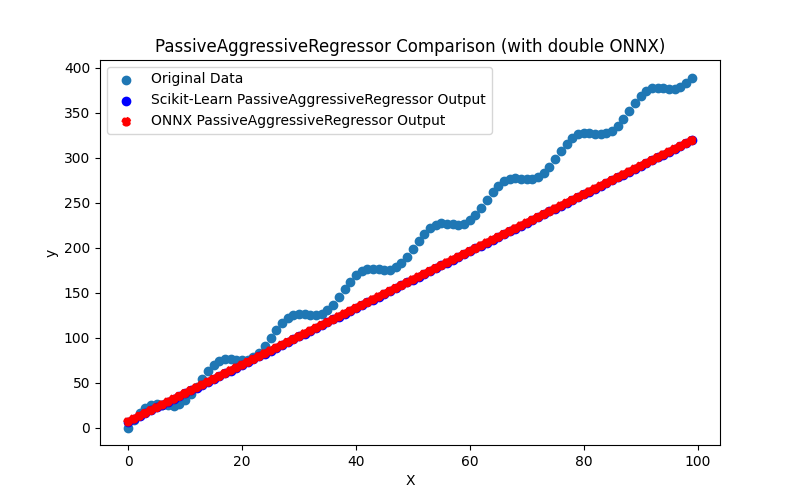

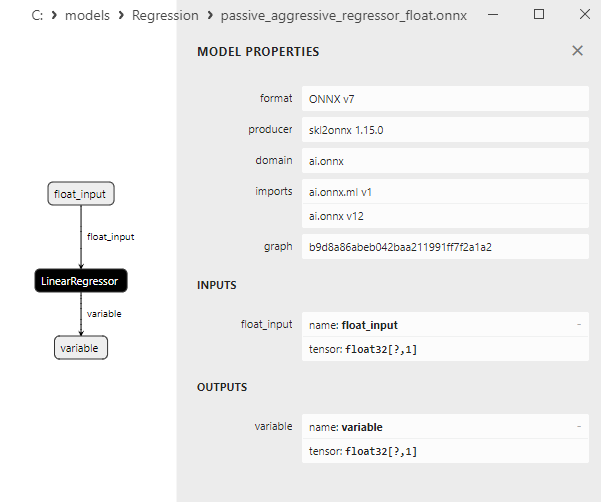

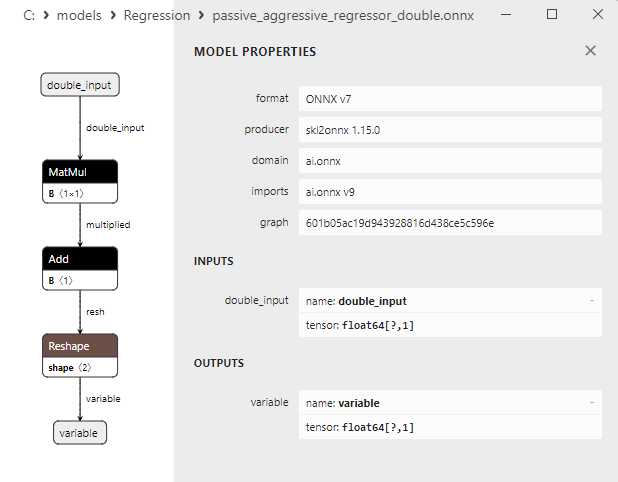

2.1.17.3. Representación ONNX de passive_aggressive_regressor_float.onnx y passive_aggressive_regressor_double.onnx - 2.1.18. sklearn.linear_model.QuantileRegressor

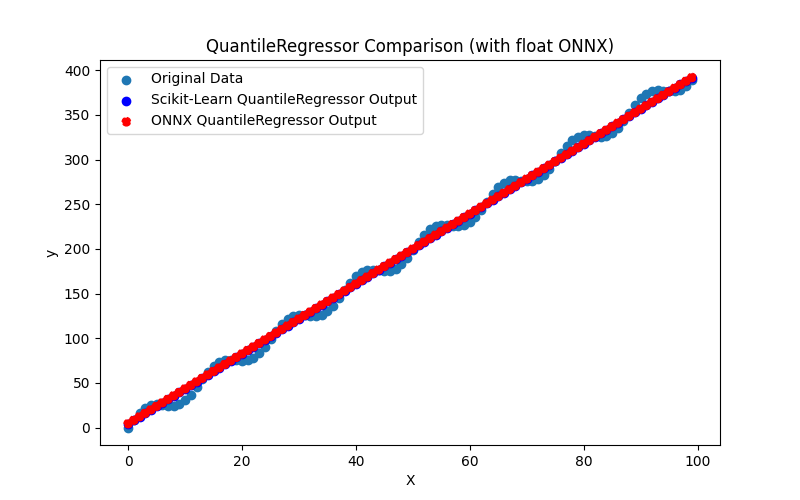

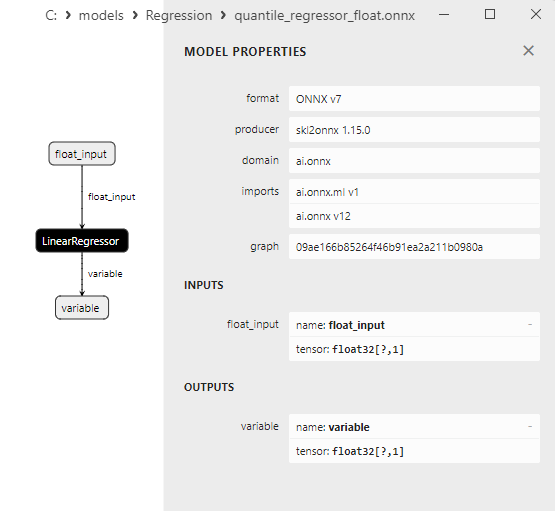

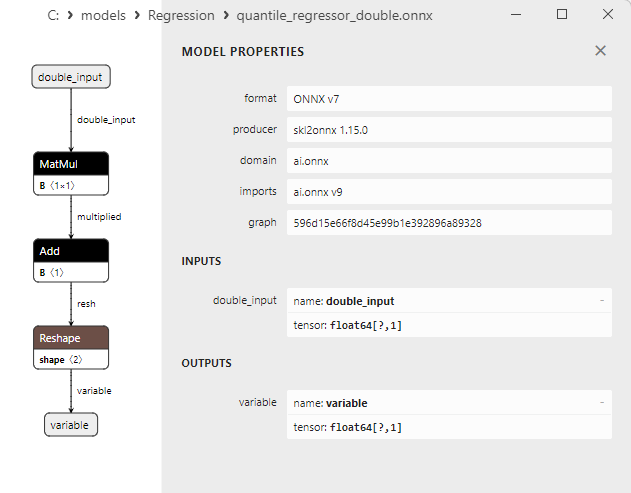

2.1.18.1. Código para crear el modelo QuantileRegressor y exportarlo a ONNX para float y double

2.1.18.2. Código MQL5 para ejecutar modelos ONNX

2.1.18.3. Representación ONNX de quantile_regressor_float.onnx y quantile_regressor_double.onnx - 2.1.19. sklearn.linear_model.RANSACRegressor

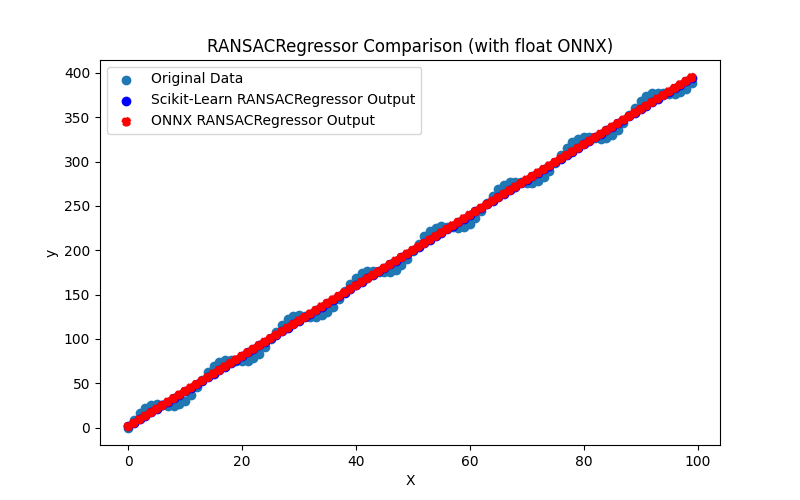

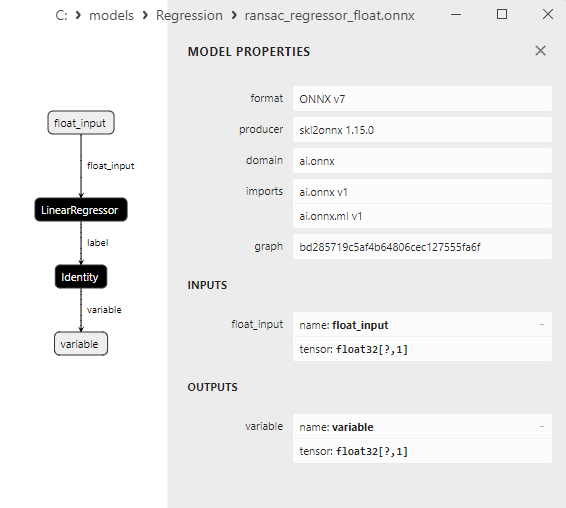

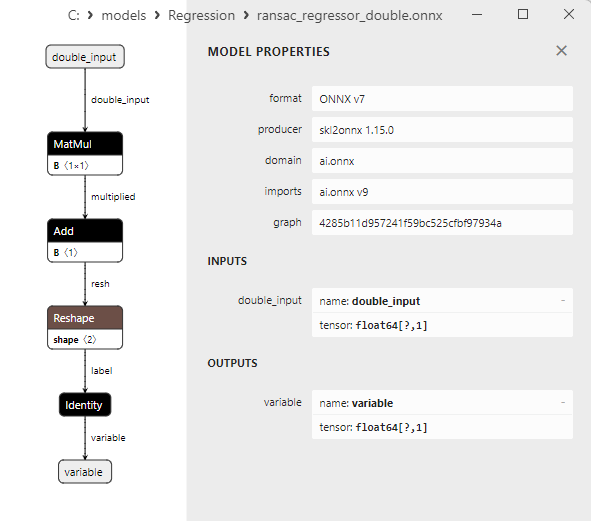

2.1.19.1. Código para crear el modelo RANSACRegressor y exportarlo a ONNX para float y double

2.1.19.2. Código MQL5 para ejecutar modelos ONNX

2.1.19.3. Representación ONNX de ransac_regressor_float.onnx y ransac_regressor_double.onnx - 2.1.20. sklearn.linear_model.TheilSenRegressor

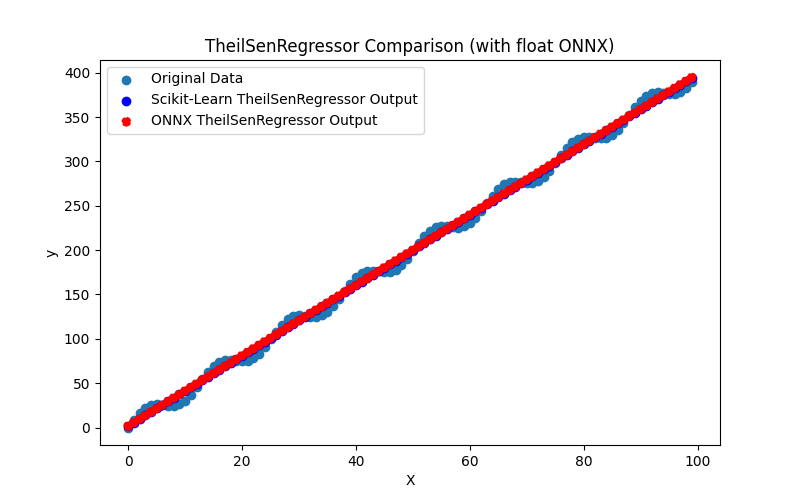

2.1.20.1. Código para crear el modelo TheilSenRegressor y exportarlo a ONNX para float y double

2.1.20.2. Código MQL5 para ejecutar modelos ONNX

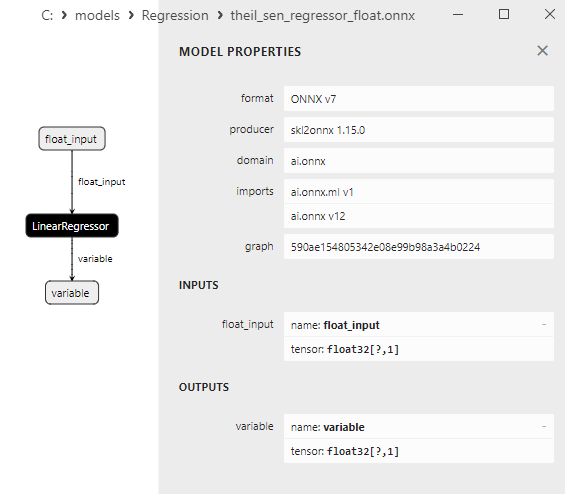

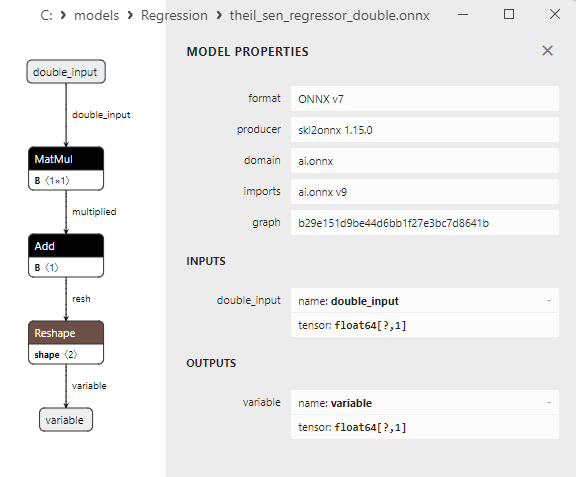

2.1.20.3. Representación ONNX de theil_sen_regressor_float.onnx y theil_sen_regressor_double.onnx - 2.1.21. sklearn.linear_model.LinearSVR

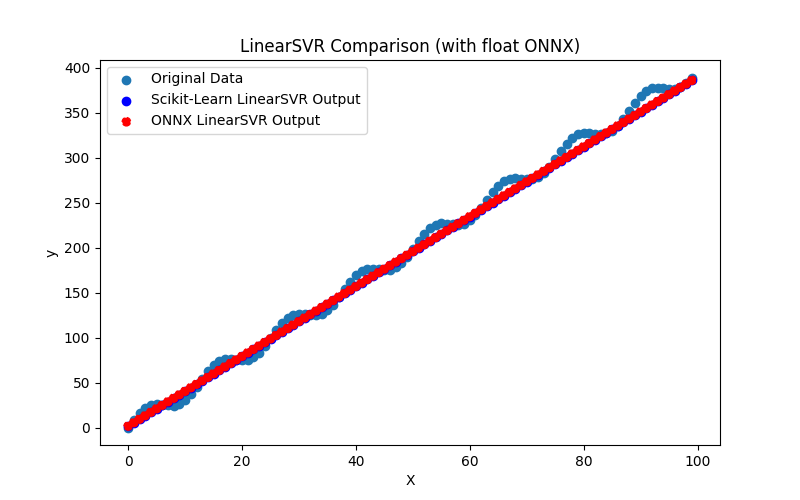

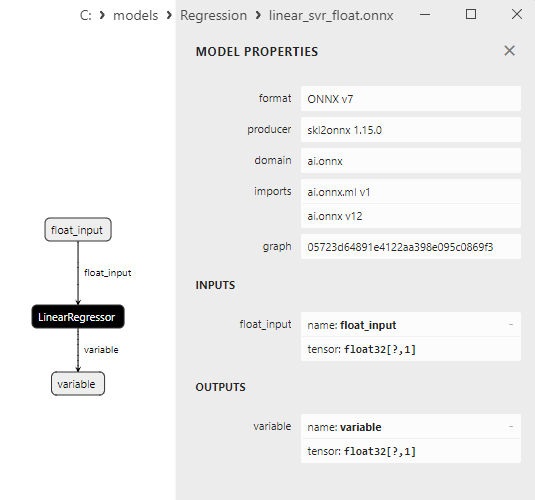

2.1.21.1. Código para crear el modelo LinearSVR y exportarlo a ONNX para float y double

2.1.21.2. Código MQL5 para ejecutar modelos ONNX

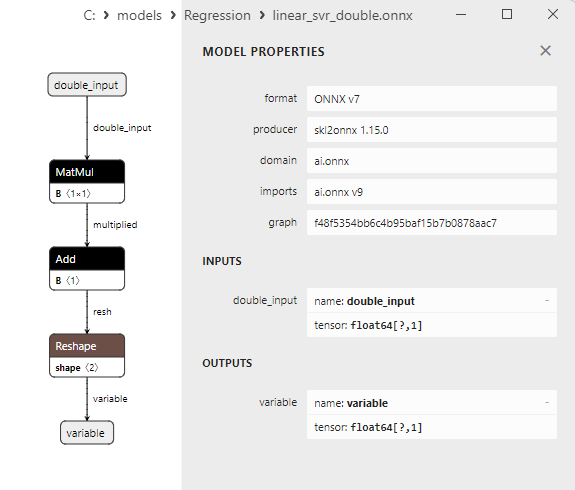

2.1.21.3. Representación ONNX de linear_svr_float.onnx y linear_svr_double.onnx - 2.1.22. sklearn.linear_model.MLPRegressor

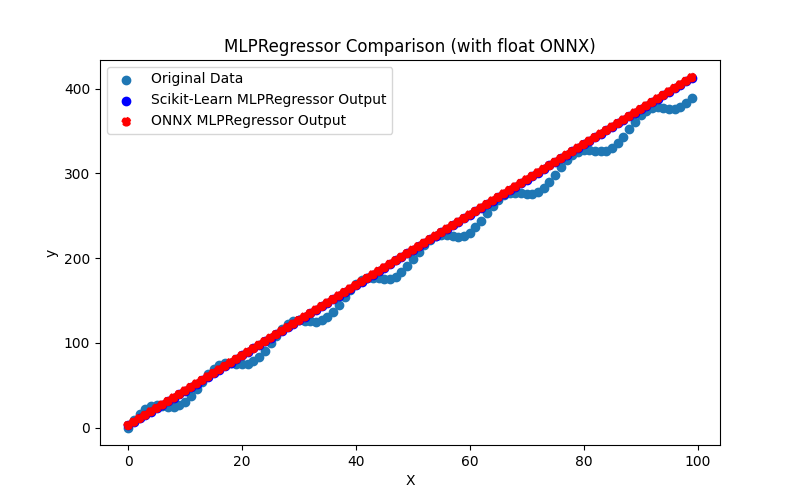

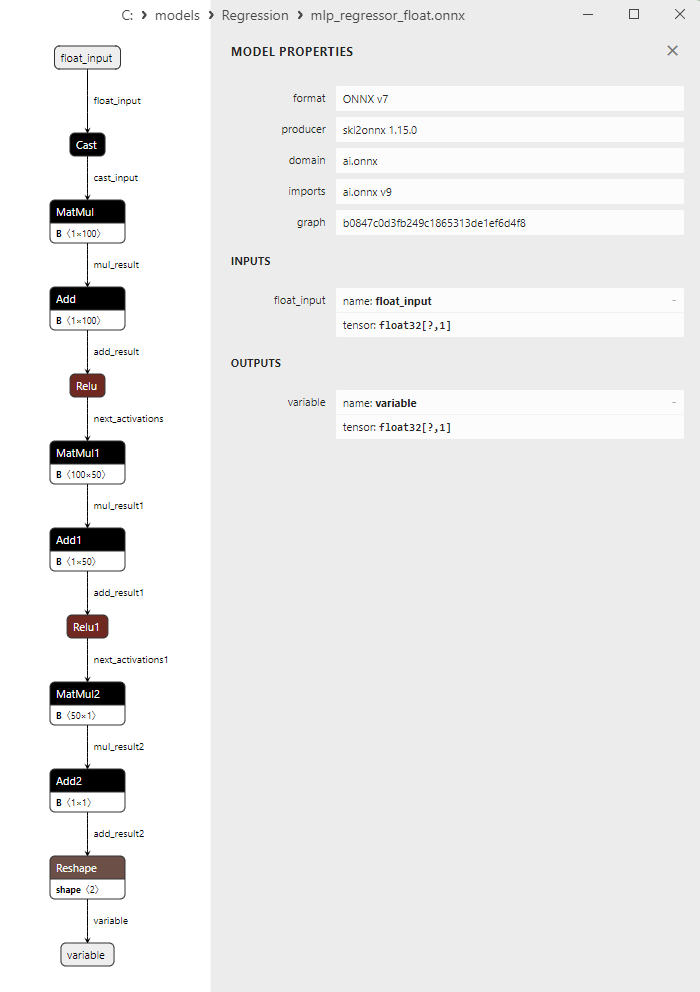

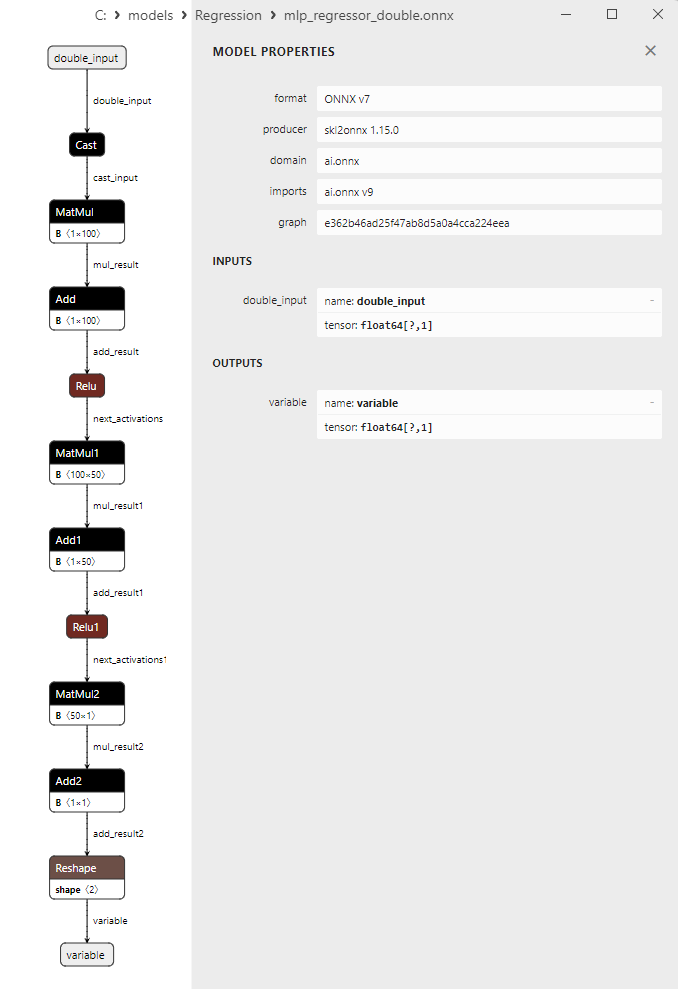

2.1.22.1. Código para crear el modelo MLPRegressor y exportarlo a ONNX para float y double

2.1.22.2. Código MQL5 para ejecutar modelos ONNX

2.1.22.3. Representación ONNX de mlp_regressor_float.onnx y mlp_regressor_double.onnx - 2.1.23. sklearn.cross_decomposition.PLSRegression

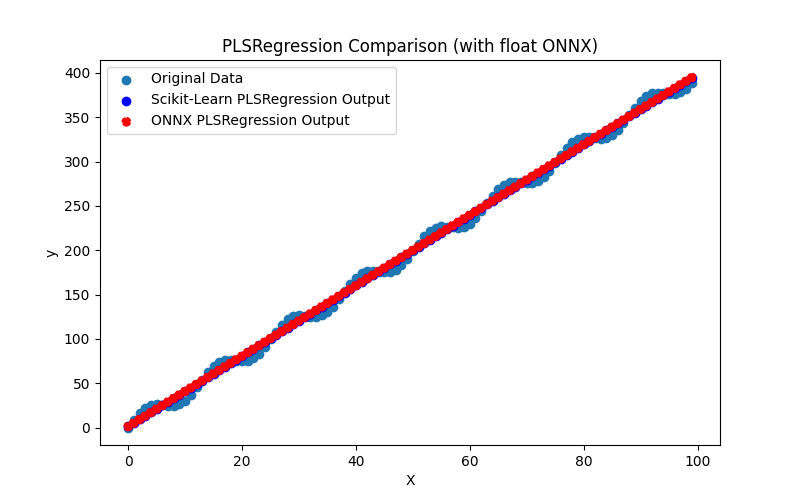

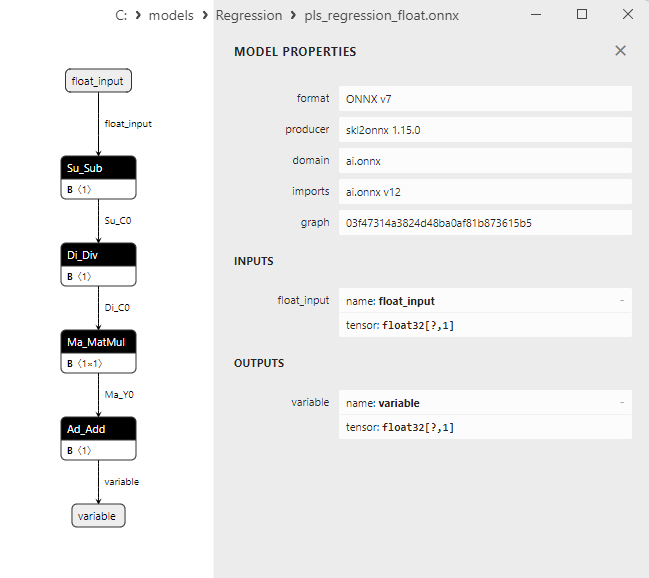

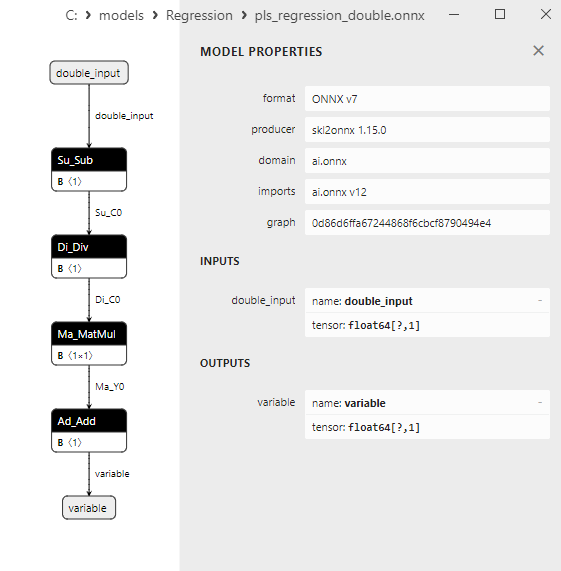

2.1.23.1. Código para crear el modelo PLSRegression y exportarlo a ONNX para float y double

2.1.23.2. Código MQL5 para ejecutar modelos ONNX

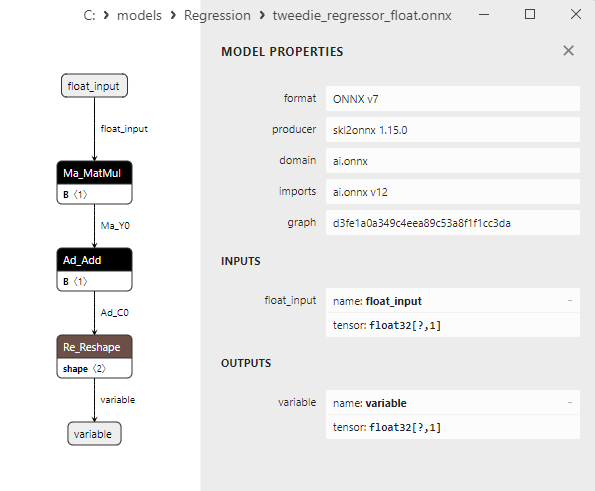

2.1.23.3. Representación ONNX de pls_regression_float.onnx y pls_regression_double.onnx - 2.1.24. sklearn.linear_model.TweedieRegressor

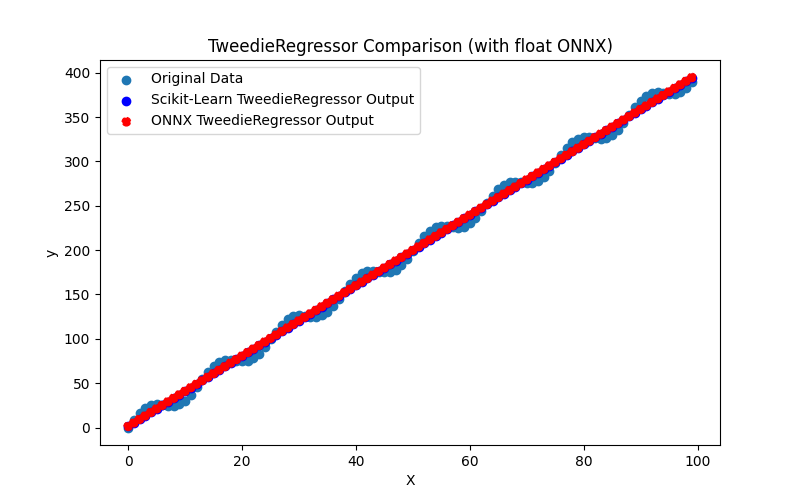

2.1.24.1. Código para crear el modelo TweedieRegressor y exportarlo a ONNX para float y double

2.1.24.2. Código MQL5 para ejecutar modelos ONNX

2.1.24.3. Representación ONNX de tweedie_regressor_float.onnx y tweedie_regressor_double.onnx - 2.1.25. sklearn.linear_model.PoissonRegressor

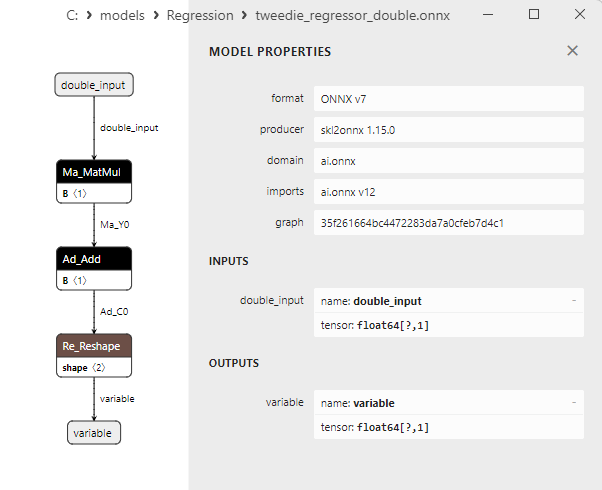

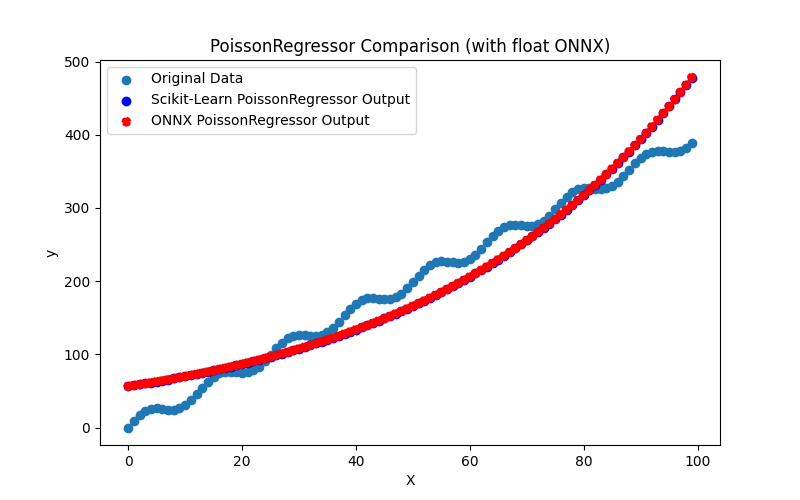

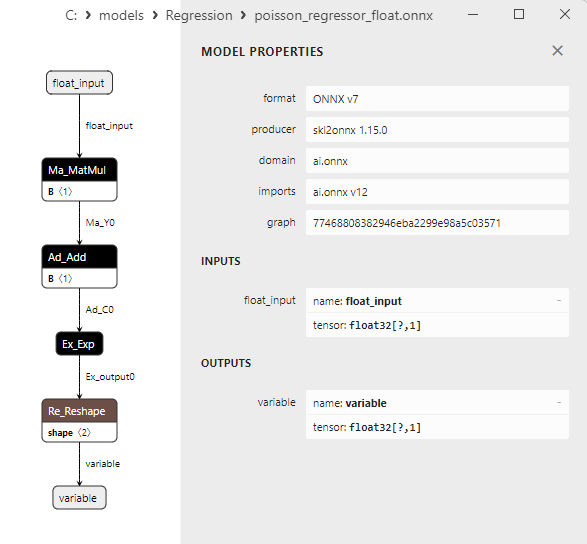

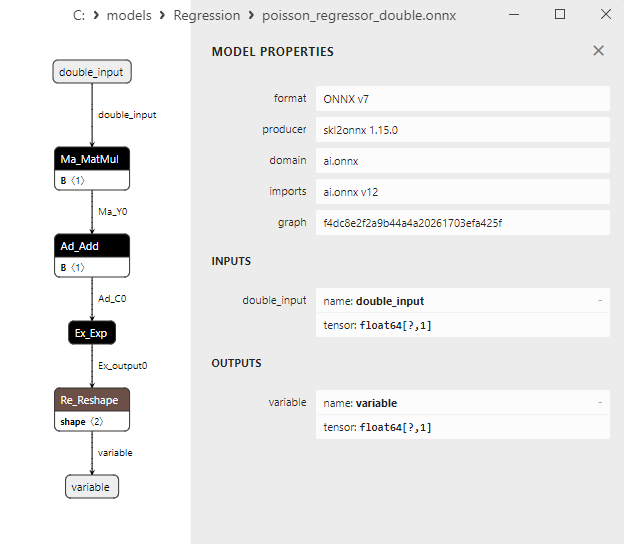

2.1.25.1. Código para crear el modelo PoissonRegressor y exportarlo a ONNX para float y double

2.1.25.2. Código MQL5 para ejecutar modelos ONNX

2.1.25.3. Representación ONNX de poisson_regressor_float.onnx y poisson_regressor_double.onnx - 2.1.26. sklearn.neighbors.RadiusNeighborsRegressor

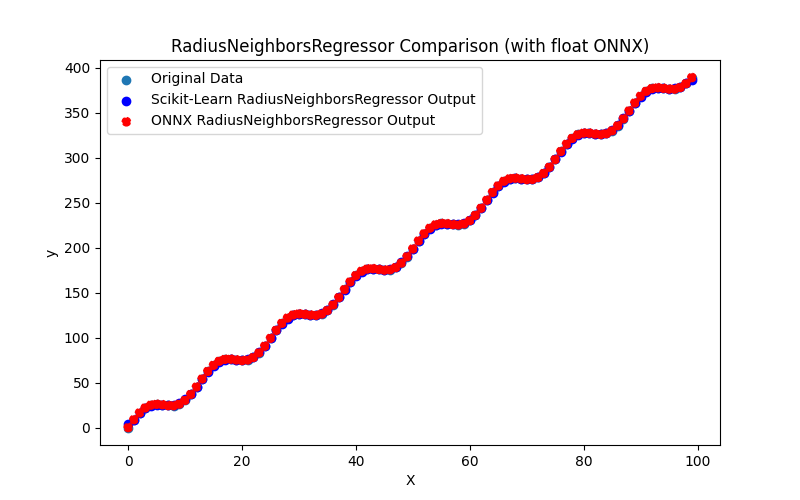

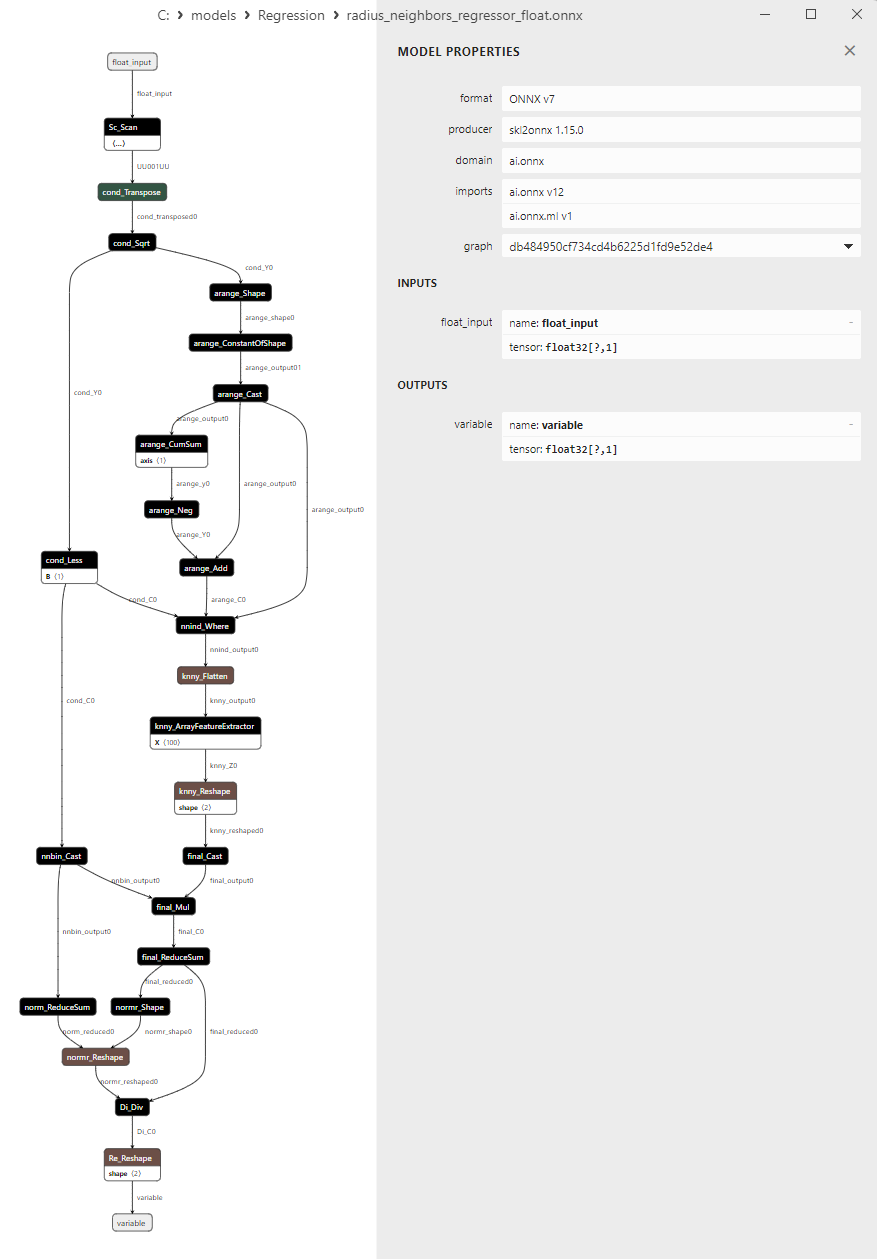

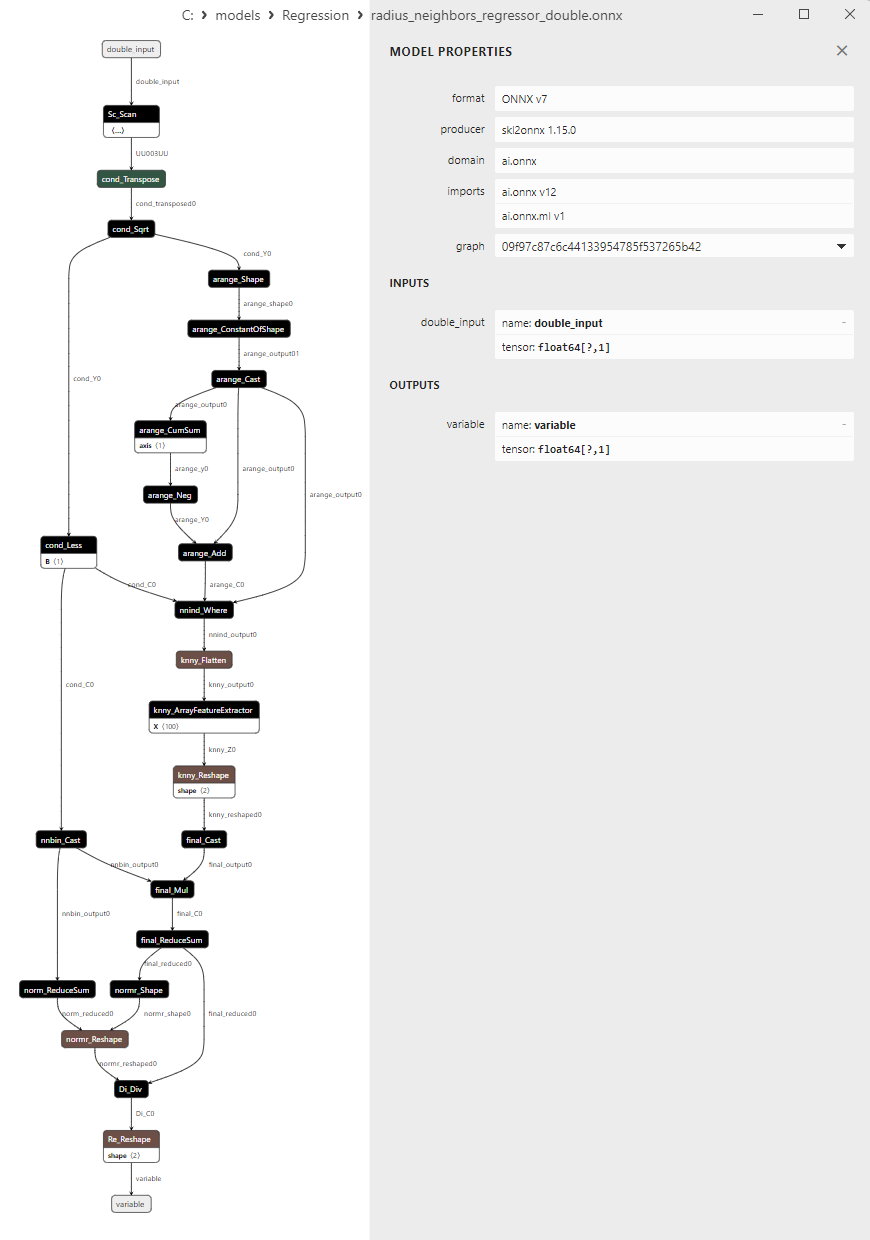

2.1.26.1. Código para crear el modelo RadiusNeighborsRegressor y exportarlo a ONNX para float y double

2.1.26.2. Código MQL5 para ejecutar modelos ONNX

2.1.26.3. Representación ONNX de radius_neighbors_regressor_float.onnx y radius_neighbors_regressor_double.onnx - 2.1.27. sklearn.neighbors.KNeighborsRegressor

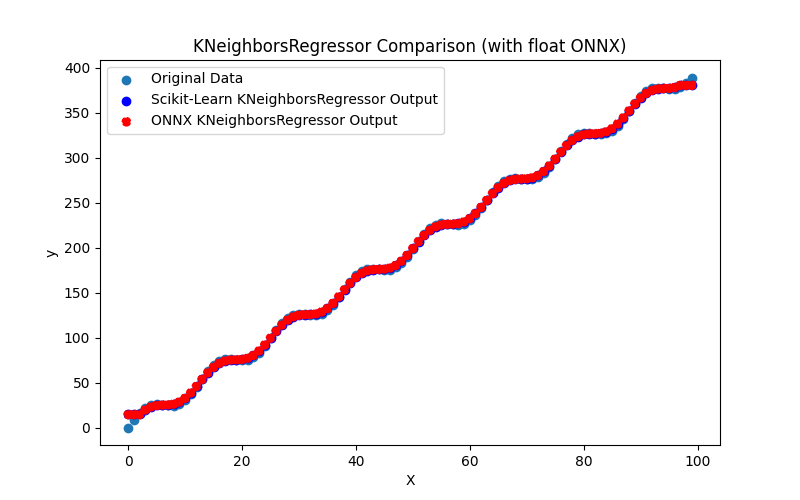

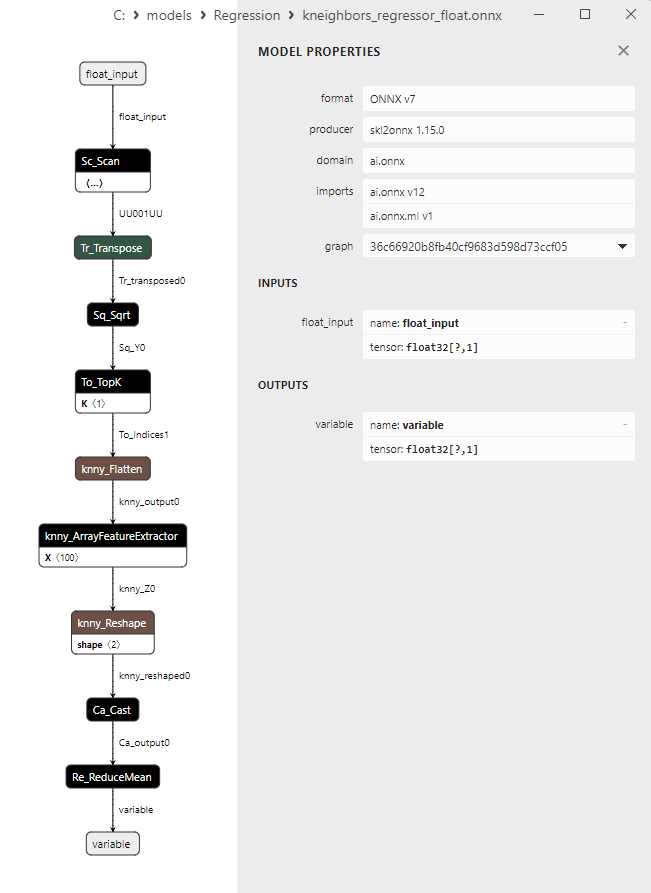

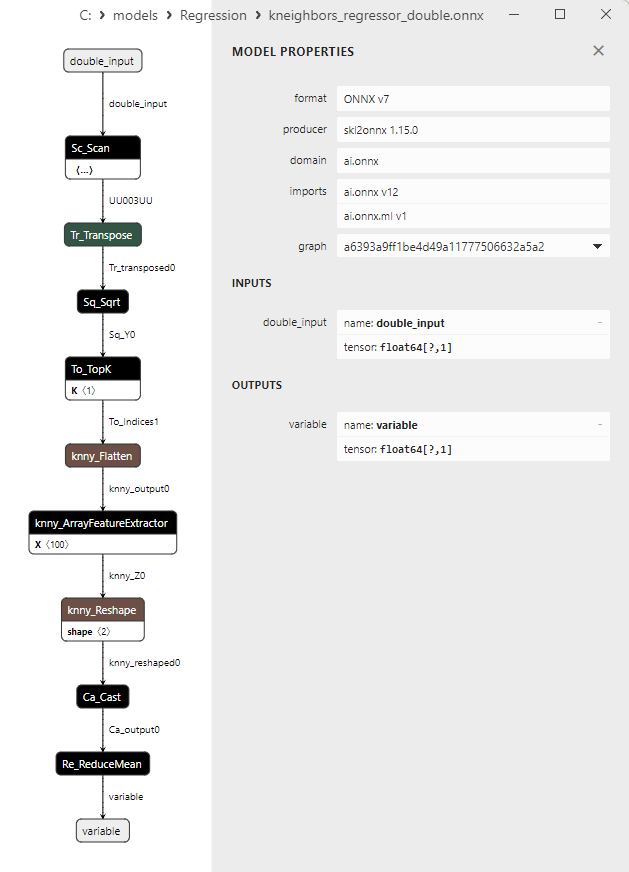

2.1.27.1. Código para crear el modelo KNeighborsRegressor y exportarlo a ONNX para float y double

2.1.27.2. Código MQL5 para ejecutar modelos ONNX

2.1.27.3. Representación ONNX de kneighbors_regressor_float.onnx y kneighbors_regressor_double.onnx

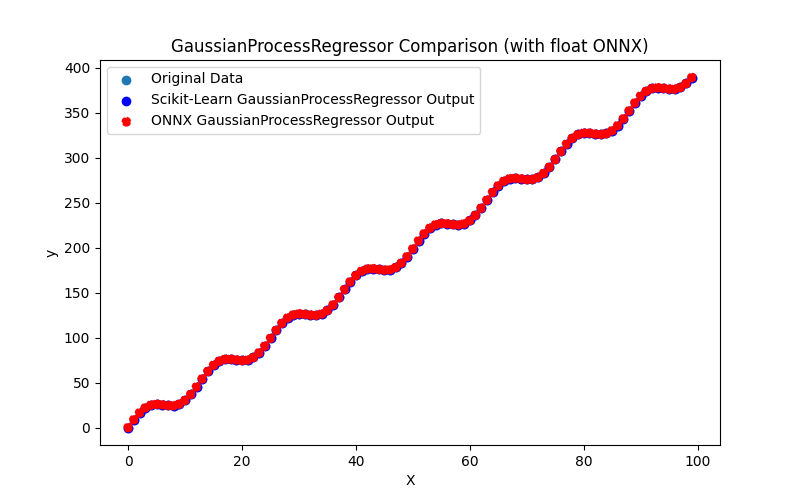

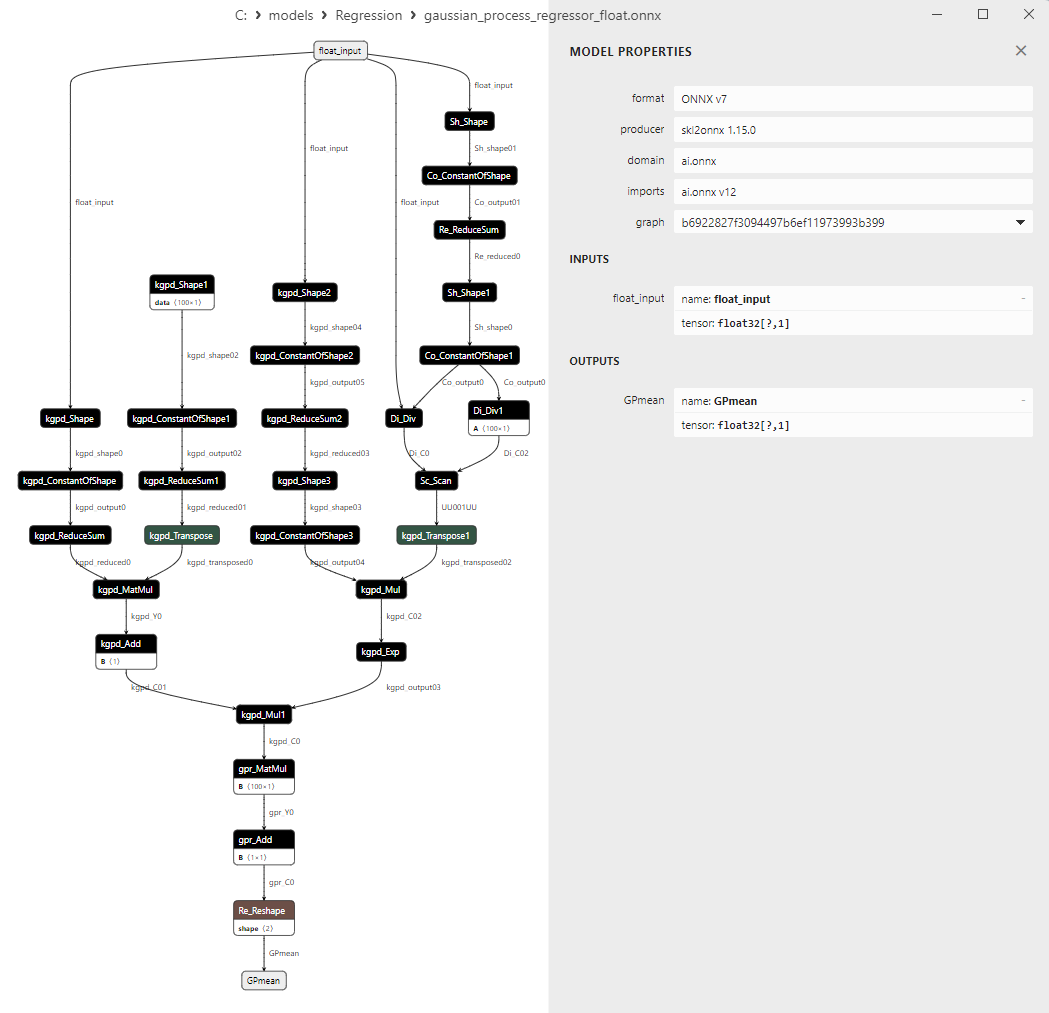

- 2.1.28. sklearn.gaussian_process.GaussianProcessRegressor

2.1.28.1. Código para crear el modelo GaussianProcessRegressor y exportarlo a ONNX para float y double

2.1.28.2. Código MQL5 para ejecutar modelos ONNX

2.1.28.3. Representación ONNX de gaussian_process_regressor_float.onnx y gaussian_process_regressor_double.onnx

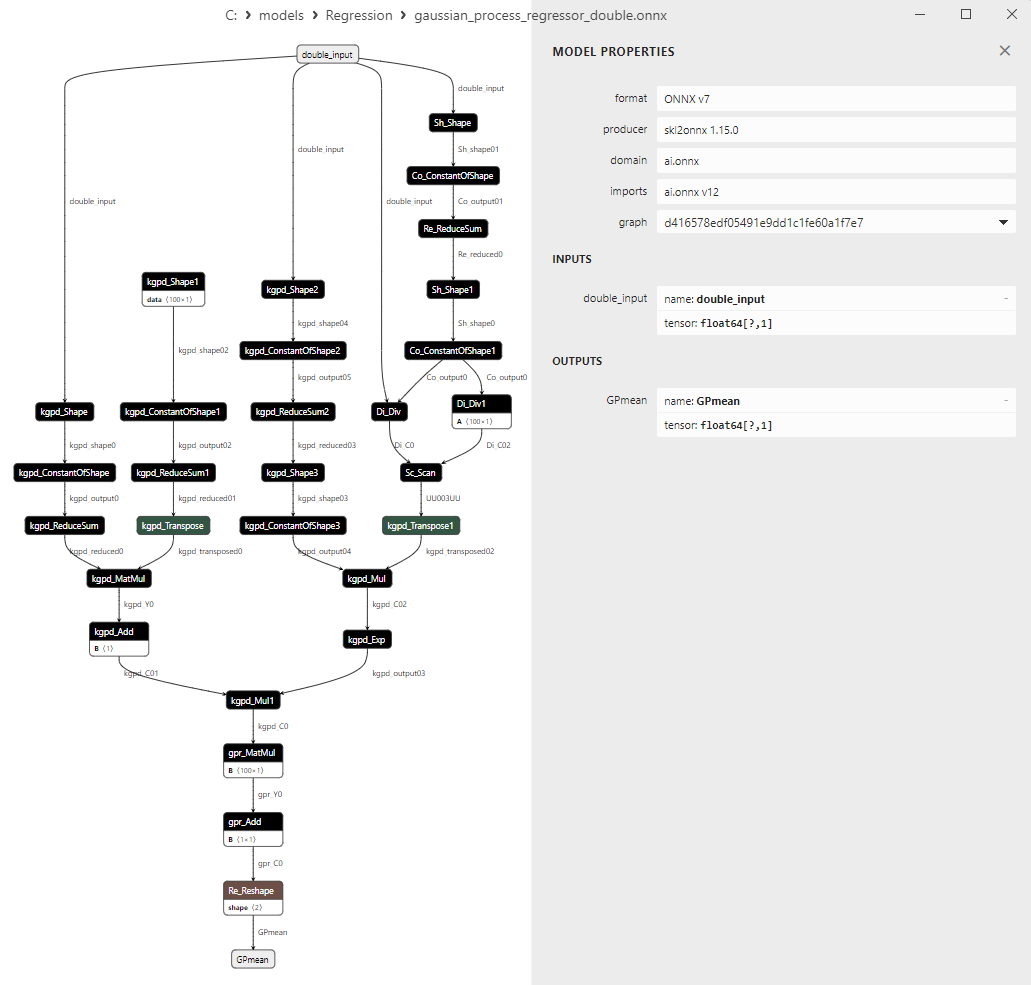

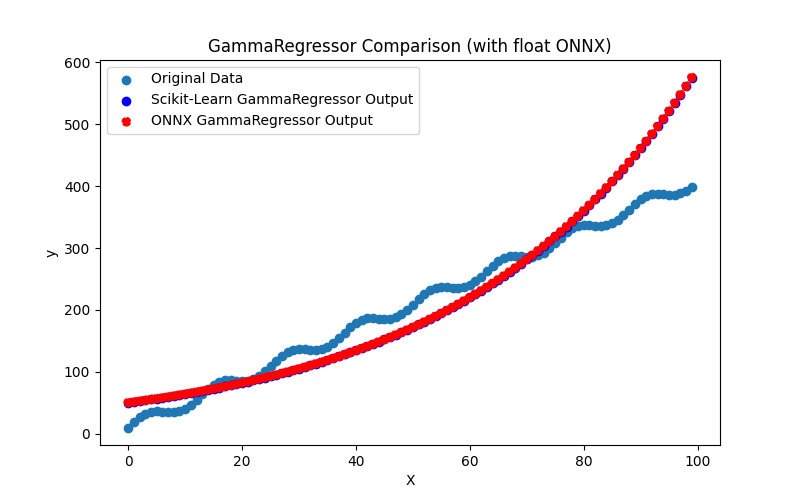

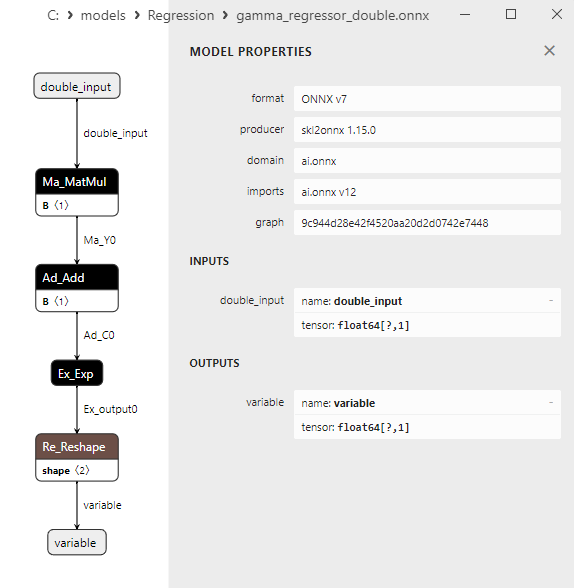

- 2.1.29. sklearn.linear_model.GammaRegressor

2.1.29.1. Código para crear el modelo GammaRegressor y exportarlo a ONNX para float y double

2.1.29.2. Código MQL5 para ejecutar modelos ONNX

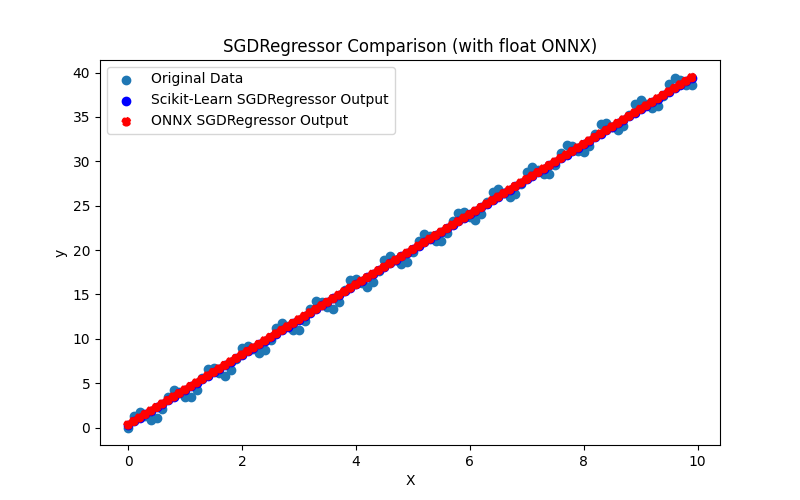

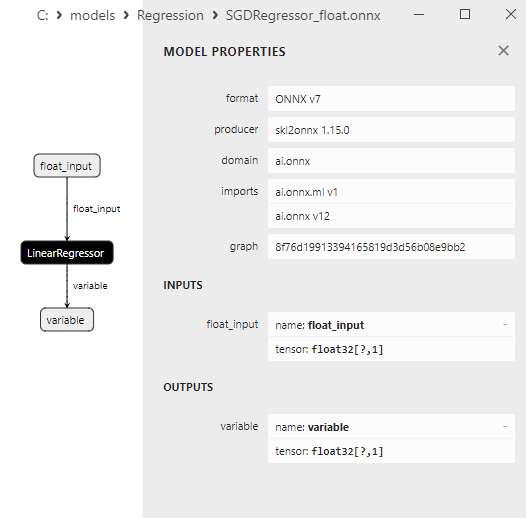

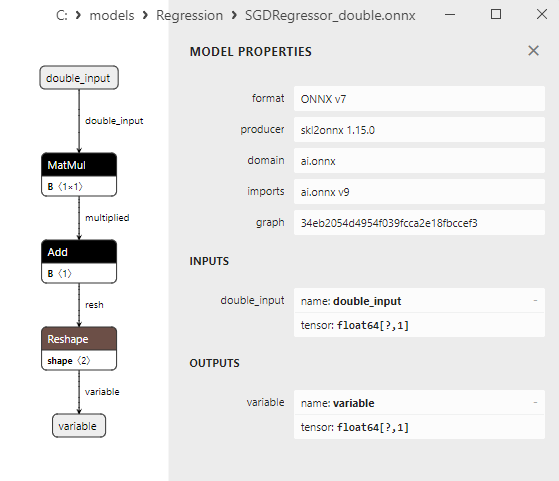

2.1.29.3. Representación ONNX de gamma_regressor_float.onnx y gamma_regressor_double.onnx - 2.1.30. sklearn.linear_model.SGDRegressor

2.1.30.1. Código para crear el modelo SGDRegressor y exportarlo a ONNX para float y double

2.1.30.2. Código MQL5 para ejecutar modelos ONNX

2.1.30.3. Representación ONNX de sgd_regressor_float.onnx y sgd_rgressor_double.onnx

- 2.2. Modelos de regresión de la biblioteca Scikit-learn convertidos sólo en modelos ONNX de precisión flotante

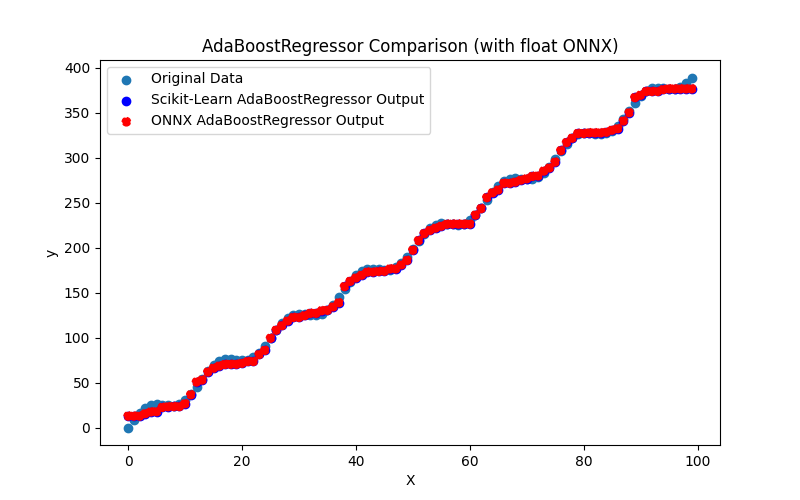

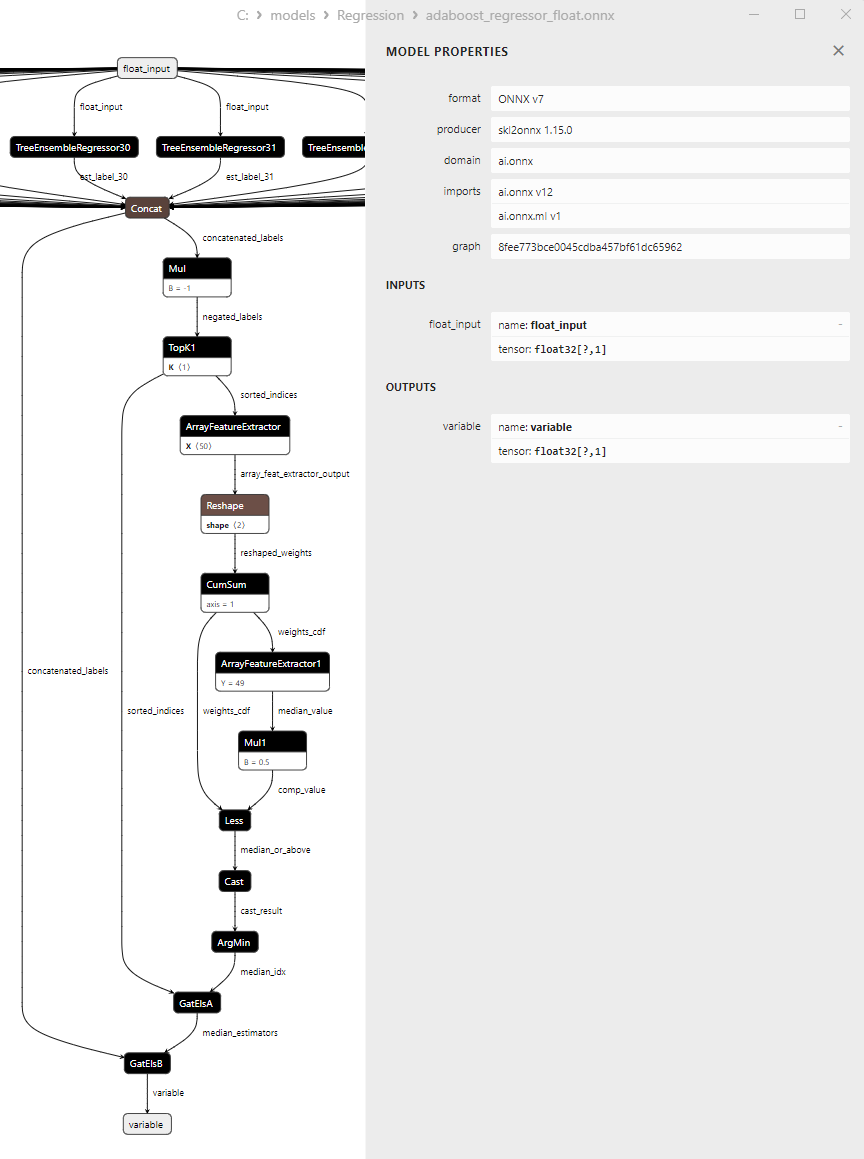

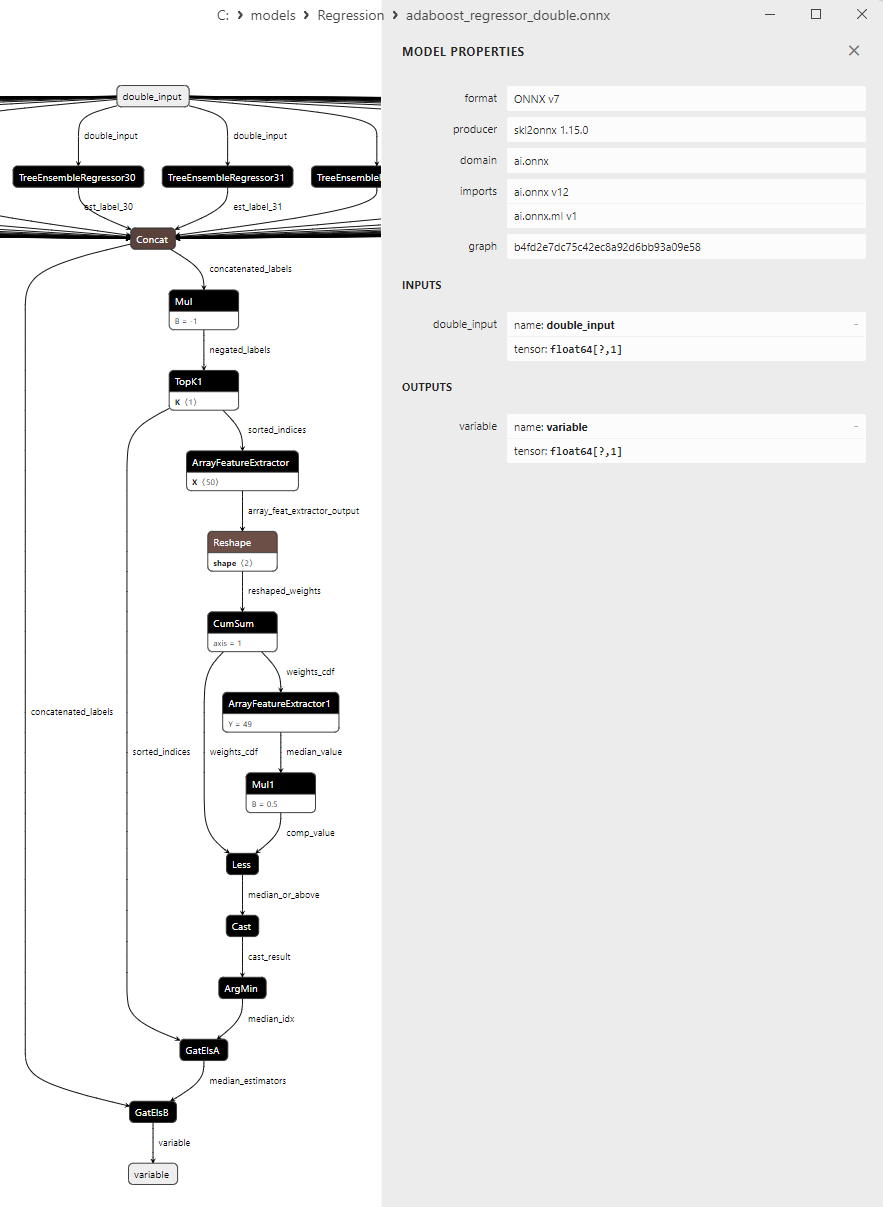

- 2.2.1. sklearn.linear_model.AdaBoostRegressor

2.2.1.1. Código para crear el modelo AdaBoostRegressor y exportarlo a ONNX para float y double

2.2.1.2. Código MQL5 para ejecutar modelos ONNX

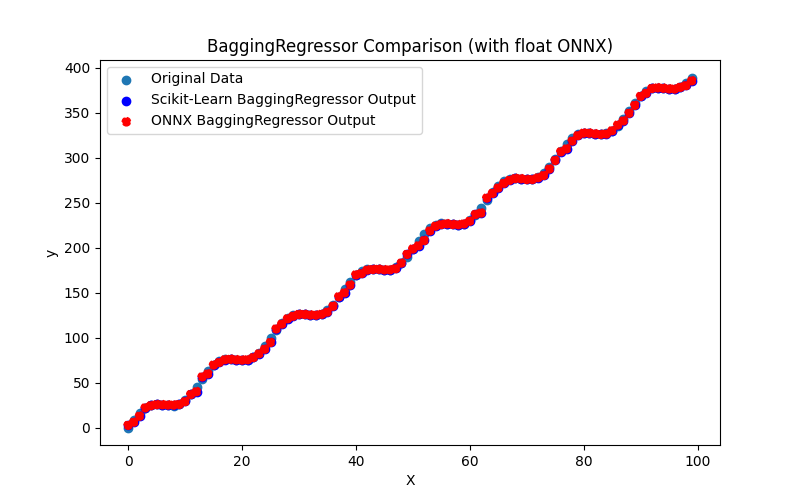

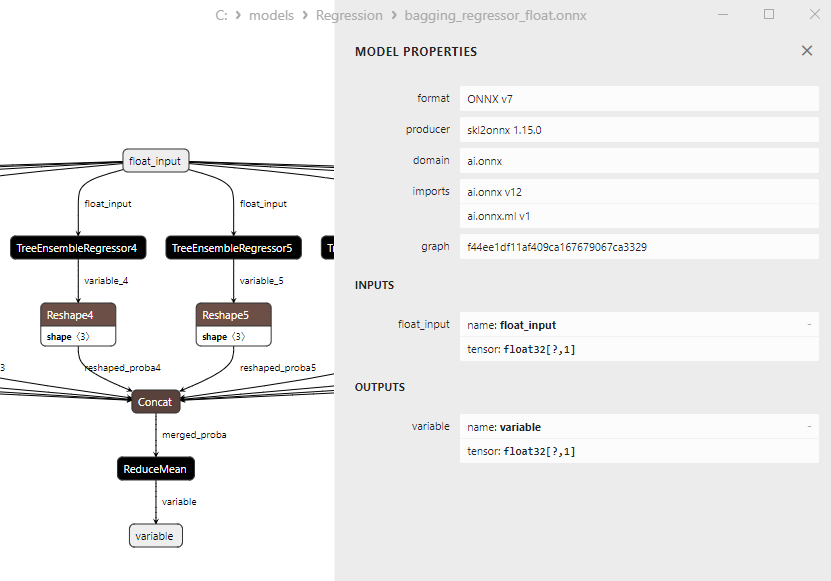

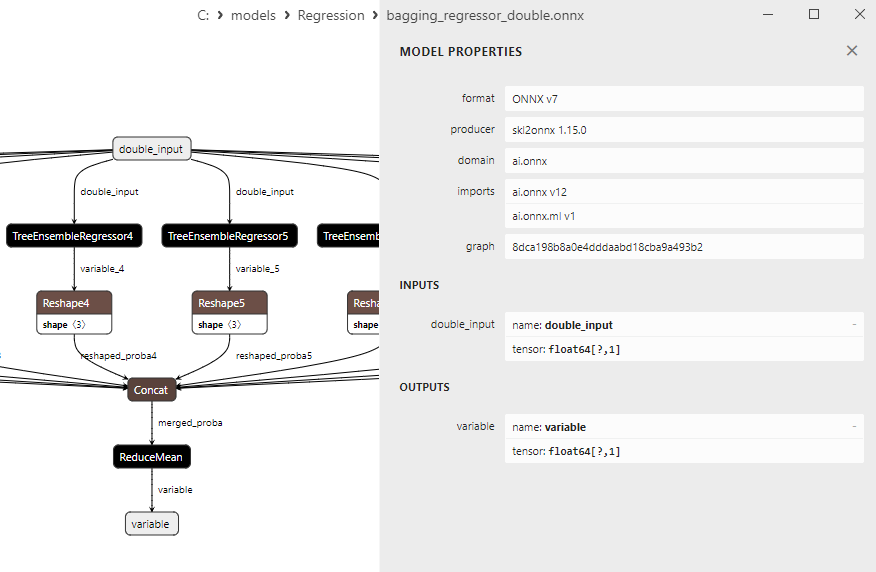

2.2.1.3. Representación ONNX de adaboost_regressor_float.onnx y adaboost_regressor_double.onnx - 2.2.2. sklearn.linear_model.BaggingRegressor

2.2.2.1. Código para crear el modelo BaggingRegressor y exportarlo a ONNX para float y double

2.2.2.2. Código MQL5 para ejecutar modelos ONNX

2.2.2.3. Representación ONNX de bagging_regressor_float.onnx y bagging_regressor_double.onnx - 2.2.3. sklearn.linear_model.DecisionTreeRegressor

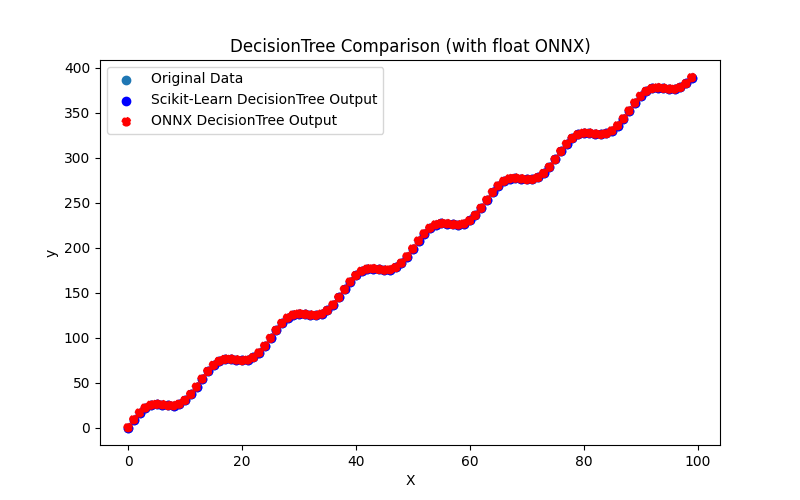

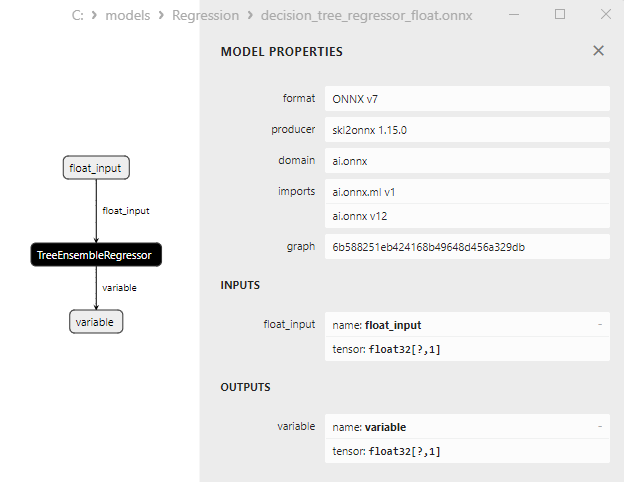

2.2.3.1. Código para crear el modelo DecisionTreeRegressor y exportarlo a ONNX para float y double

2.2.3.2. Código MQL5 para ejecutar modelos ONNX

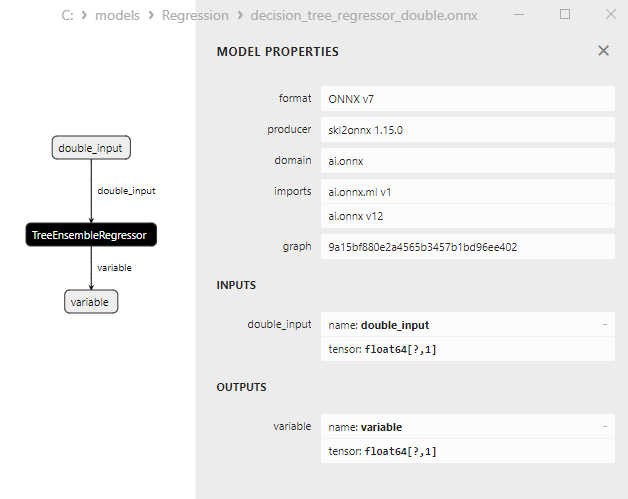

2.2.3.3. Representación ONNX de decision_tree_regressor_float.onnx y decision_tree_regressor_double.onnx - 2.2.4. sklearn.linear_model.ExtraTreeRegressor

2.2.4.1. Código para crear el modelo ExtraTreeRegressor y exportarlo a ONNX para float y double

2.2.4.2. Código MQL5 para ejecutar modelos ONNX

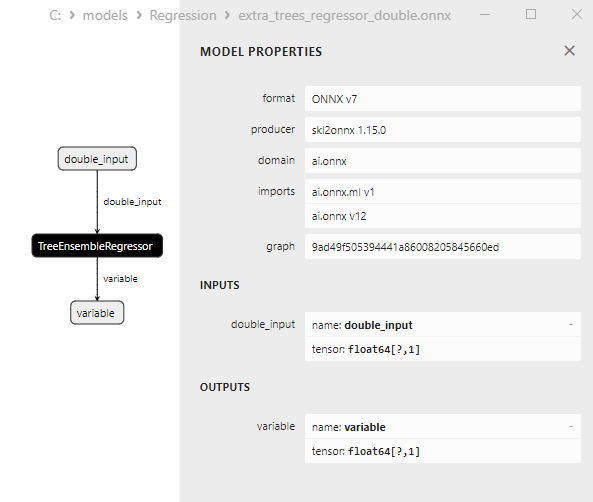

2.2.4.3. Representación ONNX de extra_tree_regressor_float.onnx y extra_tree_regressor_double.onnx - 2.2.5. sklearn.ensemble.ExtraTreesRegressor

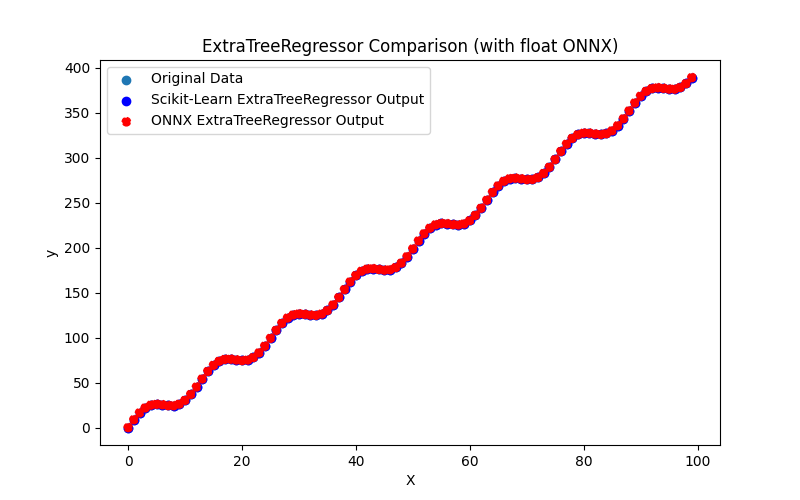

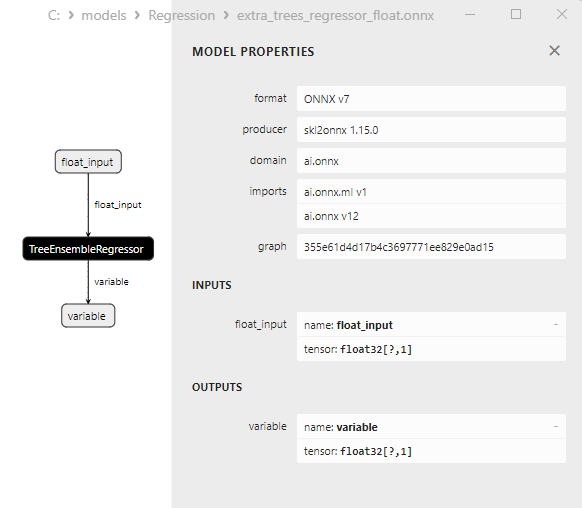

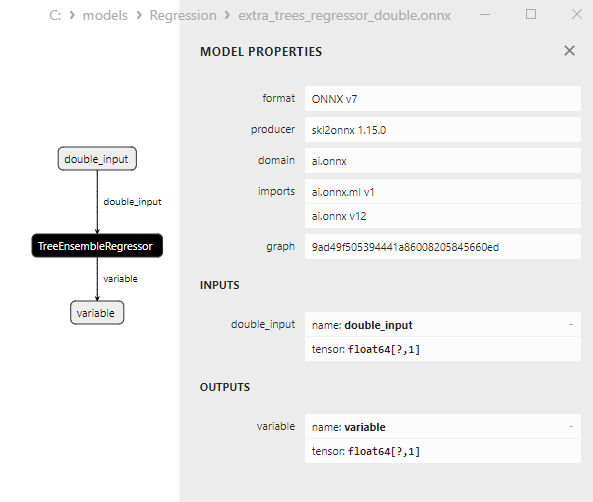

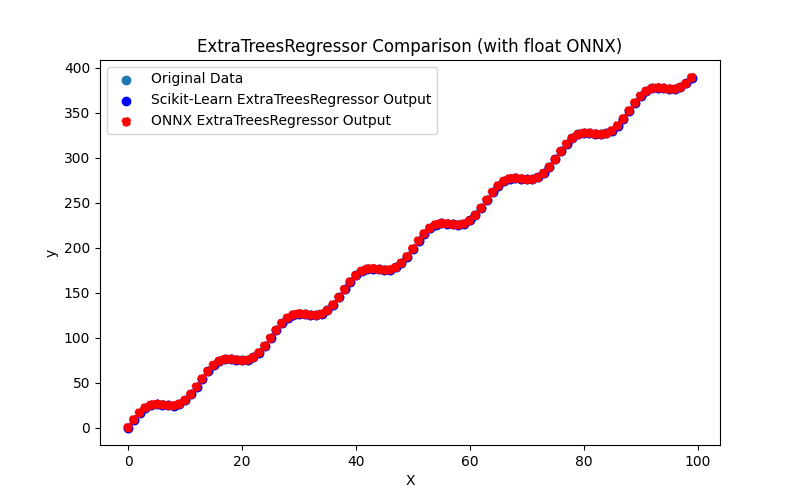

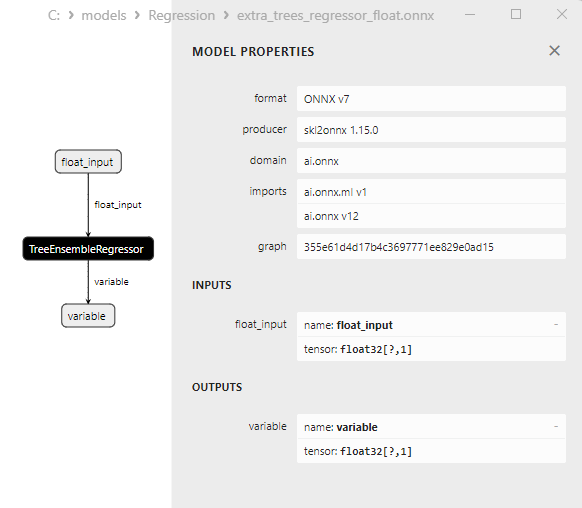

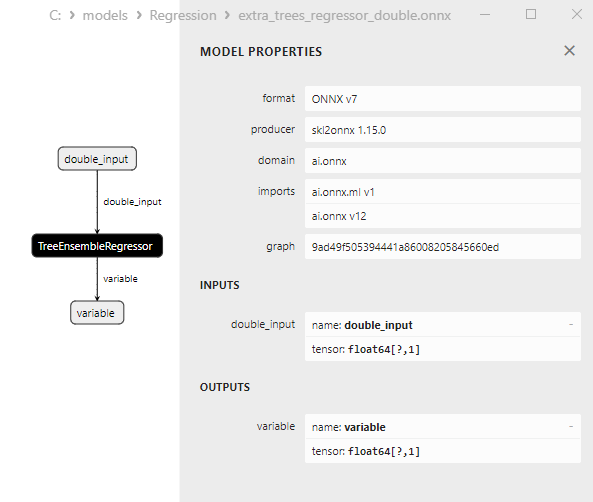

2.2.5.1. Código para crear el modelo ExtraTreesRegressor y exportarlo a ONNX para float y double

2.2.5.2. Código MQL5 para ejecutar modelos ONNX

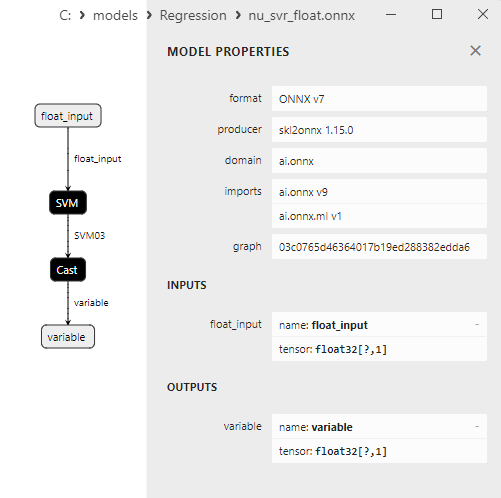

2.2.5.3. Representación ONNX de extra_trees_regressor_float.onnx y extra_trees_regressor_double.onnx - 2.2.6. sklearn.svm.NuSVR

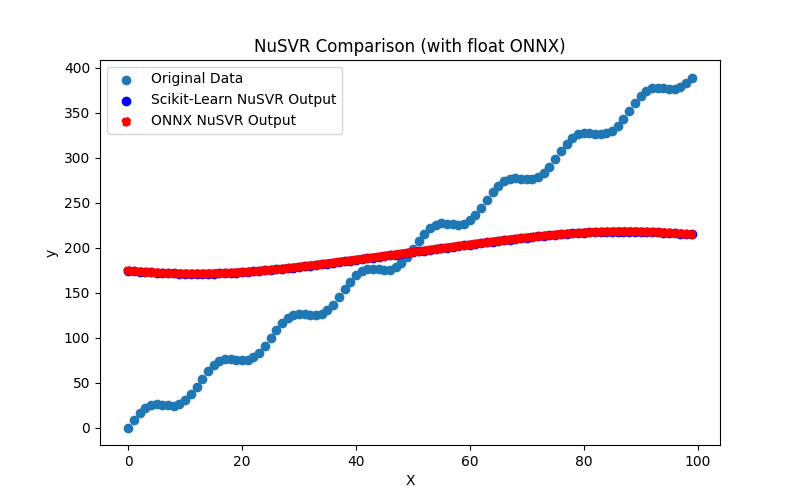

2.2.6.1. Código para crear el modelo NuSVR y exportarlo a ONNX para float y double

2.2.6.2. Código MQL5 para ejecutar modelos ONNX

2.2.6.3. Representación ONNX de nu_svr_float.onnx y nu_svr_double.onnx - 2.2.7. sklearn.ensemble.RandomForestRegressor

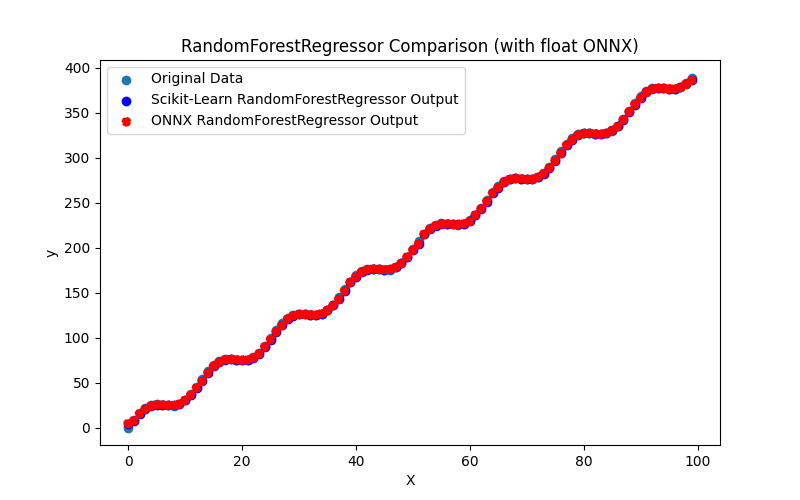

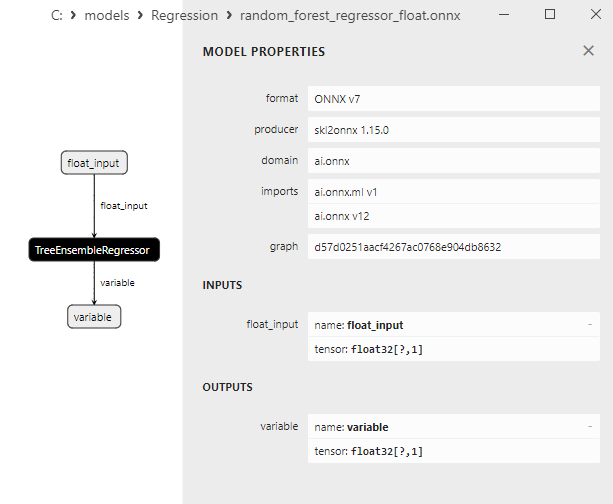

2.2.7.1. Código para crear el modelo RandomForestRegressor y exportarlo a ONNX para float y double

2.2.7.2. Código MQL5 para ejecutar modelos ONNX

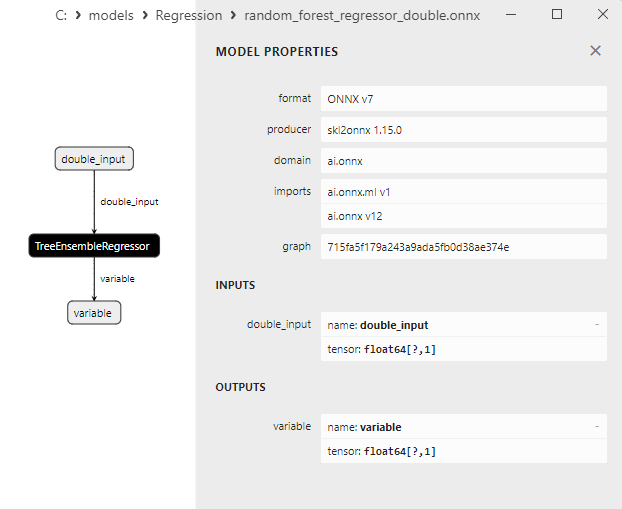

2.2.7.3. Representación ONNX de random_forest_regressor_float.onnx y random_forest_regressor_double.onnx

- 2.2.8. sklearn.ensemble.GradientBoostingRegressor

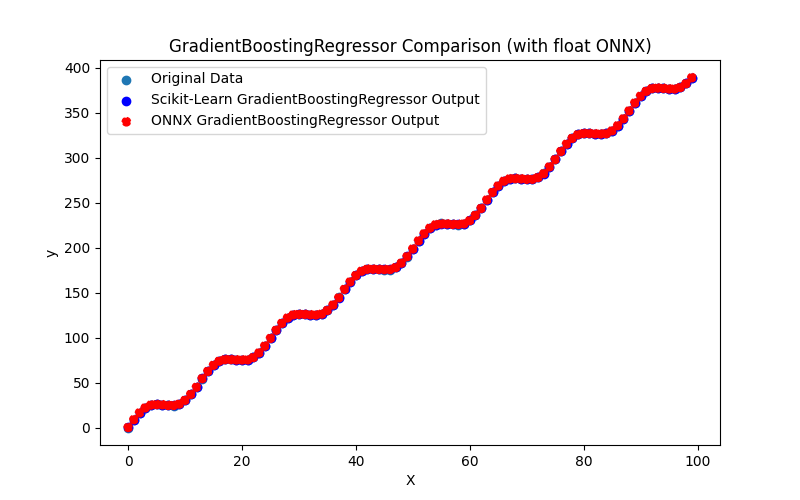

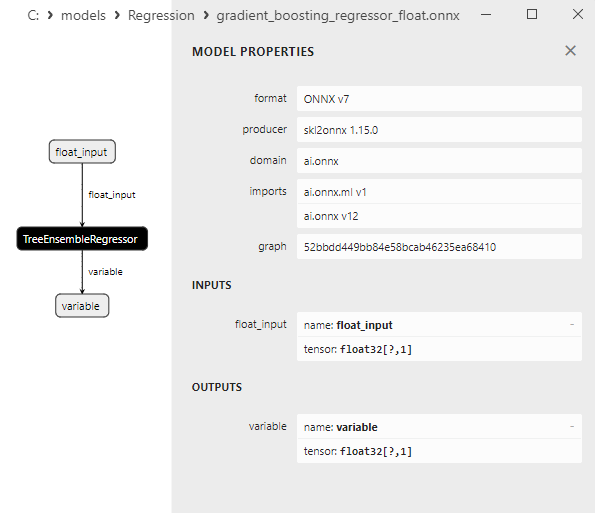

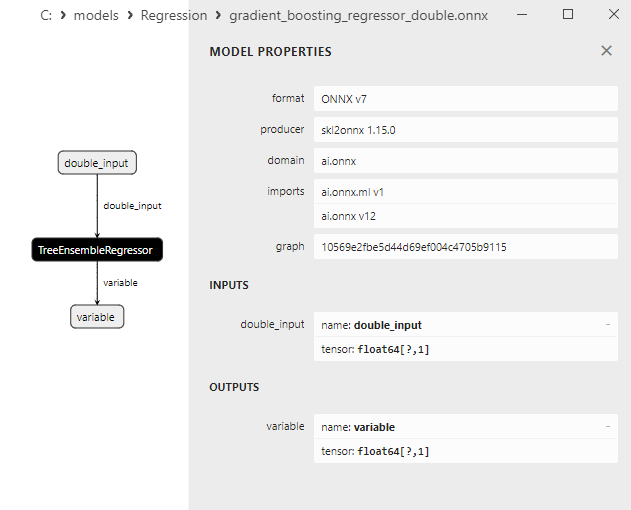

2.2.8.1. Código para crear el modelo GradientBoostingRegressor y exportarlo a ONNX para float y double

2.2.8.2. Código MQL5 para ejecutar modelos ONNX

2.2.8.3. Representación ONNX del gradient_boosting_regressor_float.onnx y gradient_boosting_regressor_double.onnx

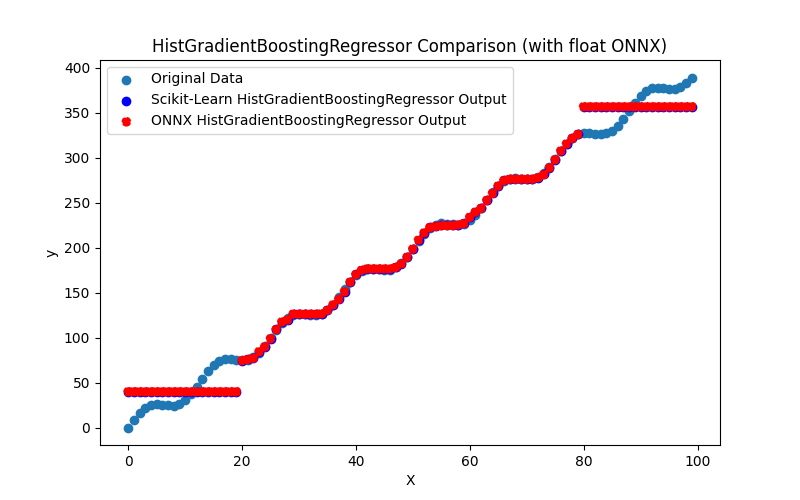

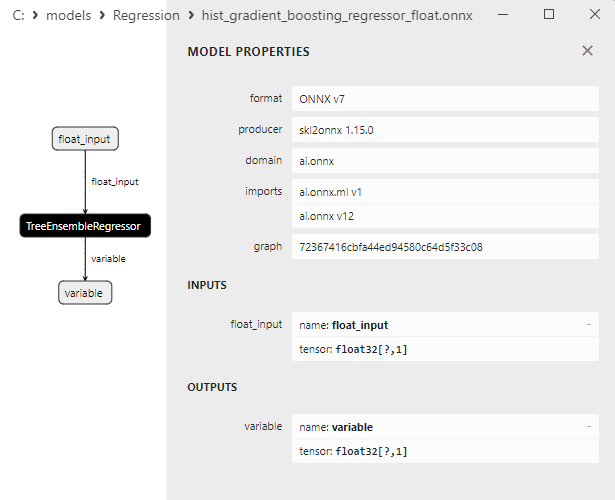

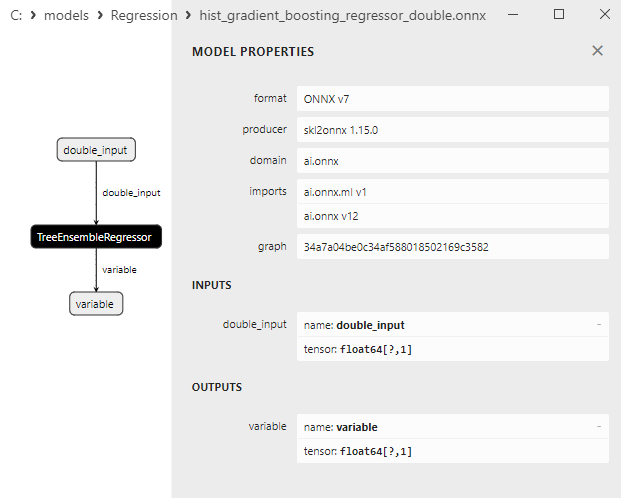

- 2.2.9. sklearn.ensemble.HistGradientBoostingRegressor

2.2.9.1. Código para crear el modelo HistGradientBoostingRegressor y exportarlo a ONNX para float y double

2.2.9.2. Código MQL5 para ejecutar modelos ONNX

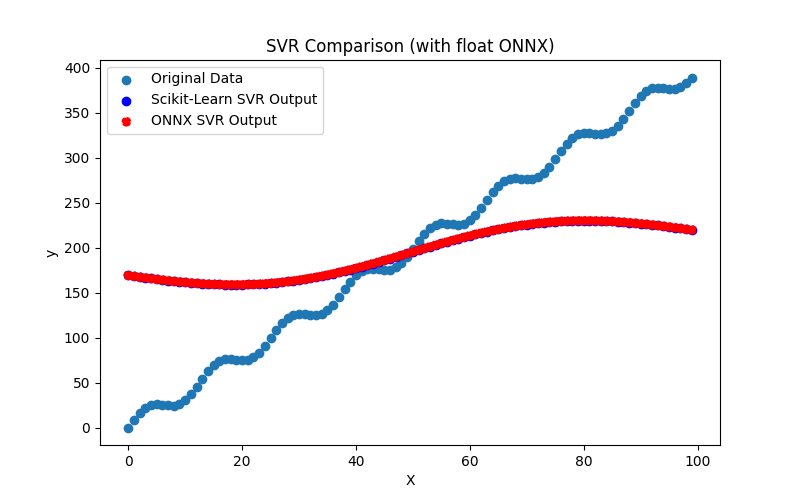

2.2.9.3. Representación ONNX de hist_gradient_boosting_regressor_float.onnx e hist_gradient_boosting_regressor_double.onnx - 2.2.10. sklearn.svm.SVR

2.2.10.1. Código para crear el modelo SVR y exportarlo a ONNX para float y double

2.2.10.2. Código MQL5 para ejecutar modelos ONNX

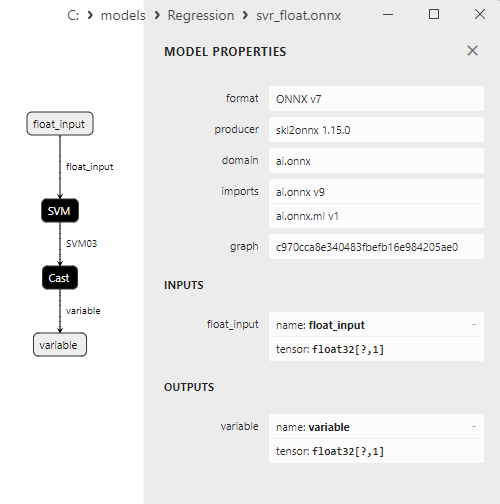

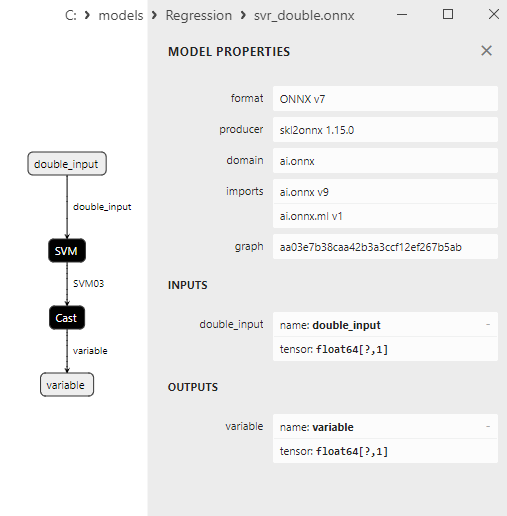

2.2.10.3. Representación ONNX de svr_float.onnx y svr_double.onnx

- 2.3. Modelos de regresión que han tenido problemas al convertirlos a ONNX

- 2.3.1. sklearn.dummy.DummyRegressor

Código para crear el DummyRegressor - 2.3.2. sklearn.kernel_ridge.KernelRidge

Código para crear el KernelRidge - 2.3.3. sklearn.isotonic.IsotonicRegression

Código para crear la IsotonicRegression - 2.3.4. sklearn.cross_decomposition.PLSCanonical

Código para crear el PLSCanonical - 2.3.5. sklearn.cross_decomposition.CCA

Código para crear la CCA - Conclusión

- Resumen

Si te molesta, eres bienvenido a contribuir.

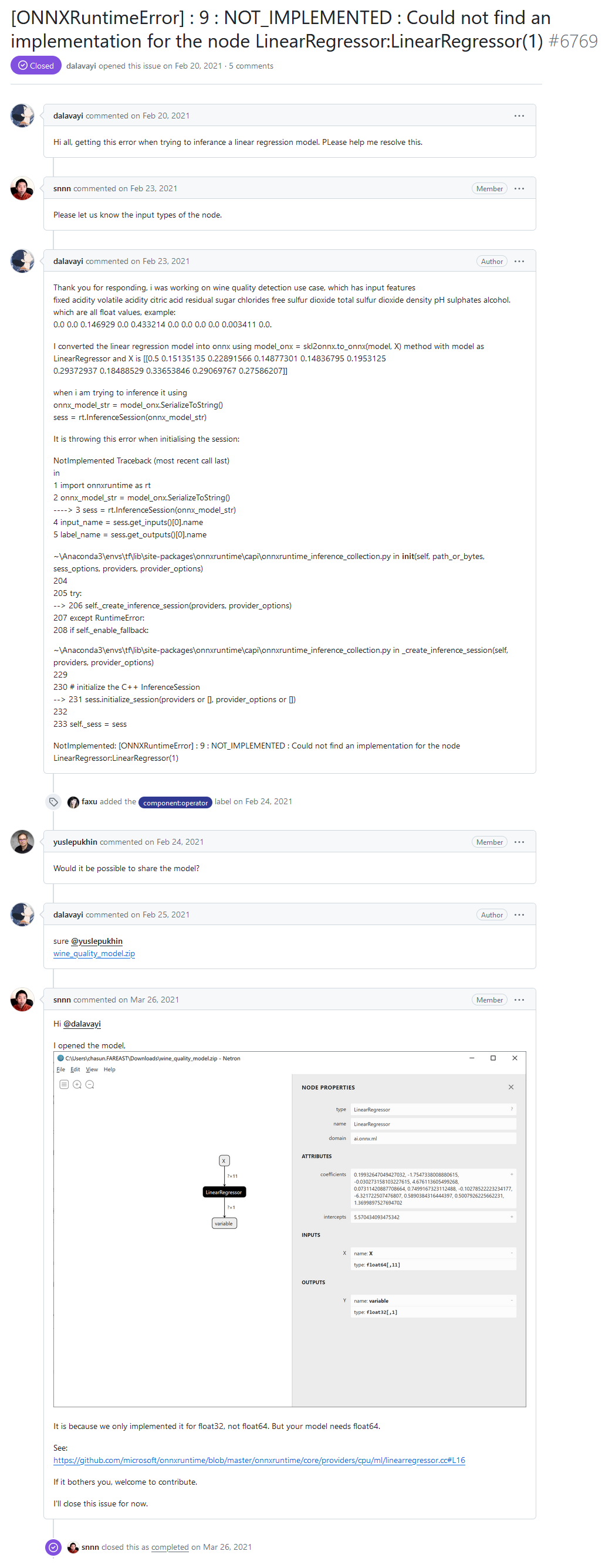

En el foro de desarrolladores de ONNX Runtime, uno de los usuarios reportó un error "[ONNXRuntimeError] : 9 : NOT_IMPLEMENTED : Could not find an implementation for the node LinearRegressor:LinearRegressor(1)" al ejecutar un modelo a través de ONNX Runtime.

Hola a todos, obtengo este error al intentar inferir un modelo de regresión lineal. Por favor, ayúdeme a resolver esto.

"NOT_IMPLEMENTED : Could not find an implementation for the node LinearRegressor:LinearRegressor(1)" error del foro de desarrolladores de ONNX Runtime

Respuesta de los desarrolladores:

Es porque sólo lo implementamos para float32, no para float64. Pero su modelo necesita float64.

Véase:

https://github.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16

Si te molesta, eres bienvenido a contribuir.

En el modelo ONNX del usuario, el operador ai.onnx.ml.LinearRegressor se llama con tipo de datos double (float64), y el mensaje de error surge porque el ONNX Runtime carece de soporte para el operador LinearRegressor() con precisión doble.

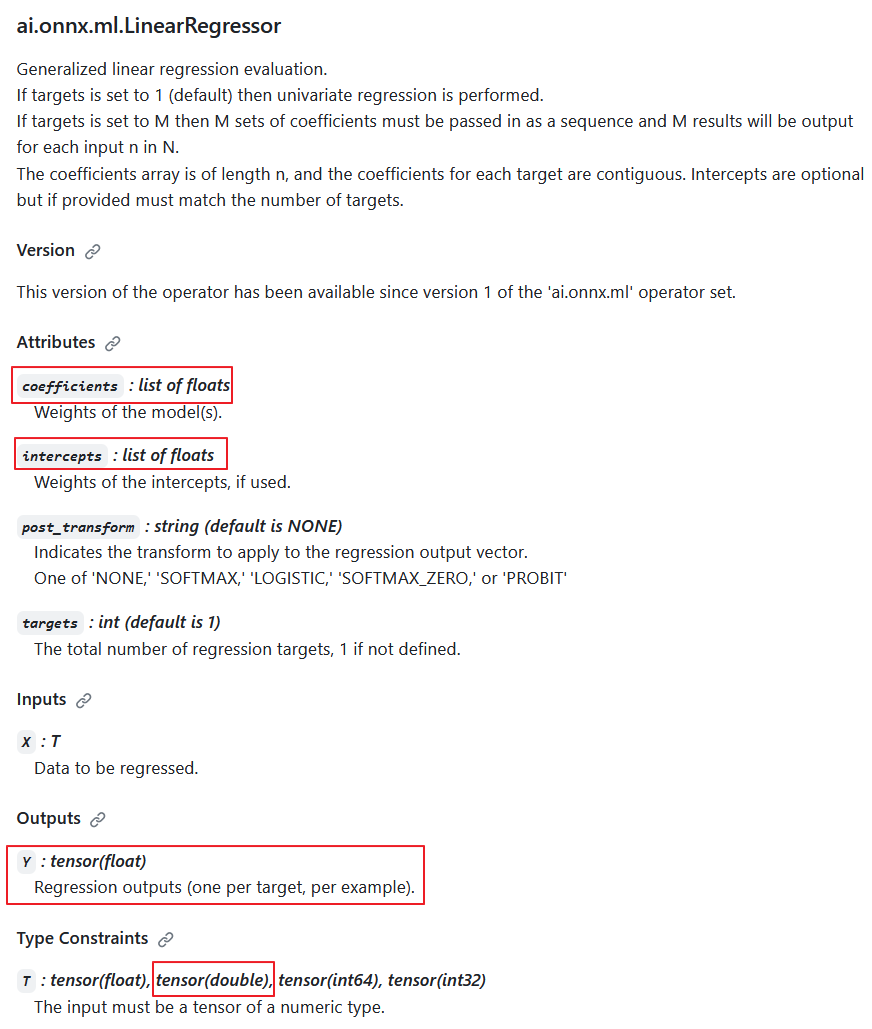

Según la especificación del operador ai.onnx.ml.LinearRegressor, el tipo de datos de entrada doble es posible (T: tensor(float), tensor(double), tensor(int64), tensor(int32)); sin embargo, los desarrolladores decidieron intencionadamente no implementarlo.

La razón es que la salida siempre devuelve el valor Y: tensor(float). Además, los parámetros de cálculo son números flotantes (coeficientes: lista de flotantes, interceptos: lista de flotantes).

En consecuencia, cuando los cálculos se realizan en doble precisión, este operador reduce la precisión a float, y su implementación en cálculos de doble precisión tiene un valor cuestionable.

Descripción del operador ai.onnx.ml.LinearRegressor

Así, la reducción de la precisión a float en los parámetros y el valor de salida hace imposible que el ai.onnx.ml.LinearRegressor funcione completamente con números dobles (float64). Presumiblemente, por esta razón, los desarrolladores de ONNX Runtime decidieron abstenerse de implementarlo para el tipo double.

El método de "añadir doble soporte" fue demostrado por los desarrolladores en comentarios de código (resaltados en amarillo).

En ONNX Runtime, su cálculo se realiza mediante la clase LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.h).

Los parámetros del operador, coefficients_, e intercepts_, se almacenan como std::vector<float>:

#pragma once #include "core/common/common.h" #include "core/framework/op_kernel.h" #include "core/util/math_cpuonly.h" #include "ml_common.h" namespace onnxruntime { namespace ml { class LinearRegressor final : public OpKernel { public: LinearRegressor(const OpKernelInfo& info); Status Compute(OpKernelContext* context) const override; private: int64_t num_targets_; std::vector<float> coefficients_; std::vector<float> intercepts_; bool use_intercepts_; POST_EVAL_TRANSFORM post_transform_; }; } // namespace ml } // namespace onnxruntimeLa implementación del operador LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.cc)

// Copyright (c) Microsoft Corporation. All rights reserved. // Licensed under the MIT License. #include "core/providers/cpu/ml/linearregressor.h" #include "core/common/narrow.h" #include "core/providers/cpu/math/gemm.h" namespace onnxruntime { namespace ml { ONNX_CPU_OPERATOR_ML_KERNEL( LinearRegressor, 1, // KernelDefBuilder().TypeConstraint("T", std::vector<MLDataType>{ // DataTypeImpl::GetTensorType<float>(), // DataTypeImpl::GetTensorType<double>()}), KernelDefBuilder().TypeConstraint("T", DataTypeImpl::GetTensorType<float>()), LinearRegressor); LinearRegressor::LinearRegressor(const OpKernelInfo& info) : OpKernel(info), intercepts_(info.GetAttrsOrDefault<float>("intercepts")), post_transform_(MakeTransform(info.GetAttrOrDefault<std::string>("post_transform", "NONE"))) { ORT_ENFORCE(info.GetAttr<int64_t>("targets", &num_targets_).IsOK()); ORT_ENFORCE(info.GetAttrs<float>("coefficients", coefficients_).IsOK()); // use the intercepts_ if they're valid use_intercepts_ = intercepts_.size() == static_cast<size_t>(num_targets_); } // Use GEMM for the calculations, with broadcasting of intercepts // https://github.com/onnx/onnx/blob/main/docs/Operators.md#Gemm // // X: [num_batches, num_features] // coefficients_: [num_targets, num_features] // intercepts_: optional [num_targets]. // Output: X * coefficients_^T + intercepts_: [num_batches, num_targets] template <typename T> static Status ComputeImpl(const Tensor& input, ptrdiff_t num_batches, ptrdiff_t num_features, ptrdiff_t num_targets, const std::vector<float>& coefficients, const std::vector<float>* intercepts, Tensor& output, POST_EVAL_TRANSFORM post_transform, concurrency::ThreadPool* threadpool) { const T* input_data = input.Data<T>(); T* output_data = output.MutableData<T>(); if (intercepts != nullptr) { TensorShape intercepts_shape({num_targets}); onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, intercepts->data(), &intercepts_shape, output_data, threadpool); } else { onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, nullptr, nullptr, output_data, threadpool); } if (post_transform != POST_EVAL_TRANSFORM::NONE) { ml::batched_update_scores_inplace(gsl::make_span(output_data, SafeInt<size_t>(num_batches) * num_targets), num_batches, num_targets, post_transform, -1, false, threadpool); } return Status::OK(); } Status LinearRegressor::Compute(OpKernelContext* ctx) const { Status status = Status::OK(); const auto& X = *ctx->Input<Tensor>(0); const auto& input_shape = X.Shape(); if (input_shape.NumDimensions() > 2) { return ORT_MAKE_STATUS(ONNXRUNTIME, INVALID_ARGUMENT, "Input shape had more than 2 dimension. Dims=", input_shape.NumDimensions()); } ptrdiff_t num_batches = input_shape.NumDimensions() <= 1 ? 1 : narrow<ptrdiff_t>(input_shape[0]); ptrdiff_t num_features = input_shape.NumDimensions() <= 1 ? narrow<ptrdiff_t>(input_shape.Size()) : narrow<ptrdiff_t>(input_shape[1]); Tensor& Y = *ctx->Output(0, {num_batches, num_targets_}); concurrency::ThreadPool* tp = ctx->GetOperatorThreadPool(); auto element_type = X.GetElementType(); switch (element_type) { case ONNX_NAMESPACE::TensorProto_DataType_FLOAT: { status = ComputeImpl<float>(X, num_batches, num_features, narrow<ptrdiff_t>(num_targets_), coefficients_, use_intercepts_ ? &intercepts_ : nullptr, Y, post_transform_, tp); break; } case ONNX_NAMESPACE::TensorProto_DataType_DOUBLE: { // TODO: Add support for 'double' to the scoring functions in ml_common.h // once that is done we can just call ComputeImpl<double>... // Alternatively we could cast the input to float. } default: status = ORT_MAKE_STATUS(ONNXRUNTIME, FAIL, "Unsupported data type of ", element_type); } return status; } } // namespace ml } // namespace onnxruntime

Resulta que existe una opción para utilizar números dobles como valores de entrada y realizar el cálculo del operador con parámetros flotantes. Otra posibilidad podría ser reducir la precisión de los datos de entrada a float. Sin embargo, ninguna de estas opciones puede considerarse una solución adecuada.

La especificación del operador ai.onnx.ml.LinearRegressor restringe la capacidad de operación completa con números dobles ya que los parámetros y el valor de salida están limitados al tipo float.

Una situación similar ocurre con otros operadores ML de ONNX, como ai.onnx.ml.SVMRegressor y ai.onnx.ml.TreeEnsembleRegressor.

Como resultado, todos los desarrolladores que utilicen la ejecución de modelos ONNX en doble precisión se enfrentan a esta limitación de la especificación. Una solución podría pasar por ampliar la especificación ONNX (o añadir operadores similares como LinearRegressor64, SVMRegressor64 y TreeEnsembleRegressor64 con parámetros y valores de salida en doble). Sin embargo, en la actualidad esta cuestión sigue sin resolverse.

Depende mucho del convertidor ONNX. Para los modelos calculados en doble, puede ser preferible evitar el uso de estos operadores (aunque no siempre es posible). En este caso concreto, el conversor a ONNX no funcionó de forma óptima con el modelo del usuario.

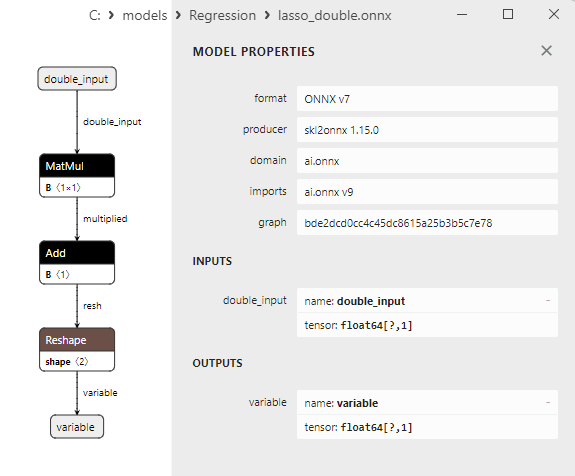

Como veremos más adelante, el conversor sklearn-onnx consigue saltarse la limitación de LinearRegressor: para los modelos dobles ONNX, utiliza en su lugar los operadores ONNX MatMul() y Add(). Gracias a este método, numerosos modelos de regresión de la librería Scikit-learn se convierten con éxito en modelos ONNX calculados en doble, preservando la precisión de los modelos dobles originales.

1. Conjunto de datos de prueba

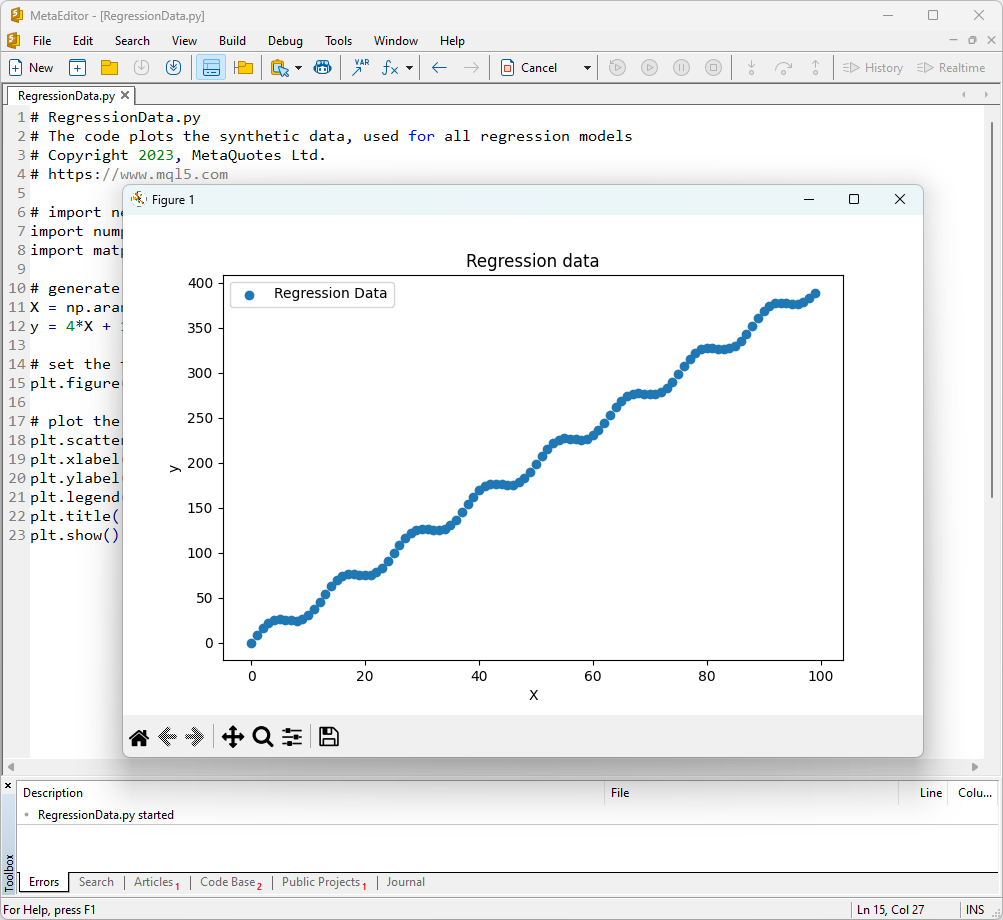

Para ejecutar los ejemplos, necesitarás instalar Python (nosotros utilizamos la versión 3.10.8), librerías adicionales (pip install -U scikit-learn numpy matplotlib onnx onnxruntime skl2onnx), y especificar la ruta a Python en el MetaEditor (en el menú Herramientas>Opciones>Compiladores>Python).

Como conjunto de datos de prueba, utilizaremos valores generados de la función y = 4X + 10sin(X*0,5).

Para mostrar un gráfico de una función de este tipo, abra el MetaEditor, cree un archivo llamado RegressionData.py, copie el texto del script y ejecútelo haciendo clic en el botón "Compilar".

El script para mostrar el conjunto de datos de prueba

# RegressionData.py # The code plots the synthetic data, used for all regression models # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # import necessary libraries import numpy as np import matplotlib.pyplot as plt # generate synthetic data for regression X = np.arange(0,100,1).reshape(-1,1) y = 4*X + 10*np.sin(X*0.5) # set the figure size plt.figure(figsize=(8,5)) # plot the initial data for regression plt.scatter(X, y, label='Regression Data', marker='o') plt.xlabel('X') plt.ylabel('y') plt.legend() plt.title('Regression data') plt.show()

Como resultado, se mostrará un gráfico de la función, que utilizaremos para probar los métodos de regresión.

Fig.1. Función para probar modelos de regresión

2. Modelos de regresión

El objetivo de una tarea de regresión es encontrar una función matemática o modelo que describa mejor la relación entre las características y la variable objetivo para predecir los valores numéricos de los nuevos datos. Esto permite hacer previsiones, optimizar soluciones y tomar decisiones informadas basadas en datos.

Consideremos los principales modelos de regresión del paquete Scikit-learn.

2.0. Lista de modelos de regresión de Scikit-learn

Para mostrar una lista de los modelos de regresión de Scikit-learn disponibles, puede utilizar la secuencia de comandos:

# ScikitLearnRegressors.py # The script lists all the regression algorithms available inb scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn regression models from sklearn.utils import all_estimators regressors = all_estimators(type_filter='regressor') for index, (name, RegressorClass) in enumerate(regressors, start=1): print(f"Regressor {index}: {name}")

Salida:

The scikit-learn version is 1.3.2.

Regressor 1: ARDRegression

Regressor 2: AdaBoostRegressor

Regressor 3: BaggingRegressor

Regressor 4: BayesianRidge

Regressor 5: CCA

Regressor 6: DecisionTreeRegressor

Regressor 7: DummyRegressor

Regressor 8: ElasticNet

Regressor 9: ElasticNetCV

Regressor 10: ExtraTreeRegressor

Regressor 11: ExtraTreesRegressor

Regressor 12: GammaRegressor

Regressor 13: GaussianProcessRegressor

Regressor 14: GradientBoostingRegressor

Regressor 15: HistGradientBoostingRegressor

Regressor 16: HuberRegressor

Regressor 17: IsotonicRegression

Regressor 18: KNeighborsRegressor

Regressor 19: KernelRidge

Regressor 20: Lars

Regressor 21: LarsCV

Regressor 22: Lasso

Regressor 23: LassoCV

Regressor 24: LassoLars

Regressor 25: LassoLarsCV

Regressor 26: LassoLarsIC

Regressor 27: LinearRegression

Regressor 28: LinearSVR

Regressor 29: MLPRegressor

Regressor 30: MultiOutputRegressor

Regressor 31: MultiTaskElasticNet

Regressor 32: MultiTaskElasticNetCV

Regressor 33: MultiTaskLasso

Regressor 34: MultiTaskLassoCV

Regressor 35: NuSVR

Regressor 36: OrthogonalMatchingPursuit

Regressor 37: OrthogonalMatchingPursuitCV

Regressor 38: PLSCanonical

Regressor 39: PLSRegression

Regressor 40: PassiveAggressiveRegressor

Regressor 41: PoissonRegressor

Regressor 42: QuantileRegressor

Regressor 43: RANSACRegressor

Regressor 44: RadiusNeighborsRegressor

Regressor 45: RandomForestRegressor

Regressor 46: RegressorChain

Regressor 47: Ridge

Regressor 48: RidgeCV

Regressor 49: SGDRegressor

Regressor 50: SVR

Regressor 51: StackingRegressor

Regressor 52: TheilSenRegressor

Regressor 53: TransformedTargetRegressor

Regressor 54: TweedieRegressor

Regressor 55: VotingRegressor

Para mayor comodidad, en esta lista de regresores aparecen resaltados en distintos colores. Los modelos que requieren un modelo de regresión base aparecen resaltados en gris, mientras que los demás modelos pueden utilizarse de forma independiente. Observe que los modelos exportados con éxito al formato ONNX están marcados en verde, los modelos que encuentran errores durante la conversión en la versión actual de Scikit-learn 1.2.2 están marcados en rojo. Los métodos inadecuados para la tarea de prueba considerada aparecen resaltados en azul.

El análisis de la calidad de la regresión utiliza métricas de regresión, que son funciones de valores verdaderos y predichos. En el lenguaje MQL5 se dispone de varias métricas diferentes, detalladas en el artículo "Evaluación de modelos ONNX mediante métricas de regresión".

En este artículo se utilizarán tres métricas para comparar la calidad de distintos modelos:

- Coeficiente de determinación (R-cuadrado) (R²);

- Error absoluto medio / Mean Absolute Error (MAE);

- Error medio cuadrado / Mean Squared Error (MSE).

2.1. Modelos de regresión de Scikit-learn que se convierten en modelos ONNX float y double

En esta sección se presentan modelos de regresión convertidos con éxito a formatos ONNX tanto en precisión flotante como doble.

Todos los modelos de regresión que se analizan a continuación se presentan en el siguiente formato:

- Descripción del modelo, principio de funcionamiento, ventajas y limitaciones

- Script en Python para crear el modelo, exportarlo a ficheros ONNX en formatos float y double, y ejecutar los modelos obtenidos utilizando ONNX Runtime en Python. Métricas como R2, MAE, MSE, calculadas con sklearn.metrics, se utilizan para evaluar la calidad de los modelos original y ONNX.

- Script MQL5 para ejecutar modelos ONNX (float y double) mediante ONNX Runtime, con métricas calculadas mediante RegressionMetric().

- Representación del modelo ONNX en Netron para float y doble precisión.

2.1.1. sklearn.linear_model.ARDRegression

ARDRegression (Automatic Relevance Determination Regression / Regresión de determinación automática de relevancia) es un método de regresión diseñado para abordar problemas de regresión determinando automáticamente la importancia (relevancia) de las características y estableciendo sus pesos durante el proceso de entrenamiento del modelo.

ARDRegression permite detectar y utilizar sólo las características más importantes para construir un modelo de regresión, lo que puede ser beneficioso cuando se trata de un gran número de características.

Principio de funcionamiento de ARDRegression:

- Regresión lineal: ARDRegression se basa en la regresión lineal, asumiendo una relación lineal entre las variables independientes (características) y la variable objetivo.

- Determinación automática de la importancia de las características: La principal distinción de ARDRegression es su determinación automática de qué características son las más importantes para predecir la variable objetivo. Esto se logra introduciendo distribuciones previas (regularización) sobre las ponderaciones, lo que permite que el modelo establezca automáticamente ponderaciones cero para características menos significativas.

- Estimación de las probabilidades posteriores: ARDRegression calcula las probabilidades posteriores de cada característica, lo que permite determinar su importancia. Las características con probabilidades posteriores altas se consideran relevantes y reciben ponderaciones distintas de cero, mientras que las características con probabilidades posteriores bajas reciben ponderaciones cero.

- Reducción de la dimensionalidad: Así, ARDRegression puede conducir a la reducción de la dimensionalidad de los datos mediante la eliminación de características insignificantes.

Ventajas de ARDRegression:

- Determinación automática de características importantes: El método identifica y utiliza automáticamente sólo las características más importantes, mejorando potencialmente el rendimiento del modelo y reduciendo el riesgo de sobreajuste.

- Resistencia a la multicolinealidad: ARDRegression maneja bien la multicolinealidad, incluso cuando las características están muy correlacionadas.

Limitaciones de ARDRegression:

- Requiere selección de distribuciones previas: elegir distribuciones previas adecuadas puede requerir experimentación.

- Complejidad computacional: El entrenamiento de ARDRegression puede ser costoso desde el punto de vista computacional, sobre todo para grandes conjuntos de datos.

ARDRegression es un método de regresión que determina automáticamente la importancia de las características y establece sus pesos basándose en probabilidades posteriores. Este método es útil cuando sólo se consideran las características significativas para construir un modelo de regresión y es necesario reducir la dimensionalidad de los datos.

2.1.1.1. Código para crear el modelo ARDRegression y exportarlo a ONNX para float y double

Este código crea el modelo sklearn.linear_model.ARDRegression, lo entrena en datos sintéticos, guarda el modelo en el formato ONNX, y realiza predicciones usando datos de entrada float y double. También evalúa la precisión tanto del modelo original como de los modelos exportados a ONNX.

# The code demonstrates the process of training ARDRegressor model, exporting it to ONNX format (both float and double), and making predictions using the ONNX models.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# function to compare matching decimal places

def compare_decimal_places(value1, value2):

# convert both values to strings

str_value1 = str(value1)

str_value2 = str(value2)

# find the positions of the decimal points in the strings

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# if one of the values doesn't have a decimal point, return 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calculate the number of decimal places

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# find the minimum of the two decimal places counts

min_decimal_places = min(decimal_places1, decimal_places2)

# initialize a count for matching decimal places

matching_count = 0

# compare characters after the decimal point

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ARDRegression

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# define the path for saving the model

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generate synthetic data for regression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name="ARDRegression"

onnx_model_filename = data_path + "ard_regression"

# create an ARDRegression model

regression_model = ARDRegression()

# fit the model to the data

regression_model.fit(X, y.ravel())

# predict values for the entire dataset

y_pred = regression_model.predict(X)

# evaluate the model's performance

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convert to ONNX-model (float)

# define the input data type as FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as FloatTensorType

initial_type_float = X.astype(np.float32)

# predict values for the entire dataset using ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# set the figure size

plt.figure(figsize=(8, 5))

# plot the original data and the regression data

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convert to ONNX-model (double)

# define the input data type as DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as DoubleTensorType

initial_type_double = X.astype(np.float64)

# predict values for the entire dataset using ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# set the figure size

plt.figure(figsize=(8, 5))

# plot the original data and the regression line

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

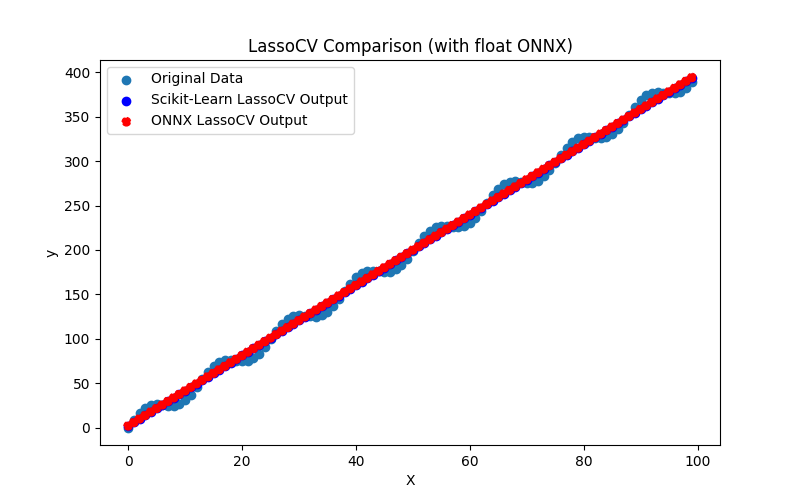

El script crea y entrena el modelo sklearn.linear_model.ARDRegression (el modelo original se considera en double), luego exporta el modelo a ONNX para float y double (ard_regression_float.onnx y ard_regression_double.onnx) y compara la precisión de su funcionamiento.

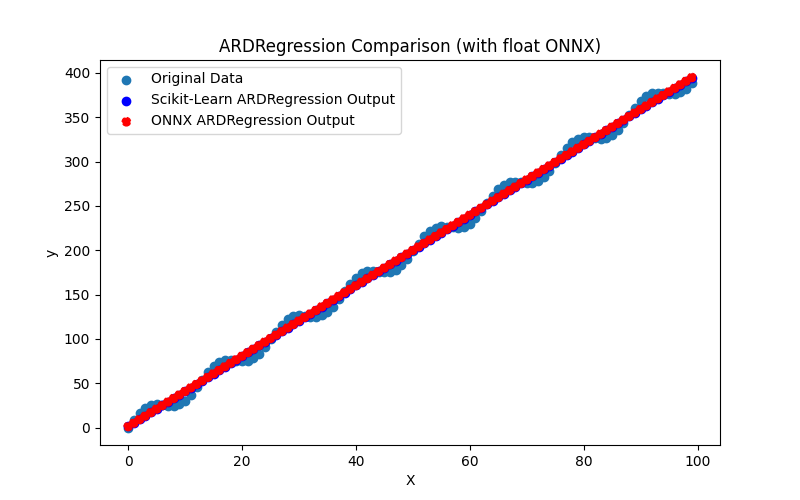

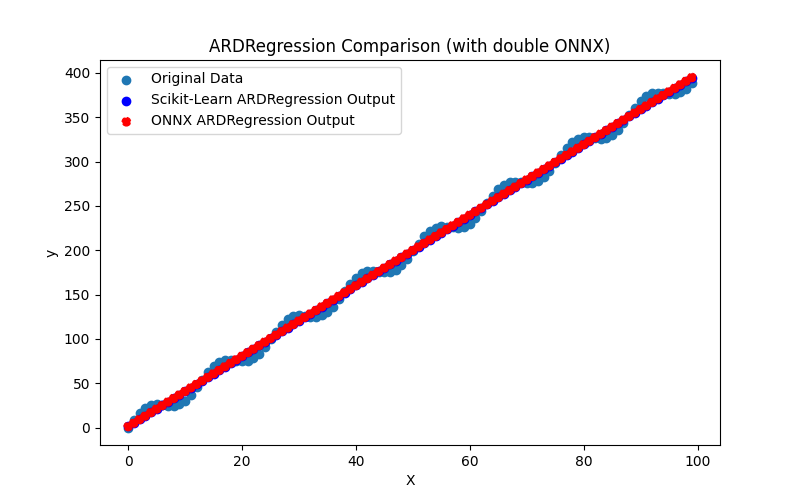

También genera los archivos ARDRegression_plot_float.png y ARDRegression_plot_double.png, que permiten una evaluación visual de los resultados de los modelos ONNX para float y double (Fig. 2-3).

Fig.2. Resultados de ARDRegression.py (float)

Fig.3. Resultados de ARDRegression.py (doble)

Visualmente, los modelos de ONNX para flotante y doble tienen el mismo aspecto (Fig. 2-3), puede encontrar información detallada en la pestaña Diario:

Python ARDRegression Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python Python ARDRegression ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python ONNX: MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python ARDRegression ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

En este ejemplo, el modelo original se consideró en double, luego se exportó a los modelos de ONNX ard_regression_float.onnx y ard_regression_double.onnx para float y double, respectivamente.

Si la precisión del modelo se evalúa mediante el Mean Absolute Error (MAE), la precisión del modelo ONNX para flotante es de hasta 6 decimales, mientras que el modelo ONNX que utiliza doble mostró una retención de precisión de hasta 15 decimales, en línea con la precisión del modelo original.

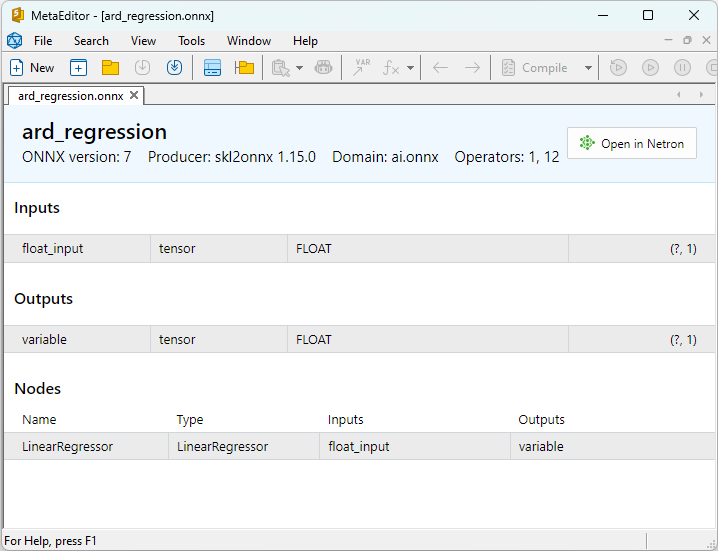

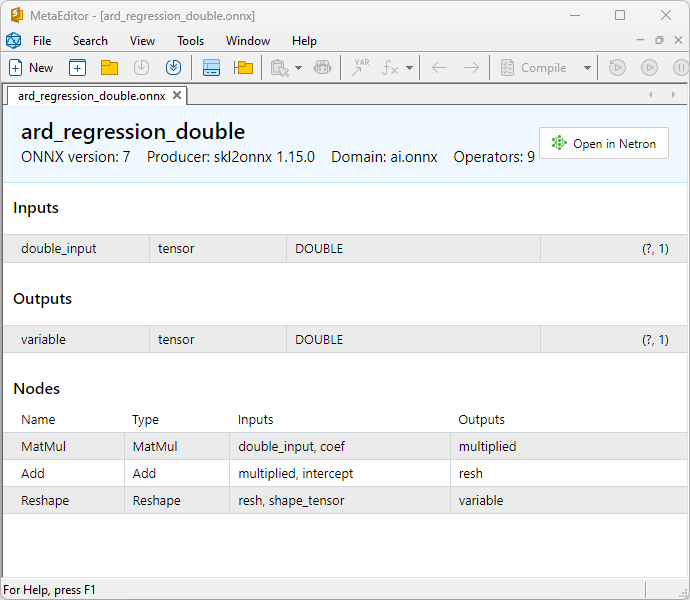

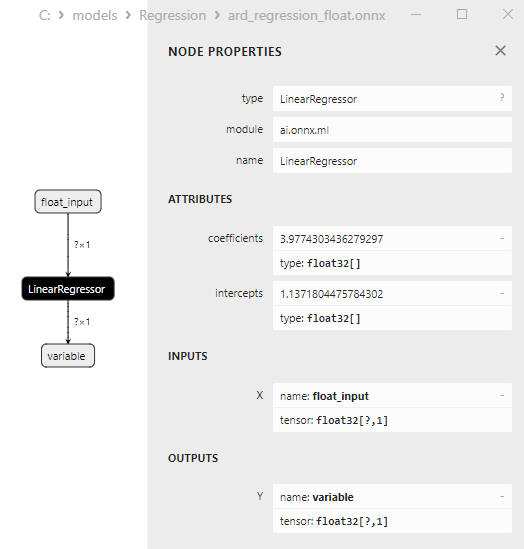

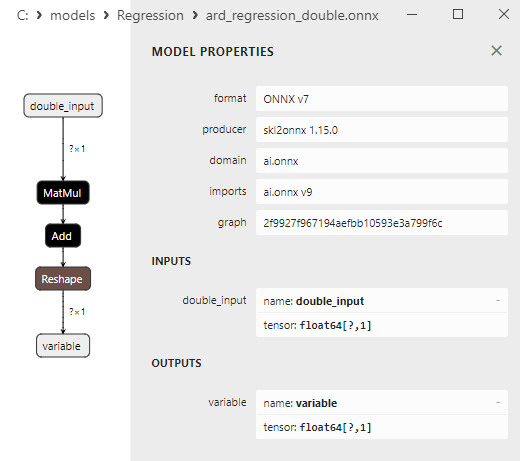

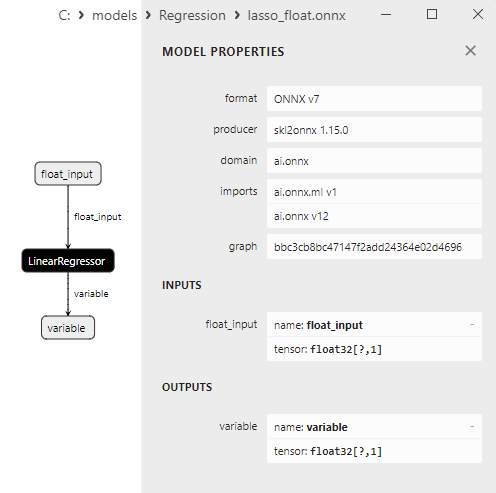

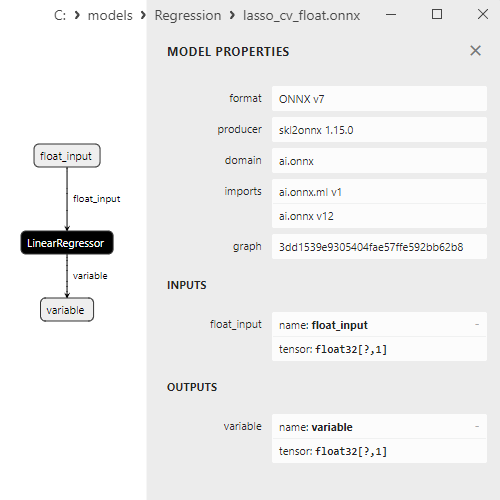

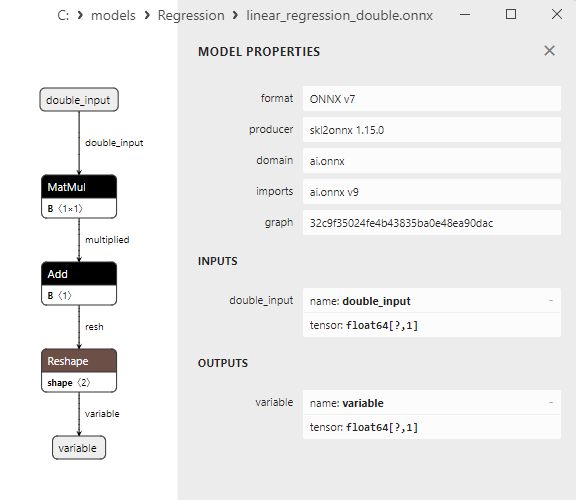

Las propiedades de los modelos ONNX pueden visualizarse en el MetaEditor (Fig. 4-5).

Fig.4. ard_regression_float.onnx ONNX-model en MetaEditor

Fig.5. ard_regression_double.onnx modelo ONNX en MetaEditor

Una comparación entre los modelos ONNX flotantes y dobles muestra que, en este caso, el cálculo de los modelos ONNX para ARDRegression se realiza de forma diferente: para los números flotantes, se utiliza el operador LinearRegressor() de ONNX-ML, mientras que para los números dobles, se utilizan los operadores ONNX MatMul(), Add() y Reshape() .

La implementación del modelo en ONNX depende del conversor; en los ejemplos de exportación a ONNX se utilizará la función skl2onnx.convert_sklearn() de la librería skl2onnx.

2.1.1.2. Código MQL5 para ejecutar modelos ONNX

Este código ejecuta los modelos guardados ard_regression_float.onnx y ard_regression_double.onnx ONNX y demuestra el uso de métricas de regresión en MQL5.

//+------------------------------------------------------------------+ //| ARDRegression.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "ARDRegression" #define ONNXFilenameFloat "ard_regression_float.onnx" #define ONNXFilenameDouble "ard_regression_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Salida:

ARDRegression (EURUSD,H1) Testing ONNX float: ARDRegression (ard_regression_float.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 ARDRegression (EURUSD,H1) ARDRegression (EURUSD,H1) Testing ONNX double: ARDRegression (ard_regression_double.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537597 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128795

Comparación con el modelo doble original en Python:

Testing ONNX float: ARDRegression (ard_regression_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: ARDRegression (ard_regression_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537597

Precisión de ONNX float MAE: 6 decimales, Precisión de ONNX double MAE: 14 decimales.

2.1.1.3. Las representaciones ONNX de los modelos ard_regression_float.onnx y ard_regression_double.onnx

Netron (versión web) es una herramienta para visualizar modelos y analizar gráficos de computación, que puede utilizarse para modelos en formato ONNX (Open Neural Network Exchange).

Netron presenta gráficos de modelos y su arquitectura de forma clara e interactiva, lo que permite explorar la estructura y los parámetros de los modelos de aprendizaje profundo, incluidos los creados con ONNX.

Las principales características de Netron son:

- Visualización de gráficos: Netron muestra la arquitectura del modelo en forma de gráfico, lo que permite ver las capas, las operaciones y las conexiones entre ellas. Puede comprender fácilmente la estructura y el flujo de datos dentro del modelo.

- Exploración interactiva: Puede seleccionar nodos en el gráfico para obtener información adicional sobre cada operador y sus parámetros.

- Compatibilidad con varios formatos: Netron admite diversos formatos de modelos de aprendizaje profundo, como ONNX, TensorFlow, PyTorch y CoreML, entre otros.

- Capacidad de análisis de parámetros: Puede ver los parámetros y ponderaciones del modelo, lo que resulta útil para comprender los valores utilizados en las distintas partes del modelo.

Netron es conveniente para desarrolladores e investigadores en el campo del aprendizaje automático y el aprendizaje profundo, ya que simplifica la visualización y el análisis de modelos, ayudando en la comprensión y depuración de redes neuronales complejas.

Esta herramienta permite inspeccionar rápidamente los modelos, explorar su estructura y sus parámetros, facilitando el trabajo con redes neuronales profundas.

Para más detalles sobre Netron, consulte los artículos: Visualizar su red neuronal con Netron y Visualizar redes neuronales Keras con Netron.

Vídeo sobre Netron::

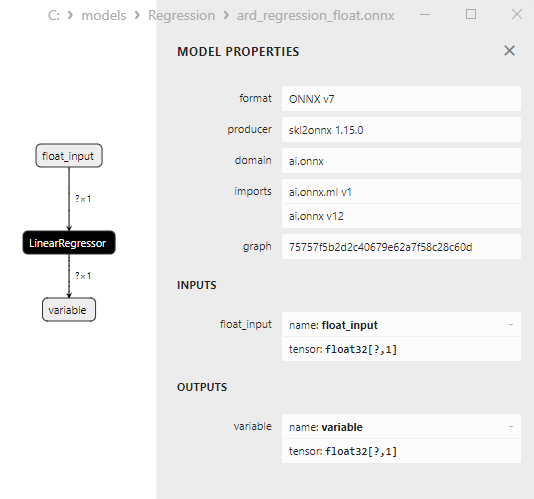

El modelo ard_regression_float.onnx se muestra en la Fig.6:

Fig.6. Representación ONNX del modelo ard_regression_float.onnx en Netron

El operador ai.onnx.ml LinearRegressor() ONNX forma parte del estándar ONNX, describiendo un modelo para tareas de regresión. Este operador se utiliza para la regresión, que consiste en predecir valores numéricos (continuos) a partir de características de entrada.

Toma como entrada los parámetros del modelo, como los pesos y el sesgo, junto con las características de entrada, y ejecuta la regresión lineal. La regresión lineal estima parámetros (ponderaciones) para cada característica de entrada y, a continuación, realiza una combinación lineal de estas características con las ponderaciones para generar una predicción.

Este operador realiza los siguientes pasos:

- Toma las ponderaciones y el sesgo del modelo, junto con las características de entrada.

- Para cada ejemplo de datos de entrada, realiza una combinación lineal de pesos con las características correspondientes.

- Añade el sesgo al valor resultante.

El resultado es la predicción de la variable objetivo en la tarea de regresión.

Los parámetros de LinearRegressor() se muestran en la Fig.7.

Fig.7. Propiedades del operador LinearRegressor() del modelo ard_regression_float.onnx en Netron

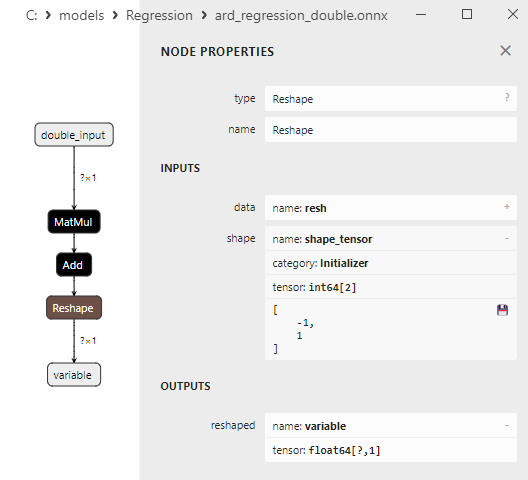

Fig.8. Representación ONNX del modelo ard_regression_double.onnx en Netron

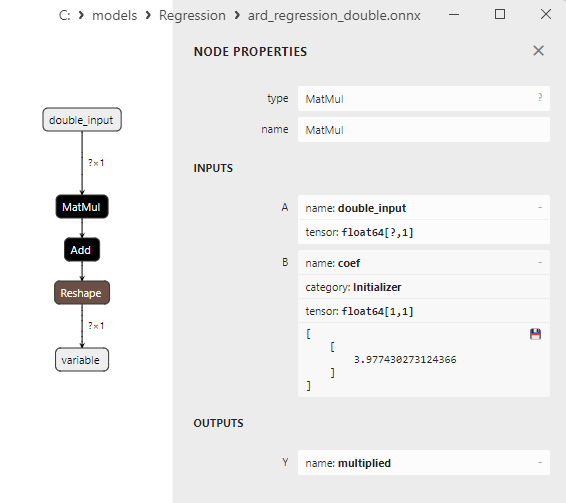

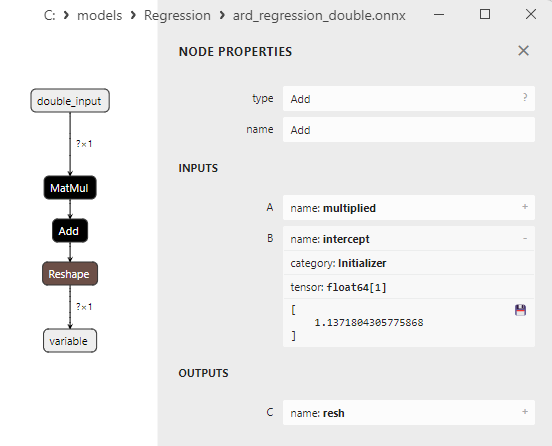

Los parámetros de los operadores ONNX MatMul(), Add() y Reshape() se muestran en la Fig.9-11.

Fig.9. Propiedades del operador MatMul en el modelo ard_regression_double.onnx de Netron

El operador MatMul (multiplicación de matrices) ONNX realiza la multiplicación de dos matrices.

Toma dos entradas: dos matrices y devuelve su producto matricial.

Si tenemos dos matrices, A y B, entonces el resultado de Matmul(A, B) es una matriz C, donde cada elemento C[i][j] se calcula como la suma de los productos de los elementos de la fila i de la matriz A por los elementos de la columna j de la matriz B.

Fig.10. Propiedades del operador Add en el modelo ard_regression_double.onnx de Netron

El operador Add() ONNX realiza la suma por elementos de dos tensores o matrices de la misma forma.

Toma dos entradas y devuelve el resultado, donde cada elemento del tensor resultante es igual a la suma de los elementos correspondientes de los tensores de entrada.

Fig.11. Propiedades del operador Reshape en el modelo ard_regression_double.onnx de Netron

El operador Reshape(-1,1) ONNX se utiliza para modificar la forma (o dimensión) de los datos de entrada. En este operador, el valor -1 para la dimensión indica que el tamaño de esa dimensión debe calcularse automáticamente basándose en las otras dimensiones para garantizar la coherencia de los datos.

El valor 1 en la segunda dimensión especifica que, tras la transformación de la forma, cada elemento tendrá una única subdimensión.

2.1.2. sklearn.linear_model.BayesianRidge

BayesianRidge es un método de regresión que utiliza un enfoque bayesiano para estimar los parámetros del modelo. Este método permite modelar la distribución previa de parámetros y actualizarla considerando los datos para obtener la distribución posterior de parámetros.

BayesianRidge es un método de regresión bayesiano diseñado para predecir la variable dependiente basándose en una o varias variables independientes.

Principio de funcionamiento de BayesianRidge:

- Distribución previa de parámetros: Comienza con la definición de la distribución previa de parámetros del modelo. Esta distribución representa el conocimiento previo o las suposiciones sobre los parámetros del modelo antes de considerar los datos. En el caso de BayesianRidge se utilizan distribuciones previas en forma gaussiana.

- Actualización de la distribución de parámetros: una vez establecida la distribución de parámetros anterior, se actualiza en función de los datos. Para ello se utiliza la teoría bayesiana, en la que la distribución posterior de los parámetros se calcula teniendo en cuenta los datos. Un aspecto esencial es la estimación de los hiperparámetros, que influyen en la forma de la distribución posterior.

- Predicción: Después de estimar la distribución posterior de los parámetros, se pueden hacer predicciones para nuevas observaciones. El resultado es una distribución de las previsiones en lugar de un valor puntual único, lo que permite tener en cuenta la incertidumbre de las predicciones.

Ventajas de BayesianRidge:

- Consideración de la incertidumbre: BayesianRidge tiene en cuenta la incertidumbre en los parámetros y predicciones del modelo. En lugar de predicciones puntuales, se proporcionan intervalos de confianza.

- Regularización: El método de regresión bayesiano puede ser útil para la regularización del modelo, ayudando a prevenir el sobreajuste.

- Selección automática de características: BayesianRidge puede determinar automáticamente la importancia de las características reduciendo los pesos de las características insignificantes.

Limitaciones de BayesianRidge:

- Complejidad computacional: El método requiere recursos computacionales para estimar los parámetros y calcular la distribución posterior.

- Alto nivel de abstracción: Puede ser necesario un conocimiento más profundo de la estadística bayesiana para comprender y utilizar BayesianRidge.

- No siempre es la mejor opción: BayesianRidge puede no ser el método más adecuado en determinadas tareas de regresión, sobre todo cuando se trata de datos limitados.

BayesianRidge es útil en tareas de regresión en las que la incertidumbre de los parámetros y las predicciones es importante y en los casos en los que es necesaria la regularización del modelo.

2.1.2.1. Código para crear el modelo BayesianRidge y exportarlo a ONNX para float y double

Este código crea el modelo sklearn.linear_model.BayesianRidge, lo entrena en datos sintéticos, guarda el modelo en el formato ONNX, y realiza predicciones usando datos de entrada float y double. También evalúa la precisión tanto del modelo original como de los modelos exportados a ONNX.

# The code demonstrates the process of training BayesianRidge model, exporting it to ONNX format (both float and double), and making predictions using the ONNX models.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# function to compare matching decimal places

def compare_decimal_places(value1, value2):

# convert both values to strings

str_value1 = str(value1)

str_value2 = str(value2)

# find the positions of the decimal points in the strings

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# if one of the values doesn't have a decimal point, return 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calculate the number of decimal places

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# find the minimum of the two decimal places counts

min_decimal_places = min(decimal_places1, decimal_places2)

# initialize a count for matching decimal places

matching_count = 0

# compare characters after the decimal point

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import BayesianRidge

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# define the path for saving the model

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generate synthetic data for regression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name = "BayesianRidge"

onnx_model_filename = data_path + "bayesian_ridge"

# create a Bayesian Ridge regression model

regression_model = BayesianRidge()

# fit the model to the data

regression_model.fit(X, y.ravel())

# predict values for the entire dataset

y_pred = regression_model.predict(X)

# evaluate the model's performance

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convert to ONNX-model (float)

# define the input data type as FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as FloatTensorType

initial_type_float = X.astype(np.float32)

# predict values for the entire dataset using ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# set the figure size

plt.figure(figsize=(8,5))

# plot the original data and the regression data

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convert to ONNX-model (double)

# define the input data type as DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as DoubleTensorType

initial_type_double = X.astype(np.float64)

# predict values for the entire dataset using ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# set the figure size

plt.figure(figsize=(8,5))

# plot the original data and the regression line

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

Salida:

Python BayesianRidge Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python Python BayesianRidge ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python BayesianRidge ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

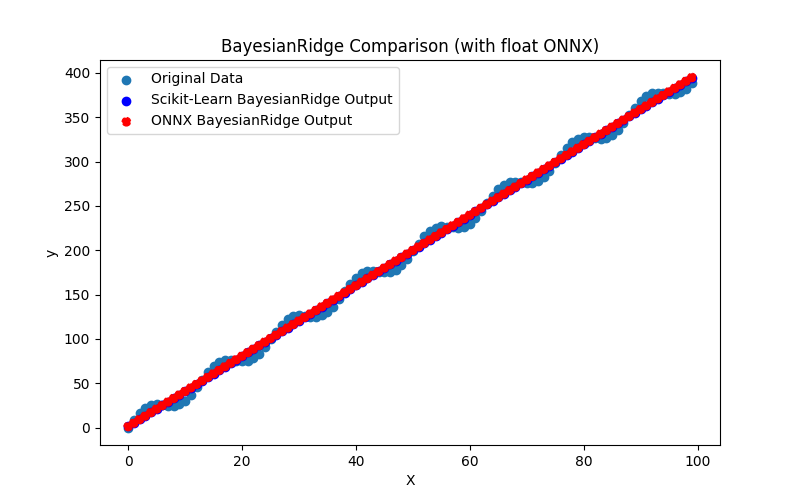

Fig.12. Resultados de BayesianRidge.py (float ONNX)

2.1.2.2. Código MQL5 para ejecutar modelos ONNX

Este código ejecuta los modelos guardados bayesian_ridge_float.onnx y bayesian_ridge_double.onnx ONNX y demuestra el uso de métricas de regresión en MQL5.

//+------------------------------------------------------------------+ //| BayesianRidge.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "BayesianRidge" #define ONNXFilenameFloat "bayesian_ridge_float.onnx" #define ONNXFilenameDouble "bayesian_ridge_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Salida:

BayesianRidge (EURUSD,H1) Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 BayesianRidge (EURUSD,H1) BayesianRidge (EURUSD,H1) Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537624 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128866

Comparación con el modelo doble original en Python:

Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537624

Precisión de ONNX float MAE: 6 decimales, Precisión de ONNX double MAE: 13 decimales.

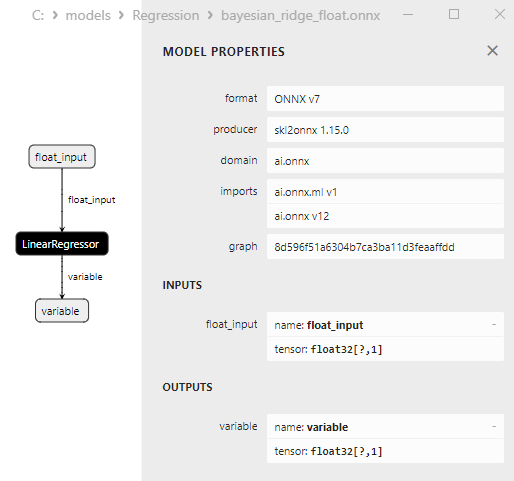

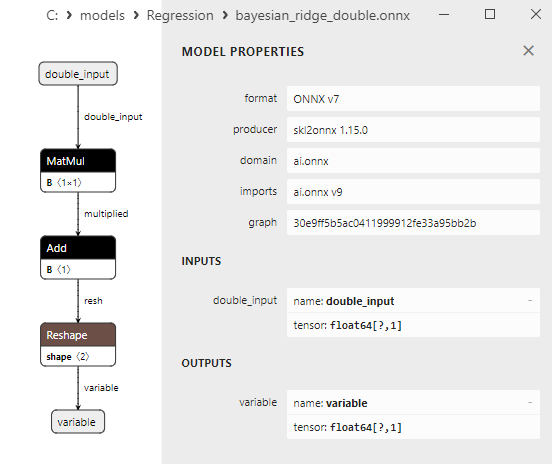

2.1.2.3. Representación ONNX de bayesian_ridge_float.onnx y bayesian_ridge_double.onnx