Klassifizierungsmodelle in der Bibliothek Scikit-Learn und ihr Export nach ONNX

Die Entwicklung der Technologie hat zur Entstehung eines grundlegend neuen Ansatzes für die Entwicklung von Datenverarbeitungsalgorithmen geführt. Bisher waren für die Lösung jeder spezifischen Aufgabe eine klare Formalisierung und die Entwicklung entsprechender Algorithmen erforderlich.

Beim maschinellen Lernen lernt der Computer, selbständig die besten Wege zur Verarbeitung von Daten zu finden. Modelle des maschinellen Lernens können Klassifizierungsaufgaben (bei denen es einen festen Satz von Klassen gibt und das Ziel darin besteht, die Wahrscheinlichkeiten für die Zugehörigkeit eines bestimmten Satzes von Merkmalen zu jeder Klasse zu ermitteln) und Regressionsaufgaben (bei denen das Ziel darin besteht, einen numerischen Wert der Zielvariablen auf der Grundlage eines bestimmten Satzes von Merkmalen zu schätzen) erfolgreich lösen. Auf der Grundlage dieser grundlegenden Komponenten können komplexere Datenverarbeitungsmodelle aufgebaut werden.

Die Bibliothek Scikit-Learn bietet eine Vielzahl von Werkzeugen für Klassifizierung und Regression. Die Wahl speziFisher Methoden und Modelle hängt von den Merkmalen der Daten ab, da verschiedene Methoden je nach Aufgabe unterschiedlich effektiv sein und unterschiedliche Ergebnisse liefern können.

In der Pressemitteilung „Runtime is now open source“ wird erklärt, dass ONNX Runtime auch das ONNX-ML Profil unterstützt:

Das Profil ONNX-ML ist ein Teil von ONNX, der speziell für Modelle für maschinelles Lernen (ML) entwickelt wurde. Es ist für die Beschreibung und Darstellung verschiedener Arten von ML-Modellen, wie Klassifizierung, Regression, Clustering und andere, in einem praktischen Format gedacht, das auf verschiedenen Plattformen und Umgebungen, die ONNX unterstützen, verwendet werden kann. Das ONNX-ML-Profil vereinfacht die Übertragung, Bereitstellung und Ausführung von Modellen des maschinellen Lernens und macht sie leichter zugänglich und portabel.

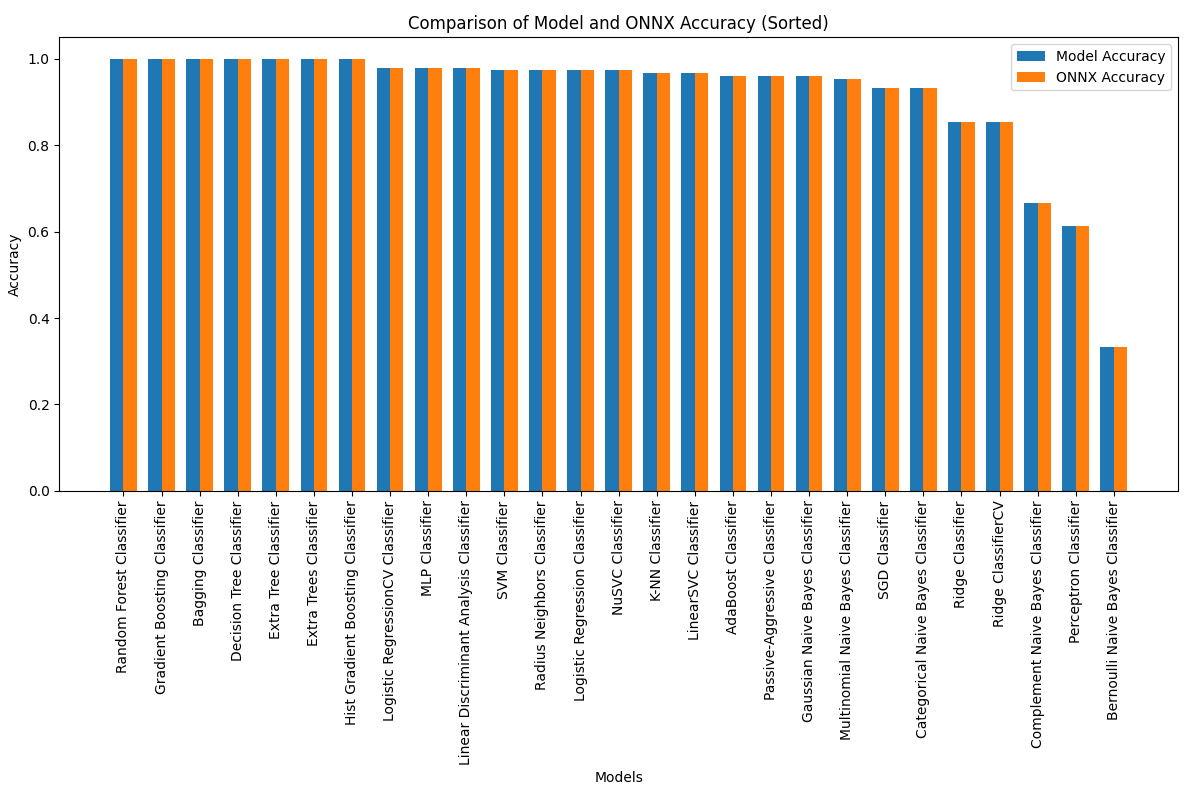

In diesem Artikel werden wir die Anwendung aller Klassifizierungsmodelle des Scikit-Learn-Pakets zur Lösung der Klassifizierungsaufgabe von Fishers Schwertlilien, den Iris-Daten, untersuchen. Wir werden auch versuchen, diese Modelle in das ONNX-Format zu konvertieren und die resultierenden Modelle in MQL5-Programmen zu verwenden.

Darüber hinaus werden wir die Genauigkeit der ursprünglichen Modelle mit ihren ONNX-Versionen auf dem kompletten Iris-Datensatz vergleichen.

Inhaltsverzeichnis

- 1. Fishers Schwertlilien (Iris-Daten)

- 2. Modelle für die Klassifizierung

Liste der Klassifikatoren von Scikit-Learn

Verschiedene Darstellungen der Ausgabe von Modellen iris.mqh - 2.1. SVC Classifier

2.1.1. Code zur Erstellung des Klassifizierungsmodells SVC

2.1.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell SVC

2.1.3. ONNX-Darstellung des Klassifizierungsmodells SVC - 2.2. LinearSVC Classifier

2.2.1. Code zur Erstellung des Klassifizierungsmodells von LinearSVC

2.2.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell LinearSVC

2.2.3. ONNX-Darstellung des Klassifizierungsmodells LinearSVC - 2.3. NuSVC Classifier

2.3.1. Code zur Erstellung des Klassifizierungsmodells von NuSVC

2.3.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell NuSVC

2.3.3. ONNX-Darstellung des Klassifizierungsmodells NuSVC - 2.4. Radius Neighbors Classifier

2.4.1. Code zur Erstellung des Klassifizierungsmodells von Radius Neighbors

2.4.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Radius Neighbors

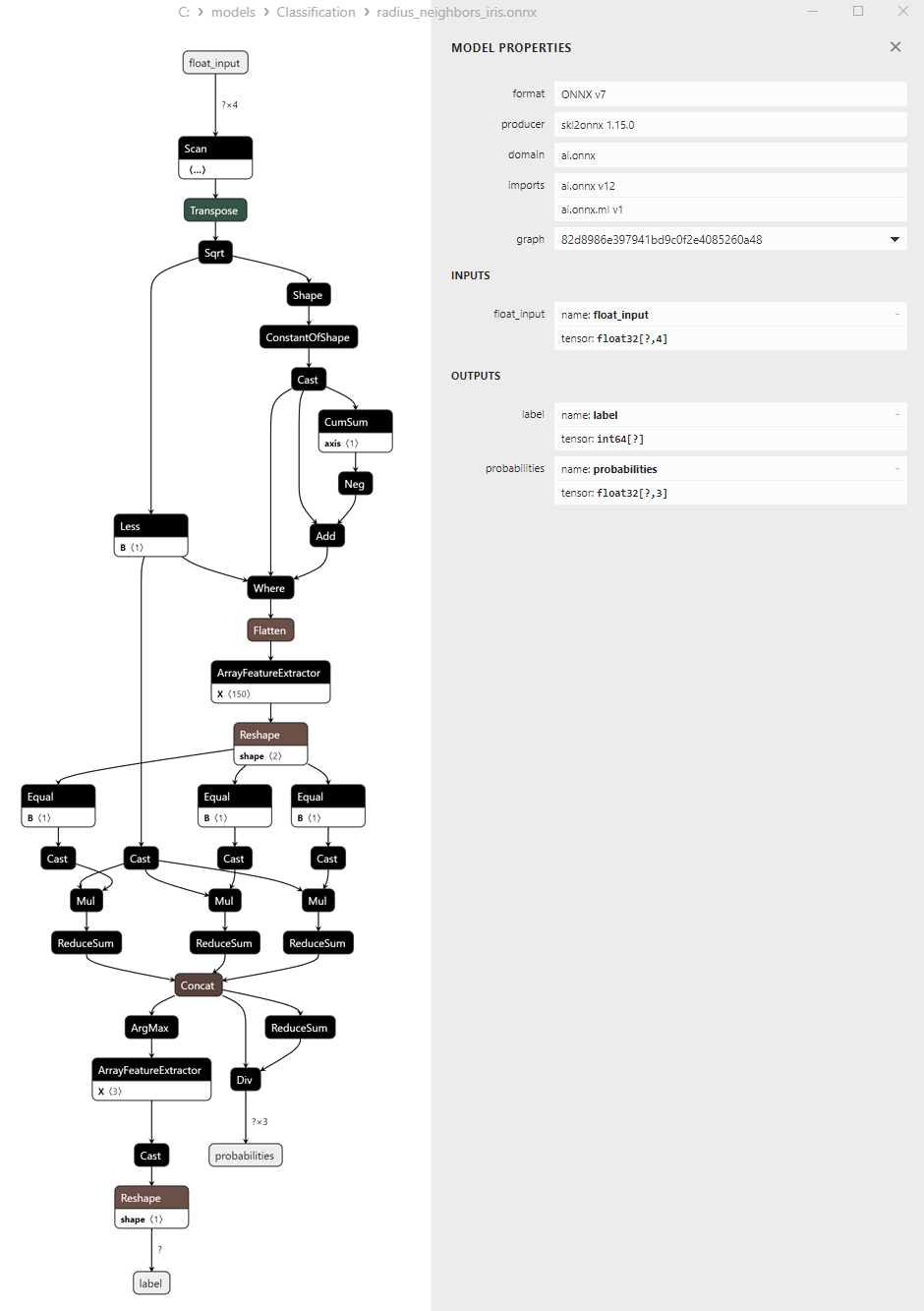

2.3.3. ONNX-Darstellung des Klassifizierungsmodells Radius Neighbors - 2.5. Ridge Classifier

2.5.1. Code zur Erstellung des Klassifizierungsmodells von Ridge Classifier

2.5.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Ridge

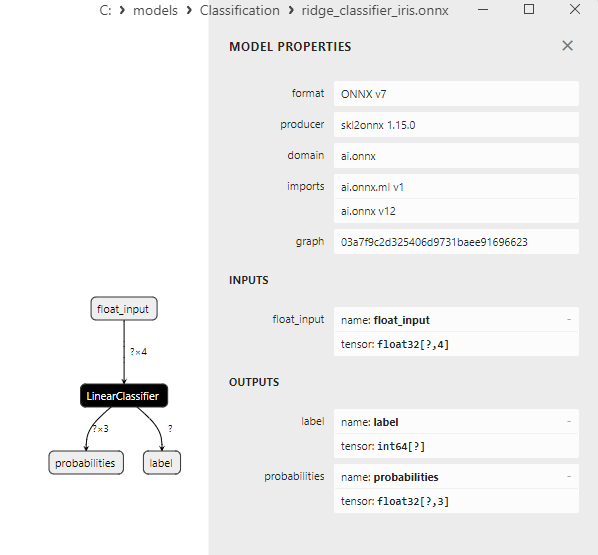

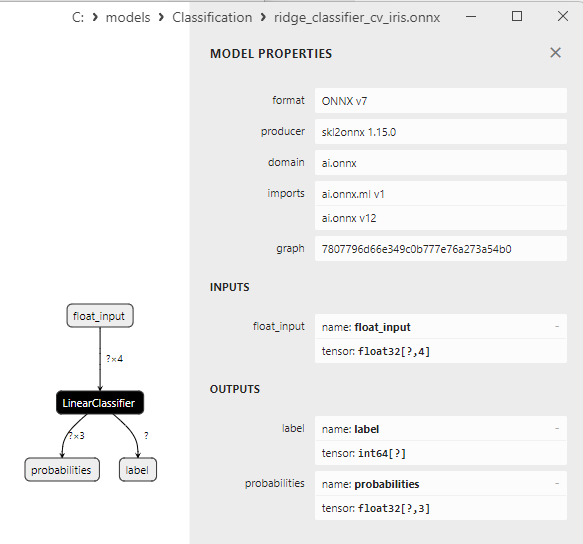

2.5.3. ONNX-Darstellung des Klassifizierungsmodells Ridge - 2.6. RidgeClassifierCV

2.6.1. Code zur Erstellung des Klassifizierungsmodells von Ridge ClassifierCV

2.6.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Ridge ClassifierCV

2.6.3. ONNX-Darstellung des Klassifizierungsmodells Ridge ClassifierCV - 2.7. Random Forest Classifier

2.7.1. Code für die Erstellung des Klassifizierungsmodells Random-Forest

2.7.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Random Forest

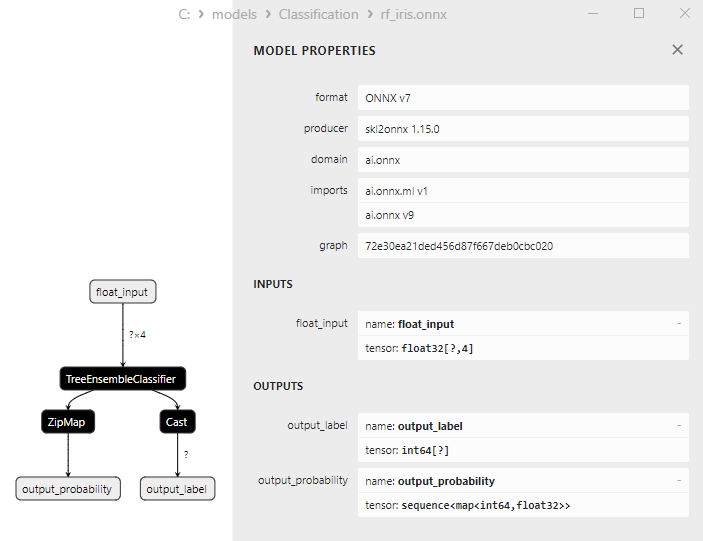

2.7.3. ONNX-Darstellung des Klassifizierungsmodells Random-Forest - 2.8. Gradient Boosting Classifier

2.8.1. Code für die Erstellung des Klassifizierungsmodells Gradient-Boosting

2.8.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Gradient Boosting

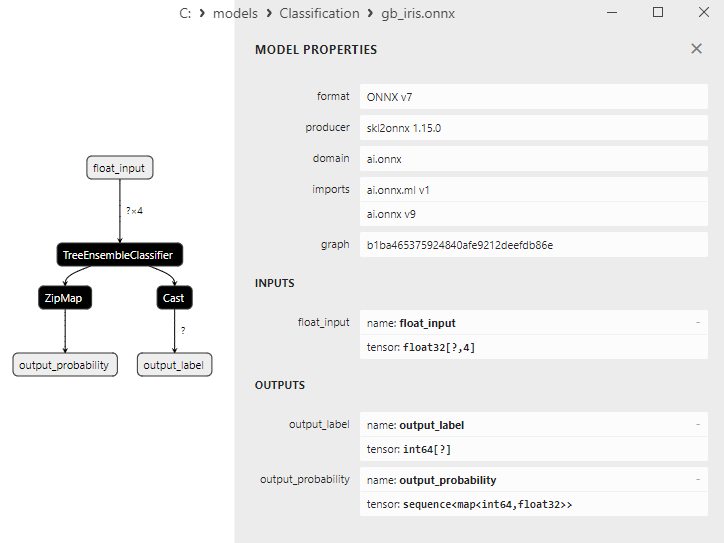

2.8.3. ONNX-Darstellung des Klassifizierungsmodells Gradient-Boosting - 2.9. Adaptive Boosting Classifier

2.9.1. Code für die Erstellung des Klassifizierungsmodells Adaptive Boosting

2.9.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Adaptive Boosting

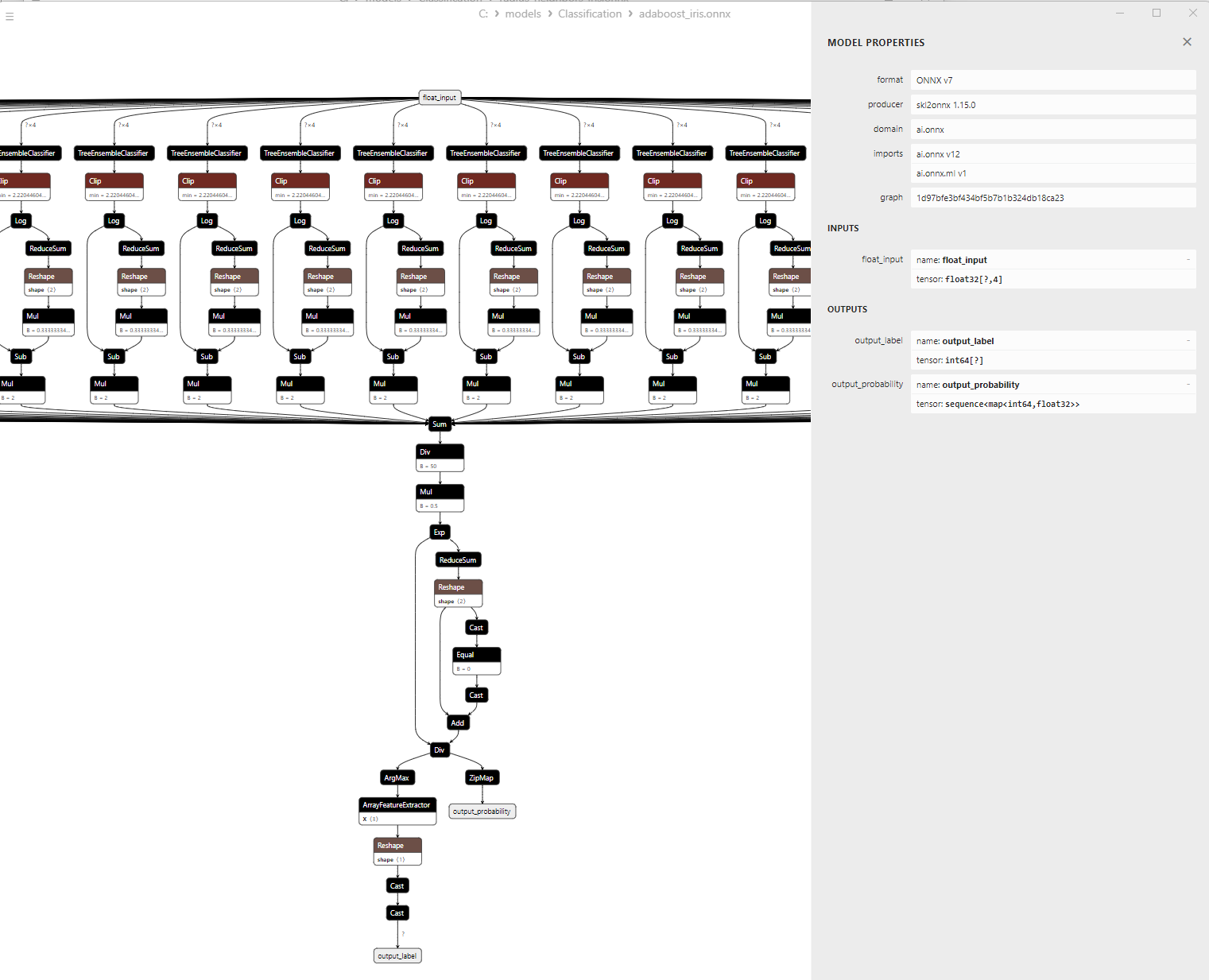

2.9.3. ONNX-Darstellung des Klassifizierungsmodells Adaptive Boosting - 2.10. Bootstrap Aggregating Classifier

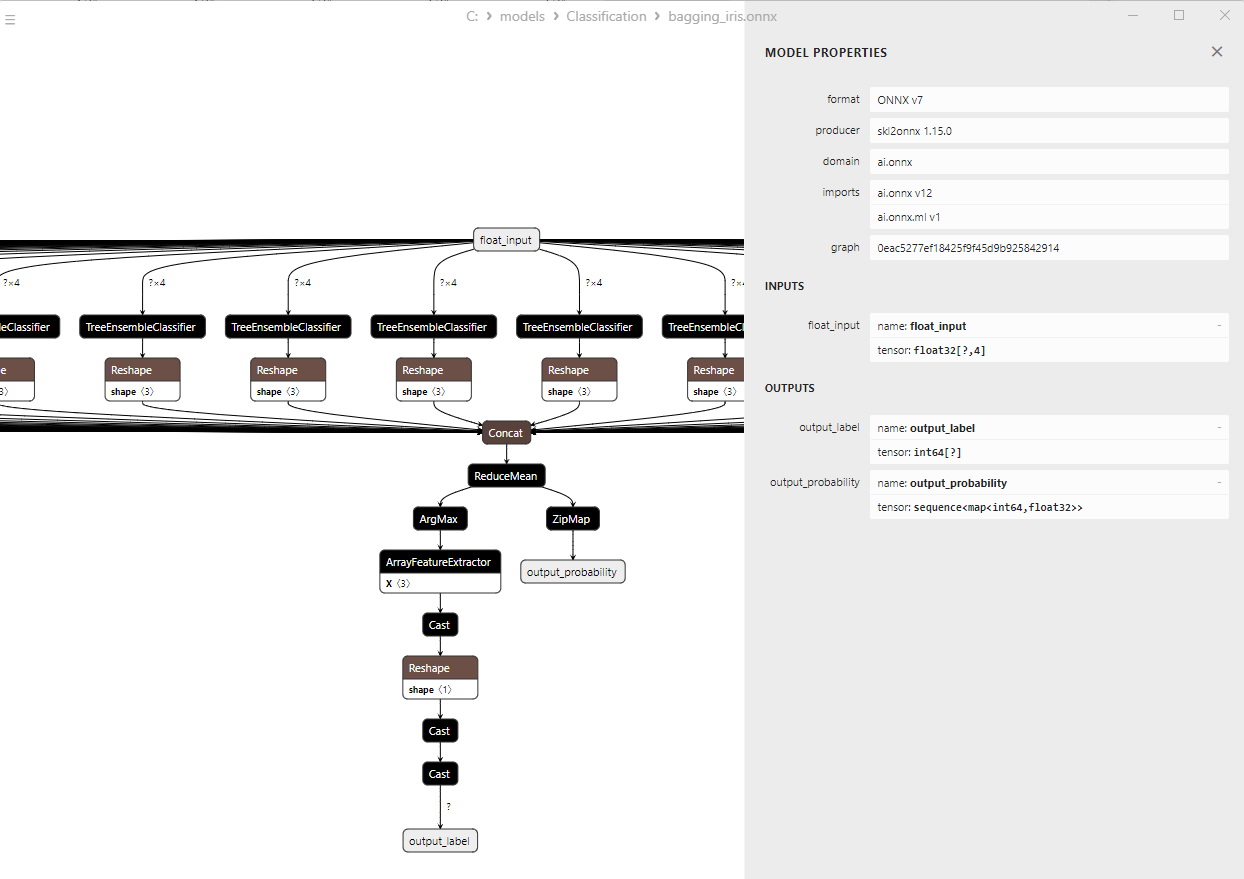

2.10.1. Code für die Erstellung des Bootstrap Aggregating Classifier Model

2.10.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Bootstrap Aggregating

2.10.3. ONNX-Darstellung des Klassifizierungsmodells Bootstrap Aggregating - 2.11. K-Nearest Neighbors (K-NN) Classifier

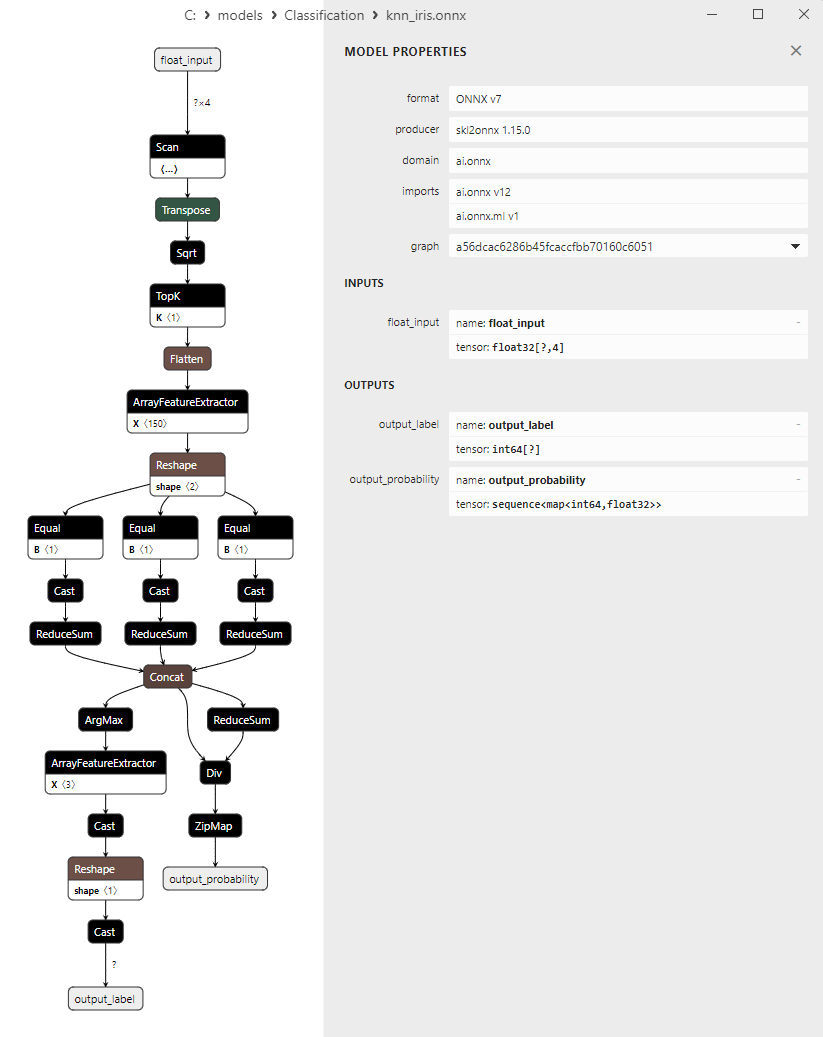

2.11.1. Code zur Erstellung des Klassifizierungsmodells von K-Nearest Neighbors (K-NN)

2.11.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell K-Nächste-Nachbarn (K-NN)

2.11.3. ONNX-Darstellung des Klassifizierungsmodells K-Nächste-Nachbarn (K-NN) - 2.12. Decision Tree Classifier

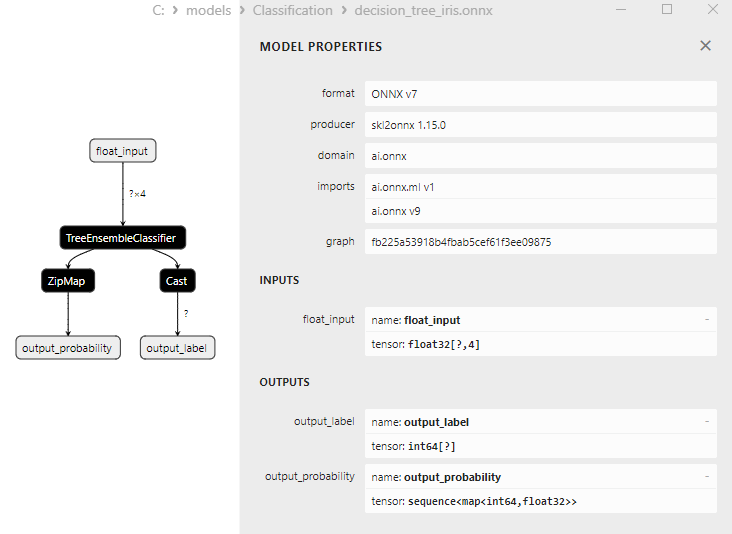

2.12.1. Code für die Erstellung des Klassifizierungsmodells Decision Tree

2.12.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Decision Tree

2.12.3. ONNX-Darstellung des Klassifizierungsmodells Decision Tree - 2.13. Logistic Regression Classifier

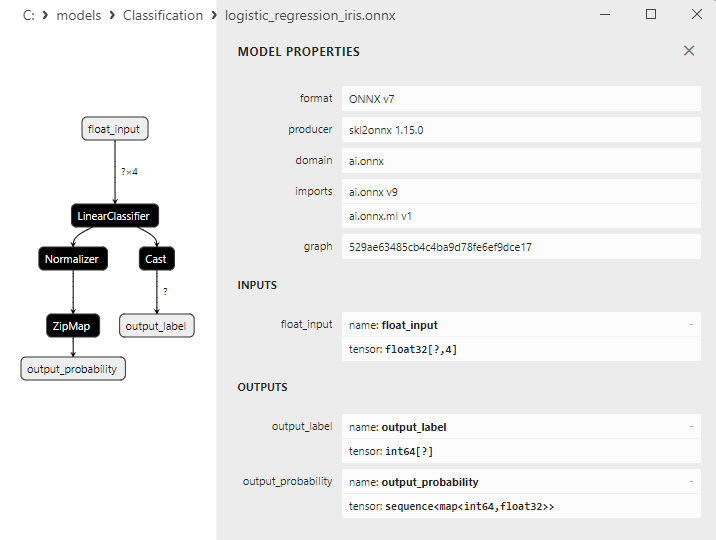

2.13.1. Code für die Erstellung des Klassifizierungsmodells Logistic Regression

2.13.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Logistic Regression

2.13.3. ONNX-Darstellung des Klassifizierungsmodells Logistic Regression - 2.14. LogisticRegressionCV Classifier

2.14.1. Code zur Erstellung des Klassifizierungsmodells von LogisticRegressionCV

2.14.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell LogisticRegressionCV

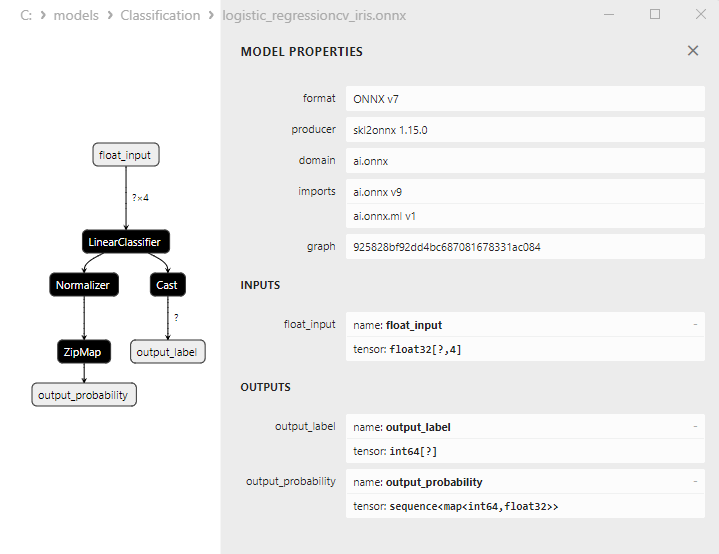

2.14.3. ONNX-Darstellung des Klassifizierungsmodells LogisticRegressionCV - 2.15. Passive-Aggressive (PA) Classifier

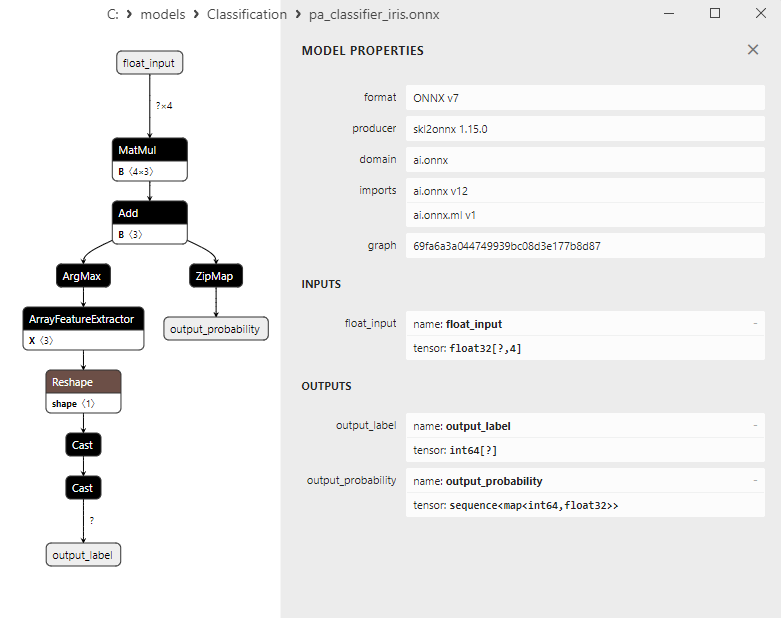

2.15.1. Code zur Erstellung des Klassifizierungsmodells von Passive-Aggressive (PA)

2.15.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Passive-Aggressive (PA)

2.15.3. ONNX-Darstellung des Klassifizierungsmodells Passive-Aggressive (PA) - 2.16. Perceptron Classifier

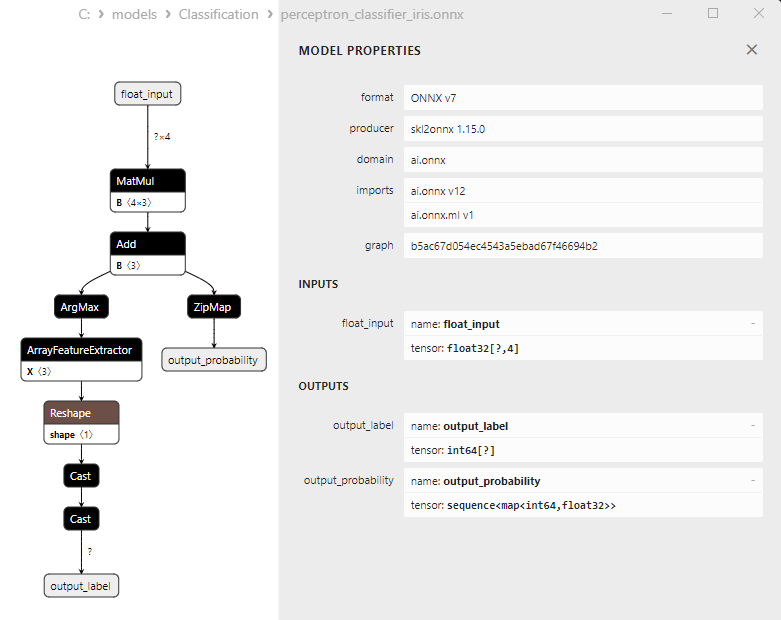

2.16.1. Code zur Erstellung des Klassifizierungsmodells von Perceptron

2.16.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Perceptron

2.16.3. ONNX-Darstellung des Klassifizierungsmodells Perceptron - 2.17. Stochastic Gradient Descent Classifier

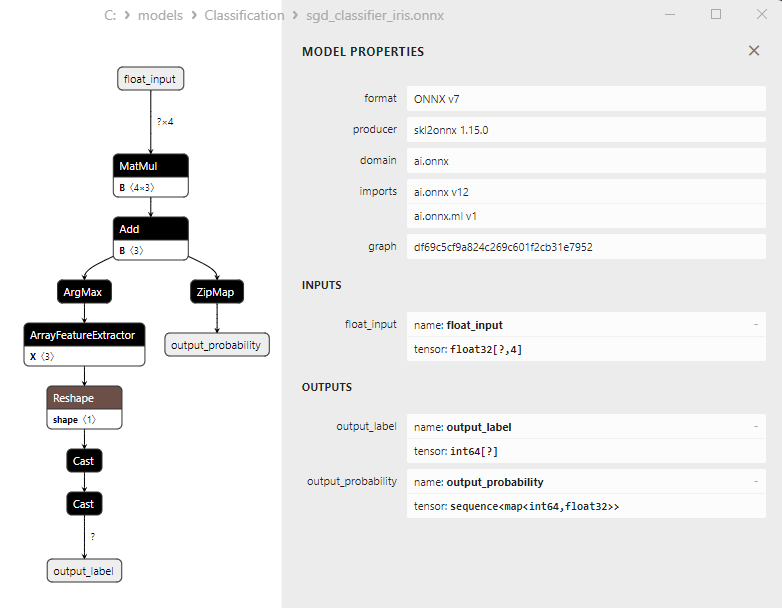

2.17.1. Code für die Erstellung des Klassifizierungsmodells mit stochastischem Gradientenabstieg

2.17.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Stochastic Gradient Descent

2.17.3. ONNX-Darstellung des Klassifizierungsmodells mit stochastischem Gradientenabstieg - 2.18. Gaussian Naive Bayes (GNB) Klassifikator

2.18.1. Code für die Erstellung des Klassifizierungsmodells Gaussian Naive Bayes (GNB)

2.18.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Gaussian Naive Bayes (GNB)

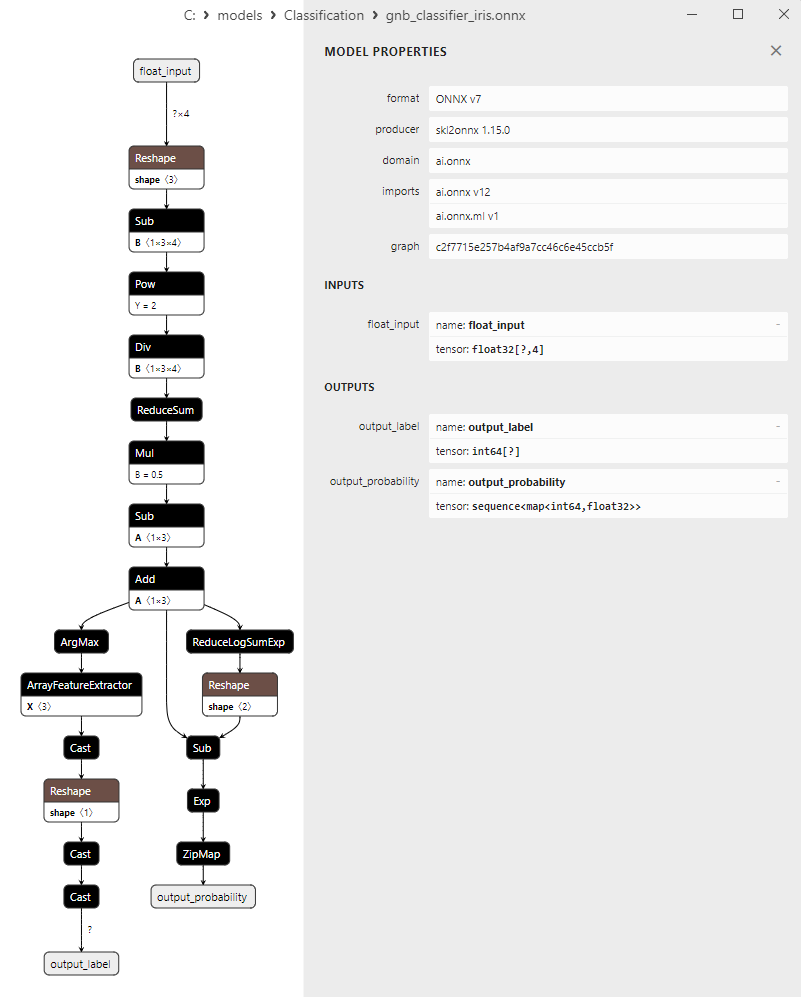

2.18.3. ONNX-Darstellung des Klassifizierungsmodells Gaussian Naive Bayes (GNB) - 2.19. Multinomial Naive Bayes (MNB) Classifier

2.19.1. Code zur Erstellung des Klassifizierungsmodells von Multinomial Naive Bayes (MNB)

2.19.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Multinomial Naive Bayes (MNB)

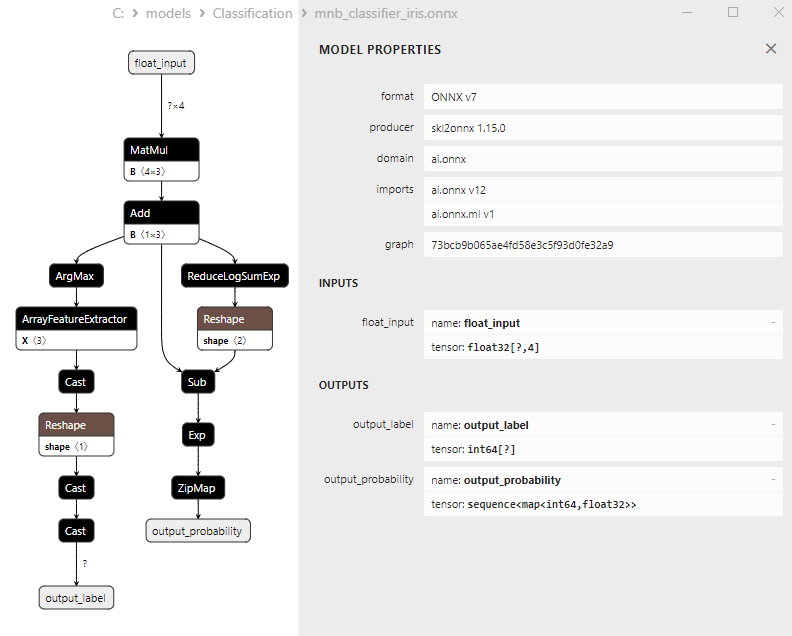

2.19.3. ONNX-Darstellung des Klassifizierungsmodells Multinomial Naive Bayes (MNB) - 2.20. Complement Naive Bayes (CNB) Classifier

2.20.1. Code zur Erstellung des Klassifizierungsmodells von Complement Naive Bayes (CNB)

2.20.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Complement Naive Bayes (CNB)

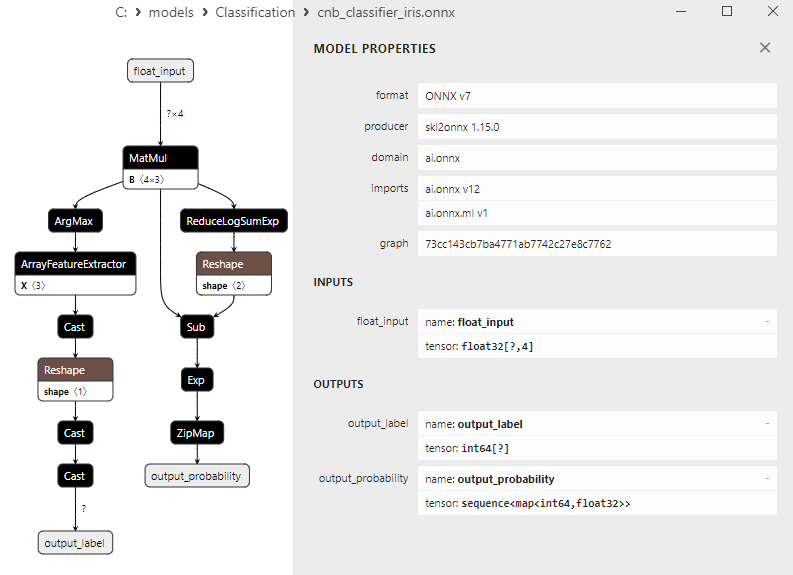

2.20.3. ONNX-Darstellung des Klassifizierungsmodells Complement Naive Bayes (CNB) - 2.21. Bernoulli Naive Bayes (BNB) Classifier

2.21.1. Code zur Erstellung des Klassifizierungsmodells von Bernoulli Naive Bayes (BNB)

2.21.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Bernoulli Naive Bayes (BNB)

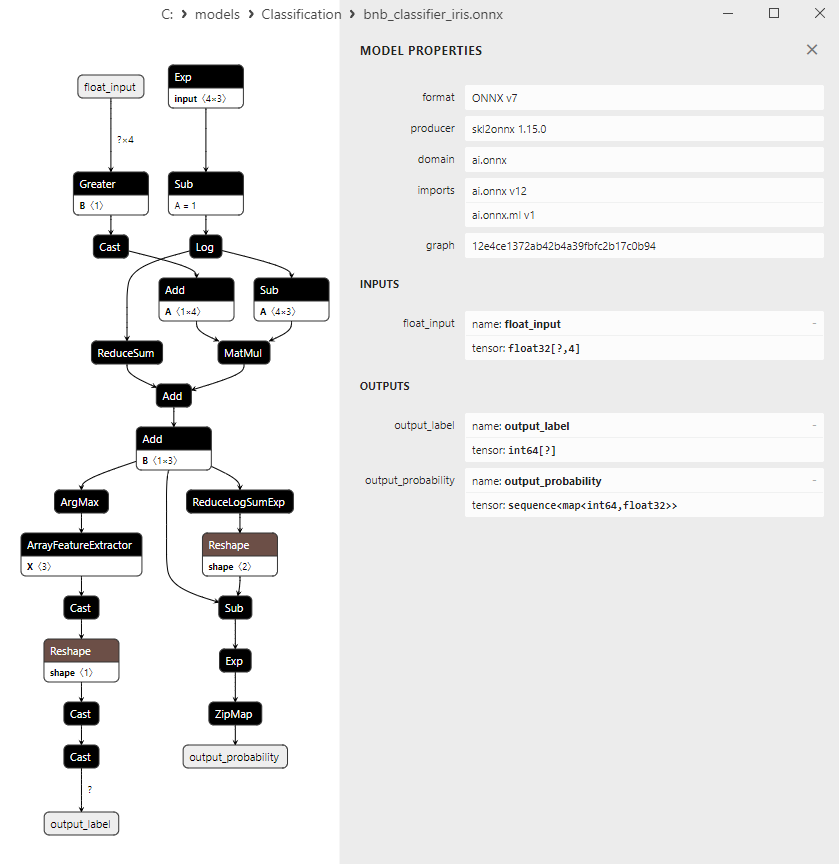

2.21.3. ONNX-Darstellung des Klassifizierungsmodells Bernoulli Naive Bayes (BNB) - 2.22. Multilayer Perceptron Classifier

2.22.1. Code zur Erstellung des Klassifizierungsmodells von Multilayer Perceptron

2.22.2. MQL5 Code für die Arbeit mit dem Klassifizierungsmodell Multilayer Perceptron

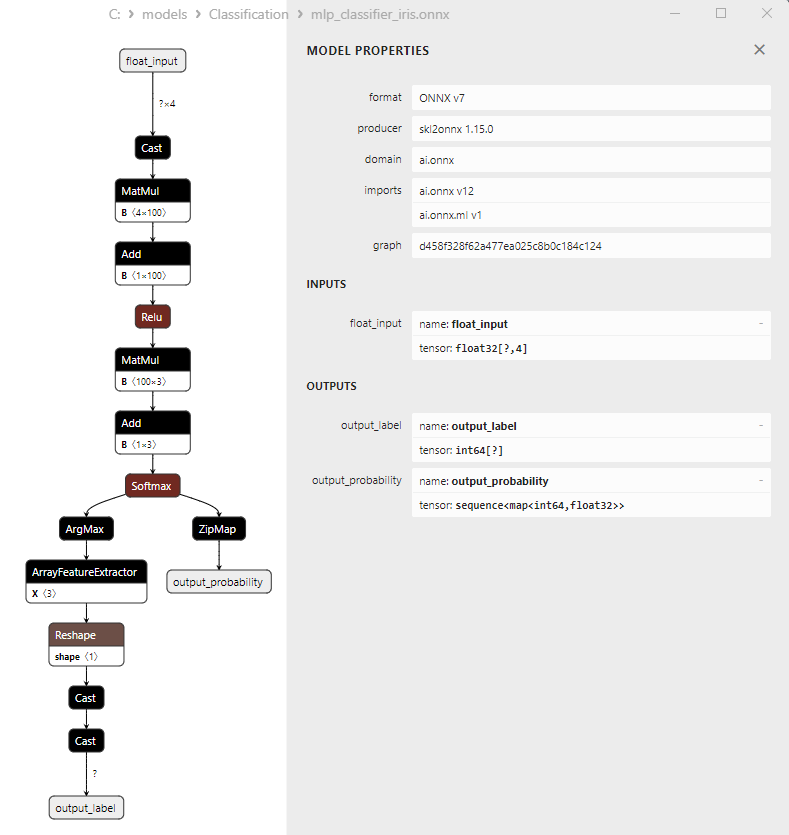

2.22.3. ONNX-Darstellung des Klassifizierungsmodells Multilayer Perceptron - 2.23. Linear Discriminant Analysis (LDA) Classifier

2.23.1. Code zur Erstellung des Klassifizierungsmodells der linearen Diskriminanzanalyse (LDA)

2.23.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell der linearen Diskriminanzanalyse (LDA)

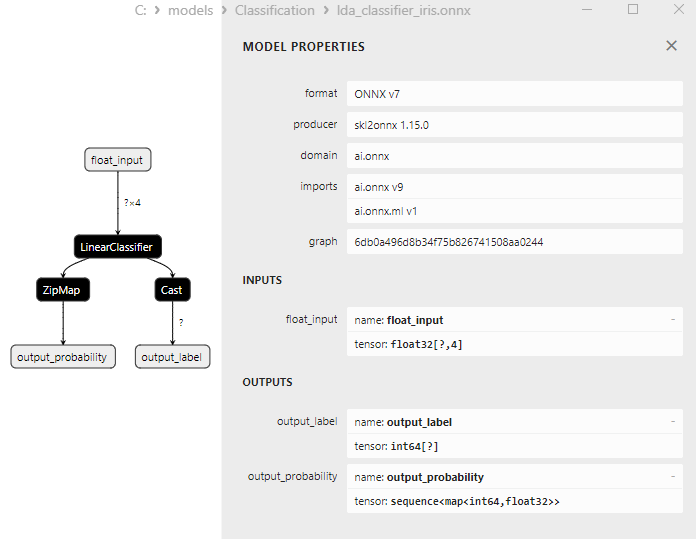

2.23.3. ONNX-Darstellung des Klassifizierungsmodells der linearen Diskriminanzanalyse (LDA) - 2.24. Hist Gradient Boosting

2.24.1. Code zur Erstellung des Klassifizierungsmodells des Histogram-basierten Gradient-Boosting

2.24.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell Histogramm-basierten Gradient Boosting

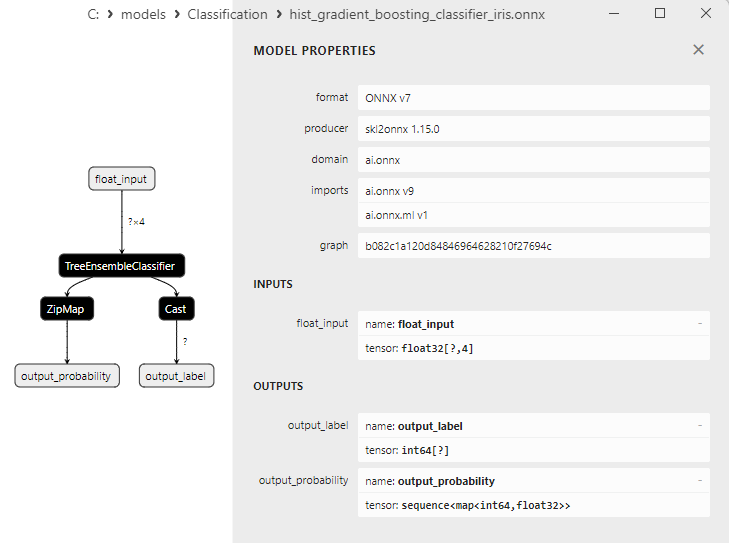

2.24.3. ONNX-Darstellung des Klassifizierungsmodells Histogramm-basierten Gradient-Boosting - 2.25. CategoricalNB Classifier

2.25.1. Code zur Erstellung des Klassifizierungsmodells von CategoricalNB

2.25.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell CategoricalNB

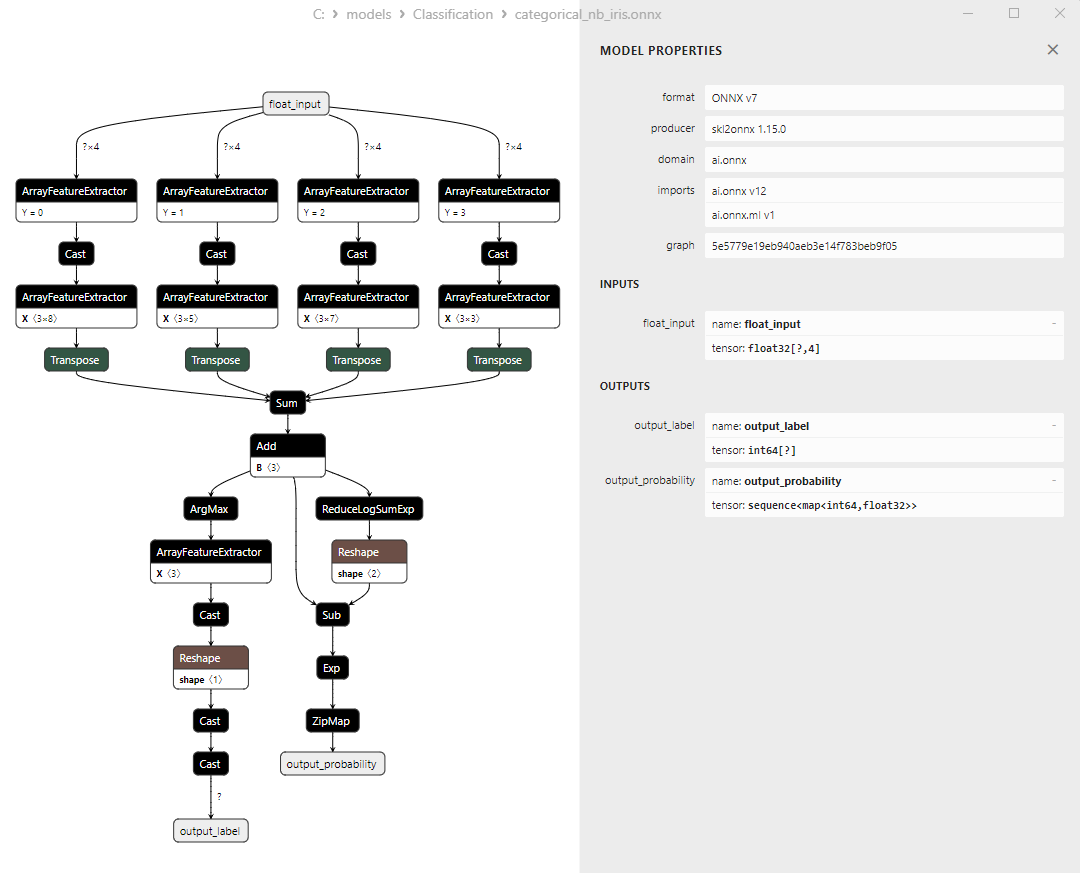

2.25.3. ONNX-Darstellung des Klassifizierungsmodells CategoricalNB - 2.26. ExtraTreeClassifier

2.26.1. Code zur Erstellung des Modells von ExtraTreeClassifier

2.26.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell ExtraTreeClassifier

2.26.3. ONNX-Darstellung des Klassifizierungsmodells ExtraTreeClassifier - 2.27. ExtraTreesClassifier

2.27.1. Code zur Erstellung des Modells von ExtraTreesClassifier

2.27.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell ExtraTreesClassifier

2.27.3. ONNX-Darstellung des Klassifizierungsmodells ExtraTreesClassifier - 2.28. Vergleich der Genauigkeit aller Modelle

2.28.1. Code für die Berechnung aller Modelle und die Erstellung eines Genauigkeitsvergleichsdiagramms

2.28.2. MQL5-Code für die Ausführung aller ONNX-Modelle - 2.29. Scikit-Learn-Klassifikationsmodelle, die nicht in ONNX konvertiert werden konnten

- 2.29.1. DummyClassifier

2.29.1.1. Code zum Erstellen des Klassifizierungsmodells DummyClassifier - 2.29.2. GaussianProcessClassifier

2.29.2.1. Code zur Erstellung des Modells von GaussianProcessClassifier - 2.29.3. LabelPropagation Klassifikator

2.29.3.1. Code zur Erstellung des Modells von LabelPropagationClassifier - 2.29.4. LabelSpreading-Klassifikator

2.29.4.1. Code zur Erstellung des Modells von LabelSpreadingClassifier - 2.29.5. NearestCentroid-Klassifikator

2.29.5.1. Code zur Erstellung Modells von NearestCentroid - 2.29.6. Quadratische Diskriminanzanalyse Klassifikator

2.29.6.1. Code zur Erstellung des Modells der quadratischen Diskriminanzanalyse - Schlussfolgerungen

1. Fishers Schwertlilien

Der Iris-Datensatz, Bilder von Schwertlilien, ist einer der bekanntesten und am häufigsten verwendeten Datensätze im Bereich des maschinellen Lernens. Sie wurde erstmals 1936 von dem Statistiker und Biologen R.A. Fisher und ist seitdem zu einem klassischen Datensatz für Klassifizierungsaufgaben geworden.

Der Iris-Datensatz besteht aus Messungen von Kelch- (sepal) und Blütenblätter (petal) von drei Schwertlilienarten - Iris setosa, Iris virginica und Iris versicolor.

Abbildung 1. Iris setosa

Abbildung 2. Schwertlilie (Iris virginica)

Abbildung 3. Iris versicolor

Der Iris-Datensatz umfasst 150 Instanzen von Schwertlilien, davon 50 Instanzen von jeder der drei Arten. Jede Instanz hat vier numerische Merkmale (gemessen in Zentimetern):

- Länge des Kelchblatts

- Breite des Kelchblatts

- Länge des Blütenblatts

- Breite des Blütenblatts

Jede Instanz hat auch eine entsprechende Klasse, die die Art der Schwertlilie angibt (Iris setosa, Iris virginica oder Iris versicolor). Diese Klassifizierungseigenschaft macht den Iris-Datensatz zu einem idealen Datensatz für maschinelle Lernaufgaben wie Klassifizierung und Clustering.

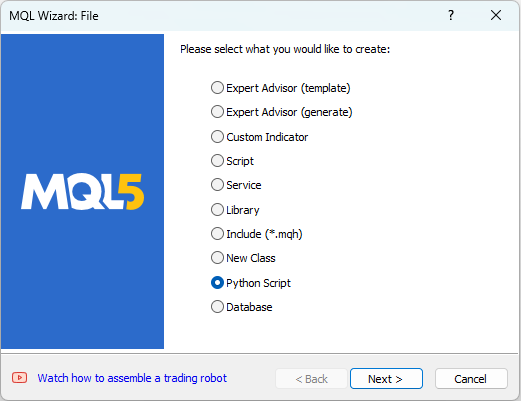

MetaEditor ermöglicht die Arbeit mit Python-Skripten. Um ein Python-Skript zu erstellen, wählen Sie in MetaEditor im Menü „Datei“ die Option „Neu“, woraufhin ein Dialog zur Auswahl des zu erstellenden Objekts erscheint (siehe Abbildung 4).

Abbildung 4. Erstellen eines Python-Skripts im MQL5-Assistenten - Schritt 1

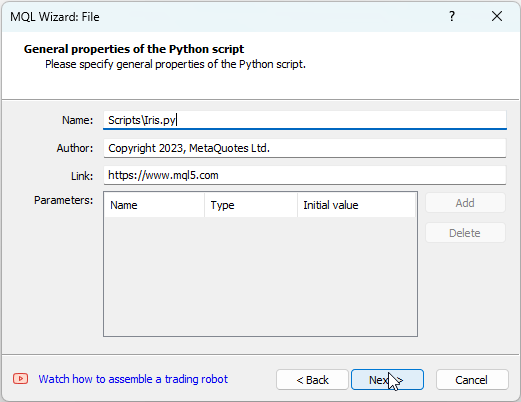

Als Nächstes muss ein Namen für das Skript ein, z. B. „IRIS.py“ eingegeben werden (siehe Abbildung 5).

Abbildung 5. Erstellen eines Python-Skripts im MQL5-Assistenten - Schritt 2 - Skriptname

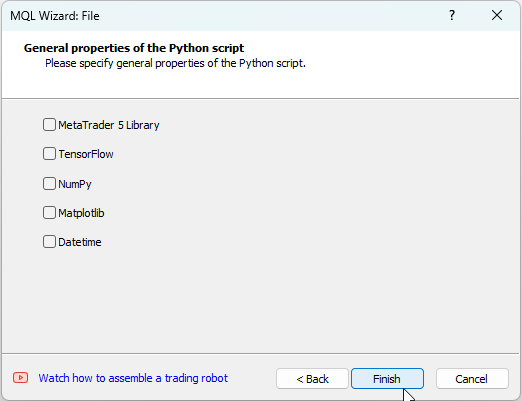

Danach können Sie angeben, welche Bibliotheken verwendet werden sollen. In unserem Fall werden wir diese Felder leer lassen (siehe Abbildung 6).

Abbildung 6: Erstellen eines Python-Skripts im MQL5-Assistenten - Schritt 3

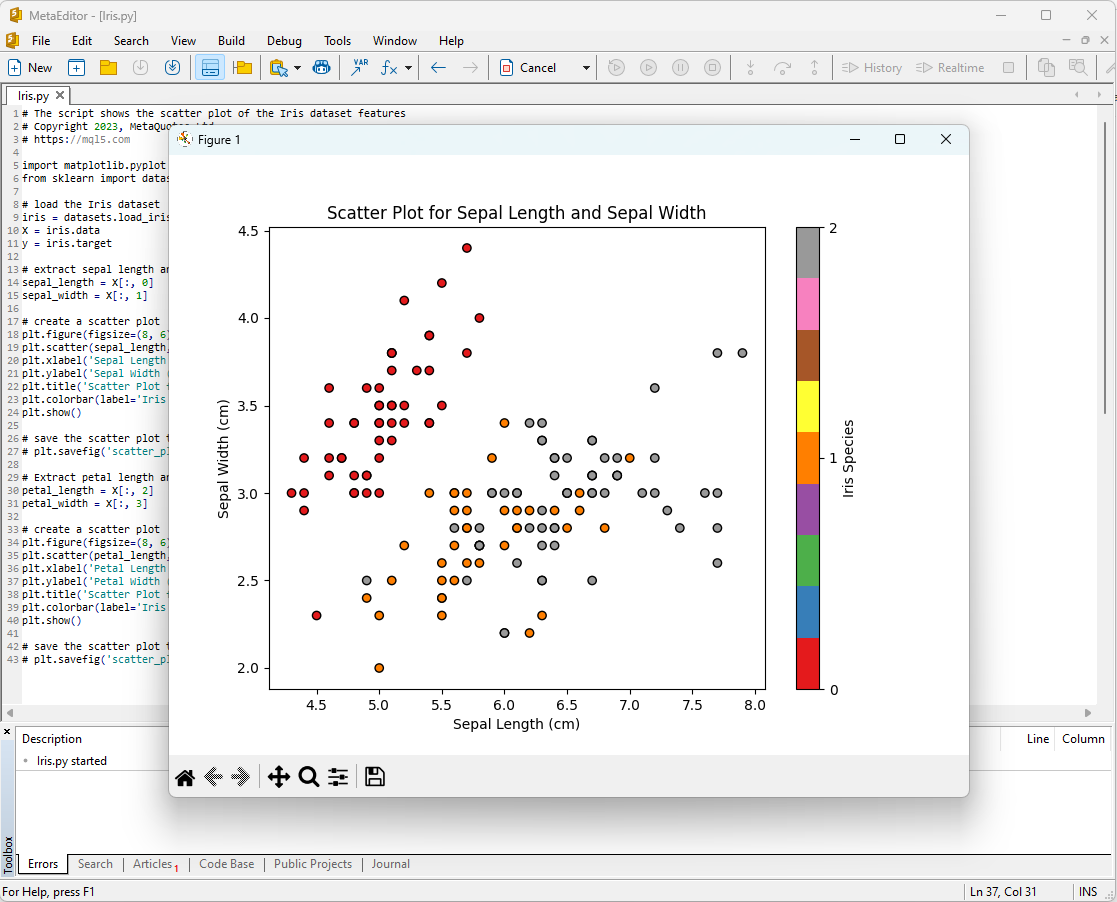

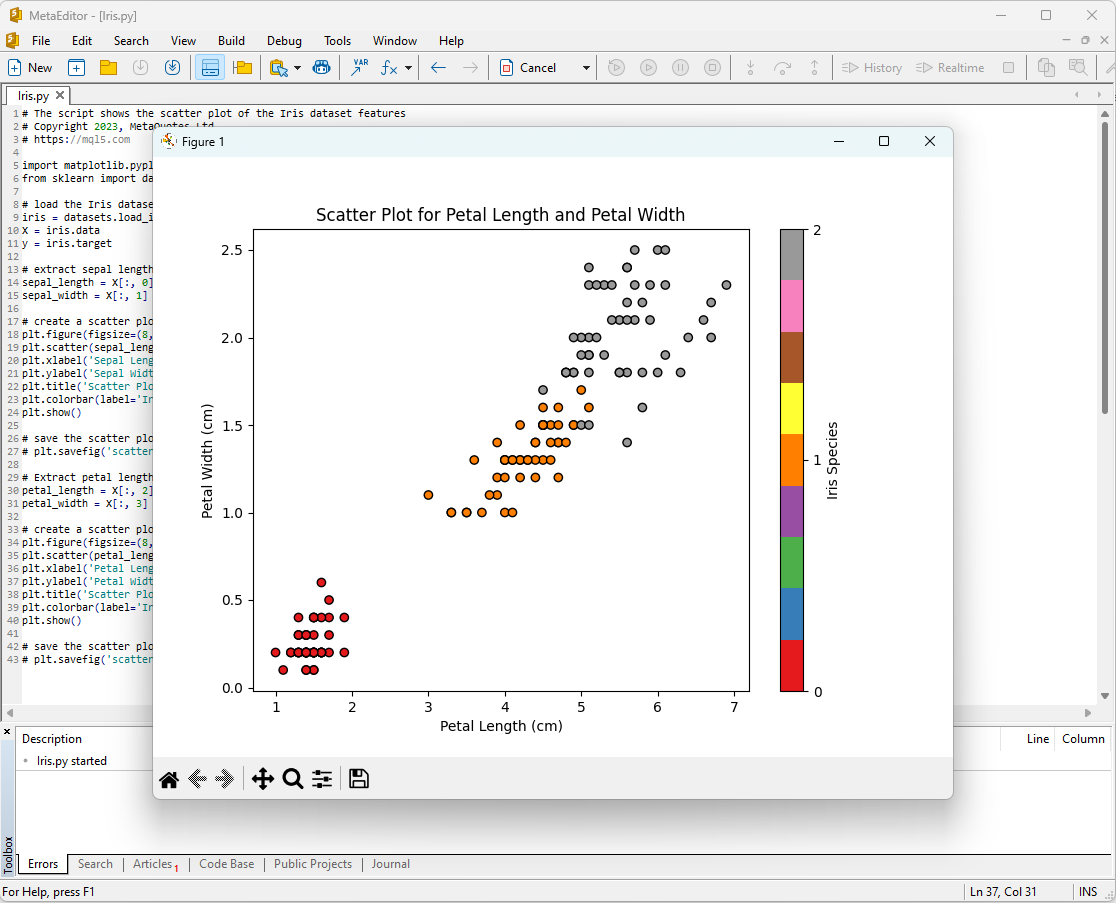

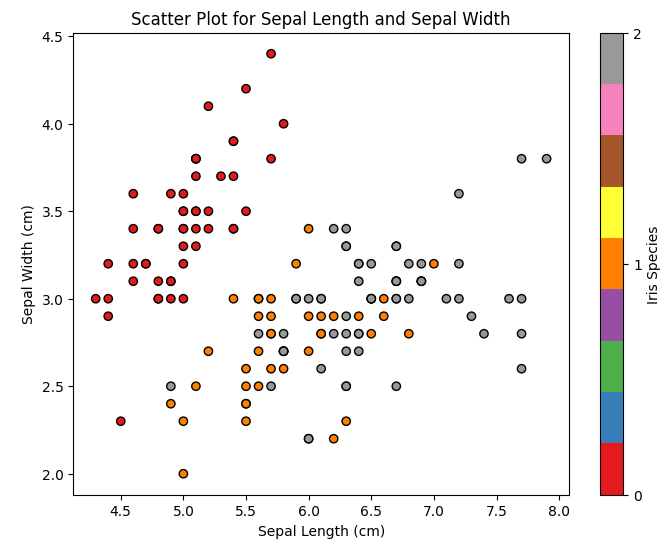

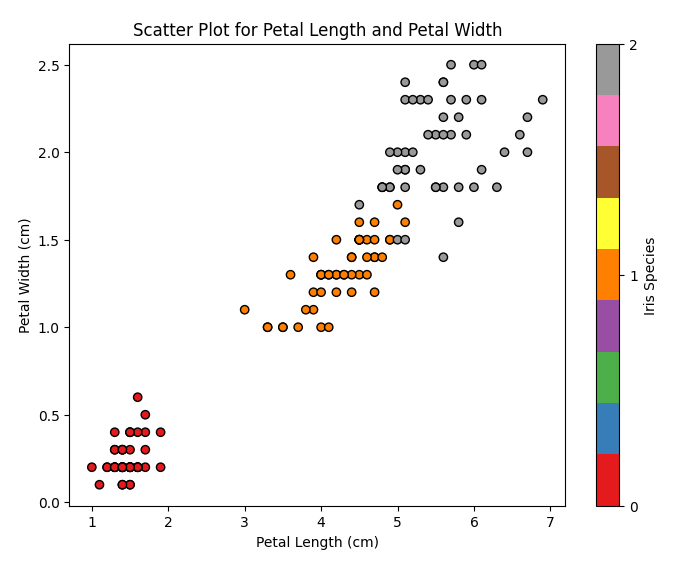

Eine Möglichkeit, mit der Analyse des Iris-Datensatzes zu beginnen, besteht darin, die Daten zu visualisieren. Eine grafische Darstellung ermöglicht es uns, die Struktur der Daten und die Beziehungen zwischen den Merkmalen besser zu verstehen.

Sie können z. B. ein Streudiagramm erstellen, um zu sehen, wie die verschiedenen Schwertlilienarten im Merkmalsraum verteilt sind.

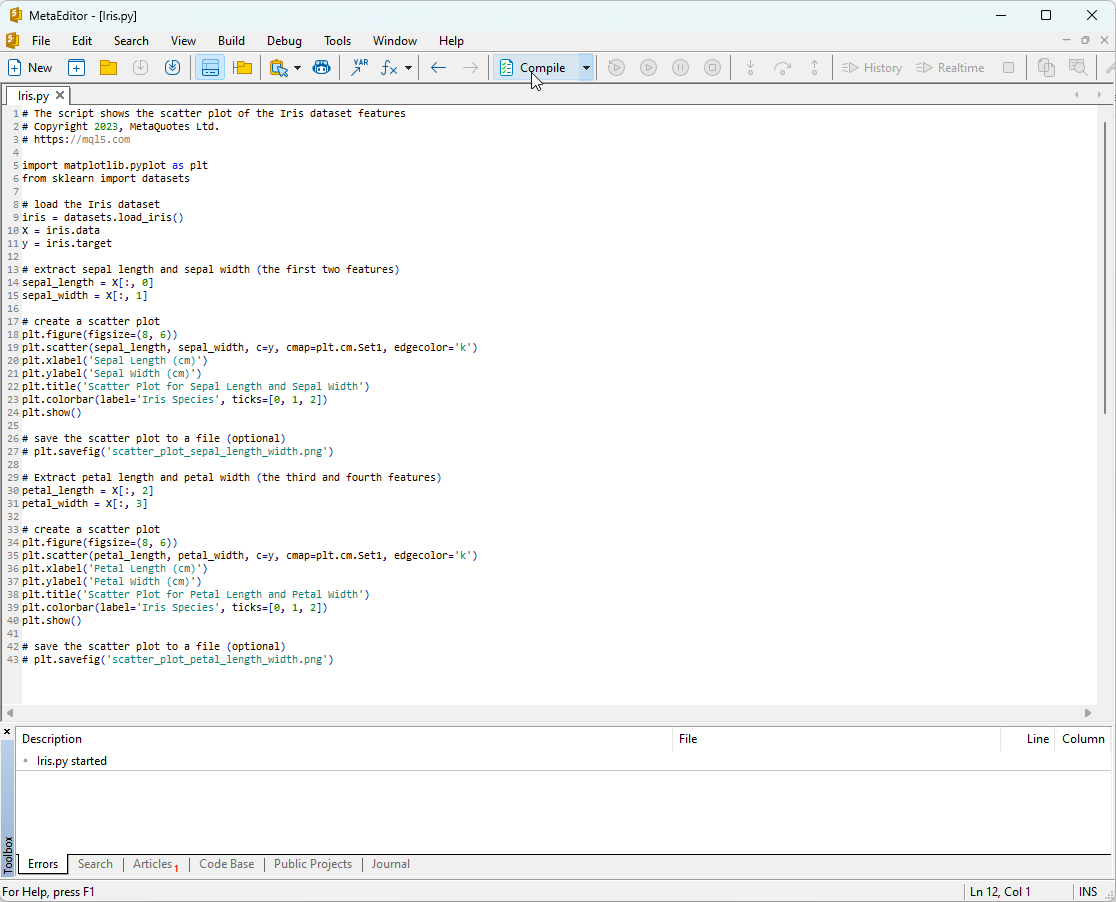

Python-Skript-Code:

# The script shows the scatter plot of the Iris dataset features # Copyright 2023, MetaQuotes Ltd. # https://mql5.com import matplotlib.pyplot as plt from sklearn import datasets # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # extract sepal length and sepal width (the first two features) sepal_length = X[:, 0] sepal_width = X[:, 1] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(sepal_length, sepal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Sepal Length (cm)') plt.ylabel('Sepal Width (cm)') plt.title('Scatter Plot for Sepal Length and Sepal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_sepal_length_width.png') # Extract petal length and petal width (the third and fourth features) petal_length = X[:, 2] petal_width = X[:, 3] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(petal_length, petal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Petal Length (cm)') plt.ylabel('Petal Width (cm)') plt.title('Scatter Plot for Petal Length and Petal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_petal_length_width.png')

Um dieses Skript auszuführen, müssen Sie es in MetaEditor kopieren (siehe Abbildung 7) und auf „Kompilieren“ klicken.

Abbildung 7: Skript IRIS.py in MetaEditor

Danach erscheinen die Diagramme auf dem Bildschirm:

Abbildung 8: Skript IRIS.py in MetaEditor mit Darstellung der Kelchblattlänge/Kelchblattbreite (Sepal Length/Sepal Width)

Abbildung 9: Skript IRIS.py in MetaEditor mit der Darstellung von Blütenblattlänge/Blütenblattbreite

Schauen wir sie uns genauer an.

Abbildung 10: Streuungsdiagramm Kelchblattlänge vs. Kelchblattbreite

In diesem Diagramm sehen wir, wie sich die verschiedenen Schwertlilienarten nach Kelchblattlänge und Kelchblattbreite verteilen. Wir können feststellen, dass Iris setosa im Vergleich zu den anderen beiden Arten kürzere und breitere Kelchblätter hat.

Abbildung 11: Streudiagramm Blütenblattlänge vs. Blütenblattbreite

In diesem Diagramm können wir die verschiedenen Schwertlilienarten auf Basis der Verteilung von Blütenblattlänge und -breite sehen. Wir können feststellen, dass Iris setosa die kürzesten und schmalsten Blütenblätter hat, Iris virginica hat die längsten und breitesten Blütenblätter, und Iris versicolor liegt dazwischen.

Der Iris-Datensatz ist ein idealer Datensatz zum Trainieren und Testen von Modellen für maschinelles Lernen. Wir werden es verwenden, um die Effektivität von maschinellen Lernmodellen für eine Klassifizierungsaufgabe zu analysieren.

2. Modelle für die Klassifizierung

Die Klassifizierung ist eine der grundlegenden Aufgaben des maschinellen Lernens, deren Ziel es ist, Daten anhand bestimmter Merkmale in verschiedene Kategorien oder Klassen einzuteilen.

Schauen wir uns die wichtigsten Modelle für maschinelles Lernen im Scikit-Learn-Paket an.

Liste der Klassifikatoren von Scikit-Learn

Um eine Liste der verfügbaren Klassifikatoren in Scikit-Learn anzuzeigen, können Sie das folgende Skript verwenden:

# ScikitLearnClassifiers.py # The script lists all the classification algorithms available in scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn classifiers from sklearn.utils import all_estimators classifiers = all_estimators(type_filter='classifier') for index, (name, ClassifierClass) in enumerate(classifiers, start=1): print(f"Classifier {index}: {name}")

Ausgabe:

Python The scikit-learn version is 1.2.2.

Python Classifier 1: AdaBoostClassifier

Python Classifier 2: BaggingClassifier

Python Classifier 3: BernoulliNB

Python Classifier 4: CalibratedClassifierCV

Python Classifier 5: CategoricalNB

Python Classifier 6: ClassifierChain

Python Classifier 7: ComplementNB

Python Classifier 8: DecisionTreeClassifier

Python Classifier 9: DummyClassifier

Python Classifier 10: ExtraTreeClassifier

Python Classifier 11: ExtraTreesClassifier

Python Classifier 12: GaussianNB

Python Classifier 13: GaussianProcessClassifier

Python Classifier 14: GradientBoostingClassifier

Python Classifier 15: HistGradientBoostingClassifier

Python Classifier 16: KNeighborsClassifier

Python Classifier 17: LabelPropagation

Python Classifier 18: LabelSpreading

Python Classifier 19: LinearDiscriminantAnalysis

Python Classifier 20: LinearSVC

Python Classifier 21: LogisticRegression

Python Classifier 22: LogisticRegressionCV

Python Classifier 23: MLPClassifier

Python Classifier 24: MultiOutputClassifier

Python Classifier 25: MultinomialNB

Python Classifier 26: NearestCentroid

Python Classifier 27: NuSVC

Python Classifier 28: OneVsOneClassifier

Python Classifier 29: OneVsRestClassifier

Python Classifier 30: OutputCodeClassifier

Python Classifier 31: PassiveAggressiveClassifier

Python Classifier 32: Perceptron

Python Classifier 33: QuadraticDiscriminantAnalysis

Python Classifier 34: RadiusNeighborsClassifier

Python Classifier 35: RandomForestClassifier

Python Classifier 36: RidgeClassifier

Python Classifier 37: RidgeClassifierCV-Klassifikator

Python Classifier 38: SGDClassifier

Python Classifier 39: SVC

Python Classifier 40: StackingClassifier

Python Classifier 41: VotingClassifier

Der Einfachheit halber sind sie in dieser Liste der Klassifikatoren farblich hervorgehoben. Modelle, die einen Basisklassifikator erfordern, sind gelb hervorgehoben, während andere Modelle unabhängig davon verwendet werden können.

Mit Blick auf die Zukunft ist es erwähnenswert, dass grün gefärbte Modelle erfolgreich in das ONNX-Format exportiert wurden, während rot gefärbte Modelle bei der Konvertierung in der aktuellen Version von Scikit-Learn 1.2.2 Fehler aufweisen.

Unterschiedliche Darstellung von Ausgabedaten in Modellen

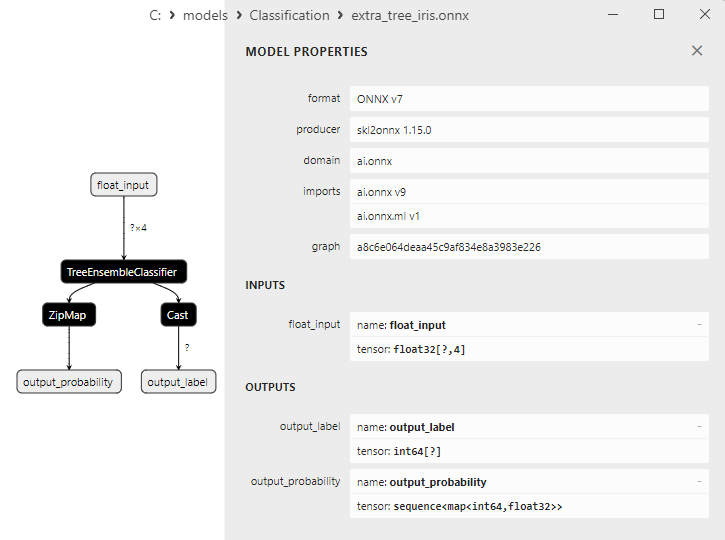

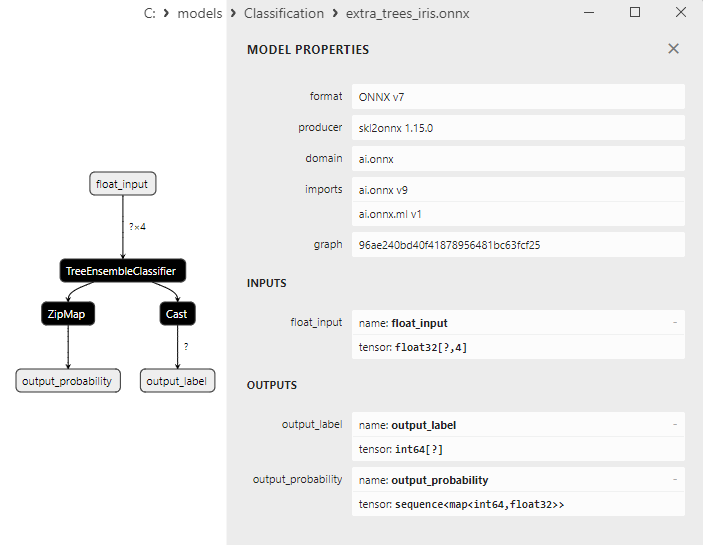

Es ist zu beachten, dass verschiedene Modelle die Ausgabedaten unterschiedlich darstellen, sodass man bei der Arbeit mit Modellen, die in ONNX konvertiert wurden, aufmerksam sein sollte.

Für die Klassifizierungsaufgabe der Schwertlilien von Fisher haben die Eingabetensoren für alle diese Modelle das gleiche Format:

1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Die Output-Tensoren der ONNX-Modelle sind unterschiedlich.

1. Modelle, die nicht nachbearbeitet werden müssen:

- SVC Classifier;

- LinearSVC Classifier;

- NuSVC Classifier;

- Radius Neighbors Classifier;

- Ridge Classifier;

- Ridge Classifier CV.

1. Name: label, Data Type: tensor(int64), Shape: [None]

2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Diese Modelle geben das Ergebnis (Klassennummer) explizit im ersten ganzzahligen Ausgabetensor „label“ zurück, ohne dass eine Nachbearbeitung erforderlich ist.

2. Modelle, deren Ergebnisse nachbearbeitet werden müssen:

- Random Forest Classifier;

- Gradient Boosting Classifier;

- AdaBoost Classifier;

- Bagging Classifier;

- K-NN_Classifier;

- Decision Tree Classifier;

- Logistic Regression Classifier;

- Logistic Regression CV Classifier;

- Passive-Aggressive Classifier;

- Perceptron Classifier;

- SGD Classifier;

- Gaussian Naive Bayes Classifier;

- Multinomial Naive Bayes Classifier;

- Complement Naive Bayes Classifier;

- Bernoulli Naive Bayes Classifier;

- Multilayer Perceptron Classifier;

- Linear Discriminant Analysis Classifier;

- Hist Gradient Boosting Classifier;

- Categorical Naive Bayes Classifier;

- ExtraTree Classifier;

- ExtraTrees Classifier.

1. Name: output_label, Data Type: tensor(int64), Shape: [None]

2. Name: output_probability, Data Type: seq(map(int64,tensor(float))), Shape: []

Diese Modelle liefern eine Liste von Klassen und Wahrscheinlichkeiten der Zugehörigkeit zu jeder Klasse.

Um das Ergebnis in diesen Fällen zu erhalten, ist eine Nachbearbeitung erforderlich, wie z. B. seq(map(int64, tensor(float)) (Suche nach dem Element mit der höchsten Wahrscheinlichkeit).

Daher ist es wichtig, bei der Arbeit mit ONNX-Modellen aufmerksam zu sein und diese Aspekte zu berücksichtigen. Ein Beispiel für eine andere Ergebnisverarbeitung ist im Skript in 2.28.2 dargestellt.

iris.mqh

Um Modelle mit dem vollständigen Iris-Datensatz in MQL5 zu testen, ist eine Datenaufbereitung erforderlich. Zu diesem Zweck wird die Funktion PrepareIrisDataset() verwendet.

Es ist praktisch, diese Funktionen in die Datei iris.mqh zu verschieben.

//+------------------------------------------------------------------+ //| Iris.mqh | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" //+------------------------------------------------------------------+ //| Structure for the IRIS Dataset sample | //+------------------------------------------------------------------+ struct sIRISsample { int sample_id; // sample id (1-150) double features[4]; // SepalLengthCm,SepalWidthCm,PetalLengthCm,PetalWidthCm string class_name; // class ("Iris-setosa","Iris-versicolor","Iris-virginica") int class_id; // class id (0,1,2), calculated by function IRISClassID }; //--- Iris dataset sIRISsample ExtIRISDataset[]; int Exttotal=0; //+------------------------------------------------------------------+ //| Returns class id by class name | //+------------------------------------------------------------------+ int IRISClassID(string class_name) { //--- if(class_name=="Iris-setosa") return(0); else if(class_name=="Iris-versicolor") return(1); else if(class_name=="Iris-virginica") return(2); //--- return(-1); } //+------------------------------------------------------------------+ //| AddSample | //+------------------------------------------------------------------+ bool AddSample(const int Id,const double SepalLengthCm,const double SepalWidthCm,const double PetalLengthCm,const double PetalWidthCm, const string Species) { //--- ExtIRISDataset[Exttotal].sample_id=Id; //--- ExtIRISDataset[Exttotal].features[0]=SepalLengthCm; ExtIRISDataset[Exttotal].features[1]=SepalWidthCm; ExtIRISDataset[Exttotal].features[2]=PetalLengthCm; ExtIRISDataset[Exttotal].features[3]=PetalWidthCm; //--- ExtIRISDataset[Exttotal].class_name=Species; ExtIRISDataset[Exttotal].class_id=IRISClassID(Species); //--- Exttotal++; //--- return(true); } //+------------------------------------------------------------------+ //| Prepare Iris Dataset | //+------------------------------------------------------------------+ bool PrepareIrisDataset(sIRISsample &iris_samples[]) { ArrayResize(ExtIRISDataset,150); Exttotal=0; //--- AddSample(1,5.1,3.5,1.4,0.2,"Iris-setosa"); AddSample(2,4.9,3.0,1.4,0.2,"Iris-setosa"); AddSample(3,4.7,3.2,1.3,0.2,"Iris-setosa"); AddSample(4,4.6,3.1,1.5,0.2,"Iris-setosa"); AddSample(5,5.0,3.6,1.4,0.2,"Iris-setosa"); AddSample(6,5.4,3.9,1.7,0.4,"Iris-setosa"); AddSample(7,4.6,3.4,1.4,0.3,"Iris-setosa"); AddSample(8,5.0,3.4,1.5,0.2,"Iris-setosa"); AddSample(9,4.4,2.9,1.4,0.2,"Iris-setosa"); AddSample(10,4.9,3.1,1.5,0.1,"Iris-setosa"); AddSample(11,5.4,3.7,1.5,0.2,"Iris-setosa"); AddSample(12,4.8,3.4,1.6,0.2,"Iris-setosa"); AddSample(13,4.8,3.0,1.4,0.1,"Iris-setosa"); AddSample(14,4.3,3.0,1.1,0.1,"Iris-setosa"); AddSample(15,5.8,4.0,1.2,0.2,"Iris-setosa"); AddSample(16,5.7,4.4,1.5,0.4,"Iris-setosa"); AddSample(17,5.4,3.9,1.3,0.4,"Iris-setosa"); AddSample(18,5.1,3.5,1.4,0.3,"Iris-setosa"); AddSample(19,5.7,3.8,1.7,0.3,"Iris-setosa"); AddSample(20,5.1,3.8,1.5,0.3,"Iris-setosa"); AddSample(21,5.4,3.4,1.7,0.2,"Iris-setosa"); AddSample(22,5.1,3.7,1.5,0.4,"Iris-setosa"); AddSample(23,4.6,3.6,1.0,0.2,"Iris-setosa"); AddSample(24,5.1,3.3,1.7,0.5,"Iris-setosa"); AddSample(25,4.8,3.4,1.9,0.2,"Iris-setosa"); AddSample(26,5.0,3.0,1.6,0.2,"Iris-setosa"); AddSample(27,5.0,3.4,1.6,0.4,"Iris-setosa"); AddSample(28,5.2,3.5,1.5,0.2,"Iris-setosa"); AddSample(29,5.2,3.4,1.4,0.2,"Iris-setosa"); AddSample(30,4.7,3.2,1.6,0.2,"Iris-setosa"); AddSample(31,4.8,3.1,1.6,0.2,"Iris-setosa"); AddSample(32,5.4,3.4,1.5,0.4,"Iris-setosa"); AddSample(33,5.2,4.1,1.5,0.1,"Iris-setosa"); AddSample(34,5.5,4.2,1.4,0.2,"Iris-setosa"); AddSample(35,4.9,3.1,1.5,0.2,"Iris-setosa"); AddSample(36,5.0,3.2,1.2,0.2,"Iris-setosa"); AddSample(37,5.5,3.5,1.3,0.2,"Iris-setosa"); AddSample(38,4.9,3.6,1.4,0.1,"Iris-setosa"); AddSample(39,4.4,3.0,1.3,0.2,"Iris-setosa"); AddSample(40,5.1,3.4,1.5,0.2,"Iris-setosa"); AddSample(41,5.0,3.5,1.3,0.3,"Iris-setosa"); AddSample(42,4.5,2.3,1.3,0.3,"Iris-setosa"); AddSample(43,4.4,3.2,1.3,0.2,"Iris-setosa"); AddSample(44,5.0,3.5,1.6,0.6,"Iris-setosa"); AddSample(45,5.1,3.8,1.9,0.4,"Iris-setosa"); AddSample(46,4.8,3.0,1.4,0.3,"Iris-setosa"); AddSample(47,5.1,3.8,1.6,0.2,"Iris-setosa"); AddSample(48,4.6,3.2,1.4,0.2,"Iris-setosa"); AddSample(49,5.3,3.7,1.5,0.2,"Iris-setosa"); AddSample(50,5.0,3.3,1.4,0.2,"Iris-setosa"); AddSample(51,7.0,3.2,4.7,1.4,"Iris-versicolor"); AddSample(52,6.4,3.2,4.5,1.5,"Iris-versicolor"); AddSample(53,6.9,3.1,4.9,1.5,"Iris-versicolor"); AddSample(54,5.5,2.3,4.0,1.3,"Iris-versicolor"); AddSample(55,6.5,2.8,4.6,1.5,"Iris-versicolor"); AddSample(56,5.7,2.8,4.5,1.3,"Iris-versicolor"); AddSample(57,6.3,3.3,4.7,1.6,"Iris-versicolor"); AddSample(58,4.9,2.4,3.3,1.0,"Iris-versicolor"); AddSample(59,6.6,2.9,4.6,1.3,"Iris-versicolor"); AddSample(60,5.2,2.7,3.9,1.4,"Iris-versicolor"); AddSample(61,5.0,2.0,3.5,1.0,"Iris-versicolor"); AddSample(62,5.9,3.0,4.2,1.5,"Iris-versicolor"); AddSample(63,6.0,2.2,4.0,1.0,"Iris-versicolor"); AddSample(64,6.1,2.9,4.7,1.4,"Iris-versicolor"); AddSample(65,5.6,2.9,3.6,1.3,"Iris-versicolor"); AddSample(66,6.7,3.1,4.4,1.4,"Iris-versicolor"); AddSample(67,5.6,3.0,4.5,1.5,"Iris-versicolor"); AddSample(68,5.8,2.7,4.1,1.0,"Iris-versicolor"); AddSample(69,6.2,2.2,4.5,1.5,"Iris-versicolor"); AddSample(70,5.6,2.5,3.9,1.1,"Iris-versicolor"); AddSample(71,5.9,3.2,4.8,1.8,"Iris-versicolor"); AddSample(72,6.1,2.8,4.0,1.3,"Iris-versicolor"); AddSample(73,6.3,2.5,4.9,1.5,"Iris-versicolor"); AddSample(74,6.1,2.8,4.7,1.2,"Iris-versicolor"); AddSample(75,6.4,2.9,4.3,1.3,"Iris-versicolor"); AddSample(76,6.6,3.0,4.4,1.4,"Iris-versicolor"); AddSample(77,6.8,2.8,4.8,1.4,"Iris-versicolor"); AddSample(78,6.7,3.0,5.0,1.7,"Iris-versicolor"); AddSample(79,6.0,2.9,4.5,1.5,"Iris-versicolor"); AddSample(80,5.7,2.6,3.5,1.0,"Iris-versicolor"); AddSample(81,5.5,2.4,3.8,1.1,"Iris-versicolor"); AddSample(82,5.5,2.4,3.7,1.0,"Iris-versicolor"); AddSample(83,5.8,2.7,3.9,1.2,"Iris-versicolor"); AddSample(84,6.0,2.7,5.1,1.6,"Iris-versicolor"); AddSample(85,5.4,3.0,4.5,1.5,"Iris-versicolor"); AddSample(86,6.0,3.4,4.5,1.6,"Iris-versicolor"); AddSample(87,6.7,3.1,4.7,1.5,"Iris-versicolor"); AddSample(88,6.3,2.3,4.4,1.3,"Iris-versicolor"); AddSample(89,5.6,3.0,4.1,1.3,"Iris-versicolor"); AddSample(90,5.5,2.5,4.0,1.3,"Iris-versicolor"); AddSample(91,5.5,2.6,4.4,1.2,"Iris-versicolor"); AddSample(92,6.1,3.0,4.6,1.4,"Iris-versicolor"); AddSample(93,5.8,2.6,4.0,1.2,"Iris-versicolor"); AddSample(94,5.0,2.3,3.3,1.0,"Iris-versicolor"); AddSample(95,5.6,2.7,4.2,1.3,"Iris-versicolor"); AddSample(96,5.7,3.0,4.2,1.2,"Iris-versicolor"); AddSample(97,5.7,2.9,4.2,1.3,"Iris-versicolor"); AddSample(98,6.2,2.9,4.3,1.3,"Iris-versicolor"); AddSample(99,5.1,2.5,3.0,1.1,"Iris-versicolor"); AddSample(100,5.7,2.8,4.1,1.3,"Iris-versicolor"); AddSample(101,6.3,3.3,6.0,2.5,"Iris-virginica"); AddSample(102,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(103,7.1,3.0,5.9,2.1,"Iris-virginica"); AddSample(104,6.3,2.9,5.6,1.8,"Iris-virginica"); AddSample(105,6.5,3.0,5.8,2.2,"Iris-virginica"); AddSample(106,7.6,3.0,6.6,2.1,"Iris-virginica"); AddSample(107,4.9,2.5,4.5,1.7,"Iris-virginica"); AddSample(108,7.3,2.9,6.3,1.8,"Iris-virginica"); AddSample(109,6.7,2.5,5.8,1.8,"Iris-virginica"); AddSample(110,7.2,3.6,6.1,2.5,"Iris-virginica"); AddSample(111,6.5,3.2,5.1,2.0,"Iris-virginica"); AddSample(112,6.4,2.7,5.3,1.9,"Iris-virginica"); AddSample(113,6.8,3.0,5.5,2.1,"Iris-virginica"); AddSample(114,5.7,2.5,5.0,2.0,"Iris-virginica"); AddSample(115,5.8,2.8,5.1,2.4,"Iris-virginica"); AddSample(116,6.4,3.2,5.3,2.3,"Iris-virginica"); AddSample(117,6.5,3.0,5.5,1.8,"Iris-virginica"); AddSample(118,7.7,3.8,6.7,2.2,"Iris-virginica"); AddSample(119,7.7,2.6,6.9,2.3,"Iris-virginica"); AddSample(120,6.0,2.2,5.0,1.5,"Iris-virginica"); AddSample(121,6.9,3.2,5.7,2.3,"Iris-virginica"); AddSample(122,5.6,2.8,4.9,2.0,"Iris-virginica"); AddSample(123,7.7,2.8,6.7,2.0,"Iris-virginica"); AddSample(124,6.3,2.7,4.9,1.8,"Iris-virginica"); AddSample(125,6.7,3.3,5.7,2.1,"Iris-virginica"); AddSample(126,7.2,3.2,6.0,1.8,"Iris-virginica"); AddSample(127,6.2,2.8,4.8,1.8,"Iris-virginica"); AddSample(128,6.1,3.0,4.9,1.8,"Iris-virginica"); AddSample(129,6.4,2.8,5.6,2.1,"Iris-virginica"); AddSample(130,7.2,3.0,5.8,1.6,"Iris-virginica"); AddSample(131,7.4,2.8,6.1,1.9,"Iris-virginica"); AddSample(132,7.9,3.8,6.4,2.0,"Iris-virginica"); AddSample(133,6.4,2.8,5.6,2.2,"Iris-virginica"); AddSample(134,6.3,2.8,5.1,1.5,"Iris-virginica"); AddSample(135,6.1,2.6,5.6,1.4,"Iris-virginica"); AddSample(136,7.7,3.0,6.1,2.3,"Iris-virginica"); AddSample(137,6.3,3.4,5.6,2.4,"Iris-virginica"); AddSample(138,6.4,3.1,5.5,1.8,"Iris-virginica"); AddSample(139,6.0,3.0,4.8,1.8,"Iris-virginica"); AddSample(140,6.9,3.1,5.4,2.1,"Iris-virginica"); AddSample(141,6.7,3.1,5.6,2.4,"Iris-virginica"); AddSample(142,6.9,3.1,5.1,2.3,"Iris-virginica"); AddSample(143,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(144,6.8,3.2,5.9,2.3,"Iris-virginica"); AddSample(145,6.7,3.3,5.7,2.5,"Iris-virginica"); AddSample(146,6.7,3.0,5.2,2.3,"Iris-virginica"); AddSample(147,6.3,2.5,5.0,1.9,"Iris-virginica"); AddSample(148,6.5,3.0,5.2,2.0,"Iris-virginica"); AddSample(149,6.2,3.4,5.4,2.3,"Iris-virginica"); AddSample(150,5.9,3.0,5.1,1.8,"Iris-virginica"); //--- ArrayResize(iris_samples,150); for(int i=0; i<Exttotal; i++) { iris_samples[i]=ExtIRISDataset[i]; } //--- return(true); } //+------------------------------------------------------------------+

Vergleichen wir drei gängige Klassifizierungsmethoden: SVC (Support Vector Classification), LinearSVC (Linear Support Vector Classification), und NuSVC (Nu Support Vector Classification).

Funktionsprinzipien:

SVC (Support Vector Classification)

Arbeitsprinzip: SVC ist eine Klassifizierungsmethode, die auf der Maximierung der Spanne zwischen den Klassen basiert. Es wird eine optimale Trennungshyperfläche gesucht, die die Klassen maximal trennt und die Supportvektoren - Punkte, die der Hyperfläche am nächsten liegen - unterstützt.

Kernel-Funktionen: SVC kann verschiedene Kernel-Funktionen verwenden, z. B. lineare, radiale Basisfunktion (RBF), Polynom und andere. Die Kernel-Funktion bestimmt, wie die Daten transformiert werden, um die optimale Hyperebene zu finden.

LinearSVC (Linear Support Vector Classification)

Arbeitsprinzip: LinearSVC ist eine Variante von SVC, die auf lineare Klassifizierung spezialisiert ist. Es sucht nach einer optimalen linearen Trennhyperebene ohne Verwendung von Kernel-Funktionen. Das macht die Arbeit mit großen Datenmengen schneller und effizienter.

NuSVC (Nu Support Vector Classification)

Arbeitsprinzip: NuSVC basiert ebenfalls auf Support-Vector-Methoden, führt aber einen Parameter Nu (nu) ein, der die Komplexität des Modells und den Anteil der Support-Vektoren steuert. Der Nu-Wert liegt im Bereich von 0 bis 1 und bestimmt, wie viele der Daten für Stützvektoren und Fehler verwendet werden können.

Vorteile:

SVC

Leistungsstarker Algorithmus: SVC kann dank der Verwendung von Kernel-Funktionen komplexe Klassifizierungsaufgaben bewältigen und mit nichtlinearen Daten arbeiten.

Robustheit gegenüber Ausreißern: SVC ist robust gegenüber Datenausreißern, da es Unterstützungsvektoren verwendet, um die trennende Hyperebene zu erstellen.

LinearSVC

Hoher Wirkungsgrad: LinearSVC ist schneller und effizienter im Umgang mit großen Datensätzen, vor allem wenn die Daten groß sind und die lineare Trennung für die Aufgabe geeignet ist.

Lineare Klassifizierung: Wenn das Problem gut linear trennbar ist, kann LinearSVC gute Ergebnisse liefern, ohne dass komplexe Kernel-Funktionen erforderlich sind.

NuSVC

Kontrolle der Modellkomplexität: Mit dem Nu-Parameter in NuSVC können Sie die Komplexität des Modells und den Kompromiss zwischen Anpassung an die Daten und Verallgemeinerung steuern.

Robustheit gegenüber Ausreißern: Ähnlich wie SVC ist NuSVC robust gegenüber Ausreißern, wodurch es sich für Aufgaben mit verrauschten Daten eignet.

Einschränkungen:

SVC

Berechnungskomplexität: SVC kann bei großen Datensätzen und/oder bei Verwendung komplexer Kernel-Funktionen langsam sein.

Kernel-Empfindlichkeit: Die Wahl der richtigen Kernel-Funktion kann eine schwierige Aufgabe sein und die Modellleistung erheblich beeinflussen.

LinearSVC

Linearitätsbeschränkung: LinearSVC ist durch eine lineare Datentrennung eingeschränkt und kann in Fällen mit nichtlinearen Abhängigkeiten zwischen Merkmalen und der Zielvariablen schlecht abschneiden.

NuSVC

Nu-Parameter-Abstimmung: Die Abstimmung des Parameters Nu kann einige Zeit und Experimente erfordern, um optimale Ergebnisse zu erzielen.

Je nach den Merkmalen der Aufgabe und dem Datenvolumen kann jede dieser Methoden die beste Wahl sein. Es ist wichtig, Experimente durchzuführen und die Methode auszuwählen, die am besten zu den spezifischen Anforderungen der Klassifizierungsaufgabe passt.

2.1. SVC Classifier

Die Klassifizierungsmethode Support Vector Classification (SVC) ist ein leistungsfähiger Algorithmus für maschinelles Lernen, der häufig zur Lösung von Klassifizierungsaufgaben eingesetzt wird.

Funktionsprinzipien:

- Optimale Trennungshyperebene

Arbeitsprinzip: Die Hauptidee hinter SVC ist es, die optimale trennende Hyperebene im Merkmalsraum zu finden. Diese Hyperebene sollte die Trennung zwischen Objekten verschiedener Klassen und Unterstützungsvektoren maximieren, d. h. Datenpunkte, die der Hyperebene am nächsten liegen.

Maximierung der Gewinnspanne: SVC zielt darauf ab, die Spanne zwischen den Klassen zu maximieren, d. h. den Abstand der Support-Vektoren zur Hyperebene. Dadurch ist die Methode robust gegenüber Ausreißern und lässt sich gut auf neue Daten verallgemeinern. - Nutzung von Kernel-Funktionen

Kernel-Funktionen: SVC kann verschiedene Kernel-Funktionen verwenden, z. B. lineare, radiale Basisfunktion (RBF), Polynom und andere. Die Kernel-Funktion ermöglicht es, Daten in einen höherdimensionalen Raum zu projizieren, in dem die Aufgabe linear wird, auch wenn es im ursprünglichen Datenraum keine lineare Trennbarkeit gibt.

Kernel-Auswahl: Die Wahl der richtigen Kernel-Funktion kann die Leistung des SVC-Modells erheblich beeinflussen. Eine lineare Hyperebene ist nicht immer die optimale Lösung.

Vorteile:

- Leistungsstarker Algorithmus. Bewältigung komplexer Aufgaben: SVC kann komplexe Klassifizierungsaufgaben lösen, einschließlich solcher mit nicht-linearen Abhängigkeiten zwischen Merkmalen und der Zielvariablen.

- Robustheit gegenüber Ausreißern: Die Verwendung von Stützvektoren macht die Methode robust gegenüber Datenausreißern. Sie hängt von Stützvektoren und nicht vom gesamten Datensatz ab.

- Kernel-Flexibilität. Anpassungsfähigkeit an Daten: Die Möglichkeit, verschiedene Kernel-Funktionen zu verwenden, erlaubt es SVC, sich an spezifische Daten anzupassen und nicht-lineare Beziehungen zu entdecken.

- Gute Verallgemeinerung. Verallgemeinerung auf neue Daten: Das SVC-Modell kann gut auf neue Daten verallgemeinert werden, was es für Vorhersageaufgaben nützlich macht.

Einschränkungen:

- Berechnungskomplexität: Trainingszeit: SVC kann langsam trainiert werden, insbesondere bei großen Datenmengen oder komplexen Kernel-Funktionen.

- Kernel-Auswahl. Die Wahl der richtigen Kernel-Funktion: Die Auswahl der richtigen Kernel-Funktion erfordert möglicherweise Experimente und hängt von den Datenmerkmalen ab.

- Empfindlichkeit gegenüber Merkmalsskalierung. Normalisierung der Daten: SVC reagiert empfindlich auf die Skalierung von Merkmalen, daher wird empfohlen, die Daten vor dem Training zu normalisieren oder zu standardisieren.

- Interpretierbarkeit des Modells. Komplexität der Interpretation: SVC-Modelle können aufgrund der Verwendung nichtlinearer Kernel und einer Vielzahl von Support-Vektoren komplex zu interpretieren sein.

Je nach Aufgabenstellung und Datenmenge kann die SVC-Methode ein leistungsfähiges Werkzeug zur Lösung von Klassifikationsaufgaben sein. Es ist jedoch wichtig, seine Grenzen zu beachten und die Parameter so einzustellen, dass optimale Ergebnisse erzielt werden.

2.1.1. Code zur Erstellung des Klassifizierungsmodells von SVC

Dieser Code demonstriert den Prozess des Trainings eines SVC-Klassifizierungsmodells mit dem Iris-Datensatz, den Export in das ONNX-Format und die Durchführung der Klassifizierung mit dem ONNX-Modell. Außerdem wird die Genauigkeit sowohl des ursprünglichen Modells als auch des ONNX-Modells bewertet.

# Iris_SVCClassifier.py # The code demonstrates the process of training SVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import SVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create an SVC Classifier model with a linear kernel svc_model = SVC(kernel='linear', C=1.0) # train the model on the entire dataset svc_model.fit(X, y) # predict classes for the entire dataset y_pred = svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of SVC Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path +"svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of SVC Classifier model in ONNX format:", accuracy_onnx)

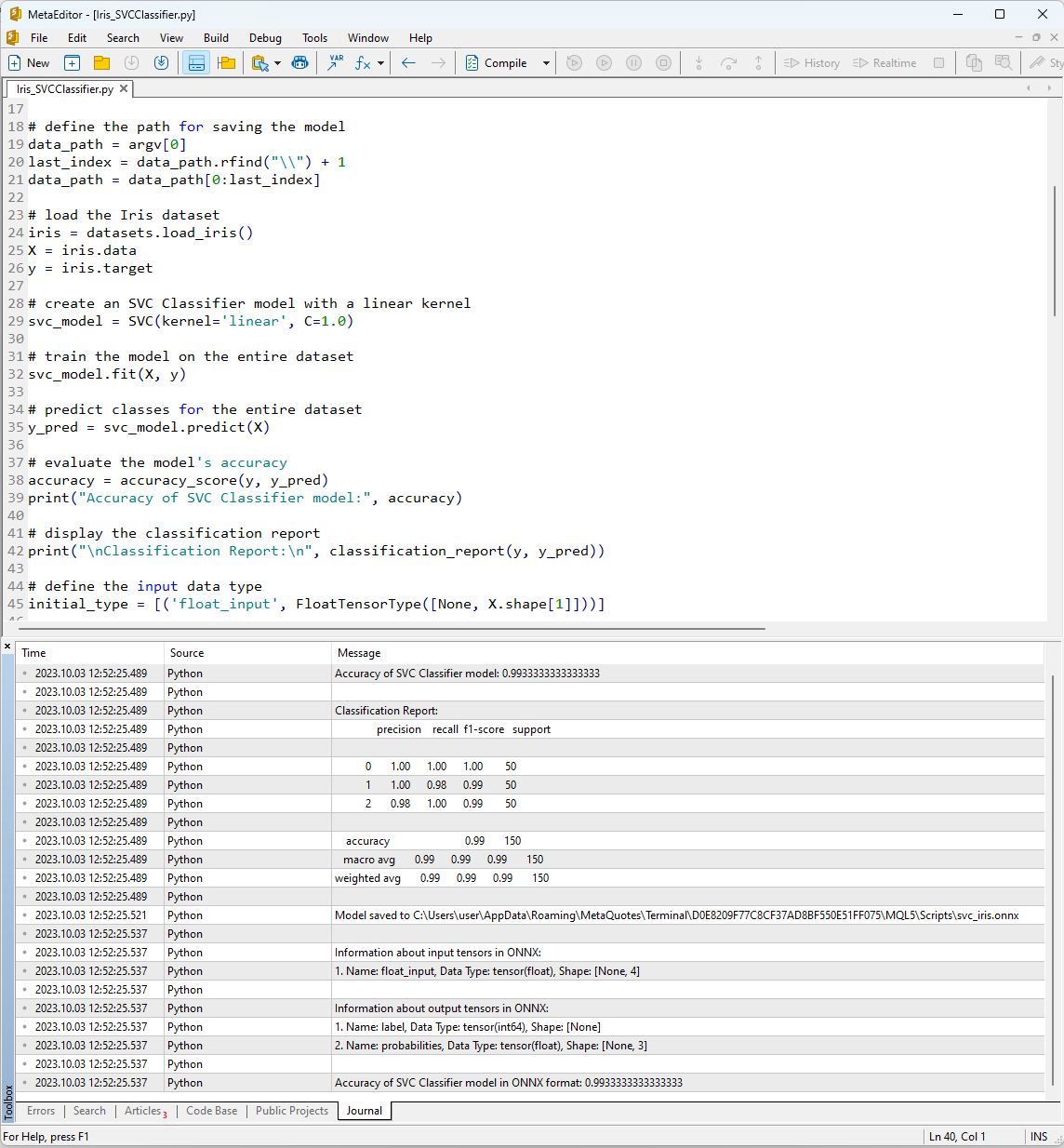

Nachdem Sie das Skript in MetaEditor mit Hilfe der Schaltfläche „Kompilieren“ ausgeführt haben, können Sie die Ergebnisse der Ausführung auf der Registerkarte „Journal“ einsehen.

Abbildung 12. Ergebnisse des Skripts Iris_SVMClassifier.py in MetaEditor

Ausgabe des Skripts Iris_SVCClassifier.py:

Python Accuracy of SVC Classifier model: 0.9933333333333333

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 1.00 0.98 0.99 50

Python 2 0.98 1.00 0.99 50

Python

Python accuracy 0.99 150

Python macro avg 0.99 0.99 0.99 150

Python weighted avg 0.99 0.99 0.99 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of SVC Classifier model in ONNX format: 0.9933333333333333

Hier finden Sie Informationen über den Pfad, in dem das ONNX-Modell gespeichert wurde, die Arten der Eingabe- und Ausgabeparameter des ONNX-Modells sowie die Genauigkeit bei der Beschreibung des Iris-Datensatzes.

Die Genauigkeit der Beschreibung des Datensatzes mit dem SVM-Klassifikator liegt bei 99 %, und das in das ONNX-Format exportierte Modell weist die gleiche Genauigkeit auf.

Nun werden wir diese Ergebnisse in MQL5 verifizieren, indem wir das konstruierte Modell für jede der 150 Datenproben ausführen. Außerdem enthält das Skript ein Beispiel für die Stapelverarbeitung von Daten.

2.1.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell SVC

//+------------------------------------------------------------------+ //| Iris_SVCClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="SVCClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Die Ergebnisse der Ausführung des Skripts werden auf der Registerkarte „Experten“ des MetaTrader 5-Terminals angezeigt.

Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier correct results: 99.33% Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier all samples accuracy=0.993333 Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier batch test accuracy=1.000000

Das SVC-Modell hat 149 von 150 Proben richtig klassifiziert, was ein ausgezeichnetes Ergebnis ist. Das Modell machte nur einen Klassifizierungsfehler im Iris-Datensatz, indem es für die Probe Nr. 84 die Klasse 2 (versicolor) statt der Klasse 1 (virginica) vorhersagte.

Es ist erwähnenswert, dass die Genauigkeit des exportierten ONNX-Modells auf dem vollständigen Iris-Datensatz 99,33 % beträgt, was der Genauigkeit des Originalmodells entspricht.

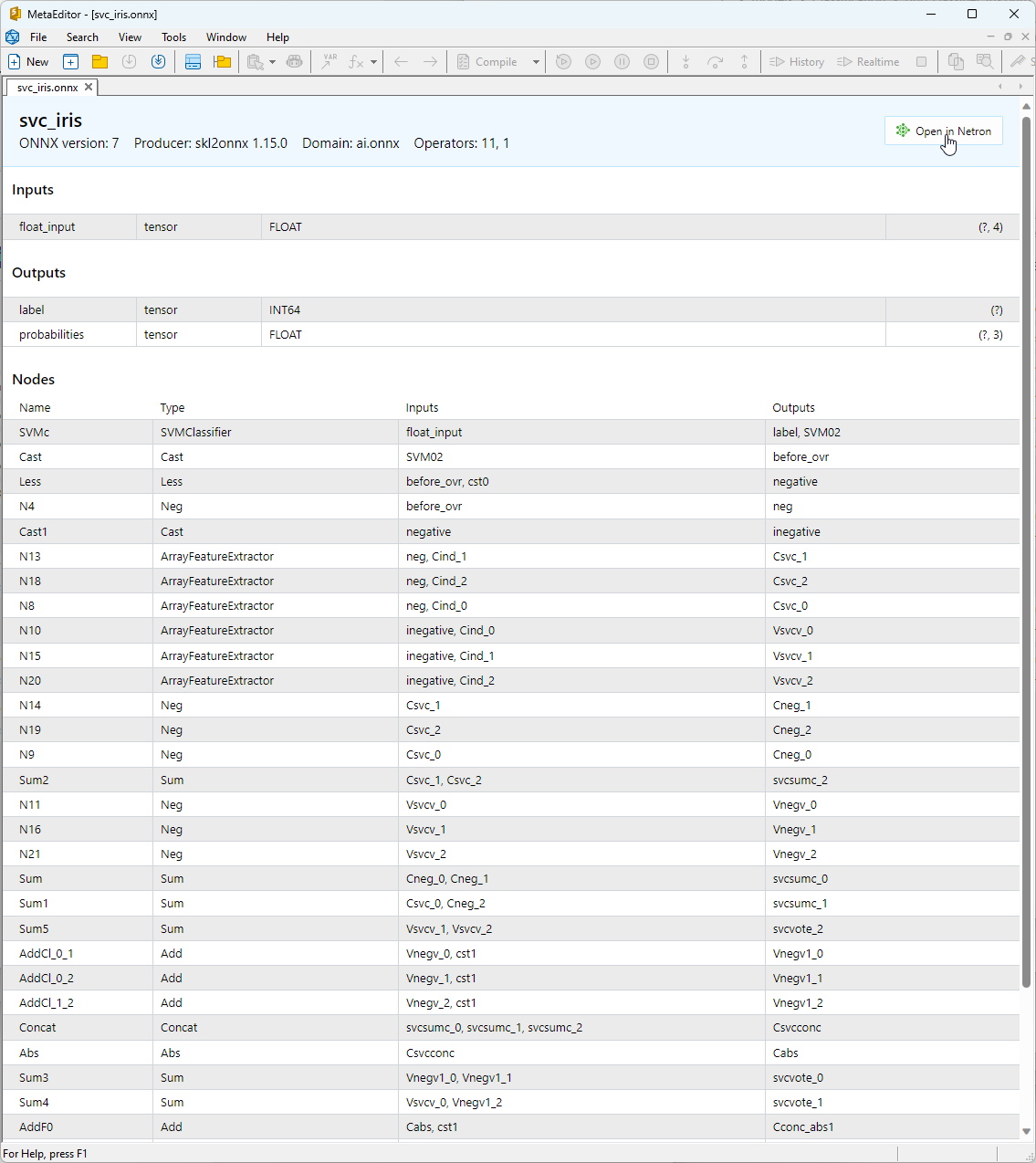

2.1.3. ONNX-Darstellung des Klassifizierungsmodells SVC

Sie können das erstellte ONNX-Modell in MetaEditor anzeigen.

Abbildung 13. ONNX-Modell svc_iris.onnx in MetaEditor

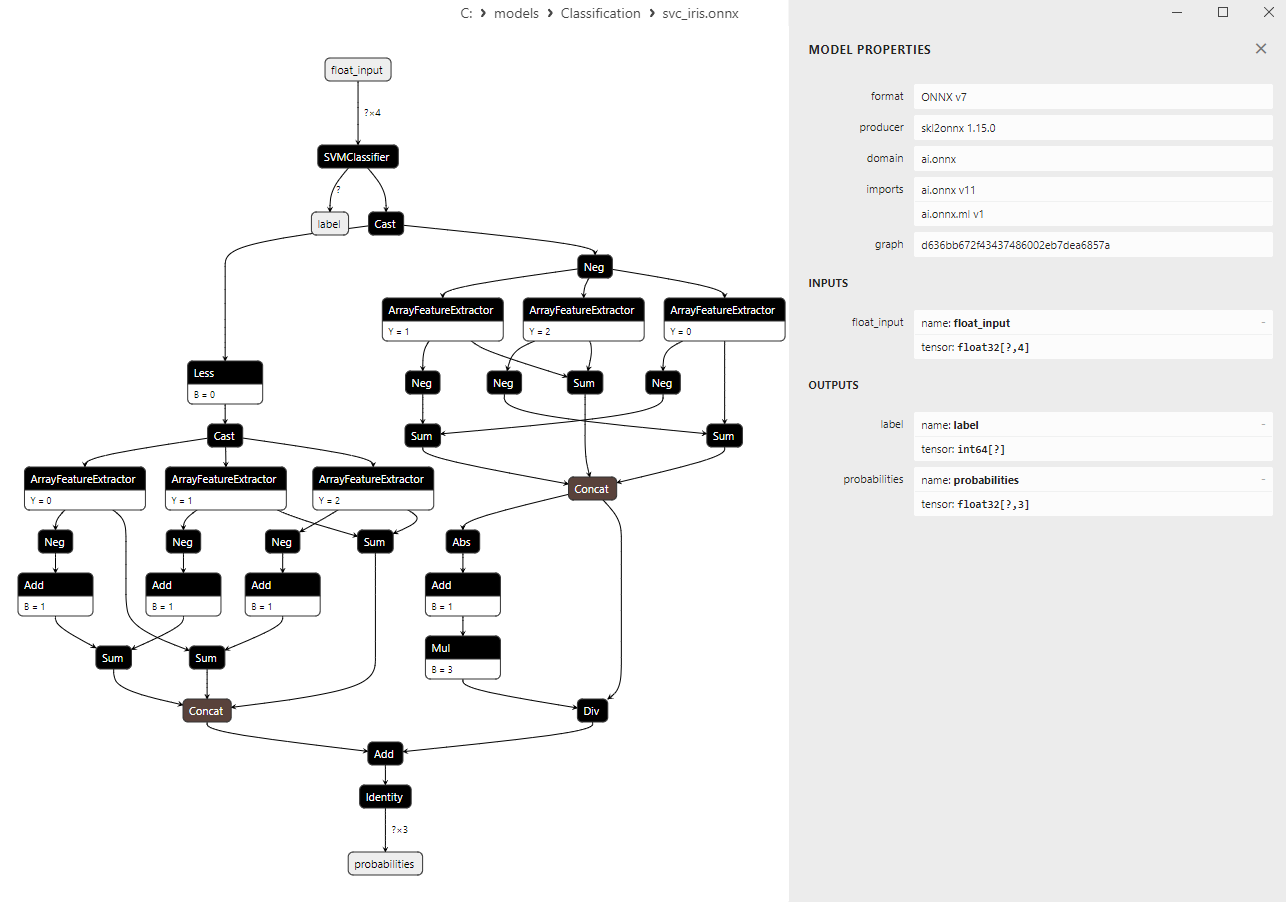

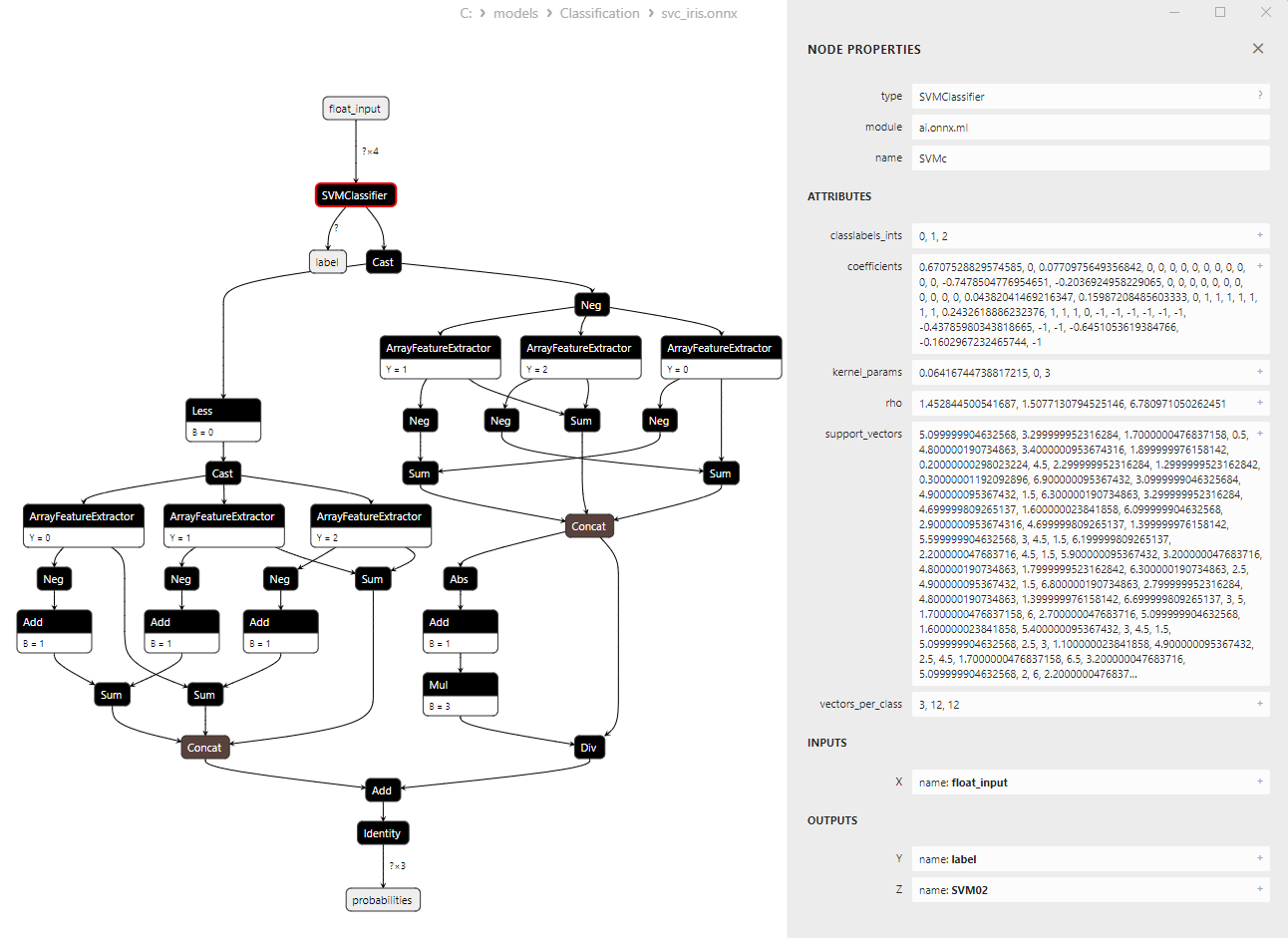

Detailliertere Informationen über die Architektur des Modells erhalten Sie mit Netron. Klicken Sie dazu in der Beschreibung des Modells im MetaEditor auf die Schaltfläche „Open in Netron“.

Abbildung 14. ONNX-Modell svc_iris.onnx in Netron

Abbildung 15. ONNX-Modell svc_iris.onnx in Netron (SVMClassifier ONNX-Operator-Parameter)

2.2. LinearSVC Classifier

LinearSVC (Linear Support Vector Classification) ist ein leistungsfähiger Algorithmus für maschinelles Lernen, der für binäre und Multiklassen-Klassifizierungsaufgaben verwendet wird. Es basiert auf der Idee, eine Hyperebene zu finden, die die Daten am besten trennt.

Grundsätze der LinearSVC:

- Suche nach der optimalen Hyperebene: Die Hauptidee von LinearSVC ist es, die optimale Hyperebene zu finden, die die beiden Datenklassen maximal trennt. Eine Hyperebene ist eine mehrdimensionale Ebene, die durch eine lineare Gleichung definiert ist.

- Einrückungen minimieren: LinearSVC zielt darauf ab, die Einrückungen (Abstände von Datenpunkten zur Hyperebene) zu minimieren. Je größer die Einrückungen sind, desto zuverlässiger trennt die Hyperebene die Klassen.

- Handhabung linear nicht trennbarer Daten: LinearSVC kann mit Daten arbeiten, die im ursprünglichen Merkmalsraum nicht linear getrennt werden können, dank der Verwendung von Kernel-Funktionen (Kernel-Trick), die die Daten in einen höherdimensionalen Raum projizieren, wo sie linear getrennt werden können.

Vorteile von LinearSVC:

- Gute Verallgemeinerung: LinearSVC hat eine gute Verallgemeinerungsfähigkeit und kann bei neuen, ungesehenen Daten gute Ergebnisse erzielen.

- Effizienz: LinearSVC arbeitet schnell mit großen Datensätzen und benötigt relativ wenig Rechenressourcen.

- Handhabung linear nicht trennbarer Daten: Mit Hilfe von Kernel-Funktionen kann LinearSVC Klassifizierungsaufgaben mit linear nicht trennbaren Daten lösen.

- Skalierbarkeit: LinearSVC kann bei Aufgaben mit einer großen Anzahl von Merkmalen und großen Datenmengen effizient eingesetzt werden.

Einschränkungen von LinearSVC:

- Nur linear trennende Hyperebenen: LinearSVC konstruiert nur lineare Trennebenen, was für komplexe Klassifikationsaufgaben mit nichtlinearen Abhängigkeiten unzureichend sein kann.

- Auswahl der Parameter: Die Wahl der richtigen Parameter (z. B. der Regularisierungsparameter) kann Expertenwissen oder eine Kreuzvalidierung erfordern.

- Empfindlichkeit gegenüber Ausreißern: LinearSVC kann empfindlich auf Ausreißer in den Daten reagieren, was die Klassifizierungsqualität beeinträchtigen kann.

- Interpretierbarkeit des Modells: Mit LinearSVC erstellte Modelle könnten im Vergleich zu einigen anderen Methoden weniger gut zu interpretieren sein.

LinearSVC ist ein leistungsstarker Klassifizierungsalgorithmus, der sich durch Verallgemeinerung, Effizienz und den Umgang mit linear nicht trennbaren Daten auszeichnet. Sie findet Anwendung bei verschiedenen Klassifizierungsaufgaben, insbesondere wenn Daten durch eine lineare Hyperebene getrennt werden können. Für komplexe Aufgaben, die die Modellierung nichtlinearer Abhängigkeiten erfordern, kann LinearSVC jedoch weniger geeignet sein, und in solchen Fällen sollten alternative Methoden mit komplexeren Entscheidungsgrenzen in Betracht gezogen werden.

2.2.1. Code für die Erstellung des Klassifizierungsmodells LinearSVC

Dieser Code veranschaulicht den Prozess des Trainings eines LinearSVC-Klassifizierungsmodells mit dem Iris-Datensatz, den Export in das ONNX-Format und die Durchführung der Klassifizierung mit dem ONNX-Modell. Außerdem wird die Genauigkeit sowohl des ursprünglichen Modells als auch des ONNX-Modells bewertet.

# Iris_LinearSVC.py # The code demonstrates the process of training LinearSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import LinearSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a LinearSVC model linear_svc_model = LinearSVC(C=1.0, max_iter=10000) # train the model on the entire dataset linear_svc_model.fit(X, y) # predict classes for the entire dataset y_pred = linear_svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of LinearSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(linear_svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "linear_svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of LinearSVC model in ONNX format:", accuracy_onnx)

Ausgabe:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.94 0.95 50

Python 2 0.94 0.96 0.95 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\linear_svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of LinearSVC model in ONNX format: 0.9666666666666667

2.2.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell LinearSVC

//+------------------------------------------------------------------+ //| Iris_LinearSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "linear_svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="LinearSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Ausgabe:

Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=71 FAILED [class=2, true class=1] features=(5.90,3.20,4.80,1.80] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=85 FAILED [class=2, true class=1] features=(5.40,3.00,4.50,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=130 FAILED [class=1, true class=2] features=(7.20,3.00,5.80,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=134 FAILED [class=1, true class=2] features=(6.30,2.80,5.10,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC correct results: 96.67% Iris_LinearSVC (EURUSD,H1) model=LinearSVC all samples accuracy=0.966667 Iris_LinearSVC (EURUSD,H1) model=LinearSVC batch test accuracy=1.000000

Die Genauigkeit des exportierten ONNX-Modells auf dem vollständigen Iris-Datensatz beträgt 96,67 %, was der Genauigkeit des Originalmodells entspricht.

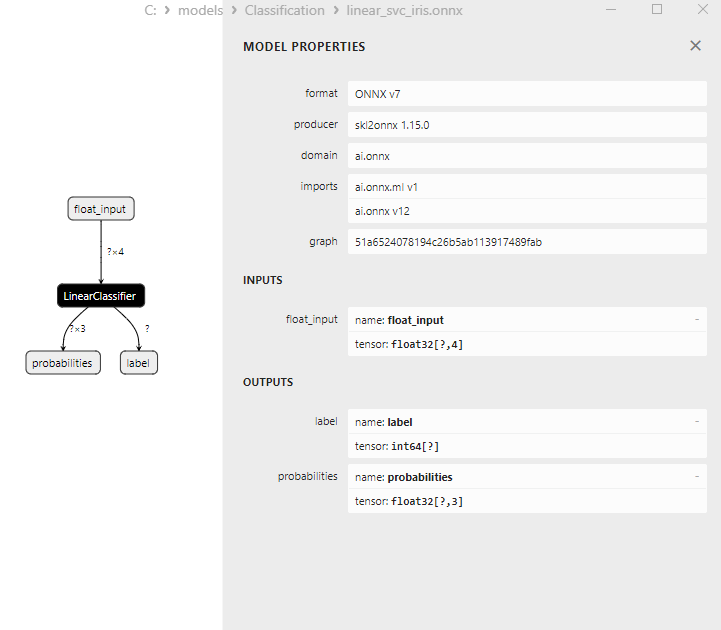

2.2.3. ONNX-Darstellung des Klassifizierungsmodells LinearSVC

Abbildung 16. ONNX-Darstellung des Klassifizierungsmodells LinearSVC in Netron

2.3. NuSVC Classifier

Die Nu-Support Vector Classification (NuSVC)-Methode ist ein leistungsstarker Algorithmus für maschinelles Lernen, der auf dem Ansatz der Support Vector Machine (SVM) basiert.

Grundsätze der NuSVC:

- Support-Vektor-Maschine (SVM): NuSVC ist eine Variante der SVM, die für binäre und Mehrklassen-Klassifikationsaufgaben verwendet wird. Das Grundprinzip der SVM besteht darin, die optimale Trennhyperebene zu finden, die die Klassen maximal trennt und gleichzeitig den maximalen Spielraum beibehält.

- Der Nu-Parameter: Ein Schlüsselparameter in NuSVC ist der Nu-Parameter (nu), der die Komplexität des Modells steuert und den Anteil der Stichprobe definiert, der als Stützvektoren und Fehler verwendet werden kann. Der Wert von Nu reicht von 0 bis 1, wobei 0,5 bedeutet, dass etwa die Hälfte der Stichprobe als Stützvektoren und Fehler verwendet wird.

- Abstimmung der Parameter: Die Bestimmung der optimalen Werte für den Nu-Parameter und andere Hyperparameter kann eine Kreuzvalidierung und eine Suche nach den besten Werten in den Trainingsdaten erfordern.

- Kernel-Funktionen: NuSVC kann verschiedene Kernel-Funktionen verwenden, z. B. lineare, radiale Basisfunktion (RBF), Polynom und andere. Die Kernel-Funktion bestimmt, wie der Merkmalsraum transformiert wird, um die trennende Hyperebene zu finden.

Vorteile von NuSVC:

- Effizienz in hochdimensionalen Räumen: NuSVC kann effizient in hochdimensionalen Räumen arbeiten und eignet sich daher für Aufgaben mit einer großen Anzahl von Merkmalen.

- Robustheit gegenüber Ausreißern: SVM und insbesondere NuSVC sind aufgrund der Verwendung von Support-Vektoren robust gegenüber Ausreißern in den Daten.

- Kontrolle der Modellkomplexität: Der Nu-Parameter ermöglicht es, die Modellkomplexität zu steuern und ein Gleichgewicht zwischen Datenanpassung und Verallgemeinerung herzustellen.

- Gute Verallgemeinerung: Insbesondere SVM und NuSVC weisen eine gute Generalisierung auf, was zu einer ausgezeichneten Leistung bei neuen, zuvor ungesehenen Daten führt.

Einschränkungen von NuSVC:

- Ineffizienz bei großen Datenvolumina: NuSVC kann aufgrund der Rechenkomplexität ineffizient sein, wenn es auf großen Datenmengen trainiert wird.

- Parameterabstimmung erforderlich: Die Abstimmung der Nu-Parameter und der Kernel-Funktion kann Zeit und Rechenressourcen erfordern.

- Linearität der Kernel-Funktion: Die Effektivität von NuSVC kann in erheblichem Maße von der Wahl der Kernel-Funktion abhängen, und für einige Aufgaben kann es notwendig sein, mit verschiedenen Funktionen zu experimentieren.

- Interpretierbarkeit des Modells: SVM und NuSVC liefern hervorragende Ergebnisse, aber ihre Modelle können komplex zu interpretieren sein, insbesondere wenn nichtlineare Kernel verwendet werden.

Nu-Support Vector Classification (NuSVC) ist eine leistungsstarke Klassifizierungsmethode auf der Grundlage von SVM mit mehreren Vorteilen, darunter Robustheit gegenüber Ausreißern und gute Generalisierung. Ihre Effektivität hängt jedoch von der Wahl der Parameter und Kernel-Funktionen ab, und sie kann bei großen Datenmengen ineffizient sein. Es ist wichtig, die Parameter sorgfältig auszuwählen und die Methode an spezifische Klassifizierungsaufgaben anzupassen.

2.3.1. Code zur Erstellung des Klassifizierungsmodells von NuSVC

Dieser Code demonstriert den Prozess des Trainings eines NuSVC-Klassifizierungsmodells mit dem Iris-Datensatz, den Export in das ONNX-Format und die Durchführung der Klassifizierung mit dem ONNX-Modell. Außerdem wird die Genauigkeit sowohl des ursprünglichen Modells als auch des ONNX-Modells bewertet.

# Iris_NuSVC.py # The code demonstrates the process of training NuSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import NuSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a NuSVC model nusvc_model = NuSVC(nu=0.5, kernel='linear') # train the model on the entire dataset nusvc_model.fit(X, y) # predict classes for the entire dataset y_pred = nusvc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of NuSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(nusvc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "nusvc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of NuSVC model in ONNX format:", accuracy_onnx)

Ausgabe:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.96 0.96 50

Python 2 0.96 0.96 0.96 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\nusvc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of NuSVC model in ONNX format: 0.9733333333333334

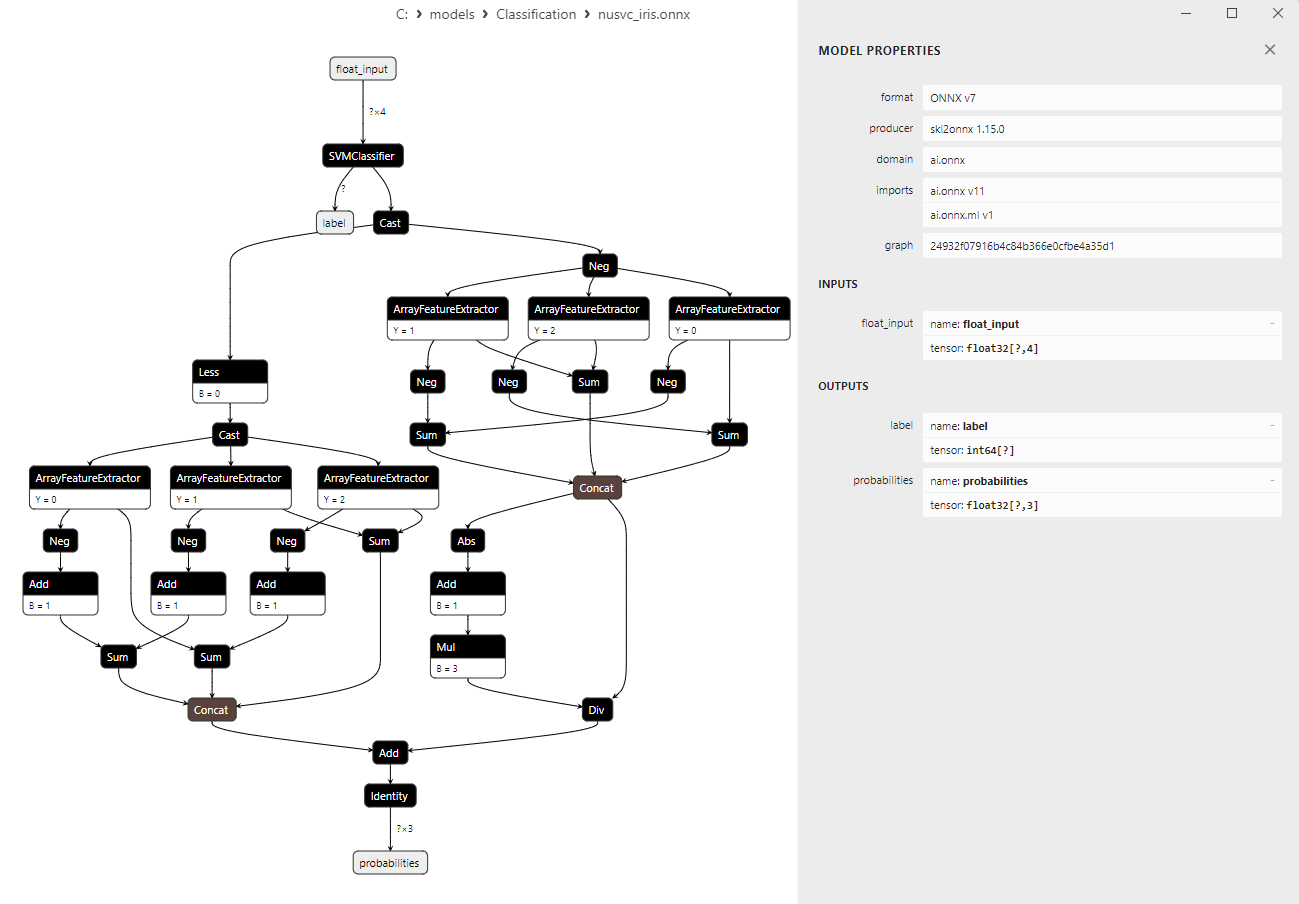

2.3.2. MQL5-Code für die Arbeit mit dem Klassifizierungsmodell NuSVC