Scikit-Learn 라이브러리의 분류 모델 및 ONNX로 내보내기

기술의 발달로 인해 데이터 처리 알고리즘을 구축하는 근본적으로 새로운 접근 방식이 등장했습니다. 이전에는 각각의 특정한 작업을 해결하기 위해 해당 알고리즘을 명확하게 공식화하고 개발해야 했습니다.

머신 러닝에서 컴퓨터는 컴퓨터 스스로 데이터를 처리하는 가장 좋은 방법을 찾는 방법을 학습합니다. 머신 러닝 모델은 분류 작업(고정된 클래스 집합이 있고 각 클래스에 속하는 주어진 피처 집합의 확률을 찾는 것을 목표로 하는 경우)과 회귀 작업(주어진 피처 집합을 기반으로 목표 변수의 수치 값을 추정하는 것을 목표로 하는 경우)을 성공적으로 해결할 수 있습니다. 이러한 기본 구성 요소를 기반으로 더 복잡한 데이터 처리 모델을 구축할 수 있습니다.

Scikit-learn 라이브러리는 분류와 회귀를 위한 다양한 도구를 제공합니다. 특정 메서드와 모델의 선택은 데이터의 특성에 따라 달라지는데 이는 메서드마다 효과가 다르고 각 메서드는 작업에 따라 다른 결과를 가져올 수 있기 때문입니다.

보도 자료 "ONNX 런타임은 이제 오픈 소스입니다"에 따르면 ONNX 런타임은 ONNX-ML 프로필도 지원한다고 합니다:

ONNX-ML 프로필은 머신 러닝(ML) 모델을 위해 특별히 설계된 ONNX의 일부입니다. ONNX-ML은 분류, 회귀, 클러스터링 등 다양한 유형의 머신 러닝 모델을 편리한 형식으로 기술하고 표현하기 위한 것으로 ONNX를 지원하는 다양한 플랫폼과 환경에서 사용할 수 있습니다. ONNX-ML 프로필은 머신 러닝 모델의 전송, 배포 및 실행을 간소화하고 접근성과 휴대성을 높입니다.

이 글에서는 피셔의 붓꽃 분류 과제를 해결하기 위해 Scikit-learn 패키지의 모든 분류 모델을 적용하는 방법에 대해 살펴볼 것입니다. 우리는 이러한 모델을 ONNX 형식으로 변환하고 결과 모델을 MQL5 프로그램에서 사용해 볼 것입니다.

또한 전체 붓꽃 데이터 세트에서 원래 모델의 정확도를 ONNX 버전과 비교할 것입니다.

목차

- 1. 피셔의 붓꽃

- 2. 분류용 모델

Scikit-learn 분류기 목록

모델의 다양한 출력 표현 iris.mqh - 2.1. SVC 분류기

2.1.1. SVC 분류기 모델 생성 코드

2.1.2. SVC 분류기 모델 작업을 위한 MQL5 코드

2.1.3. SVC 분류기 모델의 ONNX 표현 - 2.2. LinearSVC 분류기

2.2.1. LinearSVC 분류기 모델 생성 코드

2.2.2. LinearSVC 분류기 모델 작업을 위한 MQL5 코드

2.2.3. LinearSVC 분류기 모델의 ONNX 표현 - 2.3. NuSVC 분류기

2.3.1. NuSVC 분류기 모델 생성 코드

2.3.2. NuSVC 분류기 모델 작업을 위한 MQL5 코드

2.3.3. NuSVC 분류기 모델의 ONNX 표현 - 2.4. 반경 이웃 분류기

2.4.1. 반경 이웃 분류기 모델 생성 코드

2.4.2. 반경 이웃 분류기 모델 작업을 위한 MQL5 코드

2.3.3. 반경 이웃 분류기 모델의 ONNX 표현 - 2.5. 능선 분류기

2.5.1. 능선 분류기 모델 생성 코드

2.5.2. 능선 분류기 모델 작업을 위한 MQL5 코드

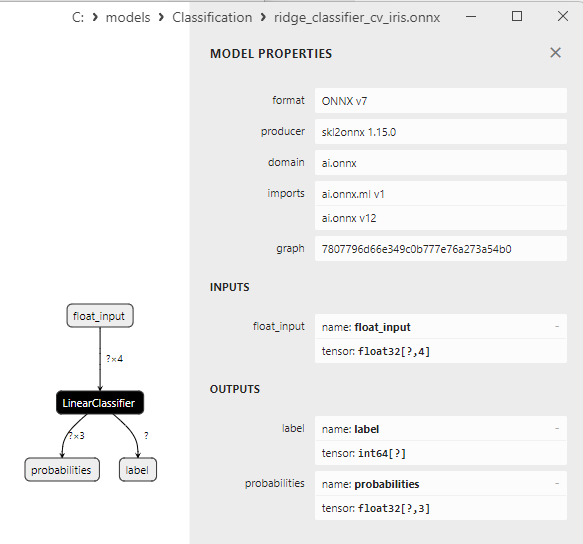

2.5.3. 능선 분류기 모델의 ONNX 표현 - 2.6. RidgeClassifierCV

2.6.1. 능선 분류기CV 모델 생성 코드

2.6.2. 능선 분류기CV 모델 작업을 위한 MQL5 코드

2.6.3. 능선 분류기CV 모델의 ONNX 표현 - 2.7. 랜덤 숲 분류기

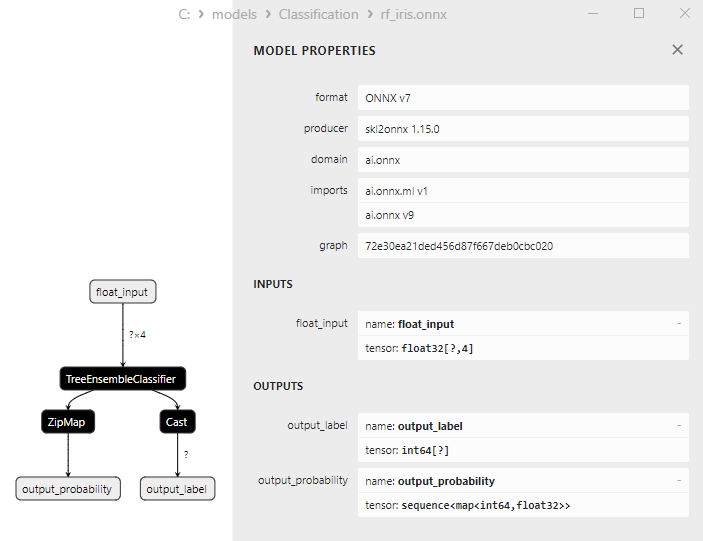

2.7.1. 랜덤 숲 분류기 모델 생성 코드

2.7.2. 랜덤 숲 분류기 모델 작업을 위한 MQL5 코드

2.7.3. 랜덤 숲 분류기 모델의 ONNX 표현 - 2.8. 경사 부스팅 분류기

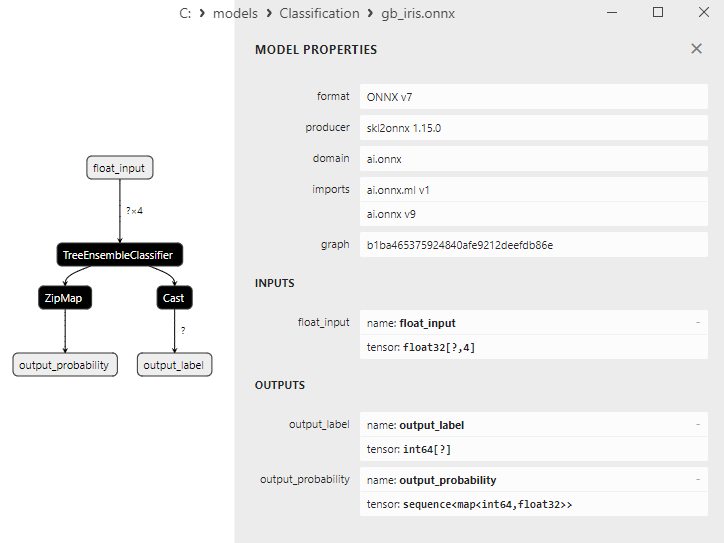

2.8.1. 경사 부스팅 분류기 모델 생성 코드

2.8.2. 경사 부스팅 분류기 모델 작업을 위한 MQL5 코드

2.8.3. 경사 부스팅 분류기 모델의 ONNX 표현 - 2.9. 적응형 부스팅 분류기

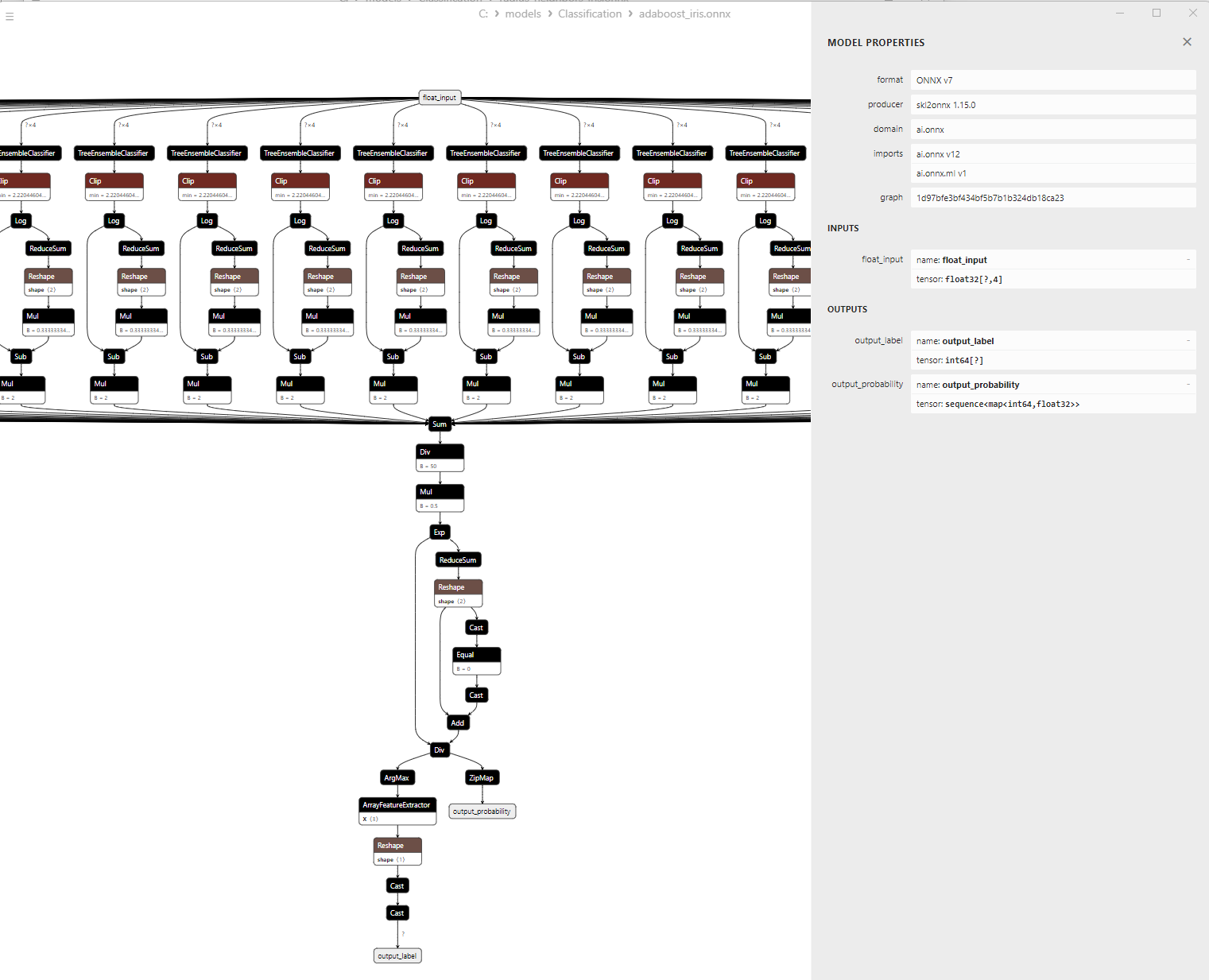

2.9.1. 적응형 부스팅 분류기 모델 생성 코드

2.9.2. 적응형 부스팅 분류기 모델 작업을 위한 MQL5 코드

2.9.3. 적응형 부스팅 분류기 모델의 ONNX 표현 - 2.10. 부트스트랩 집계 분류기

2.10.1. 부트스트랩 집계 분류기 모델 생성 코드

2.10.2. 부트스트랩 집계 분류기 모델 작업을 위한 MQL5 코드

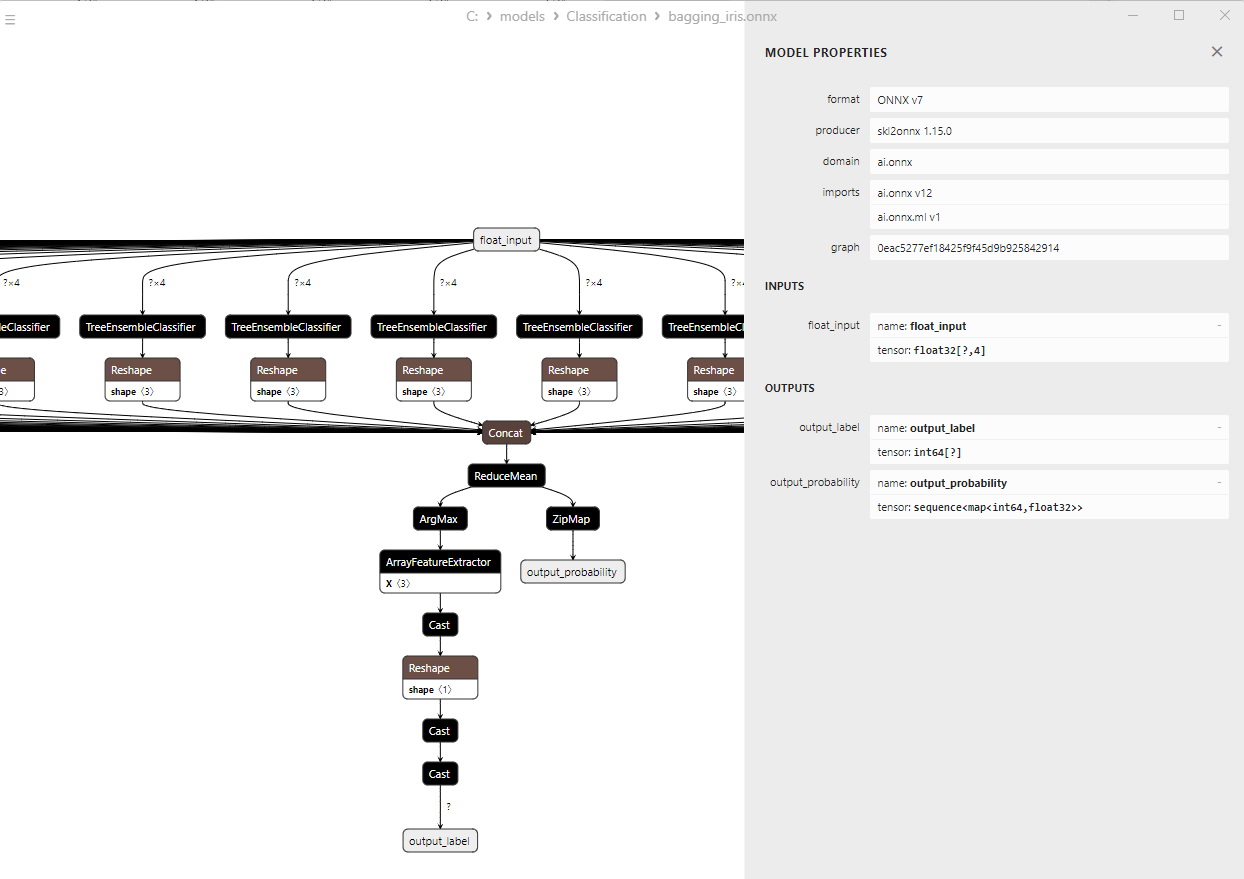

2.10.3. 부트스트랩 집계 분류기 모델의 ONNX 표현 - 2.11. K-가장 가까운 이웃(K-NN) 분류기

2.11.1. K-NN(가장 가까운 이웃) 분류기 모델 생성 코드

2.11.2. K-NN(가장 가까운 이웃) 분류기 모델 작업을 위한 MQL5 코드

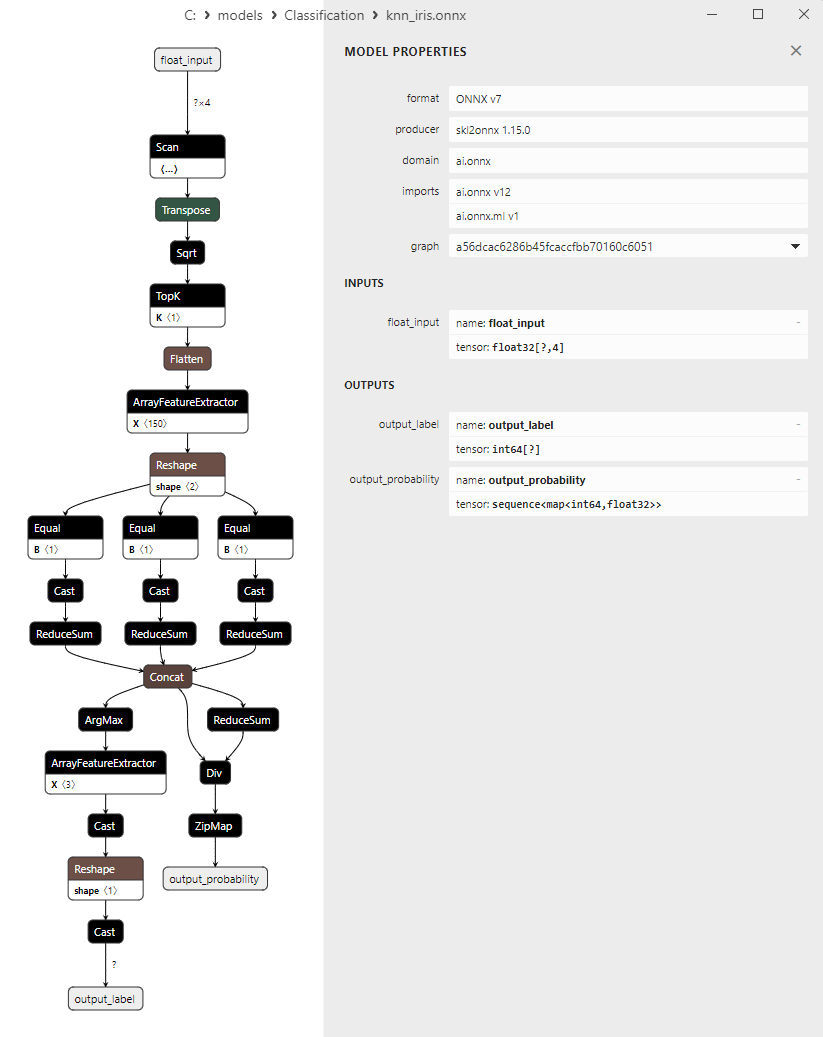

2.11.3. K-NN(가장 가까운 이웃) 분류기 모델에 대한 ONNX 표현 - 2.12. 의사 결정 트리 분류기

2.12.1. 의사 결정 트리 분류기 모델 생성 코드

2.12.2. 의사 결정 트리 분류기 모델 작업을 위한 MQL5 코드

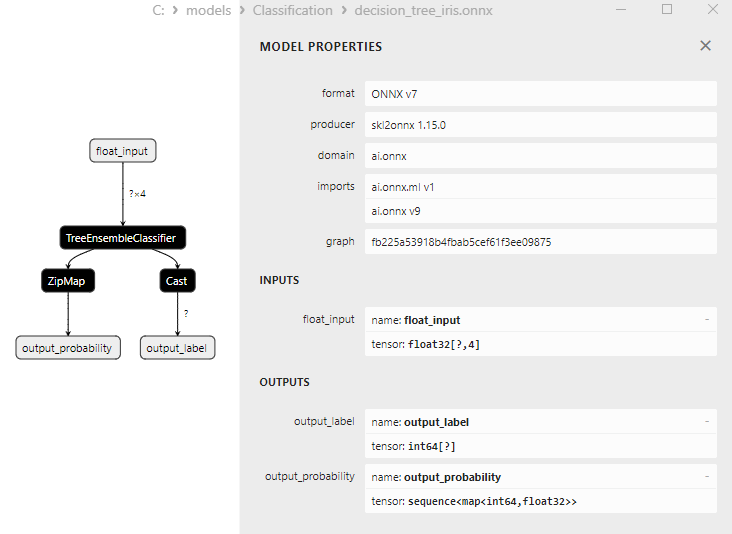

2.12.3. 의사 결정 트리 분류기 모델의 ONNX 표현 - 2.13. 로지스틱 회귀 분류기

2.13.1. 로지스틱 회귀 분류기 모델 생성 코드

2.13.2. 로지스틱 회귀 분류기 모델 작업을 위한 MQL5 코드

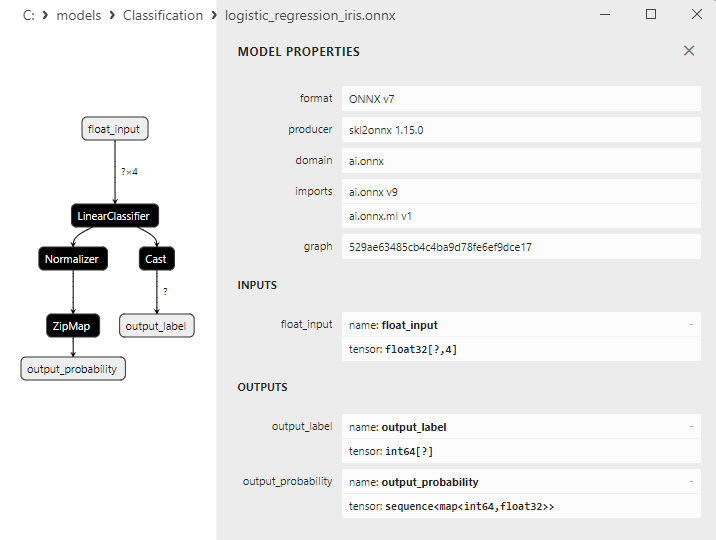

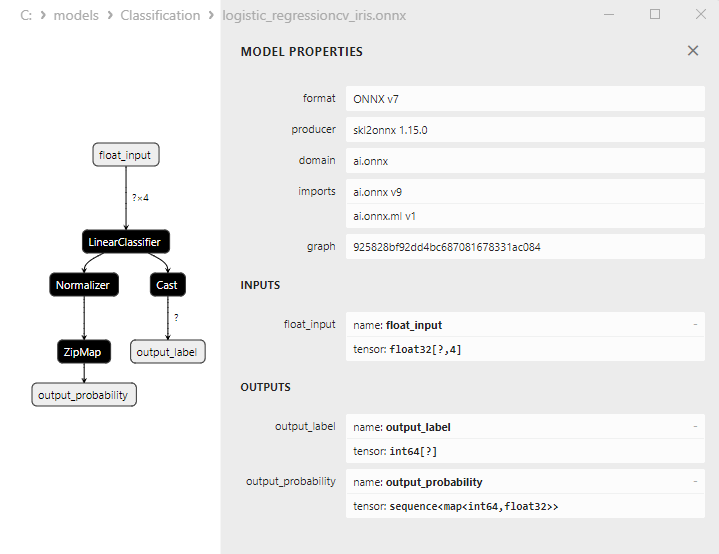

2.13.3. 로지스틱 회귀 분류기 모델의 ONNX 표현 - 2.14. LogisticRegressionCV 분류기

2.14.1. LogisticRegressionCV 분류기 모델 생성 코드

2.14.2. LogisticRegressionCV 분류기 모델 작업을 위한 MQL5 코드

2.14.3. LogisticRegressionCV 분류기 모델의 ONNX 표현 - 2.15. 패시브-어그레시브(PA) 분류기

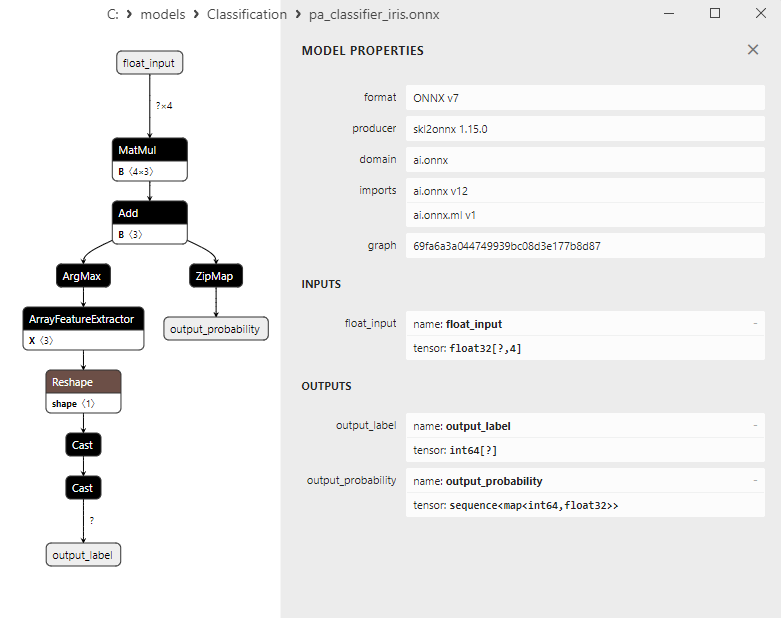

2.15.1. 패시브-어그레시브(PA) 분류기 모델 생성 코드

2.15.2. 패시브-어그레시브(PA) 분류기 모델 작업을 위한 MQL5 코드

2.15.3. 패시브-어그레시브(PA) 분류기 모델의 ONNX 표현 - 2.16. 퍼셉트론 분류기

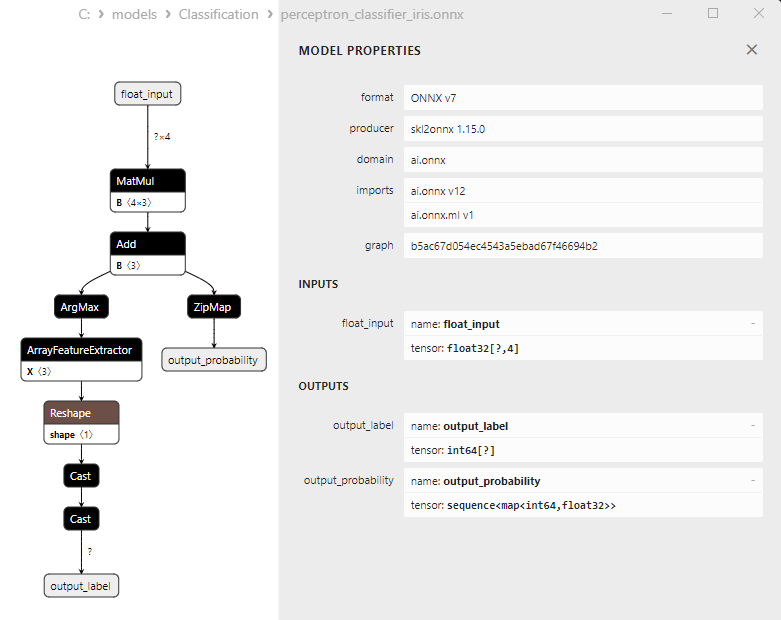

2.16.1. 퍼셉트론 분류기 모델 생성 코드

2.16.2. 퍼셉트론 분류기 모델 작업을 위한 MQL5 코드

2.16.3. 퍼셉트론 분류기 모델의 ONNX 표현 - 2.17. 스토캐스틱 경사 하강 분류기

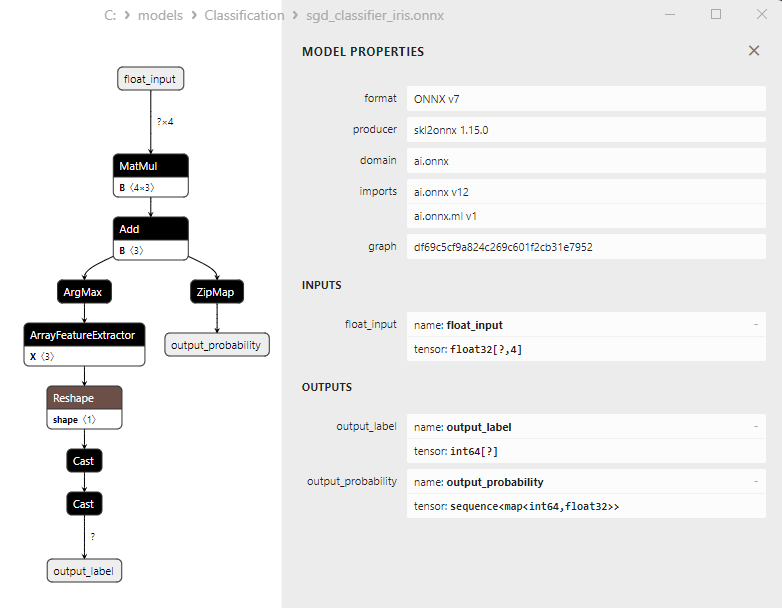

2.17.1. 스토캐스틱 경사 하강 분류기 모델 생성 코드

2.17.2. 스토캐스틱 경사 하강 분류기 모델 작업을 위한 MQL5 코드

2.17.3. 스토캐스틱 경사 하강 분류기 모델의 ONNX 표현 - 2.18. 가우시안 나이브 베이즈(GNB) 분류기

2.18.1. 가우시안 나이브 베이즈(GNB) 분류기 모델 생성 코드

2.18.2. 가우시안 나이브 베이즈(GNB) 분류기 모델 작업을 위한 MQL5 코드

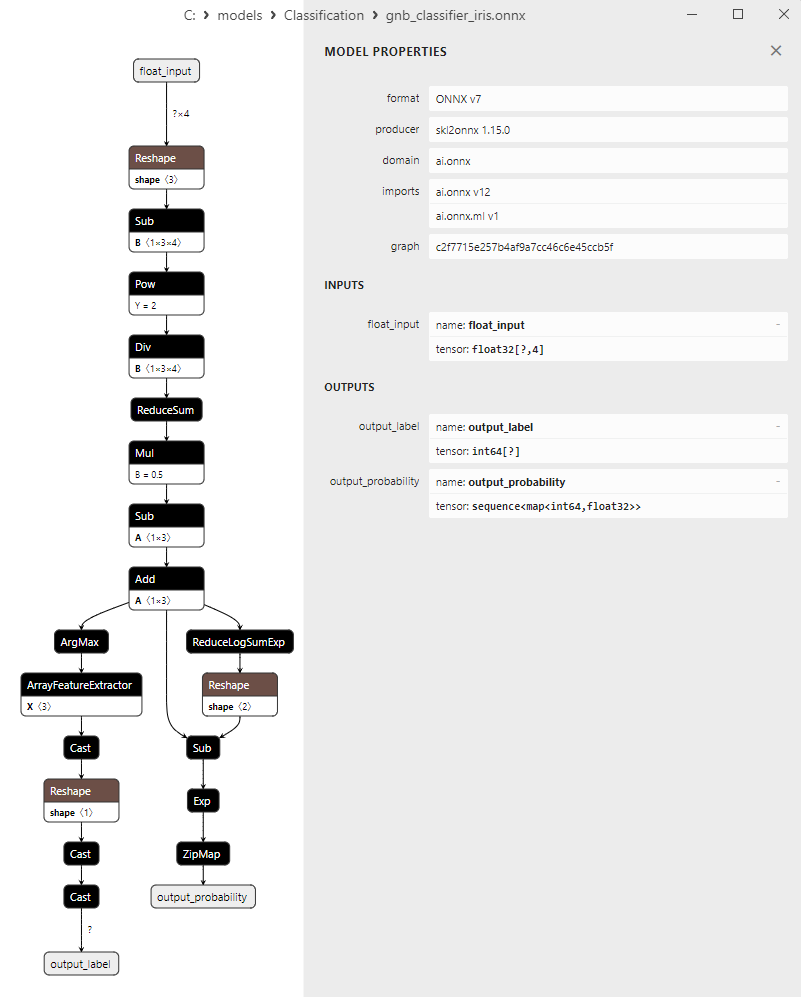

2.18.3. 가우시안 나이브 베이즈(GNB) 분류기 모델의 ONNX 표현 - 2.19. 다항식 나이브 베이즈(MNB) 분류기

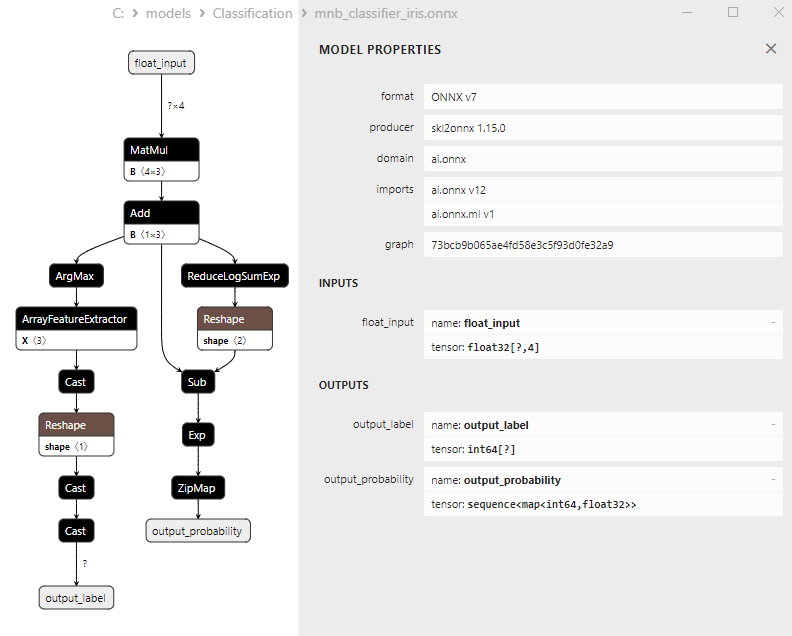

2.19.1. 다항식 나이브 베이즈(MNB) 분류기 모델 생성 코드

2.19.2. 다항식 나이브 베이즈(MNB) 분류기 모델 작업을 위한 MQL5 코드

2.19.3. 다항식 나이브 베이즈(MNB) 분류기 모델의 ONNX 표현 - 2.20. 보완 나이브 베이즈(CNB) 분류기

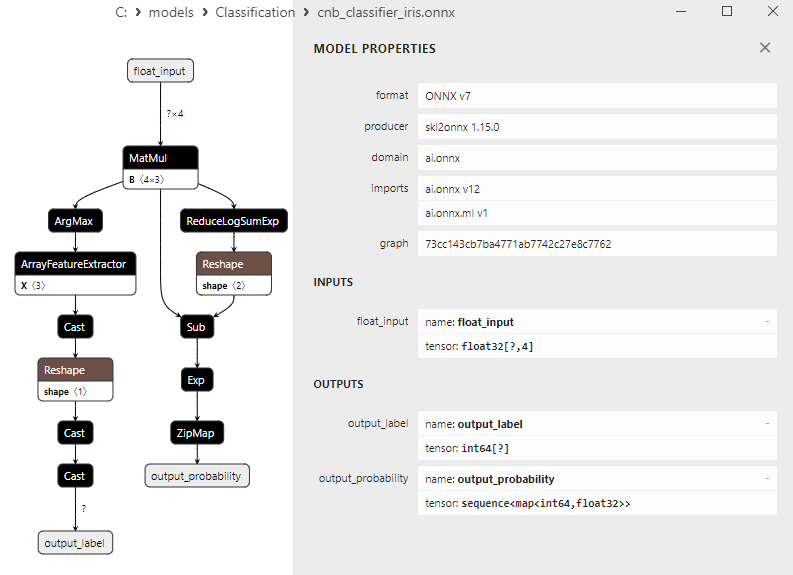

2.20.1. 보완 나이브 베이즈(CNB) 분류기 모델 생성 코드

2.20.2. 보완 나이브 베이즈(CNB) 분류기 모델 작업을 위한 MQL5 코드

2.20.3. 보완 나이브 베이즈(CNB) 분류기 모델의 ONNX 표현 - 2.21. 베르누이 나이브 베이즈(BNB) 분류기

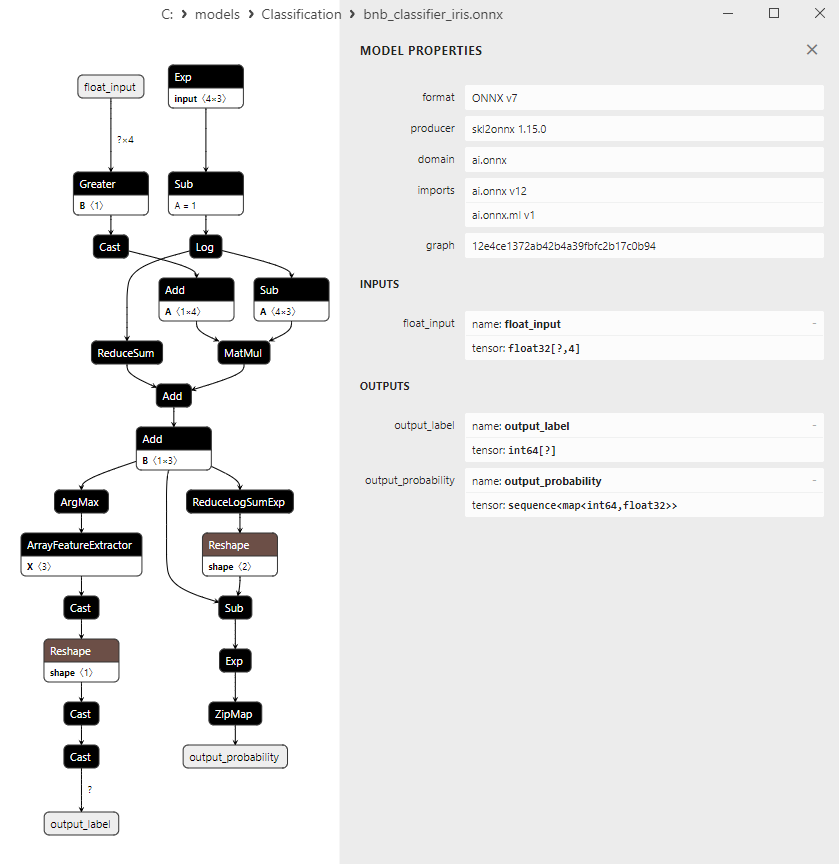

2.21.1. 베르누이 나이브 베이즈(BNB) 분류기 모델을 생성하는 코드

2.21.2. 베르누이 나이브 베이즈(BNB) 분류기 모델 작업을 위한 MQL5 코드

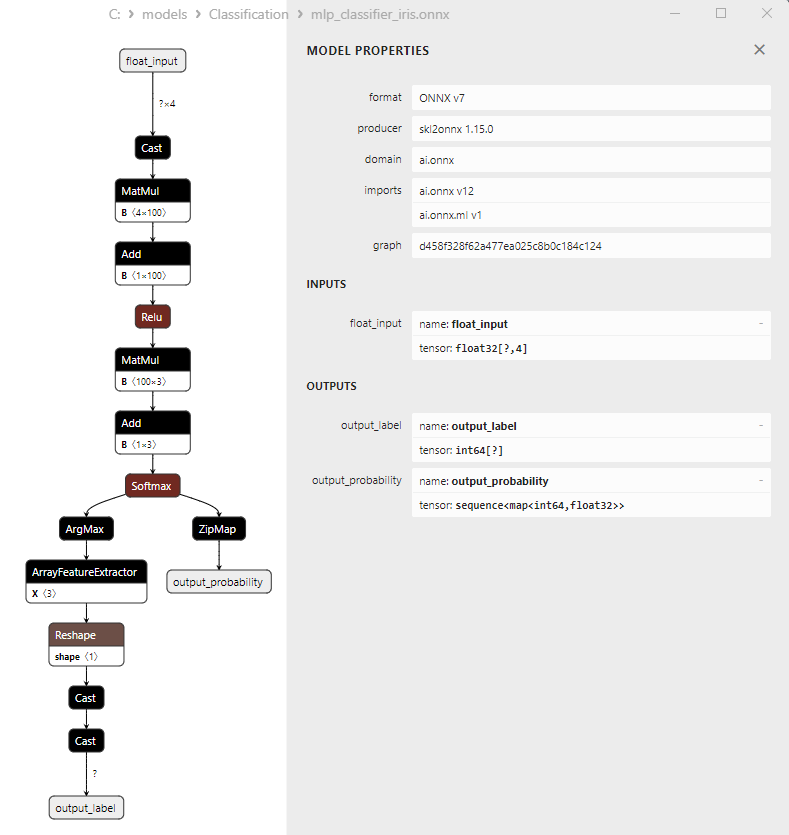

2.21.3. 베르누이 나이브 베이즈(BNB) 분류기 모델의 ONNX 표현 - 2.22. 다층 퍼셉트론 분류기

2.22.1. 다층 퍼셉트론 분류기 모델 생성 코드

2.22.2. 다층 퍼셉트론 분류기 모델 작업을 위한 MQL5 코드

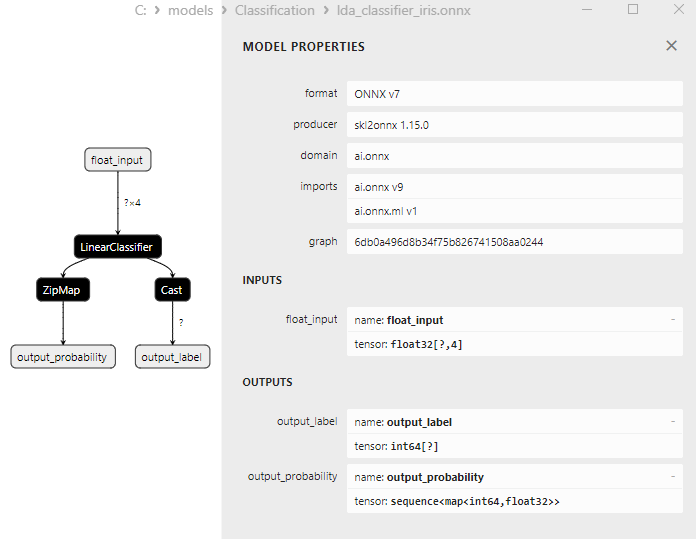

2.22.3. 다층 퍼셉트론 분류기 모델의 ONNX 표현 - 2.23. 선형 판별 분석(LDA) 분류기

2.23.1. 선형 판별 분석(LDA) 분류기 모델 생성 코드

2.23.2. 선형 판별 분석(LDA) 분류기 모델 작업을 위한 MQL5 코드

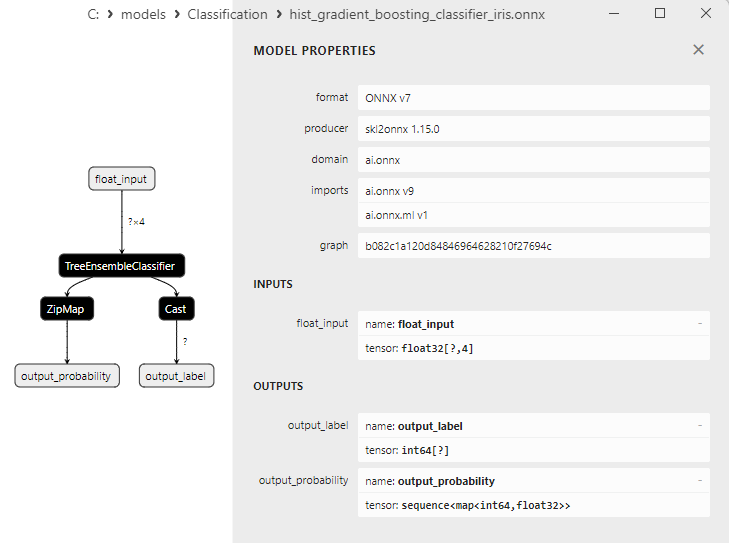

2.23.3. 선형 판별 분석(LDA) 분류기 모델의 ONNX 표현 - 2.24. 히스트 경사 부스팅

2.24.1. 히스토그램 기반의 경사 부스팅 분류기 모델 생성 코드

2.24.2. 히스토그램 기반의 경사 부스팅 분류기 모델 작업을 위한 MQL5 코드

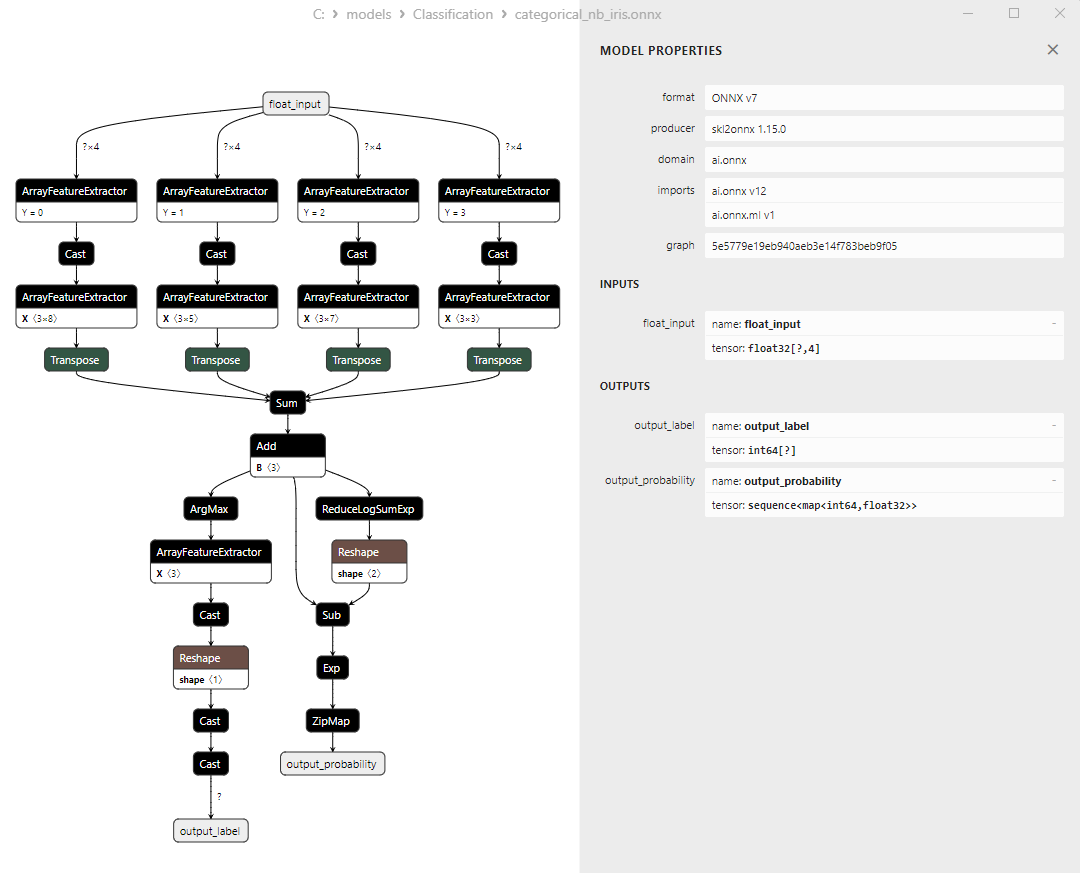

2.24.3. 히스토그램 기반의 경사 부스팅 분류기 모델의 ONNX 표현 - 2.25. CategoricalNB 분류기

2.25.1. CategoricalNB 분류기 모델 생성 코드

2.25.2. CategoricalNB 분류기 모델 작업을 위한 MQL5 코드

2.25.3. CategoricalNB 분류기 모델의 ONNX 표현 - 2.26. 엑스트라트리분류기(ExtraTreeClassifier)

2.26.1. 엑스트라트리분류기 모델 생성 코드

2.26.2. 엑스트라트리분류기 모델 작업을 위한 MQL5 코드

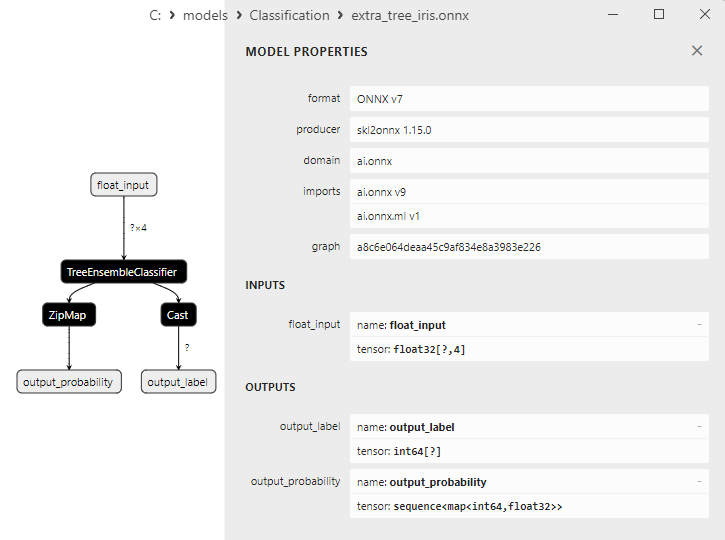

2.26.3. 엑스트라트리분류기 모델의 ONNX 표현 - 2.27. 엑스트라 트리스분류기(ExtraTreesClassifier)

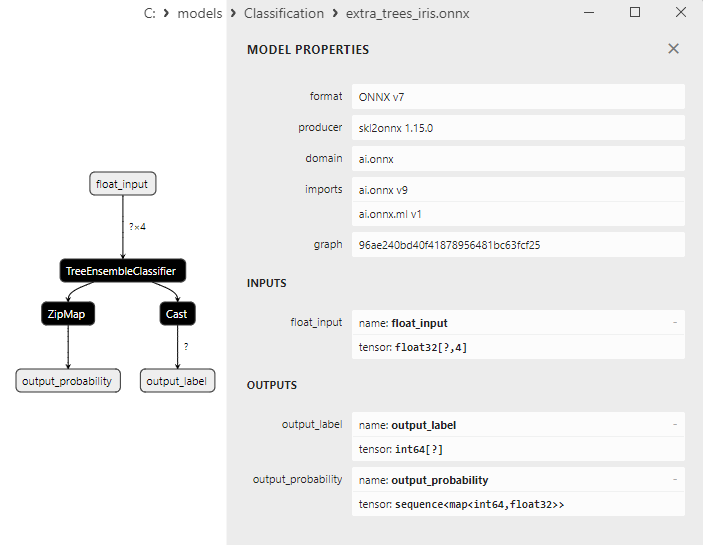

2.27.1. 엑스트라트리스분류기 모델 생성 코드

2.27.2. 엑스트라트리스분류기 모델 작업을 위한 MQL5 코드

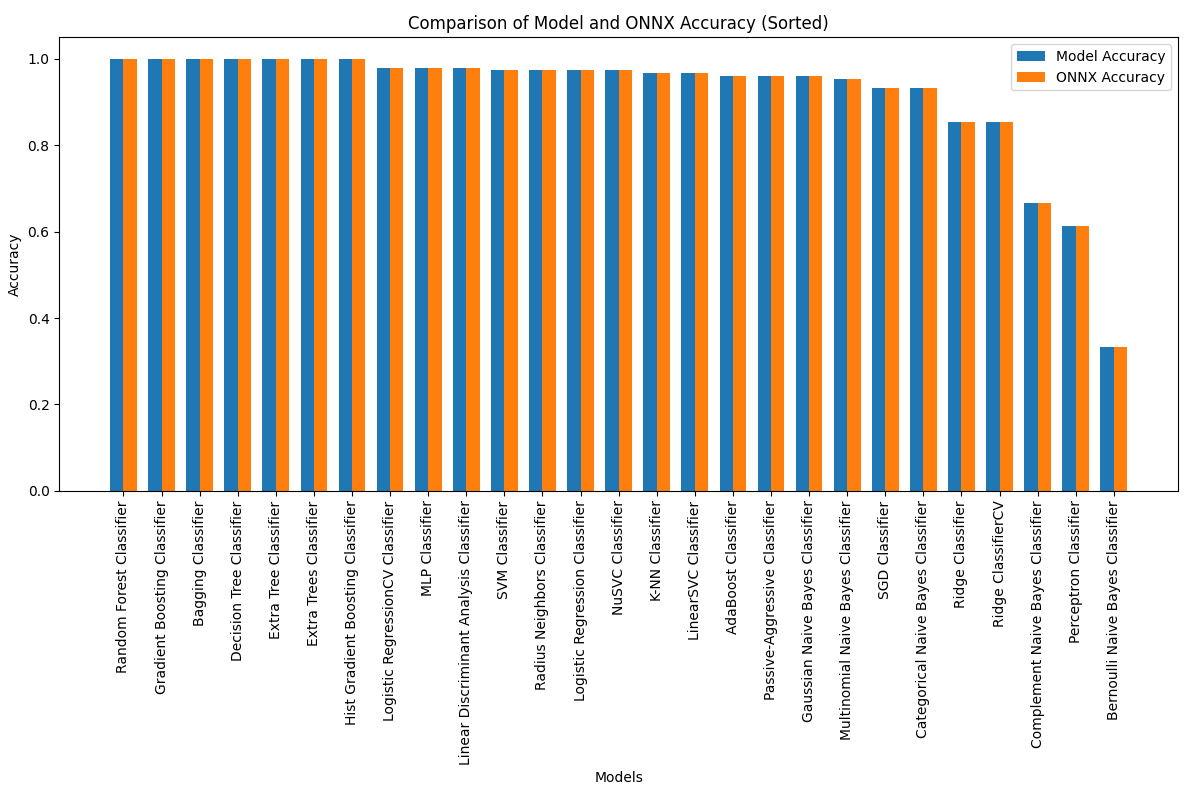

2.27.3. 엑스트라트리스분류기 모델의 ONNX 표현 - 2.28. 모든 모델의 정확도 비교하기

2.28.1. 모든 모델을 계산하고 정확도 비교 차트를 작성하는 코드

2.28.2. 모든 ONNX 모델 실행을 위한 MQL5 코드 - 2.29. ONNX로 변환할 수 없는 Scikit-Learn 분류 모델

- 2.29.1. 더미 분류기

2.29.1.1. 더미 분류기 모델 생성 코드 - 2.29.2. 가우시안 프로세스 분류기

2.29.2.1. 가우스프로세스분류기 모델 생성 코드 - 2.29.3. 레이블 전파 분류기

2.29.3.1. 레이블 전파 분류기 모델 생성 코드 - 2.29.4. 레이블 확산 분류기

2.29.4.1. 레이블 확산 분류기 모델 생성 코드 - 2.29.5. 가장 가까운 중심 분류기

2.29.5.1. 가장 가까운 중심 모델 생성 코드 - 2.29.6. 이차 판별 분석 분류기

2.29.6.1. 이차 판별 분석 모델 생성 코드 - 결론

1. 피셔의 붓꽃

붓꽃 데이터 세트는 머신 러닝 분야에서 가장 많이 알려져 있고 널리 사용되는 데이터 세트 중 하나로 1936년 통계학자이자 생물학자인 R.A.가 처음 소개한 개념이며 이후 분류 작업의 고전적인 데이터 세트가 되었습니다.

붓꽃 데이터 세트는 세 종류의 붓꽃, 즉 붓꽃 세토사, 붓꽃 버지니카, 붓꽃 버지컬러의 꽃받침과 꽃잎을 측정한 데이터로 구성되어 있습니다.

그림 1. 붓꽃 세토사

그림 2. 붓꽃 버지니카

그림 3. 붓꽃 버시컬러

붓꽃 데이터 세트는 150개의 붓꽃 인스턴스로 구성되며 세 가지 종 각각 50개의 인스턴스가 있습니다. 각 인스턴스에는 네 가지 숫자 피처(센티미터 단위로 측정)이 있습니다:

- 꽃받침 길이

- 꽃받침 너비

- 꽃잎 길이

- 꽃잎 너비

각각의 인스턴스에는 붓꽃의 종을 나타내는 해당 클래스(붓꽃 세토사, 붓꽃 버지니카 또는 붓꽃 버시컬러)도 있습니다. 이러한 분류 속성으로 인해 붓꽃 데이터 세트는 분류 및 클러스터링과 같은 머신 러닝 작업에서 이상적인 데이터 세트가 됩니다.

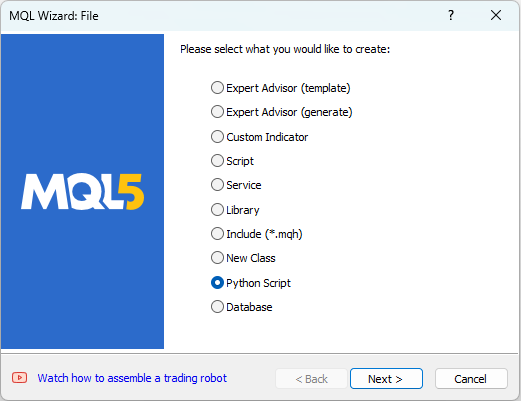

MetaEditor에서는 Python 스크립트로 작업할 수 있습니다. Python 스크립트를 만들려면 MetaEditor의 '파일' 메뉴에서 '새로 만들기'를 선택하면 만들 객체를 선택하는 대화 상자가 나타납니다(그림 4 참조).

그림 4. MQL5 마법사에서 Python 스크립트 만들기 - 1단계

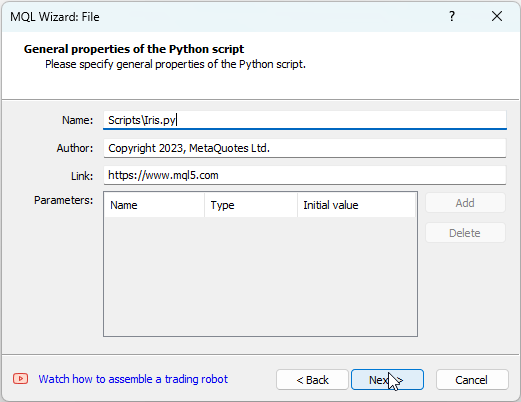

그런 다음 스크립트의 이름(예: "IRIS.py")을 입력합니다(그림 5 참조).

그림 5. MQL5 마법사에서 Python 스크립트 만들기 - 2단계 - 스크립트 이름

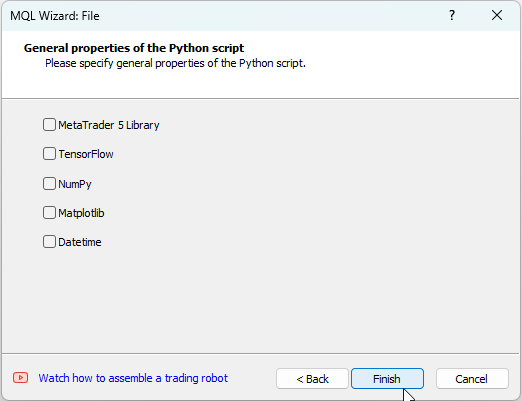

그런 다음 사용할 라이브러리를 지정할 수 있습니다. 이 경우에 우리는 이 필드를 비워 두겠습니다(그림 6 참조).

그림 6: MQL5 마법사에서 Python 스크립트 만들기 - 3단계

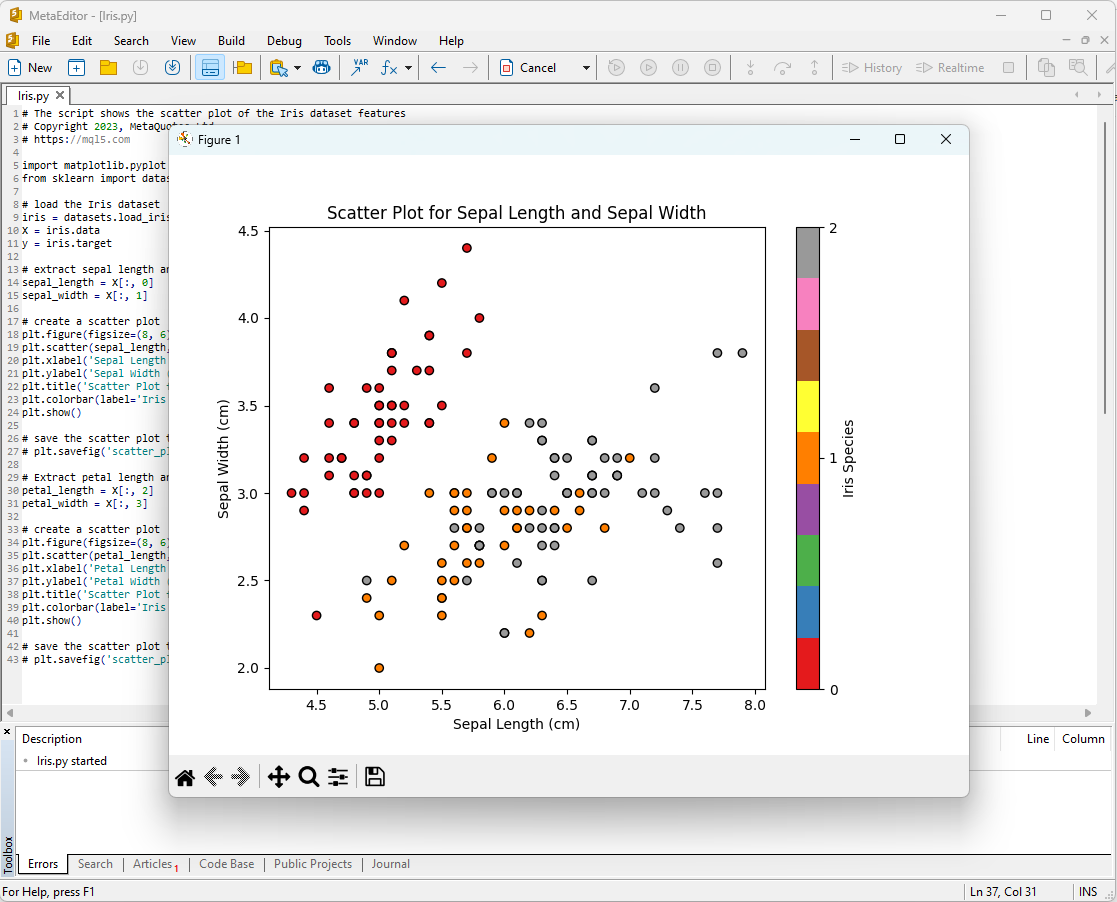

붓꽃 데이터 집합 분석을 시작하는 한 가지 방법은 데이터를 시각화하는 것입니다. 그래픽을 통하면 데이터의 구조와 피처 간의 관계를 더 잘 이해할 수 있습니다.

예를 들어 여러분은 산점도를 만들어 피처 공간에서 다양한 종류의 붓꽃이 어떻게 분포되어 있는지 확인할 수 있습니다.

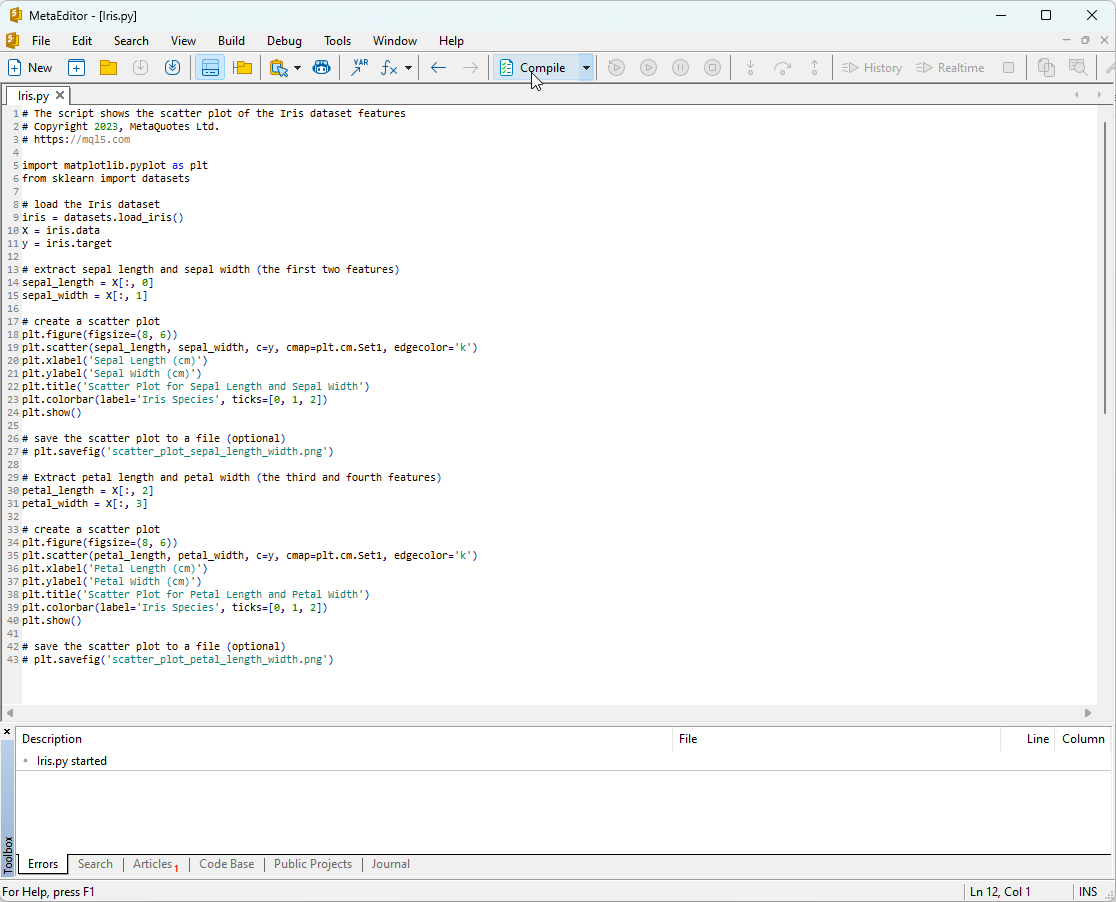

Python 스크립트 코드:

# The script shows the scatter plot of the Iris dataset features # Copyright 2023, MetaQuotes Ltd. # https://mql5.com import matplotlib.pyplot as plt from sklearn import datasets # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # extract sepal length and sepal width (the first two features) sepal_length = X[:, 0] sepal_width = X[:, 1] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(sepal_length, sepal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Sepal Length (cm)') plt.ylabel('Sepal Width (cm)') plt.title('Scatter Plot for Sepal Length and Sepal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_sepal_length_width.png') # Extract petal length and petal width (the third and fourth features) petal_length = X[:, 2] petal_width = X[:, 3] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(petal_length, petal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Petal Length (cm)') plt.ylabel('Petal Width (cm)') plt.title('Scatter Plot for Petal Length and Petal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_petal_length_width.png')

이 스크립트를 실행하려면 스크립트를 MetaEditor에 복사하고(그림 7 참조) "컴파일"을 클릭해야 합니다.

그림 7: MetaEditor의 IRIS.py 스크립트

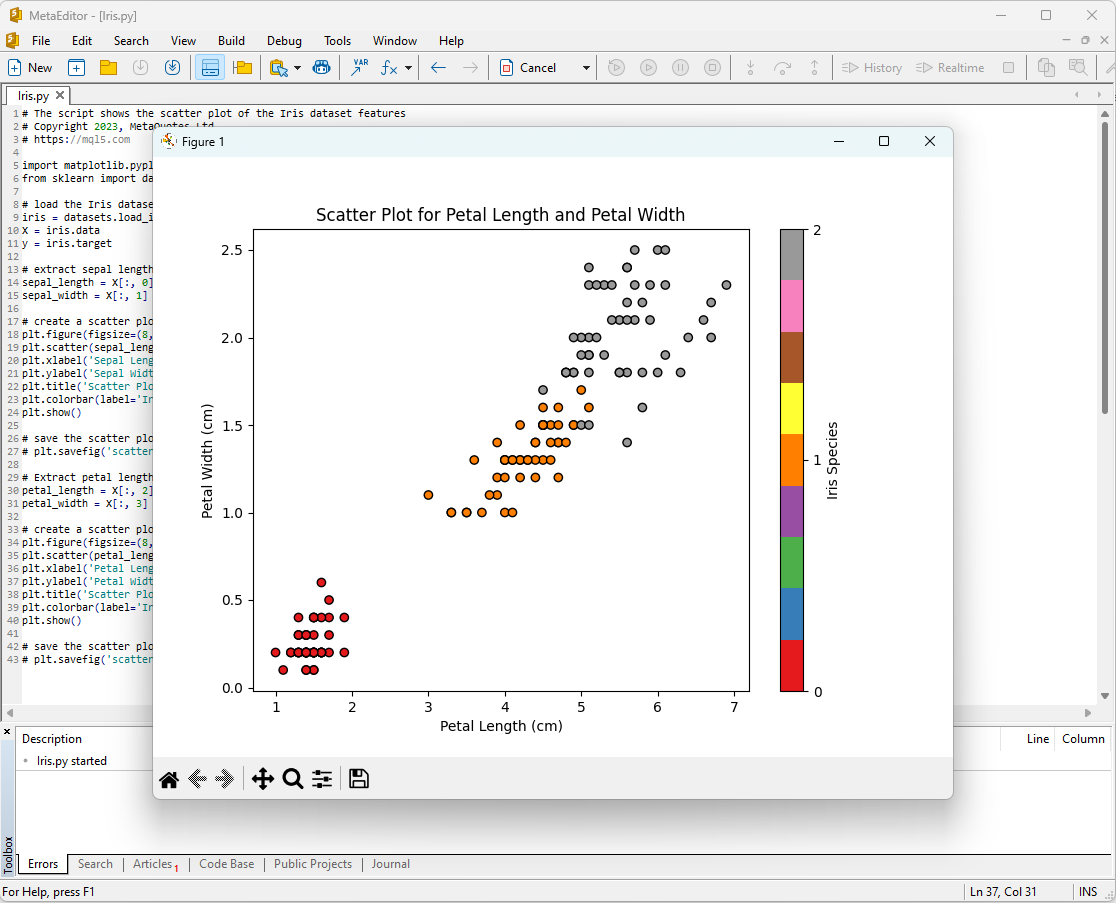

그 후 플롯이 화면에 나타납니다:

그림 8: 세팔 길이/세팔 너비 플롯이 있는 MetaEditor의 IRIS.py 스크립트

그림 9: 꽃잎 길이/꽃잎 너비 플롯이 있는 MetaEditor의 IRIS.py 스크립트

자세히 살펴보겠습니다.

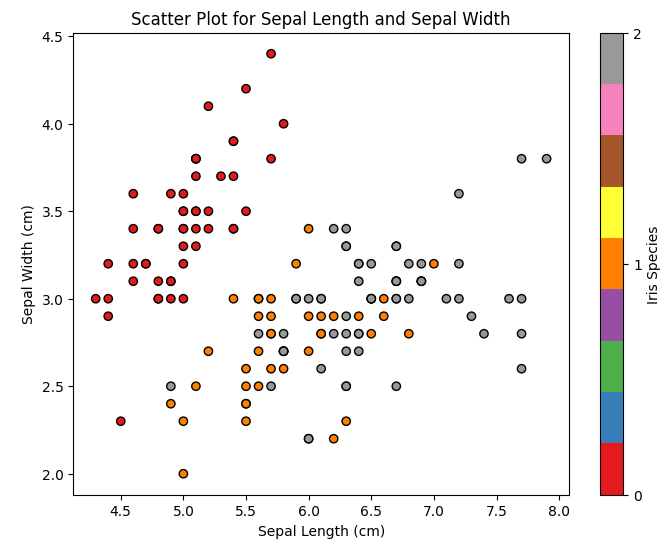

그림 10: 산점도 꽃받침 길이 대 꽃받침 폭

이 도표에서 꽃받침 길이와 꽃받침 너비에 따라 붓꽃의 종의 분포가 어떻게 다른지 확인할 수 있습니다. 붓꽃 세토사는 일반적으로 다른 두 종에 비해 꽃받침이 짧고 넓은 것을 관찰할 수 있습니다.

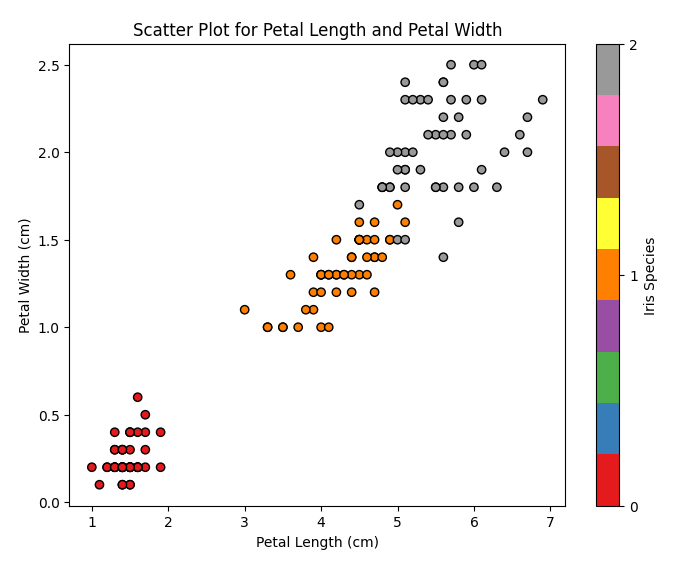

그림 11: 스캐터 플롯 꽃잎 길이 대 꽃잎 폭

이 도표에서 우리는 꽃잎 길이와 꽃잎 너비에 따라 붓꽃의 종류가 어떻게 분포하는지 확인할 수 있습니다. 붓꽃 세토사는 꽃잎이 가장 짧고 좁고 붓꽃 버지니카는 꽃잎이 가장 길고 넓으며 붓꽃 버지컬러는 그 사이에 속한다는 것을 알 수 있습니다.

붓꽃 데이터 세트는 머신 러닝 모델을 학습하고 테스트하는 데 이상적인 데이터 세트입니다. 우리는 이 세트를 분류 작업에 대한 머신러닝 모델의 효과를 분석하는 데 사용할 것입니다.

2. 분류용 모델

분류는 머신 러닝의 기본 작업 중 하나로 데이터를 특정한 피처에 따라 여러 범주 또는 클래스로 분류하는 것이 목표입니다.

이제 scikit-learn 패키지의 주요 머신 러닝 모델을 살펴보겠습니다.

Scikit-learn 분류기 목록

scikit-learn에서 사용 가능한 분류기 목록을 표시하기 위해 우리는 다음 스크립트를 사용할 수 있습니다:

# ScikitLearnClassifiers.py # The script lists all the classification algorithms available in scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn classifiers from sklearn.utils import all_estimators classifiers = all_estimators(type_filter='classifier') for index, (name, ClassifierClass) in enumerate(classifiers, start=1): print(f"Classifier {index}: {name}")

출력:

Python scikit-learn 버전은 1.2.2입니다.

Python 분류기 1: AdaBoostClassifier

Python 분류기 2: BaggingClassifier

Python 분류기 3: BernoulliNB

Python 분류기 4: CalibratedClassifierCV

Python 분류기 5: CategoricalNB

Python 분류기 6: ClassifierChain

Python 분류기 7: ComplementNB

Python 분류기 8: DecisionTreeClassifier

Python 분류기 9: DummyClassifier

Python 분류기 10: ExtraTreeClassifier

Python 분류기 11: ExtraTreesClassifier

Python 분류기 12: GaussianNB

Python 분류기 13: GaussianProcessClassifier

Python 분류기 14: GradientBoostingClassifier

Python 분류기 15: HistGradientBoostingClassifier

Python 분류기 16: KNeighborsClassifier

Python 분류기 17: LabelPropagation

Python 분류기 18: LabelSpreading

Python 분류기 19: LinearDiscriminantAnalysis

Python 분류기 20: LinearSVC

Python 분류기 21: LogisticRegression

Python 분류기 22: LogisticRegressionCV

Python 분류기 23: MLPClassifier

Python 분류기 24: MultiOutputClassifier

Python 분류기 25: MultinomialNB

Python 분류기 26: NearestCentroid

Python 분류기 27: NuSVC

Python 분류기 28: OneVsOneClassifier

Python 분류기 29: OneVsRestClassifier

Python 분류기 30: OutputCodeClassifier

Python 분류기 31: PassiveAggressiveClassifier

Python 분류기 32: Perceptron

Python Classifier 33: QuadraticDiscriminantAnalysis

Python 분류기 34: RadiusNeighborsClassifier

Python 분류기 35: RandomForestClassifier

Python 분류기 36: RidgeClassifier

Python 분류기 37: RidgeClassifierCV

Python 분류기 38: SGDClassifier

Python 분류기 39: SVC

Python 분류기 40: StackingClassifier

Python 분류기 41: VotingClassifier

이 분류기 목록은 여러분의 편의를 위해 각기 다른 색상으로 강조 표시되어 있습니다. 기본 분류기가 필요한 모델은 노란색으로 강조 표시되며 그 외 모델은 독립적으로 사용할 수 있습니다.

한 가지 주목할 점은 초록색 모델은 ONNX 형식으로 성공적으로 내보내어진 반면 빨간색 모델에서는 현재 버전의 scikit-learn 1.2.2에서 변환하는 동안 오류가 발생한다는 점입니다.

모델에서 출력 데이터의 다양한 표현

ONNX로 변환된 모델로 작업할 때는 모델에 따라 출력 데이터가 다르게 표현되므로 주의해야 합니다.

피셔의 붓꽃 분류 작업의 경우 입력 텐서는 모든 모델에 대해 동일한 형식을 갖습니다:

1. Name: float_input, 데이터 유형: 텐서(float), 모양: [None, 4]

ONNX 모델의 출력 텐서는 다릅니다.

1. 후처리가 필요하지 않은 모델입니다:

- SVC 분류기;

- LinearSVC 분류기;

- NuSVC 분류기;

- Radius Neighbors Classifier;

- Ridge Classifier;

- Ridge Classifier CV.

1. 이름: label, Data Type: tensor(int64), Shape: [None]

2. 이름: probabilities, Data Type: tensor(float), Shape: [None, 3]

이러한 모델은 사후 처리 없이 첫 번째 출력 정수 텐서 '레이블'에 결과(클래스 번호)를 명시적으로 반환합니다.

2. 결과에 후처리가 필요한 모델:

- 랜덤 숲 분류기;

- 경사 부스팅 분류기;

- AdaBoost 분류기;

- 포장 분류기;

- K-NN_Classifier;

- 의사 결정 트리 분류기;

- 로지스틱 회귀 분류기;

- 로지스틱 회귀 CV 분류기;

- 패시브-어그레시브 분류기;

- 퍼셉트론 분류기;

- SGD 분류기;

- 가우시안 나이브 베이즈 분류기;

- 다항식 나이브 베이즈 분류기;

- 보완 나이브 베이즈 분류기;

- 베르누이 나이브 베이즈 분류기;

- 다층 퍼셉트론 분류기;

- 선형 판별 분석 분류기;

- 히스트 경사 부스팅 분류기;

- 범주형 나이브 베이즈 분류기;

- ExtraTree Classifier;

- ExtraTrees Classifier.

1. 이름: output_label, Data Type: tensor(int64), Shape: [None]

2. 이름: output_probability, Data Type: seq(map(int64,tensor(float))), Shape: []

이 모델은 클래스 목록과 각 클래스에 속할 확률을 반환합니다.

이러한 경우 결과를 얻으려면 seq(map(int64, tensor(float))(가장 높은 확률을 가진 요소 찾기)와 같은 후처리가 필요합니다.

따라서 ONNX 모델로 작업할 때는 세심한 주의를 기울이고 이러한 측면을 고려해야 합니다. 다양한 결과 처리의 예는 2.28.2의 스크립트에 나와 있습니다.

iris.mqh

MQL5의 전체 붓꽃 데이터 세트에서 모델을 테스트하려면 데이터 준비가 필요합니다. 이를 위해 PrepareIrisDataset() 함수가 사용될 것입니다.

이러한 함수를 iris.mqh 파일로 옮기면 편리합니다.

//+------------------------------------------------------------------+ //| Iris.mqh | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" //+------------------------------------------------------------------+ //| Structure for the IRIS Dataset sample | //+------------------------------------------------------------------+ struct sIRISsample { int sample_id; // sample id (1-150) double features[4]; // SepalLengthCm,SepalWidthCm,PetalLengthCm,PetalWidthCm string class_name; // class ("Iris-setosa","Iris-versicolor","Iris-virginica") int class_id; // class id (0,1,2), calculated by function IRISClassID }; //--- Iris dataset sIRISsample ExtIRISDataset[]; int Exttotal=0; //+------------------------------------------------------------------+ //| Returns class id by class name | //+------------------------------------------------------------------+ int IRISClassID(string class_name) { //--- if(class_name=="Iris-setosa") return(0); else if(class_name=="Iris-versicolor") return(1); else if(class_name=="Iris-virginica") return(2); //--- return(-1); } //+------------------------------------------------------------------+ //| AddSample | //+------------------------------------------------------------------+ bool AddSample(const int Id,const double SepalLengthCm,const double SepalWidthCm,const double PetalLengthCm,const double PetalWidthCm, const string Species) { //--- ExtIRISDataset[Exttotal].sample_id=Id; //--- ExtIRISDataset[Exttotal].features[0]=SepalLengthCm; ExtIRISDataset[Exttotal].features[1]=SepalWidthCm; ExtIRISDataset[Exttotal].features[2]=PetalLengthCm; ExtIRISDataset[Exttotal].features[3]=PetalWidthCm; //--- ExtIRISDataset[Exttotal].class_name=Species; ExtIRISDataset[Exttotal].class_id=IRISClassID(Species); //--- Exttotal++; //--- return(true); } //+------------------------------------------------------------------+ //| Prepare Iris Dataset | //+------------------------------------------------------------------+ bool PrepareIrisDataset(sIRISsample &iris_samples[]) { ArrayResize(ExtIRISDataset,150); Exttotal=0; //--- AddSample(1,5.1,3.5,1.4,0.2,"Iris-setosa"); AddSample(2,4.9,3.0,1.4,0.2,"Iris-setosa"); AddSample(3,4.7,3.2,1.3,0.2,"Iris-setosa"); AddSample(4,4.6,3.1,1.5,0.2,"Iris-setosa"); AddSample(5,5.0,3.6,1.4,0.2,"Iris-setosa"); AddSample(6,5.4,3.9,1.7,0.4,"Iris-setosa"); AddSample(7,4.6,3.4,1.4,0.3,"Iris-setosa"); AddSample(8,5.0,3.4,1.5,0.2,"Iris-setosa"); AddSample(9,4.4,2.9,1.4,0.2,"Iris-setosa"); AddSample(10,4.9,3.1,1.5,0.1,"Iris-setosa"); AddSample(11,5.4,3.7,1.5,0.2,"Iris-setosa"); AddSample(12,4.8,3.4,1.6,0.2,"Iris-setosa"); AddSample(13,4.8,3.0,1.4,0.1,"Iris-setosa"); AddSample(14,4.3,3.0,1.1,0.1,"Iris-setosa"); AddSample(15,5.8,4.0,1.2,0.2,"Iris-setosa"); AddSample(16,5.7,4.4,1.5,0.4,"Iris-setosa"); AddSample(17,5.4,3.9,1.3,0.4,"Iris-setosa"); AddSample(18,5.1,3.5,1.4,0.3,"Iris-setosa"); AddSample(19,5.7,3.8,1.7,0.3,"Iris-setosa"); AddSample(20,5.1,3.8,1.5,0.3,"Iris-setosa"); AddSample(21,5.4,3.4,1.7,0.2,"Iris-setosa"); AddSample(22,5.1,3.7,1.5,0.4,"Iris-setosa"); AddSample(23,4.6,3.6,1.0,0.2,"Iris-setosa"); AddSample(24,5.1,3.3,1.7,0.5,"Iris-setosa"); AddSample(25,4.8,3.4,1.9,0.2,"Iris-setosa"); AddSample(26,5.0,3.0,1.6,0.2,"Iris-setosa"); AddSample(27,5.0,3.4,1.6,0.4,"Iris-setosa"); AddSample(28,5.2,3.5,1.5,0.2,"Iris-setosa"); AddSample(29,5.2,3.4,1.4,0.2,"Iris-setosa"); AddSample(30,4.7,3.2,1.6,0.2,"Iris-setosa"); AddSample(31,4.8,3.1,1.6,0.2,"Iris-setosa"); AddSample(32,5.4,3.4,1.5,0.4,"Iris-setosa"); AddSample(33,5.2,4.1,1.5,0.1,"Iris-setosa"); AddSample(34,5.5,4.2,1.4,0.2,"Iris-setosa"); AddSample(35,4.9,3.1,1.5,0.2,"Iris-setosa"); AddSample(36,5.0,3.2,1.2,0.2,"Iris-setosa"); AddSample(37,5.5,3.5,1.3,0.2,"Iris-setosa"); AddSample(38,4.9,3.6,1.4,0.1,"Iris-setosa"); AddSample(39,4.4,3.0,1.3,0.2,"Iris-setosa"); AddSample(40,5.1,3.4,1.5,0.2,"Iris-setosa"); AddSample(41,5.0,3.5,1.3,0.3,"Iris-setosa"); AddSample(42,4.5,2.3,1.3,0.3,"Iris-setosa"); AddSample(43,4.4,3.2,1.3,0.2,"Iris-setosa"); AddSample(44,5.0,3.5,1.6,0.6,"Iris-setosa"); AddSample(45,5.1,3.8,1.9,0.4,"Iris-setosa"); AddSample(46,4.8,3.0,1.4,0.3,"Iris-setosa"); AddSample(47,5.1,3.8,1.6,0.2,"Iris-setosa"); AddSample(48,4.6,3.2,1.4,0.2,"Iris-setosa"); AddSample(49,5.3,3.7,1.5,0.2,"Iris-setosa"); AddSample(50,5.0,3.3,1.4,0.2,"Iris-setosa"); AddSample(51,7.0,3.2,4.7,1.4,"Iris-versicolor"); AddSample(52,6.4,3.2,4.5,1.5,"Iris-versicolor"); AddSample(53,6.9,3.1,4.9,1.5,"Iris-versicolor"); AddSample(54,5.5,2.3,4.0,1.3,"Iris-versicolor"); AddSample(55,6.5,2.8,4.6,1.5,"Iris-versicolor"); AddSample(56,5.7,2.8,4.5,1.3,"Iris-versicolor"); AddSample(57,6.3,3.3,4.7,1.6,"Iris-versicolor"); AddSample(58,4.9,2.4,3.3,1.0,"Iris-versicolor"); AddSample(59,6.6,2.9,4.6,1.3,"Iris-versicolor"); AddSample(60,5.2,2.7,3.9,1.4,"Iris-versicolor"); AddSample(61,5.0,2.0,3.5,1.0,"Iris-versicolor"); AddSample(62,5.9,3.0,4.2,1.5,"Iris-versicolor"); AddSample(63,6.0,2.2,4.0,1.0,"Iris-versicolor"); AddSample(64,6.1,2.9,4.7,1.4,"Iris-versicolor"); AddSample(65,5.6,2.9,3.6,1.3,"Iris-versicolor"); AddSample(66,6.7,3.1,4.4,1.4,"Iris-versicolor"); AddSample(67,5.6,3.0,4.5,1.5,"Iris-versicolor"); AddSample(68,5.8,2.7,4.1,1.0,"Iris-versicolor"); AddSample(69,6.2,2.2,4.5,1.5,"Iris-versicolor"); AddSample(70,5.6,2.5,3.9,1.1,"Iris-versicolor"); AddSample(71,5.9,3.2,4.8,1.8,"Iris-versicolor"); AddSample(72,6.1,2.8,4.0,1.3,"Iris-versicolor"); AddSample(73,6.3,2.5,4.9,1.5,"Iris-versicolor"); AddSample(74,6.1,2.8,4.7,1.2,"Iris-versicolor"); AddSample(75,6.4,2.9,4.3,1.3,"Iris-versicolor"); AddSample(76,6.6,3.0,4.4,1.4,"Iris-versicolor"); AddSample(77,6.8,2.8,4.8,1.4,"Iris-versicolor"); AddSample(78,6.7,3.0,5.0,1.7,"Iris-versicolor"); AddSample(79,6.0,2.9,4.5,1.5,"Iris-versicolor"); AddSample(80,5.7,2.6,3.5,1.0,"Iris-versicolor"); AddSample(81,5.5,2.4,3.8,1.1,"Iris-versicolor"); AddSample(82,5.5,2.4,3.7,1.0,"Iris-versicolor"); AddSample(83,5.8,2.7,3.9,1.2,"Iris-versicolor"); AddSample(84,6.0,2.7,5.1,1.6,"Iris-versicolor"); AddSample(85,5.4,3.0,4.5,1.5,"Iris-versicolor"); AddSample(86,6.0,3.4,4.5,1.6,"Iris-versicolor"); AddSample(87,6.7,3.1,4.7,1.5,"Iris-versicolor"); AddSample(88,6.3,2.3,4.4,1.3,"Iris-versicolor"); AddSample(89,5.6,3.0,4.1,1.3,"Iris-versicolor"); AddSample(90,5.5,2.5,4.0,1.3,"Iris-versicolor"); AddSample(91,5.5,2.6,4.4,1.2,"Iris-versicolor"); AddSample(92,6.1,3.0,4.6,1.4,"Iris-versicolor"); AddSample(93,5.8,2.6,4.0,1.2,"Iris-versicolor"); AddSample(94,5.0,2.3,3.3,1.0,"Iris-versicolor"); AddSample(95,5.6,2.7,4.2,1.3,"Iris-versicolor"); AddSample(96,5.7,3.0,4.2,1.2,"Iris-versicolor"); AddSample(97,5.7,2.9,4.2,1.3,"Iris-versicolor"); AddSample(98,6.2,2.9,4.3,1.3,"Iris-versicolor"); AddSample(99,5.1,2.5,3.0,1.1,"Iris-versicolor"); AddSample(100,5.7,2.8,4.1,1.3,"Iris-versicolor"); AddSample(101,6.3,3.3,6.0,2.5,"Iris-virginica"); AddSample(102,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(103,7.1,3.0,5.9,2.1,"Iris-virginica"); AddSample(104,6.3,2.9,5.6,1.8,"Iris-virginica"); AddSample(105,6.5,3.0,5.8,2.2,"Iris-virginica"); AddSample(106,7.6,3.0,6.6,2.1,"Iris-virginica"); AddSample(107,4.9,2.5,4.5,1.7,"Iris-virginica"); AddSample(108,7.3,2.9,6.3,1.8,"Iris-virginica"); AddSample(109,6.7,2.5,5.8,1.8,"Iris-virginica"); AddSample(110,7.2,3.6,6.1,2.5,"Iris-virginica"); AddSample(111,6.5,3.2,5.1,2.0,"Iris-virginica"); AddSample(112,6.4,2.7,5.3,1.9,"Iris-virginica"); AddSample(113,6.8,3.0,5.5,2.1,"Iris-virginica"); AddSample(114,5.7,2.5,5.0,2.0,"Iris-virginica"); AddSample(115,5.8,2.8,5.1,2.4,"Iris-virginica"); AddSample(116,6.4,3.2,5.3,2.3,"Iris-virginica"); AddSample(117,6.5,3.0,5.5,1.8,"Iris-virginica"); AddSample(118,7.7,3.8,6.7,2.2,"Iris-virginica"); AddSample(119,7.7,2.6,6.9,2.3,"Iris-virginica"); AddSample(120,6.0,2.2,5.0,1.5,"Iris-virginica"); AddSample(121,6.9,3.2,5.7,2.3,"Iris-virginica"); AddSample(122,5.6,2.8,4.9,2.0,"Iris-virginica"); AddSample(123,7.7,2.8,6.7,2.0,"Iris-virginica"); AddSample(124,6.3,2.7,4.9,1.8,"Iris-virginica"); AddSample(125,6.7,3.3,5.7,2.1,"Iris-virginica"); AddSample(126,7.2,3.2,6.0,1.8,"Iris-virginica"); AddSample(127,6.2,2.8,4.8,1.8,"Iris-virginica"); AddSample(128,6.1,3.0,4.9,1.8,"Iris-virginica"); AddSample(129,6.4,2.8,5.6,2.1,"Iris-virginica"); AddSample(130,7.2,3.0,5.8,1.6,"Iris-virginica"); AddSample(131,7.4,2.8,6.1,1.9,"Iris-virginica"); AddSample(132,7.9,3.8,6.4,2.0,"Iris-virginica"); AddSample(133,6.4,2.8,5.6,2.2,"Iris-virginica"); AddSample(134,6.3,2.8,5.1,1.5,"Iris-virginica"); AddSample(135,6.1,2.6,5.6,1.4,"Iris-virginica"); AddSample(136,7.7,3.0,6.1,2.3,"Iris-virginica"); AddSample(137,6.3,3.4,5.6,2.4,"Iris-virginica"); AddSample(138,6.4,3.1,5.5,1.8,"Iris-virginica"); AddSample(139,6.0,3.0,4.8,1.8,"Iris-virginica"); AddSample(140,6.9,3.1,5.4,2.1,"Iris-virginica"); AddSample(141,6.7,3.1,5.6,2.4,"Iris-virginica"); AddSample(142,6.9,3.1,5.1,2.3,"Iris-virginica"); AddSample(143,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(144,6.8,3.2,5.9,2.3,"Iris-virginica"); AddSample(145,6.7,3.3,5.7,2.5,"Iris-virginica"); AddSample(146,6.7,3.0,5.2,2.3,"Iris-virginica"); AddSample(147,6.3,2.5,5.0,1.9,"Iris-virginica"); AddSample(148,6.5,3.0,5.2,2.0,"Iris-virginica"); AddSample(149,6.2,3.4,5.4,2.3,"Iris-virginica"); AddSample(150,5.9,3.0,5.1,1.8,"Iris-virginica"); //--- ArrayResize(iris_samples,150); for(int i=0; i<Exttotal; i++) { iris_samples[i]=ExtIRISDataset[i]; } //--- return(true); } //+------------------------------------------------------------------+

널리 사용되는 세 가지 분류 메서드를 비교해 보겠습니다: SVC(서포트 벡터 분류), LinearSVC(선형 서포트 벡터 분류), NuSVC(뉴 서포트 벡터 분류).

운영 원칙:

SVC(지원 벡터 분류)

작동 원리: SVC는 클래스 간의 마진을 극대화하는 분류 메서드입니다. SVC는 클래스를 최대한 분리하고 서포트 벡터를 지원하는 최적의 분리 초평면(초평면에 가장 가까운 점)을 찾습니다.

커널 함수: SVC는 선형, 방사형 기저 함수(RBF), 다항식 등 다양한 커널 함수를 사용할 수 있습니다. 커널 함수는 최적의 초평면을 찾기 위해 데이터를 변환하는 방법을 결정합니다.

LinearSVC(선형 지원 벡터 분류)

작동 원리: LinearSVC는 선형 분류에 특화된 SVC의 변형입니다. LinearSVC는 커널 함수를 사용하지 않고 최적의 선형 분리 초평면을 찾습니다. 따라서 대량의 데이터로 작업할 때 더 빠르고 효율적으로 작업할 수 있습니다.

NuSVC(Nu 지원 벡터 분류)

작동 원리: NuSVC도 서포트 벡터 메서드를 기반으로 하지만 모델의 복잡도와 서포트 벡터의 비율을 제어하는 매개 변수 Nu(nu)를 도입합니다. Nu 값은 0에서 1 사이의 범위이며 이 값이 지원 벡터 및 오류에 사용할 수 있는 데이터의 양을 결정합니다.

장점:

SVC

강력한 알고리즘: SVC는 커널 함수를 사용해서 복잡한 분류 작업을 처리하고 비선형 데이터로 작업할 수 있습니다.

이상값에 대한 견고성: SVC는 서포트 벡터를 사용하여 분리 초평면을 구축하기 때문에 데이터 이상값에 강합니다.

LinearSVC

높은 효율성: LinearSVC는 특히 데이터가 크고 선형 분리가 작업에 적합한 경우 대규모 데이터 집합을 처리할 때 더 빠르고 효율적입니다.

선형 분류: 문제가 선형적으로 잘 분리될 수 있는 경우 LinearSVC는 복잡한 커널 함수 없이도 좋은 결과를 얻을 수 있습니다.

NuSVC

모델 복잡도 제어: NuSVC의 Nu 매개변수를 사용하면 모델의 복잡성과 데이터 맞춤과 일반화 사이의 균형을 제어할 수 있습니다.

이상값에 대한 견고성: SVC와 마찬가지로 NuSVC는 이상값에 강하므로 노이즈가 많은 데이터가 있는 작업에 유용합니다.

제한 사항:

SVC

계산의 복잡성: SVC는 대규모 데이터 세트나 복잡한 커널 함수를 사용하는 경우 느려질 수 있습니다.

커널 감도: 올바른 커널 함수를 선택하는 것은 어려운 작업이며 모델 성능에 큰 영향을 미칠 수 있습니다.

LinearSVC

선형성 제약 조건: LinearSVC는 선형 데이터 분리에 의해 제약을 받으며 피처와 대상 변수 간에 비선형 종속성이 있는 경우 성능이 저하될 수 있습니다.

NuSVC

뉴 파라미터 튜닝: Nu 매개변수를 조정하여 최적의 결과를 얻으려고 할 경우 많은 시간과 실험이 필요할 수 있습니다.

작업 특성과 데이터 양에 따라 이러한 각 메서드가 최선의 선택이 될 수 있습니다. 그러므로 실험을 수행하여 특정 분류 작업 요구 사항에 가장 적합한 메서드를 선택하는 것이 중요합니다.

2.1. SVC 분류기

서포트 벡터 분류(SVC) 분류 메서드는 분류 작업을 해결하는 데 널리 사용되는 강력한 머신 러닝 알고리즘입니다.

운영 원칙:

- 최적의 분리 하이퍼플레인

작동 원리: SVC의 기본 개념은 피처 공간에서 최적의 분리 초평면을 찾는 것입니다. 이 초평면은 서로 다른 클래스의 오브젝트 간의 분리를 최대화하고 초평면에 가장 가까운 데이터 포인트인 서포트 벡터를 지원해야 합니다.

마진 극대화: SVC는 클래스 간 마진, 즉 서포트 벡터에서 초평면까지의 거리를 최대화하는 것을 목표로 합니다. 이를 통해 이 메서드는 이상값에 대해 강력하고 새로운 데이터에 잘 일반화할 수 있습니다. - 커널 함수 활용

커널 함수: SVC는 선형, 방사형 기저 함수(RBF), 다항식 등 다양한 커널 함수를 사용할 수 있습니다. 커널 함수를 사용하면 원래 데이터 공간에 선형 분리 가능성이 없더라도 작업이 선형화되는 고차원 공간으로 데이터를 투영할 수 있습니다.

커널 선택: 올바른 커널 함수를 선택은 SVC 모델의 성능에 큰 영향을 미칠 수 있습니다. 선형 초평면이 항상 최적의 솔루션은 아닙니다.

장점:

- 강력한 알고리즘. 복잡한 작업 처리하기: SVC는 피처와 대상 변수 간에 비선형 종속성이 있는 분류 작업을 포함해 복잡한 분류 작업을 해결할 수 있습니다.

- 이상값에 대한 견고성: 지원 벡터를 사용하면 데이터 이상값에 대해 강력한 메서드를 사용할 수 있습니다. 전체 데이터 세트가 아닌 지원 벡터에 따라 달라집니다.

- 커널 유연성. 데이터에 대한 적응성: 다양한 커널 함수를 사용할 수 있다는 사실은 SVC가 특정 데이터에 적응하게 하고 비선형 관계를 발견할 수 있게 합니다.

- 좋은 일반화. 새 데이터로 일반화: SVC 모델은 새로운 데이터에도 잘 일반화할 수 있어 예측 작업에 유용합니다.

제한 사항:

- 계산 복잡성. 훈련 시간: 특히 대량의 데이터나 복잡한 커널 함수를 처리하는 경우 SVC는 학습 속도가 느려질 수 있습니다.

- 커널 선택. 올바른 커널 함수 선택: 올바른 커널 함수를 선택하는 것은 실험적일 수 있으며 데이터 특성에 따라 달라질 수 있습니다.

- 피처 스케일링에 대한 민감도. 데이터 정규화: SVC는 피처 스케일링에 민감하므로 학습 전에 데이터를 정규화하거나 표준화하는 것이 좋습니다.

- 모델 해석 가능성. 해석의 복잡성: SVC 모델은 비선형 커널과 다양한 지원 벡터를 사용하기 때문에 해석을 하는 것이 복잡할 수 있습니다.

특정의 작업과 데이터 양에 따라 SVC 메서드는 분류 작업을 해결하는 데 강력한 도구가 될 수 있습니다. 그러나 최적의 결과를 얻으려면 그 한계를 고려하고 매개변수를 조정하는 것이 중요합니다.

2.1.1. SVC 분류기 모델 생성 코드

이 코드는 붓꽃 데이터 세트에 대해 SVC 분류기 모델을 학습하고 이를 ONNX 형식으로 내보내고 ONNX 모델을 사용하여 분류를 수행하는 과정을 보여줍니다. 또한 원래 모델과 ONNX 모델 모두의 정확도를 평가합니다.

# Iris_SVCClassifier.py # The code demonstrates the process of training SVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import SVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create an SVC Classifier model with a linear kernel svc_model = SVC(kernel='linear', C=1.0) # train the model on the entire dataset svc_model.fit(X, y) # predict classes for the entire dataset y_pred = svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of SVC Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path +"svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of SVC Classifier model in ONNX format:", accuracy_onnx)

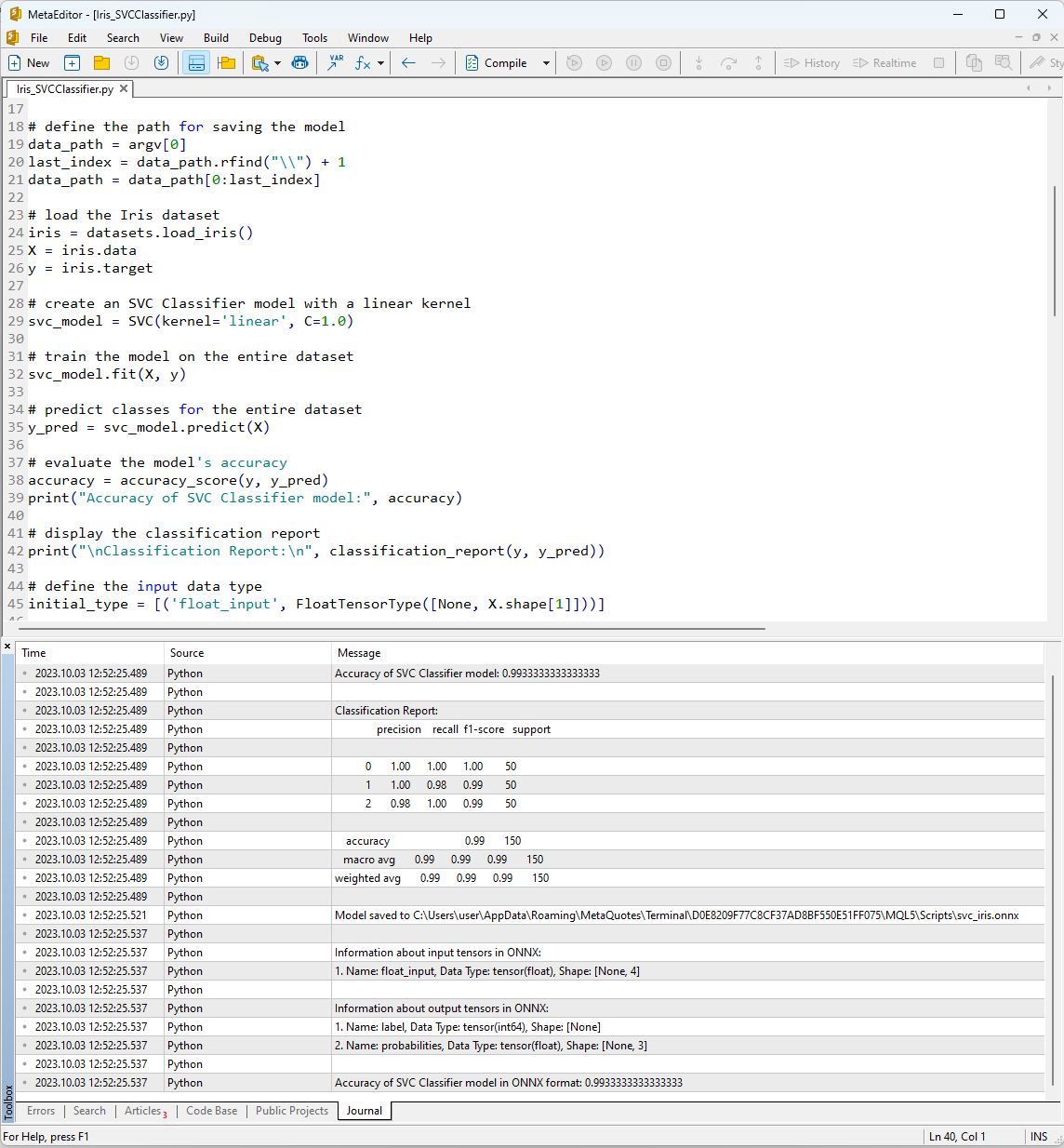

"컴파일" 버튼을 사용하여 MetaEditor에서 스크립트를 실행하면 이후 저널 탭에서 실행 결과를 볼 수 있습니다.

그림 12. MetaEditor에서 Iris_SVMClassifier.py 스크립트 결과

Iris_SVCClassifier.py 스크립트의 출력입니다:

Python SVC 분류기 모델의 정확도: 0.9933333333333333

Python

파이썬 분류 보고서:

파이썬 정밀 리콜 f1 점수 지원

Python

파이썬 0 1.00 1.00 1.00 50

파이썬 1 1.00 0.98 0.99 50

파이썬 2 0.98 1.00 0.99 50

Python

파이썬 정확도 0.99 150

파이썬 매크로 평균 0.99 0.99 0.99 150

파이썬 가중 평균 0.99 0.99 0.99 150

Python

파이썬 모델은 C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\svc_iris.onnx에 저장됩니다.

Python

파이썬 ONNX의 입력 텐서에 대한 정보입니다:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python ONNX의 출력 텐서에 대한 정보입니다:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python ONNX 형식의 SVC 분류기 모델 정확도: 0.9933333333333333

여기에서 ONNX 모델이 저장된 경로, ONNX 모델의 입력 및 출력 매개변수 유형, 붓꽃 데이터 세트 설명의 정확도에 대한 정보를 확인할 수 있습니다.

SVM 분류기를 사용하여 데이터 집합을 설명하는 정확도는 99%이며 ONNX 형식으로 내보낸 모델도 동일한 수준의 정확도를 보여줍니다.

이제 150개의 데이터 샘플 각각에 대해 구성된 모델을 실행하여 MQL5에서 이들 결과를 검증해 보겠습니다. 또한 스크립트에는 일괄 데이터 처리의 예가 포함되어 있습니다.

2.1.2. SVC 분류기 모델 작업을 위한 MQL5 코드

//+------------------------------------------------------------------+ //| Iris_SVCClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="SVCClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

스크립트 실행 결과는 MetaTrader 5 터미널의 "Experts" 탭에 표시됩니다.

Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier correct results: 99.33% Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier all samples accuracy=0.993333 Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier batch test accuracy=1.000000

SVC 모델은 150개 샘플 중 149개를 정확하게 분류했습니다. 이는 매우 우수한 결과입니다. 이 모델은 붓꽃 데이터 세트에서 단 한 번의 분류 오류만 발생했는데 샘플 #84에 대해 클래스 1(버지니카)이 아닌 클래스 2(버지컬러)를 예측했습니다.

전체 붓꽃 데이터 세트에서 내보낸 ONNX 모델의 정확도는 99.33%로 원래 모델의 정확도와 일치한다는 점에 주목할 필요가 있습니다.

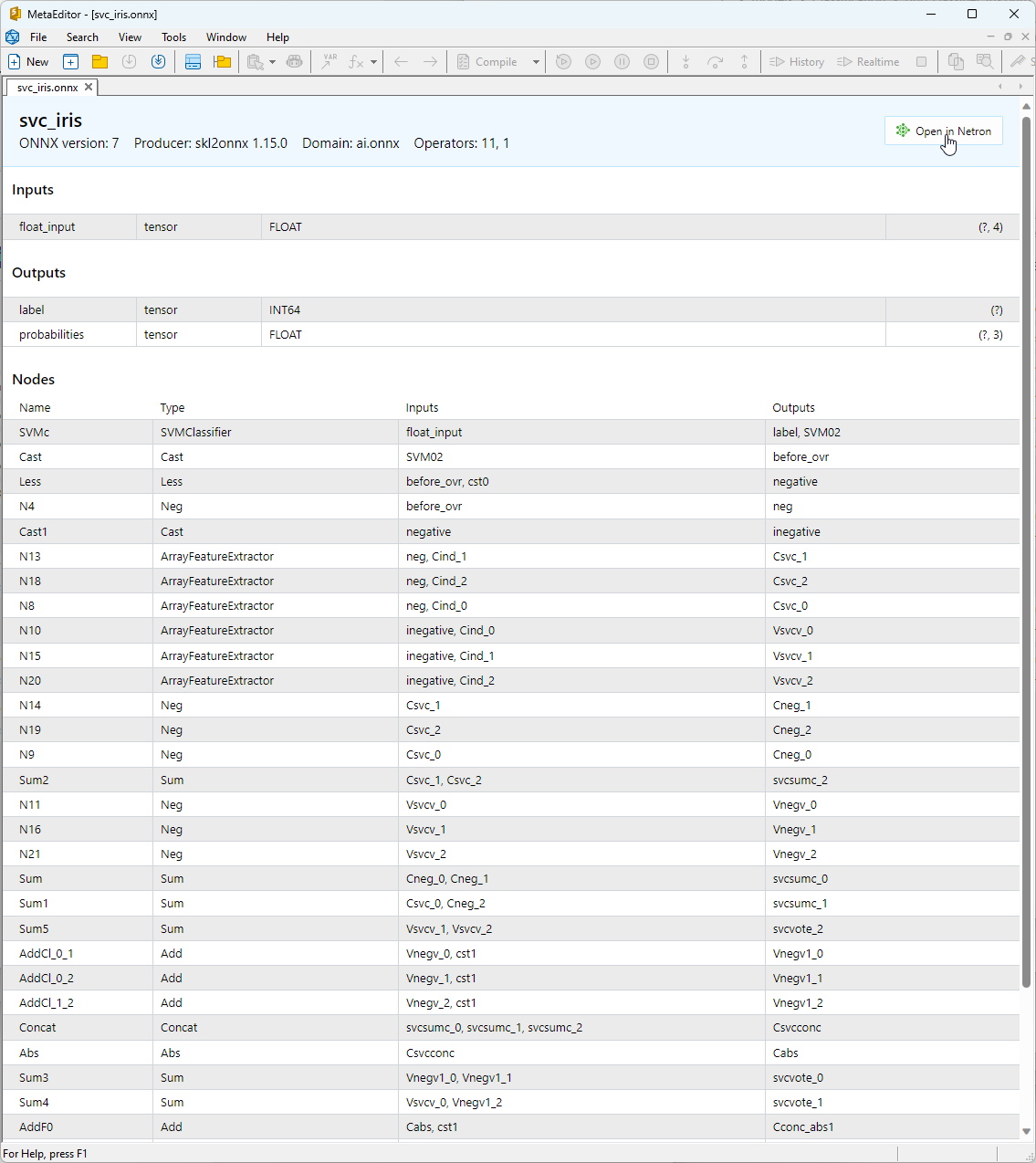

2.1.3. SVC 분류기 모델의 ONNX 표현

MetaEditor에서 빌드된 ONNX 모델을 볼 수 있습니다.

그림 13. MetaEditor의 ONNX 모델 svc_iris.onnx

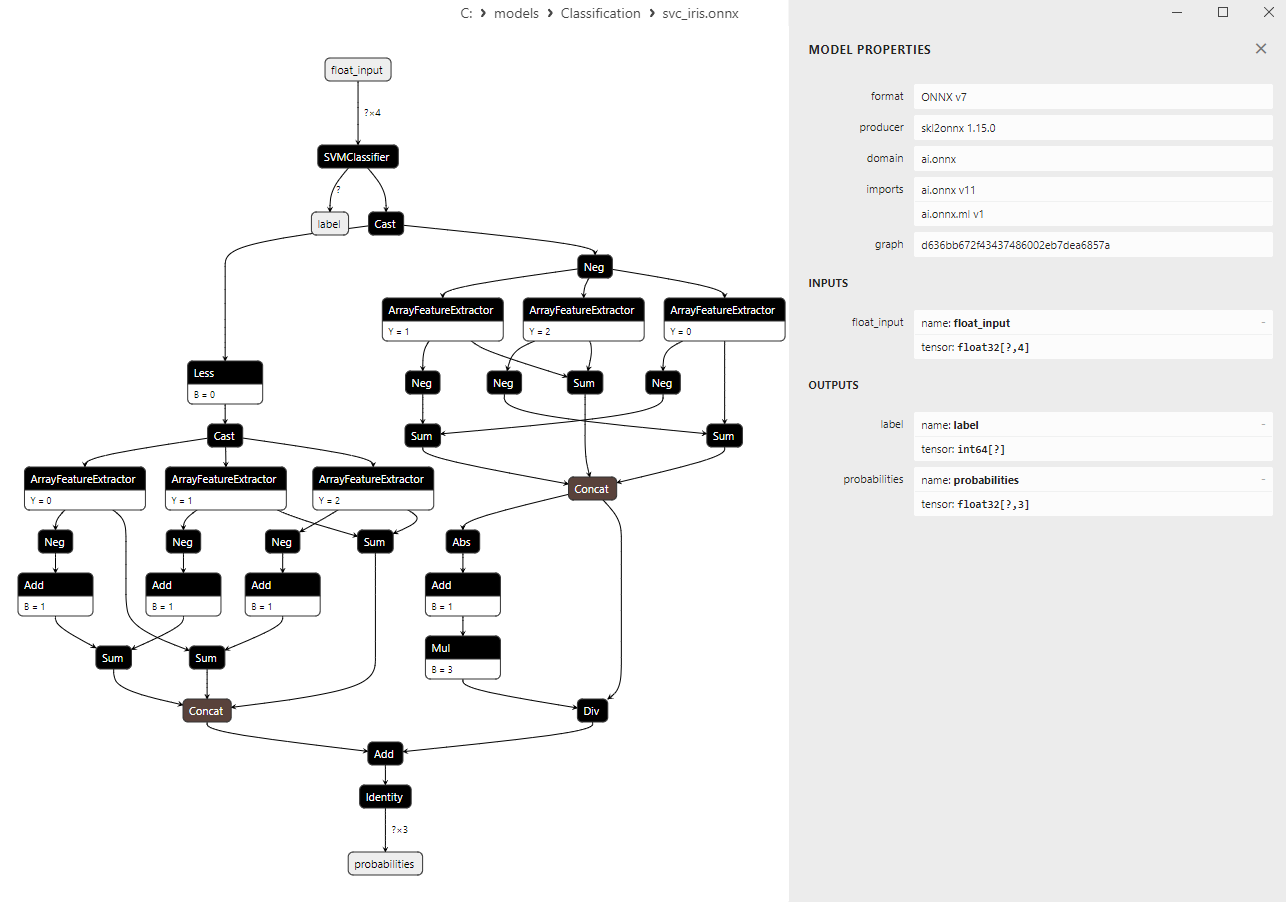

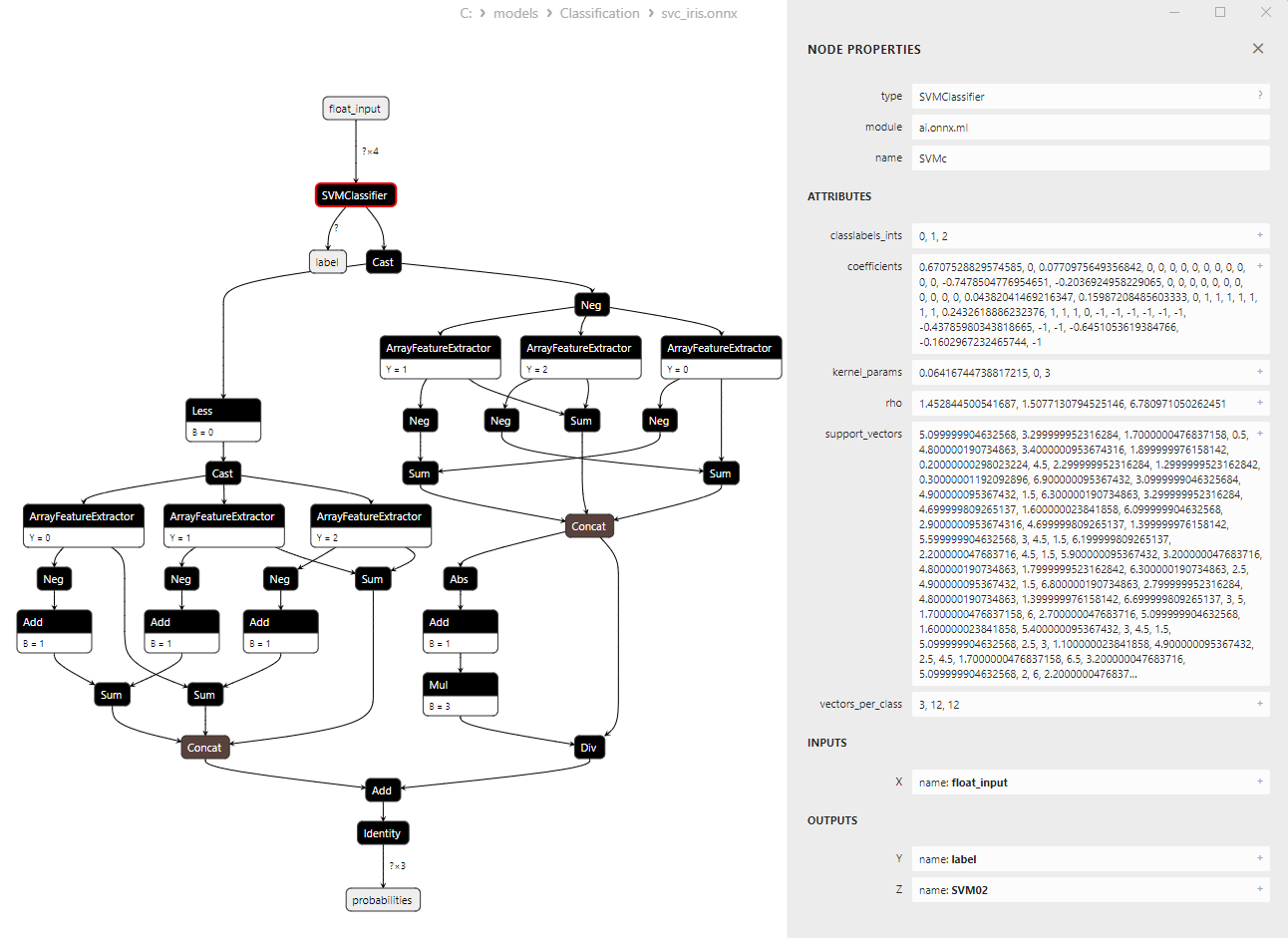

모델 아키텍처에 대한 자세한 내용은 Netron에서 확인할 수 있습니다. 이렇게 하려면 MetaEditor에서 모델 설명의 "네트론에서 열기" 버튼을 클릭합니다.

그림 14. 네트론의 ONNX 모델 svc_iris.onnx

그림 15. 네트론의 ONNX 모델 svc_iris.onnx(SVMClassifier ONNX 연산자 매개변수)

2.2. LinearSVC 분류기

LinearSVC(선형 지원 벡터 분류)는 이진 및 다중 클래스 분류 작업에 사용되는 강력한 머신 러닝 알고리즘입니다. 이는 데이터를 가장 잘 분리하는 초평면을 찾는 아이디어를 기반으로 합니다.

LinearSVC의 원리:

- 최적의 초평면 찾기: LinearSVC의 주요 아이디어는 두 데이터 클래스를 최대한 분리하는 최적의 초평면을 찾는 것입니다. 초평면은 선형 방정식으로 정의된 다차원 평면입니다.

- 마진 최소화: LinearSVC는 여백(데이터 포인트와 초평면 사이의 거리)을 최소화하는 것을 목표로 합니다. 여백이 클수록 초평면이 클래스를 더 효과적으로 구분합니다.

- 선형적으로 분리할 수 없는 데이터 처리: LinearSVC를 통해 데이터를 선형적으로 분리할 수 있는 고차원 공간으로 투영하는 커널 함수(커널 트릭)를 사용하여 원래 피처 공간에서 선형적으로 분리할 수 없는 데이터도 작업할 수 있습니다.

LinearSVC의 장점:

- 일반화: LinearSVC는 일반화 능력이 뛰어나며 보이지 않는 새로운 데이터에 대해서도 일반화를 잘 수행할 수 있습니다.

- 효율성: LinearSVC는 대규모 데이터 세트에서 빠르게 작동하며 상대적으로 적은 컴퓨팅 리소스를 요구 합니다.

- 선형적으로 분리할 수 없는 데이터 처리: 커널 함수를 사용하여 LinearSVC는 선형적으로 분리할 수 없는 데이터로 분류 작업을 처리할 수 있습니다.

- 확장성: LinearSVC는 피처가 많고 데이터 양이 많은 작업에서 효율적으로 사용할 수 있습니다.

LinearSVC의 한계:

- 선형 분리 초평면만 가능합니다: LinearSVC는 선형 분리 초평면만 구성하므로 비선형 종속성이 있는 복잡한 분류 작업에는 불충분할 수 있습니다.

- 매개변수 선택: 올바른 매개변수(예: 정규화 매개변수)를 선택하려면 전문적인 지식이나 교차 검증이 필요할 수 있습니다.

- 이상값에 대한 민감도: LinearSVC는 데이터의 이상값에 민감할 수 있으며 이는 분류 품질에 영향을 미칠 수 있습니다.

- 모델 해석 가능성: LinearSVC를 사용하여 생성된 모델은 다른 메서드에 비해 해석이 어려울 수 있습니다.

LinearSVC는 일반화, 효율성, 선형적으로 분리할 수 없는 데이터를 처리하는 데 탁월한 강력한 분류 알고리즘입니다. 특히 선형 초평면으로 데이터를 분리할 수 있는 경우 다양한 분류 작업에서 응용할 수 있습니다. 그러나 비선형 종속성을 모델링해야 하는 복잡한 작업의 경우 LinearSVC가 적합하지 않을 수 있으며, 이러한 경우 더 복잡한 결정 경계를 가진 대체적인 메서드를 고려해야 합니다.

2.2.1. LinearSVC 분류기 모델 생성 코드

이 코드는 붓꽃 데이터 세트에서 LinearSVC 분류기 모델을 학습하고 이를 ONNX 형식으로 내보내고 ONNX 모델을 사용하여 분류를 수행하는 과정을 보여줍니다. 또한 원래 모델과 ONNX 모델 모두의 정확도를 평가합니다.

# Iris_LinearSVC.py # The code demonstrates the process of training LinearSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import LinearSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a LinearSVC model linear_svc_model = LinearSVC(C=1.0, max_iter=10000) # train the model on the entire dataset linear_svc_model.fit(X, y) # predict classes for the entire dataset y_pred = linear_svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of LinearSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(linear_svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "linear_svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of LinearSVC model in ONNX format:", accuracy_onnx)

출력:

파이썬

파이썬 분류 보고서:

파이썬 정밀 리콜 f1 점수 지원

파이썬

파이썬 0 1.00 1.00 1.00 50

파이썬 1 0.96 0.94 0.95 50

파이썬 2 0.94 0.96 0.95 50

파이썬

파이썬 정확도 0.97 150

파이썬 매크로 평균 0.97 0.97 0.97 150

파이썬 가중 평균 0.97 0.97 0.97 150

파이썬

파이썬 모델은 C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\linear_svc_iris.onnx에 저장됩니다.

파이썬

파이썬 ONNX의 입력 텐서에 대한 정보입니다:

파이썬 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

파이썬

Python ONNX의 출력 텐서에 대한 정보:

파이썬 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

파이썬

Python ONNX 형식의 LinearSVC 모델 정확도: 0.9666666666666667

2.2.2. LinearSVC 분류기 모델 작업을 위한 MQL5 코드

//+------------------------------------------------------------------+ //| Iris_LinearSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "linear_svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="LinearSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

출력:

Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=71 FAILED [class=2, true class=1] features=(5.90,3.20,4.80,1.80] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=85 FAILED [class=2, true class=1] features=(5.40,3.00,4.50,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=130 FAILED [class=1, true class=2] features=(7.20,3.00,5.80,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=134 FAILED [class=1, true class=2] features=(6.30,2.80,5.10,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC correct results: 96.67% Iris_LinearSVC (EURUSD,H1) model=LinearSVC all samples accuracy=0.966667 Iris_LinearSVC (EURUSD,H1) model=LinearSVC batch test accuracy=1.000000

전체 붓꽃 데이터 세트에서 내보낸 ONNX 모델의 정확도는 96.67%로 원래 모델의 정확도와 일치합니다.

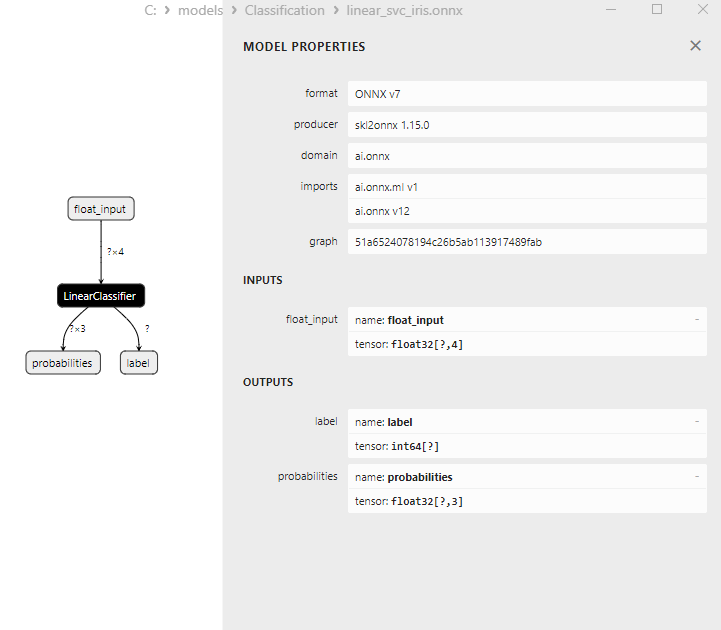

2.2.3. LinearSVC 분류기 모델의 ONNX 표현

그림 16. 네트론에서 리니어SVC 분류기 모델의 ONNX 표현

2.3. NuSVC 분류기

Nu-지원 벡터 분류(NuSVC) 메서드는 서포트 벡터 머신(SVM) 접근법을 기반으로 하는 강력한 머신 러닝 알고리즘입니다.

NuSVC의 원칙:

- SVM(서포트 벡터 머신): NuSVC는 이진 및 다중 클래스 분류 작업에 사용되는 SVM의 변형입니다. SVM의 핵심 원리는 최대한의 마진을 유지하면서 클래스를 최대한 분리하는 최적의 분리 초평면을 찾는 것입니다.

- Nu 파라미터: NuSVC에서 핵심이 되는 파라미터는 모델의 복잡도를 제어하고 지원 벡터 및 오류로 사용할 수 있는 샘플의 비율을 정의하는 Nu 파라미터(nu)입니다. Nu의 값은 0에서 1 사이이며 0.5는 샘플의 약 절반이 지원 벡터와 오류로 사용됨을 의미합니다.

- 매개변수 조정: Nu 매개변수 및 기타 하이퍼파라미터의 최적값을 결정하려면 교차 검증과 학습 데이터에서 최적의 값을 찾아야 할 수 있습니다.

- 커널 함수: NuSVC는 선형, 방사형 기저 함수(RBF), 다항식 등 다양한 커널 함수를 사용할 수 있습니다. 커널 함수는 분리하는 초평면을 찾기 위해 피처 공간을 변환하는 방법을 결정합니다.

NuSVC의 장점:

- 고차원 공간에서의 효율성: NuSVC는 고차원 공간에서 효율적으로 작업할 수 있으므로 피처가 많은 작업에 적합합니다.

- 이상값에 대한 견고성: 특히 SVM과 NuSVC는 서포트 벡터를 사용하기 때문에 데이터의 이상값에 대해 강합니다.

- 모델 복잡성 제어: Nu 매개변수를 사용하면 모델 복잡성을 제어하고 데이터 피팅과 일반화의 균형을 맞출 수 있습니다.

- 좋은 일반화: 특히 SVM과 NuSVC는 일반화에 특출납니다. 그러므로 이전에는 볼 수 없었던 새로운 데이터에 대해 뛰어난 성능을 발휘합니다.

NuSVC의 한계:

- 대용량 데이터에서의 비효율성: NuSVC는 계산 복잡성으로 인해 대량의 데이터에 대해 학습할 때 비효율적일 수 있습니다.

- 매개변수 조정이 필요합니다: Nu 매개변수와 커널 함수를 조정하려면 상당한 시간과 컴퓨팅 리소스가 필요할 수 있습니다.

- 커널 함수 선형성: NuSVC의 효과는 커널 기능의 선택에 따라 크게 달라질 수 있으며 일부 작업의 경우 다른 함수들로 실험해야 할 수도 있습니다.

- 모델 해석 가능성: SVM과 NuSVC는 뛰어난 결과를 제공하지만 특히 비선형 커널을 사용하는 경우 모델을 해석을 하는것이 복잡할 수 있습니다.

Nu-지원 벡터 분류(NuSVC)는 이상값에 대한 견고성과 우수한 일반화 등 여러 가지 장점을 가진 SVM 기반의 강력한 분류 메서드입니다. 그러나 그 효과는 매개변수 및 커널 함수 선택에 따라 달라지며 대용량 데이터의 경우 비효율적일 수 있습니다. 여러분은 매개변수를 신중하게 선택하고 특정 분류 작업에 맞게 메서드를 조정하는 것이 중요합니다.

2.3.1. NuSVC 분류기 모델 생성 코드

이 코드는 붓꽃 데이터 세트에서 NuSVC 분류기 모델을 학습하고 이를 ONNX 형식으로 내보내고 ONNX 모델을 사용하여 분류를 수행하는 과정을 보여줍니다. 또한 원래 모델과 ONNX 모델 모두의 정확도를 평가합니다.

# Iris_NuSVC.py # The code demonstrates the process of training NuSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import NuSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a NuSVC model nusvc_model = NuSVC(nu=0.5, kernel='linear') # train the model on the entire dataset nusvc_model.fit(X, y) # predict classes for the entire dataset y_pred = nusvc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of NuSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(nusvc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "nusvc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of NuSVC model in ONNX format:", accuracy_onnx)

출력:

파이썬

파이썬 분류 보고서:

파이썬 정밀 리콜 f1 점수 지원

파이썬

파이썬 0 1.00 1.00 1.00 50

파이썬 1 0.96 0.96 0.96 50

파이썬 2 0.96 0.96 0.96 50

파이썬

파이썬 정확도 0.97 150

파이썬 매크로 평균 0.97 0.97 0.97 150

파이썬 가중 평균 0.97 0.97 0.97 150

파이썬

파이썬 모델은 C:\사용자\사용자\앱데이터\로밍\MetaQuotes\터미널\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\스크립트\nusvc_iris.onnx에 저장됩니다.

파이썬

파이썬 ONNX의 입력 텐서에 대한 정보입니다:

파이썬 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

파이썬

Python ONNX의 출력 텐서에 대한 정보:

파이썬 1. Name: label, Data Type: tensor(int64), Shape: [None]

파이썬 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

파이썬

Python ONNX 형식의 NuSVC 모델 정확도: 0.9733333333333334

2.3.2. NuSVC 분류기 모델 작업을 위한 MQL5 코드

//+------------------------------------------------------------------+ //| Iris_NuSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "nusvc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="NuSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

출력:

Iris_NuSVC (EURUSD,H1) model:NuSVC sample=78 FAILED [class=2, true class=1] features=(6.70,3.00,5.00,1.70] Iris_NuSVC (EURUSD,H1) model:NuSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_NuSVC (EURUSD,H1) model:NuSVC sample=107 FAILED [class=1, true class=2] features=(4.90,2.50,4.50,1.70] Iris_NuSVC (EURUSD,H1) model:NuSVC sample=139 FAILED [class=1, true class=2] features=(6.00,3.00,4.80,1.80] Iris_NuSVC (EURUSD,H1) model:NuSVC correct results: 97.33% Iris_NuSVC (EURUSD,H1) model=NuSVC all samples accuracy=0.973333 Iris_NuSVC (EURUSD,H1) model=NuSVC batch test accuracy=1.000000

전체 붓꽃 데이터 세트에서 내보낸 ONNX 모델의 정확도는 97.33%로 원래 모델의 정확도와 일치합니다.

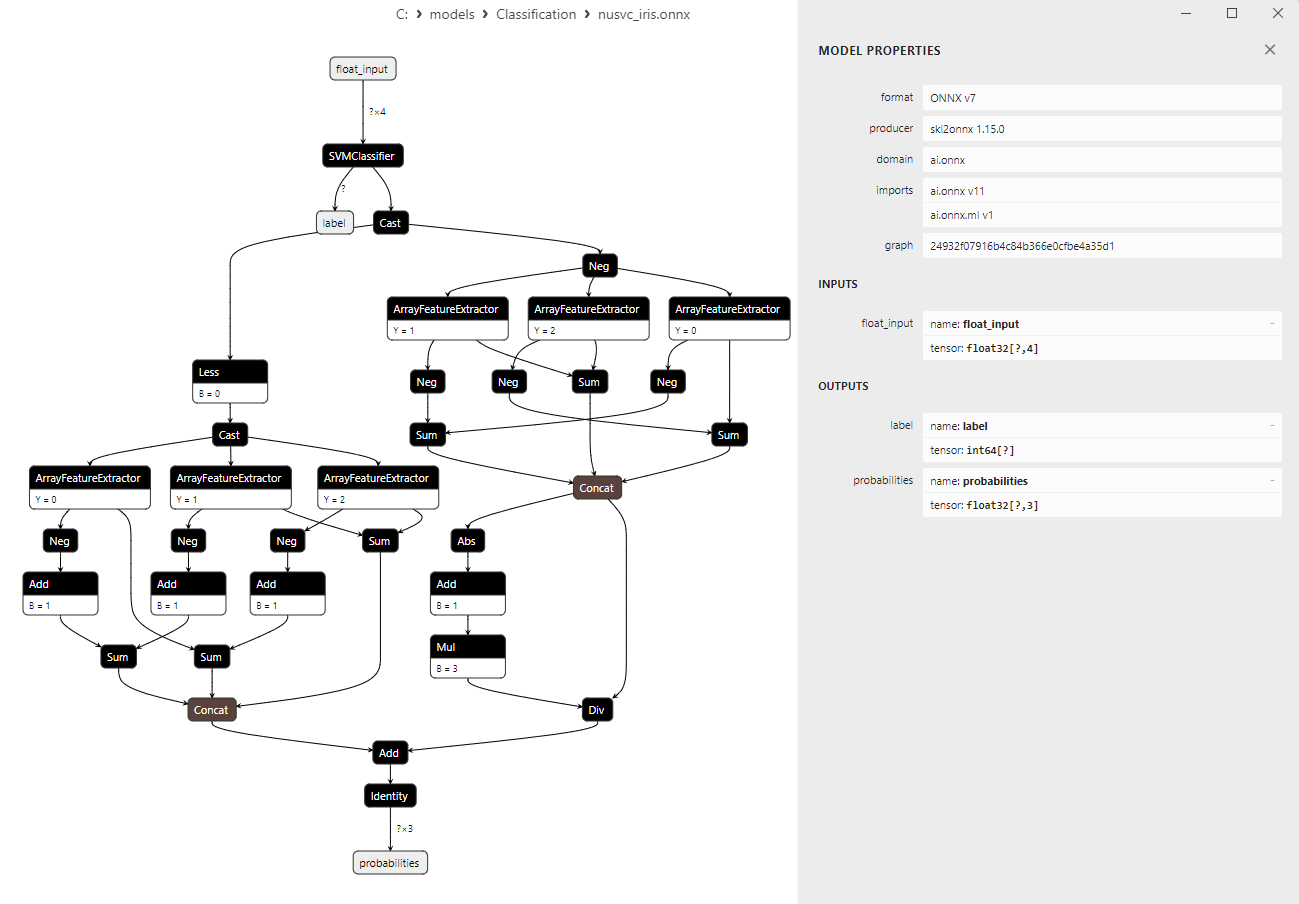

2.3.3. NuSVC 분류기 모델의 ONNX 표현

그림 17. 트론에서 NuSVC 분류기 모델의 ONNX 표현

2.4. 반경 이웃 분류기

반경 이웃 분류기는 객체 간 근접성의 원리를 기반으로 분류 작업에 사용되는 머신 러닝 메서드입니다. 고정된 수의 가장 가까운 이웃(K)이 선택되는 기존의 K-NN(K-Nearest Neighbors) 분류기와 달리 반경 이웃 분류기에서는 지정된 반경 내에서 가장 가까운 이웃과의 거리를 기준으로 객체를 분류합니다.반경 이웃 분류기의 원리:

- 반경 결정하기: 반경 이웃 분류기의 주요 매개변수는 반경으로 이웃 클래스에 가까운 것으로 간주될 수 있는 객체와 이웃 클래스 사이의 최대 거리를 정의합니다.

- 가장 가까운 이웃 찾기: 학습 데이터 세트의 다른 모든 객체와의 거리는 각 객체에 대해 계산됩니다. 지정된 반경 내에 위치한 객체는 객체의 이웃으로 간주됩니다.

- 투표: 반경 이웃 분류기는 이웃 간의 다수결 투표를 사용하여 객체의 클래스를 결정합니다. 예를 들어 대부분의 이웃이 클래스 A에 속하는 경우 해당 객체도 클래스 A로 분류됩니다.

- 데이터 밀도에 대한 적응성: 반경 이웃 분류기는 다양한 피처 공간 영역의 데이터 밀도가 다를 수도 있는 작업에 적합합니다.

- 다양한 클래스 모양으로 작업할 수 있습니다: 이 메서드는 클래스가 복잡하고 비선형적인 모양을 가진 작업에서 잘 수행됩니다.

- 이상값이 있는 데이터에 적합합니다: 반경 이웃 분류기는 지정된 반경 너머에 위치한 이웃을 무시하기 때문에 K-NN보다 이상값에 더 강력합니다.

- 반경 선택에 대한 민감도: 최적의 반경 값을 선택하는 것은 간단한 작업이 아니며 조정이 필요할 수 있습니다.

- 대규모 데이터 세트에서의 비효율성: 대규모 데이터 세트의 경우 모든 객체까지의 거리를 계산하면 계산 비용이 많이 들 수 있습니다.

- 데이터 밀도에 따른 의존성: 이 메서드는 피처 공간에서 데이터의 밀도가 균일하지 않은 경우 효율성이 떨어질 수 있습니다.

반경 이웃 분류기는 객체 근접성이 중요하고 클래스 모양이 복잡할 수 있는 상황에서 유용한 머신 러닝 메서드이며 이미지 분석, 자연어 처리 등 다양한 영역에 적용할 수 있습니다.

2.4.1. 반경 이웃 분류기 모델을 생성하는 코드

이 코드는 붓꽃 데이터 세트에서 반경 이웃 분류기 모델을 훈련하고 이를 ONNX 형식으로 내보내고 ONNX 모델을 사용하여 분류를 수행하는 과정을 보여줍니다. 또한 원래 모델과 ONNX 모델 모두의 정확도를 평가합니다.

# Iris_RadiusNeighborsClassifier.py # The code demonstrates the process of training an Radius Neughbors model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023 MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.neighbors import RadiusNeighborsClassifier from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a Radius Neighbors Classifier model radius_model = RadiusNeighborsClassifier(radius=1.0) # train the model on the entire dataset radius_model.fit(X, y) # predict classes for the entire dataset y_pred = radius_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of Radius Neighbors Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(radius_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "radius_neighbors_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of Radius Neighbors Classifier model in ONNX format:", accuracy_onnx)

스크립트 Iris_RadiusNeighbors.py의 결과입니다:

파이썬

파이썬 분류 보고서:

파이썬 정밀 리콜 f1 점수 지원

파이썬

파이썬 0 1.00 1.00 1.00 50

파이썬 1 0.94 0.98 0.96 50

파이썬 2 0.98 0.94 0.96 50

파이썬

파이썬 정확도 0.97 150

파이썬 매크로 평균 0.97 0.97 0.97 150

파이썬 가중 평균 0.97 0.97 0.97 150

파이썬

파이썬 모델은 C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\radius_neighbors_iris.onnx에 저장됩니다.

파이썬

파이썬 ONNX의 입력 텐서에 대한 정보입니다:

파이썬 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

파이썬

Python ONNX의 출력 텐서에 대한 정보:

파이썬 1. Name: label, Data Type: tensor(int64), Shape: [None]

파이썬 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

파이썬

Python 반경 이웃 분류기 모델의 정확도(ONNX 형식): 0.9733333333333334

원래 모델의 정확도와 ONNX 형식으로 내보낸 모델의 정확도는 동일합니다.

2.4.2. 반경 이웃 분류기 모델 작업을 위한 MQL5 코드

//+------------------------------------------------------------------+ //| Iris_RadiusNeighborsClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "radius_neighbors_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="RadiusNeighborsClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

출력:

Iris_RadiusNeighborsClassifier (EURUSD,H1) model:RadiusNeighborsClassifier sample=78 FAILED [class=2, true class=1] features=(6.70,3.00,5.00,1.70] Iris_RadiusNeighborsClassifier (EURUSD,H1) model:RadiusNeighborsClassifier sample=107 FAILED [class=1, true class=2] features=(4.90,2.50,4.50,1.70] Iris_RadiusNeighborsClassifier (EURUSD,H1) model:RadiusNeighborsClassifier sample=127 FAILED [class=1, true class=2] features=(6.20,2.80,4.80,1.80] Iris_RadiusNeighborsClassifier (EURUSD,H1) model:RadiusNeighborsClassifier sample=139 FAILED [class=1, true class=2] features=(6.00,3.00,4.80,1.80] Iris_RadiusNeighborsClassifier (EURUSD,H1) model:RadiusNeighborsClassifier correct results: 97.33% Iris_RadiusNeighborsClassifier (EURUSD,H1) model=RadiusNeighborsClassifier all samples accuracy=0.973333 Iris_RadiusNeighborsClassifier (EURUSD,H1) model=RadiusNeighborsClassifier batch test accuracy=1.000000

반경 이웃 분류기 모델은 4개의 분류 오류(샘플 78, 107, 127, 139)로 97.33%의 정확도를 보였습니다.

전체 붓꽃 데이터 세트에서 내보낸 ONNX 모델의 정확도는 97.33%로 원래 모델의 정확도와 일치합니다.

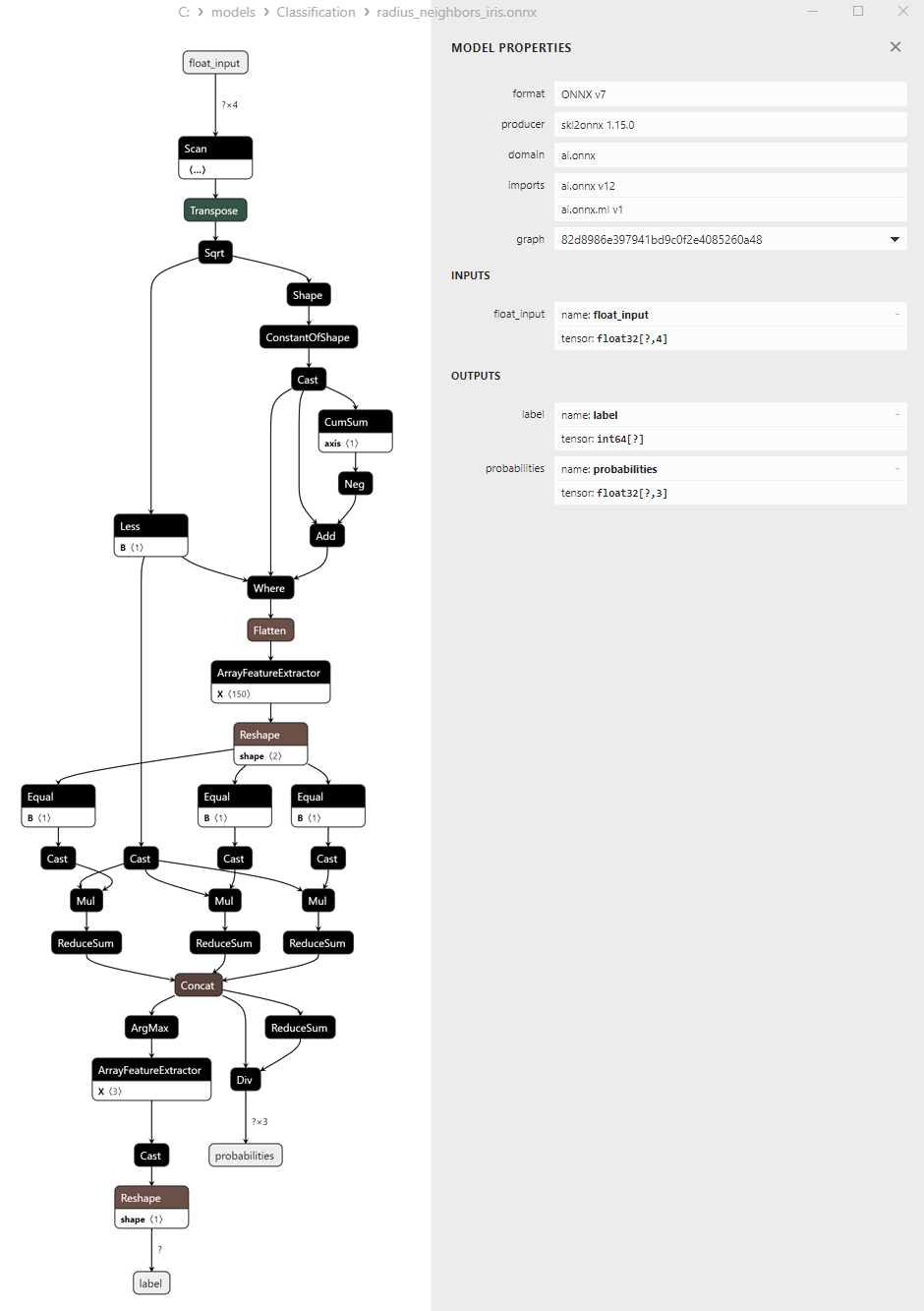

2.4.3.반경 이웃 분류기 모델의 ONNX 표현

그림 18. 네트론에서 반경 이웃 분류기의 ONNX 표현

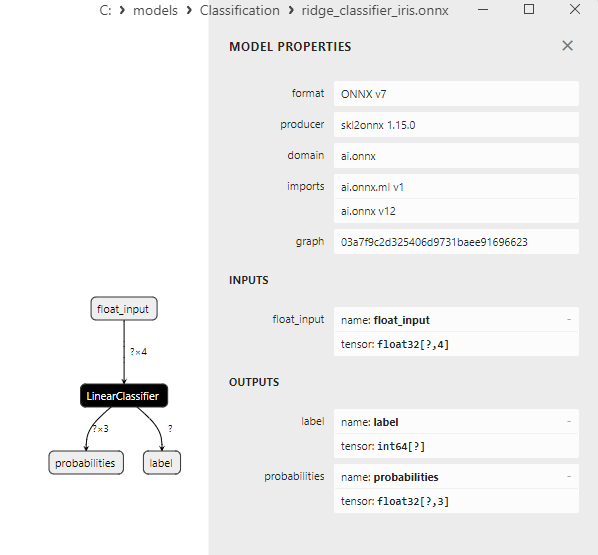

RidgeClassifier 및 RidgeClassifierCV 메서드에 대한 참고 사항