Modelos de regressão da biblioteca Scikit-learn e sua exportação para ONNX

ONNX (Open Neural Network Exchange) é um formato para descrever e trocar modelos de aprendizado de máquina, proporcionando a capacidade de transferir modelos entre diferentes frameworks de aprendizado de máquina. Em aprendizado profundo e redes neurais, tipos de dados como float32 são frequentemente usados. Eles são amplamente aplicados porque geralmente oferecem precisão e eficiência aceitáveis para o treinamento de modelos de aprendizado profundo.

Alguns modelos clássicos de aprendizado de máquina são difíceis de representar como operadores ONNX. Portanto, operadores adicionais ML operators (ai.onnx.ml) foram introduzidos para implementá-los no ONNX. Vale notar que, de acordo com a especificação ONNX, os operadores chave nesse conjunto (LinearRegressor, SVMRegressor, TreeEnsembleRegressor) podem aceitar vários tipos de dados de entrada (tensor(float), tensor(double), tensor(int64), tensor(int32)), mas sempre retornam o tipo tensor(float) como saída. A parametrização desses operadores também é realizada usando números de ponto flutuante, o que pode limitar a precisão dos cálculos, especialmente se números de precisão dupla forem usados para definir os parâmetros do modelo original.

Isso pode levar a uma perda de precisão ao converter modelos ou usar diferentes tipos de dados no processo de conversão e processamento de dados em ONNX. Muito depende do conversor, como veremos mais adiante; alguns modelos conseguem contornar essas limitações e garantir total portabilidade dos modelos ONNX, permitindo trabalhar com eles em precisão dupla sem perder precisão. É importante considerar essas características ao trabalhar com modelos e sua representação em ONNX, especialmente em casos onde a precisão da representação de dados é importante.

Scikit-learn é uma das bibliotecas mais populares e amplamente utilizadas para aprendizado de máquina na comunidade Python. Ela oferece uma ampla gama de algoritimos, uma inrterface amigável e uma boa documentação O artigo anterior, "Modelos de Classificação da Biblioteca Scikit-learn e Sua Exportação para ONNX", abordou modelos de classificação.

Neste artigo, exploraremos a aplicação de modelos de regressão no pacote Scikit-learn, calcularemos seus parâmetros com precisão dupla para o conjunto de dados de teste, tentaremos convertê-los para o formato ONNX para precisão float e double, e usaremos os modelos obtidos em programas no MQL5. Além disso, compararemos a precisão dos modelos originais e suas versões ONNX para precisão float e double. Além disso, examinaremos a representação ONNX dos modelos de regressão, o que proporcionará uma melhor compreensão de sua estrutura interna e operação.

Conteúdo

- Se isso te incomoda, sinta-se à vontade para contribuir

- 1. Conjunto de Dados de Teste

O script para exibir o conjunto de dados de teste - 2. Modelo de Regressão

2.0. Lista de Modelos de Regressão do Scikit-learn - 2.1. Modelos de Regressão do Scikit-learn que se convertem para modelos ONNX float e double

- 2.1.1. sklearn.linear_model.ARDRegression

2.1.1.1. Código para criar o ARDRegression

2.1.1.2. Código MQL5 para executar Modelos ONNX

2.1.1.3. Representação ONNX do ard_regression_float.onnx e ard_regression_double.onnx - 2.1.2. sklearn.linear_model.BayesianRidge

2.1.2.1. Código para criar o modelo BayesianRidge e exportá-lo para ONNX em float e double

2.1.2.2. Código MQL5 para executar Modelos ONNX

2.1.2.3. Representação ONNX do bayesian_ridge_float.onnx e bayesian_ridge_double.onnx - 2.1.3. sklearn.linear_model.ElasticNet

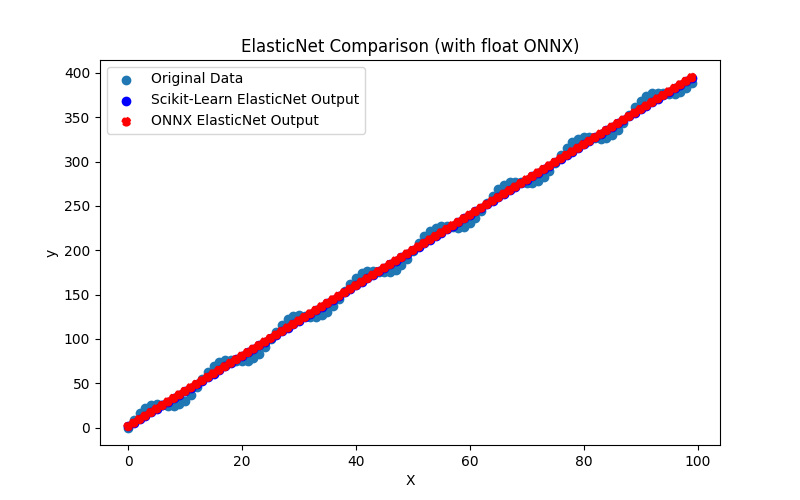

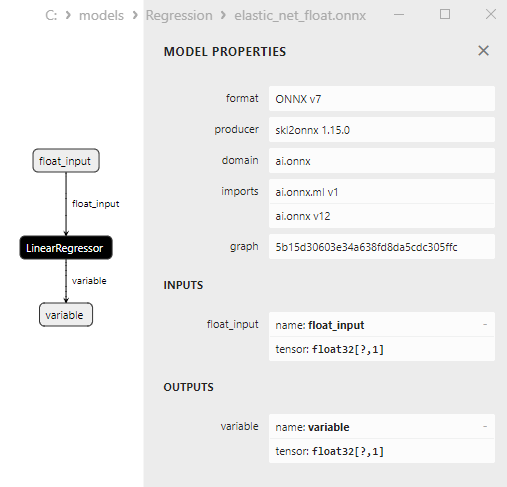

2.1.3.1. Código para criar o modelo ElasticNet e exportá-lo para ONNX em float e double

2.1.3.2. Código MQL5 para executar Modelos ONNX

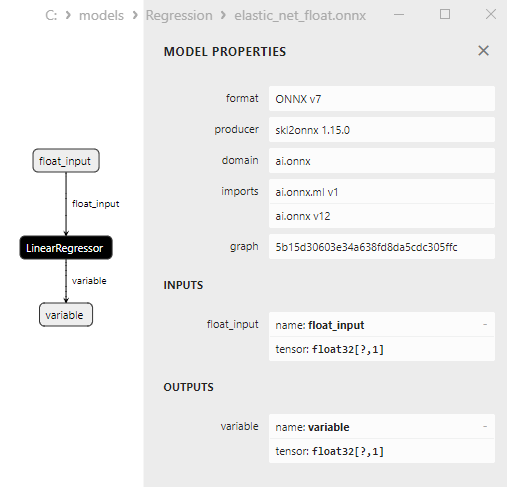

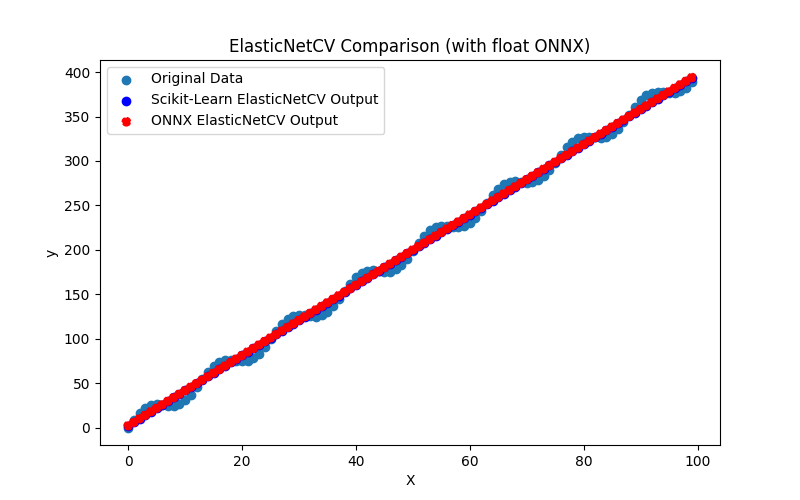

2.1.3.3. Representação ONNX do elastic_net_float.onnx e elastic_net_double.onnx - 2.1.4. sklearn.linear_model.ElasticNetCV

2.1.4.1. Código para criar o modelo ElasticNet e exportá-lo para ONNX em float e double

2.1.4.2. Código MQL5 para executar Modelos ONNX

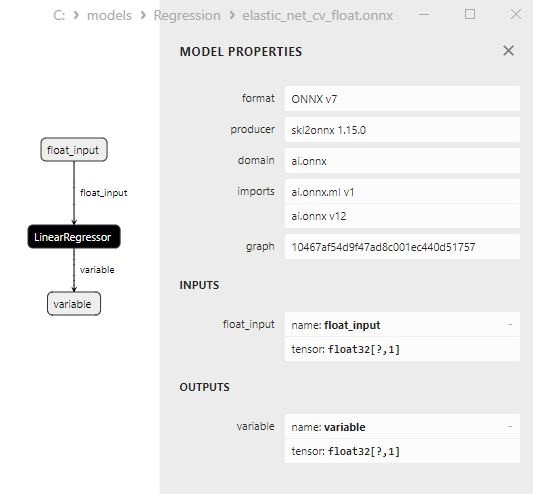

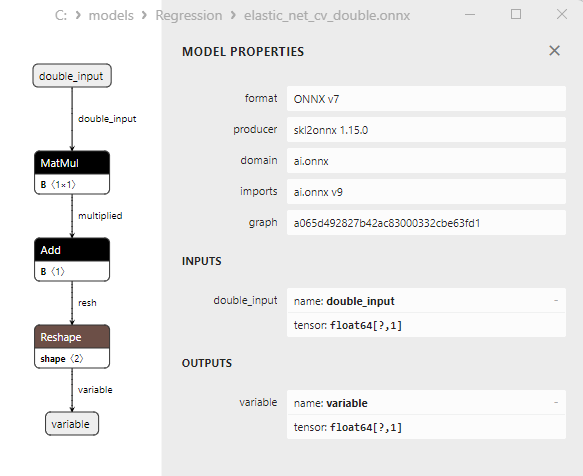

2.1.4.3. Representação ONNX do elastic_net_cv_float.onnx e elastic_net_cv_double.onnx - 2.1.5. sklearn.linear_model.HuberRegressor

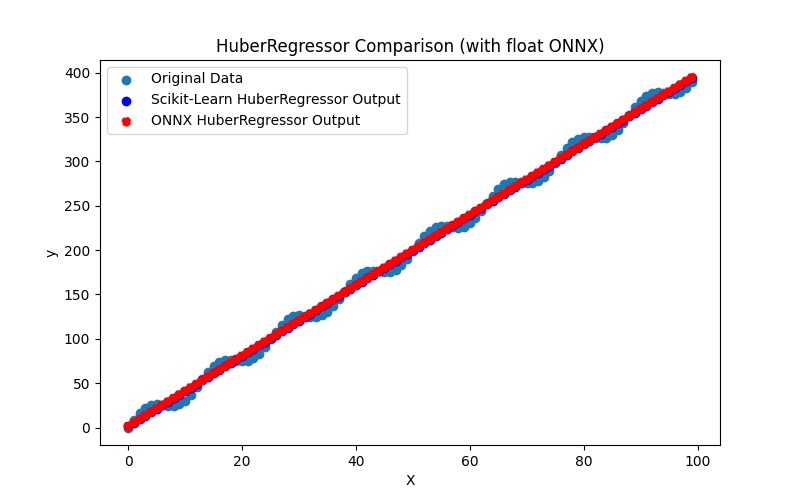

2.1.5.1. Código para criar o modelo HuberRegressor e exportá-lo para ONNX em float e double

2.1.5.2. Código MQL5 para executar Modelos ONNX

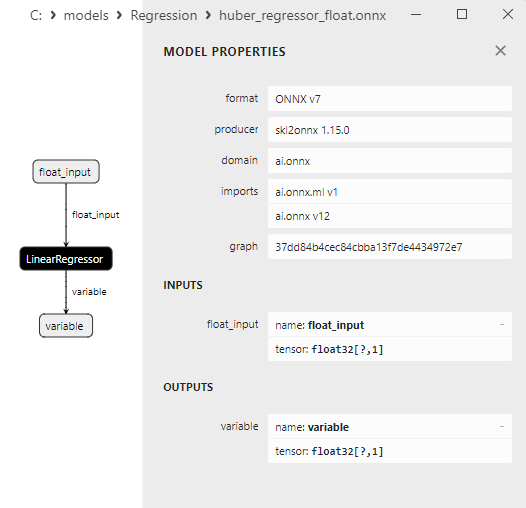

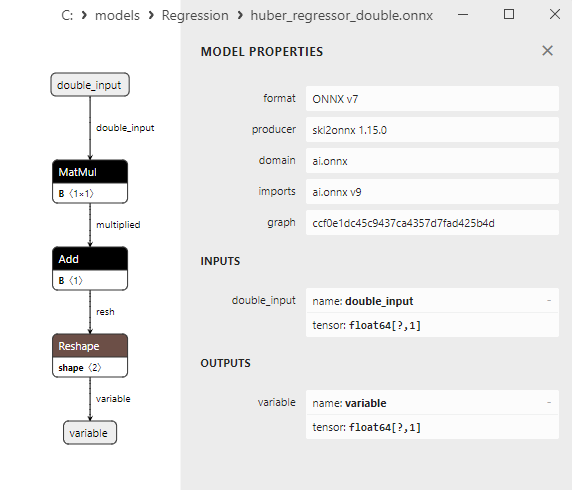

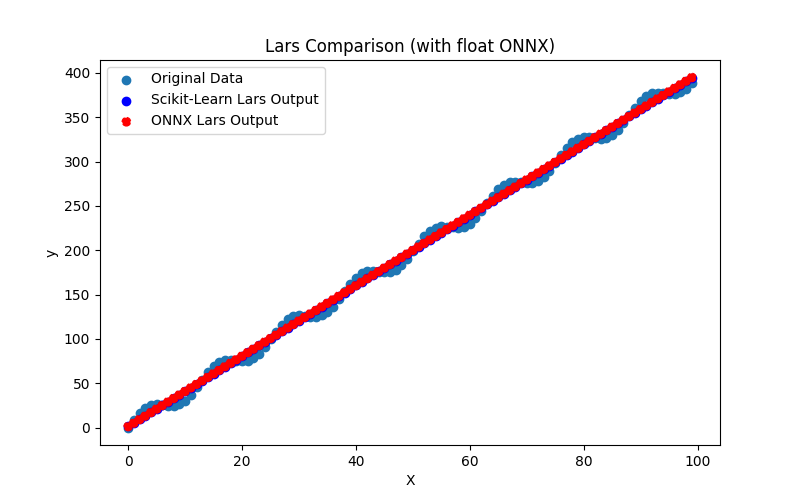

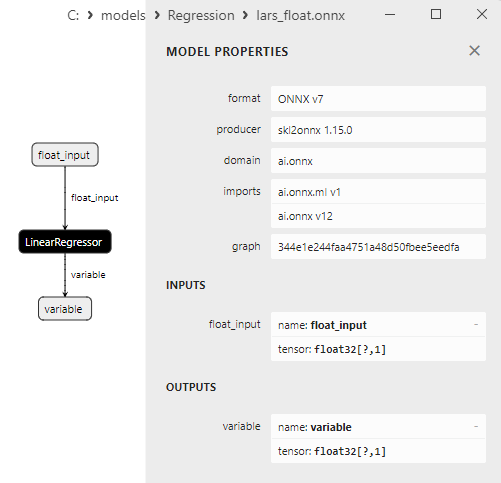

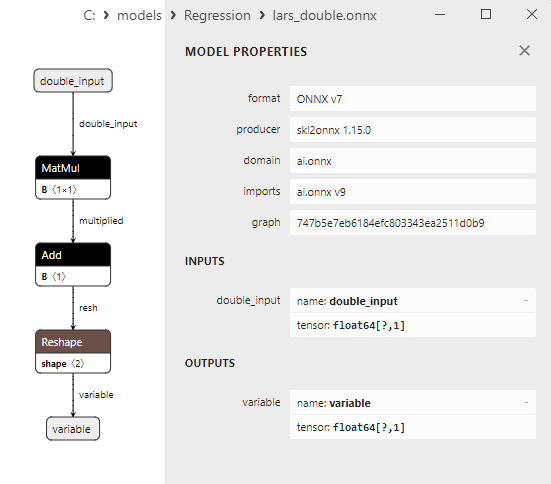

2.1.5.3. Representação ONNX do huber_regressor_float.onnx e huber_regressor_double.onnx - 2.1.6. sklearn.linear_model.Lars

2.1.6.1. Código para criar o modelo Lars e exportá-lo para ONNX em float e double

2.1.6.2. Código MQL5 para executar Modelos ONNX

2.1.6.3. Representação ONNX do lars_float.onnx e lars_double.onnx - 2.1.7. sklearn.linear_model.LarsCV

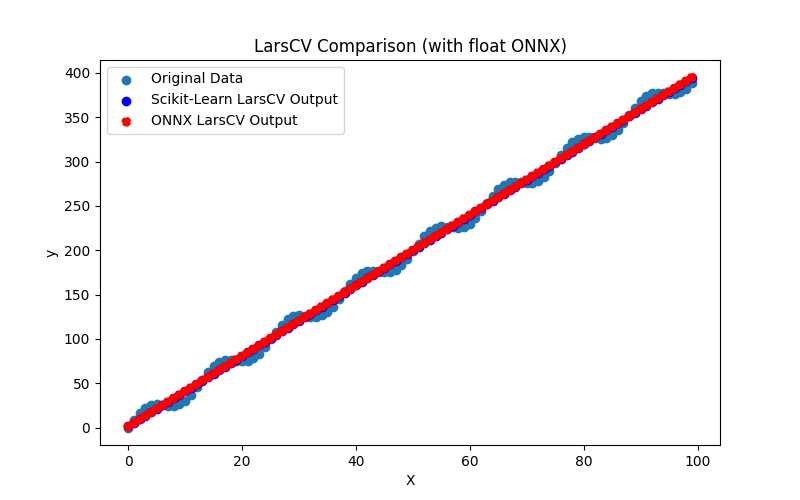

2.1.7.1. Código para criar o modelo LarsCV e exportá-lo para ONNX em float e double

2.1.7.2. Código MQL5 para executar Modelos ONNX

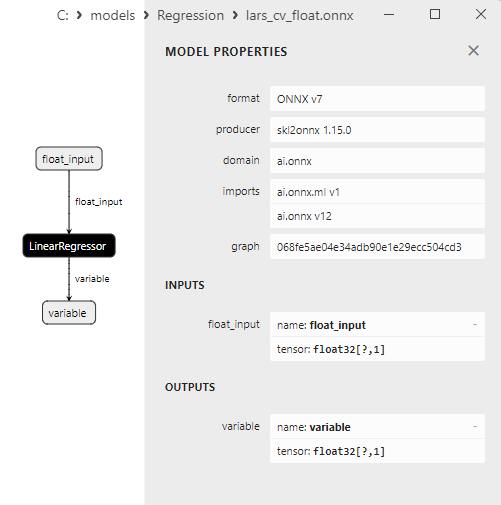

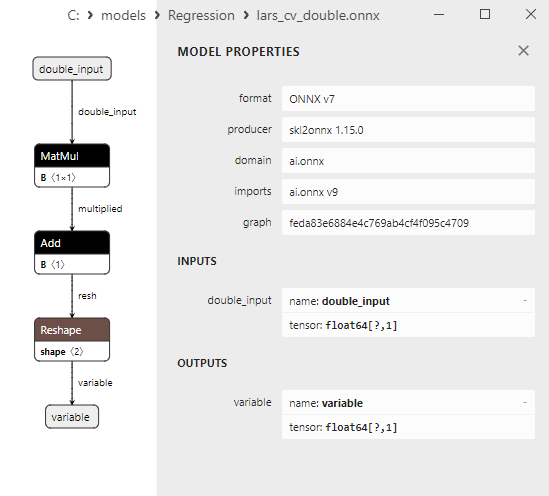

2.1.7.3. Representação ONNX do lars_cv_float.onnx e lars_cv_double.onnx - 2.1.8. sklearn.linear_model.Lasso

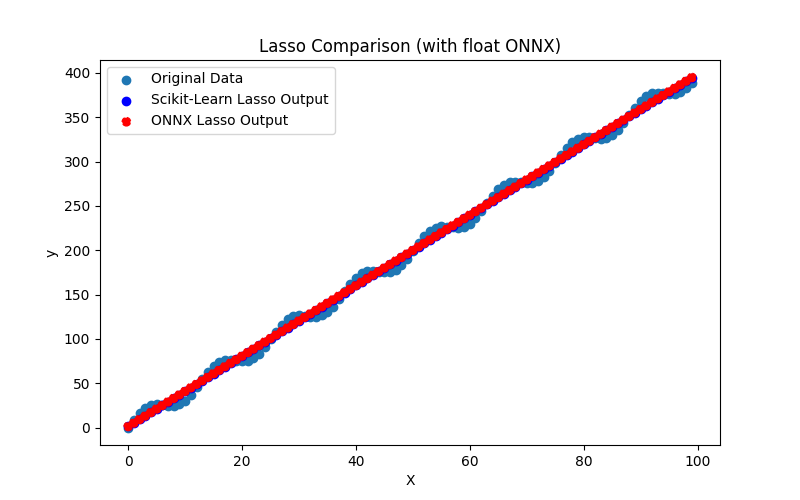

2.1.8.1. Código para criar o modelo Lasso e exportá-lo para ONNX em float e double

2.1.8.2. Código MQL5 para executar Modelos ONNX

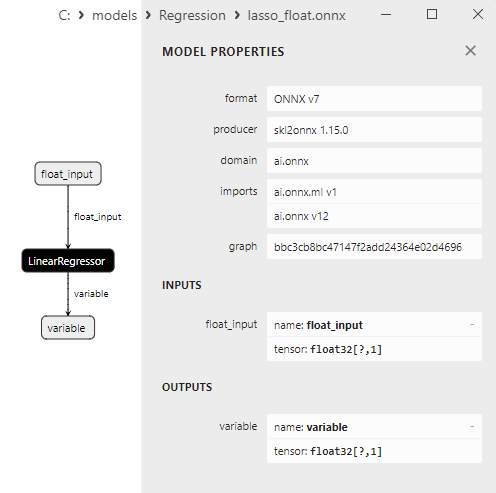

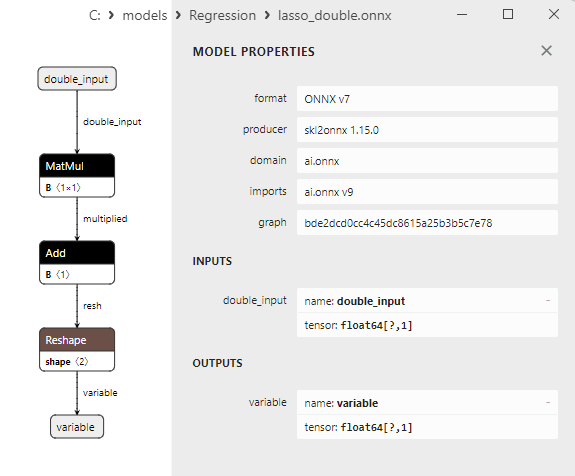

2.1.8.3. Representação ONNX do lasso_float.onnx e lasso_double.onnx - 2.1.9. sklearn.linear_model.LassoCV

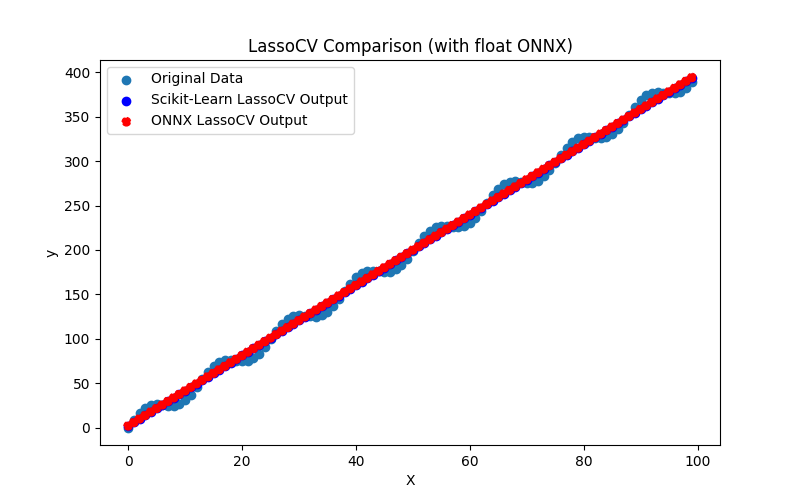

2.1.9.1. Código para criar o modelo LassoCV e exportá-lo para ONNX em float e double

2.1.9.2. Código MQL5 para executar Modelos ONNX

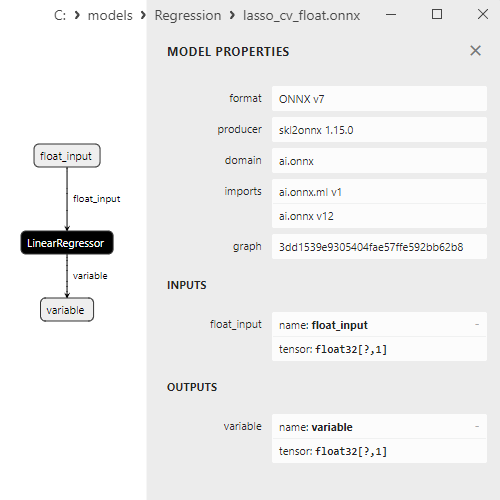

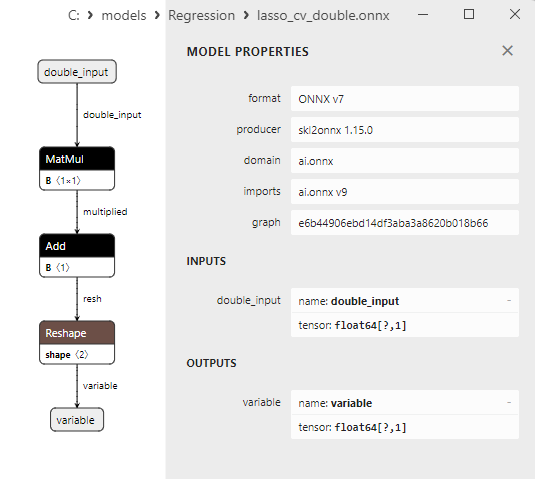

2.1.9.3. Representação ONNX do lasso_cv_float.onnx e lasso_cv_double.onnx - 2.1.10. sklearn.linear_model.LassoLars

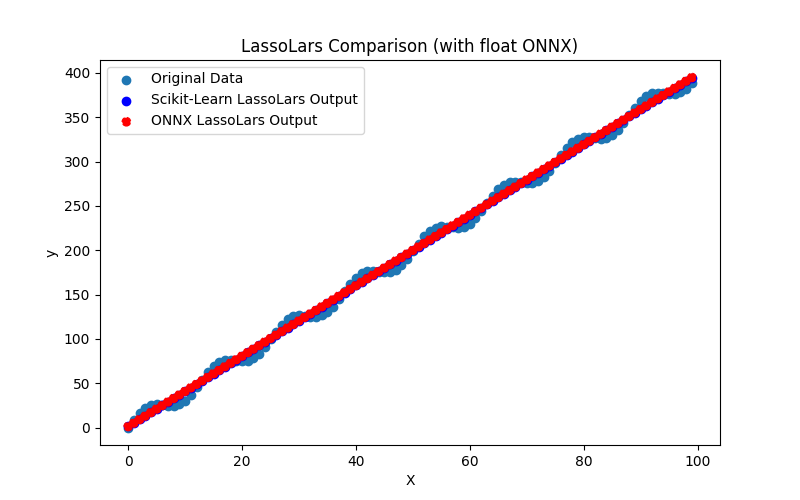

2.1.10.1. Código para criar o modelo LassoLars e exportá-lo para ONNX em float e double

2.1.10.2. Código MQL5 para executar Modelos ONNX

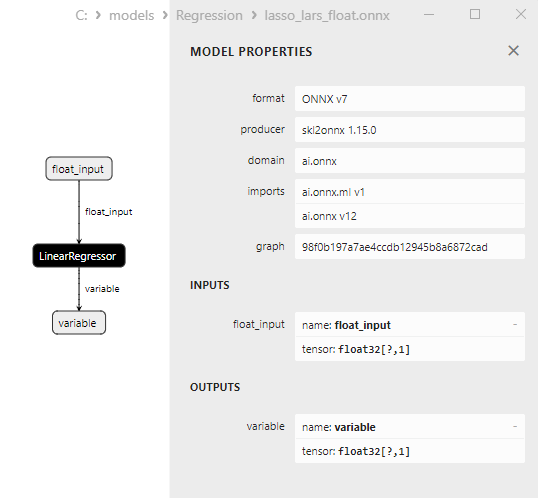

2.1.10.3. Representação ONNX do lasso_lars_float.onnx e lasso_lars_double.onnx - 2.1.11. sklearn.linear_model.LassoLarsCV

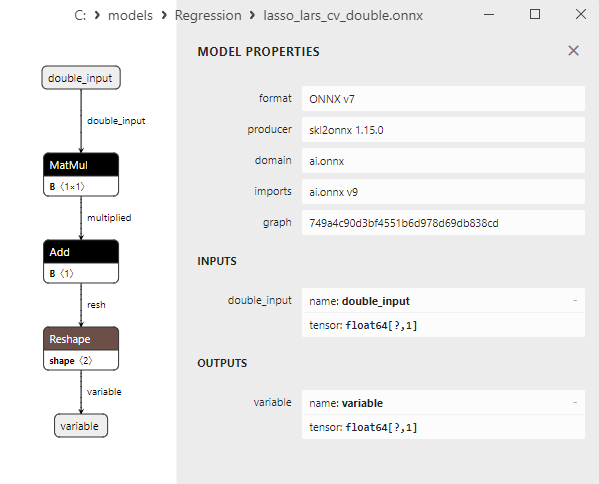

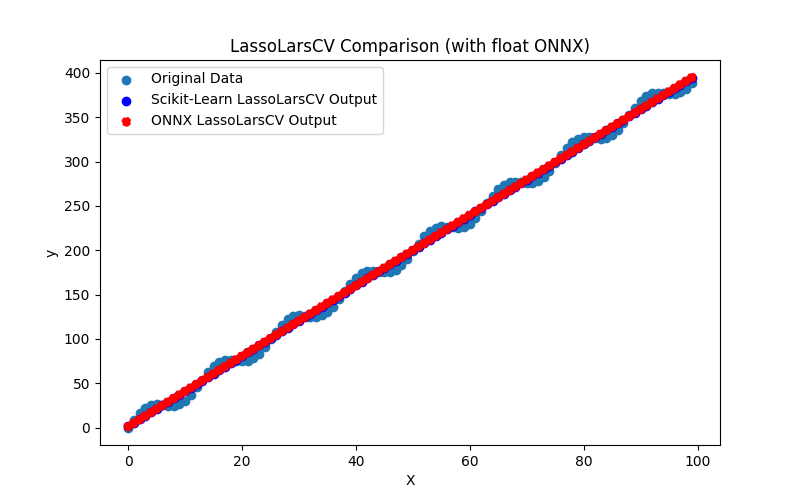

2.1.11.1. Código para criar o modelo LassoLarsCV e exportá-lo para ONNX em float e double

2.1.11.2. Código MQL5 para executar Modelos ONNX

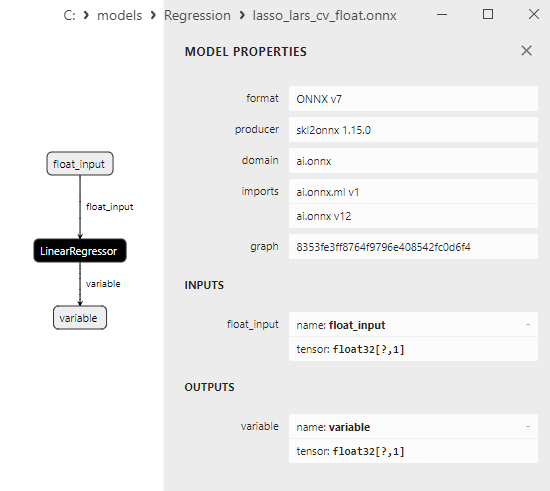

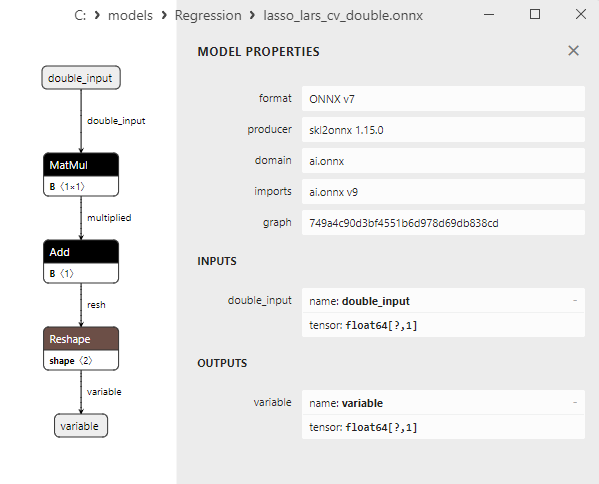

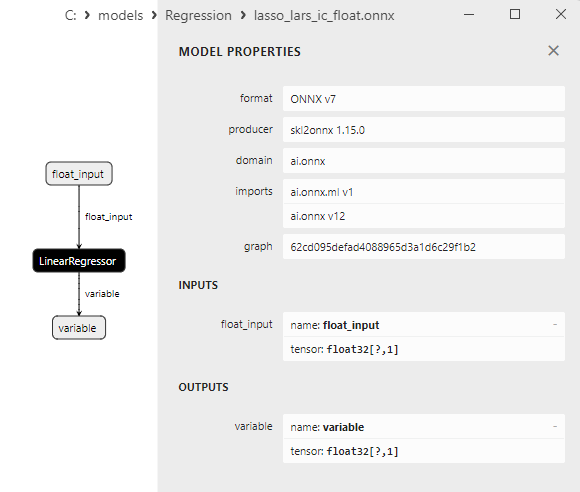

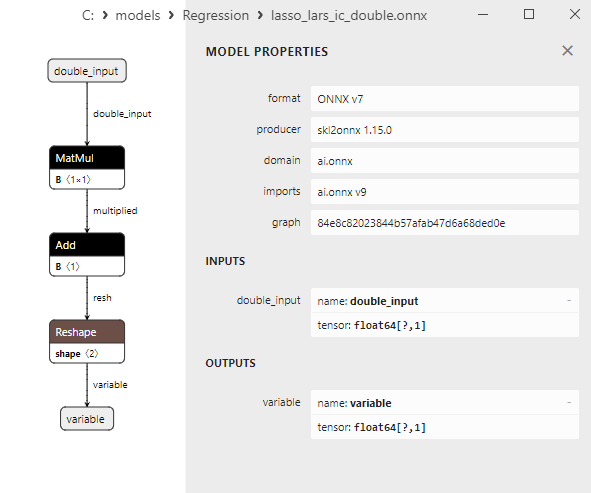

2.1.11.3. Representação ONNX do lasso_lars_cv_float.onnx e lasso_lars_cv_double.onnx - 2.1.12. sklearn.linear_model.LassoLarsIC

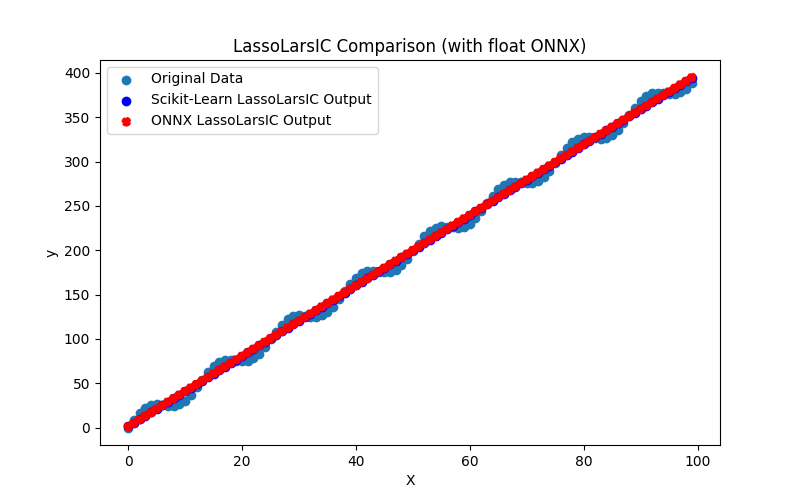

2.1.12.1. Código para criar o modelo LassoLarsIC e exportá-lo para ONNX em float e double

2.1.12.2. Código MQL5 para executar Modelos ONNX

2.1.12.3. Representação ONNX do lasso_lars_ic_float.onnx e lasso_lars_ic_double.onnx - 2.1.13. sklearn.linear_model.LinearRegression

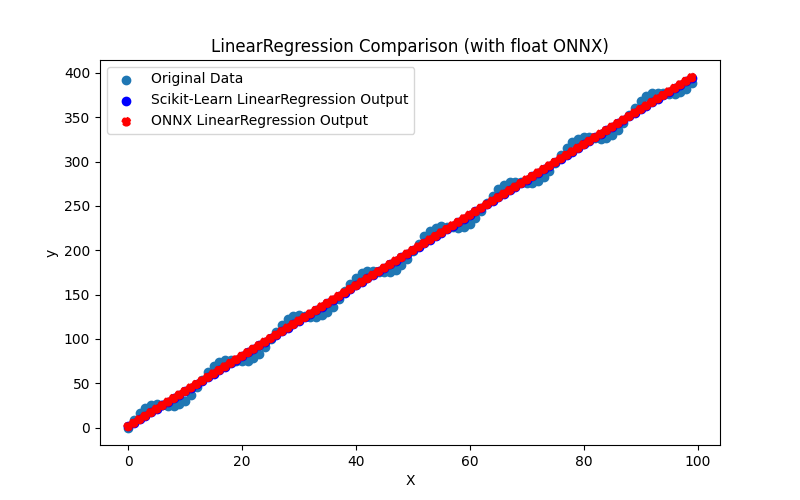

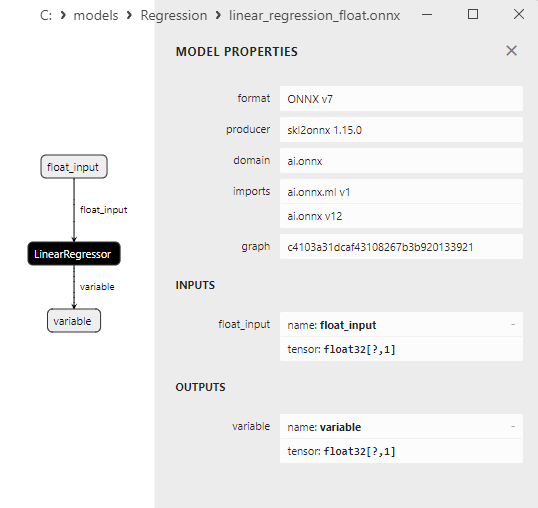

2.1.13.1. Código para criar o modelo LinearRegressione exportá-lo para ONNX em float e double

2.1.13.2. Código MQL5 para executar Modelos ONNX

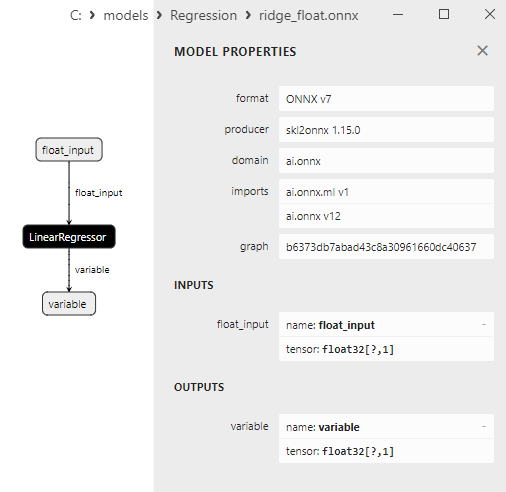

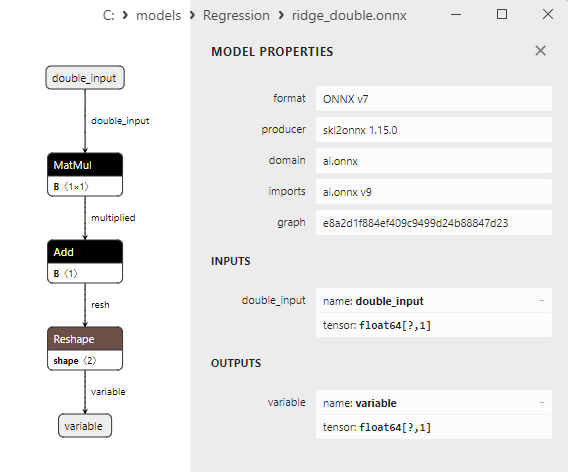

2.1.13.3. Representação ONNX do linear_regression_float.onnx e linear_regression_double.onnx - 2.1.14. sklearn.linear_model.Ridge

2.1.14.1. Código para criar o modelo Ridge e exportá-lo para ONNX em float e double

2.1.14.2. Código MQL5 para executar Modelos ONNX

2.1.14.3. Representação ONNX do ridge_float.onnx e ridge_double.onnx - 2.1.15. sklearn.linear_model.RidgeCV

2.1.15.1. Código para criar o modelo RidgeCV e exportá-lo para ONNX em float e double

2.1.15.2. Código MQL5 para executar Modelos ONNX

2.1.15.3. Representação ONNX doridge_cv_float.onnx e ridge_cv_double.onnx - 2.1.16. sklearn.linear_model.OrthogonalMatchingPursuit

2.1.16.1. Código para criar o modelo OrthogonalMatchingPursuit e exportá-lo para ONNX em float e double

2.1.16.2. Código MQL5 para executar Modelos ONNX

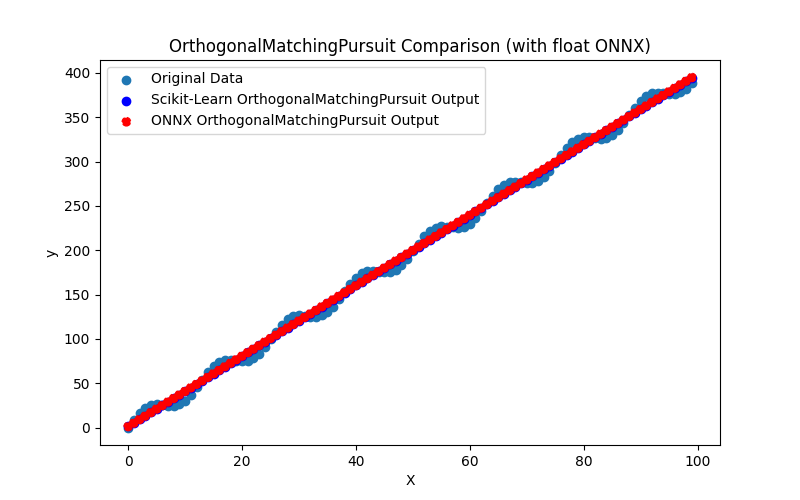

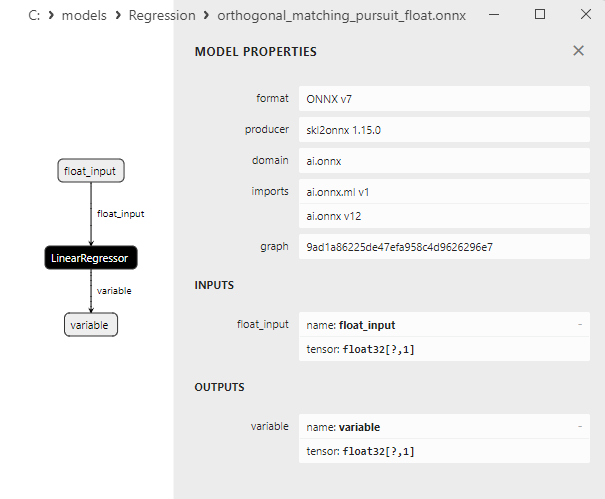

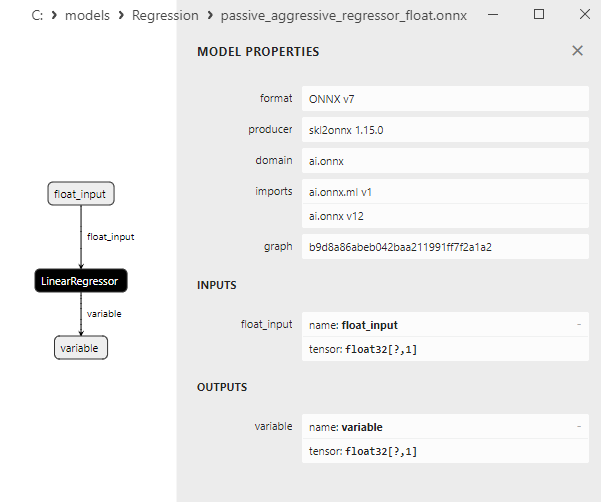

2.1.16.3. Representação ONNX do orthogonal_matching_pursuit_float.onnx e orthogonal_matching_pursuit_double.onnx - 2.1.17. sklearn.linear_model.PassiveAggressiveRegressor

2.1.17.1. Código para criar o modelo PassiveAggressiveRegressor e exportá-lo para ONNX em float e double

2.1.17.2. Código MQL5 para executar Modelos ONNX

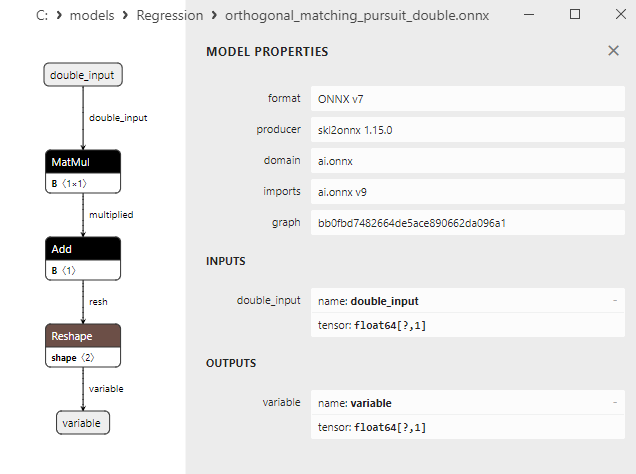

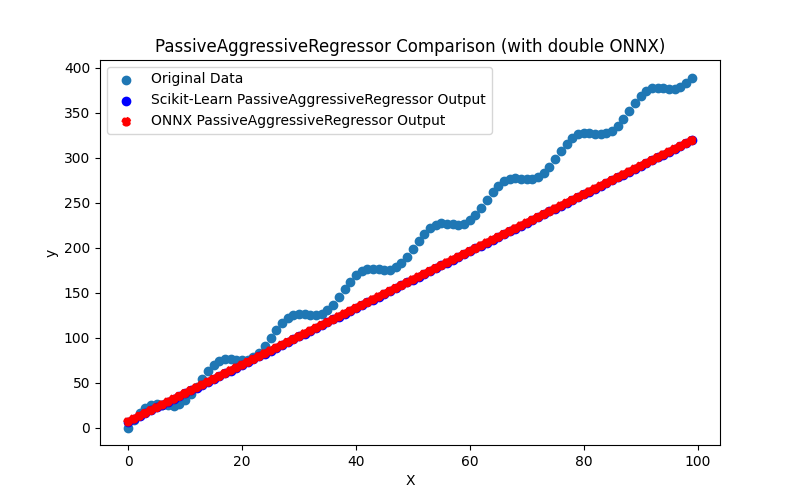

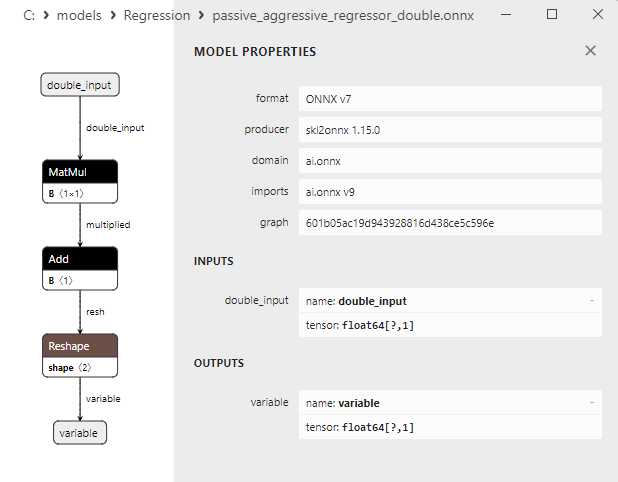

2.1.17.3. Representação ONNX do passive_aggressive_regressor_float.onnx e passive_aggressive_regressor_double.onnx - 2.1.18. sklearn.linear_model.QuantileRegressor

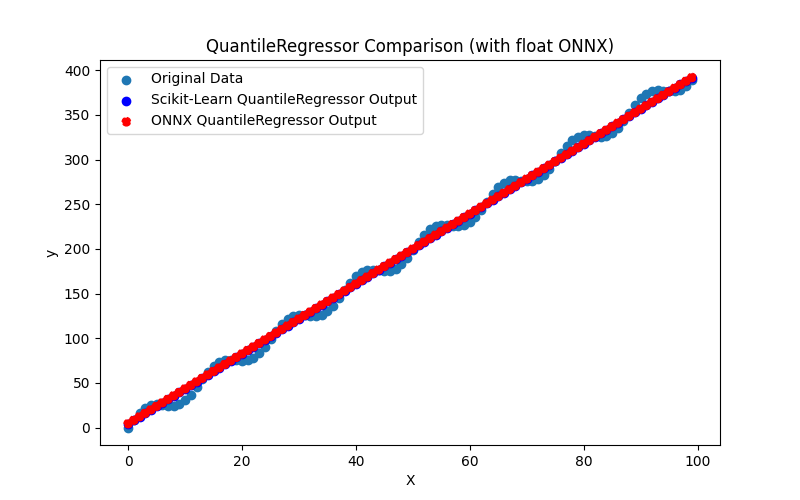

2.1.18.1. Código para criar o modelo QuantileRegressor e exportá-lo para ONNX em float e double

2.1.18.2. Código MQL5 para executar Modelos ONNX

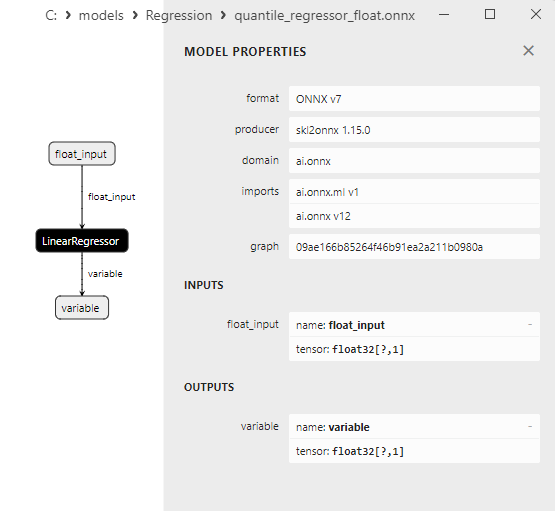

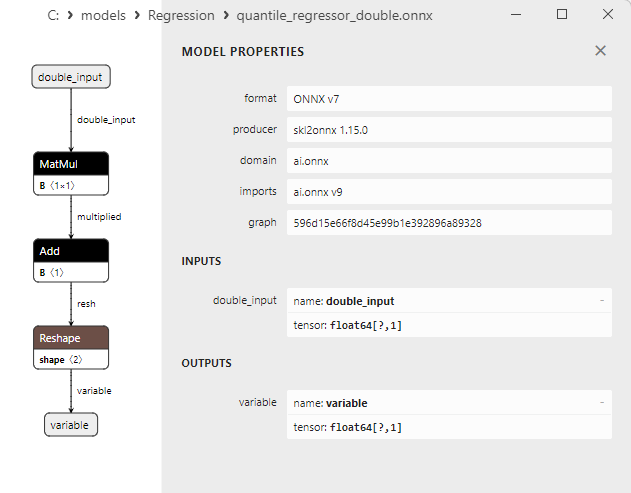

2.1.18.3. Representação ONNX do quantile_regressor_float.onnx e quantile_regressor_double.onnx - 2.1.19. sklearn.linear_model.RANSACRegressor

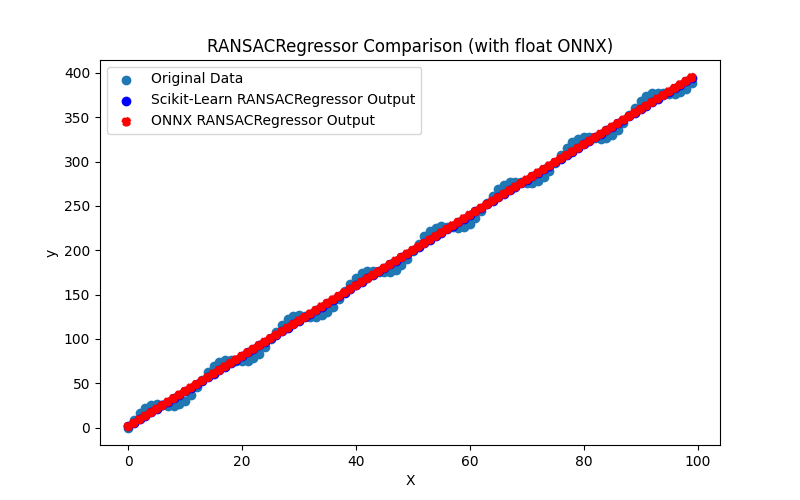

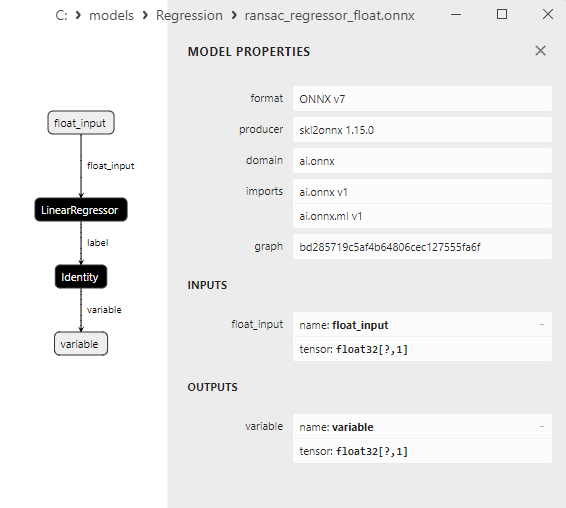

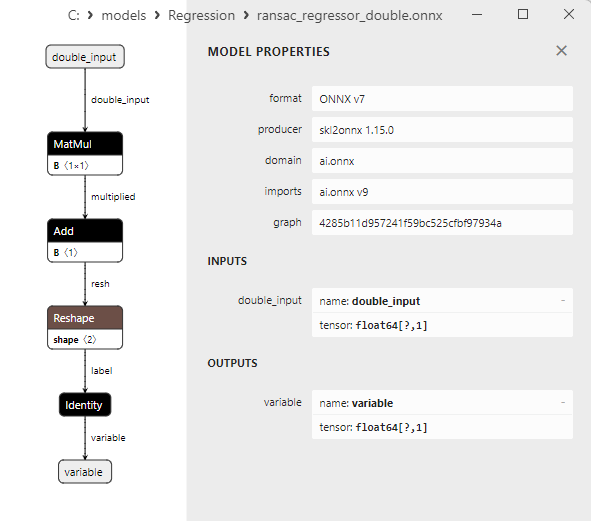

2.1.19.1. Código para criar o modelo RANSACRegressor e exportá-lo para ONNX em float e double

2.1.19.2. Código MQL5 para executar Modelos ONNX

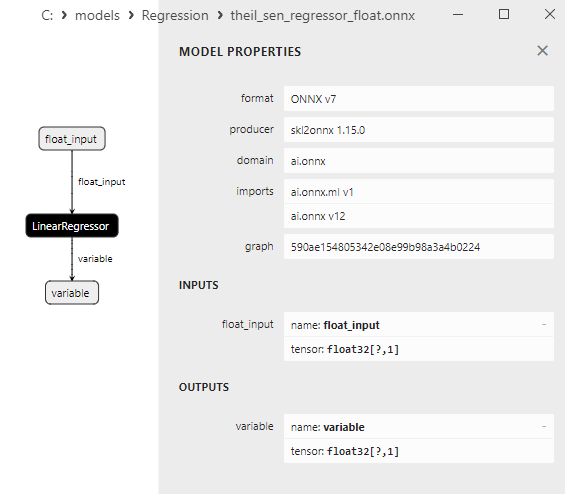

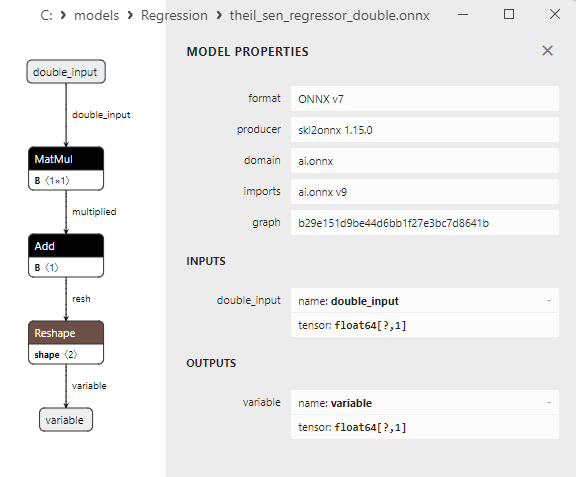

2.1.19.3. Representação ONNX do ransac_regressor_float.onnx e ransac_regressor_double.onnx - 2.1.20. sklearn.linear_model.TheilSenRegressor

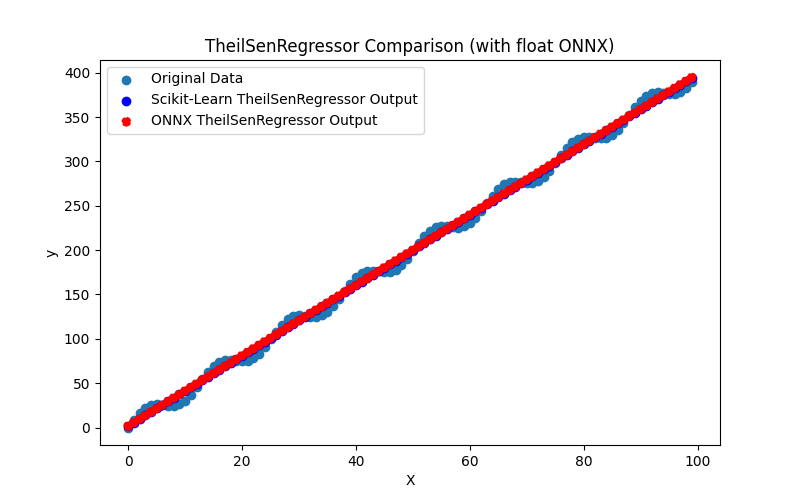

2.1.20.1. Código para criar o modelo TheilSenRegressor e exportá-lo para ONNX em float e double

2.1.20.2. Código MQL5 para executar Modelos ONNX

2.1.20.3. Representação ONNX do theil_sen_regressor_float.onnx e theil_sen_regressor_double.onnx - 2.1.21. sklearn.linear_model.LinearSVR

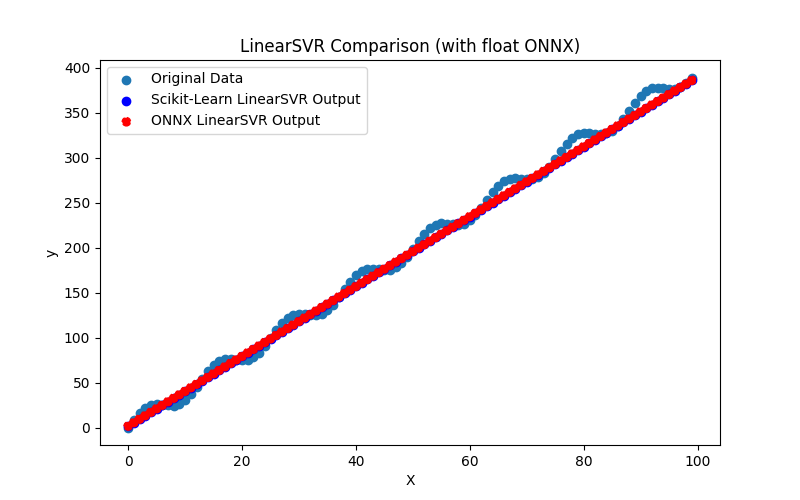

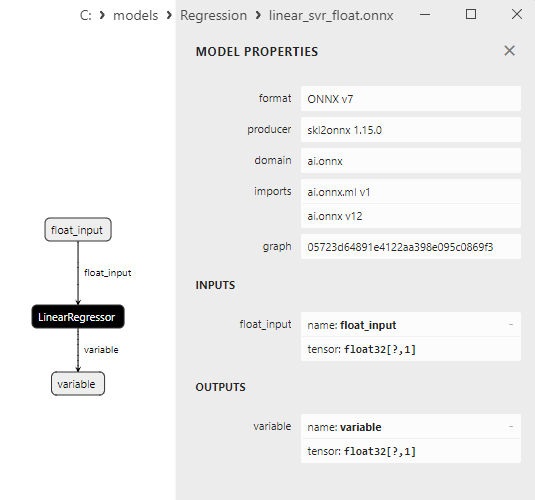

2.1.21.1. Código para criar o modelo LinearSVR e exportá-lo para ONNX em float e double

2.1.21.2. Código MQL5 para executar Modelos ONNX

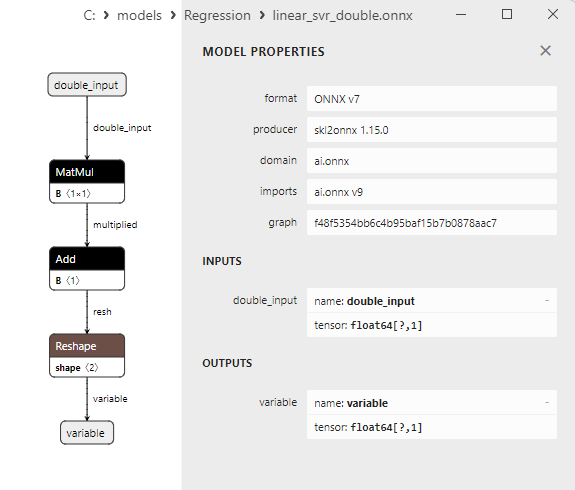

2.1.21.3. Representação ONNX do linear_svr_float.onnx e linear_svr_double.onnx - 2.1.22. sklearn.linear_model.MLPRegressor

2.1.22.1. Código para criar o modelo MLPRegressor e exportá-lo para ONNX em float e double

2.1.22.2. Código MQL5 para executar Modelos ONNX

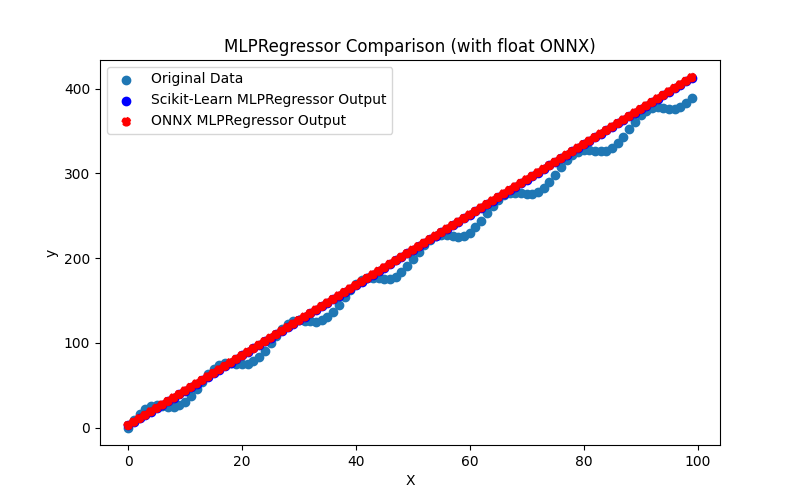

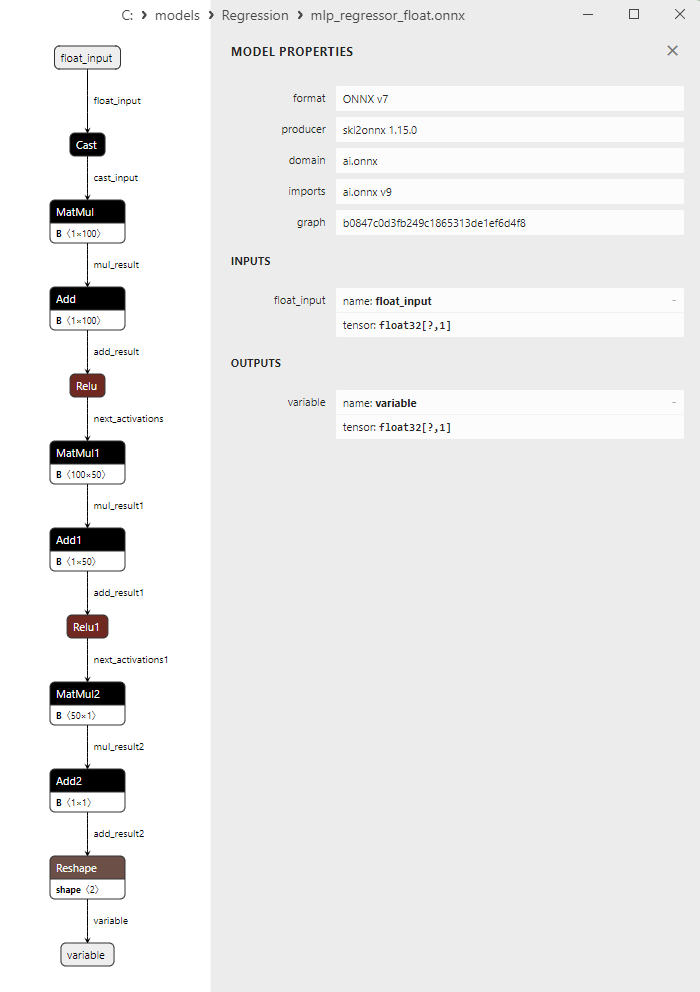

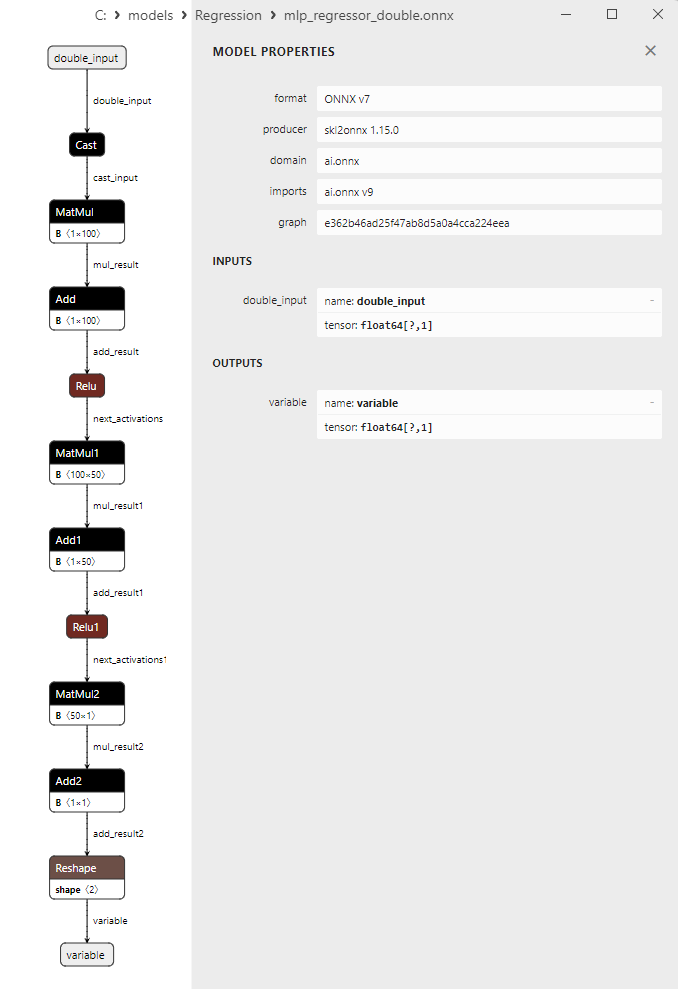

2.1.22.3. Representação ONNX do mlp_regressor_float.onnx e mlp_regressor_double.onnx - 2.1.23. sklearn.cross_decomposition.PLSRegression

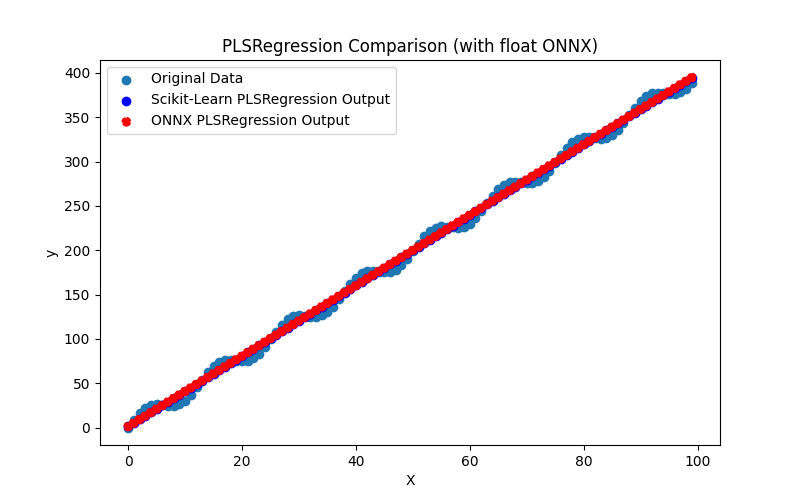

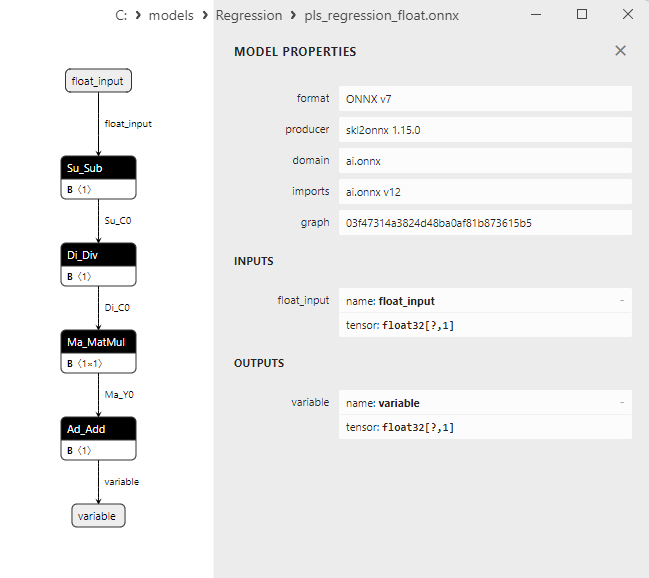

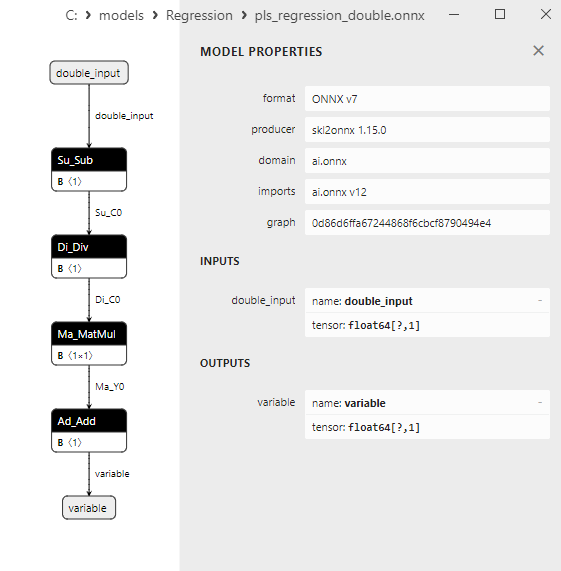

2.1.23.1. Código para criar o modelo PLSRegression e exportá-lo para ONNX em float e double

2.1.23.2. Código MQL5 para executar Modelos ONNX

2.1.23.3. Representação ONNX do pls_regression_float.onnx e pls_regression_double.onnx - 2.1.24. sklearn.linear_model.TweedieRegressor

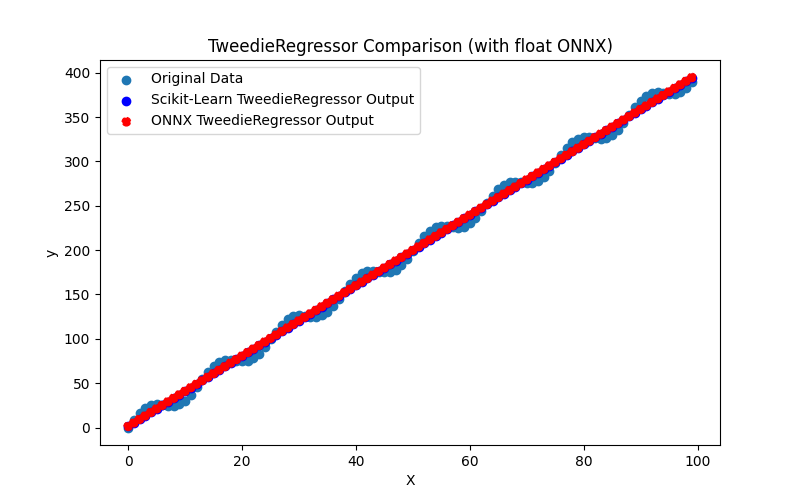

2.1.24.1. Código para criar o modelo TweedieRegressor e exportá-lo para ONNX em float e double

2.1.24.2. Código MQL5 para executar Modelos ONNX

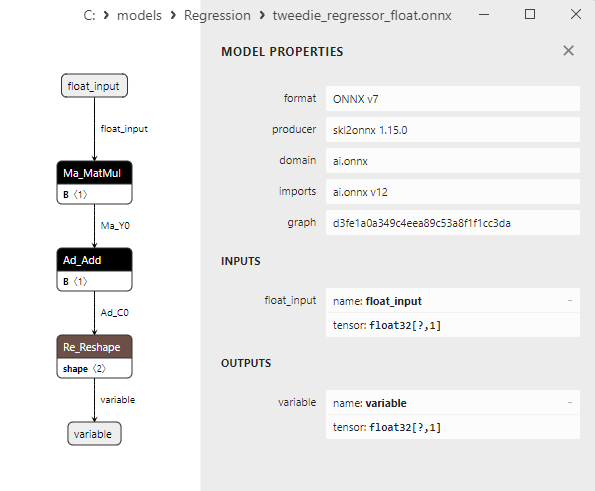

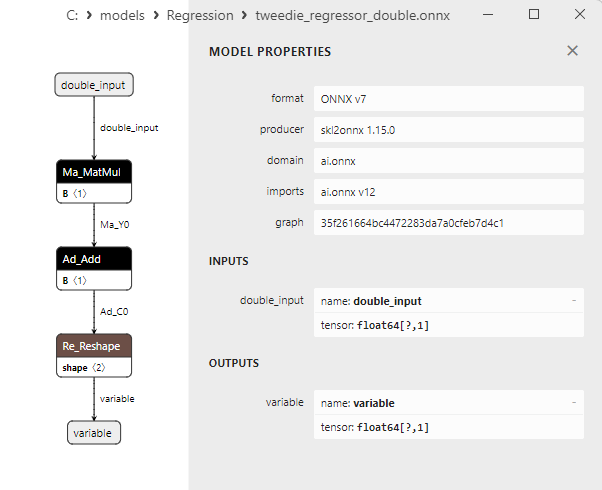

2.1.24.3. Representação ONNX do tweedie_regressor_float.onnx e tweedie_regressor_double.onnx - 2.1.25. sklearn.linear_model.PoissonRegressor

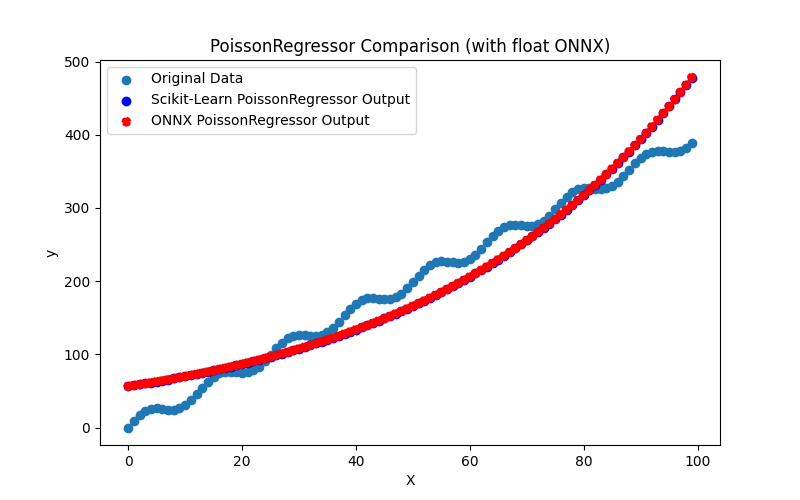

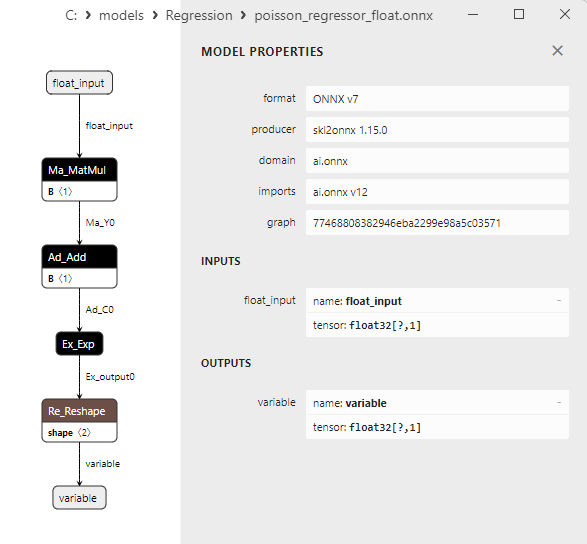

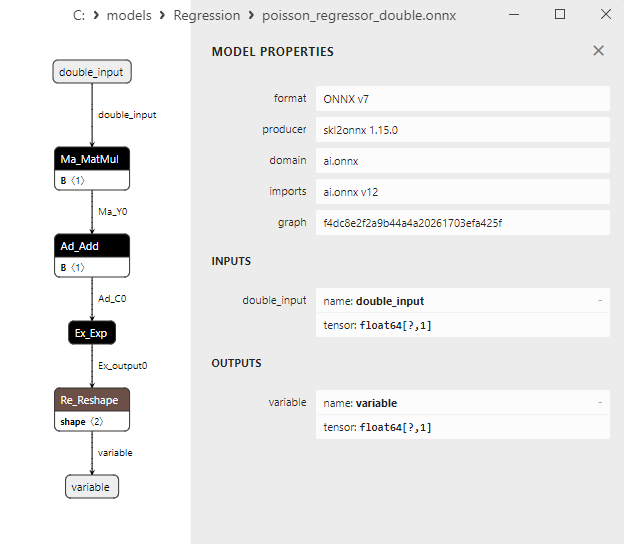

2.1.25.1. Código para criar o modelo PoissonRegressor e exportá-lo para ONNX em float e double

2.1.25.2. Código MQL5 para executar Modelos ONNX

2.1.25.3. Representação ONNX do poisson_regressor_float.onnx e poisson_regressor_double.onnx - 2.1.26. sklearn.neighbors.RadiusNeighborsRegressor

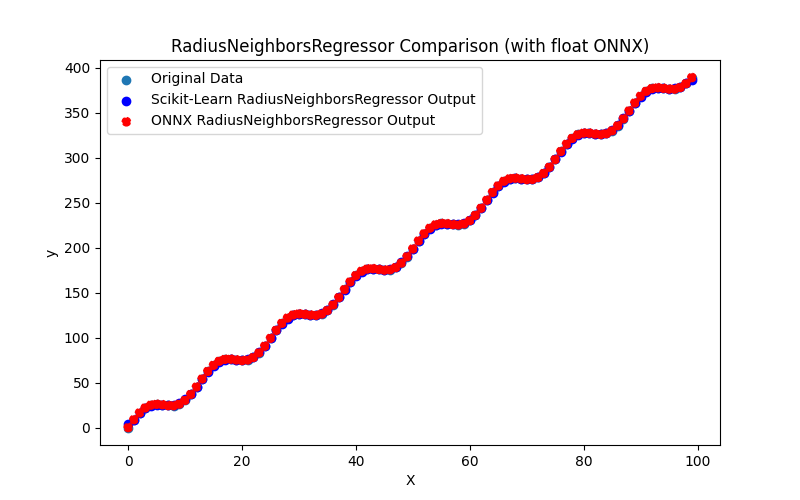

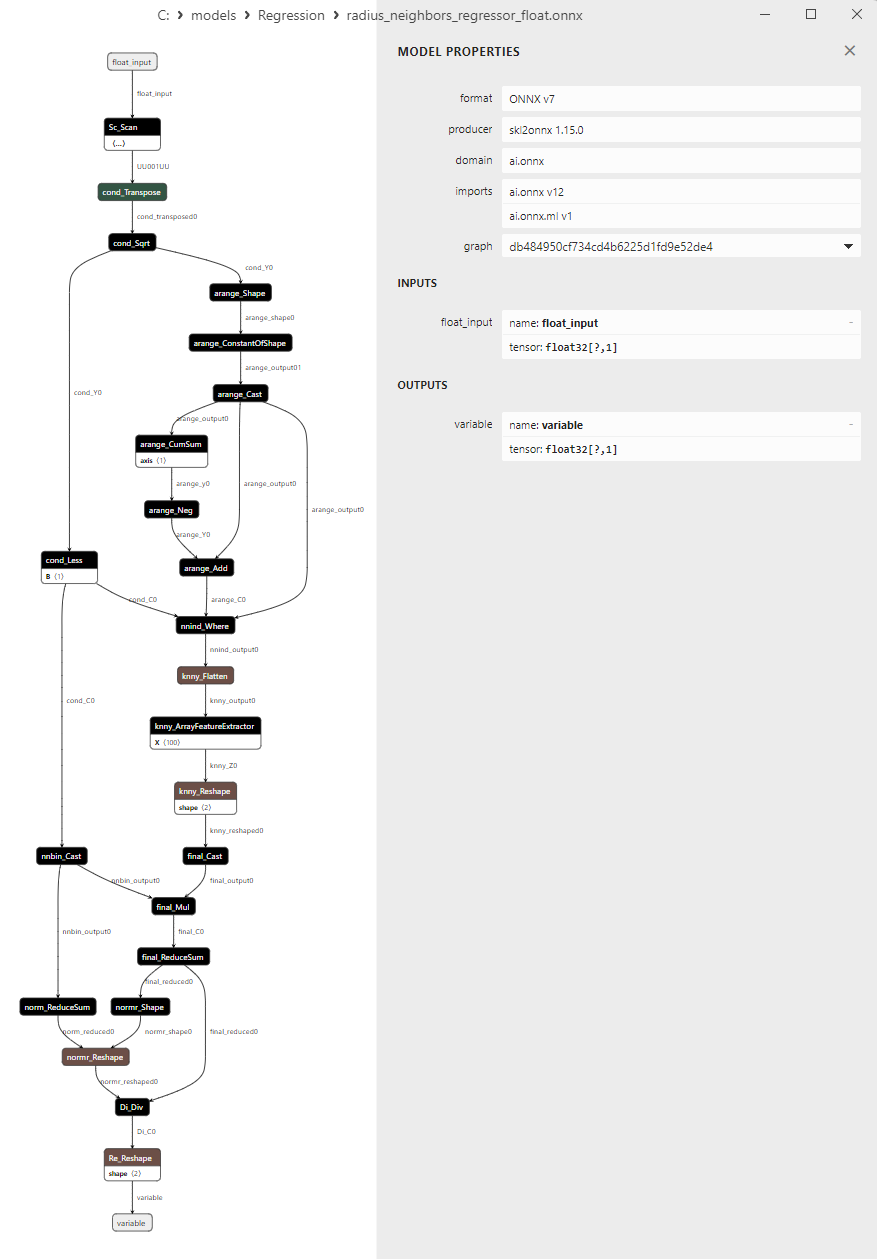

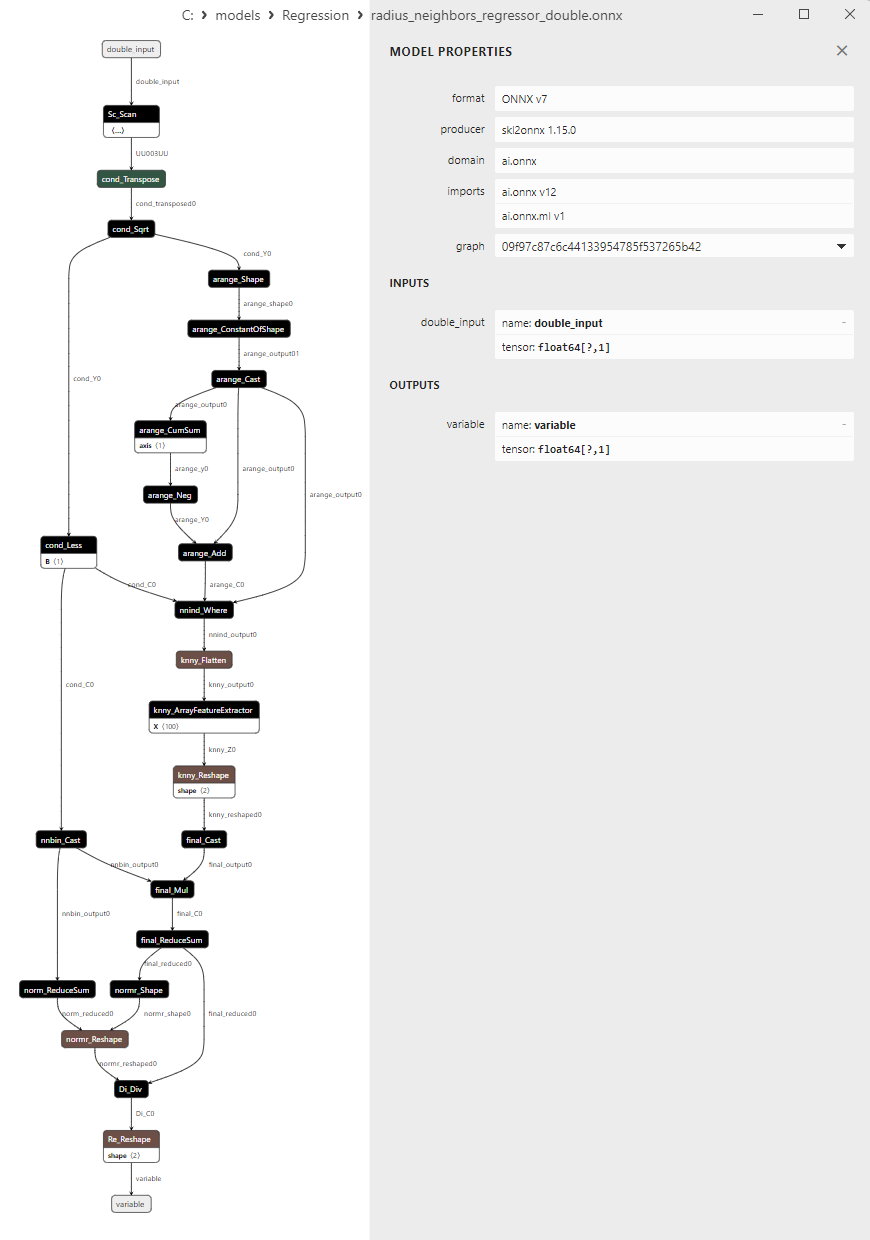

2.1.26.1. Código para criar o modelo RadiusNeighborsRegressor e exportá-lo para ONNX em float e double

2.1.26.2. Código MQL5 para executar Modelos ONNX

2.1.26.3. Representação ONNX do radius_neighbors_regressor_float.onnx e radius_neighbors_regressor_double.onnx - 2.1.27. sklearn.neighbors.KNeighborsRegressor

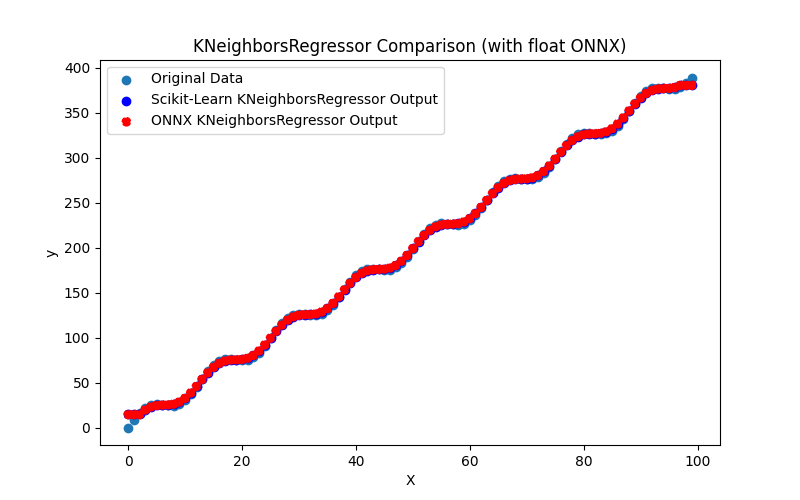

2.1.27.1. Código para criar o modelo KNeighborsRegressor e exportá-lo para ONNX em float e double

2.1.27.2. Código MQL5 para executar Modelos ONNX

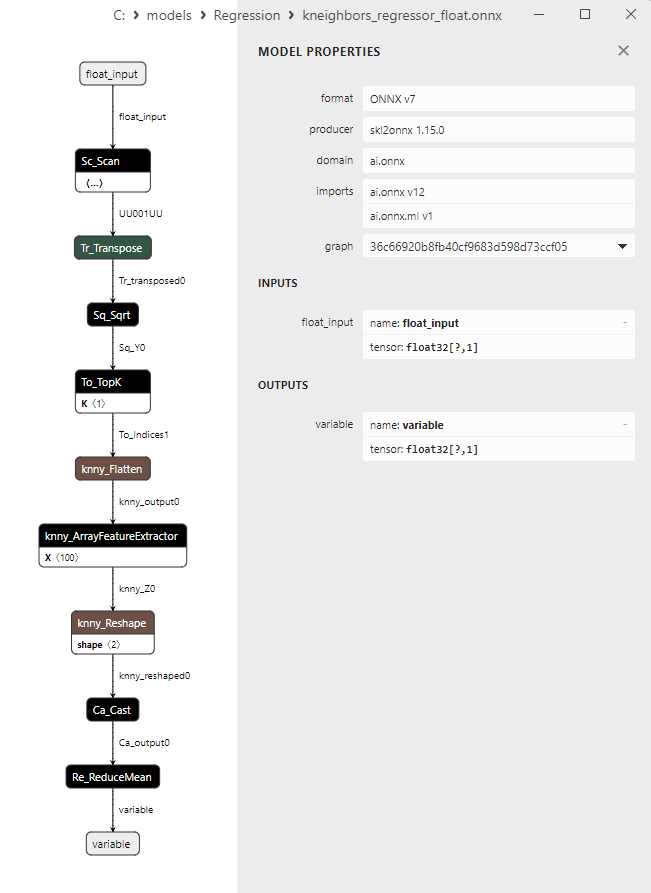

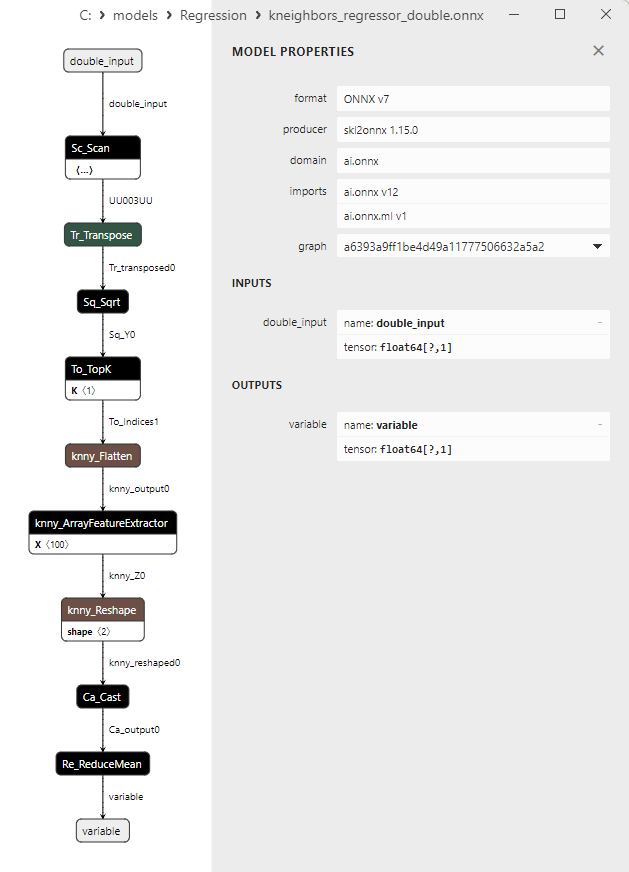

2.1.27.3. Representação ONNX do kneighbors_regressor_float.onnx e kneighbors_regressor_double.onnx

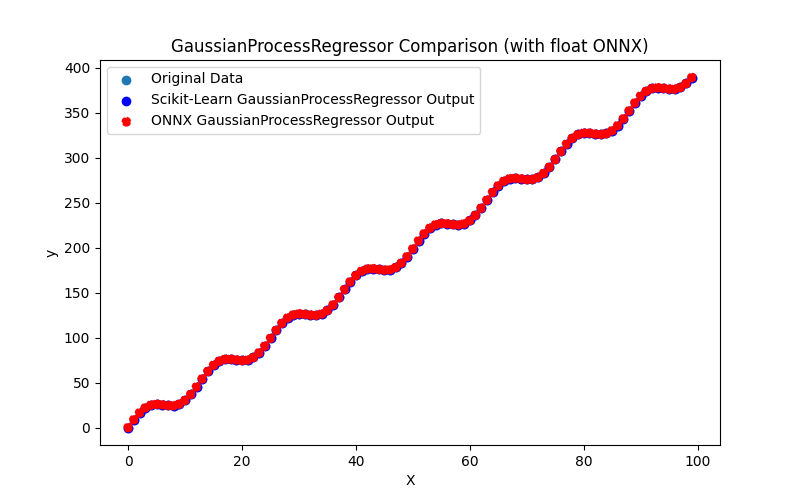

- 2.1.28. sklearn.gaussian_process.GaussianProcessRegressor

2.1.28.1. Código para criar o modelo GaussianProcessRegressor e exportá-lo para ONNX em float e double

2.1.28.2. Código MQL5 para executar Modelos ONNX

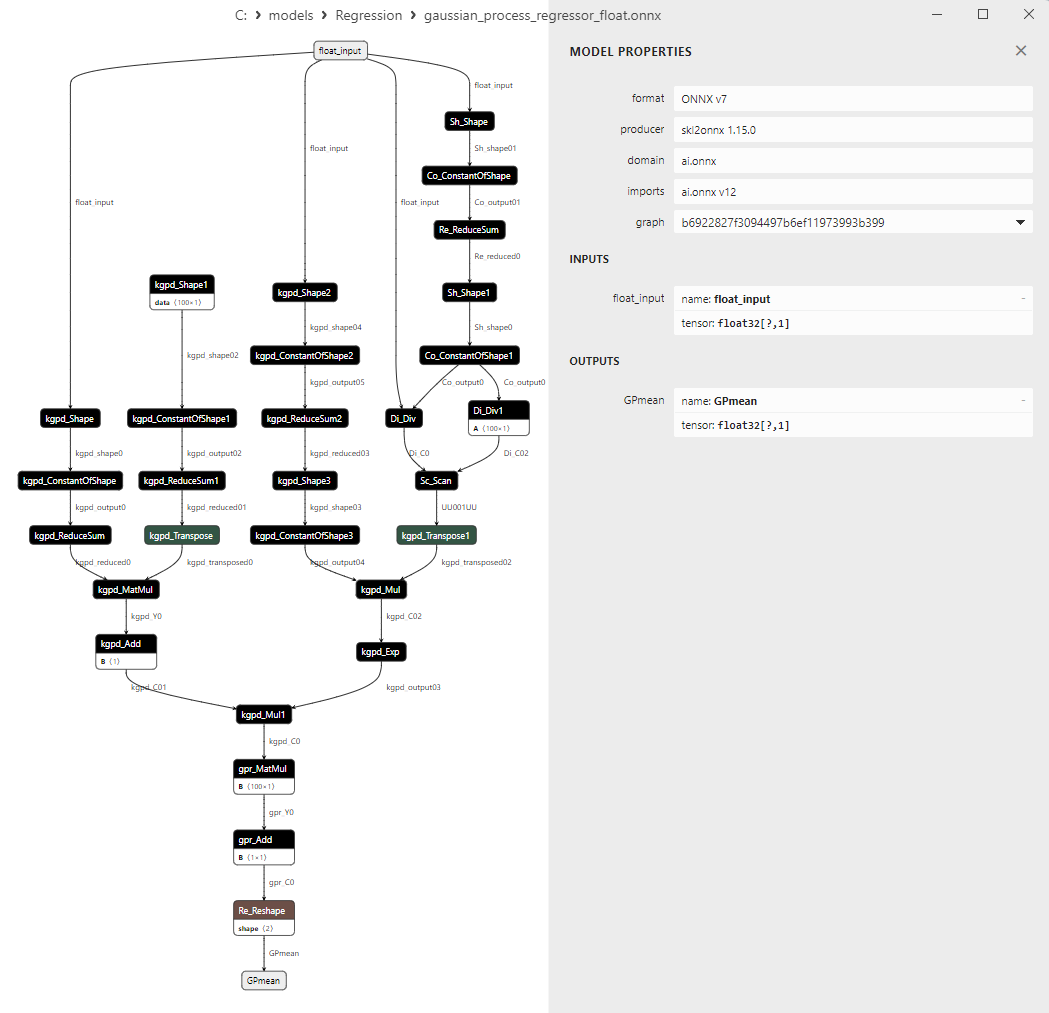

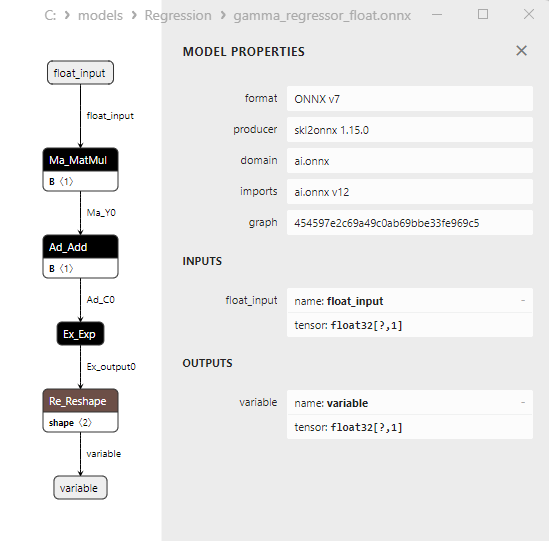

2.1.28.3. Representação ONNX do gaussian_process_regressor_float.onnx e gaussian_process_regressor_double.onnx

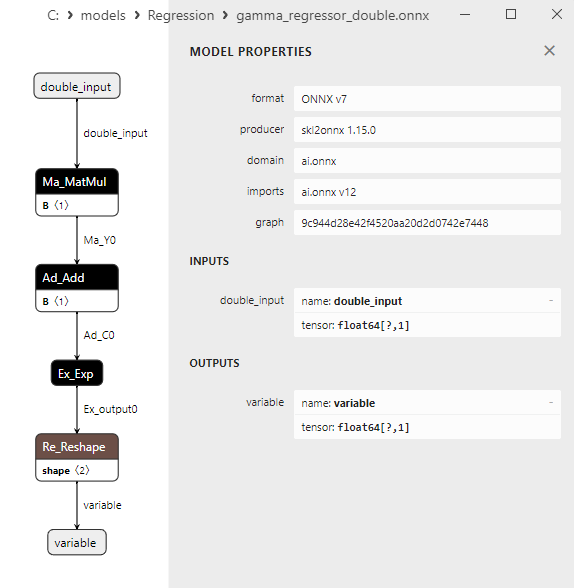

- 2.1.29. sklearn.linear_model.GammaRegressor

2.1.29.1. Código para criar o modelo GammaRegressor e exportá-lo para ONNX em float e double

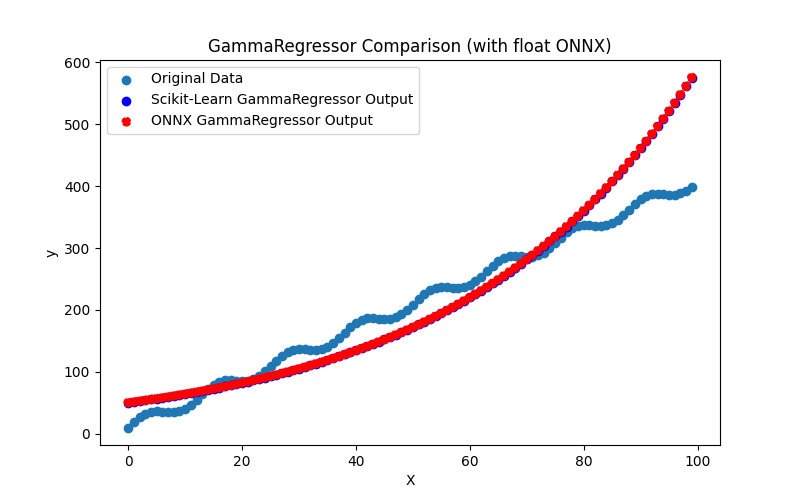

2.1.29.2. Código MQL5 para executar Modelos ONNX

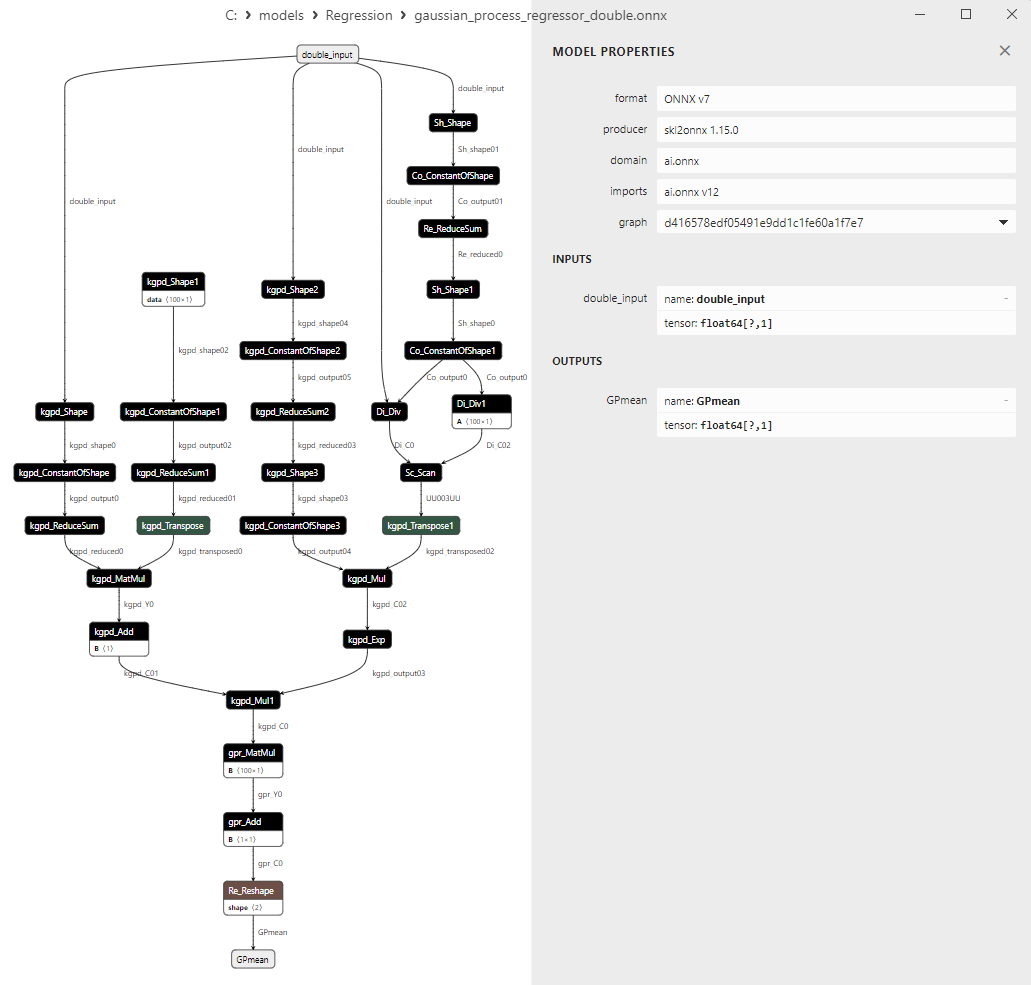

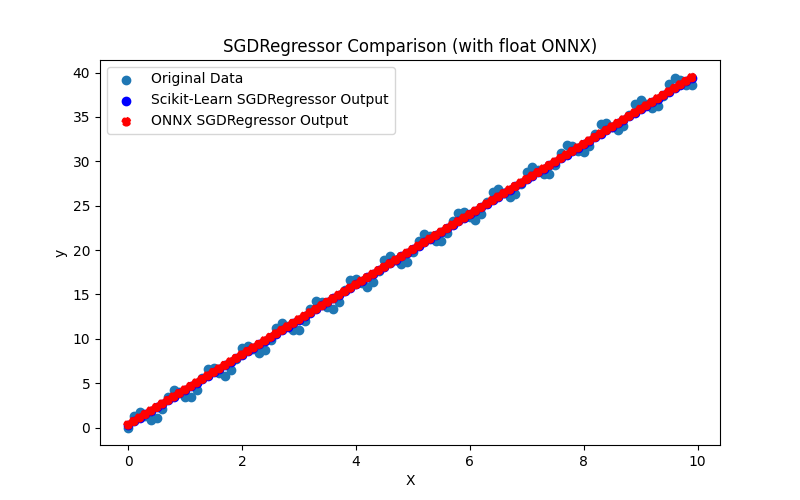

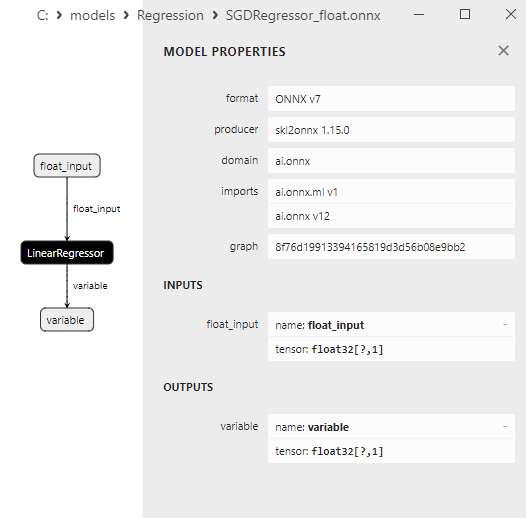

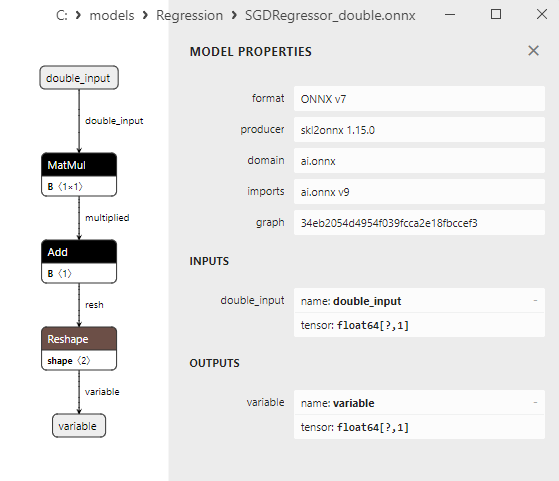

2.1.29.3. Representação ONNX do gamma_regressor_float.onnx e gamma_regressor_double.onnx - 2.1.30. sklearn.linear_model.SGDRegressor

2.1.30.1. Código para criar o modelo SGDRegressor e exportá-lo para ONNX em float e double

2.1.30.2. Código MQL5 para executar Modelos ONNX

2.1.30.3. Representação ONNX do sgd_regressor_float.onnx e sgd_rgressor_double.onnx

- 2.2. Modelos de regressão da biblioteca Scikit-learn que são convertidos apenas em modelos ONNX de precisão float

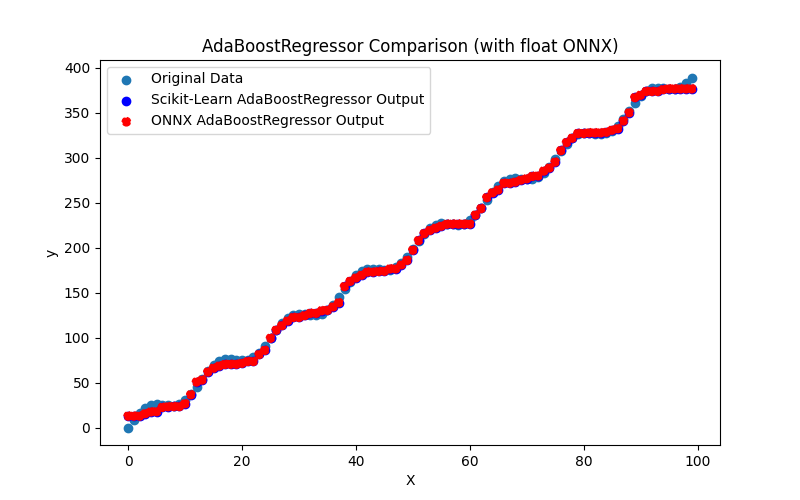

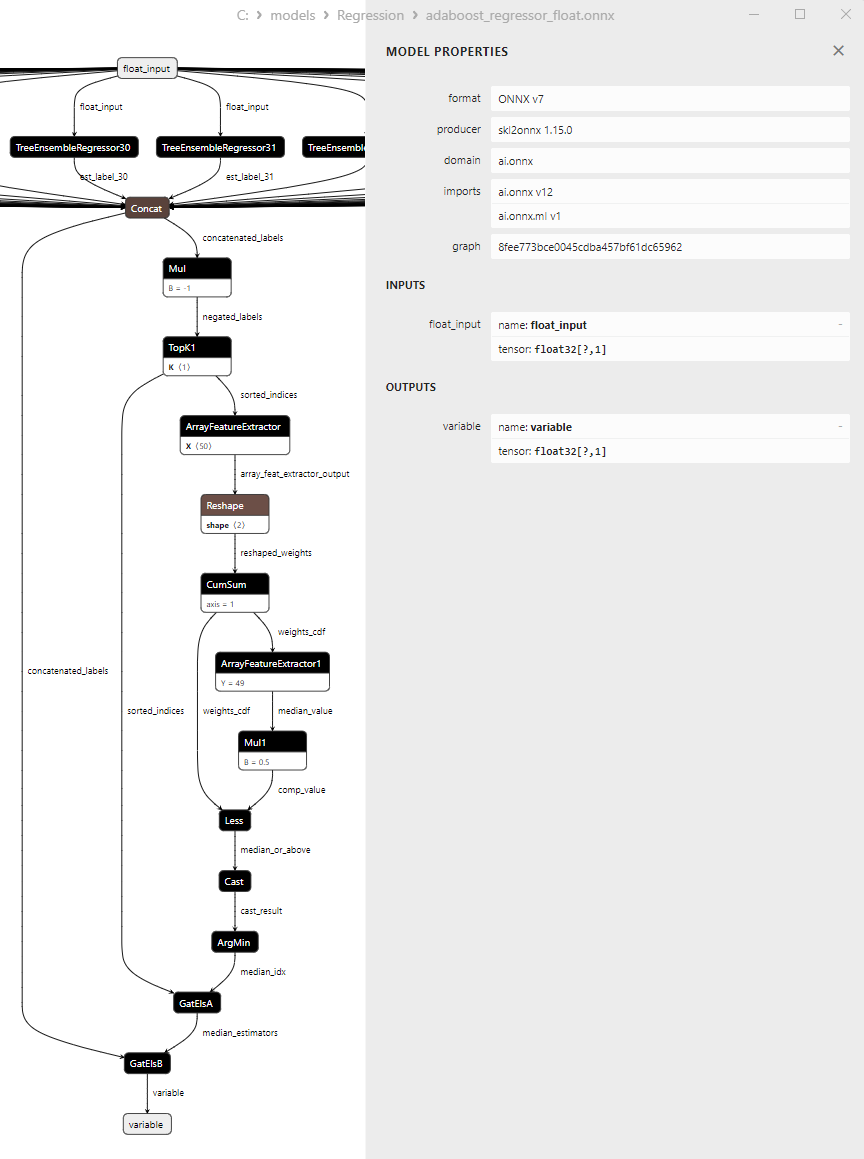

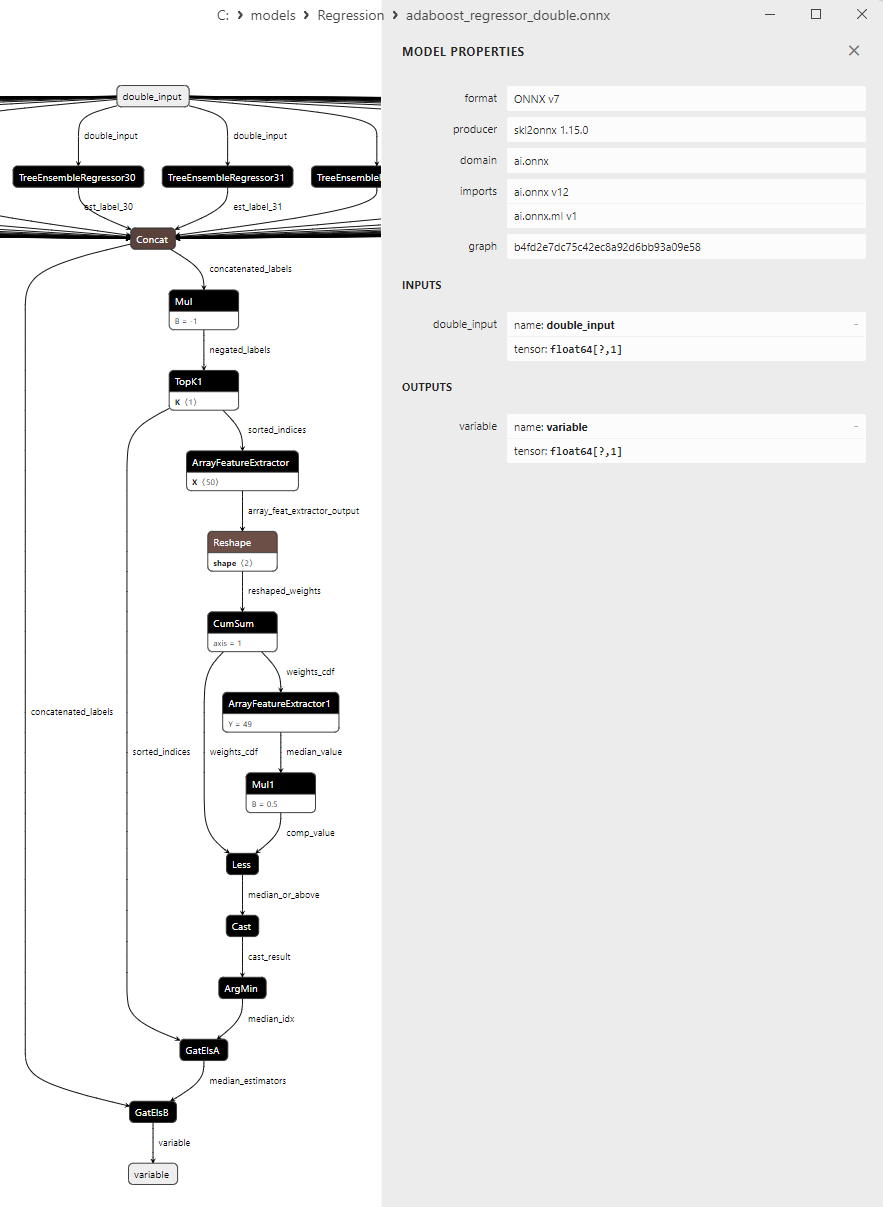

- 2.2.1. sklearn.linear_model.AdaBoostRegressor

2.2.1.1. Código para criar o modelo AdaBoostRegressor e exportá-lo para ONNX em float e double

2.2.1.2. Código MQL5 para executar Modelos ONNX

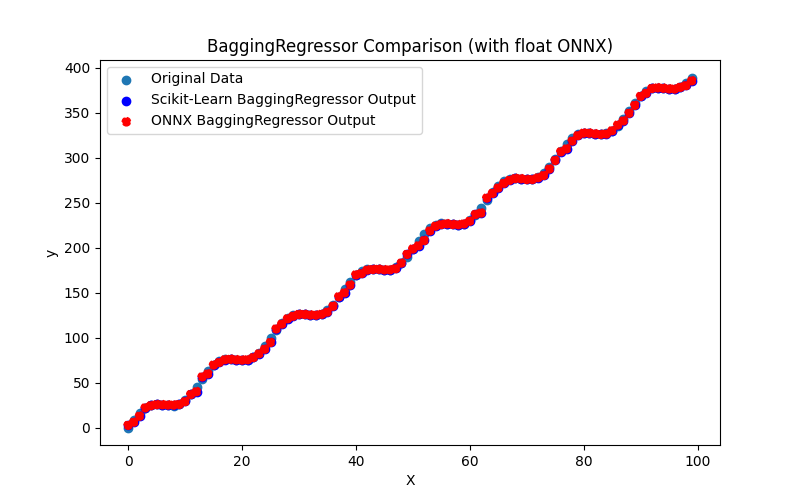

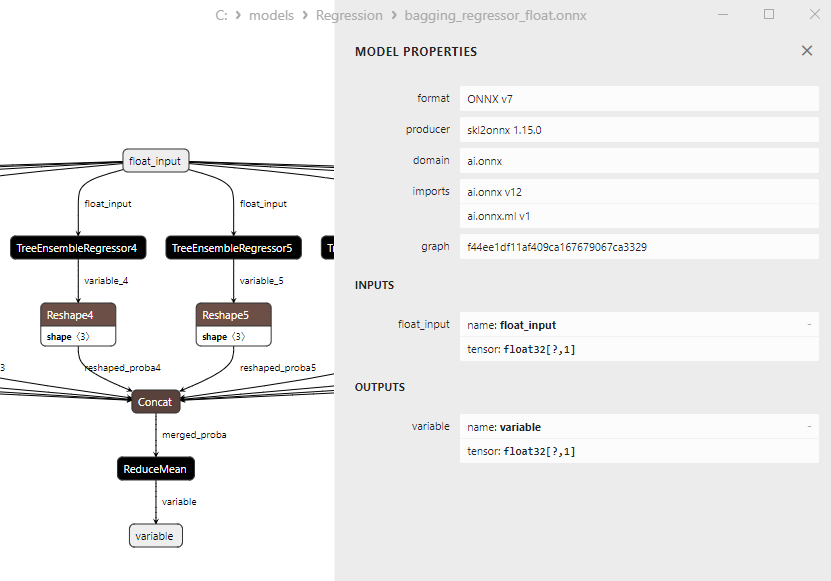

2.2.1.3. Representação ONNX do adaboost_regressor_float.onnx e adaboost_regressor_double.onnx - 2.2.2. sklearn.linear_model.BaggingRegressor

2.2.2.1. Código para criar o modelo BaggingRegressor e exportá-lo para ONNX em float e double

2.2.2.2. Código MQL5 para executar Modelos ONNX

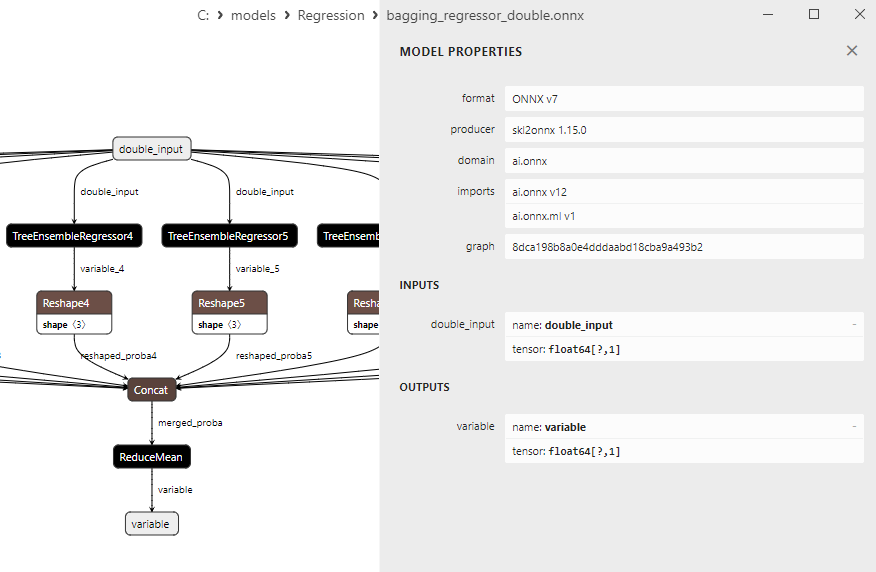

2.2.2.3. Representação ONNX do bagging_regressor_float.onnx e bagging_regressor_double.onnx - 2.2.3. sklearn.linear_model.DecisionTreeRegressor

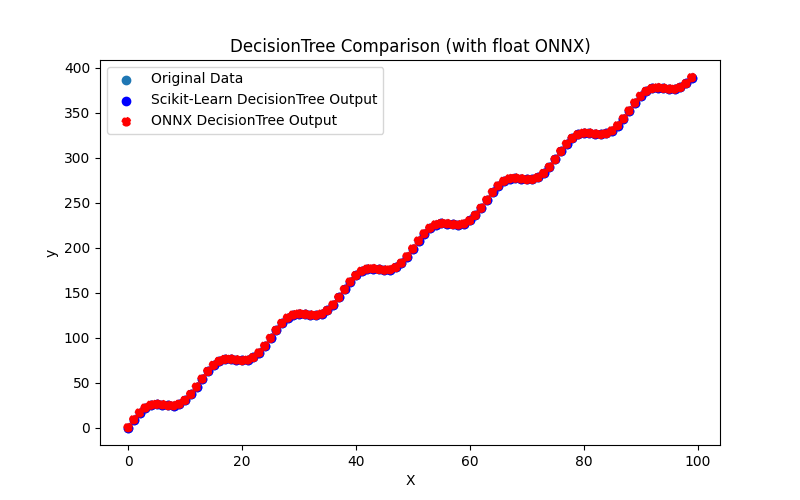

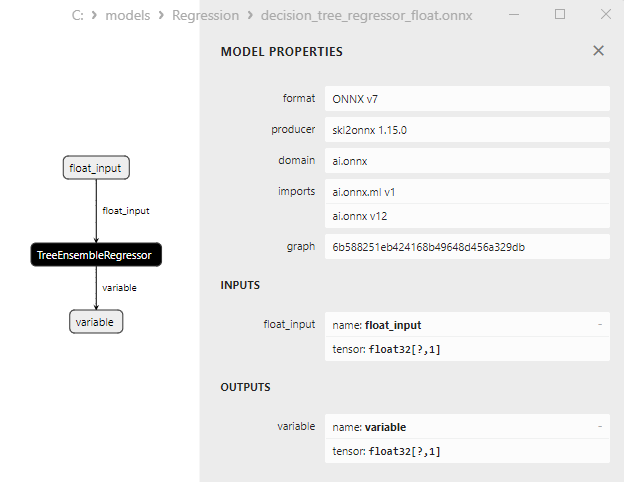

2.2.3.1. Código para criar o modelo DecisionTreeRegressor e exportá-lo para ONNX em float e double

2.2.3.2. Código MQL5 para executar Modelos ONNX

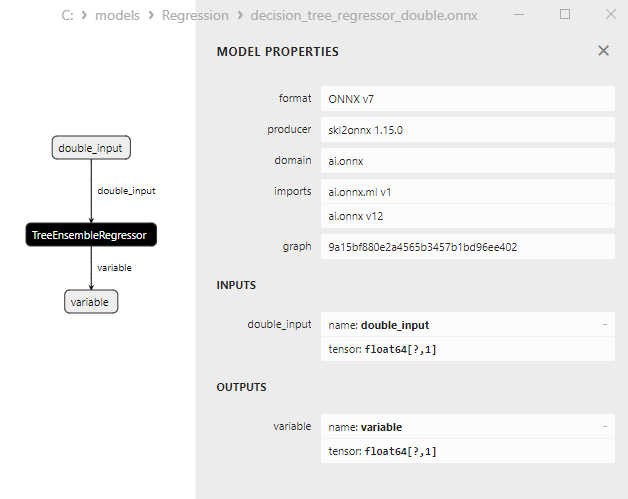

2.2.3.3. Representação ONNX do decision_tree_regressor_float.onnx e decision_tree_regressor_double.onnx - 2.2.4. sklearn.linear_model.ExtraTreeRegressor

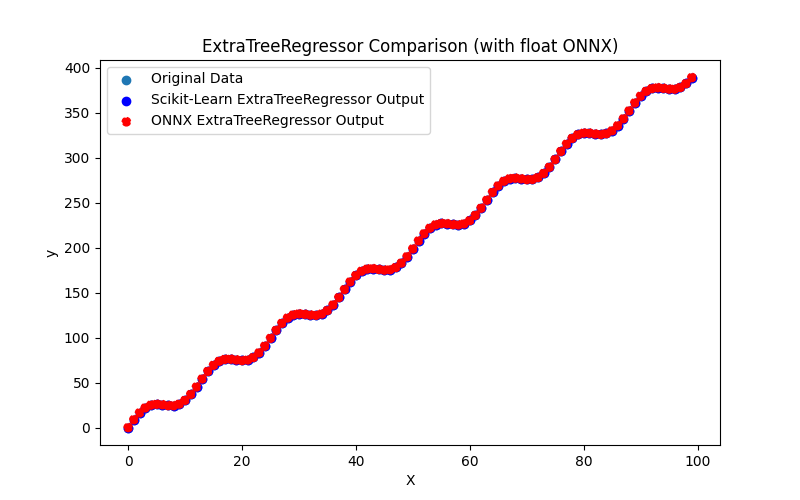

2.2.4.1. Código para criar o modelo ExtraTreeRegressor e exportá-lo para ONNX em float e double

2.2.4.2. Código MQL5 para executar Modelos ONNX

2.2.4.3. Representação ONNX do extra_tree_regressor_float.onnx e extra_tree_regressor_double.onnx - 2.2.5. sklearn.ensemble.ExtraTreesRegressor

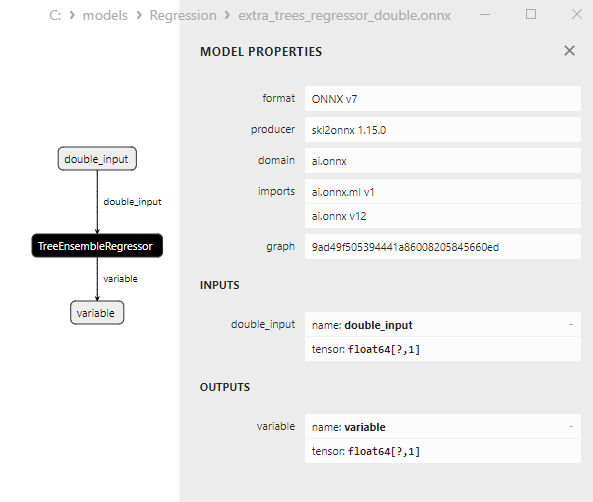

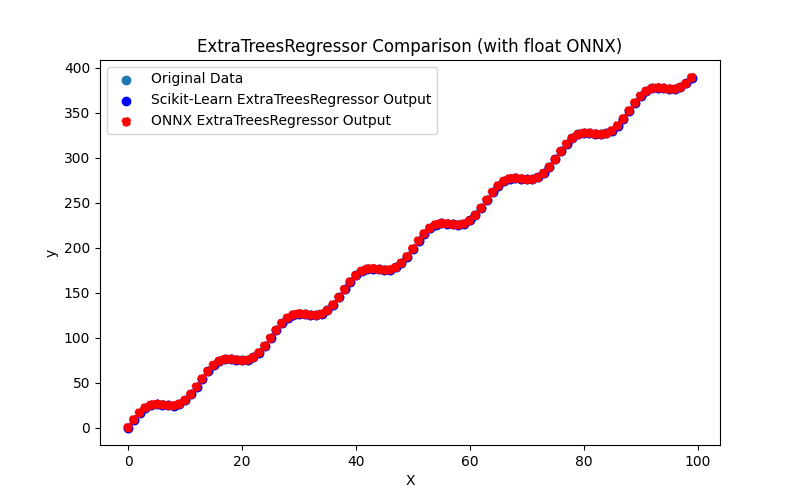

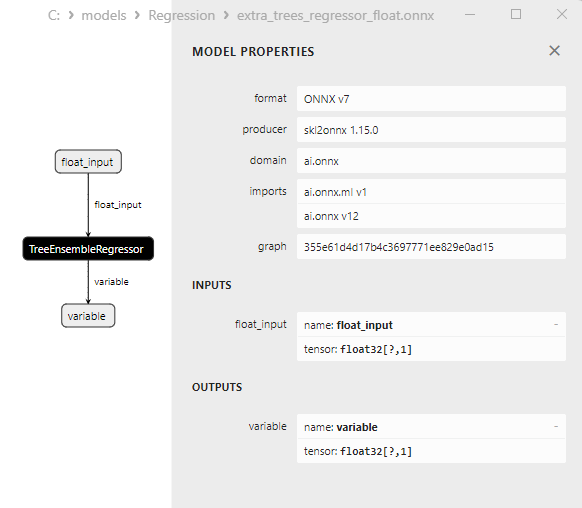

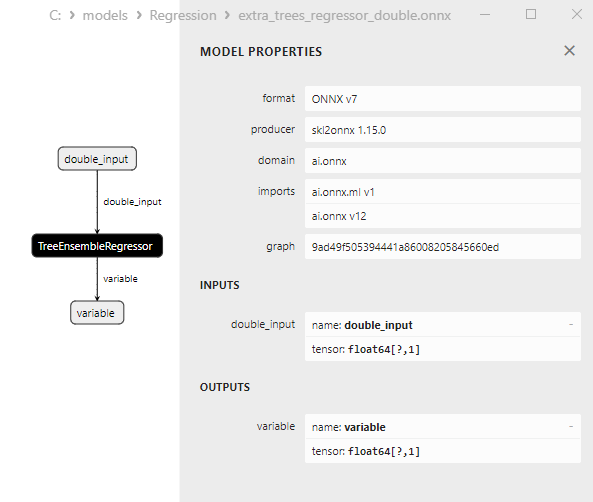

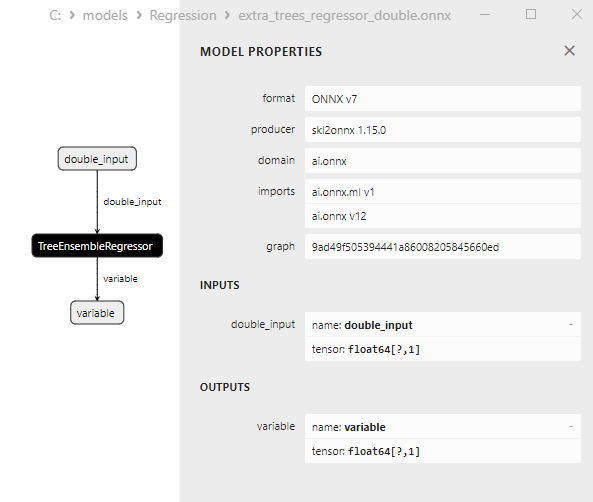

2.2.5.1. Código para criar o modelo ExtraTreesRegressor e exportá-lo para ONNX em float e double

2.2.5.2. Código MQL5 para executar Modelos ONNX

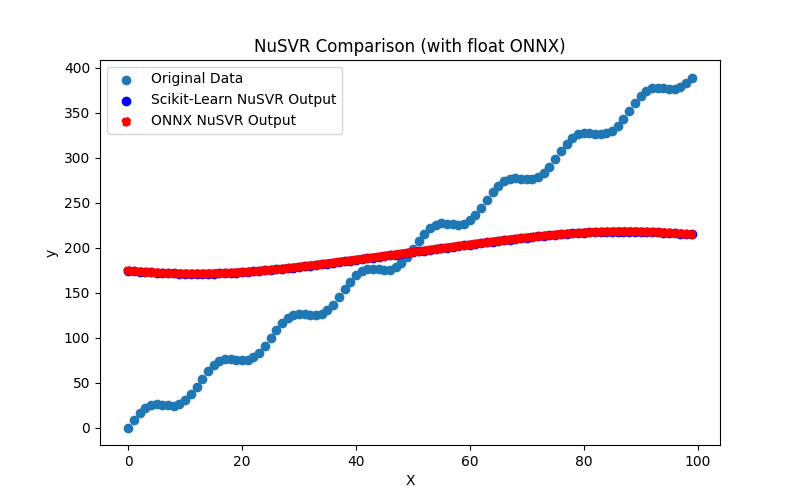

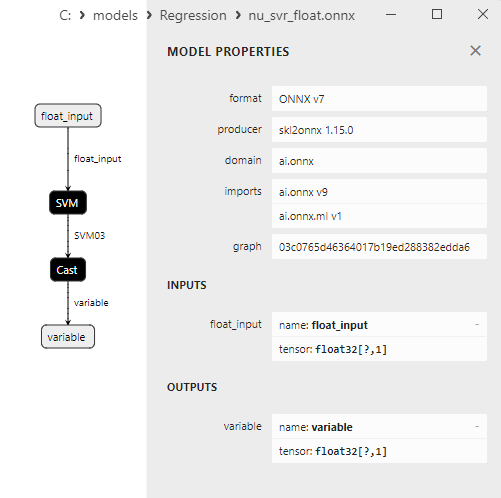

2.2.5.3. Representação ONNX do extra_trees_regressor_float.onnx e extra_trees_regressor_double.onnx - 2.2.6. sklearn.svm.NuSVR

2.2.6.1. Código para criar o modelo NuSVR e exportá-lo para ONNX em float e double

2.2.6.2. Código MQL5 para executar Modelos ONNX

2.2.6.3. Representação ONNX do nu_svr_float.onnx e nu_svr_double.onnx - 2.2.7. sklearn.ensemble.RandomForestRegressor

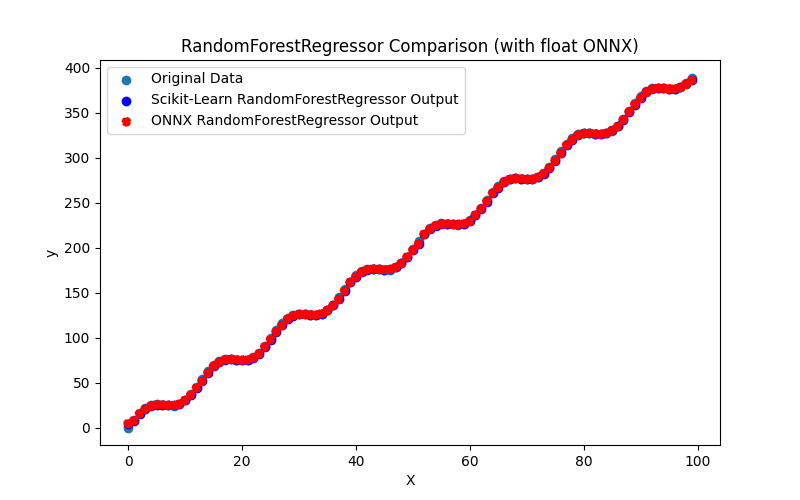

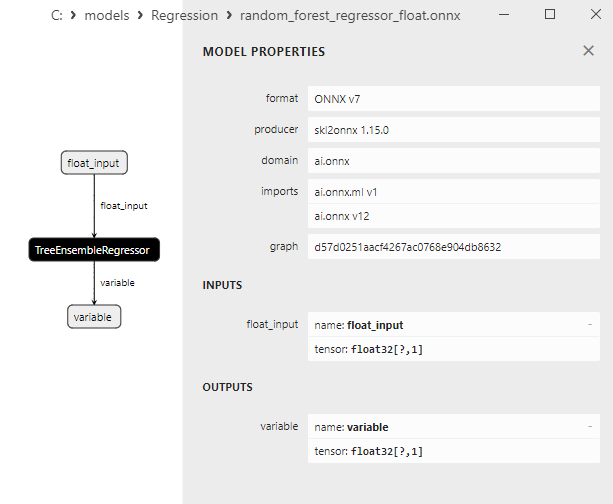

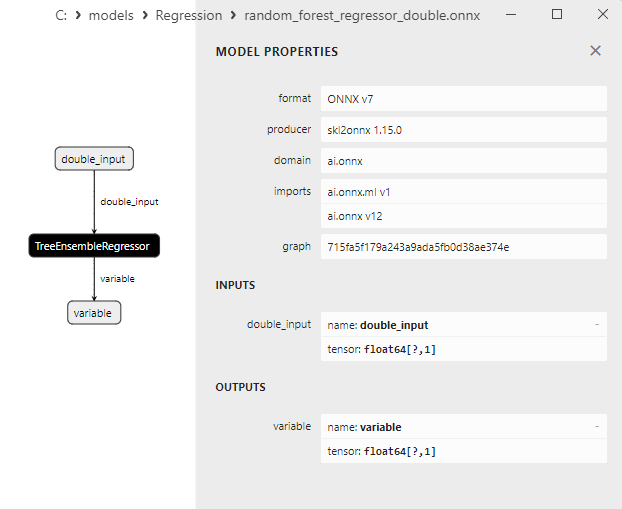

2.2.7.1. Código para criar o modelo RandomForestRegressor e exportá-lo para ONNX em float e double

2.2.7.2. Código MQL5 para executar Modelos ONNX

2.2.7.3. Representação ONNX do random_forest_regressor_float.onnx e random_forest_regressor_double.onnx

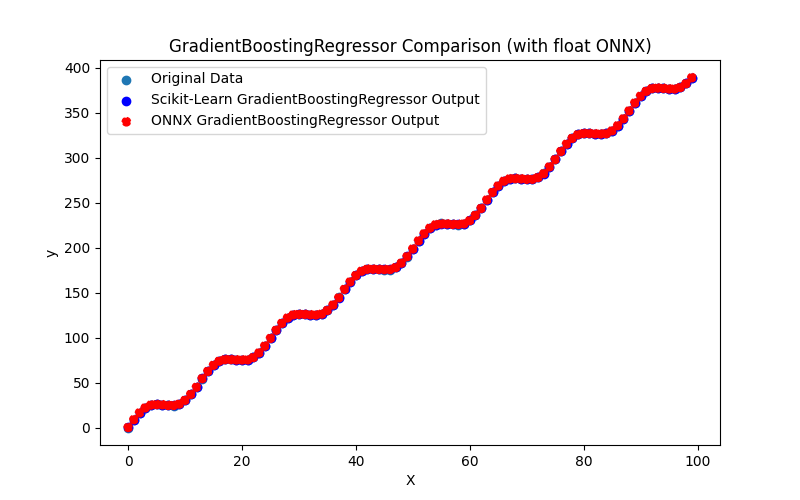

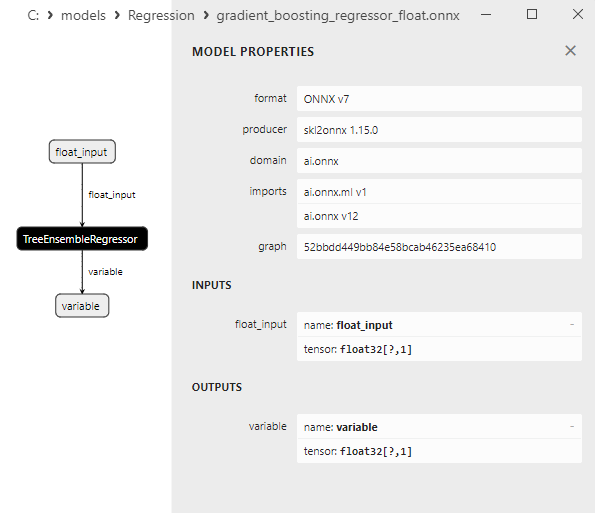

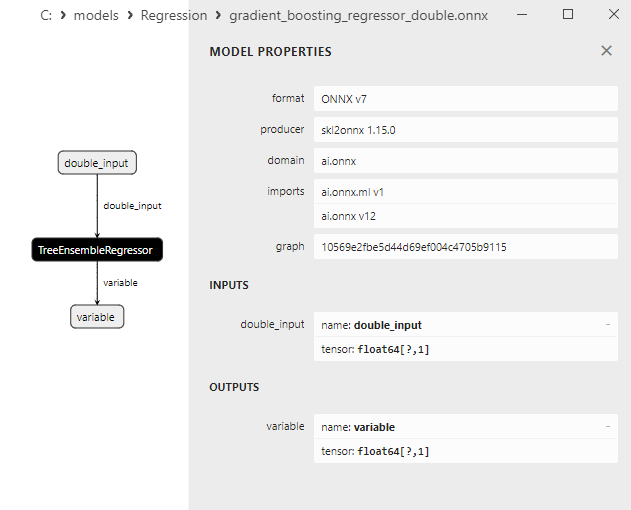

- 2.2.8. sklearn.ensemble.GradientBoostingRegressor

2.2.8.1. Código para criar o modelo GradientBoostingRegressor e exportá-lo para ONNX em float e double

2.2.8.2. Código MQL5 para executar Modelos ONNX

2.2.8.3. Representação ONNX do gradient_boosting_regressor_float.onnx e gradient_boosting_regressor_double.onnx

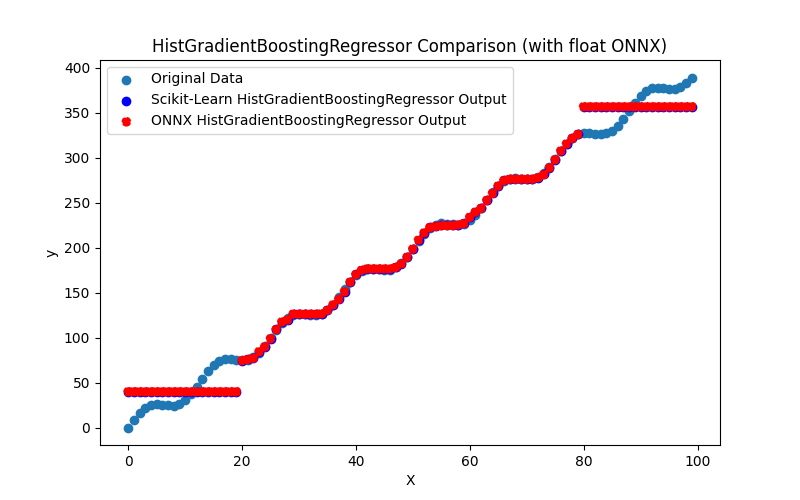

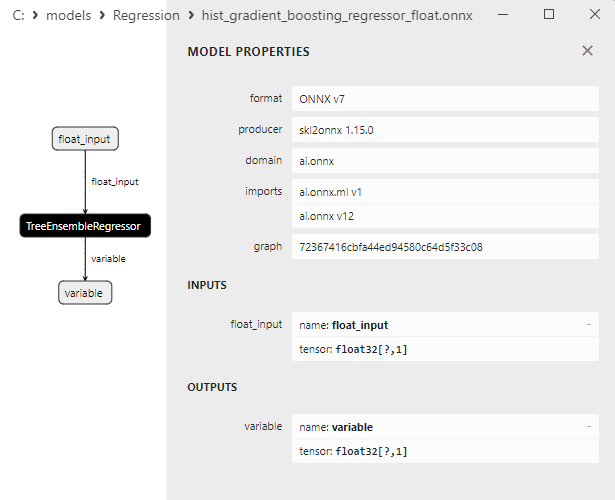

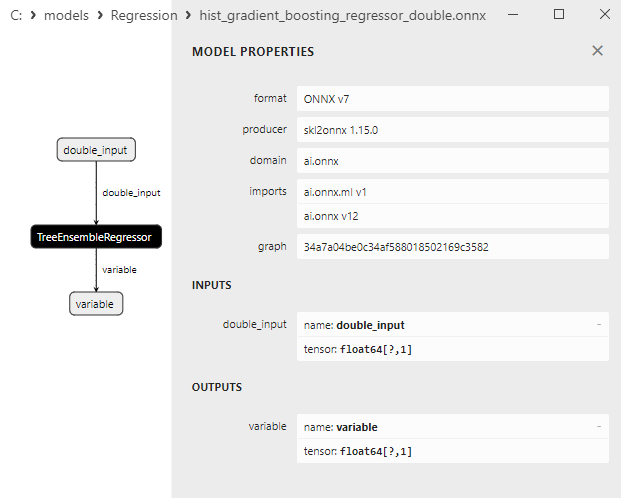

- 2.2.9. sklearn.ensemble.HistGradientBoostingRegressor

2.2.9.1. Código para criar o modelo HistGradientBoostingRegressor e exportá-lo para ONNX em float e double

2.2.9.2. Código MQL5 para executar Modelos ONNX

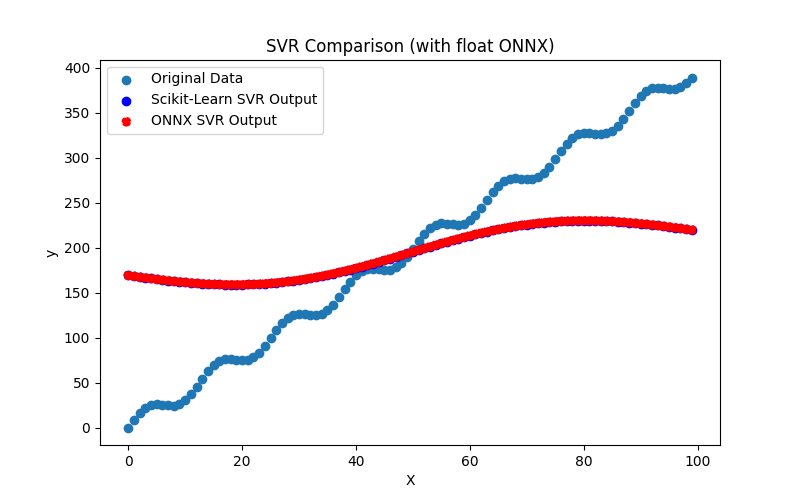

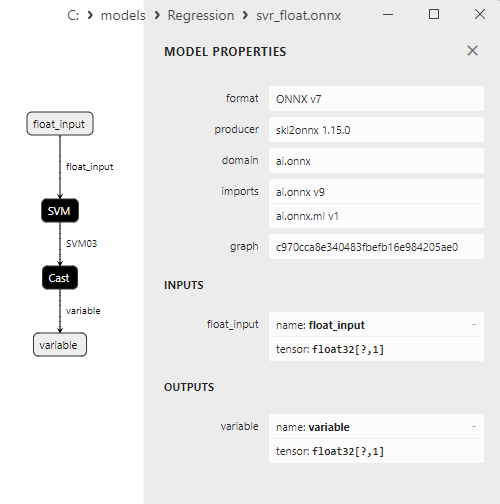

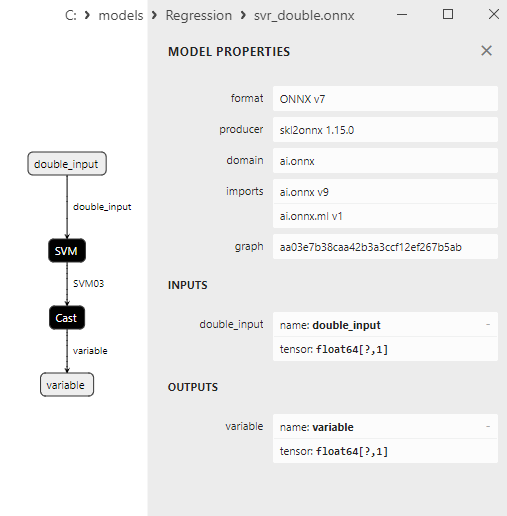

2.2.9.3. Representação ONNX do hist_gradient_boosting_regressor_float.onnx e hist_gradient_boosting_regressor_double.onnx - 2.2.10. sklearn.svm.SVR

2.2.10.1. Código para criar o modelo SVR e exportá-lo para ONNX em float e double

2.2.10.2. Código MQL5 para executar Modelos ONNX

2.2.10.3. Representação ONNX do svr_float.onnx and svr_double.onnx

- 2.3. Modelos de Regressão que encontraram problemas ao serem convertidos para ONNX

- 2.3.1. sklearn.dummy.DummyRegressor

Código para criar o DummyRegressor - 2.3.2. sklearn.kernel_ridge.KernelRidge

Código para criar o KernelRidge - 2.3.3. sklearn.isotonic.IsotonicRegression

Código para criar o IsotonicRegression - 2.3.4. sklearn.cross_decomposition.PLSCanonical

Código para criar o PLSCanonical - 2.3.5. sklearn.cross_decomposition.CCA

Código para criar o CCA - Conclusão

- Resumo

Se isso te incomoda, sinta-se à vontade para contribuir

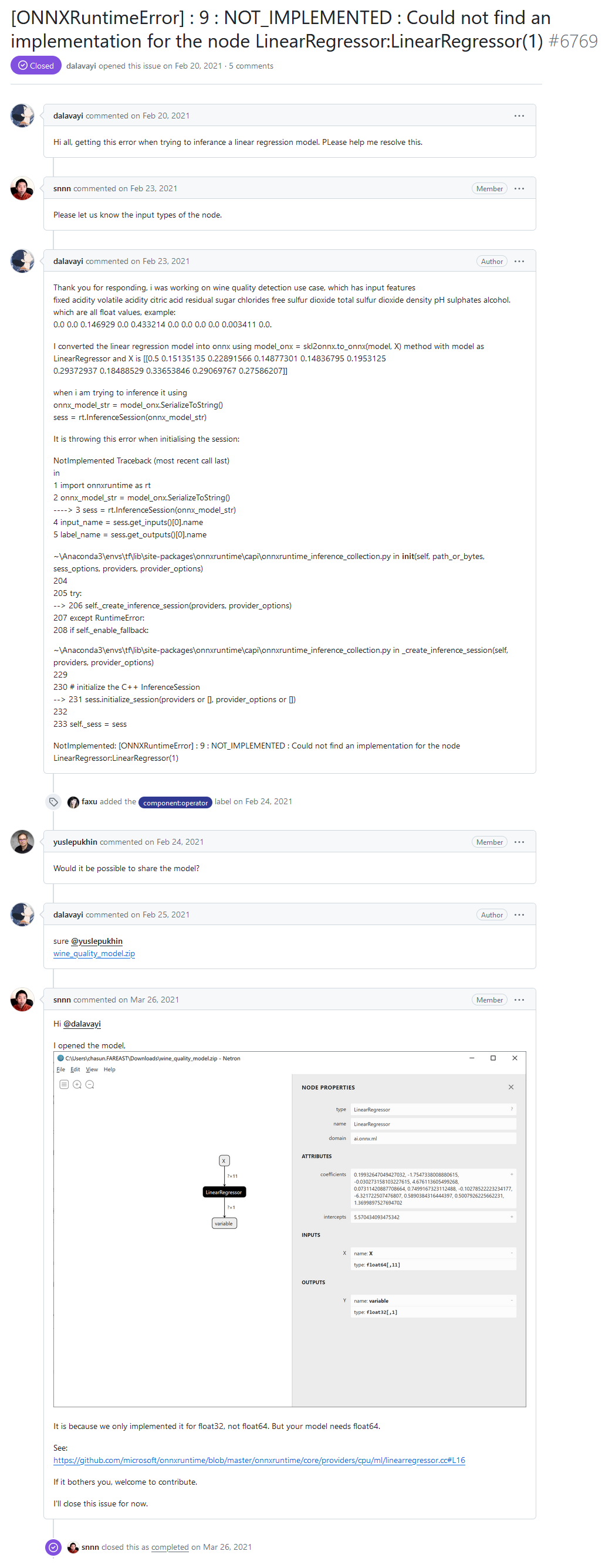

No fórum de desenvolvedores do ONNX Runtime, um dos usuários relatou um erro "[ONNXRuntimeError] : 9 : NOT_IMPLEMENTED : Could not find an implementation for the node LinearRegressor:LinearRegressor(1)" ao executar um modelo através do ONNX Runtime.

Olá a todos, estou recebendo este erro ao tentar inferir um modelo de regressão linear. Por favor, me ajudem a resolver isso.

Erro "NOT_IMPLEMENTED : Could not find an implementation for the node LinearRegressor (1)" do fórum de desenvolvedores do ONNX Runtime

Resposta do desenvolvedor:

Isso acontece porque nós implementamos apenas para float32, não para float64. Mas o seu modelo precisa de float64.

See:

https://github.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16

Se isso te incomoda, sinta-se à vontade para contribuir

No modelo ONNX do usuário, o operador ai.onnx.ml.LinearRegressor é chamado com o tipo de dado double (float64), e a mensagem de erro surge porque o ONNX Runtime não tem suporte para o operador LinearRegressor() com precisão double.

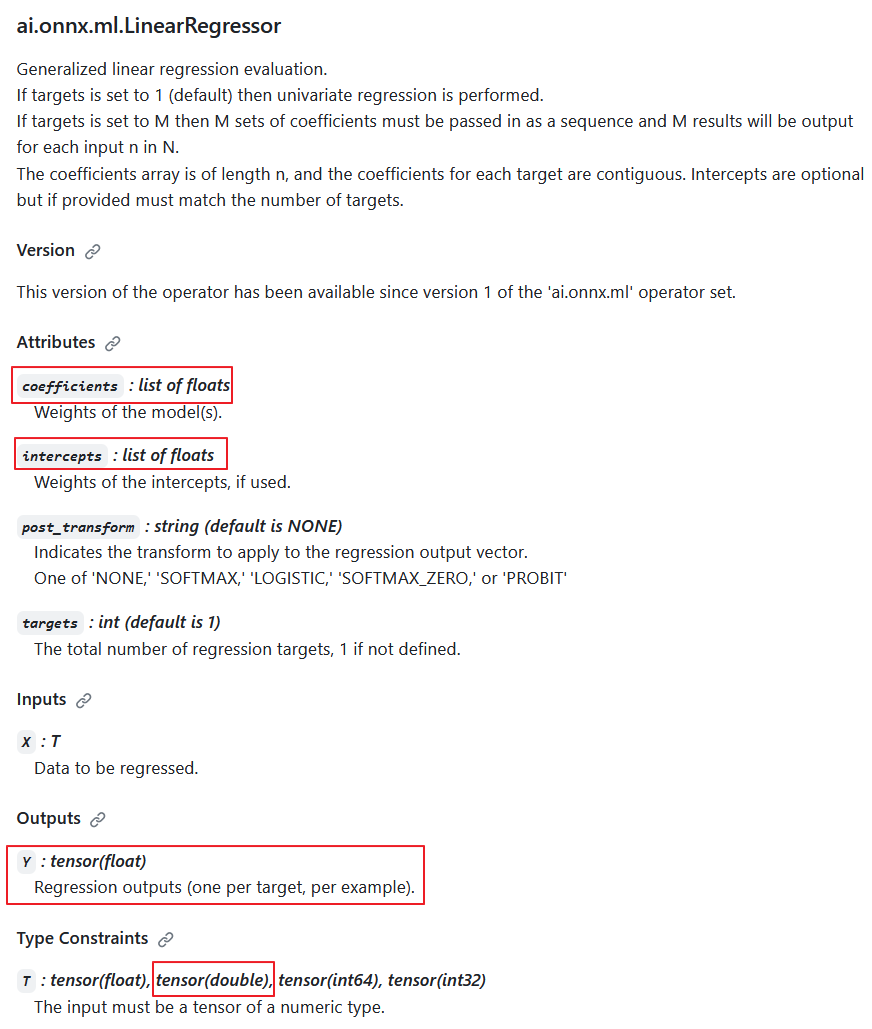

De acordo com a especificação do operador ai.onnx.ml.LinearRegressor, o tipo de dado de entrada double é possível (T: tensor(float), tensor(double), tensor(int64), tensor(int32)); no entanto, os desenvolvedores optaram por não implementá-lo intencionalmente.

A razão para isso é que a saída sempre retorna o valor Y: tensor(float). Além disso, os parâmetros computacionais são números float (coeficientes: lista de floats, interceptos: lista de floats).

Consequentemente, quando os cálculos são realizados em precisão double, este operador reduz a precisão para float, e sua implementação em cálculos de precisão double tem valor questionável.

ai.onnx.ml.LinearRegressor operator description

Assim, a redução da precisão para float nos parâmetros e no valor de saída torna impossível para o ai.onnx.ml.LinearRegressor operar totalmente com números double (float64). Presumivelmente, por essa razão, os desenvolvedores do ONNX Runtime decidiram abster-se de implementá-lo para o tipo double.

O método de "adicionar suporte para double" foi demonstrado pelos desenvolvedores nos comentários do código (destacado em amarelo).

No ONNX Runtime, seu cálculo é realizado usando a classe LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.h).

Os parâmetros do operador, coefficients_ e intercepts_, são armazenados como std::vector<float>:

#pragma once #include "core/common/common.h" #include "core/framework/op_kernel.h" #include "core/util/math_cpuonly.h" #include "ml_common.h" namespace onnxruntime { namespace ml { class LinearRegressor final : public OpKernel { public: LinearRegressor(const OpKernelInfo& info); Status Compute(OpKernelContext* context) const override; private: int64_t num_targets_; std::vector<float> coefficients_; std::vector<float> intercepts_; bool use_intercepts_; POST_EVAL_TRANSFORM post_transform_; }; } // namespace ml } // namespace onnxruntimeA implementação do operador LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.cc)

// Copyright (c) Microsoft Corporation. All rights reserved. // Licensed under the MIT License. #include "core/providers/cpu/ml/linearregressor.h" #include "core/common/narrow.h" #include "core/providers/cpu/math/gemm.h" namespace onnxruntime { namespace ml { ONNX_CPU_OPERATOR_ML_KERNEL( LinearRegressor, 1, // KernelDefBuilder().TypeConstraint("T", std::vector<MLDataType>{ // DataTypeImpl::GetTensorType<float>(), // DataTypeImpl::GetTensorType<double>()}), KernelDefBuilder().TypeConstraint("T", DataTypeImpl::GetTensorType<float>()), LinearRegressor); LinearRegressor::LinearRegressor(const OpKernelInfo& info) : OpKernel(info), intercepts_(info.GetAttrsOrDefault<float>("intercepts")), post_transform_(MakeTransform(info.GetAttrOrDefault<std::string>("post_transform", "NONE"))) { ORT_ENFORCE(info.GetAttr<int64_t>("targets", &num_targets_).IsOK()); ORT_ENFORCE(info.GetAttrs<float>("coefficients", coefficients_).IsOK()); // use the intercepts_ if they're valid use_intercepts_ = intercepts_.size() == static_cast<size_t>(num_targets_); } // Use GEMM for the calculations, with broadcasting of intercepts // https://github.com/onnx/onnx/blob/main/docs/Operators.md#Gemm // // X: [num_batches, num_features] // coefficients_: [num_targets, num_features] // intercepts_: optional [num_targets]. // Output: X * coefficients_^T + intercepts_: [num_batches, num_targets] template <typename T> static Status ComputeImpl(const Tensor& input, ptrdiff_t num_batches, ptrdiff_t num_features, ptrdiff_t num_targets, const std::vector<float>& coefficients, const std::vector<float>* intercepts, Tensor& output, POST_EVAL_TRANSFORM post_transform, concurrency::ThreadPool* threadpool) { const T* input_data = input.Data<T>(); T* output_data = output.MutableData<T>(); if (intercepts != nullptr) { TensorShape intercepts_shape({num_targets}); onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, intercepts->data(), &intercepts_shape, output_data, threadpool); } else { onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, nullptr, nullptr, output_data, threadpool); } if (post_transform != POST_EVAL_TRANSFORM::NONE) { ml::batched_update_scores_inplace(gsl::make_span(output_data, SafeInt<size_t>(num_batches) * num_targets), num_batches, num_targets, post_transform, -1, false, threadpool); } return Status::OK(); } Status LinearRegressor::Compute(OpKernelContext* ctx) const { Status status = Status::OK(); const auto& X = *ctx->Input<Tensor>(0); const auto& input_shape = X.Shape(); if (input_shape.NumDimensions() > 2) { return ORT_MAKE_STATUS(ONNXRUNTIME, INVALID_ARGUMENT, "Input shape had more than 2 dimension. Dims=", input_shape.NumDimensions()); } ptrdiff_t num_batches = input_shape.NumDimensions() <= 1 ? 1 : narrow<ptrdiff_t>(input_shape[0]); ptrdiff_t num_features = input_shape.NumDimensions() <= 1 ? narrow<ptrdiff_t>(input_shape.Size()) : narrow<ptrdiff_t>(input_shape[1]); Tensor& Y = *ctx->Output(0, {num_batches, num_targets_}); concurrency::ThreadPool* tp = ctx->GetOperatorThreadPool(); auto element_type = X.GetElementType(); switch (element_type) { case ONNX_NAMESPACE::TensorProto_DataType_FLOAT: { status = ComputeImpl<float>(X, num_batches, num_features, narrow<ptrdiff_t>(num_targets_), coefficients_, use_intercepts_ ? &intercepts_ : nullptr, Y, post_transform_, tp); break; } case ONNX_NAMESPACE::TensorProto_DataType_DOUBLE: { // TODO: Add support for 'double' to the scoring functions in ml_common.h // once that is done we can just call ComputeImpl<double>... // Alternatively we could cast the input to float. } default: status = ORT_MAKE_STATUS(ONNXRUNTIME, FAIL, "Unsupported data type of ", element_type); } return status; } } // namespace ml } // namespace onnxruntime

Acontece que há uma opção de usar números double como valores de entrada e realizar o cálculo do operador com parâmetros float. Outra possibilidade poderia ser reduzir a precisão dos dados de entrada para float. No entanto, nenhuma dessas opções pode ser considerada uma solução adequada.

A especificação do operador ai.onnx.ml.LinearRegressor restringe a capacidade de operação total com números double, já que os parâmetros e o valor de saída são limitados ao tipo float.

Uma situação semelhante ocorre com outros operadores ML do ONNX, como ai.onnx.ml.SVMRegressor e ai.onnx.ml.TreeEnsembleRegressor.

Como resultado, todos os desenvolvedores que utilizam a execução de modelos ONNX em precisão double enfrentam essa limitação da especificação. Uma solução poderia envolver a extensão da especificação ONNX (ou a adição de operadores semelhantes como LinearRegressor64, SVMRegressor64 e TreeEnsembleRegressor64 com parâmetros e valores de saída em double). No entanto, no momento, essa questão permanece sem solução.

Muito depende do conversor ONNX. Para modelos calculados em double, pode ser preferível evitar o uso desses operadores (embora isso nem sempre seja possível). Neste caso específico, o conversor para ONNX não funcionou de maneira ideal com o modelo do usuário.

Como veremos mais adiante, o conversor sklearn-onnx consegue contornar a limitação do LinearRegressor: para modelos ONNX double, ele usa os operadores ONNX MatMul() e Add() em vez disso. Graças a esse método, inúmeros modelos de regressão da biblioteca Scikit-learn são convertidos com sucesso em modelos ONNX calculados em double, preservando a precisão dos modelos double originais.

1. Conjunto de Dados de Teste

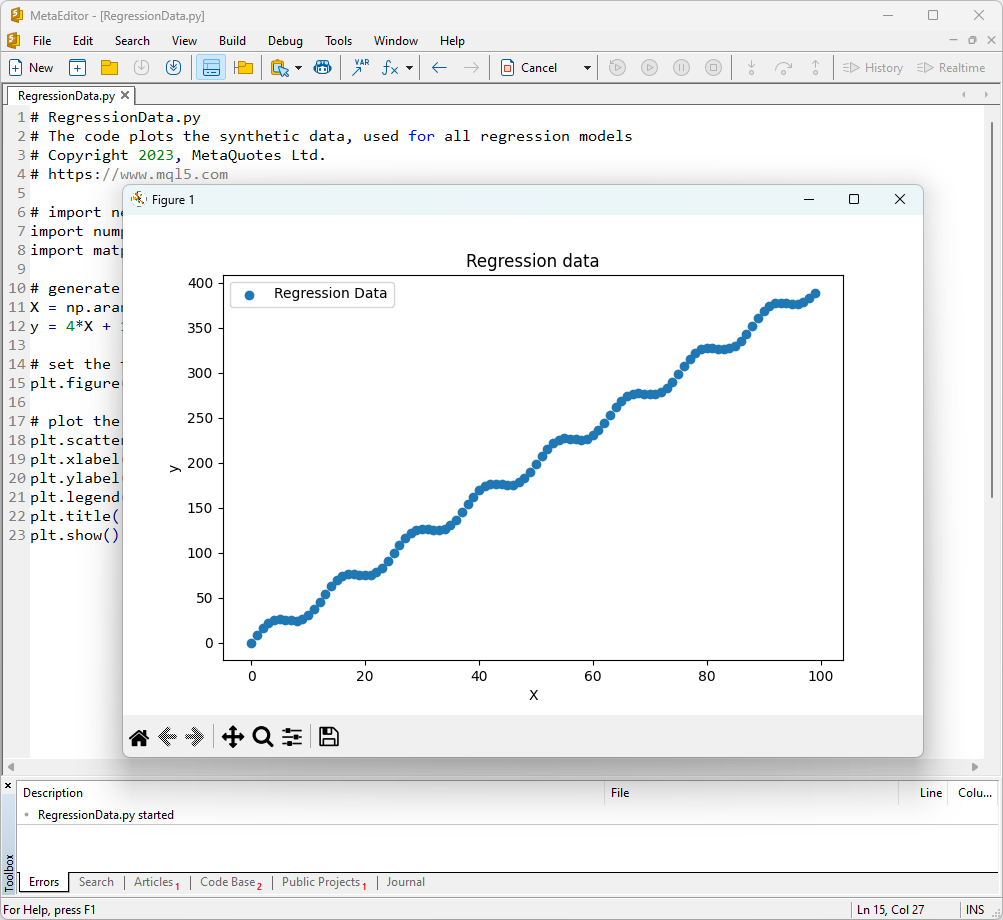

Para executar os exemplos, você precisará instalar o Python (usamos a versão 3.10.8), bibliotecas adicionais (pip install -U scikit-learn numpy matplotlib onnx onnxruntime skl2onnx) e especificar o caminho para o Python no MetaEditor (no menu Ferramentas->Opções->Compiladores->Python).

Como conjunto de dados de teste, usaremos valores gerados da função y = 4X + 10sin(X*0.5).

Para exibir um gráfico dessa função, abra o MetaEditor, crie um arquivo chamado RegressionData.py, copie o texto do script e execute-o clicando no botão "Compilar".

O script para exibir o conjunto de dados de teste

# RegressionData.py # The code plots the synthetic data, used for all regression models # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # import necessary libraries import numpy as np import matplotlib.pyplot as plt # generate synthetic data for regression X = np.arange(0,100,1).reshape(-1,1) y = 4*X + 10*np.sin(X*0.5) # set the figure size plt.figure(figsize=(8,5)) # plot the initial data for regression plt.scatter(X, y, label='Regression Data', marker='o') plt.xlabel('X') plt.ylabel('y') plt.legend() plt.title('Regression data') plt.show()

Como resultado, será exibido um gráfico da função, que usaremos para testar os métodos de regressão.

Fig.1. Função para testar modelos de regressão

2. Modelo de Regressão

O objetivo de uma tarefa de regressão é encontrar uma função ou modelo matemático que melhor descreva a relação entre as características e a variável alvo para prever valores numéricos para novos dados. Isso permite fazer previsões, otimizar soluções e tomar decisões informadas com base em dados.

Vamos considerar os principais modelos de regressão no pacote scikit-learn.

2.0. Lista de Modelos de Regressão do Scikit-learn

Para exibir uma lista dos modelos de regressão disponíveis no scikit-learn, você pode usar o script:

# ScikitLearnRegressors.py # The script lists all the regression algorithms available inb scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn regression models from sklearn.utils import all_estimators regressors = all_estimators(type_filter='regressor') for index, (name, RegressorClass) in enumerate(regressors, start=1): print(f"Regressor {index}: {name}")

Saída:

The scikit-learn version is 1.3.2.

Regressor 1: ARDRegression

Regressor 2: AdaBoostRegressor

Regressor 3: BaggingRegressor

Regressor 4: BayesianRidge

Regressor 5: CCA

Regressor 6: DecisionTreeRegressor

Regressor 7: DummyRegressor

Regressor 8: ElasticNet

Regressor 9: ElasticNetCV

Regressor 10: ExtraTreeRegressor

Regressor 11: ExtraTreesRegressor

Regressor 12: GammaRegressor

Regressor 13: GaussianProcessRegressor

Regressor 14: GradientBoostingRegressor

Regressor 15: HistGradientBoostingRegressor

Regressor 16: HuberRegressor

Regressor 17: IsotonicRegression

Regressor 18: KNeighborsRegressor

Regressor 19: KernelRidge

Regressor 20: Lars

Regressor 21: LarsCV

Regressor 22: Lasso

Regressor 23: LassoCV

Regressor 24: LassoLars

Regressor 25: LassoLarsCV

Regressor 26: LassoLarsIC

Regressor 27: LinearRegression

Regressor 28: LinearSVR

Regressor 29: MLPRegressor

Regressor 30: MultiOutputRegressor

Regressor 31: MultiTaskElasticNet

Regressor 32: MultiTaskElasticNetCV

Regressor 33: MultiTaskLasso

Regressor 34: MultiTaskLassoCV

Regressor 35: NuSVR

Regressor 36: OrthogonalMatchingPursuit

Regressor 37: OrthogonalMatchingPursuitCV

Regressor 38: PLSCanonical

Regressor 39: PLSRegression

Regressor 40: PassiveAggressiveRegressor

Regressor 41: PoissonRegressor

Regressor 42: QuantileRegressor

Regressor 43: RANSACRegressor

Regressor 44: RadiusNeighborsRegressor

Regressor 45: RandomForestRegressor

Regressor 46: RegressorChain

Regressor 47: Ridge

Regressor 48: RidgeCV

Regressor 49: SGDRegressor

Regressor 50: SVR

Regressor 51: StackingRegressor

Regressor 52: TheilSenRegressor

Regressor 53: TransformedTargetRegressor

Regressor 54: TweedieRegressor

Regressor 55: VotingRegressor

Para conveniência, nesta lista de regressoras, elas estão destacadas em diferentes cores. Modelos que requerem um modelo de regressão base estão destacados em cinza, enquanto outros modelos podem ser usados de forma independente. Note que os modelos exportados com sucesso para o formato ONNX estão marcados em verde, e os modelos que encontram erros durante a conversão na versão atual do scikit-learn 1.2.2 estão marcados em vermelho. Métodos inadequados para a tarefa de teste considerada estão destacados em azul.

A análise da qualidade da regressão usa métricas de regressão, que são funções dos valores reais e previstos. Na linguagem MQL5, várias métricas diferentes estão disponíveis, detalhadas no artigo "Avaliando modelos ONNX usando métricas de regressão".

Neste artigo, três métricas serão usadas para comparar a qualidade de diferentes modelos:

- Coeficiente de determinação R-quadrado (R2);

- Erro Médio Absoluto (MAE);

- Erro Médio Quadrático (MSE).

2.1. Modelos de Regressão do Scikit-learn que se convertem para modelos ONNX float e double

Esta seção apresenta modelos de regressão que são convertidos com sucesso para formatos ONNX em ambas as precisões float e double.

Todos os modelos de regressão discutidos a seguir são apresentados no seguinte formato:

- Descrição do modelo, princípio de funcionamento, vantagens e limitações

- Script Python para criar o modelo, exportá-lo para arquivos ONNX em formatos float e double, e executar os modelos obtidos usando o ONNX Runtime em Python. Métricas como R^2, MAE, MSE, calculadas usando sklearn.metrics, são usadas para avaliar a qualidade dos modelos originais e ONNX.

- Script MQL5 para executar modelos ONNX (float e double) via ONNX Runtime, com métricas calculadas usando RegressionMetric().

- Representação do modelo ONNX no Netron para precisão float e double.

2.1.1. sklearn.linear_model.ARDRegression

ARDRegression (Regressão por Determinação Automática de Relevância) é um método de regressão projetado para abordar problemas de regressão enquanto determina automaticamente a importância (relevância) das características e estabelece seus pesos durante o processo de treinamento do modelo.

ARDRegression permite a detecção e uso apenas das características mais importantes para construir um modelo de regressão, o que pode ser benéfico ao lidar com um grande número de características.

Princípio de Funcionamento do ARDRegression:

- Regressão Linear: ARDRegression é baseado em regressão linear, assumindo uma relação linear entre as variáveis independentes (características) e a variável alvo.

- Determinação Automática da Importância das Características: A principal distinção do ARDRegression é sua determinação automática de quais características são mais importantes para prever a variável alvo. Isso é alcançado introduzindo distribuições prévias (regularização) sobre os pesos, permitindo que o modelo defina automaticamente pesos zero para características menos significativas.

- Estimativa das Probabilidades Posteriores: ARDRegression calcula probabilidades posteriores para cada característica, permitindo determinar sua importância. Características com altas probabilidades posteriores são consideradas relevantes e recebem pesos não zero, enquanto características com baixas probabilidades posteriores recebem pesos zero.

- Redução de Dimensionalidade: Assim, ARDRegression pode levar à redução da dimensionalidade dos dados removendo características insignificantes.

Vantagens do ARDRegression:

- Determinação Automática das Características Importantes: O método identifica e usa automaticamente apenas as características mais importantes, potencialmente melhorando o desempenho do modelo e reduzindo o risco de overfitting.

- Resiliência à Multicolinearidade: ARDRegression lida bem com a multicolinearidade, mesmo quando as características são altamente correlacionadas.

Limitações do ARDRegression:

- Requer Seleção de Distribuições Prévias: A escolha de distribuições prévias adequadas pode requerer experimentação.

- Complexidade Computacional: Treinar ARDRegression pode ser computacionalmente caro, especialmente para grandes conjuntos de dados.

ARDRegression é um método de regressão que determina automaticamente a importância das características e estabelece seus pesos com base nas probabilidades posteriores. Este método é útil quando é necessário considerar apenas as características significativas para construir um modelo de regressão e reduzir a dimensionalidade dos dados.

2.1.1.1. Código para criar o modelo ARDRegression e exportá-lo para ONNX em float e double

Este código cria o modelo sklearn.linear_model.ARDRegression, treina-o em dados sintéticos, salva o modelo no formato ONNX e realiza previsões usando dados de entrada tanto em float quanto em double. Ele também avalia a precisão do modelo original e dos modelos exportados para ONNX.

# The code demonstrates the process of training ARDRegressor model, exporting it to ONNX format (both float and double), and making predictions using the ONNX models.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# function to compare matching decimal places

def compare_decimal_places(value1, value2):

# convert both values to strings

str_value1 = str(value1)

str_value2 = str(value2)

# find the positions of the decimal points in the strings

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# if one of the values doesn't have a decimal point, return 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calculate the number of decimal places

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# find the minimum of the two decimal places counts

min_decimal_places = min(decimal_places1, decimal_places2)

# initialize a count for matching decimal places

matching_count = 0

# compare characters after the decimal point

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ARDRegression

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# define the path for saving the model

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generate synthetic data for regression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name="ARDRegression"

onnx_model_filename = data_path + "ard_regression"

# create an ARDRegression model

regression_model = ARDRegression()

# fit the model to the data

regression_model.fit(X, y.ravel())

# predict values for the entire dataset

y_pred = regression_model.predict(X)

# evaluate the model's performance

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convert to ONNX-model (float)

# define the input data type as FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as FloatTensorType

initial_type_float = X.astype(np.float32)

# predict values for the entire dataset using ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# set the figure size

plt.figure(figsize=(8, 5))

# plot the original data and the regression data

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convert to ONNX-model (double)

# define the input data type as DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as DoubleTensorType

initial_type_double = X.astype(np.float64)

# predict values for the entire dataset using ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# set the figure size

plt.figure(figsize=(8, 5))

# plot the original data and the regression line

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

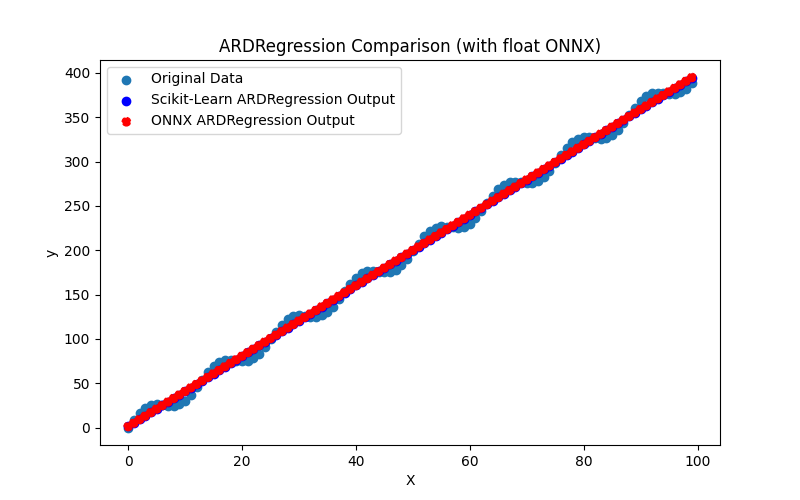

O script cria e treina o modelo sklearn.linear_model.ARDRegression (o modelo original é considerado em double), exporta o modelo para ONNX em float e double (ard_regression_float.onnx e ard_regression_double.onnx) e compara a precisão de sua operação.

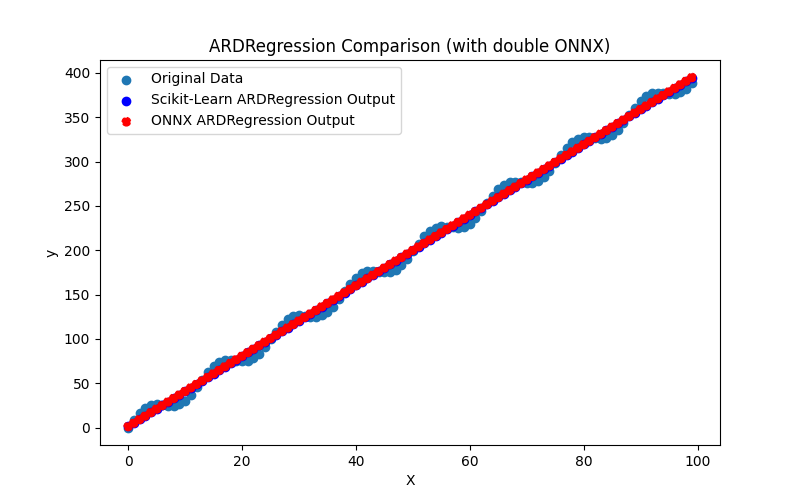

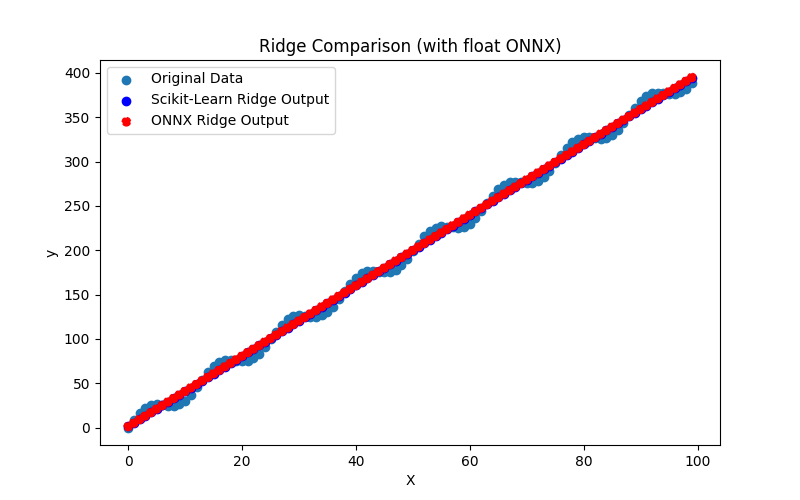

Ele também gera os arquivos ARDRegression_plot_float.png e ARDRegression_plot_double.png, permitindo uma avaliação visual dos resultados dos modelos ONNX para float e double (Fig. 2-3).

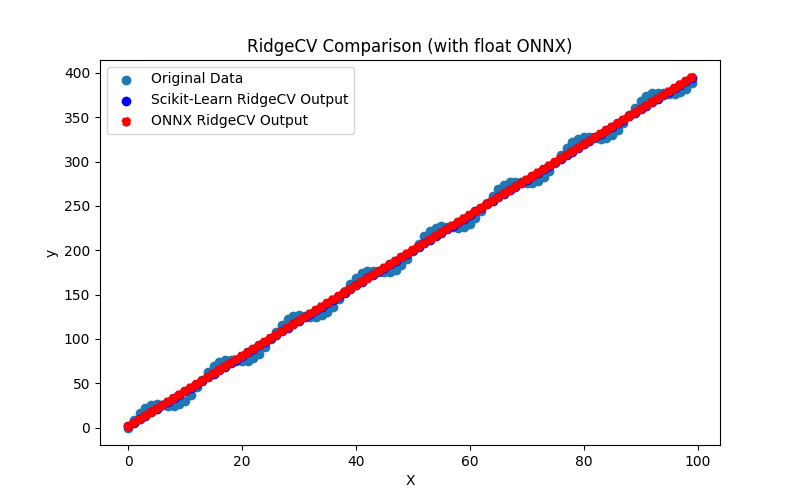

Fig.2. Resultados do ARDRegression.py (float)

Fig.3. Resultados do ARDRegression.py (double)

Visualmente, os modelos ONNX para float e double parecem os mesmos (Fig. 2-3), informações detalhadas podem ser encontradas na aba Journal:

Python ARDRegression Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python Python ARDRegression ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python ONNX: MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python ARDRegression ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

Neste exemplo, o modelo original foi considerado em double, e depois foi exportado para os modelos ONNX ard_regression_float.onnx e ard_regression_double.onnx para float e double, respectivamente.

Se a precisão do modelo for avaliada pelo Erro Médio Absoluto (MAE), a precisão do modelo ONNX para float é de até 6 casas decimais, enquanto o modelo ONNX usando double mostrou retenção de precisão de até 15 casas decimais, em conformidade com a precisão do modelo original.

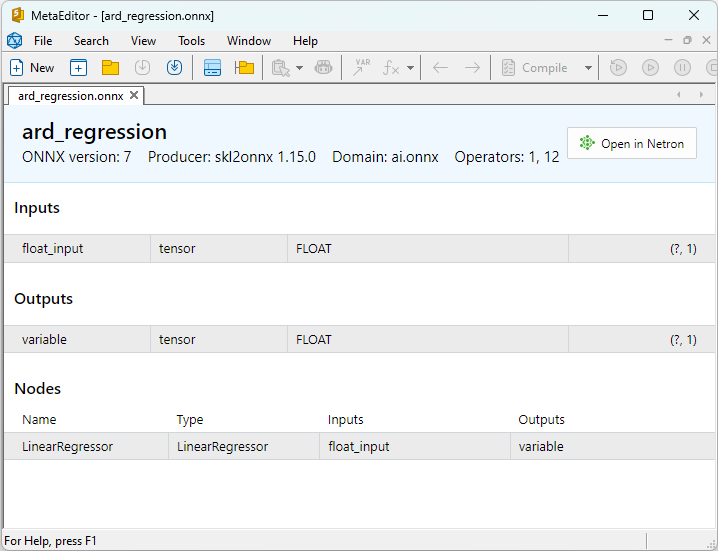

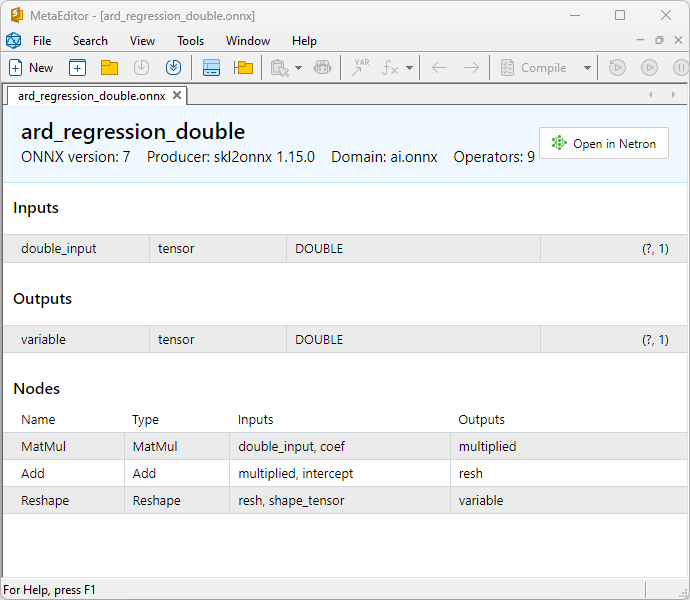

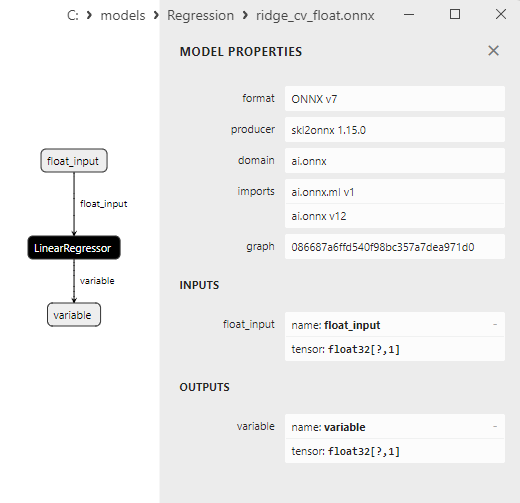

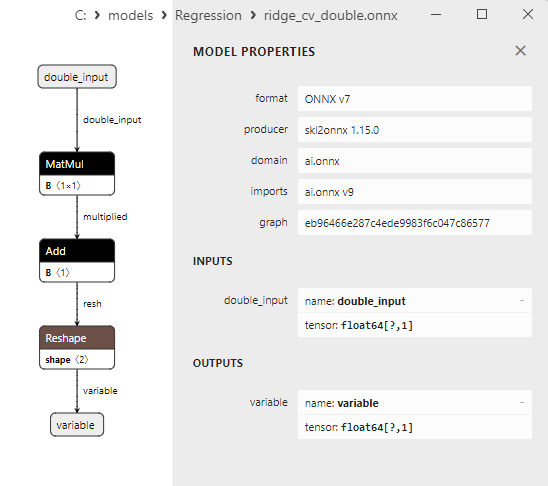

As propriedades dos modelos ONNX podem ser visualizadas no MetaEditor (Fig. 4-5).

Fig.4. ard_regression_float.onnx modelo ONNX no MetaEditor

Fig.5. ard_regression_double.onnx modelo ONNX no MetaEditor

Uma comparação entre os modelos ONNX em float e double mostra que, neste caso, o cálculo dos modelos ONNX para ARDRegression ocorre de maneira diferente: para números float, o operador LinearRegressor() do ONNX-ML é usado, enquanto para números double, são utilizados os operadores ONNX MatMul(), Add() e Reshape().

A implementação do modelo em ONNX depende do conversor; nos exemplos para exportação para ONNX, a função skl2onnx.convert_sklearn() da biblioteca skl2onnx será usada.

2.1.1.2. Código MQL5 para executar Modelos ONNX

Este código executa os modelos ONNX salvos ard_regression_float.onnx e ard_regression_double.onnx e demonstra o uso de métricas de regressão em MQL5.

//+------------------------------------------------------------------+ //| ARDRegression.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "ARDRegression" #define ONNXFilenameFloat "ard_regression_float.onnx" #define ONNXFilenameDouble "ard_regression_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Saída:

ARDRegression (EURUSD,H1) Testing ONNX float: ARDRegression (ard_regression_float.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 ARDRegression (EURUSD,H1) ARDRegression (EURUSD,H1) Testing ONNX double: ARDRegression (ard_regression_double.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537597 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128795

Comparação com o modelo original em double no Python:

Testing ONNX float: ARDRegression (ard_regression_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: ARDRegression (ard_regression_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537597

Precisão do ONNX float MAE: 6 casas decimais, Precisão do ONNX double MAE: 14 casas decimais.

2.1.1.3. As representações ONNX dos modelos ard_regression_float.onnx e ard_regression_double.onnx

Netron (versão web) é uma ferramenta para visualização de modelos e análise de gráficos de computação, que pode ser usada para modelos no formato ONNX (Open Neural Network Exchange).

Netron apresenta gráficos de modelos e sua arquitetura de forma clara e interativa, permitindo a exploração da estrutura e dos parâmetros de modelos de aprendizado profundo, incluindo aqueles criados usando ONNX.

Principais características do Netron incluem:

- Visualização de Gráficos: Netron exibe a arquitetura do modelo como um gráfico, permitindo ver as camadas, operações e conexões entre elas. Você pode compreender facilmente a estrutura e o fluxo de dados dentro do modelo.

- Exploração Interativa: Você pode selecionar nós no gráfico para obter informações adicionais sobre cada operador e seus parâmetros.

- Suporte para Vários Formatos: Netron suporta uma variedade de formatos de modelos de aprendizado profundo, incluindo ONNX, TensorFlow, PyTorch, CoreML e outros.

- Capacidade de Análise de Parâmetros: Você pode visualizar os parâmetros e pesos do modelo, o que é útil para entender os valores usados em diferentes partes do modelo.

Netron é conveniente para desenvolvedores e pesquisadores na área de aprendizado de máquina e aprendizado profundo, pois simplifica a visualização e análise de modelos, auxiliando na compreensão e depuração de redes neurais complexas.

Esta ferramenta permite uma inspeção rápida do modelo, explorando sua estrutura e parâmetros, facilitando o trabalho com redes neurais profundas.

Para mais detalhes sobre o Netron, consulte os artigos: Visualizing your Neural Network with Netron e Visualize Keras Neural Networks with Netron.

Vídeo sobre o Netron::

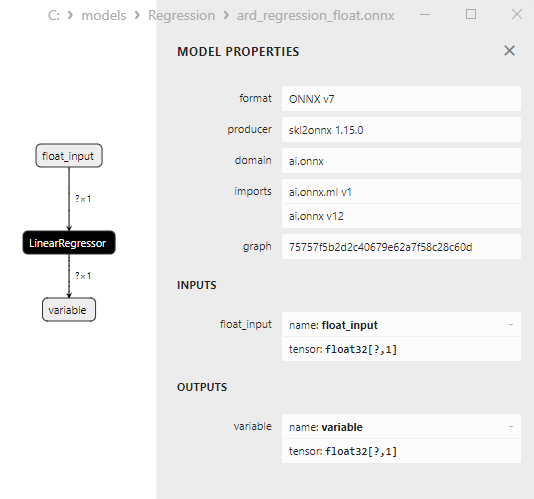

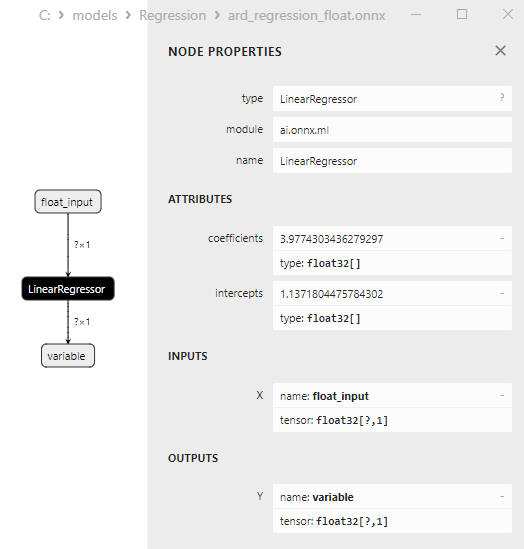

O modelo ard_regression_float.onnx é mostrado na Fig.6:

Fig.6. Representação ONNX do modelo ard_regression_float.onnx no Netron

O operador ONNX LinearRegressor() da ai.onnx.ml é parte do padrão ONNX, descrevendo um modelo para tarefas de regressão. Este operador é usado para regressão, que envolve a previsão de valores numéricos (contínuos) com base em características de entrada.

Ele recebe os parâmetros do modelo como entrada, tais como pesos e bias, junto com as características de entrada, e executa a regressão linear. A regressão linear estima os parâmetros (pesos) para cada característica de entrada e, em seguida, realiza uma combinação linear dessas características com os pesos para gerar uma previsão.

Este operador realiza os seguintes passos:

- Recebe os pesos e bias do modelo, juntamente com as características de entrada.

- Para cada exemplo de dados de entrada, realiza uma combinação linear dos pesos com as características correspondentes.

- Adiciona o bias ao valor resultante.

O resultado é a previsão da variável alvo na tarefa de regressão.

Os parâmetros do LinearRegressor() são mostrados na Fig.7.

Fig.7. As propriedades do operador LinearRegressor() do modelo ard_regression_float.onnx no Netron

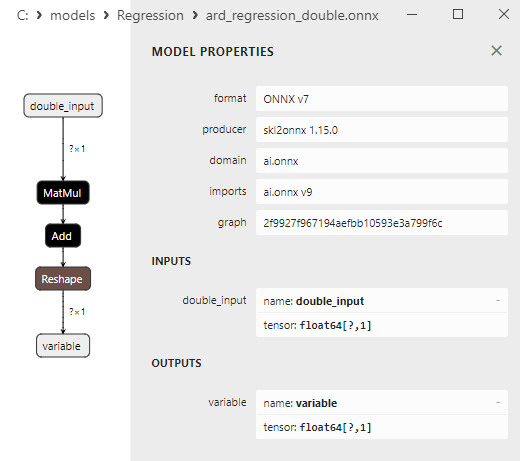

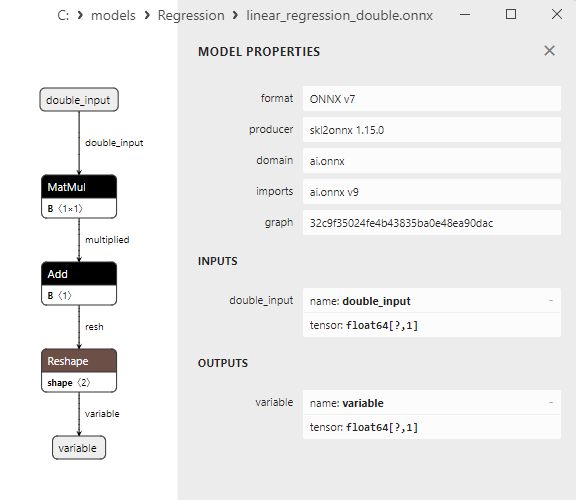

Fig.8. Representação ONNX do modelo ard_regression_double.onnx no Netron

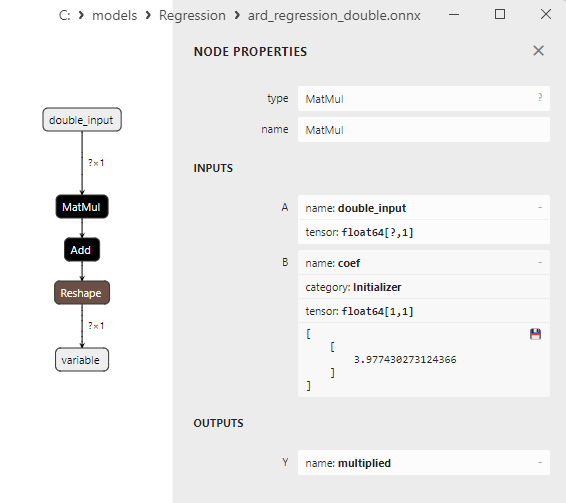

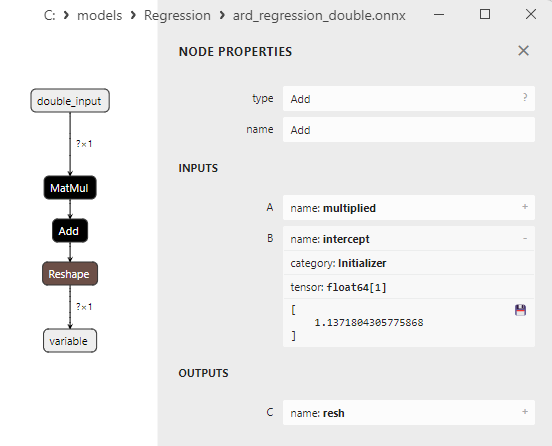

Os parâmetros dos operadores ONNX MatMul(), Add() e Reshape() são mostrados nas Fig.9-11.

Fig.9. Propriedades do operador MatMul no modelo ard_regression_double.onnx no Netron

O operador ONNX MatMul (multiplicação de matrizes) realiza a multiplicação de duas matrizes.

Ele recebe duas entradas: duas matrizes e retorna seu produto matricial.

Se você tiver duas matrizes, A e B, o resultado de Matmul(A, B) é uma matriz C, onde cada elemento C[i][j] é calculado como a soma dos produtos dos elementos da linha i da matriz A pelos elementos da coluna j da matriz B.

Fig.10. Propriedades do operador Add no modelo ard_regression_double.onnx no Netron

O operador ONNX Add() realiza a adição elemento a elemento de dois tensores ou matrizes de mesma forma.

Ele recebe duas entradas e retorna o resultado, onde cada elemento do tensor resultante é igual à soma dos elementos correspondentes dos tensores de entrada.

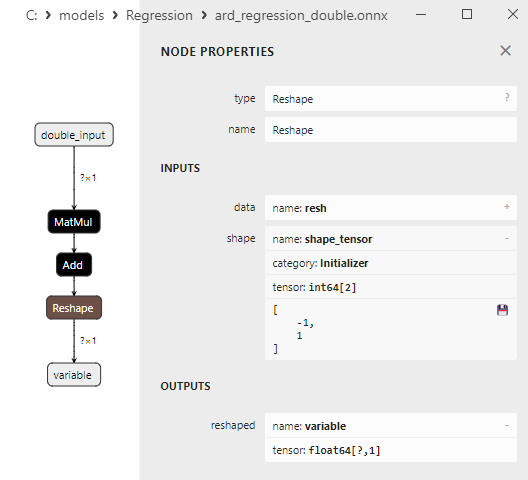

Fig.11. Propriedades do operador Reshape no modelo ard_regression_double.onnx no Netron

O operador ONNX Reshape(-1,1) é usado para modificar a forma (ou dimensão) dos dados de entrada. Neste operador, o valor -1 para a dimensão indica que o tamanho dessa dimensão deve ser calculado automaticamente com base nas outras dimensões para garantir a consistência dos dados.

O valor 1 na segunda dimensão especifica que, após a transformação da forma, cada elemento terá uma única subdimensão.

2.1.2. sklearn.linear_model.BayesianRidge

BayesianRidge é um método de regressão que utiliza uma abordagem bayesiana para estimar os parâmetros do modelo. Este método permite modelar a distribuição a priori dos parâmetros e atualizá-la considerando os dados para obter a distribuição a posteriori dos parâmetros.

BayesianRidge é um método de regressão bayesiana projetado para prever a variável dependente com base em uma ou várias variáveis independentes.

Princípio de Funcionamento do BayesianRidge:

- Distribuição a priori dos parâmetros: Começa com a definição da distribuição a priori dos parâmetros do modelo. Esta distribuição representa o conhecimento prévio ou suposições sobre os parâmetros do modelo antes de considerar os dados. No caso do BayesianRidge, distribuições a priori em forma de Gaussianas são usadas.

- Atualizando a distribuição dos parâmetros: Uma vez que a distribuição a priori dos parâmetros é definida, ela é atualizada com base nos dados. Isso é feito usando a teoria bayesiana, onde a distribuição a posteriori dos parâmetros é calculada considerando os dados. Um aspecto essencial é a estimativa dos hiperparâmetros, que influenciam a forma da distribuição a posteriori.

- Previsão: Após a estimativa da distribuição a posteriori dos parâmetros, previsões podem ser feitas para novas observações. Isso resulta em uma distribuição de previsões, em vez de um único valor pontual, permitindo que a incerteza nas previsões seja considerada.

Vantagens do BayesianRidge:

- Consideração da incerteza: O BayesianRidge leva em conta a incerteza nos parâmetros do modelo e nas previsões. Em vez de previsões pontuais, são fornecidos intervalos de confiança.

- Regularização: O método de regressão bayesiana pode ser útil para a regularização do modelo, auxiliando na prevenção do overfitting.

- Seleção automática de características: O BayesianRidge pode determinar automaticamente a importância das características, reduzindo os pesos das características insignificantes.

Limitações do BayesianRidge:

- Complexidade computacional: O método requer recursos computacionais para estimar os parâmetros e calcular a distribuição a posteriori.

- Alto nível de abstração: Pode ser necessário um entendimento mais profundo de estatísticas bayesianas para compreender e usar o BayesianRidge.

- Nem sempre a melhor escolha: O BayesianRidge pode não ser o método mais adequado em certas tarefas de regressão, especialmente ao lidar com dados limitados.

BayesianRidge é útil em tarefas de regressão onde a incerteza dos parâmetros e previsões é importante e em casos onde a regularização do modelo é necessária.

2.1.2.1. Código para criar o modelo BayesianRidge e exportá-lo para ONNX em float e double

Este código cria o modelo sklearn.linear_model.BayesianRidge, treina-o em dados sintéticos, salva o modelo no formato ONNX e realiza previsões usando dados de entrada tanto em float quanto em double. Ele também avalia a precisão do modelo original e dos modelos exportados para ONNX.

# The code demonstrates the process of training BayesianRidge model, exporting it to ONNX format (both float and double), and making predictions using the ONNX models.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# function to compare matching decimal places

def compare_decimal_places(value1, value2):

# convert both values to strings

str_value1 = str(value1)

str_value2 = str(value2)

# find the positions of the decimal points in the strings

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# if one of the values doesn't have a decimal point, return 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calculate the number of decimal places

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# find the minimum of the two decimal places counts

min_decimal_places = min(decimal_places1, decimal_places2)

# initialize a count for matching decimal places

matching_count = 0

# compare characters after the decimal point

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import BayesianRidge

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# define the path for saving the model

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generate synthetic data for regression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name = "BayesianRidge"

onnx_model_filename = data_path + "bayesian_ridge"

# create a Bayesian Ridge regression model

regression_model = BayesianRidge()

# fit the model to the data

regression_model.fit(X, y.ravel())

# predict values for the entire dataset

y_pred = regression_model.predict(X)

# evaluate the model's performance

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convert to ONNX-model (float)

# define the input data type as FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as FloatTensorType

initial_type_float = X.astype(np.float32)

# predict values for the entire dataset using ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# set the figure size

plt.figure(figsize=(8,5))

# plot the original data and the regression data

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convert to ONNX-model (double)

# define the input data type as DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as DoubleTensorType

initial_type_double = X.astype(np.float64)

# predict values for the entire dataset using ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# set the figure size

plt.figure(figsize=(8,5))

# plot the original data and the regression line

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

Saída:

Python BayesianRidge Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python Python BayesianRidge ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python BayesianRidge ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

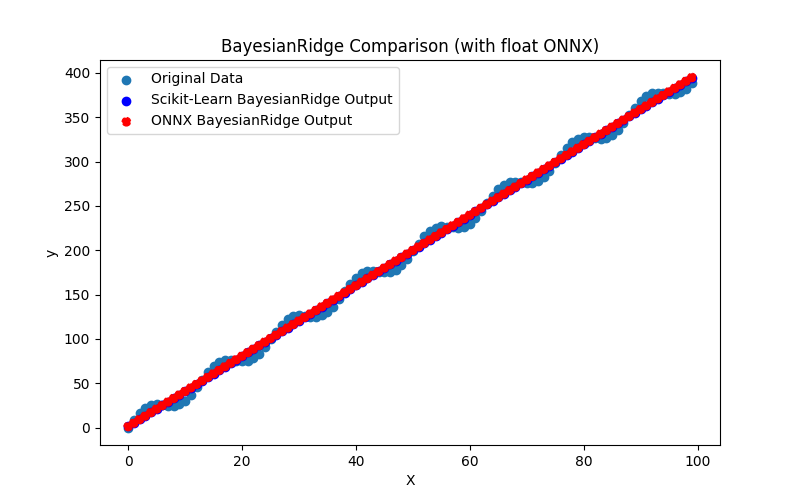

Fig.12. Resultados do BayesianRidge.py (float ONNX)

2.1.2.2. Código MQL5 para executar Modelos ONNX

Este código executa os modelos ONNX salvos bayesian_ridge_float.onnx e bayesian_ridge_double.onnx e demonstra o uso de métricas de regressão em MQL5.

//+------------------------------------------------------------------+ //| BayesianRidge.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "BayesianRidge" #define ONNXFilenameFloat "bayesian_ridge_float.onnx" #define ONNXFilenameDouble "bayesian_ridge_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Saída:

BayesianRidge (EURUSD,H1) Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 BayesianRidge (EURUSD,H1) BayesianRidge (EURUSD,H1) Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537624 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128866

Comparação com o modelo original em double no Python:

Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537624

Precisão do ONNX float MAE: 6 casas decimais, Precisão do ONNX double MAE: 13 casas decimais.

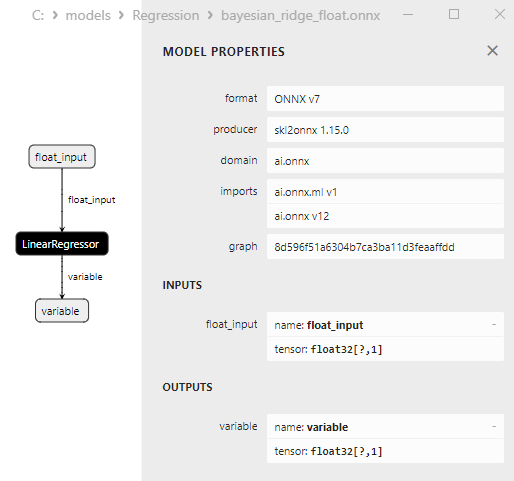

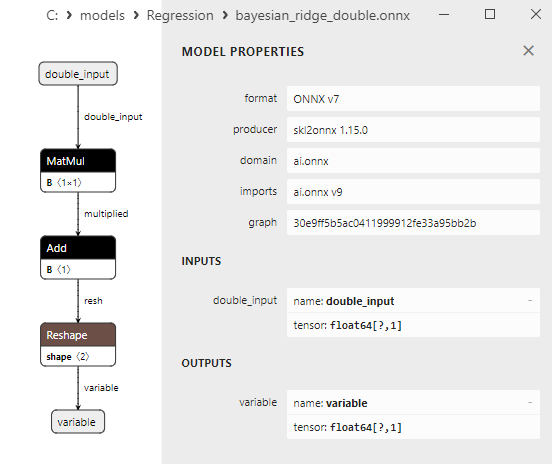

2.1.2.3. Representação ONNX do bayesian_ridge_float.onnx e bayesian_ridge_double.onnx

Fig.13. Representação ONNX do bayesian_ridge_float.onnx no Netron

Fig.14. Representação ONNX do bayesian_ridge_double.onnx no Netron

Nota sobre os Métodos ElasticNet e ElasticNetCV

ElasticNet e ElasticNetCV são dois métodos de aprendizado de máquina relacionados, usados para regularizar modelos de regressão, especialmente a regressão linear. Eles compartilham funcionalidades comuns, mas diferem na maneira de uso e aplicação.

ElasticNet (Regressão Elastic Net):

- Princípio de Funcionamento: ElasticNet é um método de regressão que combina Lasso (regularização L1) e Ridge (regularização L2). Ele adiciona dois componentes de regularização à função de perda: um penaliza o modelo por valores absolutos grandes dos coeficientes (como o Lasso), e o outro penaliza o modelo por grandes quadrados dos coeficientes (como o Ridge).

- ElasticNet é comumente usado quando há multicolinearidade nos dados (quando as características são altamente correlacionadas) e quando a redução de dimensionalidade é necessária, além de controlar os valores dos coeficientes.

ElasticNetCV (Validação Cruzada Elastic Net):