Neuronale Netze leicht gemacht (Teil 18): Assoziationsregeln

Inhalt

- Einführung

- 1. Assoziationsregeln

- 2. Apriori-Algorithmus

- 3. FP-Wachstumsalgorithmus

- Schlussfolgerung

- Liste der Referenzen

Einführung

Das Wachstum der analysierten Datenmengen führt zu einem wachsenden Interesse an unüberwachten Lernmethoden. In den letzten Artikeln haben wir bereits Algorithmen zum Clustering und zur Dimensionsreduktion gesehen, die zu den unüberwachten Lernmethoden gehören. In diesem Artikel setzen wir die Untersuchung von Methoden des unüberwachten Lernens fort. Dieses Mal werden wir eine andere Art von Problemen betrachten, die mit diesen Methoden angegangen werden können: das Mining von Assoziationsregeln. Dieser Problemtyp stammt ursprünglich aus dem Supermarkt-Einkaufsmarketing, wo er zur Analyse von Warenkörben mit dem Ziel verwendet wurde, die am häufigsten anzutreffenden Produktgruppen zu ermitteln. Heutzutage werden Algorithmen, die diese Probleme lösen, in vielen Bereichen eingesetzt. Wir werden uns ansehen, wie solche Algorithmen im Handel eingesetzt werden können.

1. Assoziationsregeln

Das Problem der Analyse von Assoziationsregeln gehört zu den angewandten Problemen des Data Mining. Außerdem ist es eines der grundlegenden Verfahren, da es die Identifizierung interessanter Beziehungen zwischen Daten in großen Datenbanken ermöglicht.

Diese Art von Problem wurde erstmals im Einzelhandel formuliert und definiert. Die Vermarkter standen vor der Frage, welche geschäftlichen Vorteile sich aus der Analyse einer großen Datenbank von Transaktionsdaten, die von Kassensystemen erfasst werden, ableiten lassen. Zuvor wurden nur die Gesamtabsatzmengen analysiert. Die Analyse der Kundenbelege eröffnete neue Horizonte, denn sie ermöglichte die Analyse der von den Kunden gekauften spezifischen Produktgruppen.

Der erste Algorithmus wurde 1993 von einer Gruppe von Entwicklern bei IBM entwickelt. In dieser Zeit wurden die wichtigsten Grundsätze formuliert, die dann die Grundlage für eine ganze Gruppe von Algorithmen bildeten.

Zunächst einmal müssen die von den Algorithmen erkannten Regeln häufig vorkommen. Das bedeutet, dass sie nicht zufällig sein dürfen und sich in der analysierten Datenbank mindestens eine bestimmte Anzahl von Malen wiederholen müssen. Das bedeutet, dass sie bestätigt werden müssen. Unter statistischen Gesichtspunkten sollte die Stichprobe der Vorgänge, die eine solche Regel enthalten, repräsentativ sein. Um dieser Anforderung gerecht zu werden, verfügen alle Algorithmen zur Ermittlung von Assoziationsregeln über einen Mindestunterstützungsparameter MinSup, der in Bruchteilen von 1 das Verhältnis der Häufigkeit des Auftretens einer Regel zur Gesamtzahl der Transaktionen in der analysierten Stichprobe angibt.

Nach den Regeln der Kombinatorik, wenn wir eine Menge von 3 Elementen haben: A, B und C, ohne die Position der Elemente zu berücksichtigen, können wir 7 verschiedene Mengen erhalten, die zwischen 1 bis 3 dieser Elemente enthalten. Mit zunehmender Anzahl der Gegenstände steigt auch die Anzahl der möglichen Kombinationen. Angesichts des Umfangs der Datenbanken wird die direkte Neuberechnung der Häufigkeit jedes Satzes zu einer ziemlich ressourcenintensiven Aufgabe. Oft ist eine solche Neuberechnung unmöglich. Daher haben die Autoren die Anti-Monotonie-Eigenschaft verwendet.

Wenn das Element A in der Datenbank nur in einem einzigen Satz von allen möglichen vorkommt, ist die Häufigkeit seines Auftretens gleich der Häufigkeit von A selbst. Wenn die Anzahl der angetroffenen Sätze größer ist, kann ihre Häufigkeit nur geringer sein, da die Gesamtzahl ihrer Vorkommen in der analysierten Stichprobe gleich der Anzahl der Vorkommen von A ist. Wenn also die Häufigkeit des Auftretens eines Elements kleiner als MinSup ist, dann ist auch die Häufigkeit aller möglichen Varianten von Sets, die dieses Element enthalten, kleiner als MinSup. Es reicht also aus, die Häufigkeit des Auftretens der einzelnen Elemente zu berechnen, um einen großen Teil der Zufallsmengen zu eliminieren, die für uns keinen praktischen Wert haben.

Wie Sie sehen, unterscheiden sich die Algorithmen für die Suche nach Assoziationsregeln stark von den bisher betrachteten. Bisher haben wir versucht, das Beste aus allen verfügbaren Daten zu machen. Im Gegensatz dazu eliminieren die Algorithmen zur Ermittlung von Assoziationsregeln sofort zufällige Elemente (Rauschen).

Der zweite Parameter, der in allen Algorithmen für Assoziationsregeln verwendet wird, ist der Mindestkonfidenzgrad MinConf. Er wird auch in Bruchteilen von 1 angegeben. Um diesen Parameter zu erklären, muss man wissen, dass jede Regel aus zwei Teilen besteht: einem Antezedens und einem Konsekutivteil. Sowohl das Antezedens als auch das Konsekutivum können aus einem einzigen Element oder aus einer ganzen Reihe von Elementen bestehen. Im allgemeinen Fall klingt die Regel wie folgt: Wenn das Antezedens wahr ist, dann gibt es ziemlich oft auch ein Konsekutivum.

Es ist zu beachten, dass die Wahrscheinlichkeit des Auftretens der Konsequenz nach dem Auftreten des Antezedens nicht 100% beträgt. Die Mindestwahrscheinlichkeit für das Eintreten der Folge wird durch den Parameter MinConf festgelegt. Wenn dieser Parameter erfüllt ist, wird die Regel als gültig angesehen und in der Liste der Regeln gespeichert. Sie ist definiert als das Verhältnis zwischen der Ausführungshäufigkeit der Regel und der Häufigkeit der Antezedenzien.

2. Apriori-Algorithmus

Einer der bekanntesten Algorithmen zum Auffinden von Assoziationsregeln ist wahrscheinlich der Apriori-Algorithmus, der 1994 von Rakesh Agrawal und Ramakrishnan Srikant vorgeschlagen wurde. Der Algorithmus basiert auf einem iterativen Prozess der Suche nach den häufigsten Mustern in der Datenbank. Anschließend werden aus den ausgewählten Mustern Regeln extrahiert.

Zum besseren Verständnis sehen wir uns die Funktionsweise des Algorithmus an einem kleinen Beispiel von 10 Transaktionen mit 5 Artikeln an.

| Transaktions-ID | Inhalt |

|---|---|

| T1 | BCDE |

| T2 | BCD |

| T3 | B |

| T4 | BCD |

| T5 | D |

| T6 | ACD |

| T7 | BCDE |

| T8 | BCE |

| T9 | CDE |

| T10 | AD |

Führen wir in das Problem die Konstanten der Mindestunterstützung 0,3 und der Mindestkonfidenz 0,7 (30% bzw. 70%) ein.

Bitte beachten Sie, dass alle Assoziationsregel-Algorithmen mit binären Arrays arbeiten. Lassen Sie uns daher zunächst die oben genannten Daten als binäre Tabelle darstellen.

| Transaktions-ID | A | B | C | D | E |

|---|---|---|---|---|---|

| T1 | 0 | 1 | 1 | 1 | 1 |

| T2 | 0 | 1 | 1 | 1 | 0 |

| T3 | 0 | 1 | 0 | 0 | 0 |

| T4 | 0 | 1 | 1 | 1 | 0 |

| T5 | 0 | 0 | 0 | 1 | 0 |

| T6 | 1 | 0 | 1 | 1 | 0 |

| T7 | 0 | 1 | 1 | 1 | 1 |

| T8 | 0 | 1 | 1 | 1 | 0 |

| T9 | 0 | 0 | 1 | 1 | 1 |

| T10 | 1 | 0 | 0 | 1 | 0 |

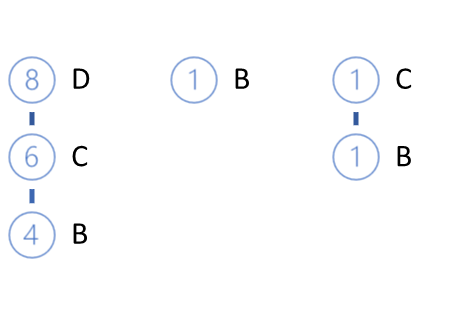

Anhand dieser Tabelle lässt sich leicht berechnen, dass das Element A nur zweimal vorkommt und seine Unterstützung 0,2 oder 20 % beträgt. In ähnlicher Weise können wir die Unterstützung für andere Güter berechnen: B — 0,6, C — 0,7, D — 0,8, E — 0,4. Wie wir sehen können, erfüllt nur A die Mindestunterstützungsanforderung nicht. Daher schließen wir sie gemäß der Anti-Monotonie-Eigenschaft von der weiteren Verarbeitung aus.

Aus den verbleibenden Elementen erstellen wir Kandidaten für häufig vorkommende Muster. Im vorangegangenen Schritt haben wir häufig vorkommende Elemente ermittelt. Nach dem Algorithmus werden die Kandidaten in Gruppen von zwei Elementen aufgeteilt: BC, BD, BE, CD, CE, DE.

Nun müssen wir die gesamte Datenbank verarbeiten und die Unterstützung für jeden der ausgewählten Kandidaten ermitteln.

| Transaktions-ID | BC | BD | BE | CD | CE | DE |

|---|---|---|---|---|---|---|

| T1 | 1 | 1 | 1 | 1 | 1 | 1 |

| T2 | 1 | 1 | 0 | 1 | 0 | 0 |

| T3 | 0 | 0 | 0 | 0 | 0 | 0 |

| T4 | 1 | 1 | 0 | 1 | 0 | 0 |

| T5 | 0 | 0 | 0 | 0 | 0 | 0 |

| T6 | 0 | 0 | 0 | 1 | 0 | 0 |

| T7 | 1 | 1 | 1 | 1 | 1 | 1 |

| T8 | 1 | 0 | 1 | 0 | 1 | 0 |

| T9 | 0 | 0 | 0 | 1 | 1 | 1 |

| T10 | 0 | 0 | 0 | 0 | 0 | 0 |

Dieses Mal erfüllt die Unterstützung aller unserer Kandidaten die Bedingung der Mindestunterstützung: BC — 0.5, BD — 0.4, BE — 0.3, CD — 0.6, CE — 0.4, DE — 0.3. Dies ist jedoch nicht immer der Fall. Bei der Lösung praktischer Probleme ist es wahrscheinlicher, dass einige Kandidaten ausgeschlossen werden.

Anschließend setzen wir den iterativen Prozess fort. Dieses Mal erstellen wir Kandidatengruppen mit drei Artikeln. Dazu nehmen wir die in der vorherigen Iteration ausgewählten häufigen Muster und kombinieren Paare, die sich nur in einem Element unterscheiden. Wir können 4 Kandidaten bestimmen: BCD, BCE, BDE, CDE.

Nach dem Apriori-Algorithmus müssen wir die gesamte Datenbank erneut durchgehen, um die Unterstützung für alle neuen Kandidaten zu ermitteln.

| Transaktions-ID | BCD | BCE | BDE | CDE |

|---|---|---|---|---|

| T1 | 1 | 1 | 1 | 1 |

| T2 | 1 | 0 | 0 | 0 |

| T3 | 0 | 0 | 0 | 0 |

| T4 | 1 | 0 | 0 | 0 |

| T5 | 0 | 0 | 0 | 0 |

| T6 | 0 | 0 | 0 | 0 |

| T7 | 1 | 1 | 1 | 1 |

| T8 | 0 | 1 | 0 | 0 |

| T9 | 0 | 0 | 0 | 1 |

| T10 | 0 | 0 | 0 | 0 |

Als Ergebnis erhalten wir die folgenden Unterstützungswerte für unsere Kandidaten: BCD — 0.4, BCE — 0.3, BDE — 0.2, CDE — 0.3. In dieser Iteration erfüllt die Unterstützung für das Itemset BDE nicht die Mindestanforderung an die Unterstützung und wir schließen es daher aus. Andere Kandidaten werden als häufige Muster betrachtet.

Bei der nächsten Iteration stellen wir Kandidatengruppen von 4 Elementen zusammen. Auf der Grundlage der in der vorherigen Iteration ausgewählten Muster können wir nur einen BCDE-Kandidaten erstellen. Doch bevor wir die Unterstützung für diesen Kandidaten berechnen, sollten wir uns mit seiner Komponente BDE befassen. Dieser Kandidat wurde nach der letzten Iteration gestrichen, da seine Unterstützung nur 0,2 betrug, während die Mindestanforderung für die Unterstützung 0,3 ist. Daher kann der BCDE-Kandidat nach der Anti-Monotonie-Regel keine Unterstützung von mehr als 0,2 haben. Dies liegt jedoch unter der Mindestförderung.

Da wir keine weiteren Kandidaten haben, beenden wir die Suche nach häufigen Mustern und gehen zum nächsten Teilprozess über - der Ermittlung von Regeln auf der Grundlage der ausgewählten häufigen Muster. Dazu unterteilen wir die ausgewählten Muster in einen Vorgänger und einen Nachfolger. Danach können wir das Konfidenzniveau für jede Regel bestimmen und es mit dem erforderlichen Mindestkonfidenzniveau vergleichen.

Wir werden die Regeln nacheinander für jedes Element der Menge erstellen. Da wir in der ersten Phase alle Muster mit A eliminiert haben (seine Unterstützung liegt unter MinSup), beginnen wir mit der Bestimmung der Regeln mit B.

Ermitteln wir aus den ausgewählten Mustern alle, die das analysierte Element enthalten. Wir extrahieren aus den Mustern das Element B, das als Konsekutivum verwendet werden soll, während der verbleibende Teil das Antezedens sein wird. Wir werden auch die Konfidenz für jede erstellte Regel bestimmen.

Der Konfidenzgrad der Regel gibt an, mit welcher Wahrscheinlichkeit ein Konsekutivum erscheint, wenn das Antezedens gebildet wird. Um sie zu ermitteln, müssen wir nicht die gesamte Datenbank erneut durchgehen. Wir müssen lediglich die Unterstützung für das vollständige Muster durch die Unterstützung des Vorgängers teilen, die zuvor in der Phase der Auswahl häufiger Muster berechnet wurde.

| Muster | Antecedent | Unterstützung | Regel |

|---|---|---|---|

| BC (0,5) | C (0.7) | 0.71. | C -> B |

| BD (0,4) | D (0.8) | 0.50 | D -> B |

| BE (0,3) | E (0.4) | 0.75. | E -> B |

| BCD (0,4) | CD (0,6) | 0.67 | CD -> B |

| BCE (0,3) | CE (0.4) | 0.75. | CE -> B |

Die Regeln D -> B und CD -> B erfüllen nicht die Mindestunterstützung von 0,7 und werden daher nicht berücksichtigt.

Bestimmen anderer Regeln auf ähnliche Weise.

| Muster | Antecedent | Unterstützung | Regel |

|---|---|---|---|

| BC (0,5) | B (0.6) | 0.83 | B -> C |

| CD (0,6) | D (0.8) | 0.75. | D -> C |

| CE (0.4) | E (0.4) | 1.00. | E -> C |

| BCD (0,4) | BD (0,4) | 1.00. | BD -> C |

| BCE (0,3) | BE (0,3) | 1.00. | BE -> C |

| CDE (0,3) | DE (0,3) | 1.00. | DE -> C |

| CD (0,6) | C (0.7) | 0.86. | C -> D |

| DE (0,3) | E (0.4) | 0.75. | E -> D |

| BCD (0,4) | BC (0,5) | 0.80. | BC -> D |

| CDE (0,3) | CE (0.4) | 0.75. | CE -> D |

Wir haben einen der bekanntesten Algorithmen für die Gewinnung von Assoziationsregeln gesehen: Apriori. Trotz ihrer Einfachheit und Beliebtheit wird sie in der Praxis jedoch nur selten verwendet. Der Grund dafür ist, dass der Engpass der betrachteten Methode die mehrfache Iteration durch die Datenbank ist, die erforderlich ist, um die Unterstützung der Kandidaten für häufige Muster zu bewerten. Je größer der Umfang der zu analysierenden Datenbanken wird, desto problematischer wird dies. Dieses Problem wird im nächsten Algorithmus effizient angegangen. Es erfordert nur zwei Iterationen für eine Datenbank beliebigen Umfangs und mit beliebiger Anzahl analysierter Elemente.

3. FP-Wachstumsalgorithmus

Betrachten wir die Lösung der oben beschriebenen Probleme am Beispiel eines der schnellsten Algorithmen zur Ermittlung von Assoziationsregeln: FP-Growth (Häufiges Muster - Wachstum). Aufgrund der Besonderheiten der Konstruktion des Algorithmus wird eine vollständige Iteration aller Elemente der Trainingsstichprobe nur 2 Mal im Verlauf seiner Ausführung durchgeführt. Der Algorithmus ruft die Trainingsstichprobe nur in diesen beiden Fällen auf.

Ähnlich wie der zuvor betrachtete Algorithmus zur Ermittlung von Assoziationsregeln kann FP-Growth bedingt in zwei Teilprobleme unterteilt werden:

- Auffinden häufig auftretender Muster. In diesem Beispiel wird diese Phase als Aufbau eines FP-Baums bezeichnet.

- Festlegung der Regeln.

Der Algorithmus beginnt mit der Eliminierung zufälliger Elemente. Dazu führen wir, wie beim vorherigen Algorithmus, den ersten Durchgang für die gesamte Trainingsmenge durch und berechnen die Unterstützung für jedes Element. Danach löschen wir alle Einträge, deren Häufigkeit kleiner als MinSup ist.

Die übrigen Elemente sind in absteigender Reihenfolge ihrer Träger angeordnet. Aus dem obigen Beispiel ergibt sich die folgende Reihe:

D (0.8) -> C (0.7) -> B (0.6) -> E(0.4)

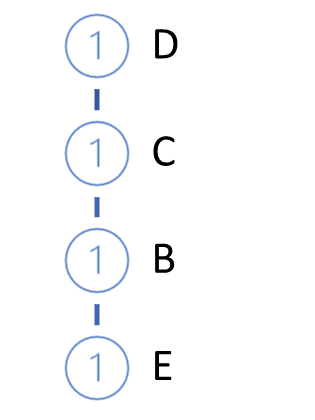

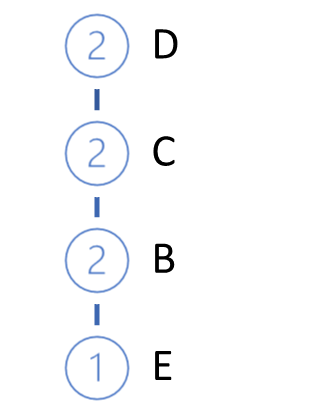

Als Nächstes werden wir den FP-Baum wachsen lassen. Dazu führen wir den zweiten Durchlauf über die Trainingsstichprobe durch. In jeder Transaktion nehmen wir nur häufige Elemente, die in absteigender Reihenfolge der Unterstützungen angeordnet sind, und erstellen einen Pfad im Baum. Der Knoten mit der höchsten Unterstützung befindet sich also in der Wurzel des Baumes, während der Knoten mit der niedrigsten Unterstützung ein Blatt ist. Wir erstellen auch einen Zähler für jeden Knoten. Bei der ersten Iteration setzen wir den Zählerwert auf 1 (oder 1/N, wobei N die Größe der Trainingsstichprobe ist).

Dann holen wir die nächste Transaktion aus der Datenbank, erstellen für sie auf die gleiche Weise einen Pfad und fügen ihn unserem Baum hinzu. Dafür überprüfen wir, ausgehend von der Wurzel des Baums, den Pfad mit bereits vorhandenen Zweigen. Wenn wir den Pfad von der Wurzel aus wiederholen, erhöhen wir einfach den Zähler der vorhandenen Knoten. Erstellen wir für das neue Teil einen Zweig.

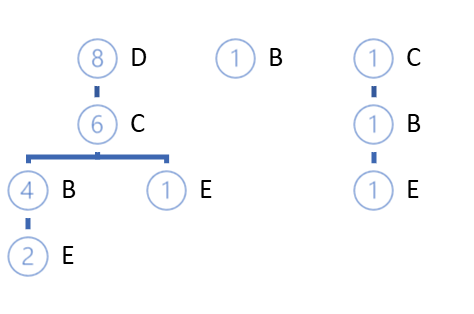

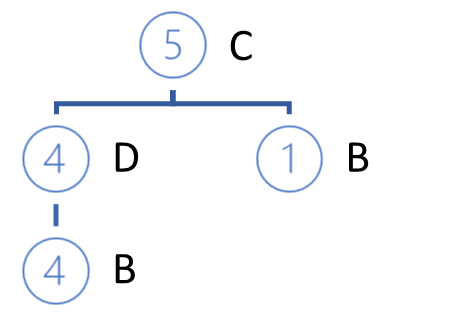

Der Zyklus der Iterationen wird so lange wiederholt, bis die gesamte Trainingsdaten vollständig durchlaufen wurde. Für das obige Beispiel erhalten wir den folgenden FP-Baum.

Mit hoher Wahrscheinlichkeit können wir die Pfade finden, die von der Wurzel selbst abweichen. Es sind zwei Optionen möglich:

- Einen Wald bauen

- Erstellen eines bestimmten Wurzelknotens, der die gesamte Auswahl zusammenfasst.

Zu Beginn des FP-Baumwachstums werden natürlich größtenteils neue Knoten erstellt. Wenn wir uns jedoch entlang der Trainingsstichprobe bewegen, werden wir zu einer Erhöhung der Zähler bestehender Knoten kommen, ohne neue Zweige zu erstellen. Die Besonderheit dieses Algorithmus besteht darin, dass wir beim Aufbau eines Baums die Trainingsstichprobe auf eine solche Größe komprimieren können, dass wir problemlos im Arbeitsspeicher des Computers arbeiten können, ohne auf die Datenbank zuzugreifen.

Weitere Arbeiten im Zusammenhang mit der Definition von Regeln werden nur mit dem FP-Baum durchgeführt, ohne die ursprüngliche Datenbank zu verwenden.

Die Regeln werden für alle Elemente in aufsteigender Reihenfolge ihrer Unterstützung erstellt.

In der ersten Stufe haben wir bereits alle Elemente mit einer geringeren Häufigkeit als der angegebenen eliminiert, und nun enthält unser Baum nur häufig vorkommende Elemente. Außerdem haben wir bei der Erstellung des Baums die Elemente in absteigender Reihenfolge sortiert. Das bedeutet, dass die Elemente mit der geringsten Unterstützung die Blätter sind.

Um also die Regeln zu bestimmen, die mit den Elementen mit der geringsten Unterstützung beginnen, bewegen wir uns von den Blättern zur Wurzel. Hier können wir die noch nicht explizite Kausalbeziehung nachvollziehen. Der Algorithmus geht davon aus, dass Elemente mit geringerer Unterstützung als Ergebnis einer Kombination von Merkmalen mit höherer Unterstützung erscheinen.

Doch zurück zu unserem Algorithmus zur Definition von Regeln. Wir nehmen die Elemente mit der niedrigsten Unterstützung und ermitteln alle Pfade im FP-Baum, die zu diesem Element führen. Bei der Auswahl der Pfade achten wir zunächst auf die Häufigkeit des Auftretens des gewünschten Elements bei der Bildung des Musters aus den Pfadelementen. Das Kriterium für die Auswahl des Pfades ist das Verhältnis zwischen der Unterstützung des Elements und der Unterstützung des vorherigen Knotens. Das Verhältnis darf nicht kleiner sein als das Mindestkonfidenz der Regel.

Im obigen Beispiel ist die niedrigste Unterstützung durch E gekennzeichnet. Drei Wege in den FP-Bäumen führen dorthin: DCBE (0.2), DCE (0.1), CBE(0.1). Keiner der Pfade erfüllt die Mindestanforderungen an die Unterstützung. Zwei von ihnen erfüllen nicht die Mindestanforderungen an die Konfidenz. Daher können wir keine Regel für E erstellen. Dies wird durch die mit dem Apriori-Algorithmus erzielten Ergebnisse bestätigt.

Wir löschen die Blätter E aus dem Baum und erhalten die folgende FP-Baumansicht.

Das nächste zu untersuchende Element ist B. Es hat die geringste Unterstützung unter den Verbliebenen. Es gibt drei Wege: DCB (0.4), B (0.1), CB (0.1).

In den ausgewählten Unterstützungspfaden wird jedem Element, das dem analysierten Element vorausgeht, die Unterstützung des analysierten Elements im gegebenen Pfad zugewiesen.

Auf der Grundlage der ausgewählten Pfade erstellen wir eine Liste der teilnehmenden Elemente und bestimmen die Unterstützung für jedes dieser Elemente. Beachten Sie, dass die Unterstützung als das Verhältnis zwischen der Anzahl der Elementvorkommen in den ausgewählten Pfaden und der Gesamtzahl der Datensätze im ursprünglichen Trainingsdatensatz bestimmt wird. So kann die neue Unterstützung jedes Elements nicht die ursprüngliche Unterstützung des Elements oder die Unterstützung des analysierten Elements (für das die Regeln bestimmt werden) übersteigen.

Auch hier entfernen wir Artikel mit weniger als minimaler Unterstützung. Wir ordnen die verbleibenden Elemente in absteigender Reihenfolge der Unterstützung.

In diesem Beispiel haben wir C (0,5), D (0,4).

Vergessen wir nicht, dass die Ergebnisse erheblich von den ursprünglichen Ergebnissen abweichen können, da wir die Unterstützung für die Artikel nur anhand der ausgewählten Pfade berechnet haben. Als Ergebnis dieses Faktors können einige Elemente eliminiert werden und ihre Reihenfolge in der neuen Hierarchie wird sich ändern.

In Übereinstimmung mit der neuen Hierarchie bauen wir einen neuen privaten Baum mit den ausgewählten Pfaden. Der Algorithmus für die Baumkonstruktion unterscheidet sich nicht von dem der FP-Baumkonstruktion.

Die Zweige des konstruierten privaten Baums werden die Vorläufer der Regeln sein, deren Folge unser analysierter Gegenstand sein wird.

Nach der Konstruktion des privaten Baums entfernen wir die Knoten des analysierten Elements aus dem ursprünglichen FP-Baum. Der Trick ist, dass wir den Artikel mit minimaler Unterstützung analysiert haben. Dies bedeutet, dass alle Knoten, die diese Elemente enthalten, die Blätter des FP-Baums sind. Daher wird sich ihre Entfernung nicht auf die Pfade anderer Elemente auswirken (wir haben etwas weiter oben von einer kausalen Beziehung gesprochen).

Durch das schrittweise Entfernen der analysierten Merkmale wird der FP-Baum schrittweise reduziert. Dadurch reduzieren wir die Datenmenge für die weitere Suche bei der Analyse von anderen Artikeln. Dies wirkt sich auf die Gesamtleistung des Algorithmus aus.

Auf ähnliche Weise erstellen wir Regeln für jedes Element in der ursprünglichen Hierarchie der FP-Bäume.

Bedenken wir, dass wir nur Regeln für Elemente erstellen können, für die es mindestens einen Wurzelknoten im FP-Baum gibt. Wir können keine Regeln für das Wurzelelement erstellen, da wir nichts haben, was wir als Antezedens verwenden können. Natürlich, außer beim Besuch eines potenziellen Kunden im Supermarkt. Wenn der Kunde in den Supermarkt gekommen ist, wird er etwas kaufen. Höchstwahrscheinlich wird dies einer der meistverkauften Artikel sein. Dies würde jedoch den Rahmen des hier betrachteten Algorithmus sprengen.

Schlussfolgerung

In diesem Artikel haben wir eine andere Art von Problemen betrachtet, die durch unüberwachte Lernmethoden gelöst werden: die Suche nach Assoziationsregeln. Wir haben zwei Algorithmen zur Ermittlung von Assoziationsregeln erörtert: Apriori und FP-Wachstum. Aber es gibt noch viele andere Algorithmen. Leider kann ich nicht das ganze Thema in einem Artikel behandeln. Darüber hinaus enthält sie nur theoretische Aspekte. Im nächsten Artikel werden wir uns mit der praktischen Konstruktion eines Algorithmus für das Mining von Assoziationsregeln unter Verwendung von MQL5 befassen. Wir werden auch seine Effizienz bei der Anwendung auf eine praktische Handelsaufgabe bewerten.

Liste der Referenzen

- Neuronale Netze leicht gemacht (Teil 14): Datenclustering

- Neuronale Netze leicht gemacht (Teil 15): Datenclustering mit MQL5

- Neuronale Netze leicht gemacht (Teil 16): Praktische Anwendung des Clustering

- Neuronale Netze leicht gemacht (Teil 17): Dimensionsreduktion.

- Fast Algorithms for Mining Association Rules

- Mining Frequent Patterns without Candidate Generation

Übersetzt aus dem Russischen von MetaQuotes Ltd.

Originalartikel: https://www.mql5.com/ru/articles/11090

Warnung: Alle Rechte sind von MetaQuotes Ltd. vorbehalten. Kopieren oder Vervielfältigen untersagt.

Dieser Artikel wurde von einem Nutzer der Website verfasst und gibt dessen persönliche Meinung wieder. MetaQuotes Ltd übernimmt keine Verantwortung für die Richtigkeit der dargestellten Informationen oder für Folgen, die sich aus der Anwendung der beschriebenen Lösungen, Strategien oder Empfehlungen ergeben.

Datenwissenschaft und maschinelles Lernen — Neuronales Netzwerk (Teil 02): Entwurf von Feed Forward NN-Architekturen

Datenwissenschaft und maschinelles Lernen — Neuronales Netzwerk (Teil 02): Entwurf von Feed Forward NN-Architekturen

Einen handelnden Expert Advisor von Grund auf neu entwickeln (Teil 20): Neues Auftragssystem (III)

Einen handelnden Expert Advisor von Grund auf neu entwickeln (Teil 20): Neues Auftragssystem (III)

Lernen Sie, wie man ein Handelssystem mit dem VIDYA entwickelt

Lernen Sie, wie man ein Handelssystem mit dem VIDYA entwickelt

Lernen Sie, wie man ein Handelssystem mit Bulls Power entwirft

Lernen Sie, wie man ein Handelssystem mit Bulls Power entwirft

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.