Modelli di regressione della libreria Scikit-learn e la loro esportazione in ONNX

ONNX (Open Neural Network Exchange) è un formato per la descrizione e lo scambio di modelli di apprendimento automatico, che offre la possibilità di trasferire modelli tra diversi framework di apprendimento automatico. Nell'apprendimento profondo e nelle reti neurali, si utilizzano spesso tipi di dati come float32. Sono ampiamente utilizzati perché di solito forniscono un'accuratezza e un'efficienza accettabili per l'addestramento dei modelli di deep learning.

Alcuni modelli classici di apprendimento automatico sono difficili da rappresentare come operatori ONNX. Per questo motivo, sono stati introdotti ulteriori operatori ML (ai.onnx.ml) per implementarli in ONNX. Vale la pena notare che, secondo le specifiche ONNX, gli operatori chiave di questo set (LinearRegressor, SVMRegressor, TreeEnsembleRegressor) possono accettare vari tipi di dati in ingresso (tensore(float), tensore(double), tensore(int64), tensore(int32)), ma restituiscono sempre il tipo tensore(float) in uscita. Anche la parametrizzazione di questi operatori viene eseguita utilizzando numeri in virgola mobile, il che può limitare l'accuratezza dei calcoli, soprattutto se sono stati utilizzati numeri a doppia precisione per definire i parametri del modello originale.

Ciò può comportare una perdita di precisione quando si convertono i modelli o si utilizzano tipi di dati differenti nel processo di conversione ed elaborazione dei dati in ONNX. Molto dipende dal convertitore, come vedremo più avanti; alcuni modelli riescono a bypassare queste limitazioni e a garantire la piena portabilità dei modelli ONNX, consentendo di lavorare con essi in doppia precisione senza perdere in accuratezza. È importante considerare queste caratteristiche quando si lavora con i modelli e la loro rappresentazione in ONNX, soprattutto nei casi in cui la precisione della rappresentazione dei dati è importante.

Scikit-learn è una delle librerie per l'apprendimento automatico più popolare e utilizzata dalla comunità Python. Offre un'ampia gamma di algoritmi, un'interfaccia facile da usare e una buona documentazione. L'articolo precedente, "Modelli di Classificazione della Libreria Scikit-learn e Loro Esportazione in ONNX", copriva i modelli di classificazione.

In questo articolo esploreremo l'applicazione dei modelli di regressione nel pacchetto Scikit-learn, calcoleremo i loro parametri con doppia precisione per il set di dati di prova, proveremo a convertirli nel formato ONNX con precisione double e float e utilizzeremo i modelli ottenuti in programmi MQL5. Inoltre, confronteremo l'accuratezza dei modelli originali e delle loro versioni ONNX per la precisione float e double. Inoltre, esamineremo la rappresentazione ONNX dei modelli di regressione, che ci forniranno una migliore comprensione della loro struttura interna e il loro funzionamento.

Contenuto

- Se ti dà fastidio, ben venga il tuo contributo

- 1. Set dei dati di prova

Lo script per la visualizzazione del set di dati di prova - 2. Modelli di Regressione

2.0. Elenco dei Modelli di Regressione di Scikit-learn - 2.1. Modelli di Regressione Scikit-learn convertiti in modelli ONNX float e double

- 2.1.1. sklearn.linear_model.ARDRegression

2.1.1.1. Codice per la creazione di ARDRegression

2.1.1.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.1.3. Rappresentazione ONNX di ard_regression_float.onnx e ard_regression_double.onnx - 2.1.2. sklearn.linear_model.BayesianRidge

2.1.2.1. Codice per la creazione del modello BayesianRidge ed esportazione in ONNX per float e double

2.1.2.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.2.3. Rappresentazione ONNX di bayesian_ridge_float.onnx e bayesian_ridge_double.onnx - 2.1.3. sklearn.linear_model.ElasticNet

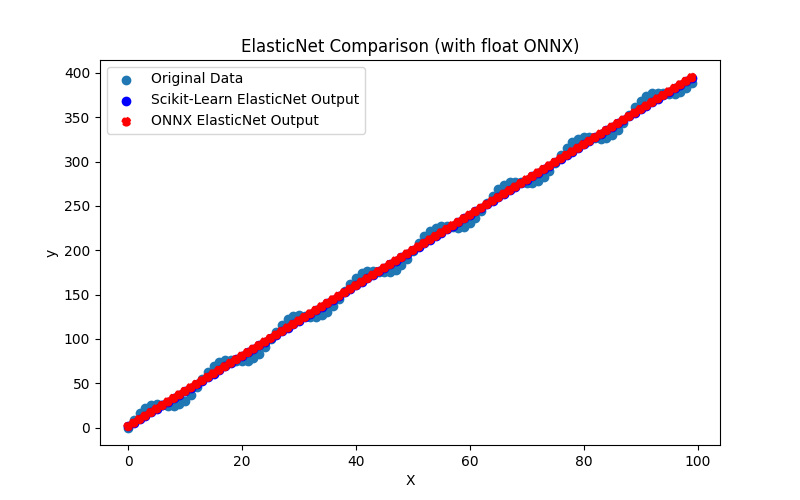

2.1.3.1. Codice per la creazione del modello ElasticNet e esportazione in ONNX per float e double

2.1.3.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

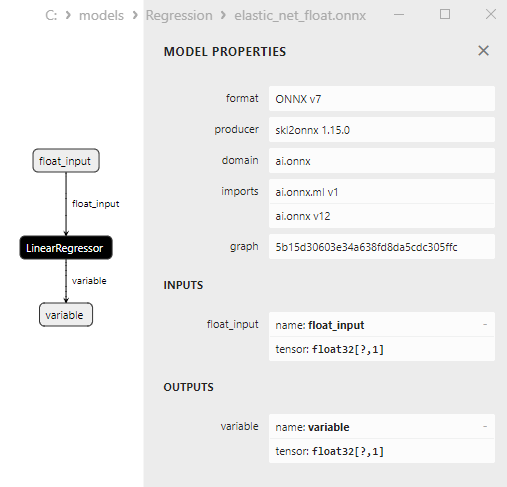

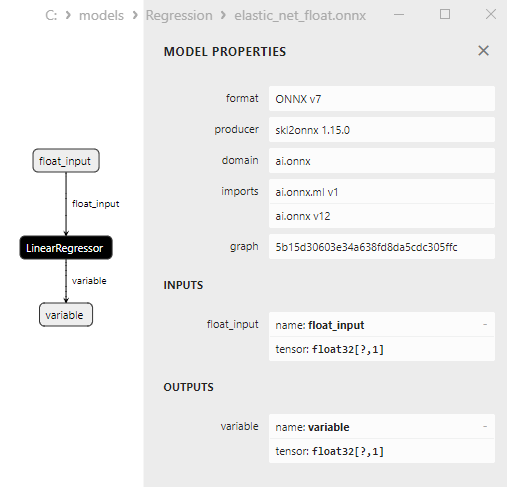

2.1.3.3. Rappresentazione ONNX di elastic_net_float.onnx e elastic_net_double.onnx - 2.1.4. sklearn.linear_model.ElasticNetCV

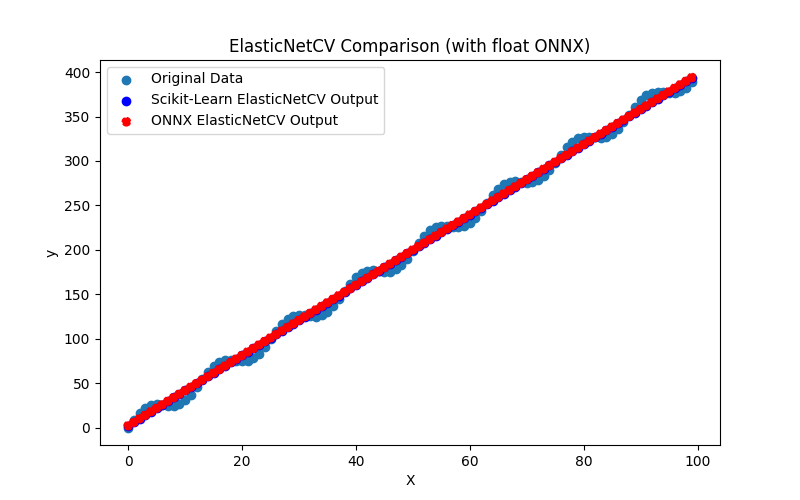

2.1.4.1. Codice per la creazione del modello ElasticNet e esportazione in ONNX per float e double

2.1.4.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

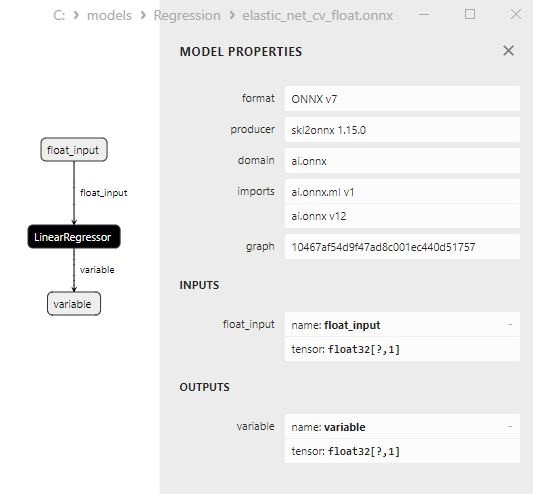

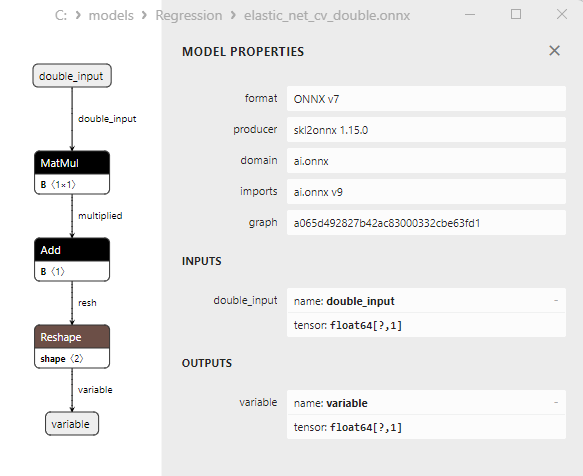

2.1.4.3. Rappresentazione ONNX di elastic_net_cv_float.onnx e elastic_net_cv_double.onnx - 2.1.5. sklearn.linear_model.HuberRegressor

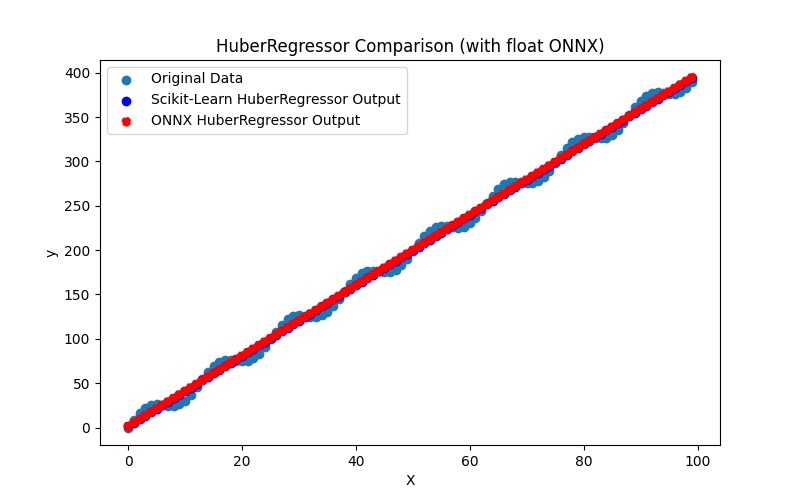

2.1.5.1. Codice per creare il modello HuberRegressor ed esportarlo in ONNX per float e double

2.1.5.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

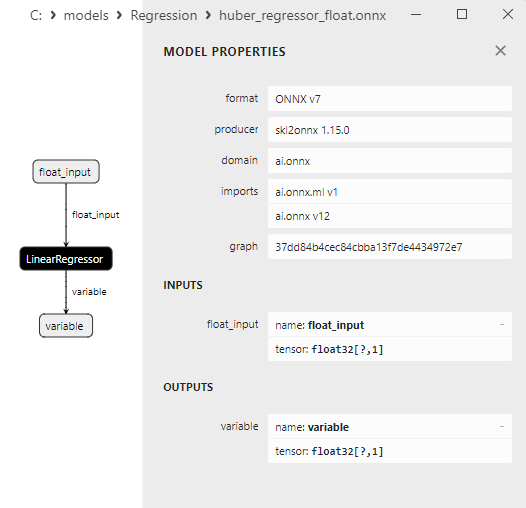

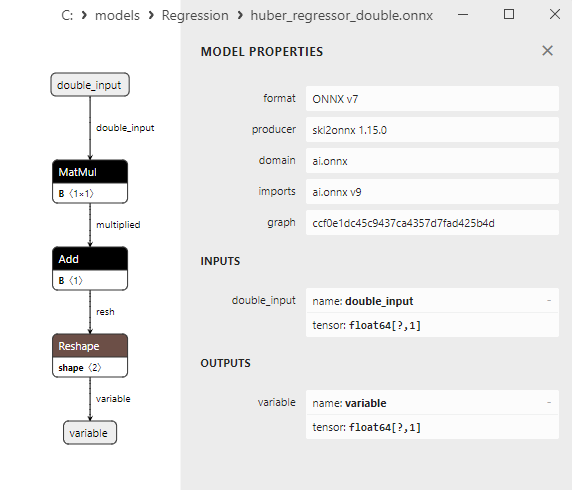

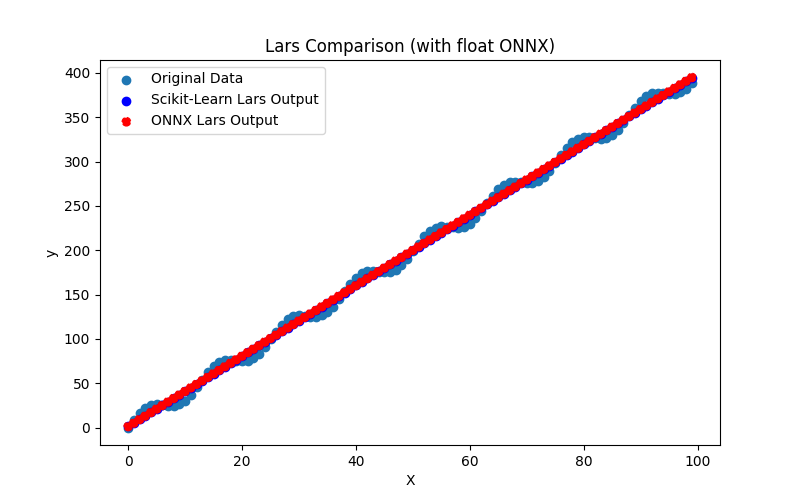

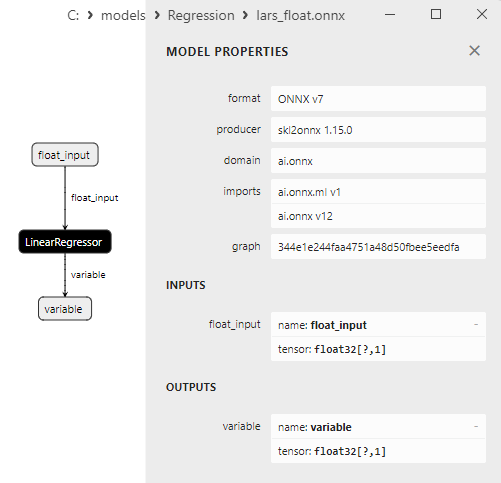

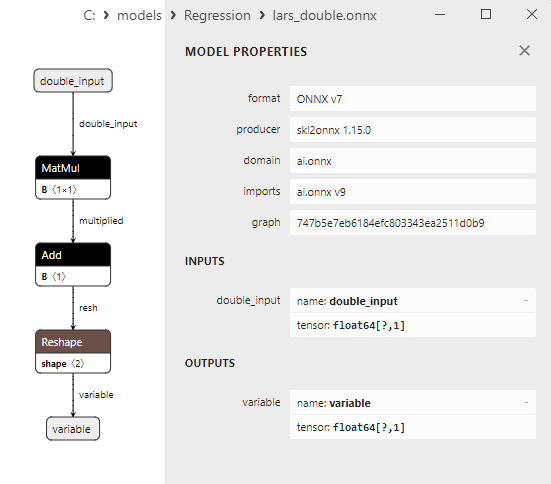

2.1.5.3. Rappresentazione ONNX di huber_regressor_float.onnx e huber_regressor_double.onnx - 2.1.6. sklearn.linear_model.Lars

2.1.6.1. Codice per creare il modello Lars ed esportarlo in ONNX per float e double

2.1.6.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.6.3. Rappresentazione ONNX di lars_float.onnx e lars_double.onnx - 2.1.7. sklearn.linear_model.LarsCV

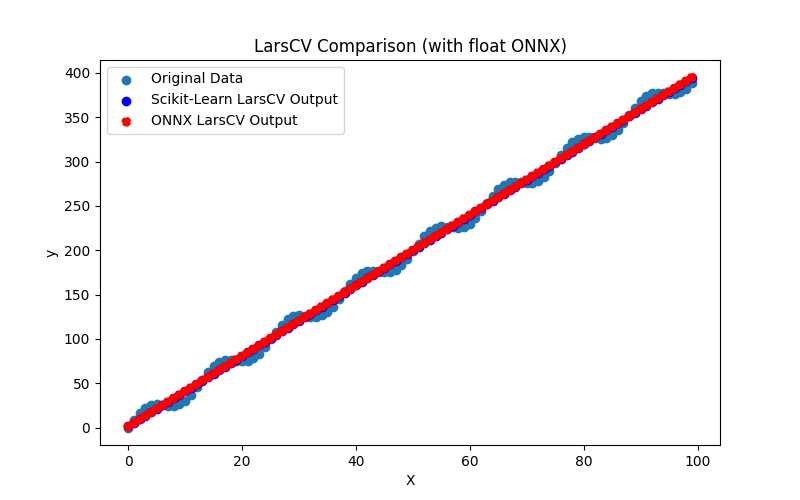

2.1.7.1. Codice per creare il modello LarsCV ed esportarlo in ONNX per float e double

2.1.7.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

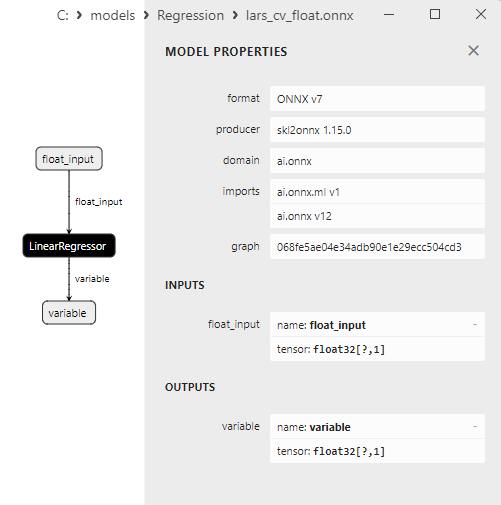

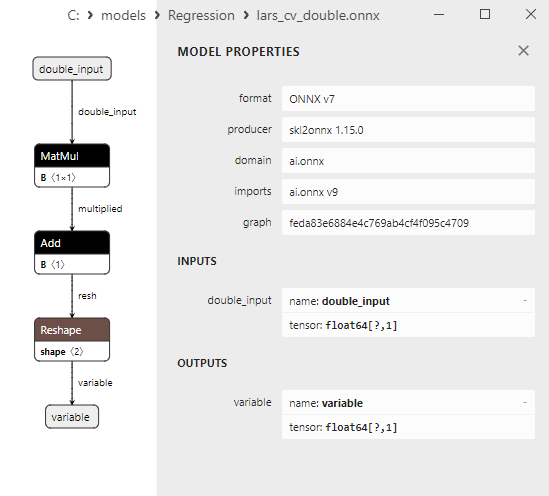

2.1.7.3. Rappresentazione ONNX di lars_cv_float.onnx e lars_cv_double.onnx - 2.1.8. sklearn.linear_model.Lasso

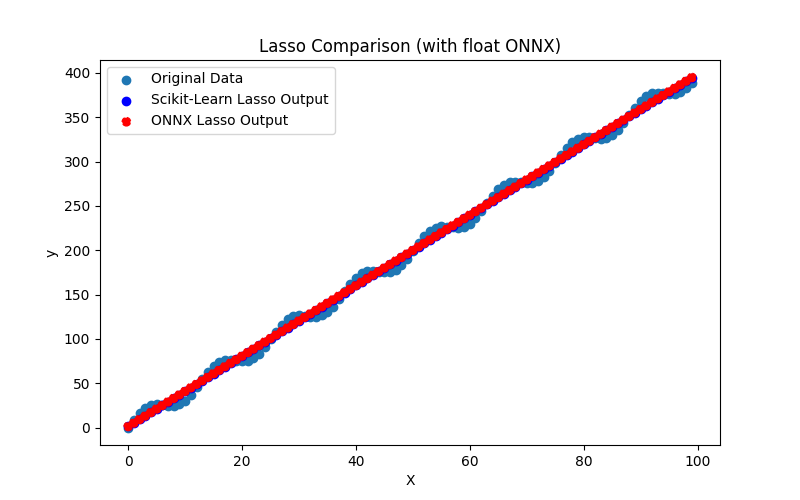

2.1.8.1. Codice per creare il modello Lasso ed esportarlo in ONNX per float e double

2.1.8.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

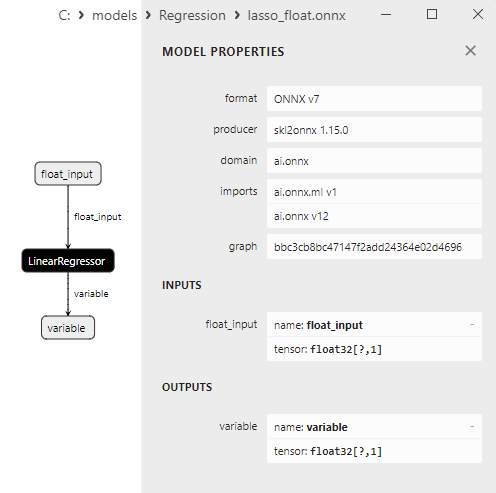

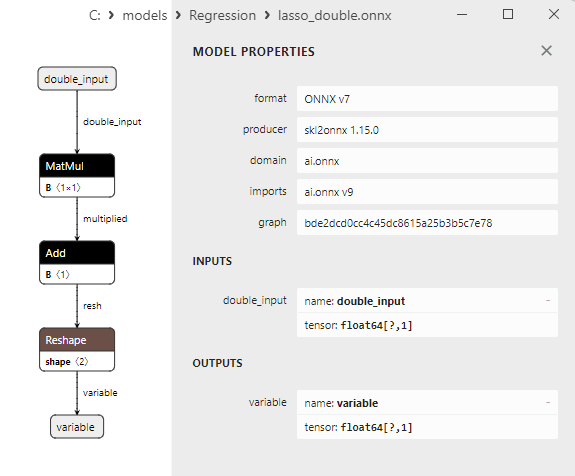

2.1.8.3. Rappresentazione ONNX di lasso_float.onnx e lasso_double.onnx - 2.1.9. sklearn.linear_model.LassoCV

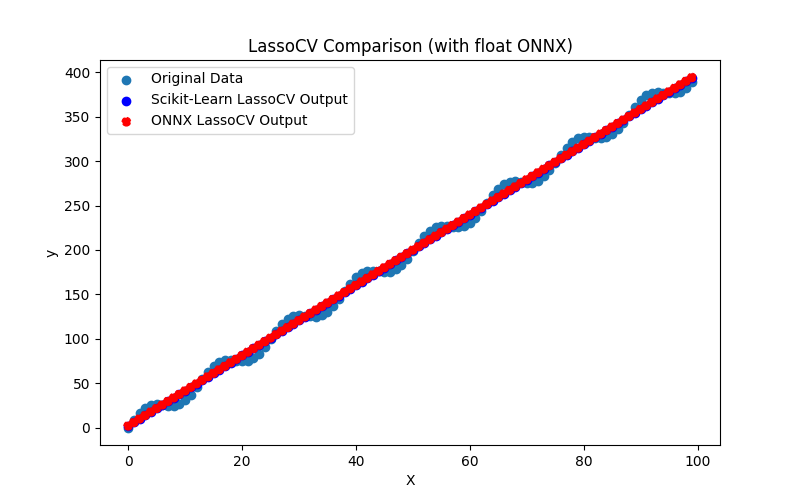

2.1.9.1. Codice per creare il modello LassoCV ed esportarlo in ONNX per float e double

2.1.9.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

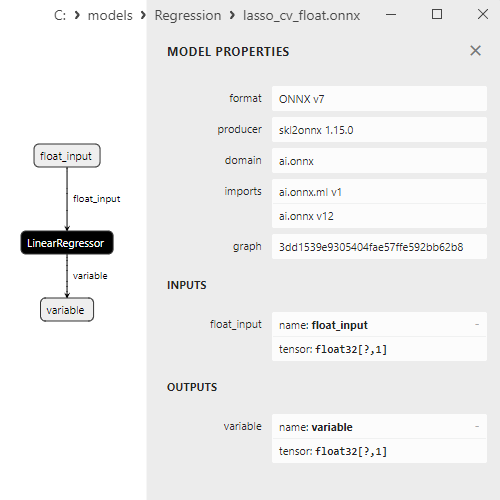

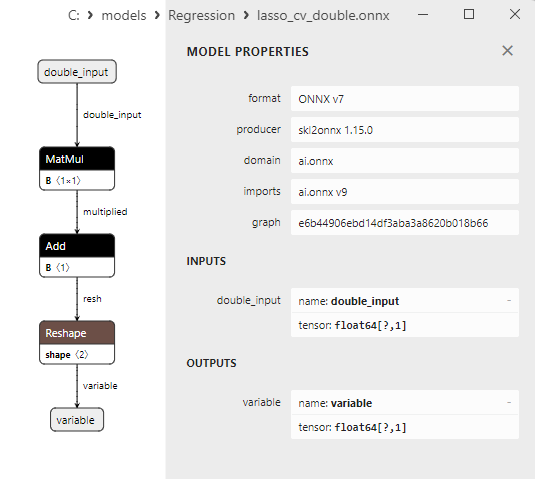

2.1.9.3. Rappresentazione ONNX di lasso_cv_float.onnx e lasso_cv_double.onnx - 2.1.10. sklearn.linear_model.LassoLars

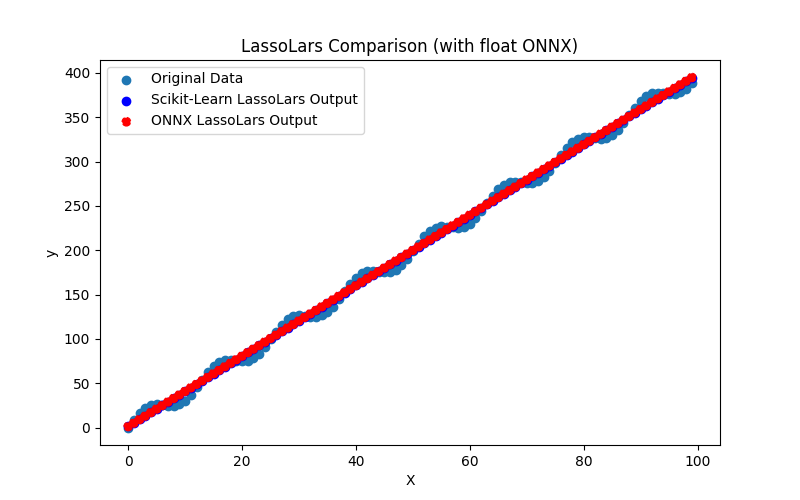

2.1.10.1. Codice per la creazione del modello LassoLars e esportazione in ONNX per float e double

2.1.10.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

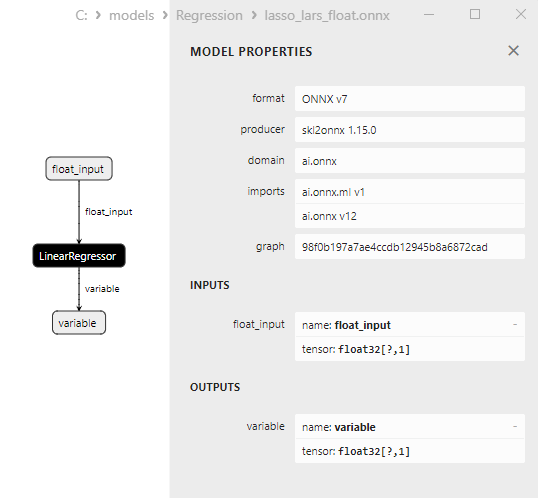

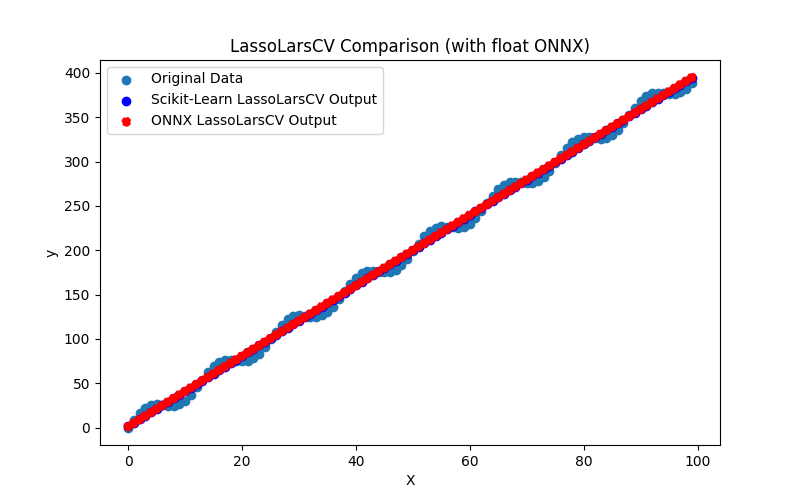

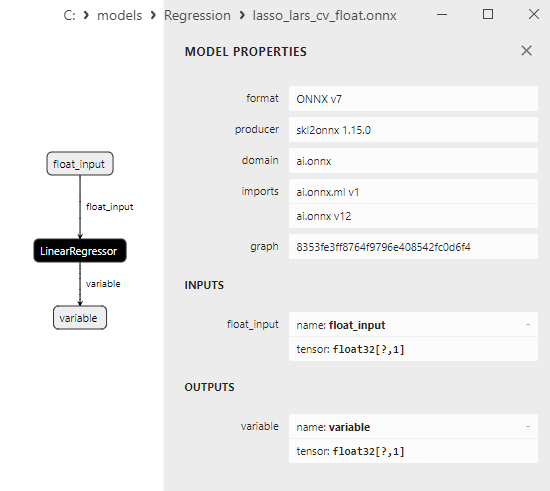

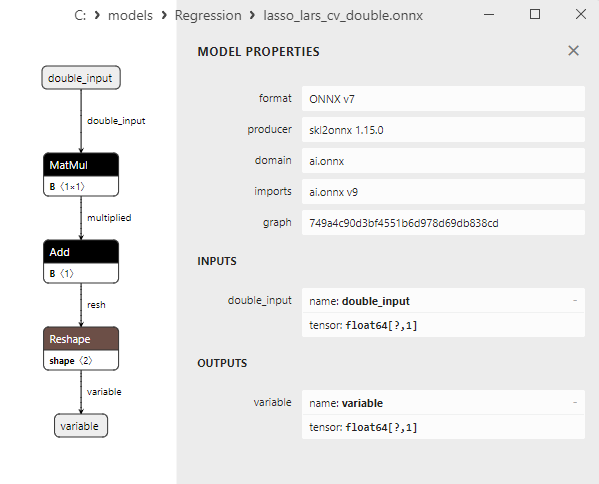

2.1.10.3. Rappresentazione ONNX di lasso_lars_float.onnx e lasso_lars_double.onnx - 2.1.11. sklearn.linear_model.LassoLarsCV

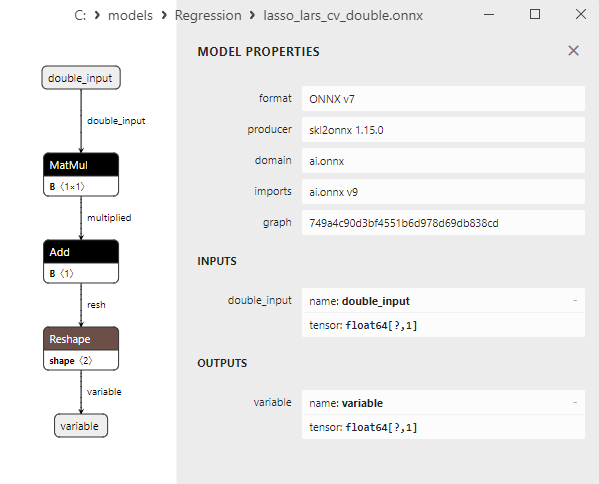

2.1.11.1. Codice per la creazione del modello LassoLarsCV e per esportazione in ONNX per float e double

2.1.11.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

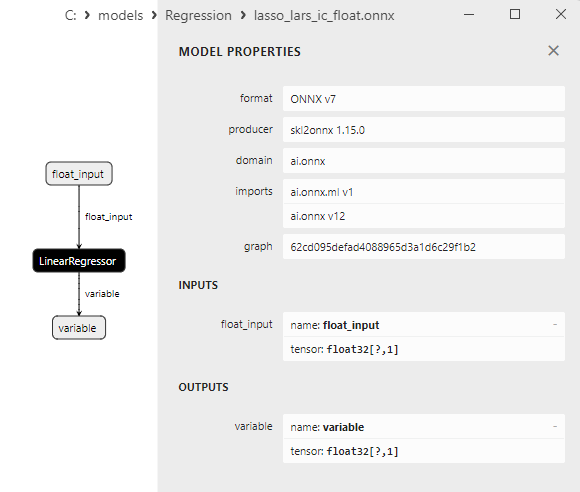

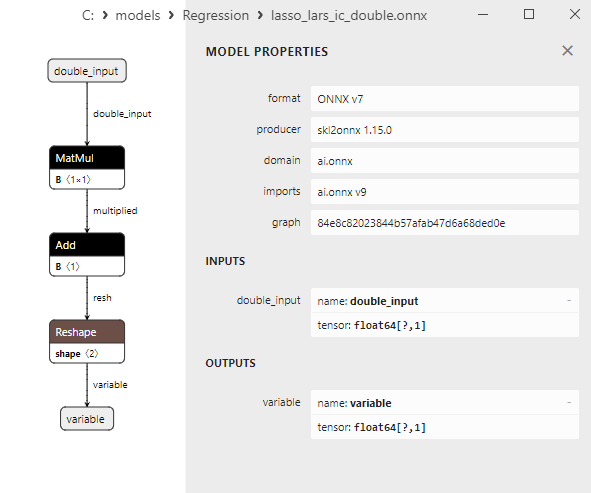

2.1.11.3. Rappresentazione ONNX di lasso_lars_cv_float.onnx e lasso_lars_cv_double.onnx - 2.1.12. sklearn.linear_model.LassoLarsIC

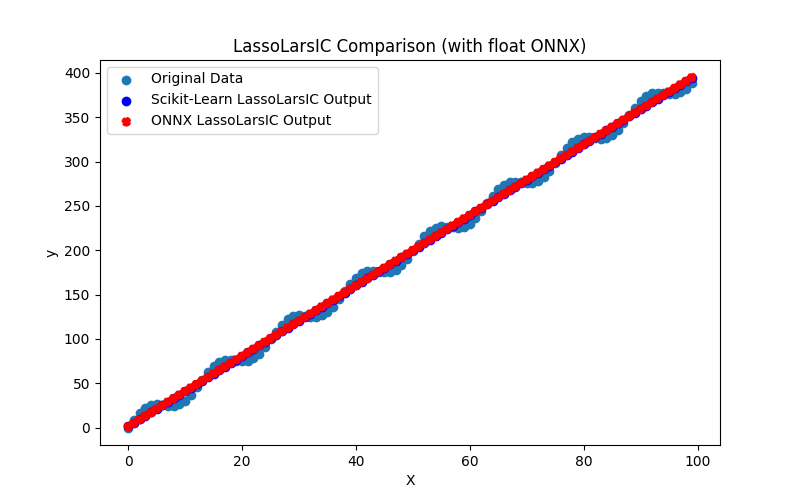

2.1.12.1. Codice per creare il modello LassoLarsIC ed esportarlo in ONNX per float e double

2.1.12.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.12.3. Rappresentazione ONNX di lasso_lars_ic_float.onnx e lasso_lars_ic_double.onnx - 2.1.13. sklearn.linear_model.LinearRegression

2.1.13.1. Codice per creare il modello LinearRegression ed esportarlo in ONNX per float e double

2.1.13.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

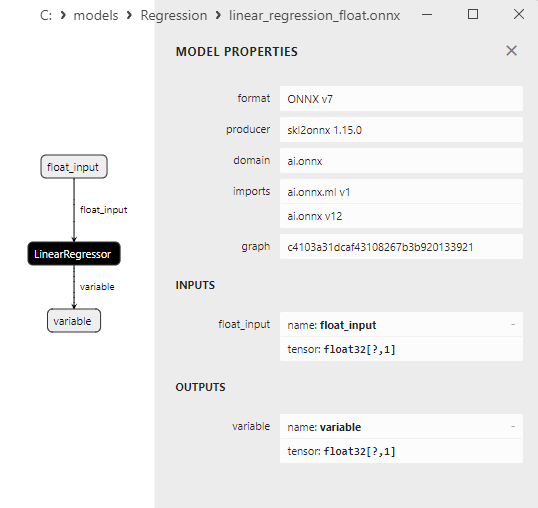

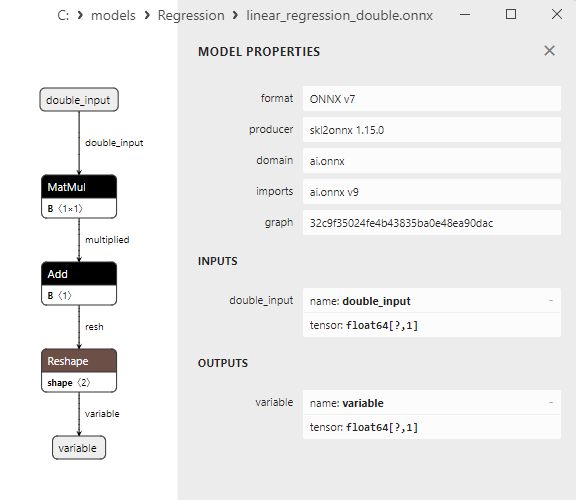

2.1.13.3. Rappresentazione ONNX di linear_regression_float.onnx e linear_regression_double.onnx - 2.1.14. sklearn.linear_model.Ridge

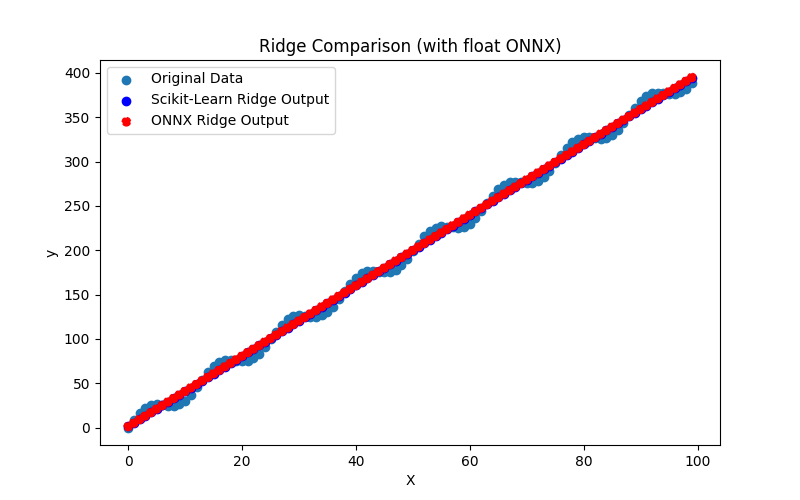

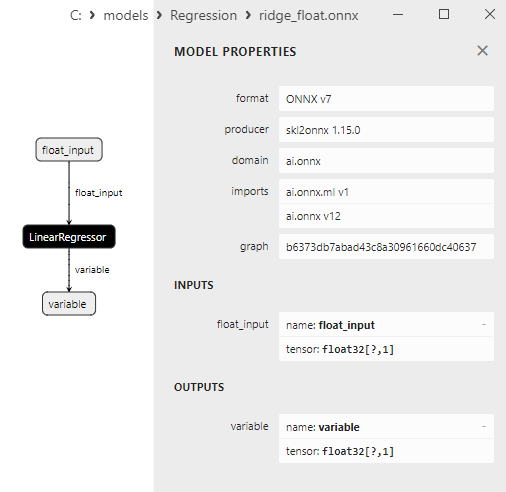

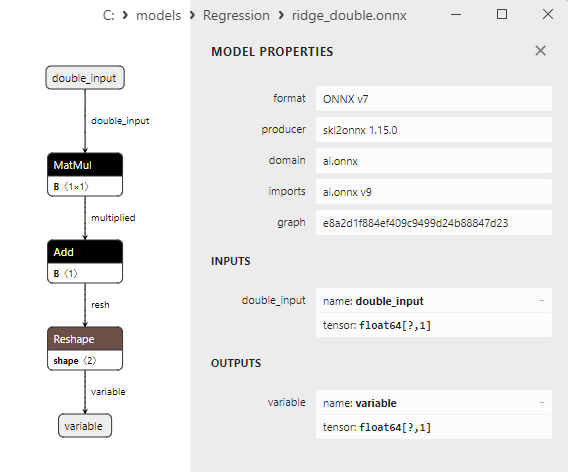

2.1.14.1. Codice per creare il modello Ridge ed esportarlo in ONNX per float e double

2.1.14.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

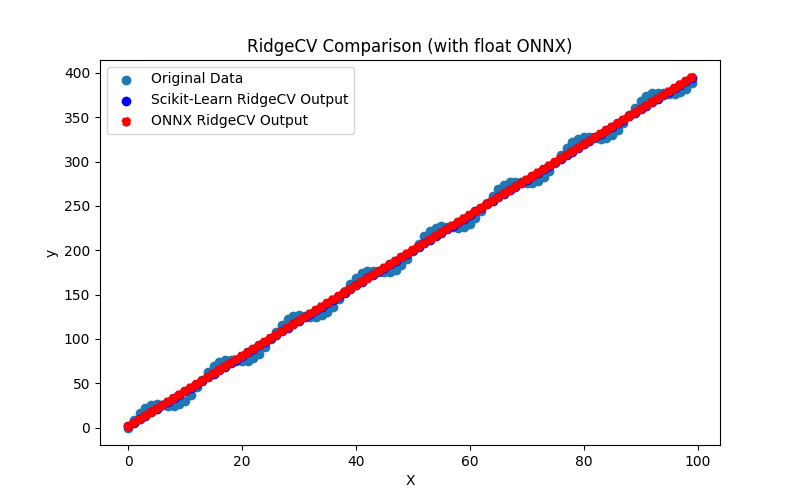

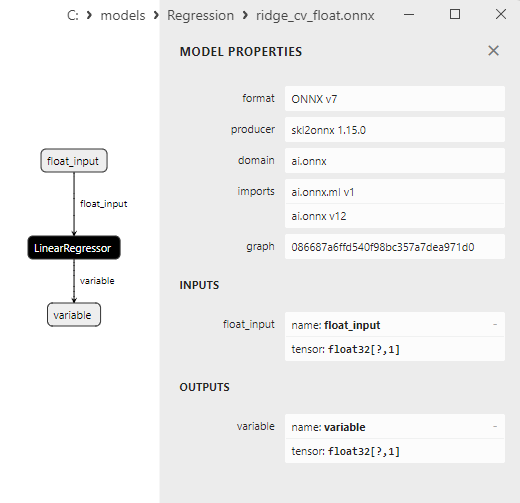

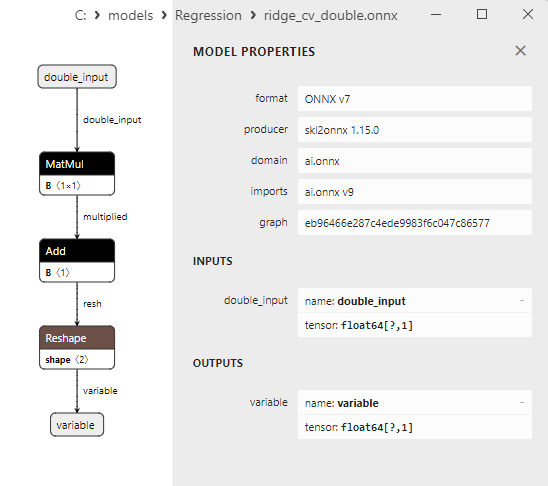

2.1.14.3. Rappresentazione ONNX di ridge_float.onnx e ridge_double.onnx - 2.1.15. sklearn.linear_model.RidgeCV

2.1.15.1. Codice per la creazione del modello RidgeCV e per l'esportazione in ONNX per float e double

2.1.15.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.15.3. Rappresentazione ONNX di ridge_cv_float.onnx e ridge_cv_double.onnx - 2.1.16. sklearn.linear_model.OrthogonalMatchingPursuit

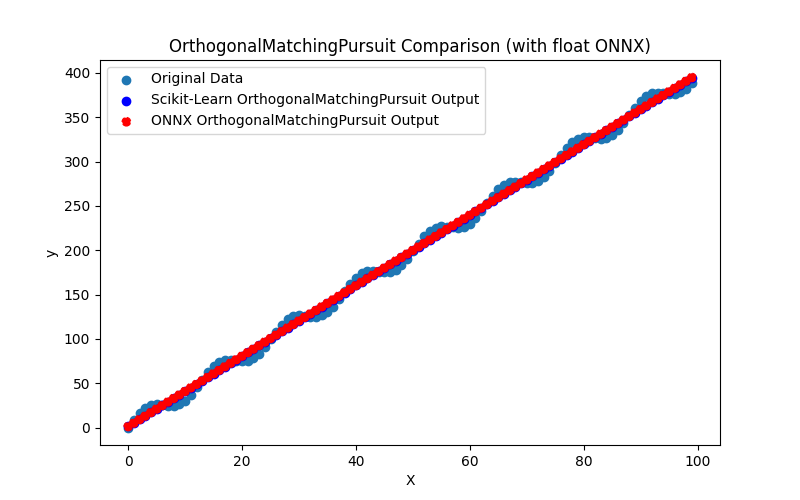

2.1.16.1. Codice per creare il modello OrthogonalMatchingPursuit ed esportarlo in ONNX per float e double

2.1.16.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

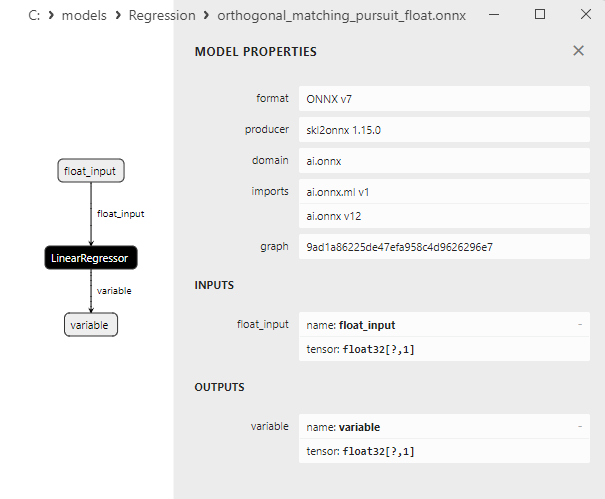

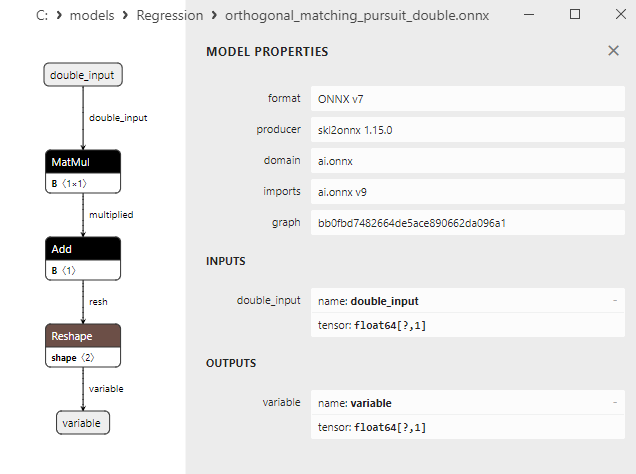

2.1.16.3. Rappresentazione ONNX di orthogonal_matching_pursuit_float.onnx e orthogonal_matching_pursuit_double.onnx - 2.1.17. sklearn.linear_model.PassiveAggressiveRegressor

2.1.17.1. Codice per la creazione del modello PassiveAggressiveRegressor e per la sua esportazione in ONNX per float e double

2.1.17.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

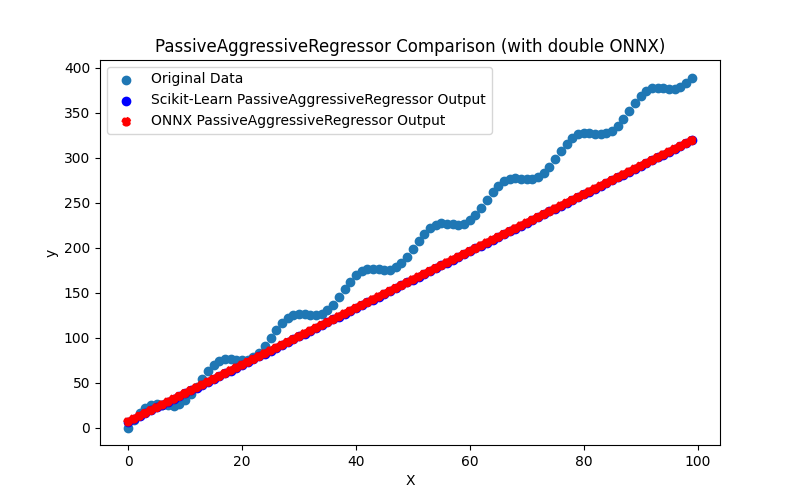

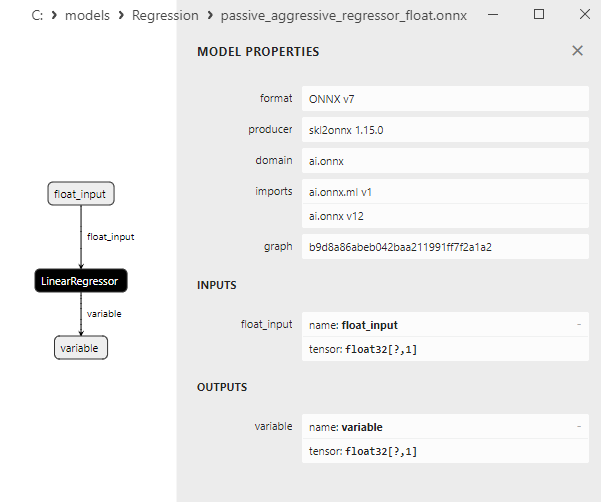

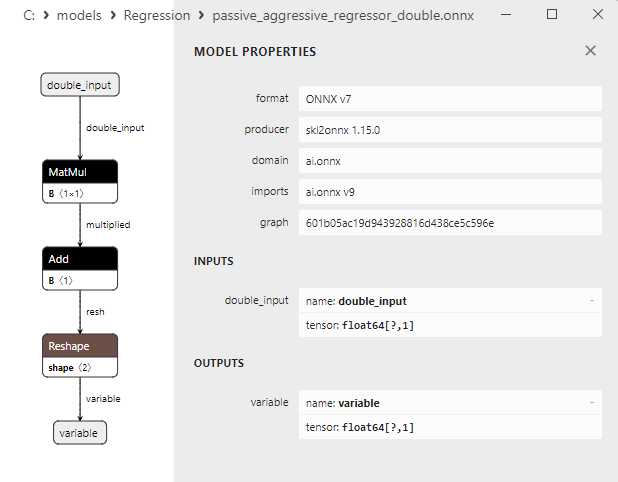

2.1.17.3. Rappresentazione ONNX di passive_aggressive_regressor_float.onnx e passive_aggressive_regressor_double.onnx - 2.1.18. sklearn.linear_model.QuantileRegressor

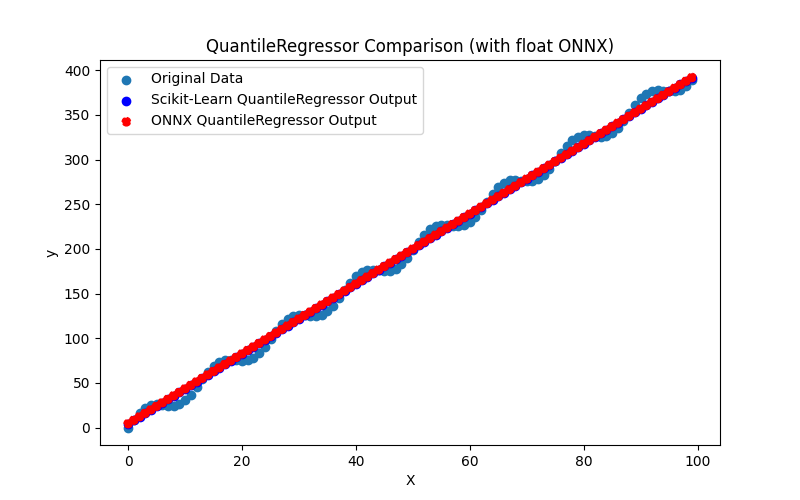

2.1.18.1. Codice per creare il modello QuantileRegressor ed esportarlo in ONNX per float e double

2.1.18.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

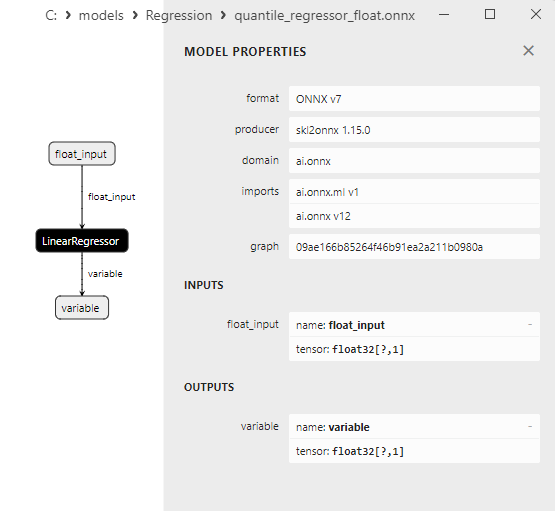

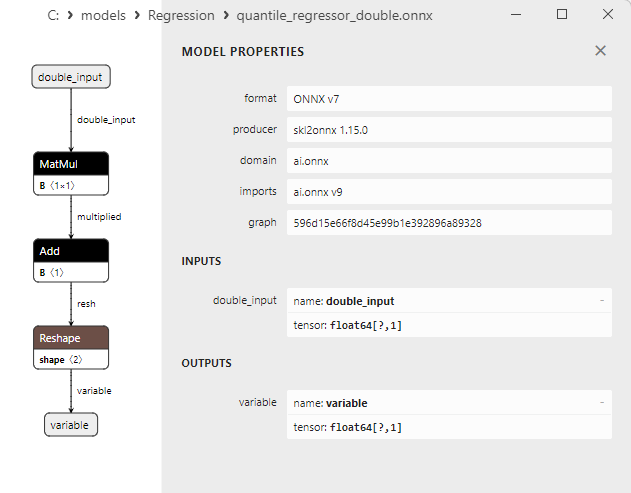

2.1.18.3. Rappresentazione ONNX del quantile_regressor_float.onnx e del quantile_regressor_double.onnx - 2.1.19. sklearn.linear_model.RANSACRegressor

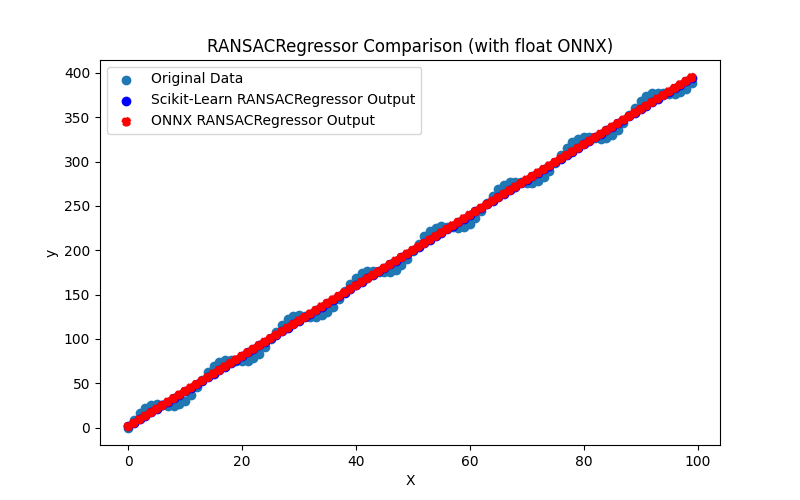

2.1.19.1. Codice per la creazione del modello RANSACRegressor ed esportazione in ONNX per float e double

2.1.19.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

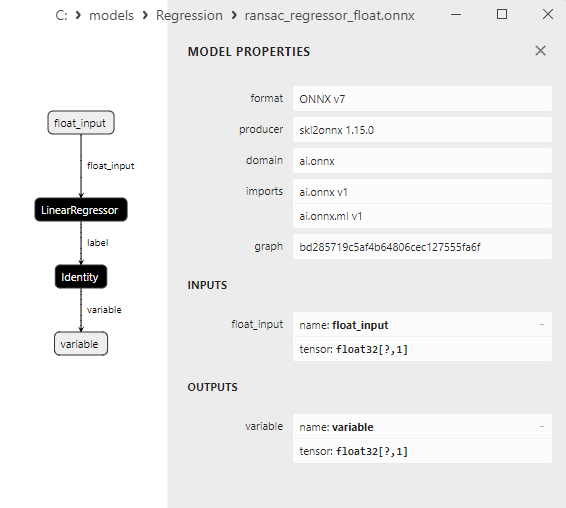

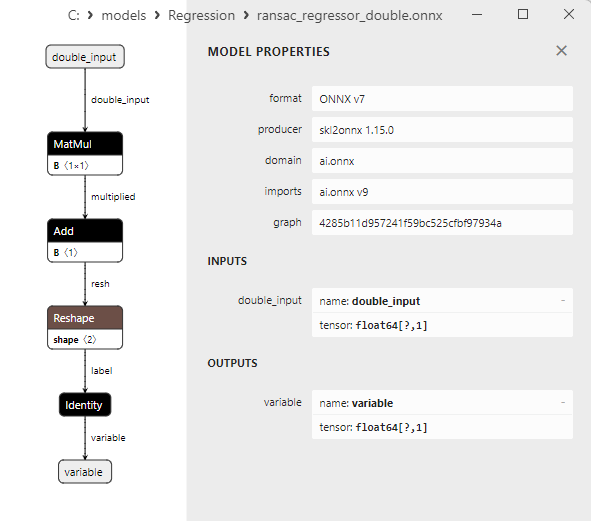

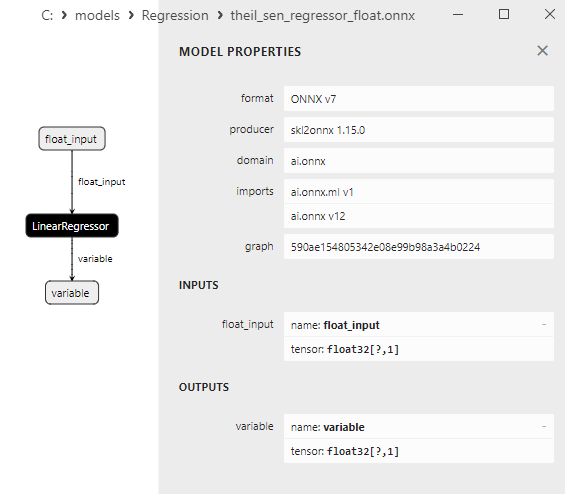

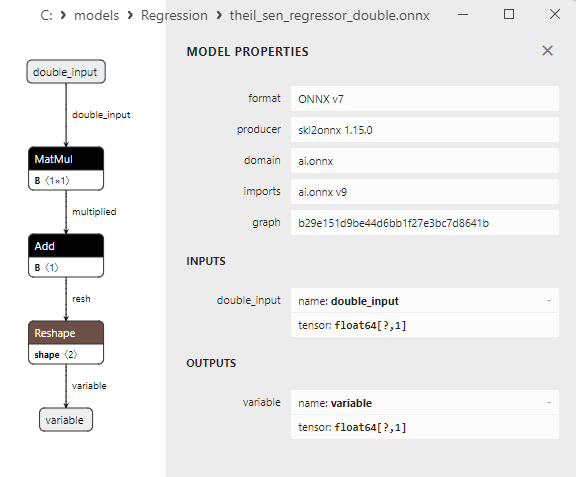

2.1.19.3. Rappresentazione ONNX di ransac_regressor_float.onnx e ransac_regressor_double.onnx - 2.1.20. sklearn.linear_model.TheilSenRegressor

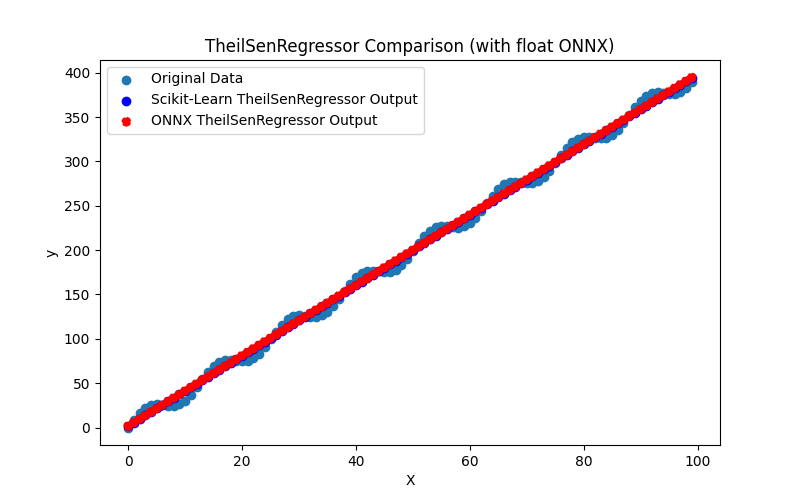

2.1.20.1. Codice per la creazione del modello TheilSenRegressor ed esportazione in ONNX per float e double

2.1.20.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.20.3. Rappresentazione ONNX di theil_sen_regressor_float.onnx e theil_sen_regressor_double.onnx - 2.1.21. sklearn.linear_model.LinearSVR

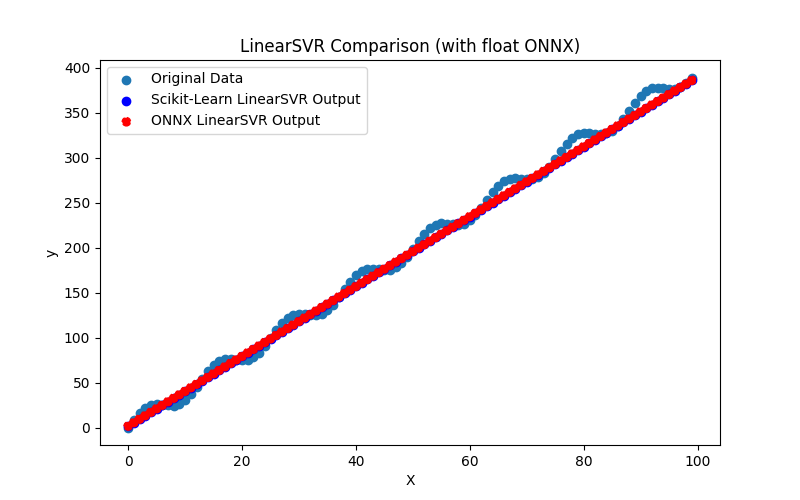

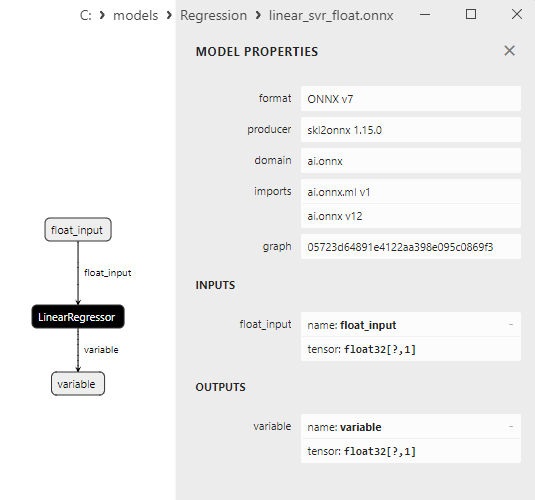

2.1.21.1. Codice per creare il modello LinearSVR ed esportarlo in ONNX per float e double

2.1.21.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

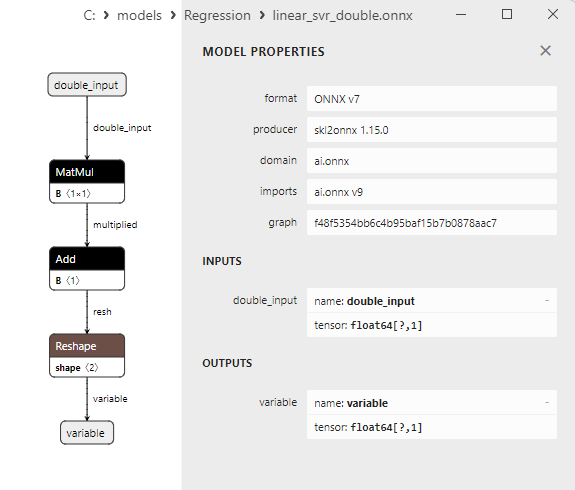

2.1.21.3. Rappresentazione ONNX di linear_svr_float.onnx e linear_svr_double.onnx - 2.1.22. sklearn.linear_model.MLPRegressor

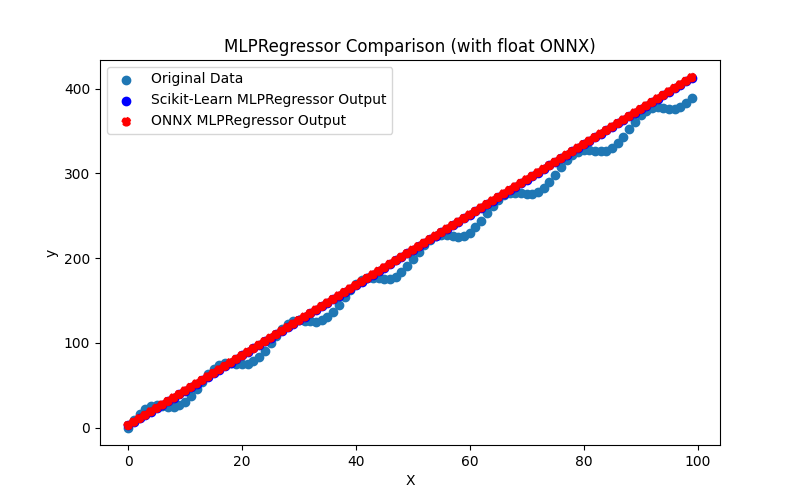

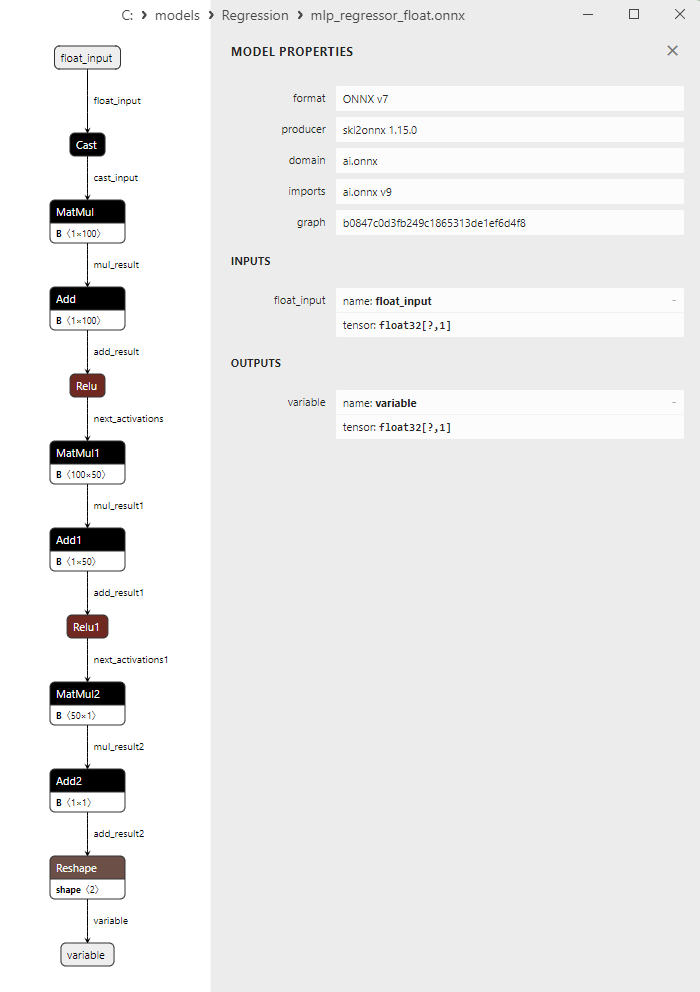

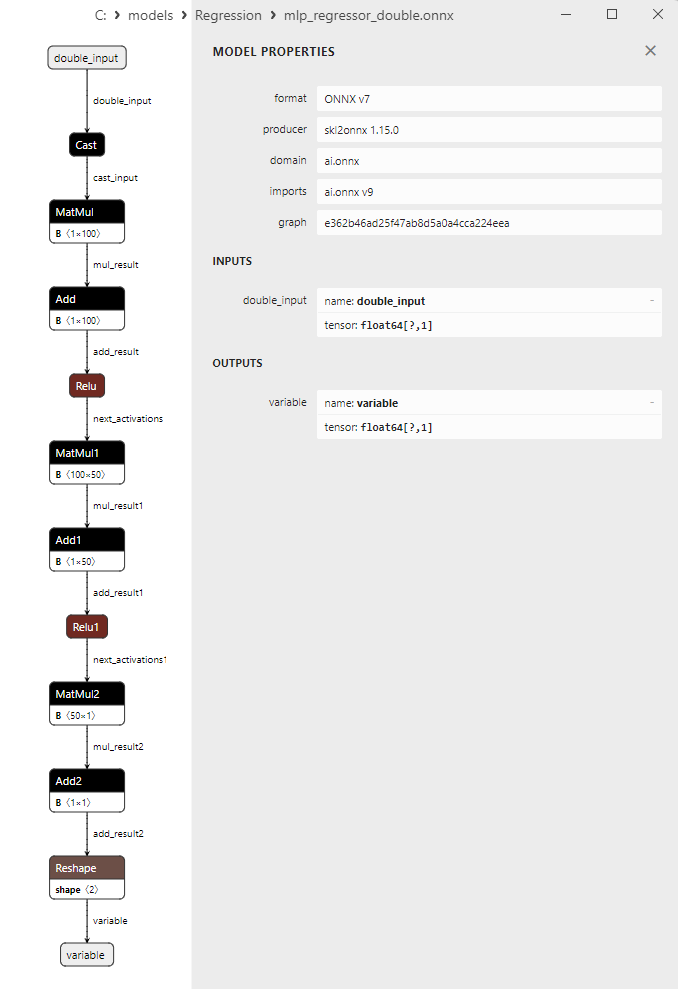

2.1.22.1. Codice per creare il modello MLPRegressor ed esportarlo in ONNX per float e double

2.1.22.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.22.3. Rappresentazione ONNX di mlp_regressor_float.onnx e mlp_regressor_double.onnx - 2.1.23. sklearn.cross_decomposition.PLSRegression

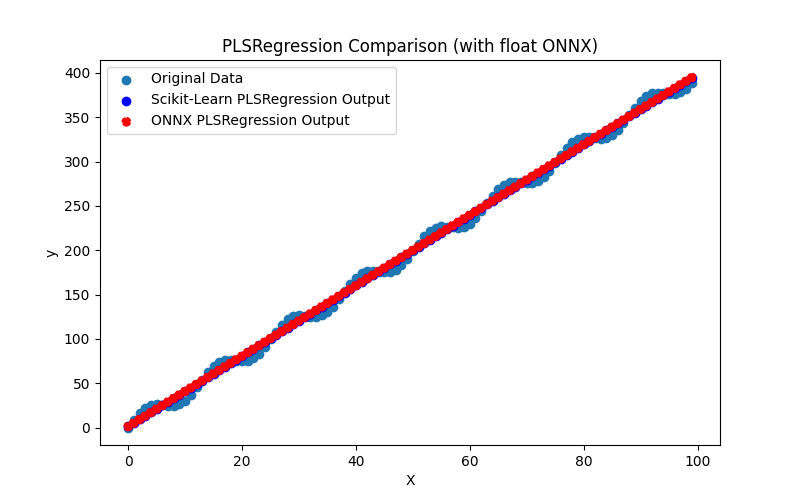

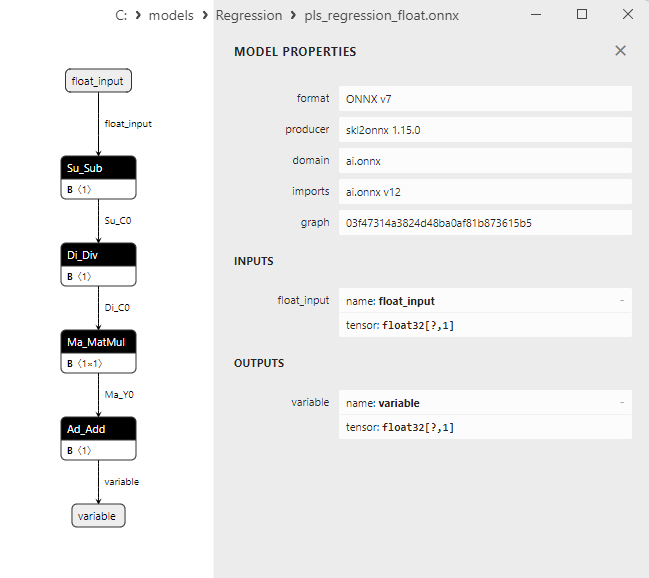

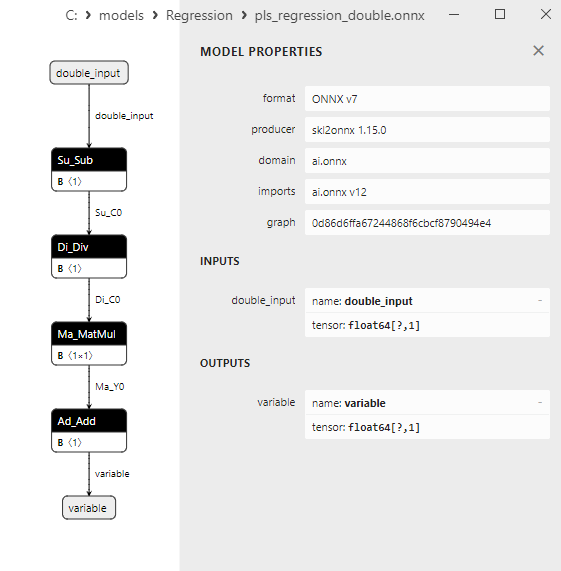

2.1.23.1. Codice per la creazione del modello PLSRegression ed esportazione in ONNX per float e double

2.1.23.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

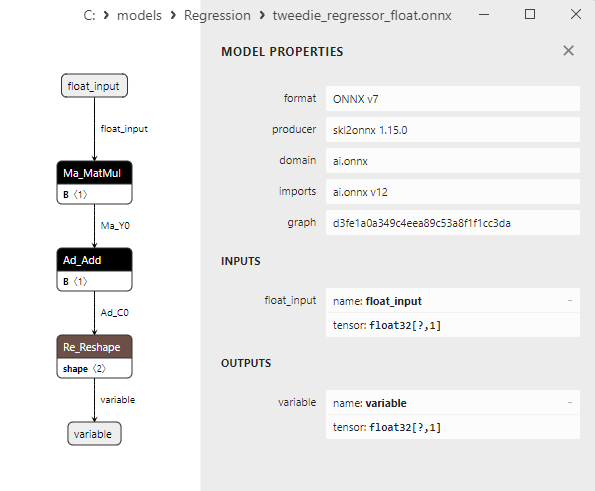

2.1.23.3. Rappresentazione ONNX di pls_regression_float.onnx e pls_regression_double.onnx - 2.1.24. sklearn.linear_model.TweedieRegressor

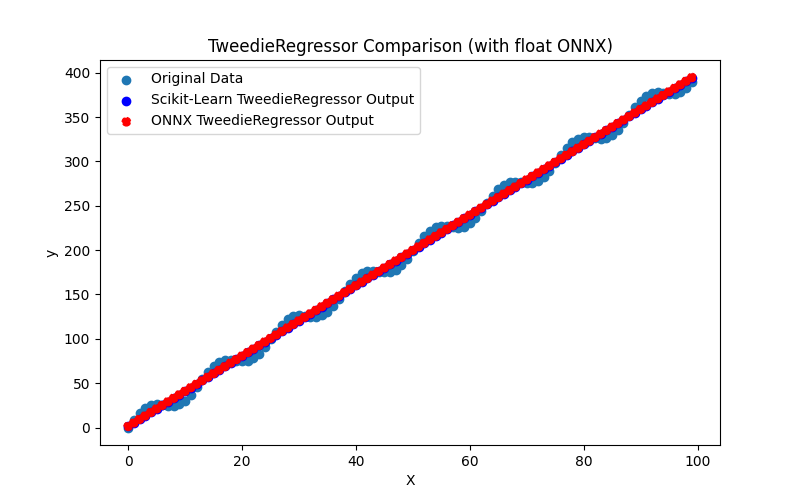

2.1.24.1. Codice per creare il modello TweedieRegressor ed esportarlo in ONNX per float e double

2.1.24.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.24.3. Rappresentazione ONNX di tweedie_regressor_float.onnx e tweedie_regressor_double.onnx - 2.1.25. sklearn.linear_model.PoissonRegressor

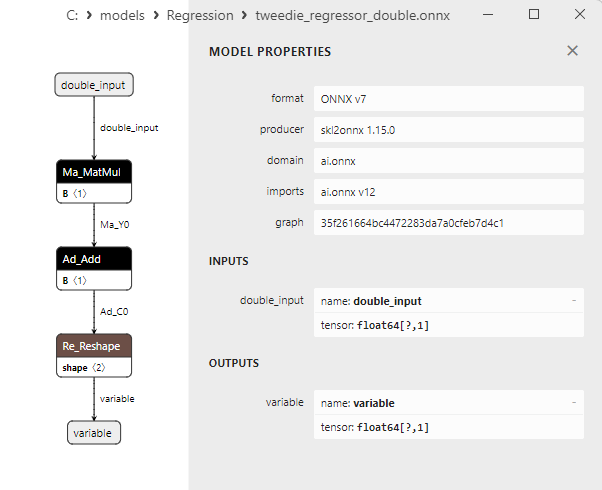

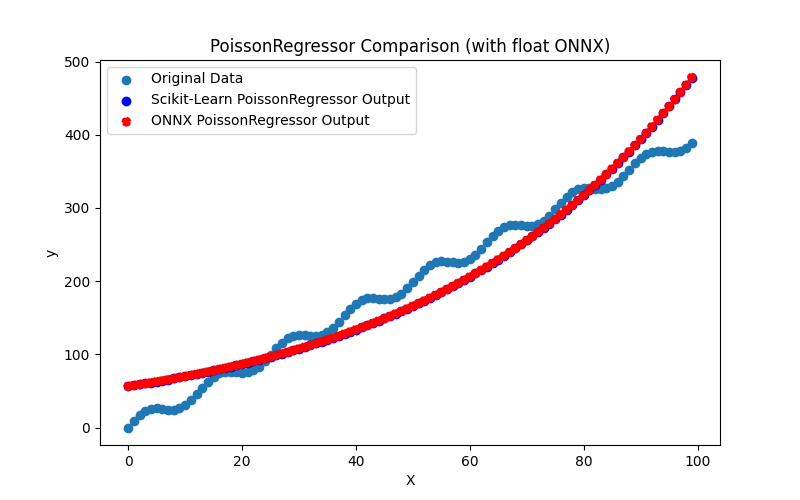

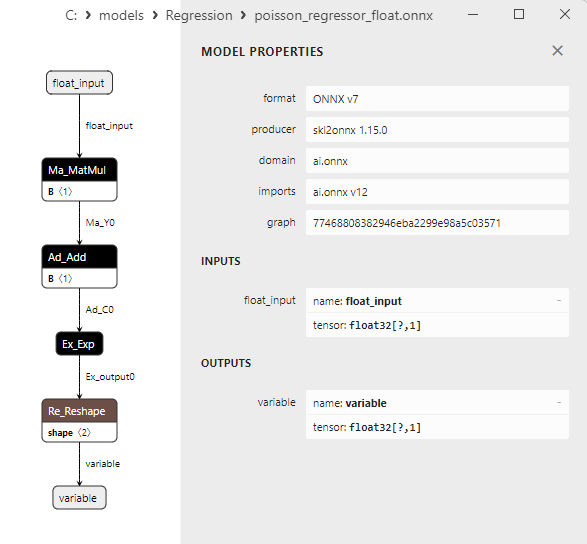

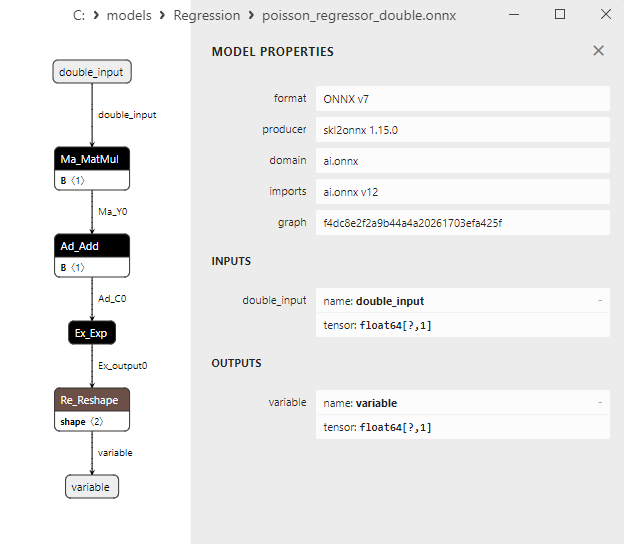

2.1.25.1. Codice per creare il modello PoissonRegressor ed esportarlo in ONNX per float e double

2.1.25.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.25.3. Rappresentazione ONNX di poisson_regressor_float.onnx e poisson_regressor_double.onnx - 2.1.26. sklearn.neighbors.RadiusNeighborsRegressor

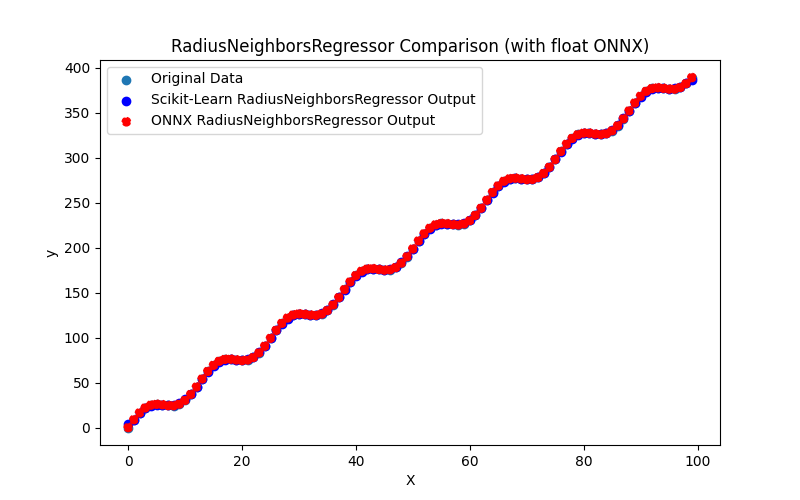

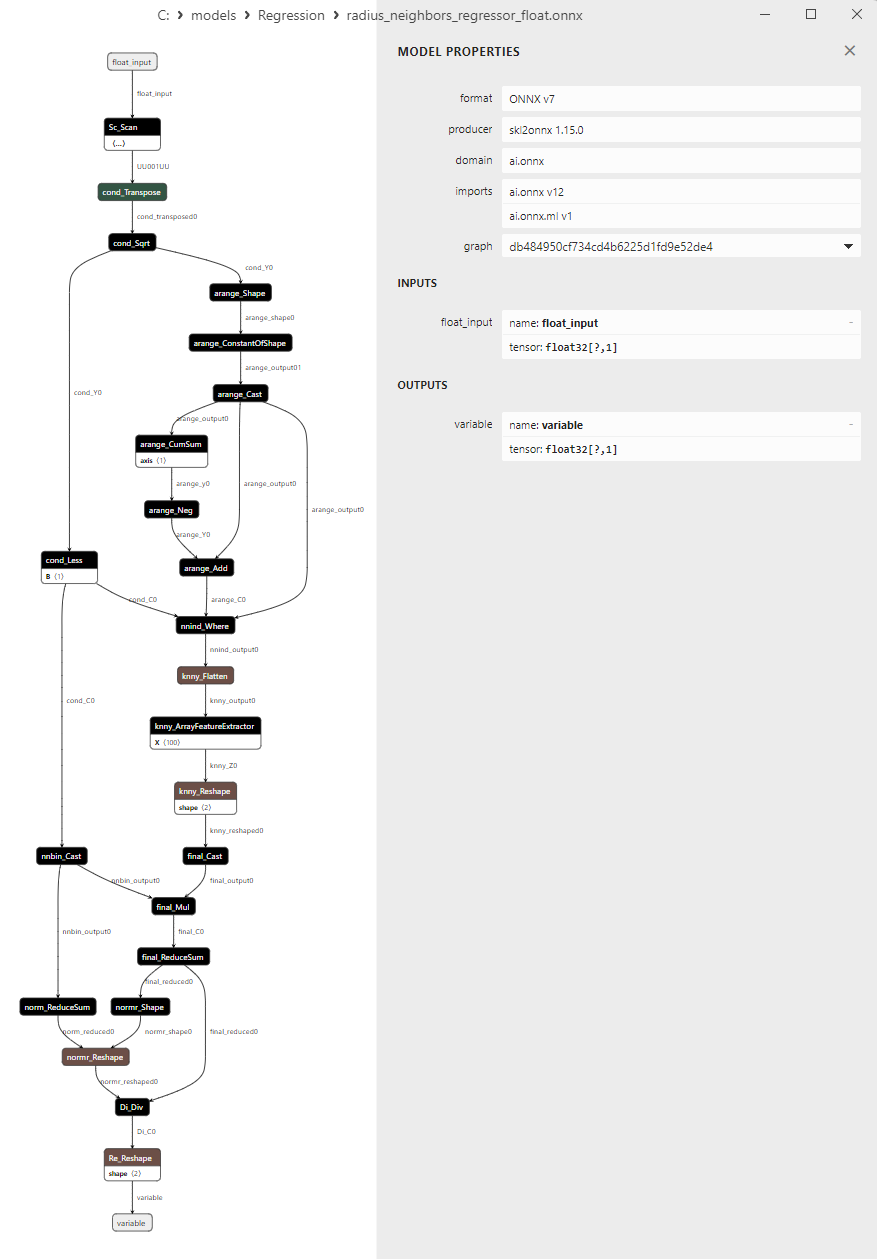

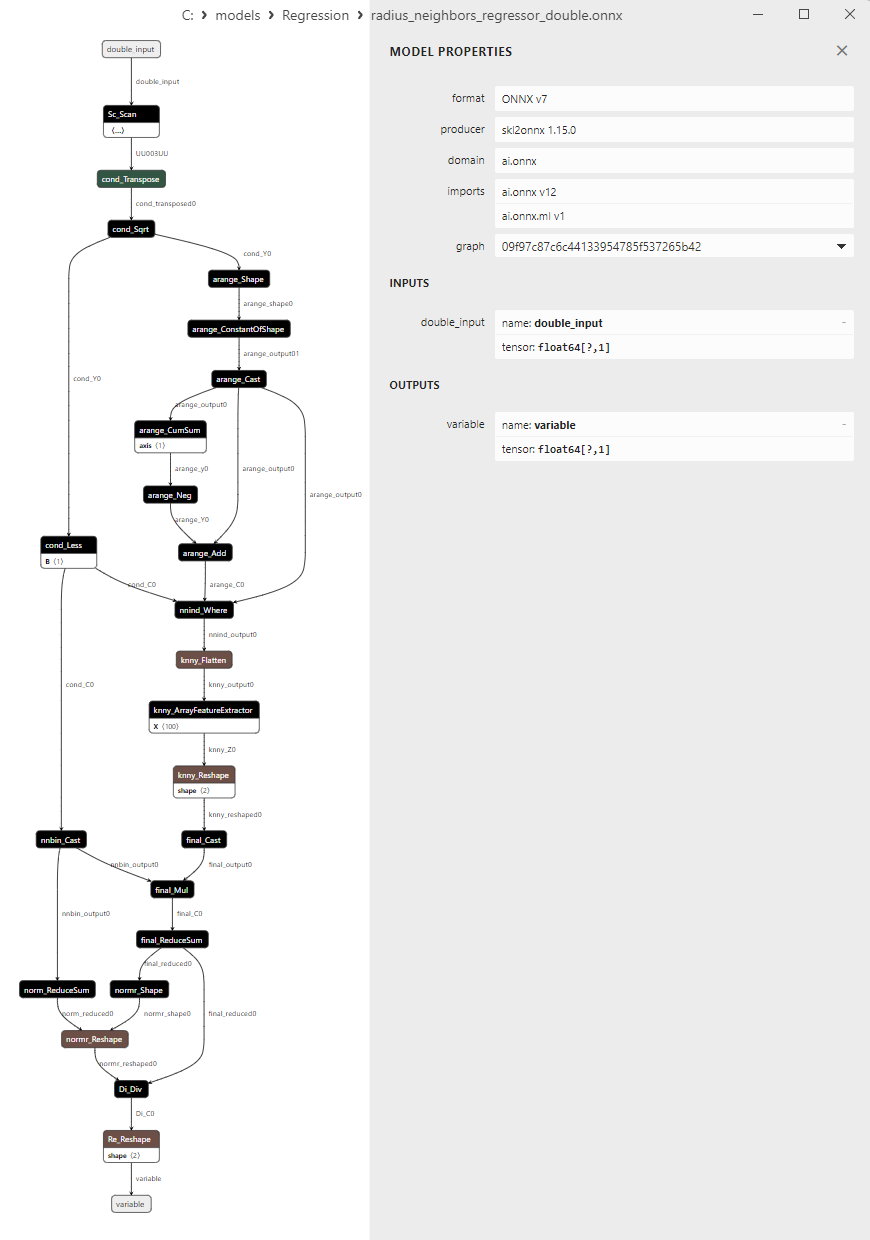

2.1.26.1. Codice per creare il modello RadiusNeighborsRegressor ed esportarlo in ONNX per float e double

2.1.26.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.26.3. Rappresentazione ONNX di radius_neighbors_regressor_float.onnx e radius_neighbors_regressor_double.onnx - 2.1.27. sklearn.neighbors.KNeighborsRegressor

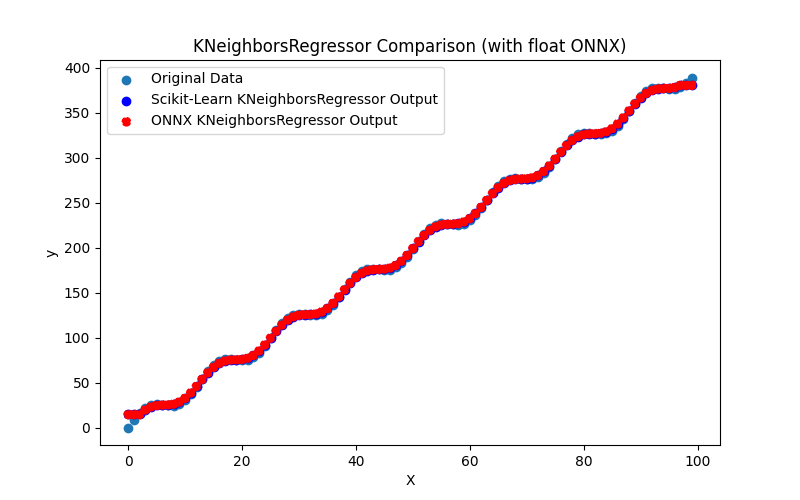

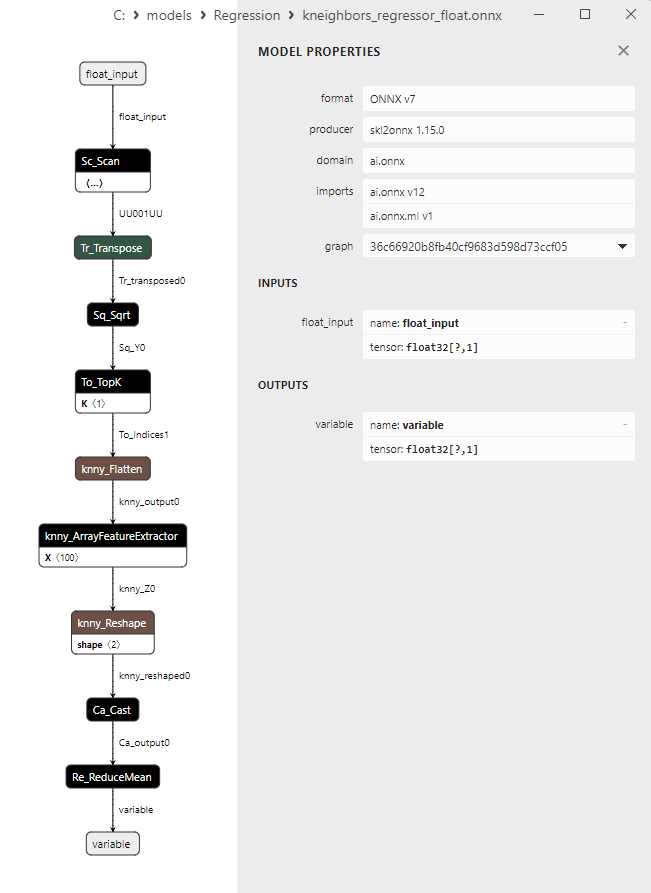

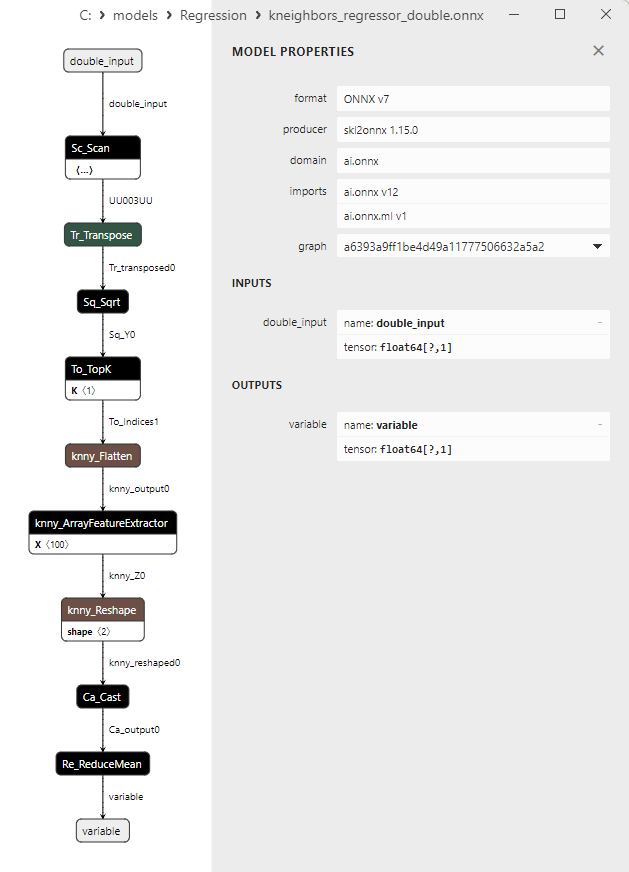

2.1.27.1. Codice per la creazione del modello KNeighborsRegressor ed esportazione in ONNX per float e double

2.1.27.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.27.3. Rappresentazione ONNX di kneighbors_regressor_float.onnx e kneighbors_regressor_double.onnx

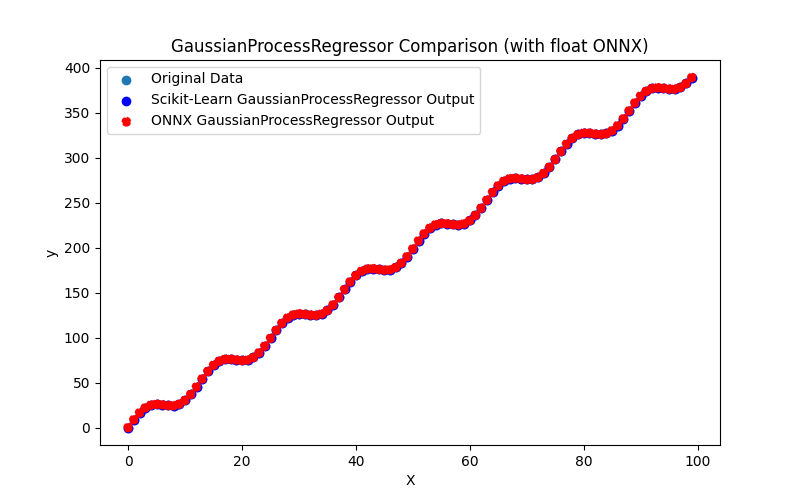

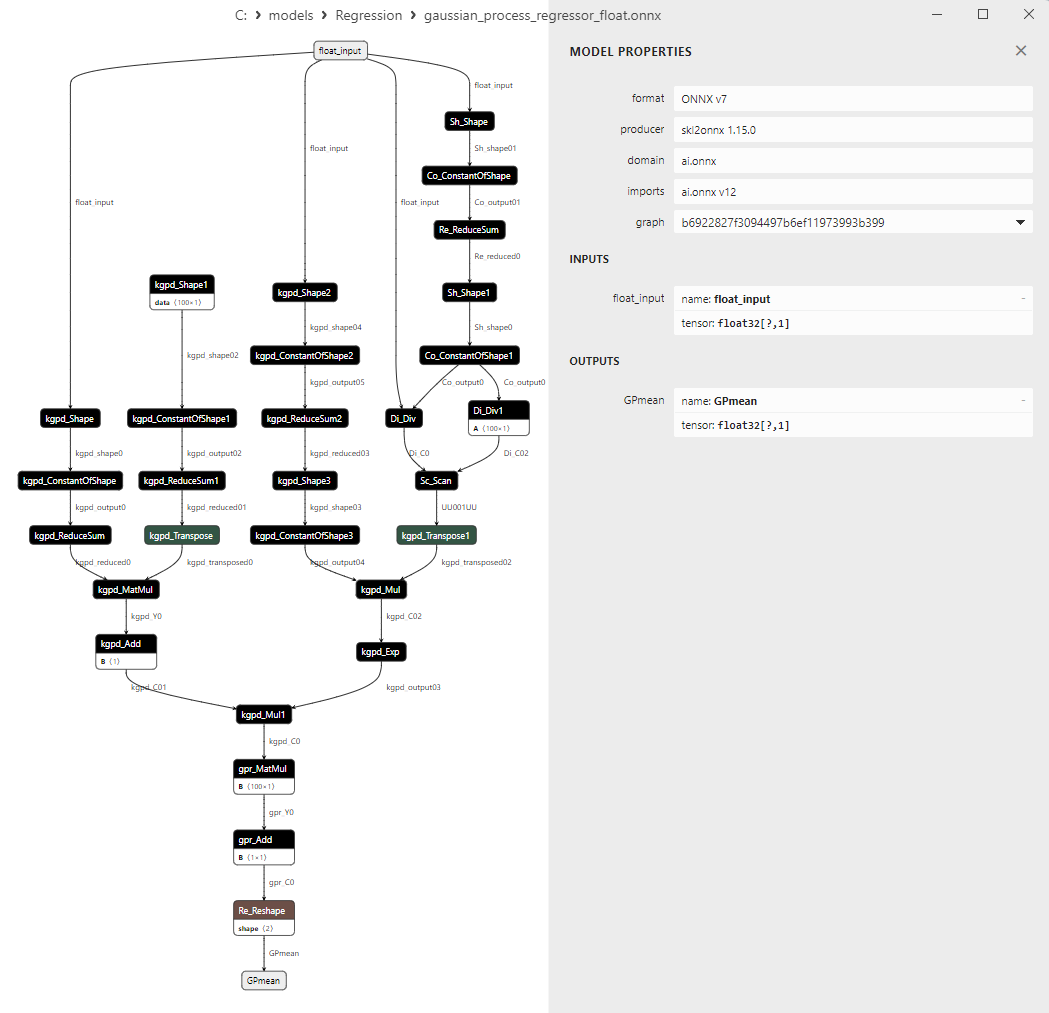

- 2.1.28. sklearn.gaussian_process.GaussianProcessRegressor

2.1.28.1. Codice per la creazione del modello GaussianProcessRegressor ed esportazione in ONNX per float e double

2.1.28.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.28.3. Rappresentazione ONNX di gaussian_process_regressor_float.onnx e gaussian_process_regressor_double.onnx

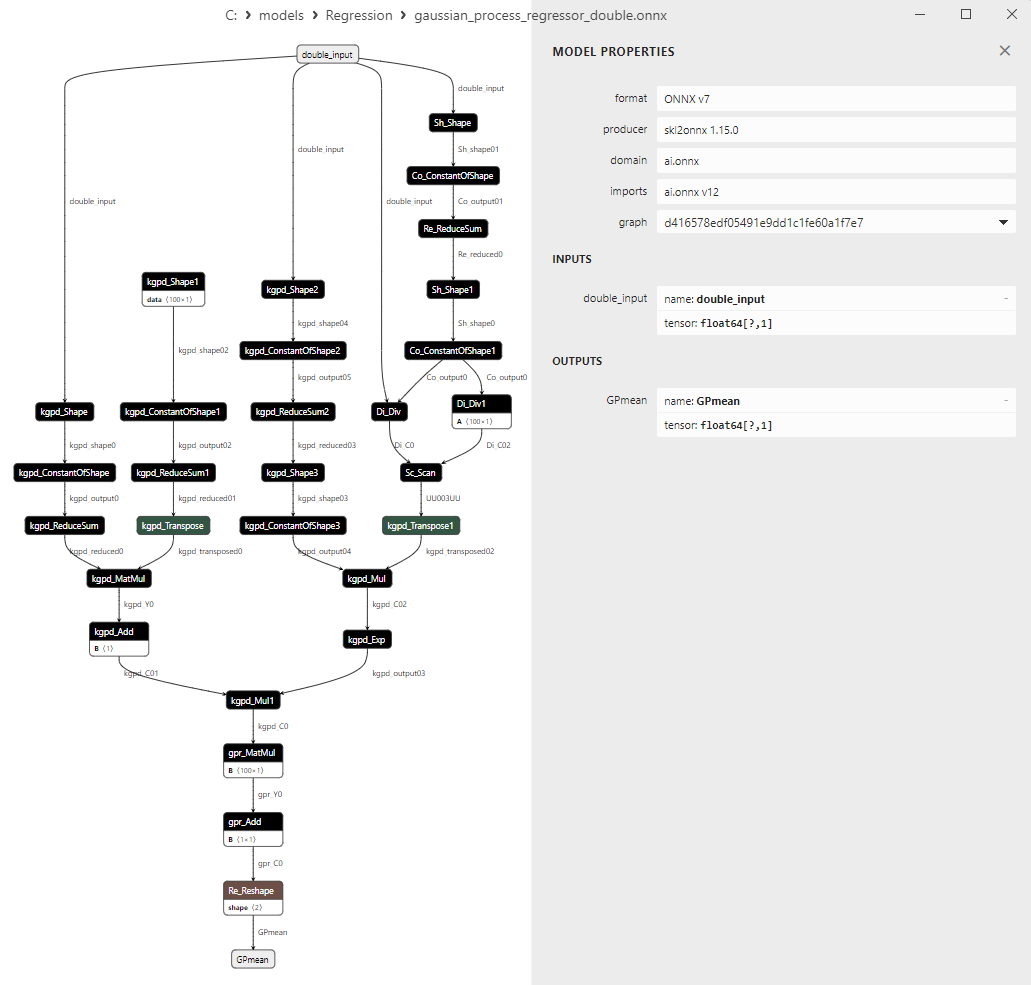

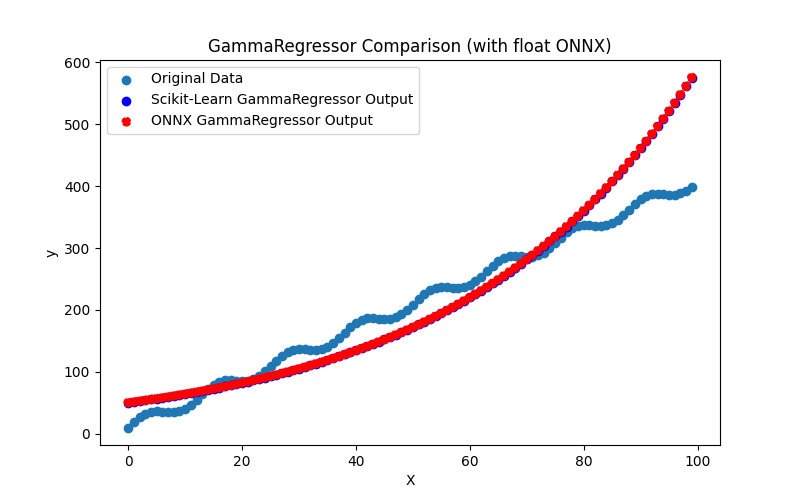

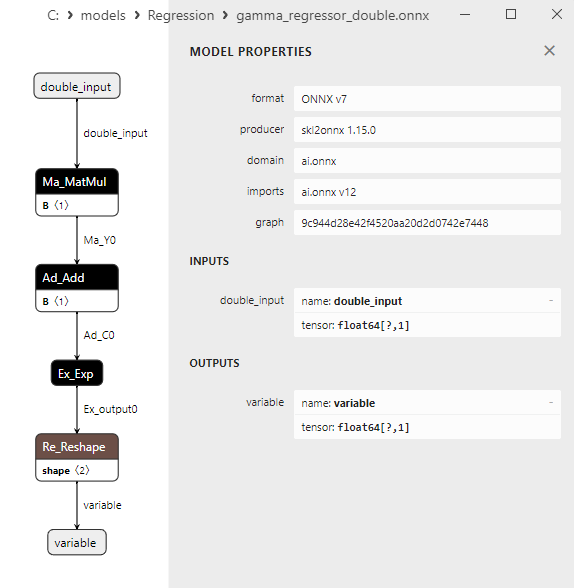

- 2.1.29. sklearn.linear_model.GammaRegressor

2.1.29.1. Codice per creare il modello GammaRegressor ed esportarlo in ONNX per float e double

2.1.29.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

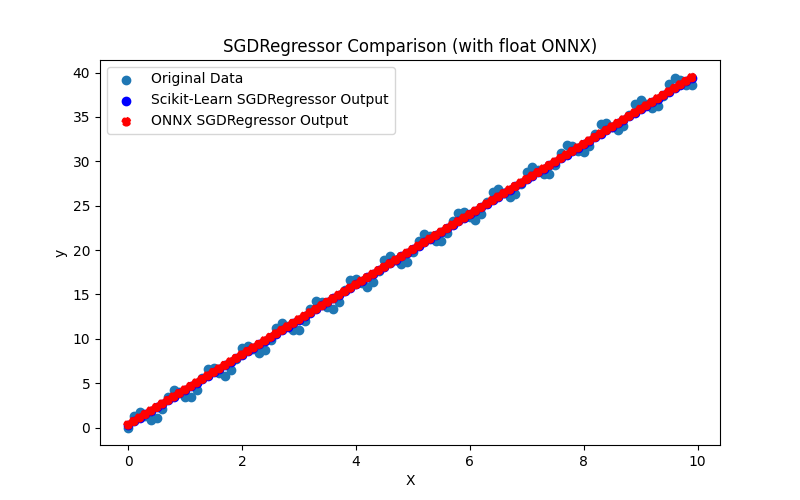

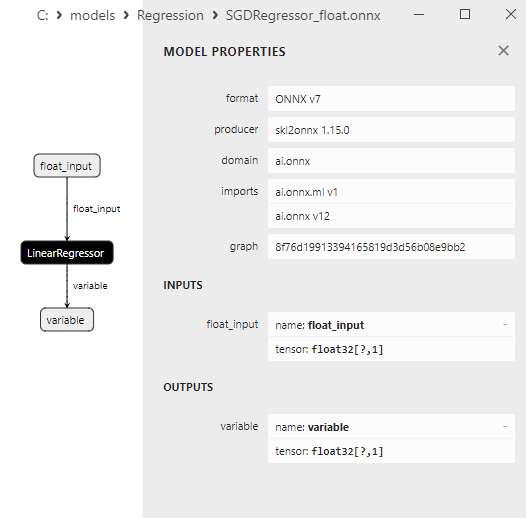

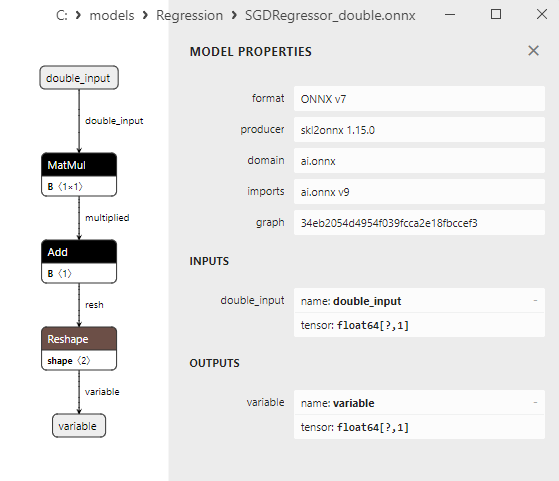

2.1.29.3. Rappresentazione ONNX di gamma_regressor_float.onnx e gamma_regressor_double.onnx - 2.1.30. sklearn.linear_model.SGDRegressor

2.1.30.1. Codice per la creazione del modello SGDRegressor ed esportazione in ONNX per float e double

2.1.30.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.1.30.3. Rappresentazione ONNX di sgd_regressor_float.onnx e sgd_rgressor_double.onnx

- 2.2. Modelli di regressione dalla libreria Scikit-learn che vengono convertiti solo in modelli ONNX con precisione float

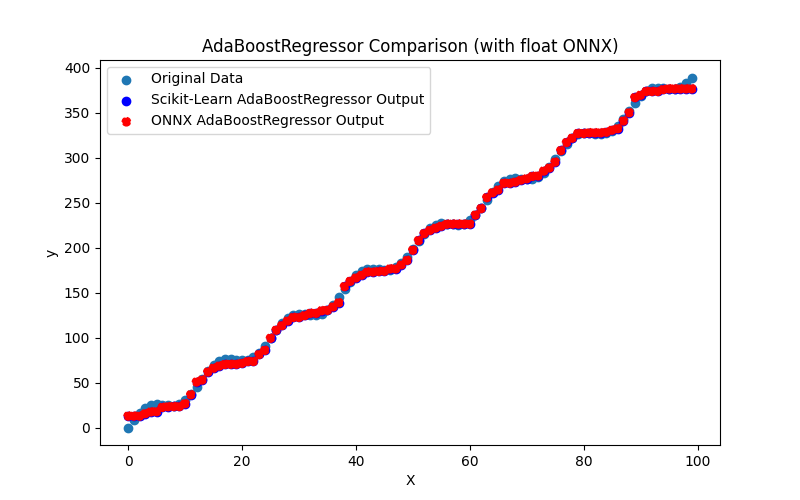

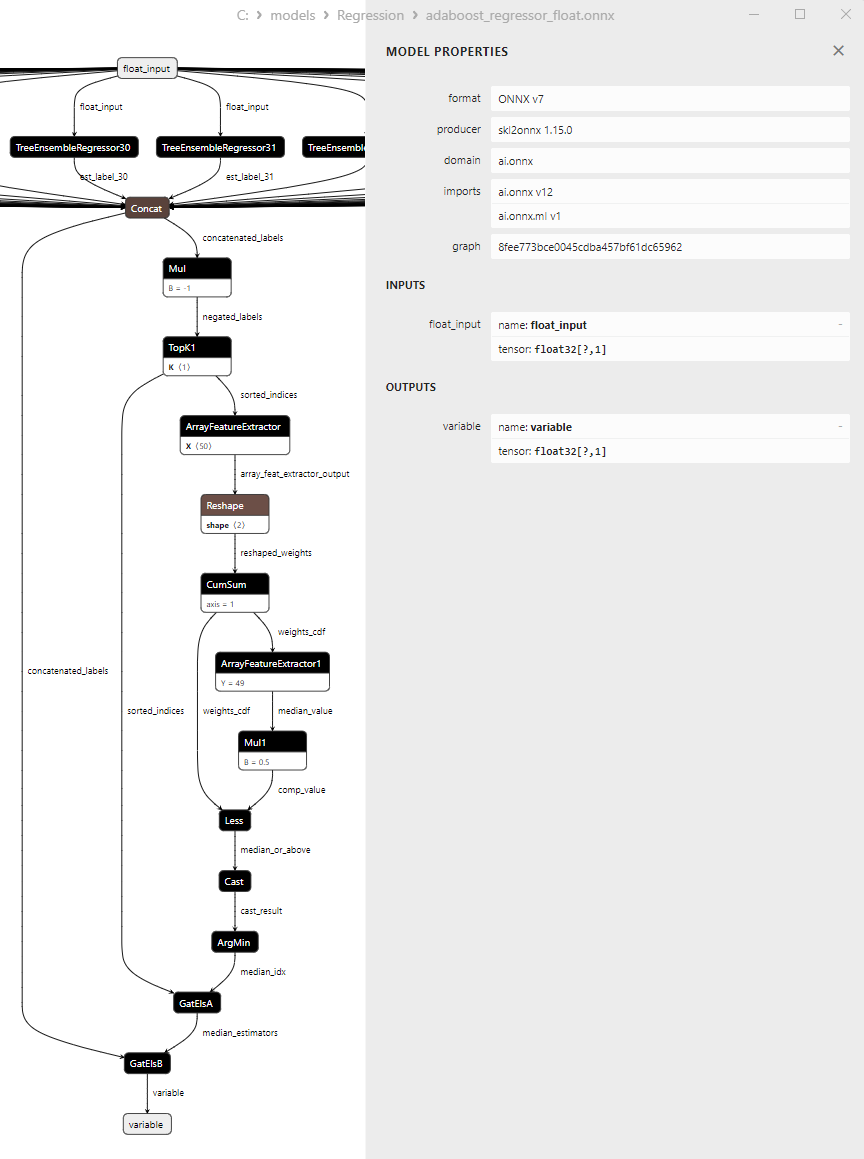

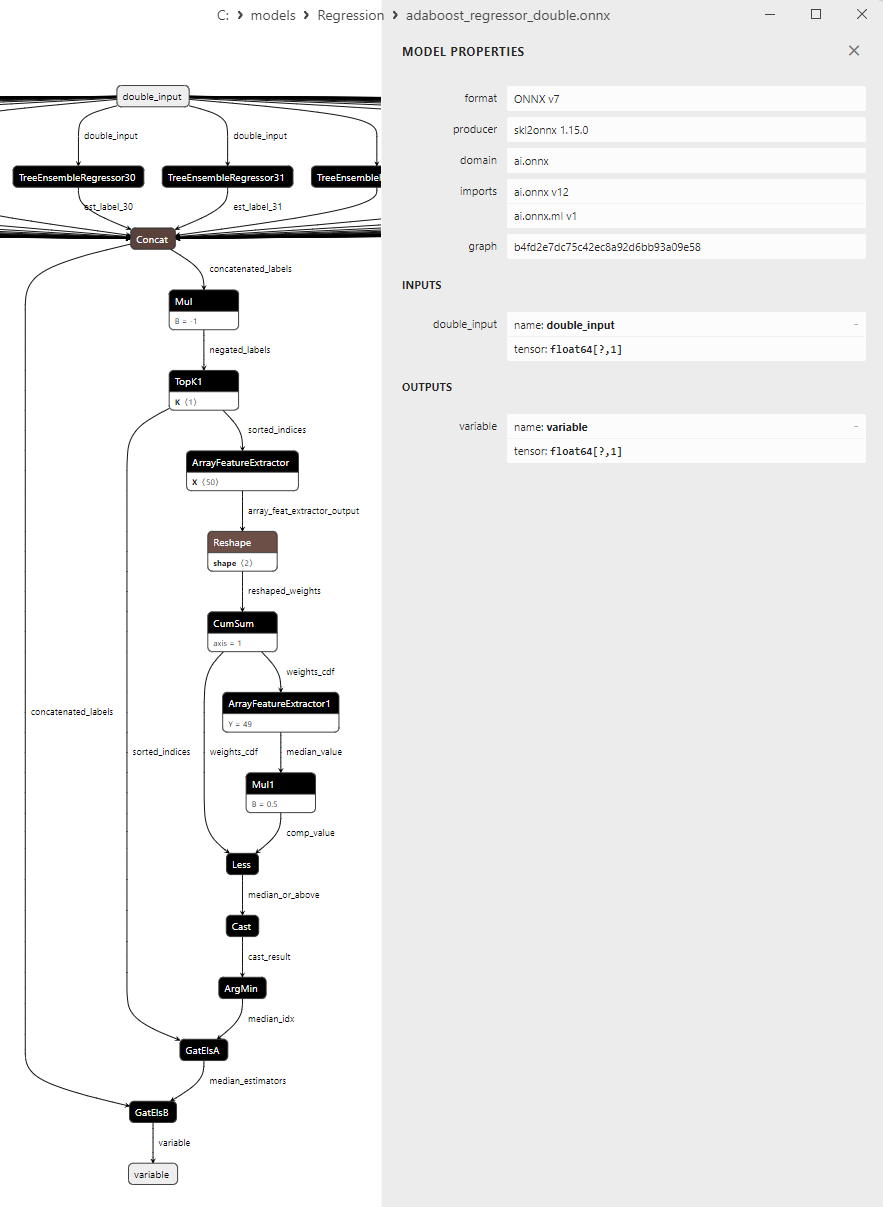

- 2.2.1. sklearn.linear_model.AdaBoostRegressor

2.2.1.1. Codice per creare il modello AdaBoostRegressor ed esportarlo in ONNX per float e double

2.2.1.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

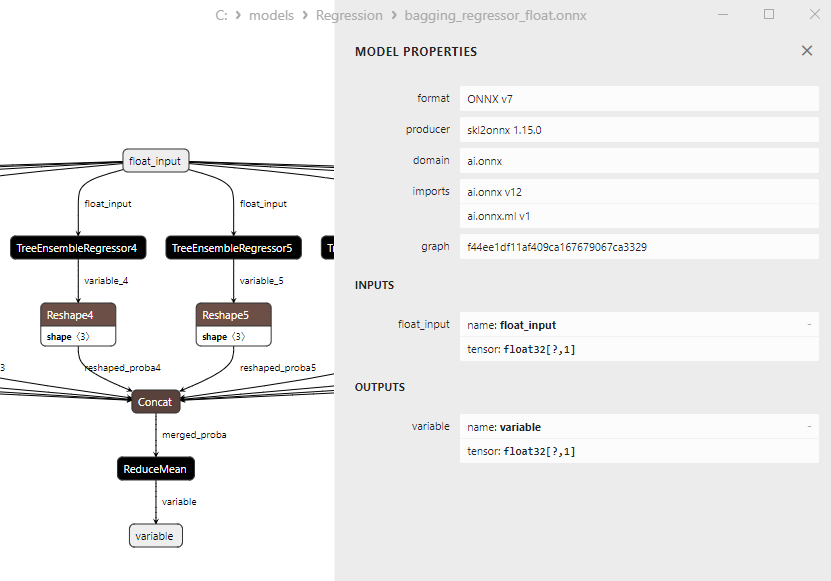

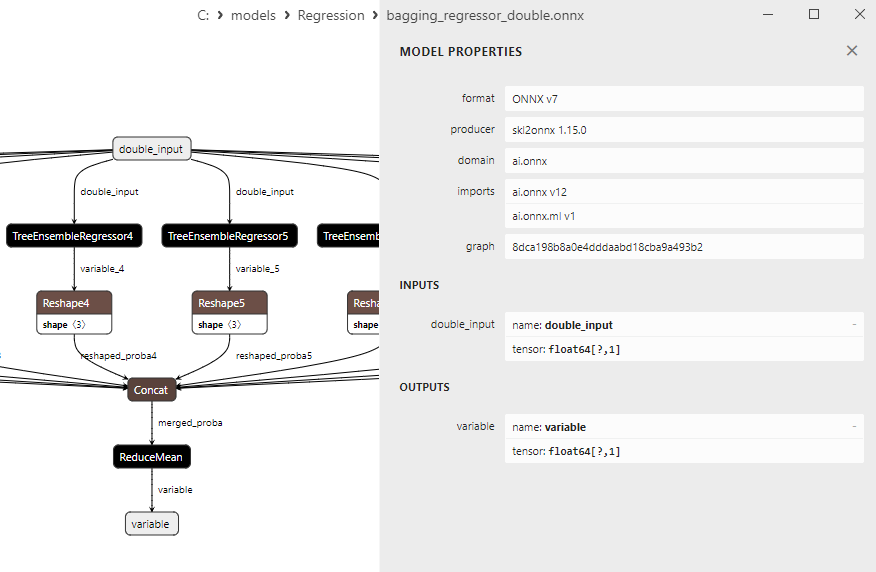

2.2.1.3. Rappresentazione ONNX di adaboost_regressor_float.onnx e adaboost_regressor_double.onnx - 2.2.2. sklearn.linear_model.BaggingRegressor

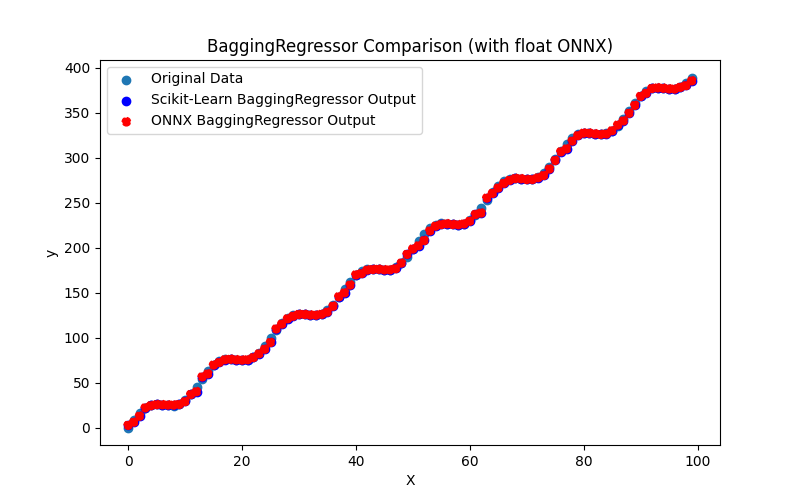

2.2.2.1. Codice per la creazione del modello BaggingRegressor e l'esportazione in ONNX per float e double

2.2.2.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.2.2.3. Rappresentazione ONNX di bagging_regressor_float.onnx e bagging_regressor_double.onnx - 2.2.3. sklearn.linear_model.DecisionTreeRegressor

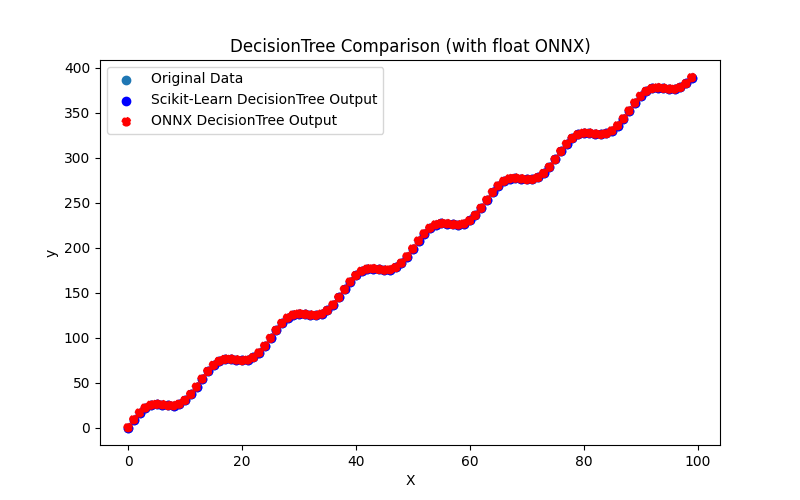

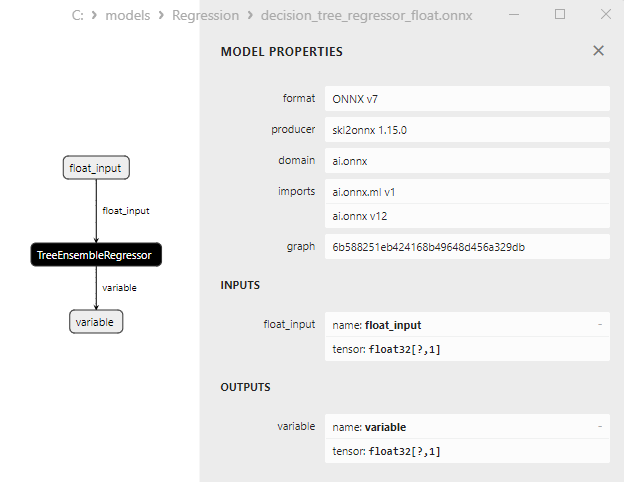

2.2.3.1. Codice per creare il modello DecisionTreeRegressor ed esportarlo in ONNX per float e double

2.2.3.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

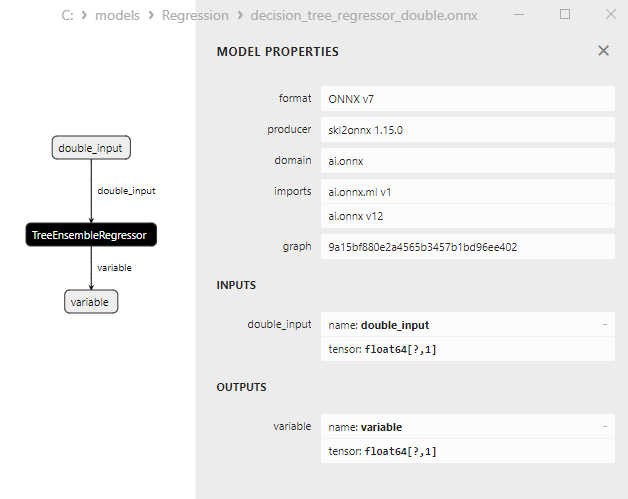

2.2.3.3. Rappresentazione ONNX decision_tree_regressor_float.onnx and decision_tree_regressor_double.onnx - 2.2.4. sklearn.linear_model.ExtraTreeRegressor

2.2.4.1. Codice per la creazione del modello ExtraTreeRegressor e per l'esportazione in ONNX per float e double

2.2.4.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

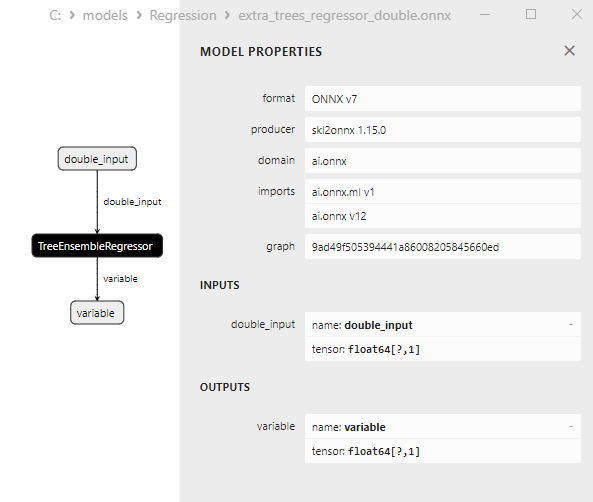

2.2.4.3. Rappresentazione ONNX di extra_tree_regressor_float.onnx e extra_tree_regressor_double.onnx - 2.2.5. sklearn.ensemble.ExtraTreesRegressor

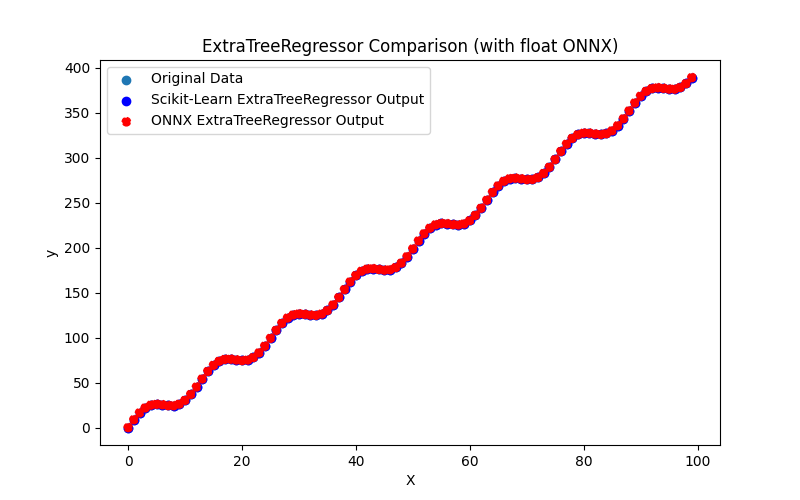

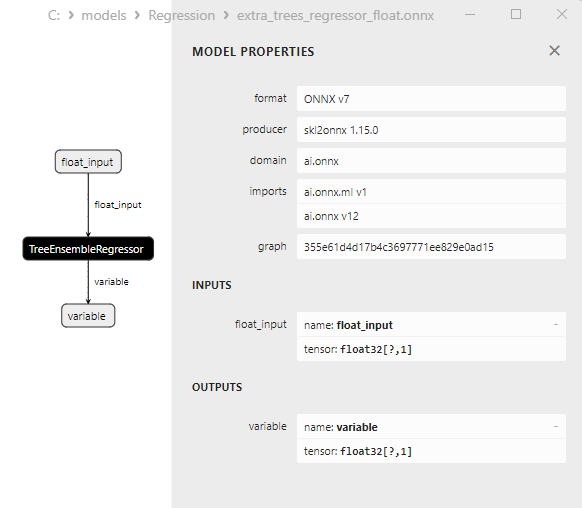

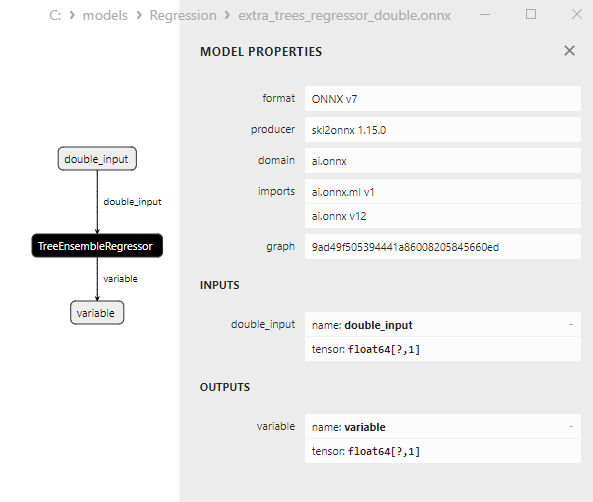

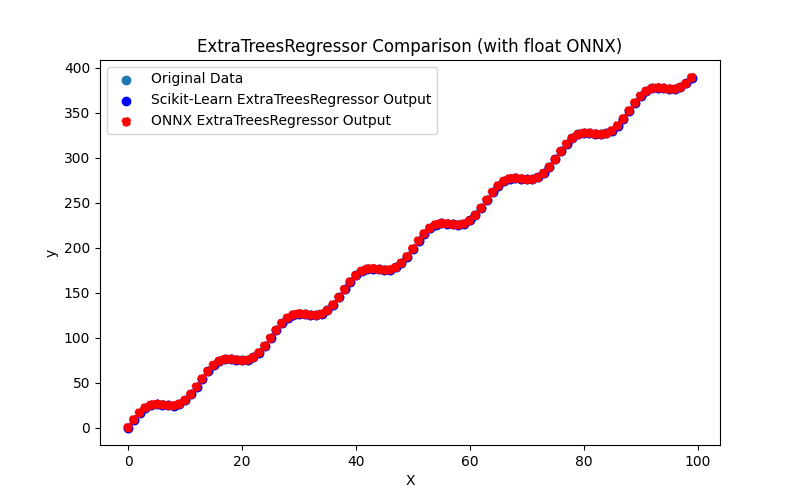

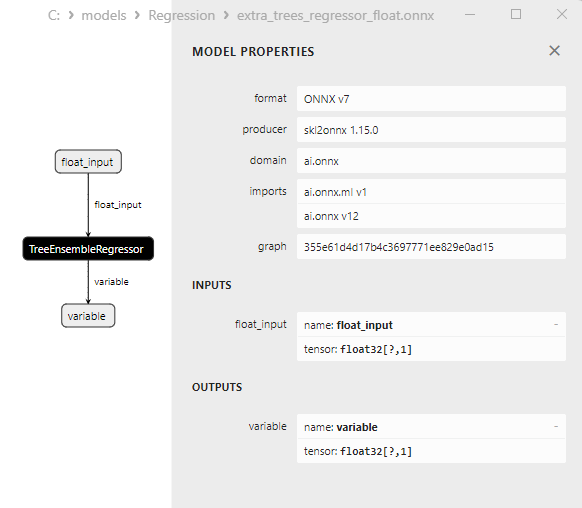

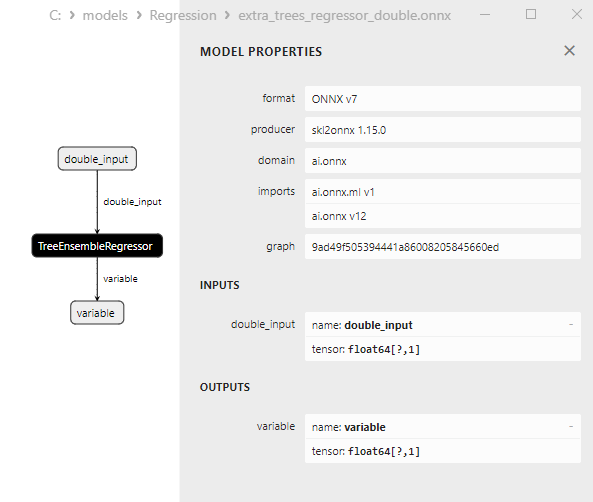

2.2.5.1. Codice per creare il modello ExtraTreesRegressor ed esportarlo in ONNX per float e double

2.2.5.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

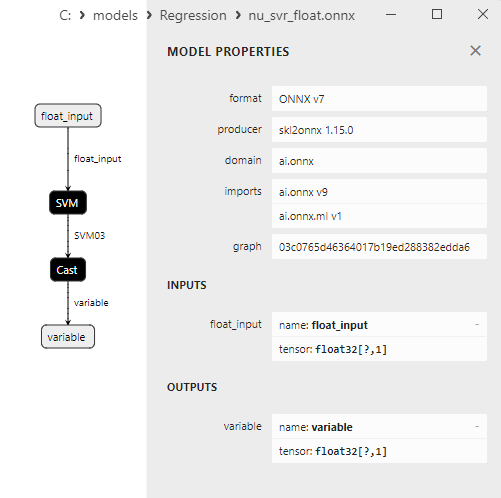

2.2.5.3. Rappresentazione ONNX di extra_trees_regressor_float.onnx e extra_trees_regressor_double.onnx - 2.2.6. sklearn.svm.NuSVR

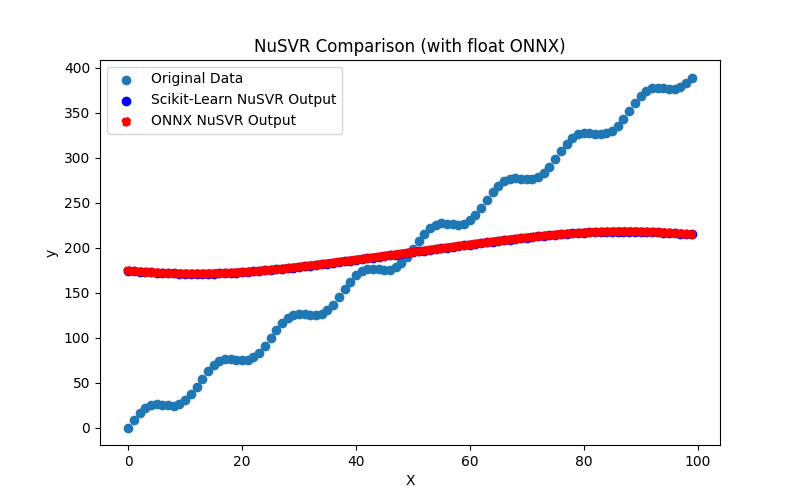

2.2.6.1. Codice per la creazione del modello NuSVR ed esportazione in ONNX per float e double

2.2.6.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.2.6.3. Rappresentazione ONNX di nu_svr_float.onnx e nu_svr_double.onnx - 2.2.7. sklearn.ensemble.RandomForestRegressor

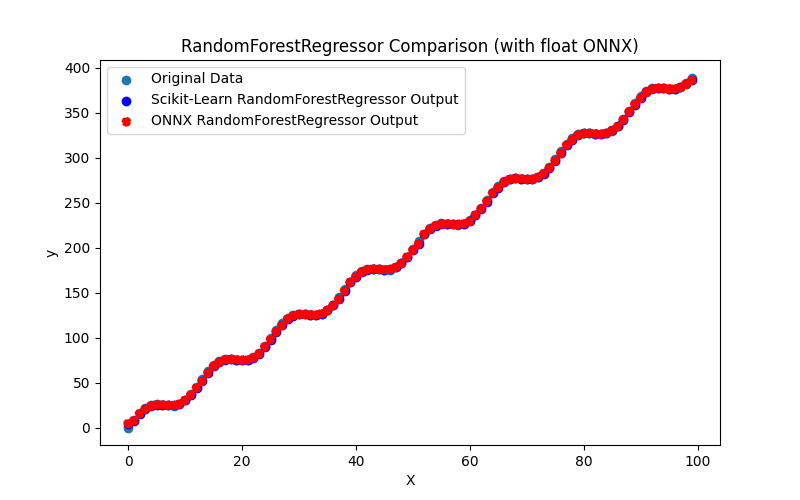

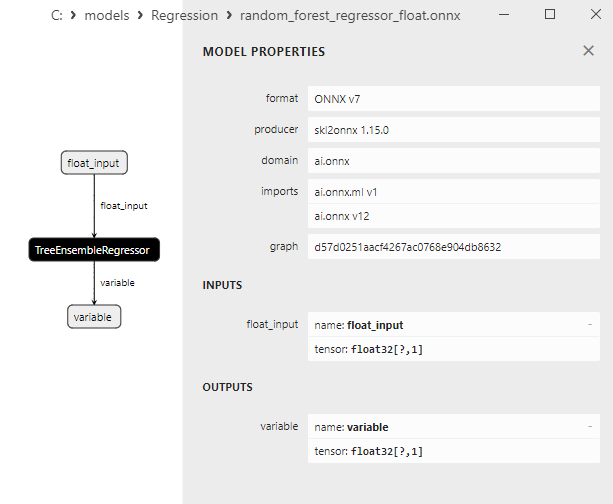

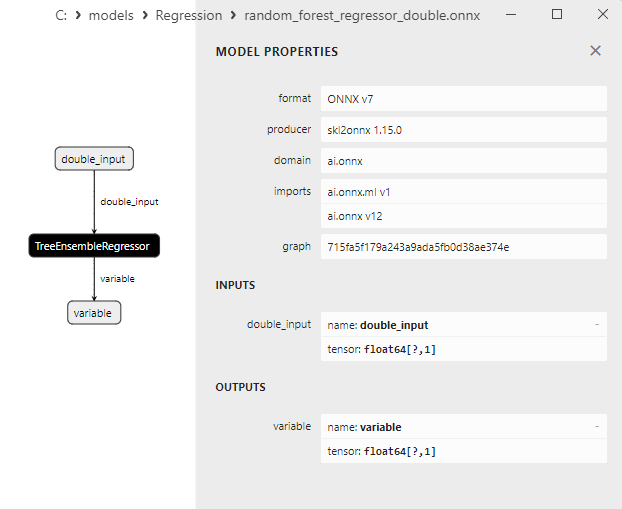

2.2.7.1. Codice per la creazione del modello RandomForestRegressor ed esportazione in ONNX per float e double

2.2.7.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.2.7.3. Rappresentazione ONNX di random_forest_regressor_float.onnx e random_forest_regressor_double.onnx

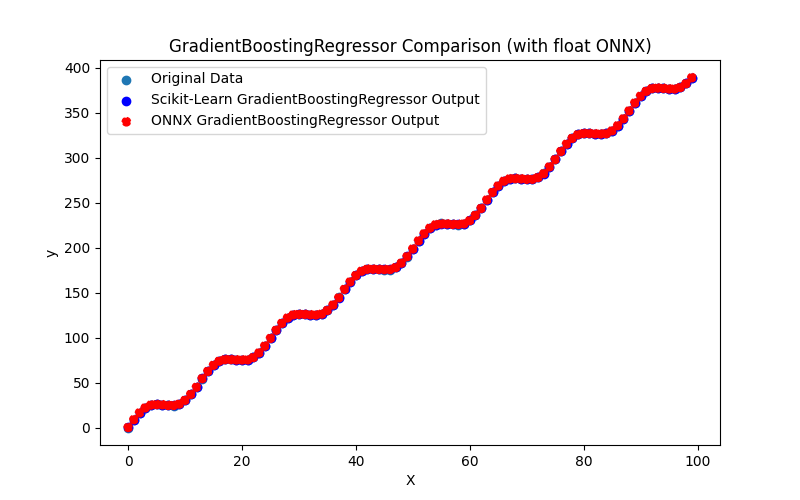

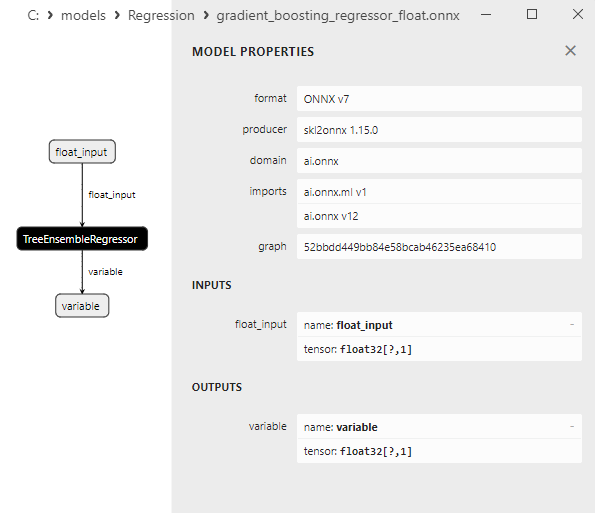

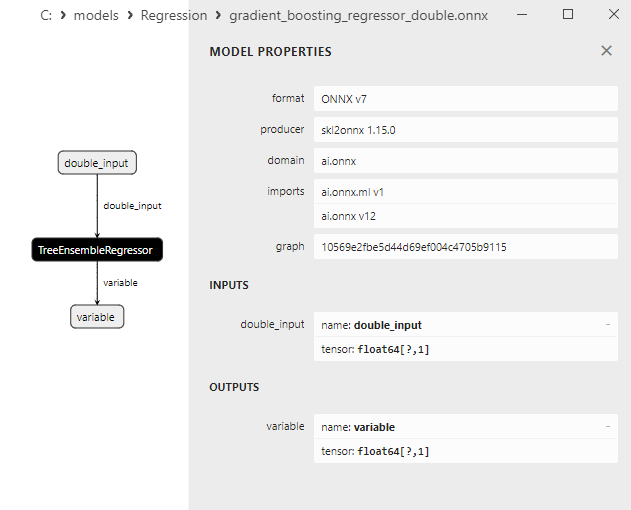

- 2.2.8. sklearn.ensemble.GradientBoostingRegressor

2.2.8.1. Codice per la creazione del modello GradientBoostingRegressor ed esportazione in ONNX per float e double

2.2.8.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.2.8.3. Rappresentazione ONNX del gradient_boosting_regressor_float.onnx e gradient_boosting_regressor_double.onnx

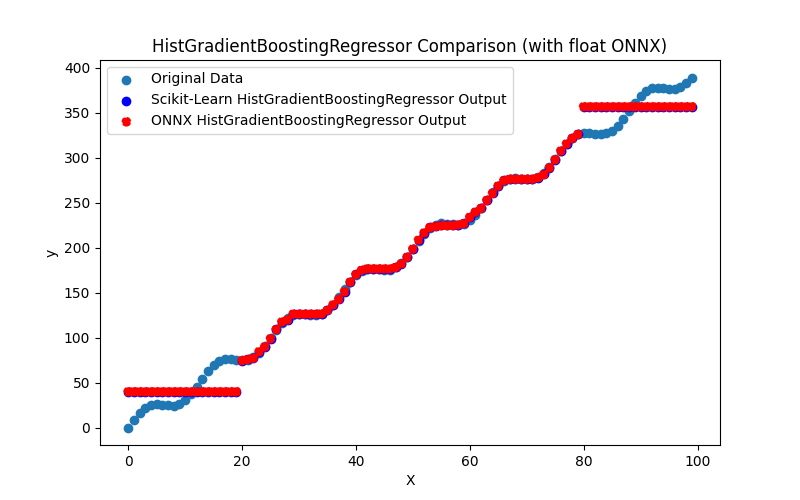

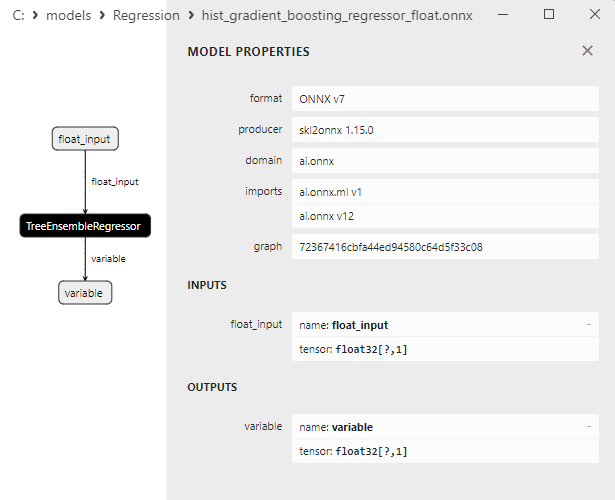

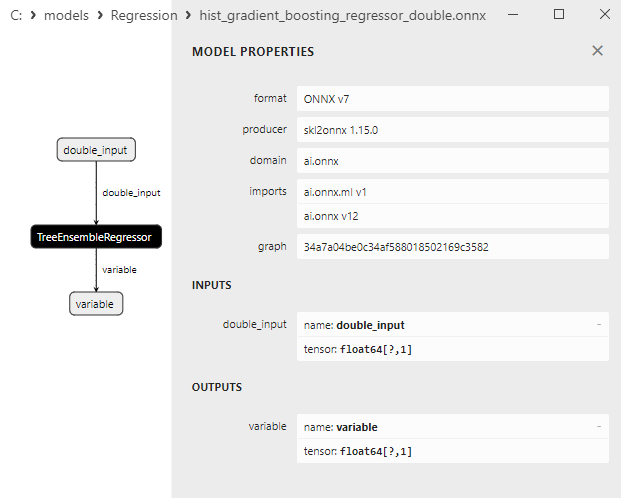

- 2.2.9. sklearn.ensemble.HistGradientBoostingRegressor

2.2.9.1. Codice per la creazione del modello HistGradientBoostingRegressor ed esportazione in ONNX per float e double

2.2.9.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

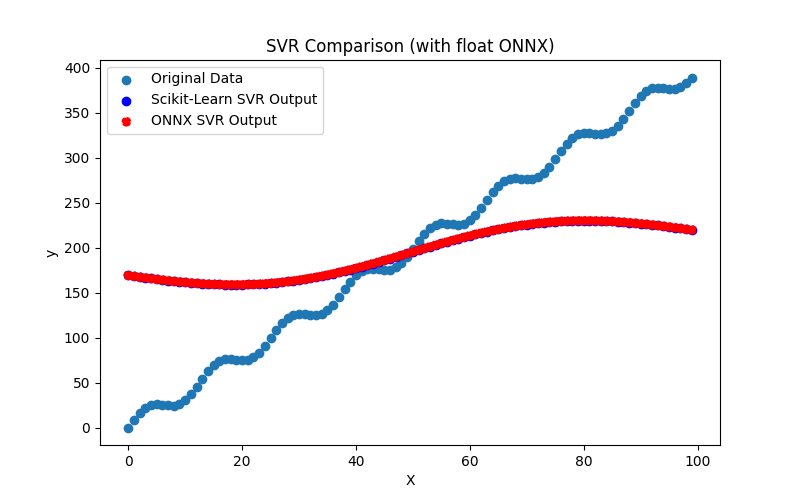

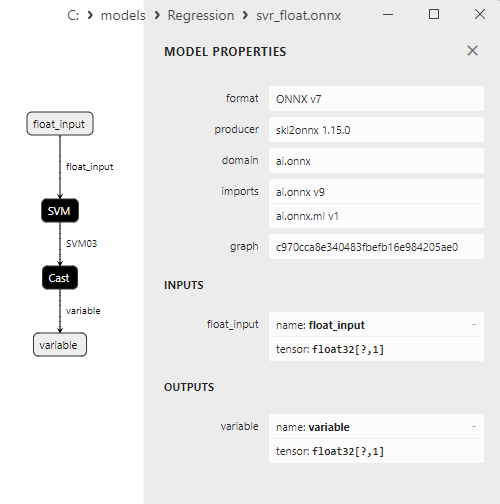

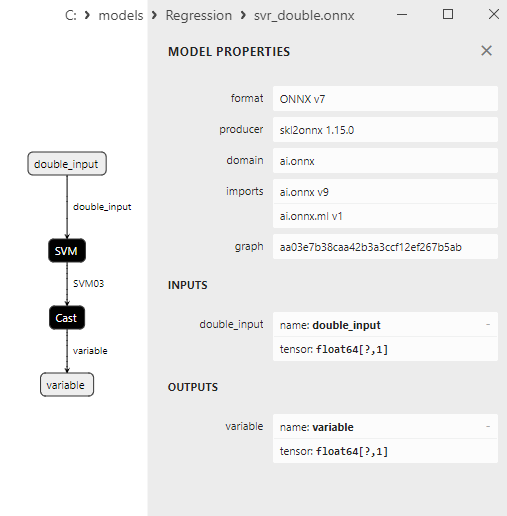

2.2.9.3. Rappresentazione ONNX di hist_gradient_boosting_regressor_float.onnx e hist_gradient_boosting_regressor_double.onnx - 2.2.10. sklearn.svm.SVR

2.2.10.1. Codice per la creazione del modello SVR ed esportazione in ONNX per float e double

2.2.10.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

2.2.10.3. Rappresentazione ONNX di svr_float.onnx e svr_double.onnx

- 2.3. Modelli di regressione che hanno riscontrato problemi durante la conversione in ONNX

- 2.3.1. sklearn.dummy.DummyRegressor

Codice per la creazione di DummyRegressor - 2.3.2. sklearn.kernel_ridge.KernelRidge

Codice per la creazione di KernelRidge - 2.3.3. sklearn.isotonic.IsotonicRegression

Codice per la creazione di IsotonicRegression - 2.3.4. sklearn.cross_decomposition.PLSCanonical

Codice per la creazione di PLSCanonical - 2.3.5. sklearn.cross_decomposition.CCA

Codice per la creazione di CCA - Conclusione

- Riepilogo

Se ti dà fastidio, ben venga il tuo contributo

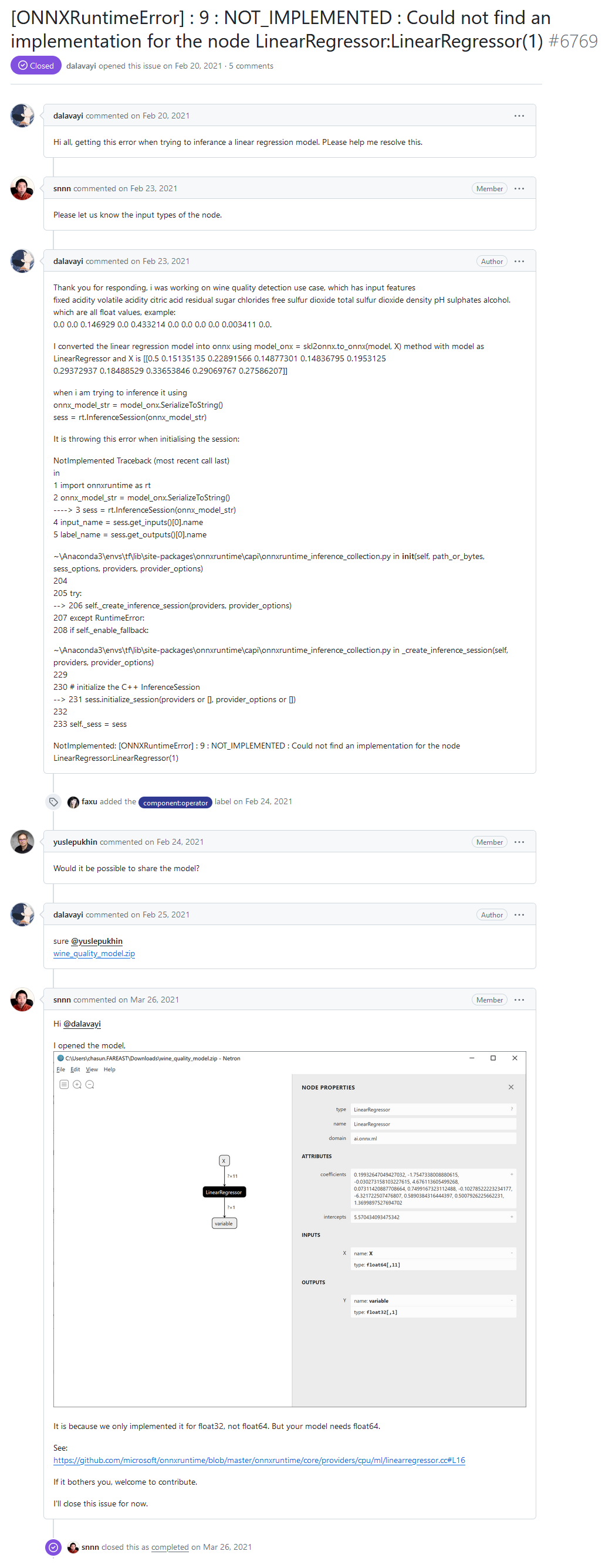

Sul forum degli sviluppatori di ONNX Runtime, uno degli utenti ha segnalato un errore "[ONNXRuntimeError] : 9 : NOT_IMPLEMENTED : Impossibile trovare un'implementazione per il nodo LinearRegressor:LinearRegressor(1)" durante l'esecuzione di un modello tramite ONNX Runtime.

Ciao a tutti, ricevo questo errore quando provo a dedurre un modello di regressione lineare. Vi prego di aiutarmi a risolvere questo problema.

"NOT_IMPLEMENTED : Impossibile trovare un'implementazione per il nodo LinearRegressor:LinearRegressor(1)" errore dal forum degli sviluppatori di ONNX Runtime

Risposta dello sviluppatore:

È perché l'abbiamo implementato solo per float32 e non per float64. Ma il tuo modello ha bisogno di float64.

Vedi:

https://github.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16

Se ti dà fastidio, ben venga il tuo contributo.

Nel modello ONNX dell'utente, l'operatore ai.onnx.ml.LinearRegressor è chiamato con il tipo di dati double (float64) e il messaggio di errore si verifica perché il Runtime ONNX non supporta l'operatore LinearRegressor() con precisione double.

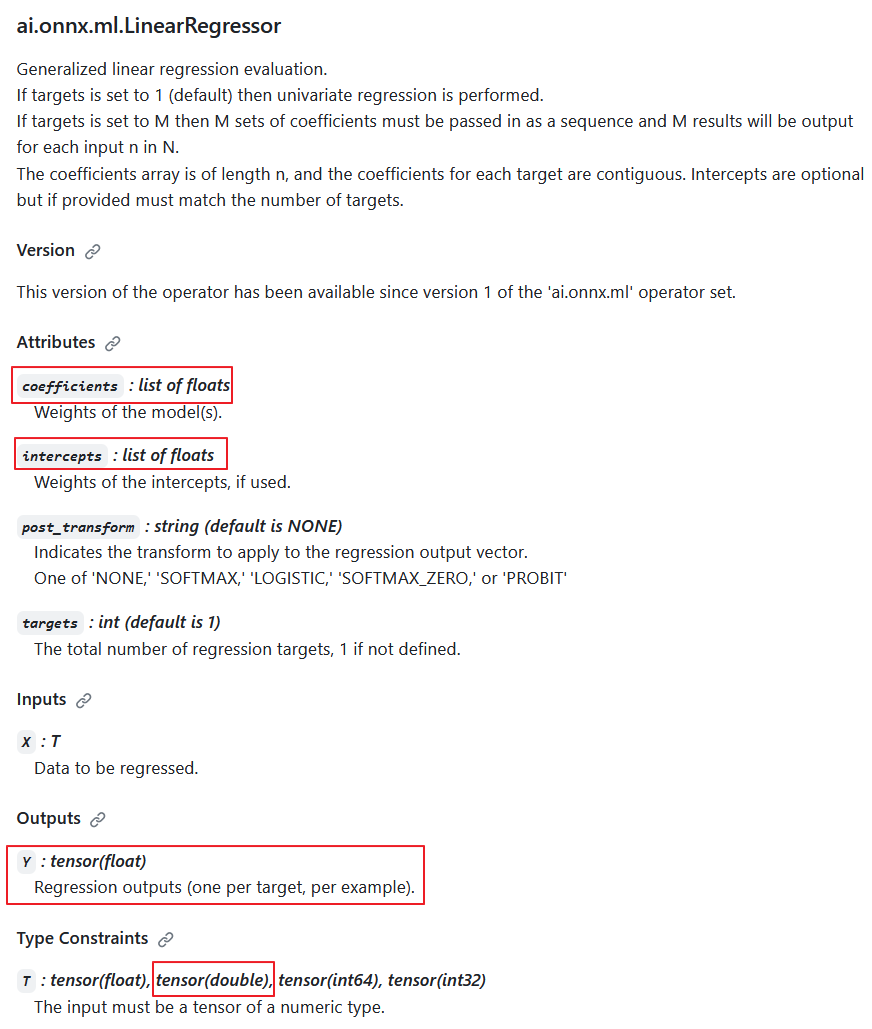

Secondo le specifiche dell'operatore ai.onnx.ml.LinearRegressor, il tipo di dati di ingresso double è possibile (T: tensor(float), tensor(double), tensor(int64), tensor(int32)); tuttavia, gli sviluppatori hanno scelto intenzionalmente di non implementarlo.

Il motivo è che l'uscita restituisce sempre il valore Y: tensor(float). Inoltre, i parametri di calcolo sono numeri float (coefficienti: lista di float, intercette: lista di float).

Di conseguenza, quando i calcoli vengono eseguiti in precisione double, questo operatore riduce la precisione a float e la sua implementazione nei calcoli in precisione double ha un valore discutibile.

Descrizione dell'operatore ai.onnx.ml.LinearRegressor

Pertanto, la riduzione della precisione a float nei parametri e nel valore di uscita rende impossibile il pieno funzionamento di ai.onnx.ml.LinearRegressor con numeri double (float64). Presumibilmente, per questo motivo, gli sviluppatori del Runtime ONNX hanno deciso di non implementarlo per il tipo double

Il metodo di "aggiunta del supporto double" è stato dimostrato dagli sviluppatori nei commenti al codice (evidenziati in giallo).

In ONNX Runtime, il suo calcolo viene eseguito utilizzando la classe LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.h).

I parametri dell'operatore, coefficienti_ e intercette_, sono memorizzati come std::vector<float>:

#pragma once #include "core/common/common.h" #include "core/framework/op_kernel.h" #include "core/util/math_cpuonly.h" #include "ml_common.h" namespace onnxruntime { namespace ml { class LinearRegressor final : public OpKernel { public: LinearRegressor(const OpKernelInfo& info); Status Compute(OpKernelContext* context) const override; private: int64_t num_targets_; std::vector<float> coefficients_; std::vector<float> intercepts_; bool use_intercepts_; POST_EVAL_TRANSFORM post_transform_; }; } // namespace ml } // namespace onnxruntimeL'implementazione dell'operatore LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.cc)

// Copyright (c) Microsoft Corporation. All rights reserved. // Licensed under the MIT License. #include "core/providers/cpu/ml/linearregressor.h" #include "core/common/narrow.h" #include "core/providers/cpu/math/gemm.h" namespace onnxruntime { namespace ml { ONNX_CPU_OPERATOR_ML_KERNEL( LinearRegressor, 1, // KernelDefBuilder().TypeConstraint("T", std::vector<MLDataType>{ // DataTypeImpl::GetTensorType<float>(), // DataTypeImpl::GetTensorType<double>()}), KernelDefBuilder().TypeConstraint("T", DataTypeImpl::GetTensorType<float>()), LinearRegressor); LinearRegressor::LinearRegressor(const OpKernelInfo& info) : OpKernel(info), intercepts_(info.GetAttrsOrDefault<float>("intercepts")), post_transform_(MakeTransform(info.GetAttrOrDefault<std::string>("post_transform", "NONE"))) { ORT_ENFORCE(info.GetAttr<int64_t>("targets", &num_targets_).IsOK()); ORT_ENFORCE(info.GetAttrs<float>("coefficients", coefficients_).IsOK()); // use the intercepts_ if they're valid use_intercepts_ = intercepts_.size() == static_cast<size_t>(num_targets_); } // Use GEMM for the calculations, with broadcasting of intercepts // https://github.com/onnx/onnx/blob/main/docs/Operators.md#Gemm // // X: [num_batches, num_features] // coefficients_: [num_targets, num_features] // intercepts_: optional [num_targets]. // Output: X * coefficients_^T + intercepts_: [num_batches, num_targets] template <typename T> static Status ComputeImpl(const Tensor& input, ptrdiff_t num_batches, ptrdiff_t num_features, ptrdiff_t num_targets, const std::vector<float>& coefficients, const std::vector<float>* intercepts, Tensor& output, POST_EVAL_TRANSFORM post_transform, concurrency::ThreadPool* threadpool) { const T* input_data = input.Data<T>(); T* output_data = output.MutableData<T>(); if (intercepts != nullptr) { TensorShape intercepts_shape({num_targets}); onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, intercepts->data(), &intercepts_shape, output_data, threadpool); } else { onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, nullptr, nullptr, output_data, threadpool); } if (post_transform != POST_EVAL_TRANSFORM::NONE) { ml::batched_update_scores_inplace(gsl::make_span(output_data, SafeInt<size_t>(num_batches) * num_targets), num_batches, num_targets, post_transform, -1, false, threadpool); } return Status::OK(); } Status LinearRegressor::Compute(OpKernelContext* ctx) const { Status status = Status::OK(); const auto& X = *ctx->Input<Tensor>(0); const auto& input_shape = X.Shape(); if (input_shape.NumDimensions() > 2) { return ORT_MAKE_STATUS(ONNXRUNTIME, INVALID_ARGUMENT, "Input shape had more than 2 dimension. Dims=", input_shape.NumDimensions()); } ptrdiff_t num_batches = input_shape.NumDimensions() <= 1 ? 1 : narrow<ptrdiff_t>(input_shape[0]); ptrdiff_t num_features = input_shape.NumDimensions() <= 1 ? narrow<ptrdiff_t>(input_shape.Size()) : narrow<ptrdiff_t>(input_shape[1]); Tensor& Y = *ctx->Output(0, {num_batches, num_targets_}); concurrency::ThreadPool* tp = ctx->GetOperatorThreadPool(); auto element_type = X.GetElementType(); switch (element_type) { case ONNX_NAMESPACE::TensorProto_DataType_FLOAT: { status = ComputeImpl<float>(X, num_batches, num_features, narrow<ptrdiff_t>(num_targets_), coefficients_, use_intercepts_ ? &intercepts_ : nullptr, Y, post_transform_, tp); break; } case ONNX_NAMESPACE::TensorProto_DataType_DOUBLE: { // TODO: Add support for 'double' to the scoring functions in ml_common.h // once that is done we can just call ComputeImpl<double>... // Alternatively we could cast the input to float. } default: status = ORT_MAKE_STATUS(ONNXRUNTIME, FAIL, "Unsupported data type of ", element_type); } return status; } } // namespace ml } // namespace onnxruntime

Si è scoperto che esiste un'opzione per utilizzare i numeri double come valori di ingresso ed eseguire il calcolo dell'operatore con parametri float. Un'altra possibilità potrebbe essere quella di ridurre la precisione dei dati di ingresso a float. Tuttavia, nessuna di queste opzioni può essere considerata una soluzione adeguata.

La specifica dell'operatore ai.onnx.ml.LinearRegressor limita la possibilità di operare completamente con i numeri double, poiché i parametri e il valore di uscita sono limitati al tipo float.

Una situazione simile si verifica con altri operatori ONNX ML, come ai.onnx.ml.SVMRegressor e ai.onnx.ml.TreeEnsembleRegressor.

Di conseguenza, tutti gli sviluppatori che utilizzano l'esecuzione di modelli ONNX in doppia precisione devono affrontare questa limitazione delle specifiche. Una soluzione potrebbe comportare l'estensione delle specifiche ONNX (o l'aggiunta di operatori simili come LinearRegressor64, SVMRegressor64 e TreeEnsembleRegressor64 con parametri e valori di uscita double). Tuttavia, al momento la questione rimane irrisolta.

Molto dipende dal convertitore ONNX. Per i modelli calcolati in double, potrebbe essere preferibile evitare l'uso di questi operatori (anche se ciò non è sempre possibile). In questo caso particolare, il convertitore ONNX non ha funzionato in modo ottimale con il modello dell'utente.

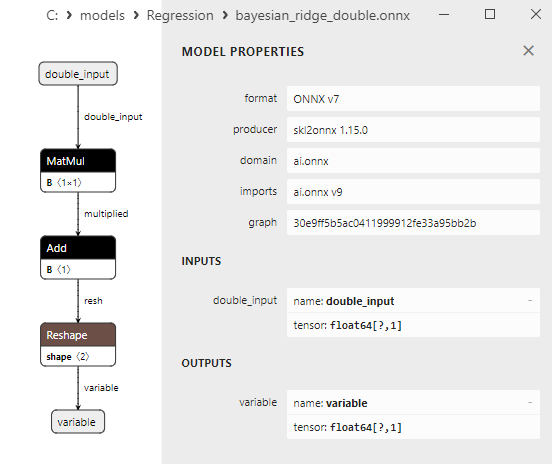

Come vedremo in seguito, il convertitore sklearn-onnx riesce ad aggirare la limitazione di LinearRegressor: per i modelli ONNX double, utilizza invece gli operatori ONNX MatMul() e Add(). Grazie a questo metodo, numerosi modelli di regressione della libreria Scikit-learn vengono convertiti con successo in modelli ONNX calcolati in double, conservando l'accuratezza dei modelli double originali.

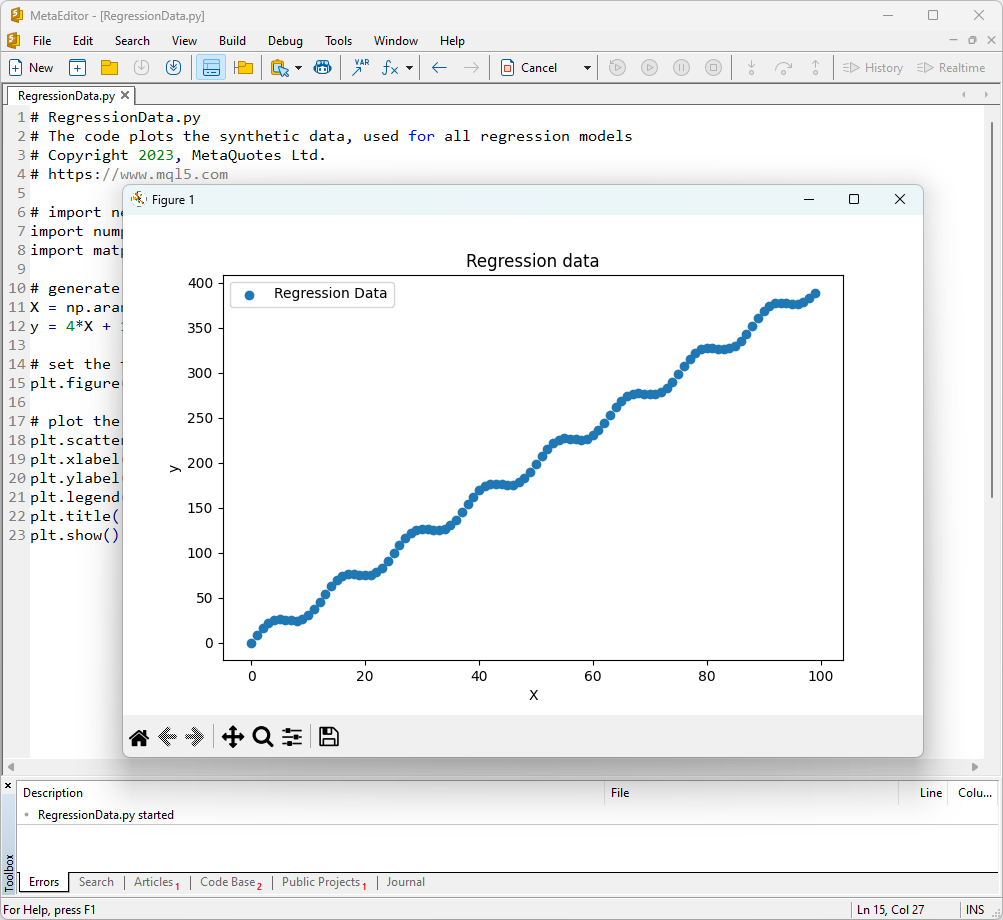

1. Set dei dati di prova

Per eseguire gli esempi, è necessario installare Python (noi abbiamo usato la versione 3.10.8), le librerie aggiuntive (pip install -U scikit-learn numpy matplotlib onnx onnxruntime skl2onnx) e specificare il percorso di Python nel MetaEditor (nel menu Strumenti->Opzioni->Compilatori->Python).

Come set di dati di prova, utilizzeremo i valori generati della funzione y = 4X + 10sin(X*0,5).

Per visualizzare il grafico di una funzione di questo tipo, aprire MetaEditor, creare un file chiamato RegressionData.py, copiare il testo dello script ed eseguirlo facendo clic sul pulsante "Compilare".

Lo script per la visualizzazione del set di dati di prova

# RegressionData.py # The code plots the synthetic data, used for all regression models # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # import necessary libraries import numpy as np import matplotlib.pyplot as plt # generate synthetic data for regression X = np.arange(0,100,1).reshape(-1,1) y = 4*X + 10*np.sin(X*0.5) # set the figure size plt.figure(figsize=(8,5)) # plot the initial data for regression plt.scatter(X, y, label='Regression Data', marker='o') plt.xlabel('X') plt.ylabel('y') plt.legend() plt.title('Regression data') plt.show()

Di conseguenza, verrà visualizzato un grafico della funzione, che verrà utilizzato per testare i metodi di regressione.

Fig.1. Funzione per testare i modelli di regressione

2. Modelli di regressione

L'obiettivo di un compito di regressione è trovare una funzione matematica o un modello che descriva al meglio la relazione tra le caratteristiche e la variabile target per prevedere i valori numerici di nuovi dati. Ciò consente di fare previsioni, ottimizzare soluzioni e prendere decisioni informate sulla base dei dati.

Consideriamo i principali modelli di regressione del pacchetto scikit-learn.

2.0. Elenco dei Modelli di Regressione di Scikit-learn

Per visualizzare un elenco dei modelli di regressione scikit-learn disponibili, è possibile utilizzare lo script:

# ScikitLearnRegressors.py # The script lists all the regression algorithms available inb scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn regression models from sklearn.utils import all_estimators regressors = all_estimators(type_filter='regressor') for index, (name, RegressorClass) in enumerate(regressors, start=1): print(f"Regressor {index}: {name}")

Output:

La versione di scikit-learn è la 1.3.2.

Regressore 1: ARDRegression

Regressore 2: AdaBoostRegressor

Regressore 3: BaggingRegressor

Regressore 4: BayesianRidge

Regressore 5: CCA

Regressore 6: DecisionTreeRegressor

Regressore 7: DummyRegressor

Regressore 8: ElasticNet

Regressore 9: ElasticNetCV

Regressore 10: ExtraTreeRegressor

Regressore 11: ExtraTreesRegressor

Regressore 12: GammaRegressor

Regressore 13: GaussianProcessRegressor

Regressore 14: GradientBoostingRegressor

Regressore 15: HistGradientBoostingRegressor

Regressore 16: HuberRegressor

Regressore 17: IsotonicRegression

Regressore 18: KNeighborsRegressor

Regressore 19: KernelRidge

Regressore 20: Lars

Regressore 21: LarsCV

Regressore 22: Lasso

Regressore 23: LassoCV

Regressore 24: LassoLars

Regressore 25: LassoLarsCV

Regressore 26: LassoLarsIC

Regressore 27: LinearRegression

Regressore 28: LinearSVR

Regressore 29: MLPRegressor

Regressore 30: MultiOutputRegressor

Regressore 31: MultiTaskElasticNet

Regressore 32: MultiTaskElasticNetCV

Regressore 33: MultiTaskLasso

Regressore 34: MultiTaskLassoCV

Regressore 35: NuSVR

Regressore 36: OrthogonalMatchingPursuit

Regressore 37: OrthogonalMatchingPursuitCV

Regressore 38: PLSCanonical

Regressore 39: PLSRegression

Regressore 40: PassiveAggressiveRegressor

Regressore 41: PoissonRegressor

Regressore 42: QuantileRegressor

Regressore 43: RANSACRegressor

Regressore 44: RadiusNeighborsRegressor

Regressore 45: RandomForestRegressor

Regressore 46: RegressorChain

Regressore 47: Ridge

Regressore 48: RidgeCV

Regressore 49: SGDRegressor

Regressore 50: SVR

Regressore 51: StackingRegressor

Regressore 52: TeilSenRegressor

Regressore 53: TransformedTargetRegressor

Regressore 54: TweedieRegressor

Regressore 55: VotingRegressor

Per comodità, in questo elenco i regressori sono evidenziati con colori diversi. I modelli che richiedono un modello di regressione base sono evidenziati in grigio, mentre gli altri modelli possono essere utilizzati indipendentemente. Notare che i modelli esportati con successo nel formato ONNX sono contrassegnati in verde, mentre i modelli che incontrano errori durante la conversione nella versione corrente di scikit-learn 1.2.2 sono contrassegnati in rosso. I metodi non adatti al compito del test considerato sono evidenziati in blu.

L'analisi della qualità della regressione utilizza metriche di regressione, che sono funzioni dei valori veri e previsti. Nel linguaggio MQL5 sono disponibili diverse metriche, descritte nell'articolo "Valutazione dei modelli ONNX utilizzando metriche di regressione".

In questo articolo verranno utilizzate tre metriche per confrontare la qualità dei diversi modelli:

- Coefficiente di determinazione R-quadro (R2);

- Errore Assoluto Medio (MAE);

- Errore Quadratico Medio (MSE).

2.1. I Modelli di Regressione Scikit-learn che convertono in modelli ONNX float e double

In questa sezione vengono presentati i modelli di regressione convertiti con successo nei formati ONNX sia con precisione float che double.

Tutti i modelli di regressione discussi in seguito sono presentati nel seguente formato:

- Descrizione del modello, principio di funzionamento, vantaggi e limitazioni

- Script Python per la creazione del modello, esportazione nel file ONNX nei formati float e double ed esecuzione dei modelli ottenuti utilizzando ONNX Runtime in Python. Metriche come R^2, MAE, MSE, calcolate con sklearn.metrics, sono utilizzate per valutare la qualità dei modelli originali e ONNX.

- Script MQL5 per l'esecuzione dei modelli ONNX (float e double) tramite ONNX Runtime, con metriche calcolate tramite RegressionMetric().

- Rappresentazione del modello ONNX in Netron per i modelli con precisione float e double.

2.1.1. sklearn.linear_model.ARDRegression

ARDRegression (Automatic Relevance Determination Regression) è un metodo di regressione progettato per risolvere i problemi di regressione determinando automaticamente l'importanza (rilevanza) delle caratteristiche e stabilendo i loro pesi durante il processo di addestramento del modello.

ARDRegression consente di individuare e utilizzare solo le caratteristiche più importanti per costruire un modello di regressione, il che può essere vantaggioso quando si ha a che fare con un ampio numero di caratteristiche.

Principio di funzionamento di ARDRegression:

- Regressione lineare: ARDRegression si basa sulla regressione lineare, ipotizzando una relazione lineare tra le variabili indipendenti (caratteristiche) e la variabile target.

- Determinazione Automatica delle Caratteristiche Importanti: La principale caratteristica di ARDRegression è la determinazione automatica di quali caratteristiche sono più importanti per la previsione della variabile target. Ciò si ottiene introducendo distribuzioni prioritarie (regolarizzazione) sui pesi, consentendo al modello di impostare automaticamente i pesi su zero per le caratteristiche meno significative.

- Stima delle Probabilità Posteriori: ARDRegression calcola le probabilità posteriori per ogni caratteristica, consentendo di determinarne l'importanza. Le caratteristiche con alte probabilità posteriori sono considerate rilevanti e ricevono pesi diversi da zero, mentre le caratteristiche con basse probabilità posteriori ricevono pesi pari a zero.

- Riduzione della Dimensionalità: Pertanto, ARDRegression può portare alla riduzione della dimensionalità dei dati eliminando le caratteristiche non significative.

Vantaggi di ARDRegression:

- Determinazione Automatica delle Caratteristiche Importanti: Il metodo identifica e utilizza automaticamente solo le caratteristiche più importanti, potenzialmente migliorando le prestazioni del modello e riducendo il rischio di overfitting.

- Resilienza alla Multicollinearità: ARDRegression gestisce bene la multicollinearità, anche quando le caratteristiche sono altamente correlate.

Limitazioni di ARDRegression:

- Richiede la Selezione delle Distribuzioni Prioritarie: La scelta di distribuzioni prioritarie adeguate potrebbe richiedere una sperimentazione.

- Complessità Computazionale: L'addestramento di ARDRegression può essere computazionalmente costoso, in particolare per i dataset di grandi dimensioni.

ARDRegression è un metodo di regressione che determina automaticamente l'importanza delle caratteristiche e stabilisce i loro pesi in base alle probabilità posteriori. Questo metodo è utile quando si considerano solo le caratteristiche significative per costruire un modello di regressione ed è necessario ridurre la dimensionalità dei dati.

2.1.1.1. Codice per la creazione del modello ARDRegression ed esportazione in ONNX per float e double

Questo codice crea il modello sklearn.linear_model.ARDRegression, lo addestra su dati sintetici, salva il modello nel formato ONNX ed esegue previsioni utilizzando dati di ingresso sia float che double. Inoltre, valuta l'accuratezza del modello originale e dei modelli esportati in ONNX.

# Il codice dimostra il processo di addestramento del modello ARDRegressor, la sua esportazione in formato ONNX (sia float che double) ed effettuare previsioni utilizzando i modelli ONNX.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# funzione per confrontare le cifre decimali corrispondenti

def compare_decimal_places(valore1, valore2):

# Convertire entrambi i valori in stringhe

str_value1 = str(value1)

str_value2 = str(value2)

# trovare le posizioni dei punti decimali nelle stringhe

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# se uno dei valori non ha un punto decimale, restituire 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calcolare il numero di cifre decimali

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# Trovare il minimo delle due cifre decimali contate

min_decimal_places = min(decimal_places1, decimal_places2)

# inizializzare un conteggio per le cifre decimali corrispondenti

matching_count = 0

# confrontare i caratteri dopo il punto decimale

for i in range(1, min_decimal_places + 1):

if str_valore1[dot_position1 + i] == str_valore2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# importare le librerie necessarie

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ARDRegressione

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# definire il percorso per il salvataggio del modello

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generare dati sintetici per la regressione

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name="ARDRegression"

onnx_model_filename = data_path + "ard_regression"

# creare un modello ARDRegression

regression_model = ARDRegression()

# Adattare il modello ai dati

regression_model.fit(X, y.ravel())

# Prevedere i valori per l'intero set di dati

y_pred = regression_model.predict(X)

# valutare le prestazioni del modello

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# Convertire in modello ONNX (float)

# definire il tipo di dati di input come FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# esportare il modello in formato ONNX

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# salvare il modello in un file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# stampare il percorso del modello

print(f"ONNX model saved to {onnx_filename}")

# caricare il modello ONNX e fare previsioni

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# visualizzare le informazioni sui tensori di input in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# visualizzare le informazioni sui tensori di output in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# definire il tipo di dati di input come FloatTensorType

initial_type_float = X.astype(np.float32)

# predire i valori per l'intero set di dati usando ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calcolare e visualizzare gli errori per i modelli originale e ONNX

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# impostare le dimensioni della figura

plt.figure(figsize=(8, 5))

# tracciare i dati originali e i dati della regressione

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convertire in modello ONNX (double)

# definire il tipo di dati di input come DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# esportare il modello in formato ONNX

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# salvare il modello in un file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# stampare il percorso del modello

print(f"ONNX model saved to {onnx_filename}")

# caricare il modello ONNX e fare previsioni

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# visualizzare le informazioni sui tensori di input in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# visualizzare le informazioni sui tensori di output in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# definire il tipo di dati di input come DoubleTensorType

initial_type_double = X.astype(np.float64)

# predire i valori per l'intero set di dati usando ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calcolare e visualizzare gli errori per i modelli originale e ONNX

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# impostare le dimensioni della figura

plt.figure(figsize=(8, 5))

# tracciare i dati originali e la linea di regressione

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

Lo script crea e addestra il modello sklearn.linear_model.ARDRegression (il modello originale è considerato double), quindi esporta il modello in ONNX per float e double (ard_regression_float.onnx e ard_regression_double.onnx) e confronta l'accuratezza del suo funzionamento.

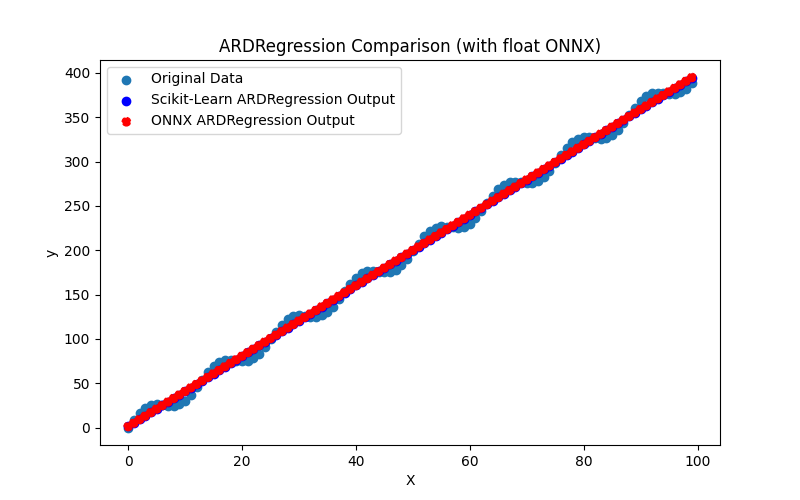

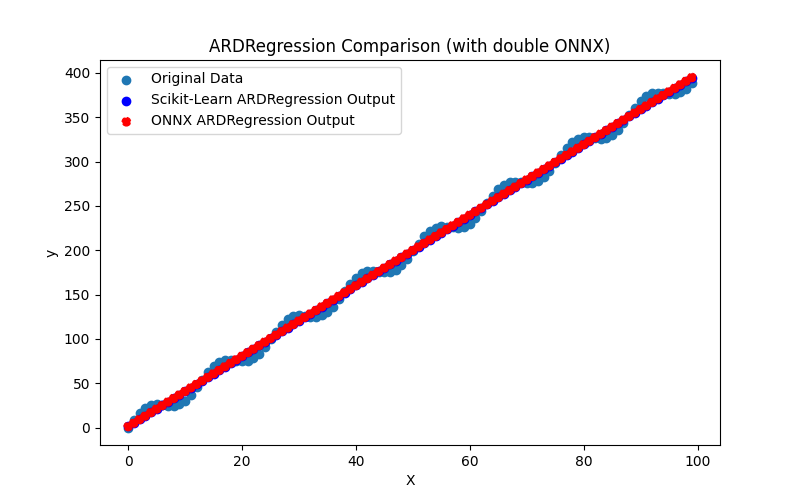

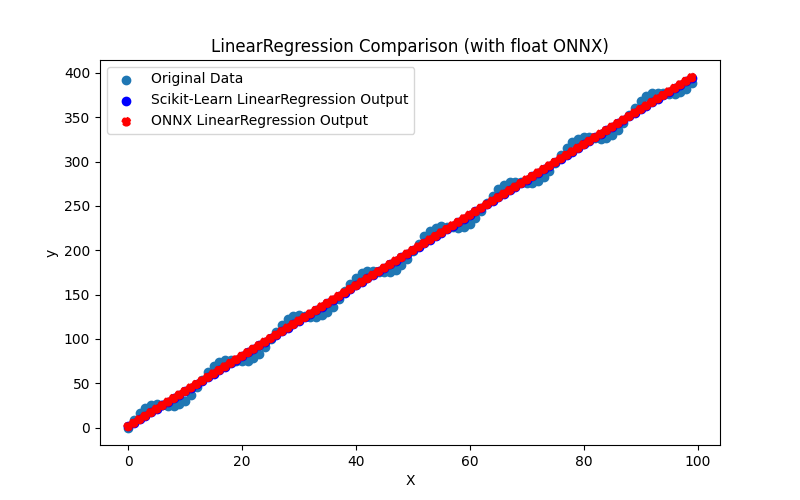

Genera anche i file ARDRegression_plot_float.png e ARDRegression_plot_double.png, che consentono una valutazione visiva dei risultati dei modelli ONNX per float e double (Fig. 2-3).

Fig.2. Risultati di ARDRegression.py (float)

Fig.3. Risultati di ARDRegression.py (double)

Visivamente, i modelli ONNX per float e double sembrano uguali (Fig. 2-3); informazioni dettagliate sono disponibili nella scheda Journal:

Python ARDRegression Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python Python ARDRegression ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python ONNX: MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python ARDRegression ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

In questo esempio, il modello originale è stato considerato double, quindi è stato esportato nei modelli ONNX ard_regression_float.onnx e ard_regression_double.onnx rispettivamente per float e double.

Se l'accuratezza del modello viene valutata in base al Mean Absolute Error (MAE), l'accuratezza del modello ONNX per float è fino a 6 cifre decimali, mentre il modello ONNX che utilizza double ha mostrato un mantenimento di precisione fino a 15 cifre decimali, in linea con la precisione del modello originale.

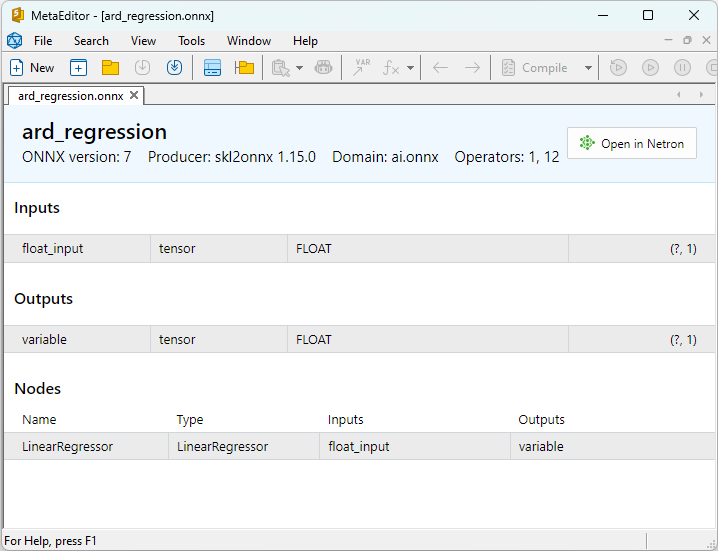

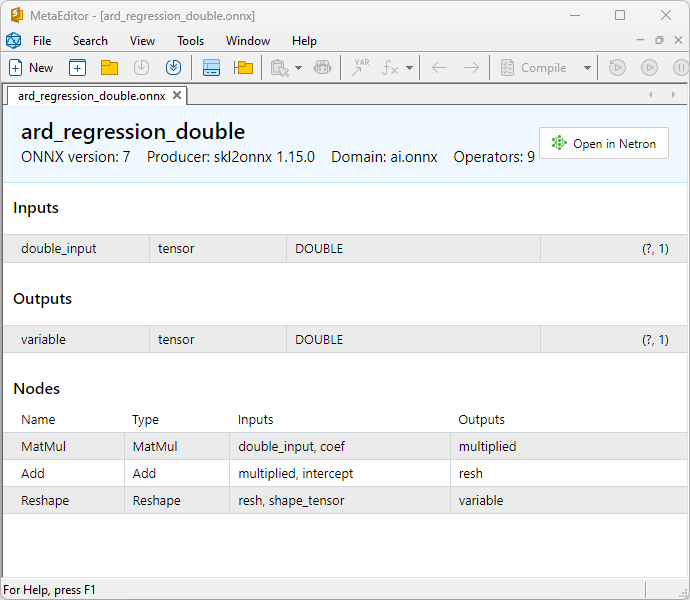

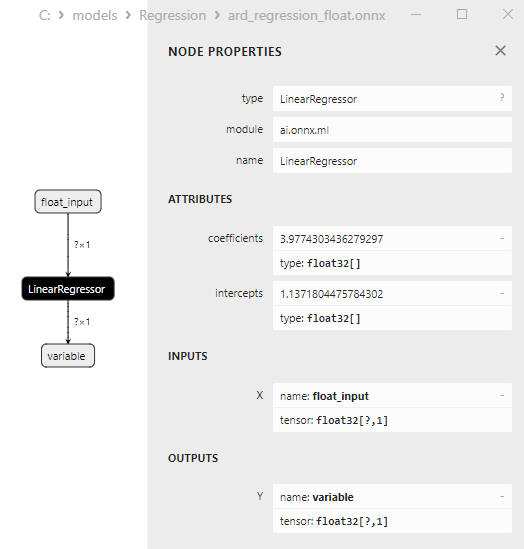

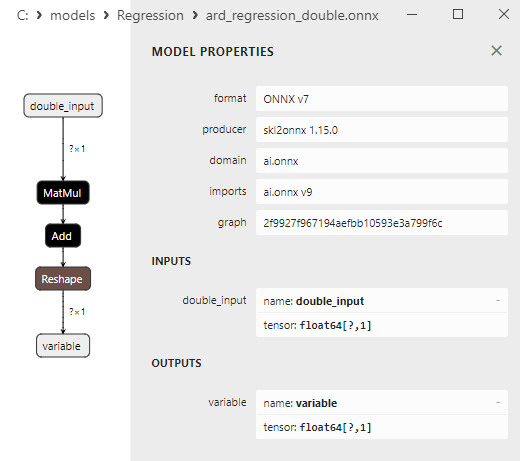

Le proprietà dei modelli ONNX possono essere visualizzate in MetaEditor (Fig. 4-5).

Fig.4. modello ONNX ard_regression_float.onnx in MetaEditor

Fig.5. modello ONNX ard_regression_double.onnx in MetaEditor

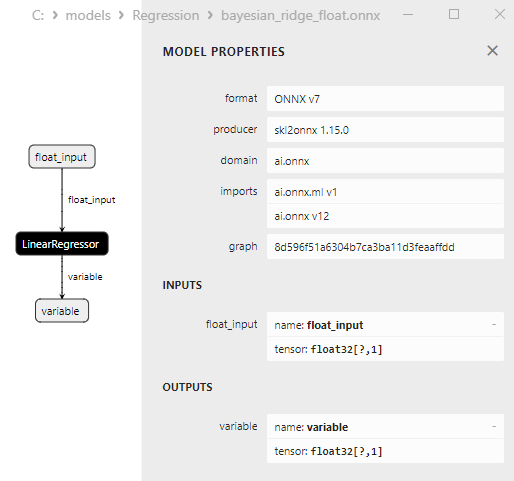

Un confronto tra modelli ONNX float e double mostra che in questo caso il calcolo dei modelli ONNX per ARDRegression avviene in modo diverso: per i numeri float si utilizza l'operatore LinearRegressor() da ONNX-ML, mentre per i numeri double si utilizzano gli operatori ONNX MatMul(), Add() e Reshape().

L'implementazione del modello in ONNX dipende dal convertitore; negli esempi per l'esportazione in ONNX, verrà utilizzata la funzione skl2onnx.convert_sklearn() della libreria skl2onnx.

2.1.1.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

Questo codice esegue i modelli salvati ONNX ard_regression_float.onnx e ard_regression_double.onnx e dimostra l'uso delle metriche di regressione in MQL5.

//+------------------------------------------------------------------+ //| ARDRegression.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "ARDRegression" #define ONNXFilenameFloat "ard_regression_float.onnx" #define ONNXFilenameDouble "ard_regression_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Output:

ARDRegression (EURUSD,H1) Testing ONNX float: ARDRegression (ard_regression_float.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 ARDRegression (EURUSD,H1) ARDRegression (EURUSD,H1) Testing ONNX double: ARDRegression (ard_regression_double.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537597 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128795

Confronto con il modello double originale in Python:

Testing ONNX float: ARDRegression (ard_regression_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: ARDRegression (ard_regression_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537597

Precisione di ONNX float MAE: 6 cifre decimali, Precisione di ONNX double MAE: 14 cifre decimali.

2.1.1.3. Le rappresentazioni ONNX dei modelli ard_regression_float.onnx e ard_regression_double.onnx

Netron (versione web) è uno strumento per la visualizzazione dei modelli e l'analisi dei grafici di calcolo, che può essere utilizzato per i modelli in formato ONNX (Open Neural Network Exchange).

Netron presenta i grafici dei modelli e la loro architettura in forma chiara e interattiva, consentendo l'esplorazione della struttura e dei parametri dei modelli di deep learning, compresi quelli creati con ONNX.

Le caratteristiche principali di Netron includono:

- Visualizzazione dei Grafici: Netron visualizza l'architettura del modello come grafico, consentendo di vedere gli strati, le operazioni e le connessioni tra loro. È possibile comprendere facilmente la struttura e il flusso di dati all'interno del modello.

- Esplorazione Interattiva: È possibile selezionare i nodi del grafico per ottenere ulteriori informazioni su ciascun operatore e sui suoi parametri.

- Supporto per Diversi Formati: Netron supporta diversi formati di modelli di deep learning, tra cui ONNX, TensorFlow, PyTorch, CoreML e altri.

- Capacità di Analisi dei Parametri: È possibile visualizzare i parametri e i pesi del modello, utili per comprendere i valori utilizzati nelle diverse parti del modello.

Netron è comodo per gli sviluppatori e i ricercatori nel campo dell'apprendimento automatico e del deep learning, in quanto semplifica la visualizzazione e l'analisi dei modelli, favorendo la comprensione e il debug di reti neurali complesse.

Questo strumento consente una rapida ispezione del modello, esplorandone la struttura e i parametri, facilitando il lavoro con le reti neurali profonde.

Per ulteriori dettagli su Netron, consultare gli articoli: Visualizzazione della rete neurale con Netron e Visualizzare Le Reti Neurali Keras con Netron.

Video su Netron::

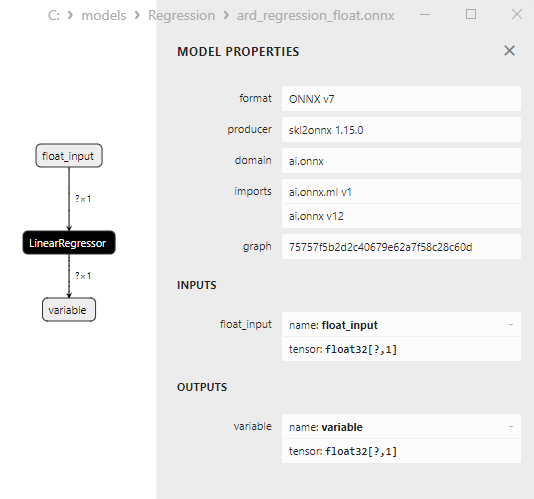

Il modello ard_regression_float.onnx è mostrato nella Fig.6:

Fig.6. Rappresentazione ONNX del modello ard_regression_float.onnx in Netron

L'operatore ONNX ai.onnx.ml LinearRegressor() fa parte dello standard ONNX e descrive un modello per compiti di regressione. Questo operatore viene utilizzato per la regressione, che prevede la previsione di valori numerici (continua) sulla base delle caratteristiche di input.

Prende in input i parametri del modello, come i pesi e il bias, insieme alle caratteristiche in ingresso, ed esegue una regressione lineare. La regressione lineare stima i parametri (pesi) per ogni caratteristica in ingresso e poi esegue una combinazione lineare di queste caratteristiche con i pesi per generare una previsione.

Questo operatore esegue le seguenti operazioni:

- Prende i pesi e i bias del modello, insieme alle caratteristiche di input.

- Per ogni esempio di dati di input, esegue una combinazione lineare dei pesi con le caratteristiche corrispondenti.

- Aggiunge il bias al valore risultante.

Il risultato è la previsione della variabile target nel compito di regressione.

I parametri di LinearRegressor() sono mostrati nella Fig.7.

Fig.7. Le proprietà dell'operatore LinearRegressor() del modello ard_regression_float.onnx in Netron

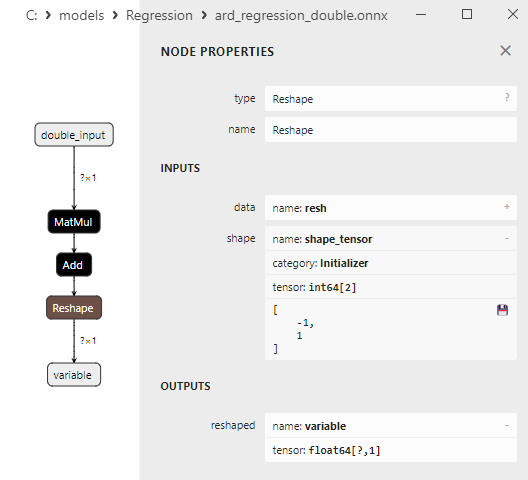

Fig.8. Rappresentazione ONNX del modello ard_regression_double.onnx in Netron

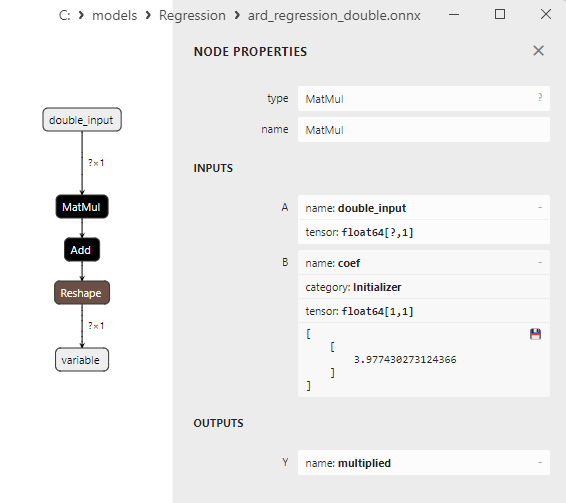

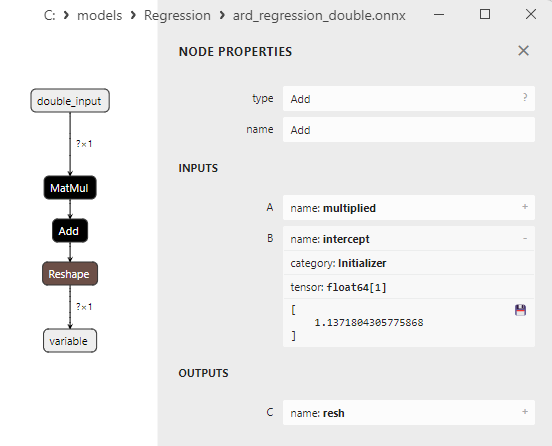

I parametri degli operatori ONNX MatMul(), Add() e Reshape() sono illustrati nella Fig.9-11.

Fig.9. Proprietà dell'operatore MatMul nel modello ard_regression_double.onnx in Netron

L’operatore ONNX MatMul (moltiplicazione matriciale) esegue la moltiplicazione di due matrici.

Richiede due input: due matrici e restituisce il loro prodotto matriciale.

Se si hanno due matrici, A e B, il risultato di Matmul(A, B) è una matrice C, in cui ogni elemento C[i][j] è calcolato come la somma dei prodotti degli elementi della riga i della matrice A per gli elementi della colonna j della matrice B.

Fig.10. Proprietà dell'operatore Add nel modello ard_regression_double.onnx in Netron

L'operatore ONNX Add() esegue l'addizione elementare di due tensori o matrici della stessa forma.

Prende due input e restituisce il risultato, dove ogni elemento del tensore risultante è uguale alla somma degli elementi corrispondenti dei tensori di input.

Fig.11. Proprietà dell'operatore Reshape nel modello ard_regression_double.onnx in Netron

L’operatore ONNX Reshape(-1,1) viene utilizzato per modificare la forma (o dimensione) dei dati di input. In questo operatore, il valore -1 per la dimensione indica che la grandezza di quella dimensione deve essere calcolata automaticamente in base alle altre dimensioni per garantire la coerenza dei dati.

Il valore 1 nella seconda dimensione specifica che, dopo la trasformazione della forma, ogni elemento avrà una singola sottodimensione.

2.1.2. sklearn.linear_model.BayesianRidge

BayesianRidge è un metodo di regressione che utilizza un approccio Bayesiano per stimare i parametri del modello. Questo metodo consente di modellare la distribuzione precedente dei parametri e di aggiornarla in base ai dati per ottenere la distribuzione posteriore dei parametri.

BayesianRidge è un metodo di regressione Bayesiano progettato per prevedere la variabile dipendente in base a una o più variabili indipendenti.

Principio di Funzionamento di BayesianRidge:

- Distribuzione prioritaria dei parametri: Si inizia con la definizione della distribuzione prioritaria dei parametri del modello. Questa distribuzione rappresenta la conoscenza preliminare o le ipotesi sui parametri del modello prima di considerare i dati. Nel caso di BayesianRidge, si utilizzano distribuzioni prioritarie di forma Gaussiana.

- Aggiornamento della distribuzione dei parametri: Una volta impostata la distribuzione prioritaria dei parametri, questa viene aggiornata in base ai dati. Questo viene fatto utilizzando la teoria Bayesiana, dove la distribuzione posteriore dei parametri viene calcolata considerando i dati. Un aspetto essenziale è la stima degli iperparametri, che influenzano la forma della distribuzione posteriore.

- Previsione: Dopo aver stimato la distribuzione posteriore dei parametri, è possibile fare previsioni per nuove osservazioni. In questo modo si ottiene una distribuzione delle previsioni piuttosto che un singolo valore puntuale, tenendo conto dell'incertezza nelle previsioni.

Vantaggi di BayesianRidge:

- Considerazione dell'incertezza: BayesianRidge tiene conto dell'incertezza dei parametri del modello e delle previsioni. Invece di previsioni puntuali, vengono forniti intervalli di affidabilità.

- Regolarizzazione: Il metodo di regressione Bayesiano può essere utile per la regolarizzazione del modello, aiutando a prevenire l'overfitting.

- Selezione automatica delle caratteristiche: BayesianRidge può determinare automaticamente le caratteristiche importanti riducendo i pesi delle caratteristiche non significative.

Limitazioni di BayesianRidge:

- Complessità computazionale: Il metodo richiede risorse computazionali per stimare i parametri e calcolare la distribuzione posteriore.

- Livello di astrazione elevato: Per comprendere e utilizzare BayesianRidge potrebbe essere necessaria una conoscenza più approfondita della statistica bayesiana.

- Non sempre è la scelta migliore: Il metodo BayesianRidge può non essere il più adatto in alcuni compiti di regressione, in particolare quando si tratta di dati limitati.

BayesianRidge è utile nei compiti di regressione in cui l'incertezza dei parametri e delle previsioni è importante e nei casi in cui è necessaria la regolarizzazione del modello.

2.1.2.1. Codice per la creazione del modello BayesianRidge ed esportazione in ONNX per float e double

Questo codice crea il modello sklearn.linear_model.BayesianRidge, lo addestra su dati sintetici, salva il modello nel formato ONNX ed esegue previsioni utilizzando dati di input sia float che double. Inoltre, valuta l'accuratezza del modello originale e dei modelli esportati in ONNX.

# Il codice dimostra il processo di addestramento del modello BayesianRidge, l'esportazione in formato ONNX (sia float che double) e l'elaborazione di previsioni utilizzando i modelli ONNX.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# funzione per confrontare le cifre decimali corrispondenti

def compare_decimal_places(valore1, valore2):

# Convertire entrambi i valori in stringhe

str_value1 = str(value1)

str_value2 = str(value2)

# trovare le posizioni dei punti decimali nelle stringhe

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# se uno dei valori non ha un punto decimale, restituire 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calcolare il numero di cifre decimali

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# Trovare il minimo delle due cifre decimali contate

min_decimal_places = min(decimal_places1, decimal_places2)

# inizializzare un conteggio per le cifre decimali corrispondenti

matching_count = 0

# confrontare i caratteri dopo il punto decimale

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# importare le librerie necessarie

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import BayesianRidge

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# definire il percorso per il salvataggio del modello

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generare dati sintetici per la regressione

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name = "BayesianRidge"

onnx_model_filename = data_path + "bayesian_ridge"

# creare un modello di regressione Bayesian Ridge

regression_model = BayesianRidge()

# Adattare il modello ai dati

regression_model.fit(X, y.ravel())

# Prevedere i valori per l'intero set di dati

y_pred = regression_model.predict(X)

# valutare le prestazioni del modello

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# Convertire in modello ONNX (float)

# definire il tipo di dati di input come FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# esportare il modello in formato ONNX

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# salvare il modello in un file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# stampare il percorso del modello

print(f"ONNX model saved to {onnx_filename}")

# caricare il modello ONNX e fare previsioni

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# visualizzare le informazioni sui tensori di input in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# visualizzare le informazioni sui tensori di output in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# definire il tipo di dati di input come FloatTensorType

initial_type_float = X.astype(np.float32)

# prevedere i valori per l'intero set di dati usando ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calcolare e visualizzare gli errori per i modelli originale e ONNX

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# impostare le dimensioni della figura

plt.figure(figsize=(8,5))

# tracciare i dati originali e i dati della regressione

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convertire in modello ONNX (double)

# definire il tipo di dati di input come DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# esportare il modello in formato ONNX

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# salvare il modello in un file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# stampare il percorso del modello

print(f"ONNX model saved to {onnx_filename}")

# caricare il modello ONNX e fare previsioni

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# visualizzare le informazioni sui tensori di input in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# visualizzare le informazioni sui tensori di output in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# definire il tipo di dati di input come DoubleTensorType

initial_type_double = X.astype(np.float64)

# prevedere i valori per l'intero set di dati usando ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calcolare e visualizzare gli errori per i modelli originale e ONNX

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# impostare le dimensioni della figura

plt.figure(figsize=(8,5))

# tracciare i dati originali e la linea di regressione

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

Output:

Python BayesianRidge Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python Python BayesianRidge ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python BayesianRidge ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

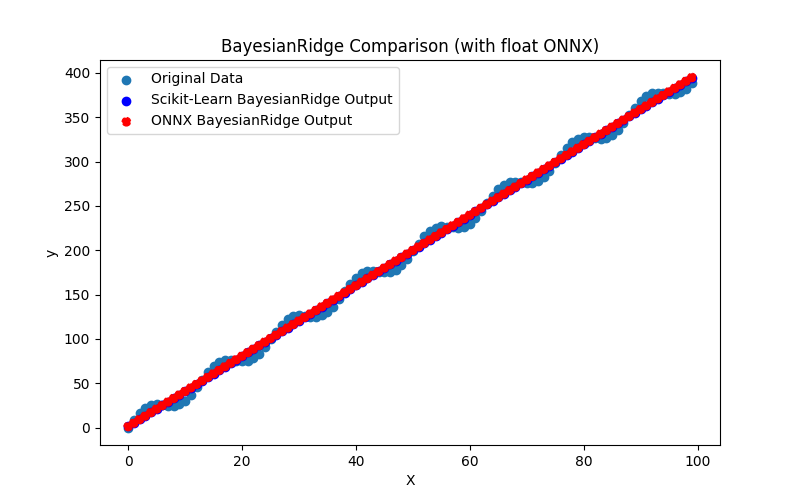

Fig.12. Risultati di BayesianRidge.py (float ONNX)

2.1.2.2. Codice MQL5 per l'esecuzione dei Modelli ONNX

Questo codice esegue i modelli ONNX bayesian_ridge_float.onnx e bayesian_ridge_double.onnx salvati e dimostra l'uso delle metriche di regressione in MQL5.