Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

Если смотреть на картинку, то да, тёплое с мягким, а в коде всё норм.

Скобки на картинке не правильно. Надо так.

Ола ке таль. Решил подкинуть свои идеи.

Моя последняя модель - собрать нормализованные цены 10 символов и так обучать рекуррентной сетью. На вход по 20 баров месяца, недели и дня.

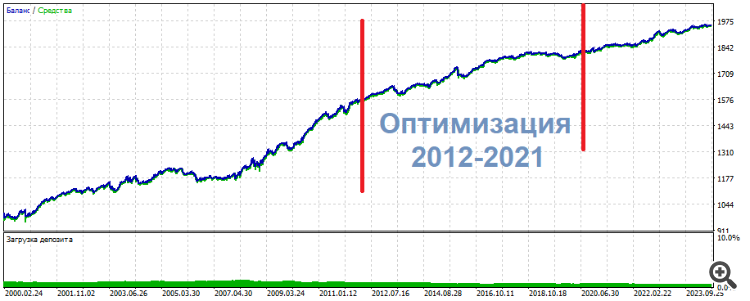

Вот такая картинка получается. Отличие от отдельных обучений в том, что общая прибыль меньше в 3 раза и просадка... вау, просадка на контрольном периоде едва дотягивает до 1%.

По-моему, это решает проблему дефицита данных.

Ола ке таль. Решил подкинуть свои идеи.

Моя последняя модель - собрать нормализованные цены 10 символов и так обучать рекуррентной сетью. На вход по 20 баров месяца, недели и дня.

Вот такая картинка получается. Отличие от отдельных обучений в том, что общая прибыль меньше в 3 раза и просадка... вау, просадка на контрольном периоде едва дотягивает до 1%.

По-моему, это решает проблему дефицита данных.

Мне кажется у вас крайне высокий уровень владения темой. Боюсь не понять ничего.

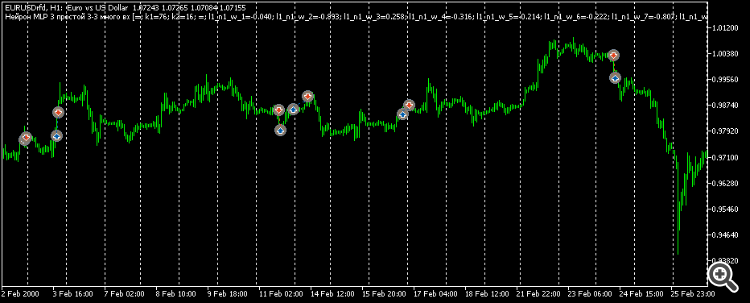

Расскажите, пожалуйста, что это за красота на графике: это Питон? Архитектура LSTM?

Возможно подобное показать на МТ5?

нормализованные цены 10 символов

Что такое "ante"

В общем, всё, что не является коммерческой тайной, поделитесь, пожалуйста)

Мне кажется у вас крайне высокий уровень владения темой. Боюсь не понять ничего.

Расскажите, пожалуйста, что это за красота на графике: это Питон? Архитектура LSTM?

Возможно подобное показать на МТ5?

Здесь тоже, как нормализовали цены.Что такое "ante"

В общем, всё, что не является коммерческой тайной, поделитесь, пожалуйста)

Конечно, это пайтон. В мкл5 чтобы выбрать данные по условию, нужно перебор делать и все эти иф иф иф. А в пайтоне в одну строку по любым условиям выбор данных. Я уже не говорю по скорость работы. Это слишком удобно. Мкл5 нужен, чтобы открывать сделки с готовой сетью.

Нормализация самая обычная. Минус среднее, разделить на стандартное отклонение. Коммерческая тайна здесь - это период нормализации, важно так подойти, чтобы цены в течение 10 лет вокруг ноля были. Но не так, чтобы в начале 10 лет они ниже ноля, а в конце выше. Так сравнивать не получится...

Два периода проверки - анте и тест. Анте до обучения период 6 месяцев. Очень удобно. Анте всегда есть. А тест - это будущее, его нет. То есть оно есть, но только в прошлом. А в будущем нет. То есть то нет.

Что, по-Вашему, важнее: архитектура или входные данные?

Что, по-Вашему, важнее: архитектура или входные данные?

Думаю входы. Вот я пробую 6 символов, а не 10. И я не прохожу контрольный период август-декабрь 2023. По отдельности, тоже сложно. А 10 символов проходной вариант можно закономерно выбрать по результатам обучения. Сеть всегда рекуррентная в 1 слой 32 состония, полносвязная только привыкает.

Некоторые итоги:

Но нейросеть оказалась не нужна. Ни MLP, ни RNN, ни LSTM, ни BiLSTM, ни CNN, ни Q-обучение, ни всё это вместе взятое-перемешанное.

В одном из таких экспериментов оптимизировал 2 входа на 3-х нейронах. В результате один из верхних сетов показал следующую картину

**********************

UPD

Вот ещё один сет, тоже самое: середина - оптимизация, результаты - по бокам. Почти одинаковые, просто поровнее

**********************

Сделки – не пипсовки и не скальп. Скорее интрадей.

Таким образом, мои субъективные выводы на текущий момент:

Как слегка ослепнуть зрячему. Только что он видел чёткий силуэт, а сейчас непойми что - какая-то мазня в глазах. Информации - 0.

Моё имхо, как вижу

Нейросеть применима только к стационарным, статичным паттернам, которые не имеют отношения к ценообразованию

Какую делаете предобработку, нормализацию? Пробовали стандартизацию делать?

Нейросеть запоминает путь. Не более

Попробуйте трансформеры, говорят в них есть толк...

ОСЦИЛЛЯТОРЫ - ЗЛО!

Ну не всё так однозначно. Просто НС удобно работать с непрерывными функциями, а нужна архитектура, которая будет работать с кусочными/интервальными функциями, тогда НС сможет брать диапазоны осциллятора, как значимую информацию.

Какую делаете предобработку, нормализацию? Пробовали стандартизацию делать?

Попробуйте трансформеры, говорят в них есть толк...

Ну не всё так однозначно. Просто НС удобно работать с непрерывными функциями, а нужна архитектура, которая будет работать с кусочными/интервальными функциями, тогда НС сможет брать диапазоны осциллятора, как значимую информацию.

1. А когда как: если окно данных, каких-нибудь приращений, то привожу в диапазон -1..1. Про стандартизацию не слышал

2. Принял, благодарю

3. Согласен, у меня нет полного док-ва обратного. Поэтому пишу со своей колокольни, как пока вижу и представляю примерно.

Просто сглаживание - это фактическое стирание информации. Не обобщение. Стирание именно. Просто вспомните фотографию: как только ухудшить её содержимое - всё, информация безвозвратно потеряна. И воостановление оной с помощью ИИ - это ведь художественная деятельность, не восстановление в истинном смысле. Произвольное дорисовывание. "Додумывание".

Сглаживание: когда у нас одно число является результатом двух независимых информационных единиц: паттерна -1/1,допустим, и паттерна -6/6. Среднее значение у каждого будет одинаковое, а паттерна то исходно - было два. Они могут что-то означать, а могут не означать, могут означать противоположные сигналы. И вот машки, осциляторы и так далее - они просто тупо стирают/размывают исходную "фотографию" рынка.

И в этой "мазне" мы кошмарим НС, заставляя её бесконечно пытаться работать как надо.

Обобщение и сглаживание - это крайне недружественные неоднородные явления.

Некоторые итоги:

Но нейросеть оказалась не нужна. Ни MLP, ни RNN, ни LSTM, ни BiLSTM, ни CNN, ни Q-обучение, ни всё это вместе взятое-перемешанное.

В одном из таких экспериментов оптимизировал 2 входа на 3-х нейронах. В результате один из верхних сетов показал следующую картину

**********************

UPD

Вот ещё один сет, тоже самое: середина - оптимизация, результаты - по бокам. Почти одинаковые, просто поровнее

**********************

Сделки – не пипсовки и не скальп. Скорее интрадей.

Таким образом, мои субъективные выводы на текущий момент:

Как слегка ослепнуть зрячему. Только что он видел чёткий силуэт, а сейчас непойми что - какая-то мазня в глазах. Информации - 0.

Моё имхо, как вижу

не слабая пипсовка

пора шить мешки?