トレーディングにおける機械学習:理論、モデル、実践、アルゴトレーディング - ページ 743 1...736737738739740741742743744745746747748749750...3399 新しいコメント Slasher111 2018.03.14 11:51 #7421 ミハイル・マルキュカイツすべてのデータをミックスすることで、幸運な偶然の秩序ではなく、この集合から本当の可能性を引き出そうとしているのです。だから、データをシャッフルすると、本当にデータができることが見えてくる......。それで... 要は、トレーニングとテストを時間的に切り離さないと、モデルがオーバーフィットしてしまうということです。大げさですが、例として、変換を行わない絶対増分を予測因子として使用した場合を挙げます。幅15のスライディングウィンドウを使用し,すなわち,15個の予測変数の増分を与えるたびに,値を1つ右にシフトさ せる.つまり、n番目の文字列がクラス1なら、n+1番目の文字列もクラス1である可能性が非常に高い。 文字列は互いにわずかに異なるだけで、n+1番目の文字列は1つの値だけ異なる。一致する値は14個です。つまり、そのようなデータセットから最初の行をtrainに、2番目の行をtestに、3番目の行をtrainに、などとすると、trainでモデルが学習した値と実際に一致する行がtestにたくさんあるので、モデルが非常にうまく機能することになるのです。モデルのOOSだけクソになる(テストを含まない本当のOOSという意味なら)。 СанСаныч Фоменко 2018.03.14 12:09 #7422 ウラジミール・ペレヴェンコモデルを使った予測変数の推定に関しては、RandomUniformForestが最も先進的なパッケージだと思います。この本では、さまざまな視点から予測因子の重要性を詳細に扱っています。一度見てみることをお勧めします。ある記事で、その詳細を紹介しました。 予測因子のモデル選択を拒否した。使用する機種の仕様に限定される。 グッドラック私は、モデルを構築するための最も「便利な」予測変数は、ターゲット変数とほとんど関係がないものであると信じているからです。そのような予測変数では常に「便利な」値を見つけることができ、最終的に予測変数の重要性は、モデルを構築するときの「便利さ」を反映します。 私はいつも予測能力について書いていますが、その影響は...。ターゲット変数に対する予測変数のその一つが上記(相互情報)であり、これについては私も何度も考えを述べています。これらは数学的な発想である。それよりも経済的なアイデアの方がずっと効果的です。なぜなら、そこではターゲットとなる変数に対して、先行して予測因子を選ぶことができるからです。 もう一度言いますが、私はモデルに対する変数の重要性に興味があるのではなく、ターゲット変数に対する予測変数の影響に興味があるのです。 PS. 推奨パッケージも確認しました。 СанСаныч Фоменко 2018.03.14 12:28 #7423 Slasher111 です。 要は、時間によってtrainとtestを分けないと、モデルがオーバーフィットしてしまうということです。大げさですが、例として、絶対増分を予測因子とし、変換を行わない場合を考えてみます。幅15のスライディングウィンドウを使用し,すなわち,15個の予測変数の増分を与えるたびに,値を1つ右にシフトさ せる.つまり、n番目の文字列がクラス1なら、n+1番目の文字列もクラス1である可能性が高い。 文字列は互いにわずかに異なるだけで、n+1番目の文字列は1つの値だけ異なる。一致する値は14個です。つまり、そのようなデータセットから最初の行をtrainに、2番目の行をtestに、3番目の行をtrainに、などとすると、trainでモデルが学習した値と実際に一致する行がtestにたくさんあるので、モデルが非常にうまくいくのです。モデルのOOSだけクソになる(テストを含まない本当のOOSという意味なら)。それはとても良い指摘ですね。上に掲載した、学習テストや検証のためのランダムサンプリングについての驚くべき、至高の結果は、まさにそれを説明するものです。また、偶然にも異なるセットに入っていた近接観測を除外すると、私のようにすべてが台無しになってしまいます。 Maxim Dmitrievsky 2018.03.14 12:33 #7424 ミハイル・マルキュカイツ2018.01.31から現在まで獲得しているモデルが届いたと言ったことを思い出して、このモデルが2018.03.05から現在までのこの2週間、どのようなパフォーマンスを見せてくれたかを紹介します。テスターの結果 40点満点で訓練して、1ヶ月半ほどOOSしているおばさんには、かなりいい感じです。 そして、これが2018.01.31からの彼女のフルOOSです。 それでも合ってると思うのか?スクリーンショットにはOOSの部分が写っているので、念のため。通常のバックテストはどうなっているのですか? 毎週月曜日に買うとか、簡単なことをやって、相場が上がってくると自分よりうまくいくことに驚けばいいのです。 Anatolii Zainchkovskii 2018.03.14 12:37 #7425 オーバートレーニングがないか、サンプル自体に誤りがないか、すべてをチェックするわけですが、もちろん統計学やアルゴリズムが何をするのかを理解する上では興味深いことです。私のテストでは半々になってしまいましたが、mooseがprofitより少ないクラスでターゲット変数を設定したため、テストではかなりスムーズに成長しています。ちなみに、テストではソリッドフォワードだけで、機械は取引開始前のデータで学習させました......。付け加えると、最も重要なのは入力予測因子とその数、そして対象を記述する真の能力である。 これは写真です。 transcendreamer 2018.03.14 12:39 #7426 議論されているアプローチの多くは、ひどく時代遅れで、1980年代には適切だったのですが...。 transcendreamer 2018.03.14 12:40 #7427 アナトリー・ザイニチコフスキーオーバートレーニングがないか、サンプル自体に誤りがないか、すべてをチェックするわけですが、統計学やアルゴリズムが何をしているかを理解する上ではもちろん面白いことです。私のテストでは半々になってしまいましたが、mooseがprofitより少ないクラスでターゲット変数を設定したため、テストではかなりスムーズに成長しています。ちなみに、テストではソリッドフォワードだけで、機械は取引開始前のデータで学習させました...。最も重要なのは、入力予測因子、その数、そして対象を記述する真の能力であることを付け加えておく。しかし、再トレーニングは非常に重要です。例えば、ブースティング(勾配の森)では、大きな成功を収めたモデルがあっても、将来的には役に立たないことがありますが、それはあなた自身が知っていることです。 transcendreamer 2018.03.14 12:41 #7428 予測変数の選択は 重要ですが、足場はそれらの間の関係因子をどのようにモデル化すればよいかを知らないので、ダムフィットとなり、変数の関係という形でバリエーションをつけた巧妙なモデル化は、残念ながら非常に時間がかかるのです Anatolii Zainchkovskii 2018.03.14 12:42 #7429 トランスセンドリーマー再トレーニングはまだ重要な点で、例えばブースティング(グラディエントフォレスト)では、見事なモデルを得ることができますが、フォワードではフェードアウトしてしまいますが、それはあなた自身が知っていることです。一生使い続けろとは言わない、鍛えなおしてまた行ける時期がある))) Maxim Dmitrievsky 2018.03.15 03:35 #7430 トランスセンドリーマー 予測変数の選択は重要ですが、森はそれらの間の関係因子をどのようにモデル化すればよいかわからないので、ダムフィットになり、変数の関係という形でバリエーションを持ったスマートなモデル化は残念ながら非常に時間のかかることですそして、これらの接続は数学的に見つけることができないので、ダムフィッティングや市場調査を行う必要があります :) バカなフィッティングも、実は一般化が進めばカッコよくなる。 1...736737738739740741742743744745746747748749750...3399 新しいコメント 取引の機会を逃しています。 無料取引アプリ 8千を超えるシグナルをコピー 金融ニュースで金融マーケットを探索 新規登録 ログイン スペースを含まないラテン文字 このメールにパスワードが送信されます エラーが発生しました Googleでログイン WebサイトポリシーおよびMQL5.COM利用規約に同意します。 新規登録 MQL5.com WebサイトへのログインにCookieの使用を許可します。 ログインするには、ブラウザで必要な設定を有効にしてください。 ログイン/パスワードをお忘れですか? Googleでログイン

すべてのデータをミックスすることで、幸運な偶然の秩序ではなく、この集合から本当の可能性を引き出そうとしているのです。だから、データをシャッフルすると、本当にデータができることが見えてくる......。それで...

モデルを使った予測変数の推定に関しては、RandomUniformForestが最も先進的なパッケージだと思います。この本では、さまざまな視点から予測因子の重要性を詳細に扱っています。一度見てみることをお勧めします。ある記事で、その詳細を紹介しました。

予測因子のモデル選択を拒否した。使用する機種の仕様に限定される。

グッドラック

私は、モデルを構築するための最も「便利な」予測変数は、ターゲット変数とほとんど関係がないものであると信じているからです。そのような予測変数では常に「便利な」値を見つけることができ、最終的に予測変数の重要性は、モデルを構築するときの「便利さ」を反映します。

私はいつも予測能力について書いていますが、その影響は...。ターゲット変数に対する予測変数のその一つが上記(相互情報)であり、これについては私も何度も考えを述べています。これらは数学的な発想である。それよりも経済的なアイデアの方がずっと効果的です。なぜなら、そこではターゲットとなる変数に対して、先行して予測因子を選ぶことができるからです。

もう一度言いますが、私はモデルに対する変数の重要性に興味があるのではなく、ターゲット変数に対する予測変数の影響に興味があるのです。

PS.

推奨パッケージも確認しました。

要は、時間によってtrainとtestを分けないと、モデルがオーバーフィットしてしまうということです。大げさですが、例として、絶対増分を予測因子とし、変換を行わない場合を考えてみます。幅15のスライディングウィンドウを使用し,すなわち,15個の予測変数の増分を与えるたびに,値を1つ右にシフトさ せる.つまり、n番目の文字列がクラス1なら、n+1番目の文字列もクラス1である可能性が高い。 文字列は互いにわずかに異なるだけで、n+1番目の文字列は1つの値だけ異なる。一致する値は14個です。つまり、そのようなデータセットから最初の行をtrainに、2番目の行をtestに、3番目の行をtrainに、などとすると、trainでモデルが学習した値と実際に一致する行がtestにたくさんあるので、モデルが非常にうまくいくのです。モデルのOOSだけクソになる(テストを含まない本当のOOSという意味なら)。

それはとても良い指摘ですね。上に掲載した、学習テストや検証のためのランダムサンプリングについての驚くべき、至高の結果は、まさにそれを説明するものです。また、偶然にも異なるセットに入っていた近接観測を除外すると、私のようにすべてが台無しになってしまいます。

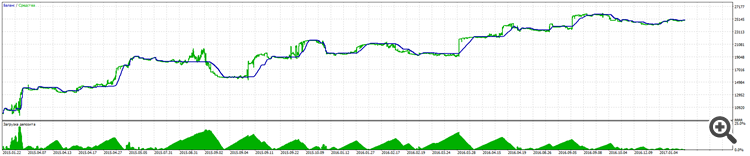

2018.01.31から現在まで獲得しているモデルが届いたと言ったことを思い出して、このモデルが2018.03.05から現在までのこの2週間、どのようなパフォーマンスを見せてくれたかを紹介します。テスターの結果

40点満点で訓練して、1ヶ月半ほどOOSしているおばさんには、かなりいい感じです。

そして、これが2018.01.31からの彼女のフルOOSです。

それでも合ってると思うのか?スクリーンショットにはOOSの部分が写っているので、念のため。

通常のバックテストはどうなっているのですか?

毎週月曜日に買うとか、簡単なことをやって、相場が上がってくると自分よりうまくいくことに驚けばいいのです。

オーバートレーニングがないか、サンプル自体に誤りがないか、すべてをチェックするわけですが、もちろん統計学やアルゴリズムが何をするのかを理解する上では興味深いことです。私のテストでは半々になってしまいましたが、mooseがprofitより少ないクラスでターゲット変数を設定したため、テストではかなりスムーズに成長しています。ちなみに、テストではソリッドフォワードだけで、機械は取引開始前のデータで学習させました......。付け加えると、最も重要なのは入力予測因子とその数、そして対象を記述する真の能力である。

これは写真です。

オーバートレーニングがないか、サンプル自体に誤りがないか、すべてをチェックするわけですが、統計学やアルゴリズムが何をしているかを理解する上ではもちろん面白いことです。私のテストでは半々になってしまいましたが、mooseがprofitより少ないクラスでターゲット変数を設定したため、テストではかなりスムーズに成長しています。ちなみに、テストではソリッドフォワードだけで、機械は取引開始前のデータで学習させました...。最も重要なのは、入力予測因子、その数、そして対象を記述する真の能力であることを付け加えておく。

しかし、再トレーニングは非常に重要です。例えば、ブースティング(勾配の森)では、大きな成功を収めたモデルがあっても、将来的には役に立たないことがありますが、それはあなた自身が知っていることです。

再トレーニングはまだ重要な点で、例えばブースティング(グラディエントフォレスト)では、見事なモデルを得ることができますが、フォワードではフェードアウトしてしまいますが、それはあなた自身が知っていることです。

一生使い続けろとは言わない、鍛えなおしてまた行ける時期がある)))

予測変数の選択は重要ですが、森はそれらの間の関係因子をどのようにモデル化すればよいかわからないので、ダムフィットになり、変数の関係という形でバリエーションを持ったスマートなモデル化は残念ながら非常に時間のかかることです

そして、これらの接続は数学的に見つけることができないので、ダムフィッティングや市場調査を行う必要があります :)

バカなフィッティングも、実は一般化が進めばカッコよくなる。