Statistiche di dipendenza nelle citazioni (teoria dell'informazione, correlazione e altri metodi di selezione delle caratteristiche) - pagina 15

Ti stai perdendo delle opportunità di trading:

- App di trading gratuite

- Oltre 8.000 segnali per il copy trading

- Notizie economiche per esplorare i mercati finanziari

Registrazione

Accedi

Accetti la politica del sito e le condizioni d’uso

Se non hai un account, registrati

Le persone che hanno EViews non fanno queste domande, hee-hee

Sarebbe così gentile da mandarmi, privatamente o qui, EViews, se possibile?

Le persone che hanno EViews non fanno queste domande, heehee

Beh sì, è una domanda stupida, sono d'accordo. Le garanzie sono le stesse del modello stesso.

Che versione avete? Dicono che il 5 è superato.

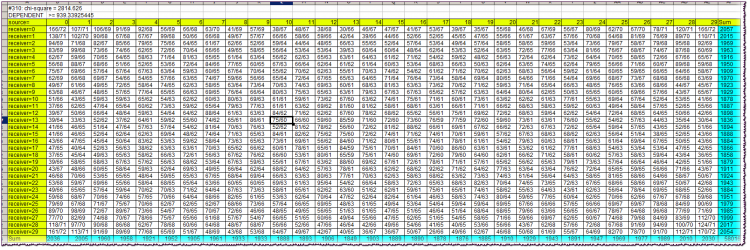

Prima linea del blocco: #310: chi-quadro = 2814.626Prima - il valore della variabile Lag. Poi il valore chi-quadro dell'indipendenza delle variabili.

Seconda riga: conclusione di dipendenza/indipendenza, insieme al valore limite del chi-quadro.

Le celle gialle nella tabella sono dei tappi. Permettono di orientare quali caratteri dell'alfabeto sono stati osservati simultaneamente all'intersezione della riga e della colonna corrispondenti. Ricordiamo che gli alfabeti alla fonte e al ricevitore sono identici e uguali ai quantili in cui sono caduti i rendimenti delle barre corrispondenti (fonte e ricevitore).

Per esempio, all'intersezione della colonna source=10 e della riga receiver=13 troviamo un valore di cella di 75/60. Ciò significa che la combinazione "il ritorno della fonte (barra nel passato) catturato nel 10° quantile e il ritorno del ricevitore (barra più vicina al presente) catturato nel 13° quantile" è stata osservata 75 volte nella storia, con il numero teorico di tali combinazioni che sarebbe 60 se fossero indipendenti.

Le celle turchesi sono le somme delle frequenze effettive per riga o colonna necessarie per calcolare il chi-quadrato.

Il chi-quadrato stesso nel caso dell'indipendenza della fonte e del ricevitore dovrebbe essere quasi sempre più piccolo di quello limite, cioè specificato nella seconda riga del blocco. Come possiamo vedere, è molto più grande, quasi 3 volte più grande. Questo indica una dipendenza da barre molto forte in questo caso.

L'intero file, anche archiviato, richiede troppo spazio, quindi non posso postarlo qui.

Beh sì, è una domanda stupida, sono d'accordo. Le garanzie sono le stesse del modello stesso.

Che versione stai usando? Dicono che il 5 è superato.

C'è la definizione di Shannon dell'entropia, in cui l'indipendenza è obbligatoria.

E c'è una definizione di informazione reciproca, in cui la definizione di Shannon è applicata in modo puramente formale, poiché si suppone ancora che esistano delle dipendenze.

Se volete scavare nelle profondità filosofiche e nelle contraddizioni della definizione di informazione reciproca - per favore, scavate. Preferirei non preoccuparmene e usare semplicemente la formula "americana" con le probabilità, senza preoccuparmi dell'indipendenza.

Un po' un termine improprio. La traduzione dei significati di bark..., TI è la seguente. Esiste un concetto di entropia. Bisogna capire chiaramente che dietro questa bella e incomprensibile parola straniera c'è una figura inventata artificialmente. Nei libri di testo, quelli che sono più onesti, è scritto direttamente così, una misura di incertezza introdotta assiomaticamente. Come si scopre è in realtà una convoluzione. In parole povere, una grande tabella che descrive gli stati e le loro frequenze, con l'aiuto di formule aritmetiche sono convolute in un numero. Inoltre, solo le frequenze sono arrotolate, e gli stati stessi (che, tra l'altro, possono anche avere le loro misure) sono interessanti solo dal punto di vista del loro numero totale.

In ter.faith c'è un'operazione simile, più o meno, i sistemi mo sono contati in modo simile. Ma solo lì si moltiplicano le probabilità degli stati con le loro misure, si sommano e si ottiene una cifra, sulla quale poi si dimostrano i teoremi sulla convergenza, ecc. Qui non è così. Qui la frequenza stessa (chiamata probabilità), o piuttosto il suo logaritmo, agisce come misura. Il logaritmo risolve alcuni problemi aritmetici che Shannon ha formulato in tre condizioni (deve crescere monotonicamente, ecc.).

Dopo di che, Shannon dice: -Amici, sapete, ho trovato delle regole ragionevoli e ovvie su come si possono sommare i numeri che ho scoperto recentemente, che chiamo entropia, da due tabulazioni diverse. Gli amici (per lo più militari) chiedono: - Bene, come fai? - Molto semplicemente. - Shannon risponde loro, facendo lampeggiare i suoi occhi. - Diciamo che un piatto non è collegato ad un altro, sono indipendenti, succede nella vita. E in questo caso ho un teorema sull'addizione delle entropie, con un risultato meraviglioso - i numeri semplicemente si sommano! - Bene, ma se le piastre sono collegate in qualche modo incomprensibile? - Qui è lo stesso semplice, costruire una grande tabella quadrata dalle due tabelle iniziali, moltiplicare le probabilità in ogni cella. Sommiamo i numeri nelle celle per colonne, sommiamo le colonne separatamente, costruiamo una nuova tabella, dividiamo uno per l'altro, qui presto zero, qui pesce avvolto... Ops, il risultato è un numero, che io chiamo entropia condizionata! Ciò che è interessante, l'entropia condizionale può essere calcolata sia dalla prima tabella alla seconda, che viceversa! E per tenere conto di questa sfortunata dualità, ho inventato l'entropia reciproca totale, ed è la stessa cifra! - E così, - chiedono gli amici, sgranocchiando pop-corn, - è molto più facile confrontare una cifra con un'altra, che capire l'essenza dei dati dalle tabelle originali. Ed è ancora più facile quando si tratta di capire i significati e l'affidabilità delle relazioni - è noioso, davvero. Tenda.

Ecco come si presenta una breve storia di TI per me. Compilato dalle mie ricerche e dalle affermazioni di un dizionario accademico (vedi citazioni precedenti).

Ora, ciò che è importante. Il punto chiave di tutta questa storia è nascosto nell'entropia condizionata. Infatti, se si vuole operare con una cifra, non è necessario contare alcuna informazione reciproca e altre cose, è sufficiente padroneggiare il metodo di calcolo dell'entropia condizionata. È questo che darà una certa misura dell'interrelazione dell'uno con l'altro. Così, è necessario capire che le figure nelle tabelle devono essere "stazionarie", e inoltre, le interrelazioni delle tabelle devono essere "stazionarie". Inoltre, le cifre iniziali delle tabelle devono provenire da fonti appropriate.

Bisogna dire che ci sono estensioni di TI al caso delle catene di Markov. Sembra essere proprio quello che il dottore ha ordinato. Ma no, le probabilità di transizione per il mercato non sono costanti, a causa della non stazionarietà generale. Inoltre, mentre per il CM non importa come il sistema sia finito nel suo stato attuale, per il mercato è molto importante.

Non so quale sia il tuo alfabeto problematico. Ho un sistema di una coppia di barre separate dalla distanza Lag. Una barra, in passato, è la fonte e l'altra è il ricevitore. Gli alfabeti di entrambi sono identici (per quanto riguarda i ritorni a barre, ovviamente).

Chiaramente, qualcosa di simile all'autocorrelazione, ma con una misura diversa. Le mie obiezioni sono esattamente le stesse del caso CM. Bene e tutti gli altri, la stazionarietà ecc.

SZU. devo dire che se davvero lo scambi (TI) e con successo, cosa con esso, con obiezioni. Lascia anche una zampa di lepre sul monitor, se ti aiuta.

Leggi HideYourRichess.

Sì, interessante. In effetti, la matrice di frequenza degli stati condizionali di un sistema - sotto l'ipotesi di connettività - riformulata in termini di entropia condizionale, ci dà UNA figura che descrive la possibilità che ci sia una certa determinatezza di una variabile da un'altra. Se la PDF in una tale matrice iniziale è uniforme, allora abbiamo la massima entropia del sistema (naturalmente, volevo dire entropia condizionata). E se ci sono irregolarità, l'entropia sarà minore. Come prima approssimazione possiamo fare con una cifra. Su questo hai ragione. E l'informazione reciproca per un insieme di variabili, separate dal ricevitore da Lag, come ha scritto Alexey, è calcolata già per scopi abbastanza concreti, cioè per la selezione di variabili informative.

Finora, personalmente non faccio trading usando TI. Questo argomento era un "primo tentativo", penso il prossimo.

HideYourRichess: Вот так выглядит краткая история ТИ в моём исполнении. Составлена по мотивам моих собственных изысканий и утверждений академического словарика (см. цитаты ранее).

Molto interessante. Shannon ha fatto un tale casino che stiamo ancora cercando di capirlo...

Bisogna dire che ci sono estensioni di TI per casi di catene di Markov. Sembra essere proprio quello che il dottore ha ordinato. Ma no, le probabilità di transizione per il mercato non sono costanti, a causa della non stazionarietà generale. Inoltre, se per CM non importa come il sistema si è rivelato nello stato attuale, per il mercato è molto importante.

Questo è il punto, il flusso di ritorno non è un processo markoviano, poiché il ritorno della barra zero dipende fortemente dal ritorno non solo della prima barra, ma anche della seconda, terza, ecc. In ogni caso, questo è il modo in cui lo studio del ramo principale può essere interpretato direttamente.

ZS. Devo dire che se davvero si fa commercio questo (TI) e con successo, poi che diavolo con esso, con obiezioni. Lasciate che la lepre scalpiti sul monitor, se vi aiuta.

No, non lo so. Ma sarebbe molto interessante svilupparlo in qualcosa di commerciale. Ho sentito da alsu (Alexey è scomparso da qualche parte, mi dispiace), che ricorda vagamente un programma sul canale RBC, in cui è apparso qualche rettore-trader che commercia davvero qualcosa di simile. E ci ha scommesso un sacco di soldi. E chiama il suo sistema "catturare le inefficienze del mercato".

È da molto tempo che penso all'entropia. Ho anche messo qualcosa qui. Ma allora era più simile all'entropia della fisica statistica, non al TI, e si riferiva alla multicurrency. Comunque, è da qualche anno che il karma mi sussurra qualcosa di entropico nell'orecchio, e io lo ascolto e cerco di capire cosa vuole da me...

Questo è il punto, il flusso di ritorno non è un processo markoviano, poiché il ritorno della barra zero è fortemente dipendente dal ritorno non solo della prima barra, ma anche della seconda, terza, ecc. In ogni caso, questo è il modo in cui lo studio del ramo principale può essere interpretato direttamente.

No, non faccio scambi. Ma sarebbe molto interessante sviluppare questo in qualcosa di commerciabile. Ho sentito da alsu (Alexey è scomparso da qualche parte, mi dispiace), che ricorda vagamente un programma sul canale RBC, in cui è apparso qualche rettore-trader che effettivamente commercia qualcosa di simile. E ci ha scommesso un sacco di soldi. E chiama il suo sistema "catturare le inefficienze del mercato".

Ed è da molto tempo che penso alle entropie. E ho anche postato qualcosa qui. Ma allora era più simile all'entropia della fisica statistica, non a TI, ed era legata alla multicurrency. Comunque, è da qualche anno che il karma mi sussurra qualcosa di entropico nell'orecchio, e io lo ascolto e cerco di capire cosa vuole da me...

Molto interessante.

Ma tu, Alexey, potresti formulare più chiaramente (sulla tua tabella) a quale ipotesi sulla distribuzione dei rendimenti corrispondono le stime del chi-quadro?

Il "browne" primordiale o qualcosa di più fresco?

;)