Maschinelles Lernen im Handel: Theorie, Modelle, Praxis und Algo-Trading - Seite 192

Sie verpassen Handelsmöglichkeiten:

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Registrierung

Einloggen

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Wenn Sie kein Benutzerkonto haben, registrieren Sie sich

Die ganze Welt hat mit angehaltenem Atem auf diesen Moment gewartet.

Und nun ist es endlich soweit!

Release 12 von jPrediction, das Code von trainierten ternären Klassifikatoren in MQL generiert, wurde veröffentlicht. MetaTrader-Benutzer müssen nicht mehr ternäre Klassifikatorcodes von Java nach MQL portieren. Der gesamte Code für MQL wird jetzt in Dateien mit der Erweiterung mqh gespeichert.

(Lauter Beifall und "Hurra!"-Rufe)

Aber das ist noch nicht alles. jPrediction 12 ist jetzt etwa 12% schneller als die Vorgängerversion!

(Lauter Beifall beim Werfen von Hauben)

Zahlreiche jPrediction-Benutzer können die Version 12 kostenlos von meiner Website herunterladen und nutzen (Link in meinem Profil, erster Beitrag auf meiner Homepage).

(Klopfen der Tasten und Bewegung der Download-Anzeigen auf den Monitoren)

Glückwünsche werden sowohl mündlich als auch schriftlich entgegengenommen, Sie können auch Geschenke und Geldüberweisungen über WebMoney empfangen.

Es ist mir peinlich zu fragen, für welche Version von MKUL? 4 oder 5???

Ich habe es mit der 5. Version überprüft. Aber es gibt kein OOP und andere Funktionen, die nur für die 5. Die Kompatibilität mit der 4. sollte also gegeben sein, oder? Natürlich glaube ich das nicht, denn ich habe es nicht auf der 4.

Großartig, ich habe gerade den Code, den Prediction generiert, mit dem Code, den ich geschrieben habe, verglichen, das Ergebnis ist dasselbe. Ich war nur besorgt, wenn ich einen Fehler hatte, wie Sie mit 1d erinnern, überprüfte ich jetzt alles ist das gleiche, das Ergebnis ist identisch. Ab heute ist die Signalauswahl für den Kauf war so schlecht, dass ich beschlossen, die gestrige verlassen und ich habe nicht verloren, und ich habe die 12 Release mit besseren Ergebnissen optimiert, aber ich habe weniger Einträge ... Ich habe nur drei. Alles in allem also in Ordnung, aber wir müssen morgen mehr Details sehen. Morgen werde ich also ausführlicher berichten.... Wie auch immer, das heutige Ölgemälde... urteilen Sie selbst.....Klage zu erheben. Und lassen Sie mich noch einmal die Signale erklären, die das Netzwerk als "Ich weiß nicht" definiert hat (Punkte ohne Pfeile). Wir bestimmen durch die Tatsache. Für heute ist es wahr. Wenn das Netz also sagt "Ich weiß es nicht", meinen wir, dass es wahr ist...

Aber, mein Gott, wie langweilig

Tag und Nacht bei einem kranken Mann zu sitzen,

Ohne einen Schritt aus dem Weg zu gehen!

Was für eine niederträchtige Heimtücke

Um einen halbtoten Mann zu unterhalten,

Um seine Kissen anzupassen,

Um die Medizin traurig zu ihm zu bringen,

Sie seufzen und denken bei sich selbst:

Wenn der Teufel dich holt!)))

Ich habe ein Paket gefunden, mit dem man einen tieferen Einblick in die MoD-Algorithmen nehmen kann. Ich verstehe es selbst nicht, aber irgendetwas sagt mir, dass es ein gutes Paket ist, vielleicht ist ja jemand daran interessiert...

Partykit

Die 14. Version von jPrediction ist erschienen.

Die neue Version verfügt über einen verbesserten Algorithmus zur Erkennung und Entfernung unbedeutender Prädiktoren aus Modellen

Sie könnenjPrediction 14 kostenlos herunterladen und für Klassifizierungsaufgaben verwenden, indem Sie es von meiner Website herunterladen (Link in meinem Profil, oberster Beitrag auf meiner Homepage).

Die Beispiele (Indikatoren) dienen nur der Veranschaulichung. Ich empfehle nicht, Indikatoren zu verwenden.

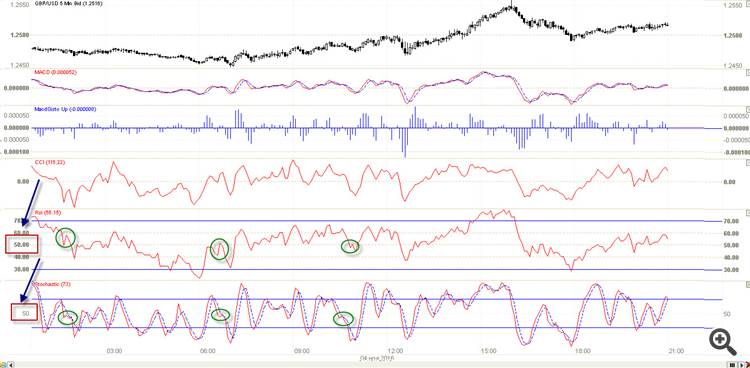

Stellen wir uns einmal folgende Situation vor: Wir haben 5 Prädiktoren und den Preis, wir müssen die Preisbewegung mit hoher Wahrscheinlichkeit( sagen wir über 70 %) vorhersagen, und wir wissen im Voraus, dass es nur ein Muster in diesen Prädiktoren gibt, das verwendet werden kann, um den Markt mit einer solchen Genauigkeit vorherzusagen. Das ist, wennRSI und stochastische machen einen Mini-Zickzack nach unten in der ~50 Bereich

s

Nebenbei bemerkt liegt das Muster sozusagen in zwei Betrachtungsebenen, der digitalen (Muster im Bereich ~50 ) und der figurativen (Zickzack - Bild), so dass es bei der Suche nach Mustern sinnvoll ist, diese Ebenen zu berücksichtigen...

Das ist alles, es gibt keine funktionierenden Muster mehr in diesen Prädiktoren, alles andere ist nur Rauschen, diese ersten drei Indikatoren sind ursprünglich Rauschen, und inRSI und Stochastik gibt es nur ein Muster, alles andere inRSI und Stoch ist auch totales Rauschen...

Lassen Sie uns nun darüber nachdenken, wie wir nach solchen Mustern in den Daten suchen können... Können herkömmliche MOs das tun?

Die Antwort lautet nein, warum?

Da das Ziel der MOs darin besteht, alle Bewegungen vorherzusagen, handelt es sich entweder um eine Zickzack- oder eine Spurenfarbe. Candlestick oder Richtung oder... oder. ..alle Ziele zwingen MOs dazu, alle Kursbewegungen vorherzusagen , und das ist bei Geräuschvorhersagen unter 99% unmöglich...

Ich erzähle eine kleine Geschichte mit Moral, ich habe eine synthetische Stichprobe von 20 Prädiktoren erstellt, 4 Prädiktoren interagieren zusammen, vollständig das Ziel zu erklären, die anderen 16 Prädiktoren waren nur zufälliges Rauschen, nach dem Training auf neue Daten "OOS" -Modell erraten alle neuen Werte, es zeigte Fehler 0%.... Die Moral dieser Fabel ist: Wenn es Prädiktoren in den Daten gibt, die das Ziel vollständig erklären können, werden sowohl MI trainiert als auchOOS sich normal verhalten... Unsere Ergebnisse zeigen das Gegenteil, in den Stichproben, die wir in MI einspeisen, gibt es mehr als 5 % nützliche Informationen, die 5 % des Ziels erklären können, und wir wollen 100 % davon, Sie kennen die Utopie des Ansatzes? Das ist der Grund, warum MOs übertrainieren, wir lassen sie übertrainieren, weil wir alles zu 100% vorhersagen wollen.

Doch zurück zum eigentlichen Thema: Wie können wir nach diesen Arbeitsmustern suchen? Wie finden wir die "Nadel" der Robustheit in dem "Stapel " von Daten?

Ich schlage vor, MO im Prinzip loszuwerden, wir müssen nur jeden Prädiktor in kleine Teile ähnlicher Situationen (Muster) zerlegen, und indem wir alle möglichen Kombinationen ausprobieren und mit der Zielvorgabe vergleichen, werden wir finden, wonach wir suchen... Also, wie zerlegt man Prädiktoren? Womit?

Die Antwort ist einfach, auch wenn ich sie nicht sofort verstanden habe: Wir müssen einfach jeden Prädiktor dummerweise in, sagen wir, 30 Cluster einteilen.

Wir teilen einfach jeden Prädiktor zu diesen Clustern und versuchen verschiedene Kombinationen zwischen ihnen können wir einige Muster, die funktionieren, wie im Bild zu finden - wenn Stochastik hat Cluster 1 und RSI hat Cluster 2, wird es Wachstum...

Nun zu den Grundzügen der Suche nach Arbeitsmustern

Dies ist unsere hypothetische Stichprobe, dasZiel.Das Etikett ist das Ziel, das, sagen wir mal, Wachstum/Rückgang bedeutet.

Beispiel für die Suche nach Wachstum

Wir suchen nach Zeilen, die sich in der gesamten Stichprobe mindestens 10 Mal wiederholen, und in jeder der gefundenen identischen Gruppen, die sich wiederholt haben, sollte die Anzahl der "1" in target.label mehr als 70% von "0" betragen.

Ich bin mir nicht ganz sicher, was Sie mit "Clustering" meinen. Normalerweise wird nicht ein bestimmter Prädiktor geclustert, sondern man nimmt ein Dutzend von ihnen und findet Bereiche im Raum, in denen sich diese Punkte häufen. Wenn wir zum Beispiel in der folgenden Abbildung zwei Prädiktoren haben, ergibt die Clusterung in 2 Cluster blaue und rote Cluster.

Vielleicht sprechen Sie von Mustern? Grünes Muster - der Preis geht nach unten und dann nach oben. Gelb: Der Preis steigt. Rot: auf->ab. Haben Sie es verstanden?