Maschinelles Lernen im Handel: Theorie, Modelle, Praxis und Algo-Trading - Seite 2474

Sie verpassen Handelsmöglichkeiten:

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Registrierung

Einloggen

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Wenn Sie kein Benutzerkonto haben, registrieren Sie sich

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Da ist etwas Wahres dran, aber ich habe mein Modell überprüft, und die Hauptsache ist, dass wir wissen, mit welchem Stürmer wir rechnen....

Ich verstehe es nicht wirklich, aber das ist mein Problem, ich habe nicht gut studiert, ich sehe Algorithmen für den Handel etwas anders, eher asoziale Regeln und genetische Suchregeln oder Formeln, wie symbolische Regression usw. Aber wenn Sie es geschafft haben, einfache Modelle mit neuen Daten zum Laufen zu bringen, ist es sehr interessant, davon zu hören...

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Danke fürs Lesen...

Ich liebe Maitreid auch, habe sein Video bestimmt 8 Mal gesehen, kein einziges zusätzliches Wort...

Was den Dummy betrifft, so ist es meiner Meinung nach viel einfacher: Die Börse lebt von der Provision, und wenn die meisten Leute kaufen wollen und diese Kaufanfragen unter dem aktuellen Preis liegen, ist es für die Börse profitabel, die Käufer zu befriedigen, weil es mehr von ihnen gibt, so dass die Provision (Geld) mehr verdienen kann, so dass der Preis nach unten geht und umgekehrt bei den Verkäufern ...

Wie er das macht, ob er nur den Preis druckt oder den Tumbler manipuliert oder etwas anderes, weiß ich nicht, aber ich denke, das Ergebnis ist das gleiche...

Deshalb läuft der Preis den Positionen der Teilnehmer zuwider.

Ich verstehe Sie nicht ganz, aber das ist mein Problem, weil ich nicht gut studiert habe. Ich suche ein bisschen anders nach Handelsalgorithmen, mehr nach asozialen Regeln und genetischen Suchregeln oder Formeln, wie symbolische Regression usw. Aber wenn Sie es geschafft haben, reguläre Modelle auf neuen Daten funktionieren zu lassen, ist es sehr interessant, davon zu hören.

Ja, ich habe es, die Qualität ist nicht wie auf der Trainingsfläche, aber immer ein Teil dieser Qualität beibehalten wird, und auf meiner Forschung vorwärts von 10 Jahren der Geschichte kann bis zu einem Jahr, im Durchschnitt 2-3 Monate funktioniert es für ziemlich gute Qualität, im Vergleich zu der Trainingsfläche Prozent 60-70 im Durchschnitt wahrscheinlich. Ein neuronales Netz wird bessere Ergebnisse liefern, aber es müssen bereits diese Kriterien der Umschulung hinzugefügt werden, um kombinierte Daten etwas wie Gewichte einzugeben, um der Datenmenge ein bestimmtes Gewicht zu geben, dann die Qualität des endgültigen Backsest zum Beispiel Erwartung oder Profitka und natürlich die Komplexität des endgültigen Algorithmus, der sich herausstellte (Menge aller Gewichte aller Perceptrons zum Beispiel). Um dies in einem neuronalen Netz zu erreichen, sollte die Art der Neuronen so unterschiedlich wie möglich sein, und die Anzahl der Schichten und deren Zusammensetzung sollte beliebig sein, dann ist es möglich. Im Grunde genommen verwendet jeder ein neuronales Netz mit fester Architektur, aber aus irgendeinem Grund verstehen sie nicht, dass die Architektur auch flexibel sein muss, denn durch die Zerstörung dieser Flexibilität zerstören wir die Möglichkeit, das Umlernen zu minimieren. Im Allgemeinen können die gleichen Kriterien natürlich auch auf einfache Modelle angewandt werden, sogar müssen, dann erhalten Sie eine gute Vorwärts, mein Modell gibt ein paar Monate Gewinn voraus und die Einstellungen können in einem Tag aktualisiert werden. Einer der Haupttricks besteht darin, so viele Daten wie möglich zu nehmen (10 Jahre oder mehr). In diesem Fall wird nach globalen Mustern gesucht, die auf der Physik des Marktes basieren und in den meisten Fällen noch sehr lange funktionieren.

Ich habe es getan, die Qualität ist nicht.....

Ich brauche starkes Eisen, ich habe die Eisendecke, aber es gibt eine Lösung für dieses Problem.

Wenn Sie es noch nicht gelesen haben, wird es Ihnen gefallen. Ich bin sicher, dass es interessante Ideen zu den Kriterien für die Qualität des Modells enthält.

Ich brauche starkes Eisen, auch ich habe Probleme mit Hardware, aber es gibt eine Lösung für dieses Problem.

Ich brauche wirklich Server), aber ich habe sie nicht (ich habe gerade alle diese auf toten Netbook gemacht), ich brauche lange und schmerzhafte Zeit zu lesen. Aber an sich gibt es keinen anderen Weg, oder Sie nehmen Macht von irgendwo und laden Sie sie hart, in diesem Fall müssen Sie 20-30 Konfigurationen mindestens zu überprüfen, und besser in der Nähe von hundert, und für jedes Signal hängen und zu überwachen, die meisten stabilen, die eine natürliche Auswahl passieren und zu verlassen, dann versuchen, mehr Macht hinzuzufügen. Es gibt keinen anderen Weg, sonst ist es nur ein Weg ins Nichts, wie hier schon viele geschrieben haben... Es kann sich wirklich über viele Jahre hinziehen, ohne dass man weiß, wo man graben muss. Die Alternative ist ein Studium der Forumswissenschaften und ein Geschwätz über die Mondphasen und ihren Einfluss auf den Markt im Geiste der Prokopenko-Shows ))). Was ist die Lösung, wenn nicht ein Geheimnis?

Was ist die Lösung, wenn es kein Geheimnis ist?

In dem Buch, das ich verlinkt habe, ist die Lösung intelligenter beschrieben... Ich kann nur empfehlen, es zu lesen...

Die Lösung ist ganz einfach: Man muss das Problem aufteilen, z. B. die Daten clustern und für jedes Cluster ein anderes Modell trainieren.

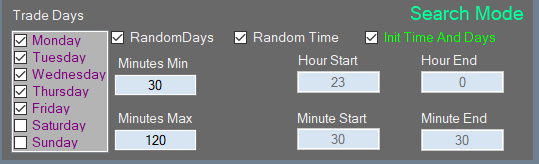

Oder ein noch einfacheres Beispiel: Es gibt 5 Handelstage in der Woche, also trainieren wir ein Modell täglich für montags, das zweite für dienstags usw. So haben wir die Trainingsstichprobe um das Fünffache reduziert und haben 2 Jahre Training, nicht 10 Jahre, und so weiter, es hängt von unserer Vorstellung ab.

Das Buch, das ich verlinkt habe, beschreibt diese Lösung auf intelligentere Weise... Ich kann nur empfehlen, es zu lesen...

Die Lösung ist ganz einfach: Man muss das Problem aufteilen, z. B. die Daten clustern und für jedes Cluster ein anderes Modell trainieren.

Oder noch einfacheres Beispiel: in einer Woche von 5 Handelstagen, trainieren wir ein Modell streng für montags, die zweite für dienstags, usw. Es stellte sich heraus, die Ausbildung Probe von 5 mal und bereits 10 Jahre zu reduzieren, und 2 Jahre der Ausbildung, und so weiter ist die Phantasie ...

Ich habe es nicht gelesen, aber es ist alles implementiert, ich habe es aus dem gleichen Grund getan, ich musste die Stichprobengröße reduzieren, aber immer noch in der Lage sein, tief in die Geschichte zu analysieren, aber ich habe es experimentell gemacht, als ich begriffen habe, dass ich nicht stark genug in meinem Computer bin und ich es besser machen kann )))), plus Multithreading und solche Sachen... um das Beste aus ihm herauszuholen.

Ich habe es nicht gelesen, aber es wurde bereits bei mir zu Hause implementiert. Ich habe es aus dem gleichen Grund gemacht, ich musste irgendwie das Sampling reduzieren, aber immer noch in der Lage sein, tief in die Geschichte hinein zu analysieren, aber ich bin experimentell dazu gekommen, als ich merkte, dass mein Computer nicht stark genug ist und ich es besser machen kann )))), plus Multithreading und solche Sachen... um das Beste aus ihm herauszuholen.

nun denn

)))

=====

Im Ernst: Das Buch beschreibt, wie man effizienter und ohne Qualitätsverluste herunterladen kann, aber es ist unwahrscheinlich, dass man damit ... Ich denke, es ist an der Zeit, zu euristischen Algorithmen zu wechseln...

oder so etwas wie eine Wissensdatenbank, das ist die kleinste Aufteilung, meine Ideen und Gedanken gehen in diese Richtung, da Varianten von Ereignissen und Zeichen für Dutzende von Gigabytes sein werden, und ein Modell mit 20 Millionen Zeichen kann nicht trainiert werden...)) also eine Wissensdatenbank sieht für mich wie ein Ausweg aus dem "Fluch der Dimension" aus

oder so etwas wie eine Wissensdatenbank, das ist der kleinste Schwarm, meine Ideen und Gedanken gehen in diese Richtung, denn es wird Dutzende von Gigabytes an Ereignisvarianten und Zeichen geben, und ein Modell mit 20 Millionen Zeichen kann nicht trainiert werden...))

Vergessen Sie die Schilder. So wie ich es sehe, handelt es sich um eine skalare Größe (oder mit anderen Worten um einen mathematischen Ausdruck, auch wenn er logisch ist, kann er auf die mathematische Ebene reduziert werden, nur die Genauigkeit wird darunter leiden). Alle diese skalaren oder logischen Werte werden aus dem Preis abgeleitet, weil wir keine anderen Daten haben, und der Versuch, zusätzliche Daten zu verwenden, kann die Prognose nur verschlechtern, weil die Daten unterschiedlich sind und aus verschiedenen Quellen stammen können, wobei nicht klar ist, welche Daten vorrangig zu behandeln sind. Jede Zahlenreihe kann alle anderen Zahlenreihen in sich aufnehmen, wenn alle möglichen Arten der Umwandlung dieser Reihe verwendet werden... versuchen Sie, dies zu verstehen. In diesem Fall geben Sie dem Algorithmus diesen Merkmalsraum nicht vor, sondern lassen ihn diese Merkmale selbst finden... Sie brauchen keine Basis, Sie brauchen Macht. Wenn es ein System gibt und es zumindest teilweise funktioniert, ist der nächste Schritt die Dezentralisierung der Berechnungen. Die Arbeitnehmer müssen vernetzt werden, und die Datenbank würde dabei helfen, aber sie muss als Speicher für gemeinsame Ergebnisse dienen. Das klingt schon nach Bergbau.

Vergessen Sie die Attribute. Meines Erachtens handelt es sich um eine skalare Größe (oder mit anderen Worten um einen mathematischen Ausdruck, auch wenn er logisch ist, kann er auf die mathematische Ebene reduziert werden, nur die Genauigkeit wird darunter leiden). Alle diese skalaren oder logischen Werte werden aus dem Preis abgeleitet, weil wir keine anderen Daten haben und der Versuch, zusätzliche Daten zu verwenden, die Prognose nur verschlechtern kann, weil die Daten unterschiedlich sind und aus verschiedenen Quellen stammen können, wobei nicht klar ist, welche Daten vorrangig zu behandeln sind. Jede Zahlenreihe kann alle anderen Zahlenreihen in sich aufnehmen, wenn alle möglichen Arten der Umwandlung dieser Reihe verwendet werden... versuchen Sie, dies zu verstehen. In diesem Fall brauchen Sie dem Algorithmus diesen Merkmalsraum nicht zu geben, sondern müssen ihn diese Merkmale selbst finden lassen... Sie brauchen keine Basis, Sie brauchen Energie. Wenn es ein System gibt und es zumindest teilweise funktioniert, ist der nächste Schritt die Dezentralisierung der Berechnungen. Die Arbeitnehmer müssen vernetzt werden, und die Datenbank würde dabei helfen, aber sie muss als Speicher für gemeinsame Ergebnisse dienen. Das klingt schon nach Bergbau.

Ich verstehe Ihre Sichtweise nicht sehr gut, also werde ich nicht diskutieren...

Ich sehe meinen Algorithmus als eine Abfolge von Ereignissen, das Ereignis ist eine Protokollregel, die Abfolge ist nicht zeitlich festgelegt, sie ist entweder da oder nicht.

(als Händler, der ein Niveau festlegt, kann der Preis es in 5 Minuten oder in einem Tag erreichen, aber die Situation ist die gleiche)

Das Ensemble solcher Arbeitsabläufe wird also TS sein.

Aber um solche "nichtdimensionalen" Sequenzen zu finden, müssen wir Billionen von Varianten durchgehen, die Lösung sehe ich darin, eine Wissensdatenbank auf Ihrer Festplatte anzulegen...

Ich denke, dass alle "typischen" Trainings eines Algorithmus in einem gleitenden Fenster keine funktionierenden Varianten sind, da der Markt nicht stabil ist, die Ausgabe wird ein gleitender Durchschnitt mit einer Erinnerung an die Vergangenheit sein, die sich in der Zukunft aufgrund der Nicht-Stationarität niemals wiederholen wird...