この記事で作成したニューラルネットワーク(順モデル、逆モデル)は、前回の記事と互換性がありますか?

CS 0 15:22:10.739 Core 01 2023.01.01 00:00:00 EURUSD_PERIOD_H1_RRL-learning.nnw CS 0 15:22:10.739 Core 01 2023.01.01 00:00:00 OpenCL not found. Error code=5103 CS 2 15:22:10.739 Core 01 2023.01.01 00:00:00 invalid pointer access in 'NeuroNet.mqh' (2876,11) CS 2 15:22:10.739 Core 01 OnInit critical error CS 2 15:22:10.739 Core 01 tester stopped because OnInit failed CS 2 15:22:10.740 Core 01 disconnected CS 0 15:22:10.740 Core 01 connection closed

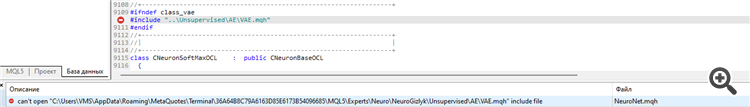

NetCreatorでもニューラルネットワークを 作成しようとしましたが、同じエラーが発生しました。

何が問題を引き起こしているのでしょうか?

| err_opencl_context_create | 5103 | OpenCL コンテキストの 作成エラー |

このライブラリを使用する前に、PCにOpenCLをインストールする必要があります。

Dmitry Gizlyk # :

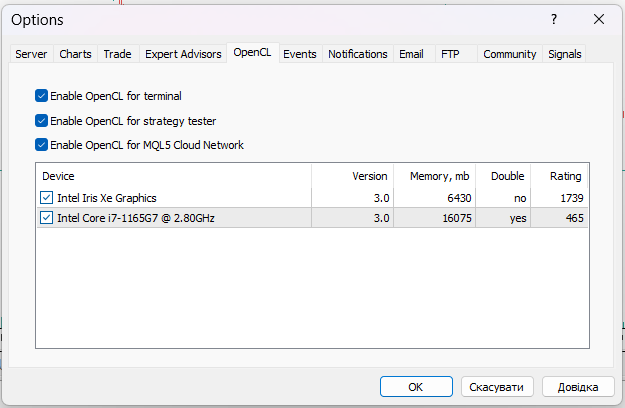

Nvidia Tesla A100 GPUを使用しており、すでにOpenCLが有効になっていますが、同じエラーが発生します。

| err_opencl_context_create | 5103 | OpenCLコンテキストの 作成エラー |

このライブラリを使用する前に、PCにOpenCLをインストールする必要があります。

ドミトリーさん、テスターで 学習済みのネットワークにバイナリファイル(.nnw)を "スリップ "させる方法を教えてください。私の理解が正しければ、テスターでは、やはり仮想サンドボックスが作成され、テスターのこのディレクトリにファイルが強制的にコピーされたとしても、テスターを再起動すると、そこからすべてのファイルが削除されます。例としてこのディレクトリを示します。C:◆UsersACER ◆AppData ◆Roaming ◆MetaQuotes ◆Tester ◆36A64B8C79A6163D85E6173B54096685 ◆Agent-127.0.0.1-3000 ◆MQL5 ◆Files ネットワークは当然、新しい、訓練されていないネットワーク上に構築されます。 または、どのようにこの問題を別の方法で解決できますか?

取引の機会を逃しています。

- 無料取引アプリ

- 8千を超えるシグナルをコピー

- 金融ニュースで金融マーケットを探索

新しい記事「ニューラルネットワークが簡単に(第36回):関係強化学習」はパブリッシュされました:

前回の記事で説明した強化学習モデルでは、元のデータ内のさまざまなオブジェクトを識別できる畳み込みネットワークのさまざまなバリアントを使用しました。畳み込みネットワークの主な利点は、場所に関係なくオブジェクトを識別できることです。同時に、畳み込みネットワークは、オブジェクトやノイズのさまざまな変形がある場合、常にうまく機能するとは限りません。これらは、関係モデルが解決できる問題です。

関係モデルの主な利点は、オブジェクト間の依存関係を構築できることです。これにより、ソースデータの構造化が可能になります。関係モデルは、オブジェクトとイベントがノードとして表されるグラフの形式で表すことができ、関係はオブジェクトとイベント間の依存関係を示します。

グラフを使用することで、オブジェクト間の依存関係の構造を視覚的に構築できます。たとえば、チャネルのブレイクアウトパターンを説明したい場合、チャネルの形成を頂点とするグラフを作成できます。チャネル形成記述は、グラフとして表すこともできます。次に、2つのチャネルブレイクアウトノード(上下の境界線)を作成します。両ノードは前のチャネル形成ノードへの同じリンクを持ちますが、互いに接続されていません。誤ったブレイクアウトの場合にポジションを建てるのを避けるために、価格がチャネル境界にロールバックするのを待つことができます。これらは、チャネルの上下の境界にロールバックするためのさらに2つのノードです。それらは、対応するチャネル境界ブレイクアウトのノードと接続します。ただし、繰り返しになりますが、それらは互いに接続しません。

記述された構造はグラフに適合するため、データとイベントシーケンスの明確な構造が提供されます。連関規則を構築する際にも同様のことを検討しましたが、これは以前に使用した畳み込みネットワークとはほとんど関係がありません。

畳み込みネットワークは、データ内のオブジェクトを識別するために使用されます。モデルを訓練して、いくつかの動きの反転ポイントまたは小さなトレンドを検出できますが、実際には、チャネル形成プロセスは、チャネル内のさまざまな強度のトレンドに合わせて延長できます。ただし、畳み込みモデルは、このような歪みにうまく対処できない場合があります。さらに、畳み込みニューラル層も全結合ニューラル層も、異なるシーケンスを持つ同じオブジェクトで構成される2つの異なるパターンを分離できません。

また、畳み込みニューラルネットワークはオブジェクトを検出することしかできず、オブジェクト間の依存関係を構築できません。したがって、そのような依存関係を学習できる他のアルゴリズムを見つける必要があります。さて、アテンションモデルに戻りましょう。アテンションモデルは、個々のオブジェクトに注意を集中させ、一般的なデータ配列からそれらを抽出できるようにします。

作者: Dmitriy Gizlyk