トレーディングにおける機械学習:理論、モデル、実践、アルゴトレーディング - ページ 3309 1...330233033304330533063307330833093310331133123313331433153316...3399 新しいコメント Andrey Dik 2023.10.15 13:42 #33081 СанСаныч Фоменко #:質問の答えはいらない。もし答えが見つかったら、私はどこへ行くのだろう?あなたの質問に対する答えの実際的な価値は何ですか?EAのどこに質問の答えを入れるのか?IOのどこに質問の答えを入れるのか?なぜ、私が必要としない答えを100回も質問するのか? ここに、あなたの質問に対する答えがあります: 範囲外の赤い破線の符号を変えれば、希望する区間に残っているものは、あなたが探しているものの最大スコアを持つことになるので、最適化は最大値を 見つけることに縮小される。 これは、使用しているスコアを、最大値が高原に横たわるスコアに変換する簡単な方法である。しかし、これは正しい方法ではなく、正しい方法は、探している場所で最大値を持つスコアを最初に使用することである。 これはニューラルネットワークのトレーニング、関数の最適化、戦略の最適化、すべてに当てはまる。 したがって、「最大値を探す必要はなく、安定したプラトーを探す必要がある」という発言は本質的に間違っており、推定の使い方が間違っていることを示している。 Maxim Dmitrievsky 2023.10.15 13:51 #33082 Maxim Dmitrievsky #:アンドリューはNSのトレーニングとパラメーターの最適化を混同しているようだ。どちらも最適 化のようなもので、子猫がたくさんの餌をかけられたときには、少し狼狽してしまう。 СанСаныч Фоменко 2023.10.15 13:59 #33083 Andrey Dik #: だから、「最大値を探す必要はなく、安定したプラトーを探す必要がある」という発言は本質的に間違っている。 あなたの主張に反して、あなたは推定を実証することによってプラトーを発見したことを示している。 実際にどこでこれを適用できるのですか? 私たちはオーバーフィッティングについて議論しているのですが、それは通常最適化に基づいています。 MOでは、異なるファイルでモデルを実行することにより、オーバーフィッティングが明らかになります。モデル性能の変動はスーパーフィッティングであり、基準は必要ありません。オーバーフィッティングによって明らかになるパッケージもある。 空から、失礼、極端なところから、物事が異なる地上へ降りてきてください。 Andrey Dik 2023.10.15 14:05 #33084 СанСаныч Фоменко #:あなたの主張に反して、あなたは感謝を示すことでプラトーを発見した。これを実践するためにはどうすればいいのでしょうか?私たちはオーバーフィッティングについて議論しているが、それは通常、最適化に基づいている。MOでは、異なるファイルでモデルを実行することで、オーバーフィッティングが明らかになります。モデル性能の変動はスーパーフィッティングであり、基準は必要ありません。オーバーフィッティングを検出するパッケージもある。極端なところから、物事が異なるところに降りてきてください。あなたは、自分が何を求めているのか正確に分かっていない(質問に答えていない)。 Maxim Dmitrievsky 2023.10.15 14:08 #33085 СОЗДАТЕЛЬ ИИ: ИСКУССТВЕННЫЙ МОЗГ, СВОБОДА ВОЛИ, СИНГУЛЯРНОСТЬ 2023.10.15www.youtube.com Освойте бесплатно за 2 недели основы Python и анализа данных на курсе «Специалист по Data Science» от Яндекс Практикум: https://ya.cc/t/HG2PtD254WHFyvПереход... Maxim Dmitrievsky 2023.10.16 06:32 #33086 mytarmailS パラメータを合わせるのに、10000回ではなく10回繰り返したとしたら、それは訓練されていないモデルと言えるのでしょうか? 結局のところ、"We came up with "というフレーズ自体も、何らかの思考プロセス(反復)を意味している。最終的なモデルは、それが頭脳による反復なのか、コンピュータによる反復なのか、そして両者に違いがあるのかをどうやって知るのだろうか?この疑問は、プラドの記事に 敬意を表した後に生じた。 Pハッキングとは、データを思い通りに引き伸ばすことだ。どのようなFFでも、それを最大化するために入力にできるだけ多くのデータを加える。うまく最大化できなければ、さらにデータを追加するか、より正確な最適化アルゴリズムを選択する。つまり、どんなFFでもこの方法で最大化することができる。これは、TC最適化で最も一般的なケースです。この場合、データを増やせばオーバートレーニングになる。選択肢がない。グローバル・ミニマム・マキシマムではまったく何もわからない。論理的な解決策は、上に書いたように、特徴数を最小にしながらFFを最大にすることである。いわば最小の悪だ。Baesは科学的な言葉で言えば、variant traidofである。逆のプロセスは研究であり、最初の仮定を立てず、天井からFFを取らず、パターンがないかデータを調べる。「あなたが作り上げた」というのは現実とは何の関係もない。「フレンドリーなフレンドリーなフレンドリーフレンドリーフレンドリーフレンドリーフレンドリーフレンドリーフレンドリーフレンドリーフレンドリー。そして、研究をするのであれば、少なくとも研究の対象と方法を定義し、研究ツールを選択する必要がある。研究対象がBPですらなく、自分だけが知っている存在であれば、そのような研究の結果を事前に決定することさえできる。大学ではこんなことは教えてくれないだろう。) СанСаныч Фоменко 2023.10.16 07:52 #33087 Maxim Dmitrievsky #: Pハッキングとは、データを思い通りに引き伸ばすことだ。どのようなFFでも、それを最大化するために入力にできるだけ多くのデータを加える。もし最大化できなければ、さらにデータを追加するか、より正確な最適化アルゴリズムを選択する。つまり、どんなFFでもこの方法で最大化できる。これは、TC最適化で最も一般的なケースです。この場合、データを増やせば、オーバートレーニングになる。選択肢がない。グローバル・ミニマム・マキシマムではまったく何もわからない。論理的な解決策は、上に書いたように、特徴数を最小にしながらFFを最大にすることである。いわば最小の悪だ。科学的な言葉で言えば、バリアントレードオフだ。 逆のプロセスは研究であり、最初の仮定を立てず、天井からFFを取らず、パターンがないかデータを調べる。 「あなたが作った」というのは現実とは関係ない。「あなたは研究に基づいて結論を導き出した」のだ。 そして、研究をするのであれば、少なくとも研究の対象と方法を定義し、研究ツールを選択する必要がある。研究対象がBPですらなく、自分だけが知っている存在であれば、そのような研究の結果を事前に決定することさえできる。 大学ではこのようなことは教えてくれないだろう。) ハチミツの樽にタールのスプーン、そうすればハチミツは捨てられる。スターリッツが言ったように、印象に残るのは最後のフレーズだ。 Maxim Dmitrievsky 2023.10.16 08:08 #33088 СанСаныч Фоменко #:蜂蜜の樽にタールをひとさじ、そうすれば蜂蜜は捨てられる。スターリッツが言ったように、大事なのは最後の一文だ。 そうすれば、あまり賢そうに聞こえない。 mytarmailS 2023.10.16 09:08 #33089 ー最適化のー最適化のー最適化のー最適化プロセスはー最適化プロセスはー未知なるパラメータのーパラメータのー探索のーである。各反復は、仮説(パラメータ)を提示し、実験結果を検証(FF)する実験/研究である。ーつまりー最適化(ー(ー探索ーはーというーというーのー)とはーしかし、これは知的な無に理解することはもちろん与えられない、ここでは考える必要がある、論理が含まれているはずだ......。 Maxim Dmitrievsky 2023.10.16 09:37 #33090 mytarmailS #: 最適化プロセスは、未知のパラメータの探索である。ー各反復はー仮説(ー(ー)をー(ー)をー(ー(ー)のー(ー)のー(ー)のー(ー)のー(ーー)のー(ーーー)するー(ーーー)のー(ーー)ノ)。つまり、最適化のプロセス(探索)は、かなりの研究なのである。But this is not given to understand intellectual nothingness, of course not given, here you need to think, logic to include ... ー 研究者の研究者のーというータはー最適化のー最適化のー最適化のー最適化のー。ー最適化のーそのー最適化のー最適化のー最適化ー最適化ー最適化のー最適化のー最適化のー最適化ー最適化ーはー最適化のー最適化ーはー最適化研究者のー最適化研究者ーー彼のー最適化はー 1...330233033304330533063307330833093310331133123313331433153316...3399 新しいコメント 取引の機会を逃しています。 無料取引アプリ 8千を超えるシグナルをコピー 金融ニュースで金融マーケットを探索 新規登録 ログイン スペースを含まないラテン文字 このメールにパスワードが送信されます エラーが発生しました Googleでログイン WebサイトポリシーおよびMQL5.COM利用規約に同意します。 新規登録 MQL5.com WebサイトへのログインにCookieの使用を許可します。 ログインするには、ブラウザで必要な設定を有効にしてください。 ログイン/パスワードをお忘れですか? Googleでログイン

質問の答えはいらない。もし答えが見つかったら、私はどこへ行くのだろう?あなたの質問に対する答えの実際的な価値は何ですか?

EAのどこに質問の答えを入れるのか?IOのどこに質問の答えを入れるのか?

なぜ、私が必要としない答えを100回も質問するのか?

ここに、あなたの質問に対する答えがあります:

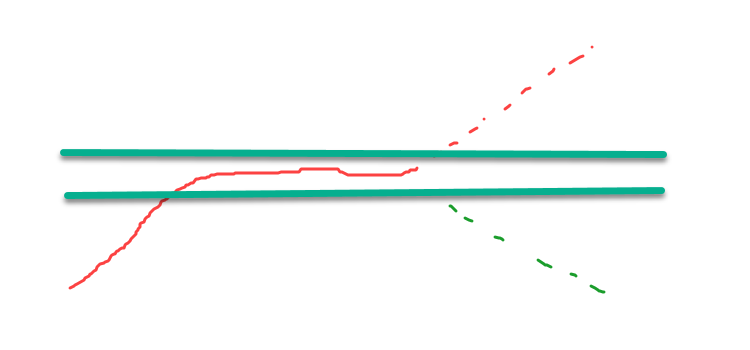

範囲外の赤い破線の符号を変えれば、希望する区間に残っているものは、あなたが探しているものの最大スコアを持つことになるので、最適化は最大値を 見つけることに縮小される。

これは、使用しているスコアを、最大値が高原に横たわるスコアに変換する簡単な方法である。しかし、これは正しい方法ではなく、正しい方法は、探している場所で最大値を持つスコアを最初に使用することである。

これはニューラルネットワークのトレーニング、関数の最適化、戦略の最適化、すべてに当てはまる。

したがって、「最大値を探す必要はなく、安定したプラトーを探す必要がある」という発言は本質的に間違っており、推定の使い方が間違っていることを示している。

アンドリューはNSのトレーニングとパラメーターの最適化を混同しているようだ。

どちらも最適 化のようなもので、子猫がたくさんの餌をかけられたときには、少し狼狽してしまう。

だから、「最大値を探す必要はなく、安定したプラトーを探す必要がある」という発言は本質的に間違っている。

あなたの主張に反して、あなたは推定を実証することによってプラトーを発見したことを示している。

実際にどこでこれを適用できるのですか?

私たちはオーバーフィッティングについて議論しているのですが、それは通常最適化に基づいています。

MOでは、異なるファイルでモデルを実行することにより、オーバーフィッティングが明らかになります。モデル性能の変動はスーパーフィッティングであり、基準は必要ありません。オーバーフィッティングによって明らかになるパッケージもある。

空から、失礼、極端なところから、物事が異なる地上へ降りてきてください。

あなたの主張に反して、あなたは感謝を示すことでプラトーを発見した。

これを実践するためにはどうすればいいのでしょうか?

私たちはオーバーフィッティングについて議論しているが、それは通常、最適化に基づいている。

MOでは、異なるファイルでモデルを実行することで、オーバーフィッティングが明らかになります。モデル性能の変動はスーパーフィッティングであり、基準は必要ありません。オーバーフィッティングを検出するパッケージもある。

極端なところから、物事が異なるところに降りてきてください。

結局のところ、"We came up with "というフレーズ自体も、何らかの思考プロセス(反復)を意味している。

最終的なモデルは、それが頭脳による反復なのか、コンピュータによる反復なのか、そして両者に違いがあるのかをどうやって知るのだろうか?

この疑問は、プラドの記事に 敬意を表した後に生じた。

Pハッキングとは、データを思い通りに引き伸ばすことだ。どのようなFFでも、それを最大化するために入力にできるだけ多くのデータを加える。もし最大化できなければ、さらにデータを追加するか、より正確な最適化アルゴリズムを選択する。つまり、どんなFFでもこの方法で最大化できる。これは、TC最適化で最も一般的なケースです。この場合、データを増やせば、オーバートレーニングになる。選択肢がない。グローバル・ミニマム・マキシマムではまったく何もわからない。論理的な解決策は、上に書いたように、特徴数を最小にしながらFFを最大にすることである。いわば最小の悪だ。科学的な言葉で言えば、バリアントレードオフだ。

ハチミツの樽にタールのスプーン、そうすればハチミツは捨てられる。スターリッツが言ったように、印象に残るのは最後のフレーズだ。

蜂蜜の樽にタールをひとさじ、そうすれば蜂蜜は捨てられる。スターリッツが言ったように、大事なのは最後の一文だ。

最適化プロセスは、未知のパラメータの探索である。