Ti stai perdendo delle opportunità di trading:

- App di trading gratuite

- Oltre 8.000 segnali per il copy trading

- Notizie economiche per esplorare i mercati finanziari

Registrazione

Accedi

Accetti la politica del sito e le condizioni d’uso

Se non hai un account, registrati

Non che sia sbagliato. Giusto, giusto come l'espressione "comprare a poco prezzo, vendere a caro prezzo". Non è solo la correttezza che conta, ma anche la formalizzabilità. Non ha senso costruire intelligenti costrutti filosofici vicini al mercato se questi (i costrutti) sono come il latte per una capra.

Pensa che il lasso di tempo dopo l'accettazione di una perdita sia difficile da formalizzare? O cosa c'è di diverso?

Grazie. Penserò alla SOM a mio piacimento.

L'articolo al link fornisce una panoramica dei metodi di segmentazione delle serie temporali. Fanno tutti più o meno la stessa cosa. Non che SOM sia il miglior metodo per il forex, ma non è neanche il peggiore, questo è un fatto ))

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.115.6594&rep=rep1&type=pdf

I miei colleghi, purtroppo, non mi permettono di dedicare più tempo al trading, ma ho trovato un po' di tempo e ho deciso di chiedere (per il mio interesse, così non lo dimenticherò :o, quindi tornerò più tardi, quando avrò più tempo libero)

L'essenza del fenomeno.

Lasciate che vi ricordi l'essenza di questo fenomeno. È stato scoperto durante l'analisi dell'influenza delle "code lunghe" sulle deviazioni future dei prezzi. Se classifichiamo le code lunghe e guardiamo le serie temporali senza di esse, possiamo osservare alcuni fenomeni curiosi, unici per quasi ogni simbolo. L'essenza del fenomeno è una classificazione molto specifica, basata in qualche modo su un approccio "neurale". In effetti, questa classificazione "scompone" i dati grezzi, cioè il processo di citazione stesso in due sottoprocessi, che sono convenzionalmente chiamati"alfa" e"betta". In generale, il processo iniziale può essere suddiviso in un maggior numero di sottoprocessi.

Sistema con struttura casuale

Questo fenomeno si applica molto bene ai sistemi con struttura casuale. Il modello stesso sembrerà molto semplice. Vediamo un esempio. La serie iniziale EURUSD M15(abbiamo bisogno di un campione lungo, e il più piccolo possibile frame), da qualche "ora":

Passo 1: Classificazione

La classificazione viene eseguita e si ottengono due processi"alfa" e"beta". Si definiscono i parametri del processo master (il processo che si occupa del "montaggio" finale del preventivo)

Passo 2 Identificazione

Per ogni sotto-processo viene definito un modello basato sulla rete Volterry:

Oh, che dolore identificarli.

Passo 3 Previsione del sottoprocesso

Si fa una previsione per 100 conteggi per ogni processo (per 15 minuti, cioè poco più di un giorno).

Passo 4: modellazione della simulazione

Si costruisce un modello di simulazione, che genererà il numero x.o. di implementazioni future. Lo schema del sistema è semplice:

Tre randomizzazioni: un errore per ogni modello e condizioni di transizione del processo. Ecco le realizzazioni stesse (da zero):

Passo 5: La soluzione di trading.

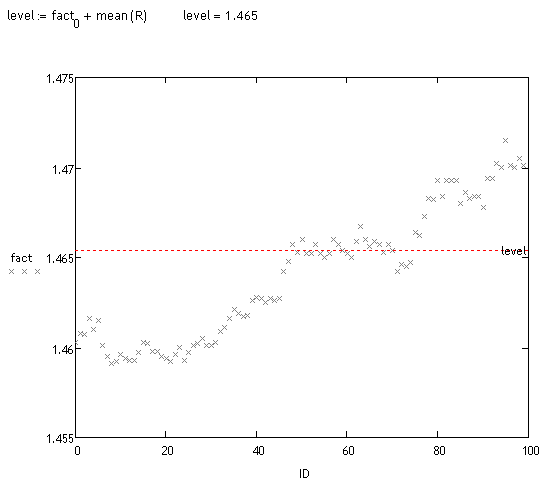

Viene eseguita un'analisi dei bias di queste realizzazioni. Questo può essere fatto in diversi modi. Visivamente possiamo vedere che una grande massa di traiettorie è spostata. Guardiamo il fatto:

<>

Test preliminari

Ha preso circa 70 "misure" a caso (ci vuole molto tempo per contare). Circa il 70% delle deviazioni rilevate dal sistema sono corrette, quindi non ha ancora detto nulla, ma spero di tornare su questa pista in un paio di mesi, anche se non ho ancora finito di lavorare al progetto principale :o(.

a sayfuji

Может не совсем корректно: по какому принципу производится классификация и, собственно, разложение на какие процессы предполагается?

No, è tutto corretto. È stato uno degli argomenti di discussione in diverse decine di pagine di questo thread. Tutto quello che ho ritenuto necessario - l'ho scritto. Purtroppo non ho tempo per sviluppare ulteriormente l'argomento. Inoltre, questo fenomeno in particolare, anche se interessante, non è molto promettente. Il fenomeno delle "code lunghe" appare su orizzonti lunghi, cioè dove ci sono grandi deviazioni delle traiettorie, ma a questo scopo è necessario prevedere lontano i processi alfa e betta (e altri processi). E questo è impossibile. Non esiste una tecnologia simile...

:о(

a tutti

Colleghi, si scopre che ci sono dei post a cui non ho risposto. Perdonami, è inutile cercare di muovermi ora.

Prohwessor Fransfort, risponda per favore quale programma usa per le sue ricerche.

E anche... se qualcuno ha un manuale in russo o un russificatore per il programma http://originlab.com/ (OriginPro 8.5.1)

Un risultato interessante.

Questo fenomeno potrebbe essere dovuto al fatto che i dati storici sono prezzi Bid? (Lambda nell'esperimento è paragonabile allo spread).

Non pensi che abbia più senso testare la qualità del processo di "tendenza" risultante usando la regressione lineare con coefficienti costanti piecewise se visti come funzioni del tempo?

Si possono sommare gli incrementi filtrati e si ottengono due processi: