L'apprendimento automatico nel trading: teoria, modelli, pratica e algo-trading - pagina 2820

Ti stai perdendo delle opportunità di trading:

- App di trading gratuite

- Oltre 8.000 segnali per il copy trading

- Notizie economiche per esplorare i mercati finanziari

Registrazione

Accedi

Accetti la politica del sito e le condizioni d’uso

Se non hai un account, registrati

Aumento del gradiente

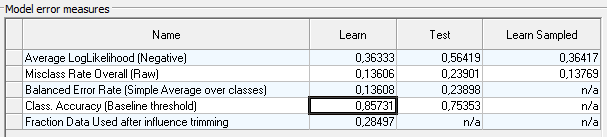

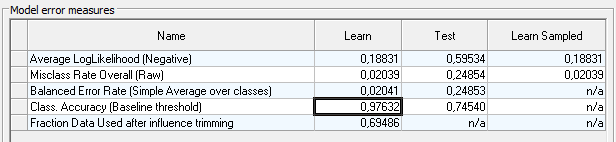

Sulla trayne, l'asscgasusale a 0,85

ma sul test scende a 0,75.

Come opzione per aumentare l'assgassu, si può provare ad approssimare l'influenza delle variabili significative , per ogni classe -1, 0, 1

Per utilizzare queste spline come nuove variabili.

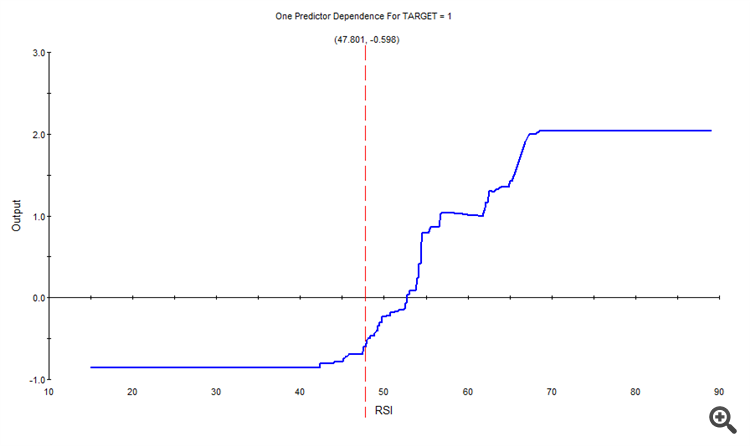

Ad esempio, per la classe 1, l'influenza della RSI era la seguente

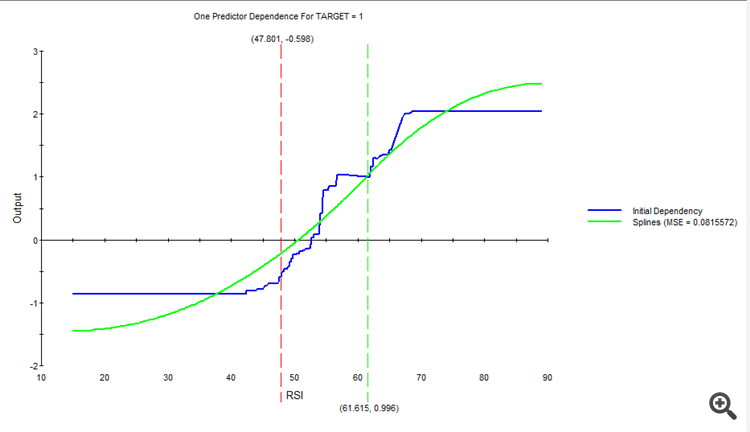

Approssimata, si ottiene una nuova spline.

E così via, per ogni variabile e per ogni classe.

Come risultato, si otterrà un nuovo insieme di spline, da inserire nell'input al posto delle variabili originali.

Incremento del gradiente

sulla traiettoria, il guadagnosale a 0,85

ma scende a 0,75 sul test

Come opzione per aumentare l'asssugasu, si può provare ad approssimare l'effetto delle variabili significative , per ogni classe -1, 0, 1

Per utilizzare queste spline come nuove variabili.

Ad esempio, per la classe 1, l'impatto della RSI è stato il seguente

Approssimando, si ottiene una nuova spline.

E così via, per ogni variabile e per ogni classe.

Come risultato, otteniamo una nuova serie di spline, che inseriamo nell'input al posto delle variabili originali.

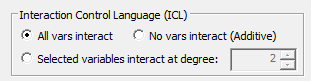

In questi esempi tutte le possibili relazioni tra le variabili sono state impostate automaticamente.

Anche se è possibile disabilitarle, o impostare variabili specifiche per la relazione.

Ho giocato con la messa a punto senza approssimazione, aumentando il numero di nodi per albero al numero di variabili.

Il modello è diventato più complesso, allenato per 12 minuti.

sulla traina assugasuè salito a 0,97

ma il test rovina tutto a 0,74.

In generale, probabilmente c'è qualcosa su cui lavorare e riflettere. Forse qualcosa verrà fuori dai vostridati.

Ci sono molte impostazioni diverse nel programma, solo che non capisco bene come lavorarci.

Sto studiando le funzionalità da ieri))

E il vostro set di dati è venuto fuori per caso, per studiare le funzionalità, beh, forse qualcosa verrà fuori dai vostri dati.

Non capisco bene cosa intendete per costruttore automatico di funzionalità?

Ricerca automatica di funzionalità stesse, o ricerca automatica di relazioni tra funzionalità esistenti?

In questi esempi, tutte le possibili relazioni tra le variabili sono state impostate automaticamente.

Anche se è possibile disattivarle o impostare variabili specifiche per la relazione.

No, non è quello che intendevo.

Intendevo dire che ho addestrato xgboost su altre caratteristiche per ottenere akurasi 0,83 su nuovi dati.

Ho costruito i tratti a partire da OHLC e da un altro indicatore

secondo il principio

O[i] - H[i-1]

L[i-5]-indicatore[i-10]

........

....

..

e così tutte le possibili combinazioni (tutte con tutte).

Ho ottenuto circa 10.000 tratti.

300 di questi sono utili.

il modello ha dato 0,83 sui nuovi dati.

===========

Non capisco bene cosa intendi per costruttore automatico di caratteristiche?

Voglio automatizzare quanto descritto sopra in modo che sia il computer stesso a costruire le caratteristiche, e quindi non ci saranno 10k caratteristiche tra cui scegliere, ma un miliardo per esempio....

Ricerca automatica delle caratteristiche stesse o ricerca automatica delle dipendenze tra le caratteristiche disponibili?

creazione/costruzione automatica di caratteristiche ---> test di idoneità ---> selezione delle migliori ---> eventualmente mutazione delle migliori alla ricerca di altre ancora migliori ....

Ed è tutto automatico.

Basato su MSUA, se lo avete letto... ma solo su di esso....

Ci sono molte impostazioni diverse nel programma, ma non riesco a capire bene come utilizzarle.

Sto solo studiando la funzionalità da ieri ))

E il tuo set di dati, a proposito, per studiare la funzionalità, beh, forse qualcosa e spremere dai tuoi dati.

Che cos'è questo programma?

leggere la probabilitàgeometrica

E' un vero e proprio idiota, che si aggrappa ad ogni parola.

Hai una distrofia cognitiva totale, come puoi discutere di qualcosa?