L'apprentissage automatique dans la négociation : théorie, modèles, pratique et algo-trading - page 623

Vous manquez des opportunités de trading :

- Applications de trading gratuites

- Plus de 8 000 signaux à copier

- Actualités économiques pour explorer les marchés financiers

Inscription

Se connecter

Vous acceptez la politique du site Web et les conditions d'utilisation

Si vous n'avez pas de compte, veuillez vous inscrire

Non, java n'est pas un langage interprété, il est traduisible, comme C#, la traduction se fait une fois, le résultat est un "byte code" qui est exécuté par la machine virtuelle, java et sysharp sont plus lents que C++ de manière non significative, 1 à 2 fois plus lents en fonction de l'algorithme, l'optimisation ne se fait qu'à bas niveau (unsafe), en raison de la gestion des pointeurs et de l'allocation intelligente de la mémoire, lorsque l'on travaille avec des abstractions standard de haut niveau comme les vecteurs, les listes, etc. Les performances sont comparables à celles de Java-C#. Mais python et R perdent par dizaines de fois, parfois par centaines, si vous écrivez des algorithmes natifs, l'interprétation se faisant à chaque fois au moment de l'exécution.

Sélection des caractéristiques

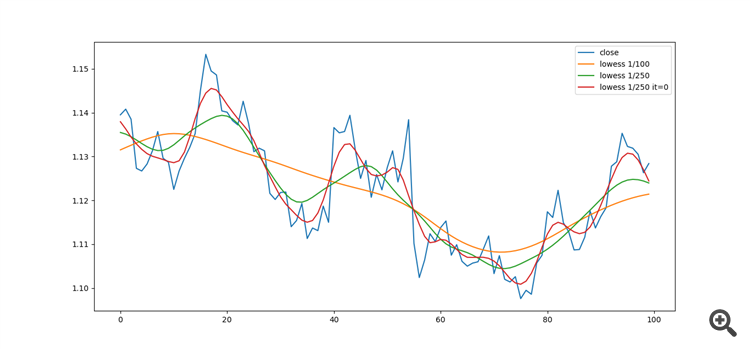

Application de l'algorithme de lissage de Lowess :Pour filtrer les valeurs aberrantes des données.

Delta, dérivée, dérivée logarithmique, detrending avec ema et lowess :

Yuriy Asaulenko:

Je me demande pourquoi pas Python ? Peut-être le même R ? Je ne comprends pas.

Je necomprends pas :

Je ne parlerai pas pour Michael, il est en mesure d'argumenter son choix lui-même, mais je peux suggérer que probablement parce que python et R sont des langages d'interprétation de haut niveau, ils sont comme matlab ou "maths" plutôt que des langages eux-mêmes, c'est très cool à apprendre, mais en production quand vous devez vous battre avec des algorithmes exclusifs, aucune chance, c'est comme gagner la formule 1 sur un scooter.

Quand vous aurez besoin d'écrire du code de production, vous aurez besoin de java ou de c++, donc c'est plus une question de temps, parce que vous devez étudier soit les pros soit java, alors que python et R sont juste "pour le fun".

https://medium.com/deep-learning-turkey/google-colab-free-gpu-tutorial-e113627b9f5d

Je cherche VAR, VECM, le paquet vars, et dedans, comme toujours, les références. Frontières d'entrée par SETAR

Accroché, mais google pour aider - littérature et applications spécifiques ....

Si vous dépassez l'écart, vous pourrez peut-être partager. Il est si beau sans la propagation, il est difficile de le quitter des yeux.

J'ai lu, mais je l'ai déjà fait et montré les incréments, mais je l'ai fait via RF. Je l'ai déjà fait avec RF. Les résidus y sont vraiment plus petits que l'écart, souvent. Avec LR les résidus devraient être plus grands (en pips), parce que RF stocke trop puissamment toutes les dépendances. Mais c'est un sujet intéressant en soi, j'y suis venu intuitivement, sans savoir que de tels modèles ont déjà été inventés :)

Et des exemples de transactions, purement visuels (je n'ai pas encore vérifié avec le robot).

les soldes semblent être normalement distribués, mais une certaine cyclicité n'est pas entièrement retenue

et voici comment le modèle s'effondre sur OOS... il recalcule toutes les 50 barres et s'effondre à nouveau, presque immédiatement :)

Vous ignorez les tests pour une raison quelconque, alors que la cointégration est impensable sans eux. Après tout, l'idée principale de la cointégration est de prendre des décisions de trading sur une série STATIONNAIRE, et une telle série est prévisible, par opposition à une série non stationnaire. Le test fournira la preuve de la prévisibilité sur l'historique.

Eh bien, voyez dans la vidéo comment une série STATIONNAIRE sur l'échantillon d'entraînement se transforme en une série non stationnaire sur l'échantillon d'avance. Pourquoi faire un tas de tests quand on peut tout voir.

Elle est exprimée en écarts types. Sur les nouvelles données, un grand nombre de valeurs aberrantes 3+ apparaissent, ce qui suggère que le modèle vectoriel ne fonctionne pas aussi bien que le modèle standard.

Je ferai une autre représentation un peu plus tard, elle semble déjà un peu plus intéressante :)

Vous ignorez les tests pour une raison quelconque, alors que la cointégration est impensable sans eux. Après tout, l'idée principale de la cointégration est de prendre des décisions de trading sur une série STATIONNAIRE, et une telle série est prévisible, par opposition à une série non stationnaire. Le test fournira la preuve de la prévisibilité sur l'historique.

Disons-le comme ça :

Dans la capture d'écran, le rouge est juste les incréments avec le lag 55 de la paire actuelle, le vert est une approximation... hmm... appelons cela une autorégression vectorielle non linéaire (en utilisant les incréments de la paire actuelle et d'une autre paire de devises (GBPUSD), plusieurs différentes). les incréments prédits avec le lag 55 de la paire actuelle, ne sont bien sûr pas introduits dans l'entrée du modèle, mais seulement dans la sortie.

Tout semble correctdans l'historique .

Plus loin dans la vidéo, nous allons voir comment le modèle fonctionne sur l'avant.

Ce n'était pas très clair dans la vidéo précédente avec les écarts types : on prenait la différence entre 2 courbes et on l'utilisait pour calculer les écarts.