1) La red es capaz de recuperar la función si los datos de entrada la contienen. Si en el último experimento el valor del periodo depende de la volatilidad, entonces la parrilla debería haber dado alguna estimación de esa volatilidad, es decir, puede que no hayas proporcionado todos los datos necesarios para la recuperación.

2)Puedes exprimir todo lo que necesites de MLP. Utilice otras redes cuando pueda demostrar matemáticamente que el uso de otra arquitectura es mejor que el MLP.

3)NS2 - rápido, resultado de calidad, fácil de transferir a cualquier lugar...

El error en la prueba deja de disminuir... Suelo hacer al menos 3-5 entrenamientos, quizás más cuando el resultado es más importante, con selección de neuronas en capas, más precisamente en una capa. unos cuantos entrenamientos para ver la dispersión y el mínimo.

En mi opinión, cuando el error en la prueba deja de disminuir, lo más probable es que se trate de un sobreentrenamiento. ¿Cómo se comporta la red en OOS, con un error tan mínimo en la de prueba?

Si las neuronas se seleccionan correctamente, la red se comporta absolutamente igual que en el entrenamiento, es más, con una muestra de 200 000 se obtiene el mismo resultado con una muestra de entrenamiento mucho más pequeña (más de 5 veces menor).

Es decir, a veces seleccionando neuronas podemos igualar los errores de las muestras de prueba y de entrenamiento.

Si las neuronas se seleccionan de forma incorrecta, el error en la prueba es un poco mayor, pero se mantiene en la muestra "general".

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Usted acepta la política del sitio web y las condiciones de uso

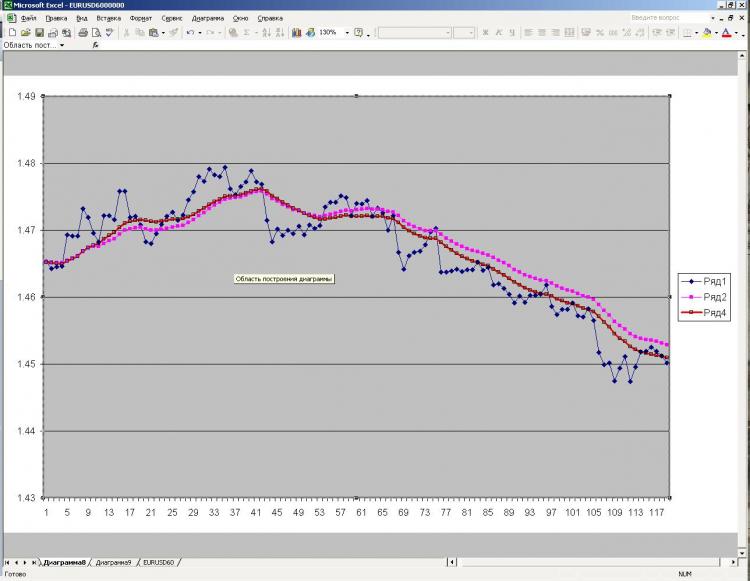

Señores, buenas tardes. Una pregunta para los expertos en el campo de las redes neuronales. La conclusión es la siguiente. Instalé statisctica y comencé mi investigación con redes neuronales automáticas. Perspetrón multicapa. Fija un objetivo para entender la inteligencia de las redes neuronales en la búsqueda de patrones. ¿Qué he hecho? He tomado la media ponderada lineal (LVSS) más habitual de las últimas 20 barras. He dado el último valor de la LSS como objetivo (salida) y los últimos 20 puntos de los que depende el valor actual de la LSS. Evidentemente, una persona que conozca los últimos 20 puntos y la fórmula de cálculo del LVLS sería capaz de restablecer su valor al 100%. La parrilla no conocía la fórmula y su tarea era entenderla a su manera. Resultado: la pila restauró el LVLS en un 100%, es decir, entendió cómo está dispuesto el LVLS. Podemos considerar que ha hecho frente a la tarea perfectamente, es decir, que si hay un patrón, la red lo encuentra realmente. A continuación, se realizó un experimento similar con EMA, SAR y osciladores. El resultado es el mismo. 100%. Después decidí complicar la tarea. Tomé la media adaptativa. Te recuerdo que cambia el parámetro de promediación en función de la volatilidad del mercado. La volatilidad, a su vez, se calcula para una determinada cantidad de barras. Introduzco todas las barras necesarias para construir el ACS y poner en marcha la red. El resultado fue mucho peor que el 100%, aunque una persona que conozca la fórmula del CAC y posea todos los puntos podría construir el CAC al 100%. En realidad la red falló, estamos hablando de redes neuronales automáticas.

Conclusión y preguntas a los expertos en la materia.

1) ¿He entendido bien que una red neuronal es incapaz de reconstruir una función si es intrínsecamente dinámica como en el caso del ACC, aunque tenga todos los datos necesarios para el cálculo, ya que si la fórmula es rígidamente estática como en el caso del LVSS o el EMA, no hay ningún problema.

2) Si me equivoco, ¿qué redes deben utilizarse? Y utilizó MLP en las estadísticas.

3) He oído la opinión de que las redes automáticas y las redes de diseño propio e...., si se me permite decirlo, no hay fundamentalmente mucha diferencia. ¿Es realmente así?

4) ¿Qué redes y qué programas aconsejaría para su aplicación a los mercados financieros, en particular para la tarea que he descrito, es decir, para restablecer los valores a partir de todos los datos conocidos?

Respetuosamente, mrstock