Обсуждение статьи "Популяционные алгоритмы оптимизации: Искусственные мультисоциальные поисковые объекты (artificial Multi-Social search Objects, MSO)"

Теоретический вопрос (можно на практике проверить).

Если добавить в набор фейковый (не участвует в расчетах ФФ) параметр с диапазоном, например, пять значений, будет ли улучшение/ухудшение результатов алгоритма?

Форум по трейдингу, автоматическим торговым системам и тестированию торговых стратегий

fxsaber, 2024.02.15 11:46

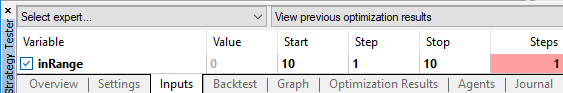

input int inRange = 0; void OnInit() {}

На тему сложности ФФ в виде ТС.

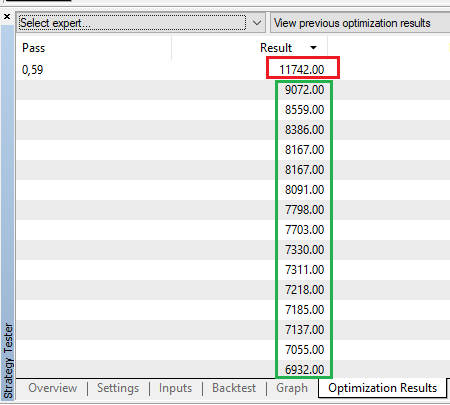

Штатный ГА закончил оптимизацию в зеленой рамке.

Повторный запуска ГА первыми же нащупываниями вышел на значительно лучший результат (красная рамка).

На тему сложности ФФ в виде ТС.

Штатный ГА закончил оптимизацию в зеленой рамке.

Повторный запуска ГА первыми же нащупываниями вышел на значительно лучший результат (красная рамка).

Для штатного ГА многократный запуск является рекомендуемым приемом (не знаю, хорошо это или плохо - есть доводы и за, и против).

Теоретический вопрос (можно на практике проверить).

Если добавить в набор фейковый (не участвует в расчетах ФФ) параметр с диапазоном, например, пять значений, будет ли улучшение/ухудшение результатов алгоритма?

Ухудшатся, однозначно. Запуски фф будут тратиться на бесполезные попытки найти "хорошие" фейковые параметры.

Чем больший процент возможных вариантов фейковых параметров от всего количества возможных вариантов параметров, тем влияние будет сильнее - в пределе стремиться к рандомным результатам.

Ухудшатся, однозначно. Запуски фф будут тратиться на бесполезные попытки найти "хорошие" фейковые параметры.

Чем больший процент возможных вариантов фейковых параметров от всего количества возможных вариантов параметров, тем влияние будет сильнее - в пределе стремиться к рандомным результатам.

Надо будет проверить.

Я бы сказал вернее так, фейковые параметры затрудняют поиск. Но при прочих равных результаты будут хуже. Скажем, делать 1мио прогонов фф, результат будет одинаковым, но если делать 1к запусков, то разница уже будет заметна.

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Вы принимаете политику сайта и условия использования

Опубликована статья Популяционные алгоритмы оптимизации: Искусственные мультисоциальные поисковые объекты (artificial Multi-Social search Objects, MSO):

Продолжение предыдущей статьи как развитие идеи социальных групп. В новой статье исследуется эволюция социальных групп с использованием алгоритмов перемещения и памяти. Результаты помогут понять эволюцию социальных систем и применить их в оптимизации и поиске решений.

В предыдущей статье мы обсудили эволюцию социальных групп, где они перемещались свободно в пространстве поиска. Однако в данной статье мы предлагаем изменить эту концепцию и предположить, что группы перемещаются между секторами, перепрыгивая из одного в другой. Все группы имеют свои центры, которые обновляются на каждой итерации алгоритма. Кроме того, мы вводим понятие памяти как для группы в целом, так и для каждой отдельной частицы в ней. Используя эти изменения, наш алгоритм теперь позволяет группам перемещаться из сектора в сектор, основываясь на информации о лучших решениях.

Эта новая модификация открывает новые возможности для исследования эволюции социальных групп. Переход к секторам позволяет группам обмениваться информацией и опытом внутри каждого сектора, что может привести к более эффективному поиску и адаптации. Введение памяти позволяет группам сохранять информацию о предыдущих перемещениях и использовать ее для принятия решений о будущих перемещениях.

В данной статье мы проведем серию экспериментов, чтобы исследовать, как эти новые концепции влияют на поисковые качества алгоритма. Мы будем анализировать взаимодействие между группами, их способность к сотрудничеству и координации, а также их способность к обучению и адаптации. Наши результаты могут пролить свет на эволюцию социальных систем и помочь лучше понять, как группы формируются, развиваются и приспосабливаются к изменяющейся среде.

Автор: Andrey Dik