Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

(PF-1)*SdDay - ограничения сверху для того, чтоб этот коэффициент не захватил основной объем показателя Vigoda. Чем больше сделок, тем сложнее добиться большой прибыльности.

(PF-1) - делается для того, чтоб при отрицательном показателе баланса, множитель PF тоже был отрицательным. Это идет как первый показатель, по этому следующие должны также влиять на объем общего, и не иметь какой-то свой перевес.

((PipBar+Ust)/10) - при открытии позиции время не в нашу пользу, т.к. рынок может поменяться в любую минуту, и показатель PipBar (теперь я его переделал на PipMin, пункт/мин.) как раз и показывает качество используемого времени, т.е. максимальное кол-во пунктов за минимальное время. Ust - устойчивость также не мало важна, чем выше показатель, тем значит плавнее рост баланса. Деление на 10 выравнивает влияние на общую сумму.

(ProcDay*10)/(MD+(SrD*4)) - соотношение скорости роста баланса к использованным рискам во время этого. Умножения на 10 и 4, также для выравнивания влияния на общий показатель.

Если использовать вместо сложения умножение, то сложнее отбалансировать влияние каждого показателя, от этого итог иногда неоправданно скачет. Поверьте уже все проверено, если один параметр слегка завышен, то при умножении он часто вытягивает общий итог не на ту верхушку.

Я продолжаю корректировать формулу и позже выложу обновления и сравнения...

(PF-1)*SdDay - ограничения сверху для того, чтоб этот коэффициент не захватил основной объем показателя Vigoda. - 1. Указывает на явное использование неверной зависимости от Профит Фактора. Чем больше сделок, тем сложнее добиться большой прибыльности. - 2. Cформулируем по-другому, тем сложнее добится случайного результата с большой прибыльностью.

(PF-1) - делается для того, чтоб при отрицательном показателе баланса, множитель PF тоже был отрицательным. - 3. Отрицательный баланс имеет минус, а профит фактор < 1 - это имеет смысл и методически оправдано. Смысл перегружать одно другим? Это идет как первый показатель, по этому следующие должны также влиять на объем общего, и не иметь какой-то свой перевес. -

((PipBar+Ust)/10) - при открытии позиции время не в нашу пользу, т.к. рынок может поменяться в любую минуту, и показатель PipBar (теперь я его переделал на PipMin, пункт/мин.) как раз и показывает качество используемого времени, т.е. максимальное кол-во пунктов за минимальное время. - 4. Обратная зависимость критерия от длины тестируемого периода проще и понятнее. Ust - устойчивость также не мало важна, чем выше показатель, тем значит плавнее рост баланса. - 5. Прибыль деленая на максимальную просадку никак не вяжется с плавностью роста баланса. Я бы так не называл это. Деление на 10 выравнивает влияние на общую сумму. - 6. Эта 10-ка результат каких-то статистических формульных вычислений или среднепотолочная эмпирика по типу "подогнать примерно"?

(ProcDay*10)/(MD+(SrD*4)) - соотношение скорости роста баланса к использованным рискам во время этого. 4. Обратная зависимость критерия от длины тестируемого периода проще и понятнее. Умножения на 10 и 4, также для выравнивания влияния на общий показатель. - 6. Эти 10-ка и 4-ка результат каких-то статистических формульных вычислений или среднепотолочная эмпирика по типу "подогнать примерно"?

Если использовать вместо сложения умножение, то сложнее отбалансировать влияние каждого показателя, от этого итог иногда неоправданно скачет.Поверьте уже все проверено, если один параметр слегка завышен, то при умножении он часто вытягивает общий итог не на ту верхушку. - 1. Указывает на явное использование неверной зависимости от Профит Фактора, Профита, Максимальной просадки, Длины тестируемого периода.

Я продолжаю корректировать формулу и позже выложу обновления и сравнения...

Давайте я на простом примере покажу, и вы поймете, что ваш подход методологически неверен.

Показатель баланса ценен нам потому, что мы сравниваем его с нашей мечтой - "побольше денег". Баланс и "побольше денег" показатели одной природы, и чем больше баланс, тем он ближе к "побольше денег"

Показатель максимальной просадки ценен нам потому, что мы сравниваем его с нашим кошмарным сном - "пропал депозит". Максимальная просадка и "пропал депозит" снова показатели одной природы, и чем меньше максимальная просадка, тем дальше мы от "пропал депозит".

Показатель профит фактор ценен нам потому, что мы сравниваем в нем сумму всех прибылей с суммой всех убытков. Удиветельно, но факт, сумма всех прибылей и сумма всех убытков - это опять-таки показатели одной природы, и чем больше прибылей и меньше убытков, тем ценнее нам показатель.

Думаю, что вы уже примерно поняли, насколько важно сравнивать (складывать, делить, умножать) однородные показатели. показатели имеющие одну природу. Иначе будет винегрет.

Теперь вернемся к вашему SrD. На его примере, я хочу вам указать, что вводить показатель только потому, что мы умеет считать среднюю просадку по все сделкам настолько же уместно, как и средняя температура пациента. Вы можете объяснить, что добавляет SrD в оценку? На мой взгляд - абсолютно ничего. Просадки 1,11,1,11,1,11,... будут эквивалентны просадкам 6,6,6,6,6,6,.. для вашего SrD. Не думаю, что вы найдете здесь сторонников, которые согласятся с такой оценкой. Особенно, если смерть депозита наступает при просадке 10. Понимаете, чем ценна Максимальная просадка? Она указывает насколько близко от смерти был ваш депозит и жив ли он или мертв на финише. SrD само по себе ни на что не укзаывает, т.к. вы не сравниваете его с показателем такой же природы, а просто вешаете его в воздухе, без оценки, поэтому ценность его - никакая. Если уж вам так хочется ввести что-либо подобное, то попробуйте посчитать SrProfit и сравнивать его с SrD, но не с MD и уж тем более не со скоростью роста баланса.

После того, как у вас будут показатели их надо перемножить. Если для вас один показатель весомее другого, то для него вам необходимо использовать более "мощную" функциию. К примеру, возвести более весомый показатель в квадрат, или взять от менее весомого логарифм, квадратный корень и т.д. и т.п. Это дело вкуса и предпочтений навязать вес показателю при помощи функции. За таким перемножением не стоит никакой статистики, это всего лишь грубое приближение, в котором есть смысл - пропорциональность критерия показателям, которые для вас важны. А вот то, что делате вы - делите прибыль на бары и прибавляете скорости роста деленной на разные просадки, пытаясь нормировать на глаз 10-ми и 4-ками - это было бы правдой, если за вашим расчетом стояла строгая математическая формульность. Пока мест ваша формула не является даже грубым приближением, т.к. в ней нет показателей.

Vita писал(а) >>

Теперь вернемся к вашему SrD. На его примере, я хочу вам указать, что вводить показатель только потому, что мы умеет считать среднюю просадку по все сделкам настолько же уместно, как и средняя температура пациента. Вы можете объяснить, что добавляет SrD в оценку? На мой взгляд - абсолютно ничего. Просадки 1,11,1,11,1,11,... будут эквивалентны просадкам 6,6,6,6,6,6,.. для вашего SrD. Не думаю, что вы найдете здесь сторонников, которые согласятся с такой оценкой. Особенно, если смерть депозита наступает при просадке 10. Понимаете, чем ценна Максимальная просадка? Она указывает насколько близко от смерти был ваш депозит и жив ли он или мертв на финише. SrD само по себе ни на что не укзаывает, т.к. вы не сравниваете его с показателем такой же природы, а просто вешаете его в воздухе, без оценки, поэтому ценность его - никакая. Если уж вам так хочется ввести что-либо подобное, то попробуйте посчитать SrProfit и сравнивать его с SrD, но не с MD и уж тем более не со скоростью роста баланса.

MD - один из самых важных показателей. И наша задача выявить честность этого показателя. Что это значит? Объясняю на примере: предположим у нас два похожих друг на друга прохода, у обоих одинаковая просадка, и все остальное так же где-то рядом, изначально нет принципиальной разницы. На самом деле в одном из проходов просадка подогнана в притирку от опасных сделок (которые не открылись, и мы их не видим), а в другом наоборот просадка в основном маленькая, и только в одной случайной сделке она дошла до такого же уровня. В итоге мы получаем в корне разные два прохода. Если представить что просадка каждой сделки это штриховка, то SrD как раз и определяет плотность и радиус этой штриховки, и наглядно показывает что максимальная просадка к примеру 15% случайно совпала еле вытягиваясь из статистических 25-30% (которые не открылись в миллиметре от сигнала, и мы их не видим) или наоборот случайно проскользнувшая из 5-10% (максимально открытых всех позиций).

PF - также один из самых важных показателей. И оптимизация его может получить запросто, также обходя опасные сделки в миллиметре. По мне так лучше открывать все сделки и получить PF 1.8. Но чтоб видеть все опасные и безопасные сделки, а уж на деле (после оптимизации), немного сузить сигнал и получить PF 2-3. В оптимизации жизнь для ТС должна быть жесткой, а на деле можно и облегчить труд. Тем более что убыточные сделки здесь уже не нужны... "Тяжело в учении - легко в бою" как говориться, вот так должно быть...

PipBar - объясняю важность на примере. Опять же два похожих друг на друга прохода, да же кол-во сделок одинаково. Только в одном проходе сделки в среднем открываются, пол дня межуются, потом закрываются хорошо. В другом открываются, через 5-10минут происходит скачок, и закрываются также в плюсе. Получается одна и та же прибыль, но при кардинально разном использовании времени. Хотя период тестирования у них одинаковый (год к примеру). PipBar - прозрачно показывает качество использованного времени, т.е. ТС занимает деньги у баланса для совершения сделки на минимальный срок с максимальной отдачей!

Об остальном позже напишу...

MD - один из самых важных показателей. И наша задача выявить честность этого показателя. Что это значит? Объясняю на примере: предположим у нас два похожих друг на друга прохода, у обоих одинаковая просадка, и все остальное так же где-то рядом, изначально нет принципиальной разницы. На самом деле в одном из проходов просадка подогнана в притирку от опасных сделок (которые не открылись, и мы их не видим) - прошу пояснить, что такое опасная сделка, которая не открылась и котрую мы не видим, и как её на чистую воду выводит SrD? - а в другом наоборот просадка в основном маленькая, и только в одной случайной сделке она дошла до такого же уровня - уровня опасной сделки, так ведь?. В итоге мы получаем в корне разные два прохода. Если представить что просадка каждой сделки это штриховка, то SrD как раз и определяет плотность и радиус этой штриховки, и наглядно показывает что максимальная просадка к примеру 15% случайно совпала еле вытягиваясь из статистических 25-30% (которые не открылись в миллиметре от сигнала, и мы их не видим) или наоборот случайно проскользнувшая из 5-10% (максимально открытых всех позиций). - Я приводил примеры просадок 1-11-1-11-... против 6-6-6-6-... Я полагаю, что для них SrD одинаковое, но вот первый пример как раз именно тот, который дергает эти ваши опасные сделки, или не так?

PF - также один из самых важных показателей. И оптимизация его может получить запросто, также обходя опасные сделки в миллиметре. По мне так лучше открывать все сделки и получить PF 1.8. Но чтоб видеть все опасные и безопасные сделки, - у вас есть определение опасных и безопасных сделок и когда они открываются? Выше вы их связываете с просадкой. Сложно понять, что это. а уж на деле (после оптимизации), немного сузить сигнал и получить PF 2-3. В оптимизации жизнь для ТС должна быть жесткой, а на деле можно и облегчить труд. Тем более что убыточные сделки здесь уже не нужны... "Тяжело в учении - легко в бою" как говориться, вот так должно быть... - Интуитивно, я понимаю, чего вы желаете добиться. Сомневаюсь, что для оптимизации вы ставите параметр PF=1.8 и он вам делает прогон с PF=1.8, а для работы вы устанавливаете PF=2-3. Нет, конечно, оптимизационные и рабочие варианты отличаются другими параметрами. И вам кажется, что при оптимизационном режиме вы собираете "опасные и безопасные" сделки, убеждаетесь, что все тип-топ, а потом как бы выключаете "опасные" сделки и в уме держите - класс, я осведомлен об "опасных" сделках, я их контролирую, ведь, я их выключил в рабочем варианте, и если они даже возникнут, то они мне не угроза. Это иллюзия. Мне она напоминает анекдот про "Что делаю? Отгоняю крокодилов - Так их отродясь тут не было - Так это потому, что я их так хорошо отгоняю. А по-научному, любое высказывание о любом элементе пустого множества верно. Все что вы не придумаете о сделках, которых не было, которые не открылись в рабочем варианте и в любом другом, - все будет верно. Ваше "лучше открывать все сделки" показывает вам реальность при одном наборе оптимизируемых параметров. "Немного сузить сигнал" - другую реальность, в которой нет сделок из первой. Эти несуществующие сделки, которые не открылись при узком сигнале, существуют только в вашем воображении. И естественно, вы осведомлены о них, что они "существуют", что все под контролем - вы их отпугнули "сузив сигнал". Попробуйте понять, что в условиях "узкого сигнала" неоткрывшихся сделок нет, их свойств мы не знаем, но воображать о них мы можем что угодно. Интуитивно хочется приоткрыть дверь и вглянуть на эти неоткрывшиеся опасные сделки, но приоткрывая дверь - расширяя сигнал, мы меняем реальность. Я бы не тратил время на попытку взвешивания фантомов. Исходите из фактов. Для каждого прогона они свои.

PipBar - объясняю важность на примере. Опять же два похожих друг на друга прохода, да же кол-во сделок одинаково. Только в одном проходе сделки в среднем открываются, пол дня межуются, потом закрываются хорошо. В другом открываются, через 5-10минут происходит скачок, и закрываются также в плюсе. Получается одна и та же прибыль, но при кардинально разном использовании времени. Хотя период тестирования у них одинаковый (год к примеру). PipBar - прозрачно показывает качество использованного времени, т.е. ТС занимает деньги у баланса для совершения сделки на минимальный срок с максимальной отдачей! - Желание понятно, но методологический подход неверен. Расчитайте стоимость денег, которую вы одолжили у депозита на сделку(и) и сравните её с чем-то такой же природы, т.е. снова стоимостью чего вам покажется правильным. Или умножьте обратную величину стоимости на критерий - чем больше стоимость, тем хуже. Так ведь? А вы её к устойчивости прибавляете. То, что вы делаете, это попытка вымучать калибровкой коэффициентов критерий по вот такому типу: максимальная скорость/стоимость авто + количество подушек безопасности / расход топлива на 100 км + мощность /% по кредиту

Об остальном позже напишу...

Первый вопрос, на который мы хотим ответить при оптимизации с постоянным лотом, какой уровень просадки следует ожидать от ТС. Допустим, уровень просадки равен 30% от начального депозита. Как реализовать на практике этот критерий, чтобы в процессе оптимизации лишние варианты отсеивались? Например так:

После оптимизации получаем выборку вариантов, которую переносим в Эксель. Сортируем по критерию - фактор восстановления (прибыль/максимальная просадка).

Второй вопрос, какой вариант использовать в реальной торговле? Допустим, лучший вариант дает просадку в 10%. Мы допускаем просадку в 3 раза больше, т.е объем сделки можем увеличить в 3 раза. Но... В дальнейшем параметры, выбранного вараинта, могут ухудшится. Как правило, так и происходит.

Тогда вместо одного варианта, мы можем использовать одновременно группу вараинтов с объемом сделки равной единичному лоту (0.01, 0.1, 1 и т.д.). При этом ставим ограничение на количество одновременно открытых сделок. Например, мы поставили торговать 20 экспертов, при этом может быть открыто только 3 позиции с единичным объемом. Перед открытием позиции ставим проверку:

Т.о. перераспределяем вероятность получения потенциальной просадки в 30% от начального депозита на 20 экспертов вместо одного.

Теперь задача выбрать эти 20 экспертов? Просто взять 20 лучших вариантов - плохое решение. Ведь многие варианты имеют одинаковое количество сделок за период оптимизации, т.е работают синхронно. Поэтому сортируем по количеству сделок и по фактору восстановления. В каждой группе выбираем лучший вариант.

Для меня "Критерий автоматического отбора результатов оптимизации." это время, т.е. на любых временных интервалах система должна быть стабильна.

Рынок динамичен, напрашивается вывод о динамичности выходных данных оптимизации и невозможности авто отбора по ним.

Если атс выявляет высокую волитильность рынка и переходит в режим интрадэй то как быть с авто отбором?

Допустим второе полугодие 2008 года (01.08.2008-01.01.2009) оптимизация не имеет смысла, атс с одной МА будет прибыльным.

Выборка трендовых и не трендовых временных интервалов это как вариант (предпочитаю фиксированную двухнедельную оптимизацию).

Как добиться стабильности?

Мой критерий отбора состоит в стабильности. Попробуйте изменить подход, я делаю это примерно так:

Полугодия, 12 независимых оптимизаций, на М5 вполне достаточно.

Как правило, остается не более 50 вариантов параметров, которые впрочем то будут выделять примерно 2-3 “одинаковых” пакетов настроек.

Отбор результатов оптимизации по пф или кс напрямую связано с методикой написания алгоритма АТС.

Человеку чтобы научиться ходить необходимо время, боксеру сначала нужно пройти не один турнир чтобы претендовать на звание на это нужно время…

Есть статья которая поможет в сортировке данных и прогоне отобранных вариантов параметров на любых отрезках времени.

Приветствую всех!

Тема ветки и другие вопросы по использованию результатов оптимизации, безусловно, крайне важны для любого трейдера.

Мой вопрос адресован не только авторам, которые процитированны ниже....

Анализ, полученного - это, наверное, только ручками, как кто-то здесь сказал: "самая совершенная нейросеть одна, - голова"

Но считаю, что результаты, как психологический, так и фактический того стоят.

Без ложной скромности), замечу, что достиг определенных успехов при выборе результата оптимизации руками. Однако, автоматизировать этот процесс никак не получается. Наверно, это просто плохо формализуемый опыт.

пока тестовый вариант, но показатели уже радуют...

Ну вот, умолили мой суперпростой, но сверхэффективный критерий ;)

Зря тема затихла. Вопрос-то в воздухе так и завис. Поюзав намного некоторое количество прибыльных на "тупой" (однопроходной) оптимизации экспертов, а далее сливающих если не на форвардах, то на демо, если не на демо, то на реале, понял, что пока этот вопрос для себя не решу - дальше не двинусь.... некуда :)

..............

Если вижу что стоит, то провожу группировку наборов - 2, от силы три и окончательную оптимизацию по всему интервалу......выбираю лучшее, а дальше Демо.... без гарантий, статистики пока нет :)

...............................................

Этот пост от 04.10.2008 12:05 Статистика уже должна появиться!!!

Судя по постам, все более или менее удовлетворены своими критериями и результами отбора Финального Набора Параметров (ФНП).

.............................

Итак, постановка вопроса:

Допустим есть некая ТС, которую оптимизируем на 3-х недельной истории, затем отбираем ФНП по результатам оптимизации, далее на неделю на реал (или OOS), в течении недели ФНП не изменяется, в конце недели фиксируем результат.

Таким образом повторяем 52 цикла(недели), со сдвигом на неделю вперёд, т.е. 1 год.

Успехом считаем если результат недельной торговли(тестирования) положителен или равен нулю.

Вопрос: Какое количество успехов получится в результате применения Ваших критериев и методик отбора финального набора параметров?

Вопрос задаю, т.к. сам плотно занимался поиском методики отбора ФНП по результатам оптимизации.

Свой опыт по данной теме обязательно опишу чуть позже.

Приветствую всех!

Ну, ладно, пока вы все прячетесь, у меня появилось время рассказать свою историю.

.............

После того, как пришло понимание, что а) рынок изменчив, б) создать советника приносящего прибыль при стационарных параметрах длительное время - не удастся, в) ... другие важные понимания,

была поставлена задача: научится отбирать среди результатов оптимизации советника такой Финальный Набор Параметров (ФНП), применение которого статистически достоверно давало бы положительное матожидание.

Вроде все понятно, но на всякий случай поясню примером из предыдущего поста:

Таким образом повторяем 52 цикла(недели), со сдвигом на неделю вперёд, т.е. 1 год.

Успехом считаем если результат недельной торговли(тестирования) положителен или равен нулю.

т.е. если из 52 недель результаты 40-ка оказались успешными и средний убыток среди 12-ти неудачных недель составил, например 1126 у.е.,

а средняя прибыльная неделя вышла равной - 1777 у.е., то считаем, что задача нами решена на отлично.

(Понимаем, что лучше иметь результаты выборки в 520 недель или 5200. Но имеем основания предполагать, что и на выборках такого размера пропорции нашего результата не изменяются)

.........

Согласитесь, что задача серьезная. Покруче, чем грааль отыскать, т.к. теоретически, по данной методике, можно использовать любую МТС. Об этом же нам пишет и топик-стартер.

Техническая сторона вопроса решена была таким образом:

- к советнику прикручиваются расчеты различных критериев. Стандартные из отчета МТ, плюс например максимальная достигнутая прибыль, время её достижения в % от времени теста, расширенный Z-cчёт, среднее время сделки на бай и на селл, время нахождения в бай и селл в в % от времени теста и т.д., и т.п. Короче, чем больше, тем лучше. Лишней информации - не бывает. (имею ввиду инфу о своих сделках ;-)) )

- к советнику прикручивается функционал IsBackTestingTime.mqh Copyright © 2008, Nikolay Kositsin. У меня он переделан, но суть похожа. Буду использовать предыдущий пример: допустим у советника опттимизируется два параметра по десять значений каждый и ещё один - три значения. Задав необходимые нам длительности периодов оптимизации и тестирования, а так же сдвиг этих периодов, за выполнение одной полной (без ГА) оптимизации мы получим 31200 = 300*52 + 300*52 проходов, т.е. 52-е подгруппы состоящих из 300 проходов на оптимизационном периоде и 300 проходов на тестовом (относительно предыдущих проходов периоде). Статья Н.Косицина и картинки там есть

Я отлучусь не надолго, потом продолжу....

Вы пока выходите из укрытий, хватит прятаться.... ))

- по-проходно (из deinit) записываем все внешние параметры советника и необходимые нам критерии в csv файл.

- по окончании оптимизации загружаю его в Excel, и через минуту имеем отформатированный и готовый к употреблению xls файл со всеми проходами.

И вот тут встает вопрос, а что делать дальше со всем этим "богатством"?

Решил для начала автоматизировать процесс выбора ФНП по моделям которые уже примерно описывались в этой, да и в других ветках. Например:

Берем 1-у подгруппу оптимизационные проходы с 1-го по 300-й

1. Сделок меньше 50 - отфильтровываем (осталось 220)

2. ПрофитФактор меньше 2 - отфильтровываем (осталось 78)

3. Прибыль меньше 30% или больше 70% (берем серединку) - отфильтровываем (осталось 33)

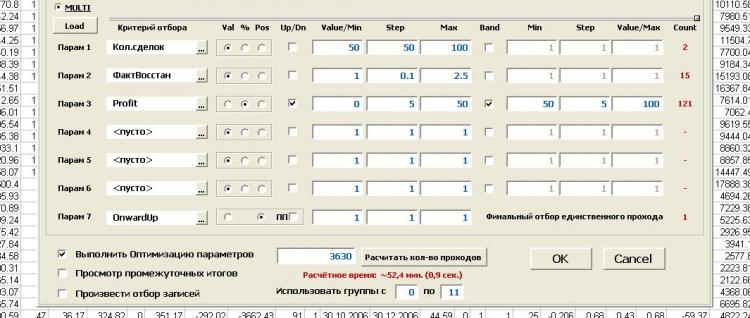

.... всего можно обработать 6 критериев с фильтрами по абс.значению, по относительному значению (%), по номеру позиции. Фильтры двух типов - полосный (внутри, снаружи) и граничный (больше, меньше)

7. Отбираем непосредственно ФНП. Например, им будет набор у которого критерий отвечающий за прямолинейность кривой баланса имеет максимальное значение.

Теперь по имеющемуся номеру прохода ФНП находим соответствующий ему проход в тестовой трехсотке проходов этой подгруппы (как бы OoS) и фиксируем профит.

И так для каждой подгруппы.

В итоге получаем отчет о проделанной работе с графиком баланса и показателями по-недельных (в этом случае) "сделок". Вроде все гламурно. Но...

Результат:

Никаких устойчивых закономерностей в методах отбора мне обнаружить не удалось. Вроде бы и все хорошо, но что-то не так. Не верю!!! (как говорил великий...)

В тоже время верится что потенциал у этого подхода есть и он огромен.

Я занимался этим вопросом не продолжительное время и тестил лишь одну стратегию (Сейчас пытаюсь вспомнить куда и почему меня понесло после разработки этой темы....)

Вопросы:

1. Как вы считаете: Может быть не каждая ТС годится для подобных обработок? т.е. есть более устойчивые во времени и какой ввести критерий этой устойчивости, что бы сразу определять - Наша ТС/Не наша ТС.

2. Что здесь сделано не так? Может кто-то видит другие подходы?

3. Хотелось бы всё таки услышать о ваших результатах. Вопрос уже задан в первом моём посте(у) на этой странице

Предложение:

Коллективно выбрать одну готовую стратегию (уже отлаженную МТС или от вызывающего доверия автора, предлагайте) и опять же коллективно попытаться решить поставленную задачу (или хотя бы приблизиться к решению)

используя описанный мной функционал (но я не настаиваю можно и другой, подобный - предлагайте).

Результаты тестов будут выкладываться здесь или не здесь, решить можно опять же совместно.

Можно открыть новую ветку, как скажете.

Лишь бы были результаты и эта тема не угасала и развивалась.

Дополнение.

1. Инструмент довольно гибкий. Позволяет формализовать любые методики по отбору результатов оптимизации. Имхо, конечно.

2. Совсем не сказал, что имеется функционал по оптимизации методов поиска финального набора параметров, т.е. типа оптимизация параметров оптимизации. Выбираем диапазон и шаг для каждого критерия, а также тип границы и режим работы фильтра, и запускаем оптимизацию. Лучше ведь один раз увидеть, чем...

Вот вроде и всё.

ПС. "Во какая ботва, прикинь... Не до смеха... " (с) УмаТурман