- Vous devez toujours définir le bon objectif/la bonne question pour l'étude.

- L'apprentissage automatique dans la négociation : théorie, modèles, pratique et algo-trading

- Qu'est-ce qu'une tendance ?

Supposons que nous voyons une caractéristique intéressante sur le graphique et que nous supposons qu'il s'agit d'un modèle qui peut être utilisé pour créer un conseiller expert rentable. Ainsi, si un conseiller expert qui utilise ce modèle attendu affiche des bénéfices sans aucune optimisation lorsqu'il est testé sur une longue période, nous pouvons considérer qu'il s'agit d'un modèle réel avec une forte probabilité.

À mon avis, il existe un spectre de régularités que j'identifierais d'une certaine manière.

Supposons que vous ayez un historique de l'intensité du facteur (appelons-le F1), qui provoque une variation de prix tout à fait naturelle. Vous devez filtrer l'historique des prix pour qu'il corresponde clairement à l'historique de ce facteur après filtrage (par le filtre que nous désignons par C1). Alors le prix qui sera filtré par C1 vous donnera une image de son mouvement régulier C1, associé à l'action de F1.

Déterminez tous les autres facteurs importants pour la fixation des prix (Ф2, ..., Фn) et trouvez leurs filtres correspondants (С2, ..., Сn), ce qui donnera un spectre de mouvements de prix réguliers (Ц1, ..., Цn).

Il est stupide de chercher un modèle au hasard. Toute régularité doit être fondée sur une théorie, justifiée par la logique du déroulement des processus ou des hypothèses fondées sur l'analyse des résultats d'observation, ou sur un postulat plausible. Par conséquent, toute régularité doit être recherchée consciemment, en s'attendant approximativement à ce qu'elle apparaisse. Par conséquent, la recherche d'un modèle est un travail minutieux et épuisant et doit commencer par la formulation des positions susmentionnées. Au cours de ces 8 dernières années de recherche, je n'ai réussi à formuler que 3 hypothèses dans lesquelles j'ai pu trouver 3 régularités qui ont conduit à des résultats positifs. Mais tous ont confirmé mon hypothèse selon laquelle, sur un marché aussi parfait que le Forex, il est impossible d'obtenir des résultats exceptionnels. Les bénéfices fluctuent entre 10 et 15 % par an, et ce, lorsqu'ils sont composés sur 10 à 20 ans. Il n'est même pas possible de garantir un bénéfice dans ces limites pour une année spécifique, prise au hasard, dans l'histoire. Conclusion - il est en principe impossible d'obtenir un bénéfice stable et garanti sur le marché, bien supérieur à celui d'une banque, car le Forex est avant tout un instrument interbancaire. D'un autre côté, il s'agit de mon opinion personnelle et je ne l'impose en aucun cas aux autres chercheurs de marché et évaluateurs de rake. Je leur souhaite bonne chance pour trouver de meilleurs résultats.

Et les 3 théories que j'ai développées et recherchées sont connues de tous :

1. Le modèle de régression universel pour prédire le prix du marché https://www.mql5.com/ru/articles/250 ;

2. la théorie du marché https://www.mql5.com/ru/articles/1825 ;

3. Analyse des forces haussières et baissières https://www.mql5.com/ru/code/19139 ,https://www.mql5.com/ru/code/19142.

- www.mql5.com

Un de mes articles récents présente un aspect similaire - l'exploration de la déviation du prix par rapport à l'errance aléatoire après les écarts.

Un de mes articles récents présente un aspect similaire - l'exploration de la déviation du prix par rapport à l'errance aléatoire après les écarts.

Alexey, excellent article en rapport avec le problème de la recherche de modèles, notamment la conclusion sobre sur le profit insignifiant, qui coïncide avec mes conclusions. Cherchons de nouvelles directions dans ce voyage. Merci pour le lien.

Un de mes articles récents présente un aspect similaire - l'exploration de la déviation du prix par rapport à l'errance aléatoire après les écarts.

Alexei. Merci, je l'ai déjà lu et me suis familiarisé avec les résultats et les méthodes, ainsi qu'avec votre article précédent sur l'estimation des risques.

Je suis particulièrement proche de votre méthode décrite de marche aléatoire des prix, car dans ma question (post), je parle exactement de cette caractéristique.

Mais pour appliquer votre méthode comme un pochoir à la décision du problème, je ne pense pas encore comment, et fondamentalement et dans l'expérience appliquée, je ne suis pas si fortement savvy que vous, que fiable et rapide pour résoudre ce problème.

Dites-moi Alexey, si je vous fournis un algorithme qui, selon moi, crée une probabilité de 50/50% de deviner l'événement, évaluerez-vous sa crédibilité ou sa non-fiabilité ?

Mon algorithme pour trouver un prix fonctionne sur le principe d'un théoricien, mais il garantit la répétabilité du résultat dans l'ensemble de l'échantillon de l'histoire, ainsi que dans certaines parties de celui-ci.

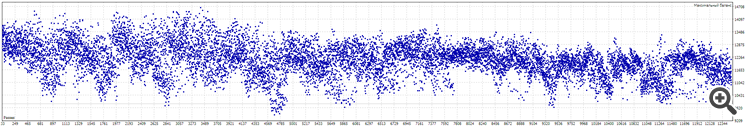

Ça ressemble à ça :

L'algorithme ne comporte que trois variables : SL, TP et Market Entry Point.

Je fixe une certaine fourchette de valeurs pour chacune de ces variables afin de dissoudre/moyenniser l'influence de l'ajustement.

SL de 40 à 70

TP de 40 à 70

Point d'entrée sur le marché de 0 à 12.

Total de 12 493 variables.

Résultats des tests sur l'historique de 10 ans :

Tâche.

Identifier/prouver : Ce résultat est-il purement un ajustement ou existe-t-il un algorithme où la probabilité de résultats aléatoires et indépendants peut être supérieure à 50/50.

Alexey. Le ferez-vous ?

Je suis sceptique quant à mes résultats, je suppose qu'ils ont été causés par une erreur dans le code ou des conditions logiques, mais depuis une semaine entière je ne trouve ni l'un ni l'autre.

Aide... Et le diamant de votre générosité brillera dans l'écrin de ma gratitude).

Identifier/prouver : ce résultat est-il purement un ajustement, ou existe-t-il un algorithme dans lequel la probabilité de résultats aléatoires et indépendants peut être supérieure à 50/50.

Pour savoir s'il s'agit d'un ajustement ou non, vérifiez sur l'avant

Supposons que nous voyons une caractéristique intéressante sur un graphique et supposons qu'il s'agit d'une régularité et qu'elle peut être utilisée pour créer un conseiller expert rentable. Ainsi, si un conseiller expert qui utilise ce modèle attendu affiche des bénéfices sans aucune optimisation lorsqu'il est testé sur une longue période, nous pouvons considérer qu'il s'agit d'un modèle réel avec une forte probabilité.

Eh bien cette méthode est claire pour moi, mais elle ne le prouve pas de manière fiable, elle ne fait que créer des conditions de probabilité... plus/moins.

Merci quand même)

Je me suis soudain souvenu de la définition de Platon de ce qu'est un être humain :

On demanda un jour aux disciples de l'ancien philosophe grec Platon de définir l'homme, ce à quoi il répondit :

"L'homme est un animal avec deux jambes et sans plumes." Cependant, après que Diogène de Sinop..,

Diogène de Sinop a apporté un coq déplumé à l'Académie et l'a présenté comme l'homme de Platon,

Platon a dû ajouter à sa définition : "Et avec des ongles plats".

)))

Pour savoir s'il est adapté ou non, vérifiez sur l'avant.

Je devrais essayer... Mais je ne comprends pas vraiment l'utilité de Forward.

Si je comprends bien, la retransmission prend une partie de l'histoire et en fait un tirage supplémentaire...

Mais si j'utilise déjà l'ensemble de l'histoire (de qualité) dans le test, cela a-t-il un sens d'avancer ?

Je devrais essayer... Mais je ne comprends pas vraiment l'utilité de Forward.

Si je comprends bien, alors le forwarding va prendre une partie de l'historique et lancer une exécution supplémentaire dessus...

Mais si je suis déjà dans le test en utilisant toute l'histoire (de qualité), alors cela vaut-il la peine d'avancer ?

Si la rentabilité de la stratégie est préservée sur le forward, alors nous avons trouvé un modèle, sinon, il s'agit simplement d'un ajustement à l'histoire.

- Applications de trading gratuites

- Plus de 8 000 signaux à copier

- Actualités économiques pour explorer les marchés financiers

Vous acceptez la politique du site Web et les conditions d'utilisation