L'apprentissage automatique dans la négociation : théorie, modèles, pratique et algo-trading - page 2820

Vous manquez des opportunités de trading :

- Applications de trading gratuites

- Plus de 8 000 signaux à copier

- Actualités économiques pour explorer les marchés financiers

Inscription

Se connecter

Vous acceptez la politique du site Web et les conditions d'utilisation

Si vous n'avez pas de compte, veuillez vous inscrire

Renforcement du gradient

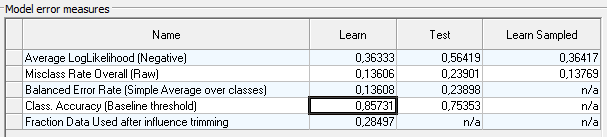

sur le trayne, l'asscgasumonte à 0,85

mais sur le test, il descend à 0,75.

Comme option pour augmenter l'assgassu, vous pouvez essayer d'approximer l'influence des variables significatives , pour chaque classe -1, 0, 1

. Utiliser ces splines comme nouvelles variables.

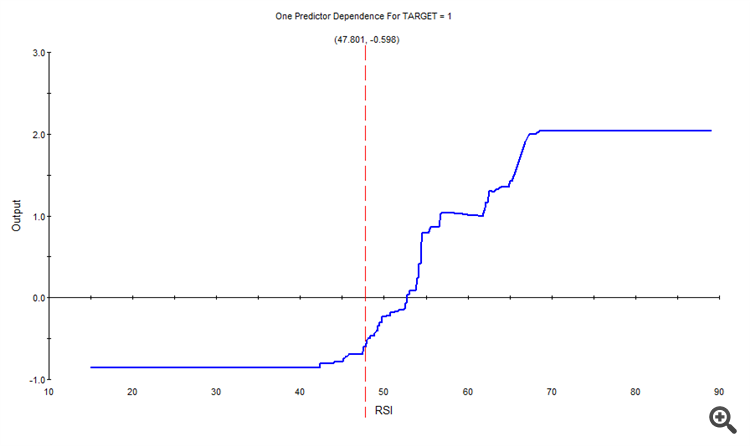

Par exemple, pour la classe 1, l'influence de RSI était la suivante

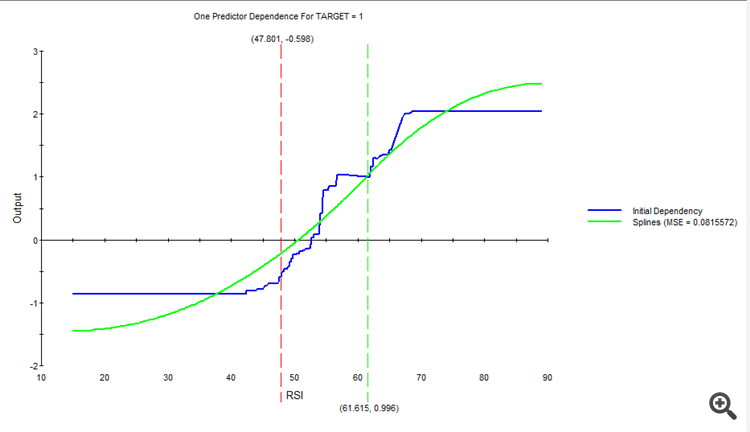

Approximée, on obtient une nouvelle spline.

Et ainsi de suite, pour chaque variable et chaque classe.

On obtient ainsi un nouvel ensemble de splines que l'on introduit dans l'entrée à la place des variables d'origine.

Renforcement du gradient

sur le stagiaire, le gainpasse à 0,85

mais tombe à 0,75 sur le test

Comme option pour augmenter l'asssugasu, vous pouvez essayer d'approximer l'effet des variables significatives , pour chaque classe -1, 0, 1

Pour utiliser ces splines comme de nouvelles variables.

Par exemple, pour la classe 1, l'impact du RSI était le suivant

En faisant une approximation, nous obtenons une nouvelle spline.

Et ainsi de suite, pour chaque variable et chaque classe.

En conséquence, nous obtenons un nouvel ensemble de splines, que nous introduisons dans l'entrée à la place des variables d'origine.

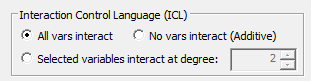

Dans ces exemples, toutes les relations possibles entre les variables ont été définies automatiquement.

Bien que vous puissiez les désactiver ou définir des variables spécifiques pour la relation.

J'ai joué avec le réglage sans approximation, en augmentant le nombre de nœuds par arbre au nombre de variables.

Le modèle est devenu plus complexe, entraîné pendant 12 minutes.

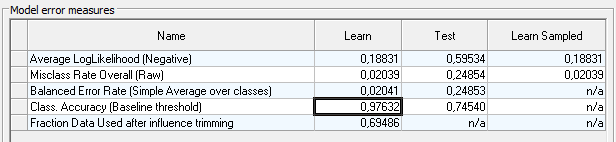

sur le traine assugasua augmenté à 0,97

mais le test gâche tout à 0,74.

En général, il y a probablement quelque chose à travailler et à penser. Peut-être que quelque chose sortira de vosdonnées.

Il y a beaucoup de paramètres différents dans le programme, mais je ne comprends pas très bien comment les utiliser.

J'étudie la fonctionnalité moi-même depuis hier ))

Et votre ensemble de données est apparu par hasard, pour étudier la fonctionnalité, eh bien, peut-être que quelque chose sortira de vos données.

Je ne comprends pas très bien ce que vous entendez par constructeur automatique de caractéristiques ?

Recherche automatique des caractéristiques elles-mêmes, ou recherche automatique des relations entre les caractéristiques existantes ?

Dans ces exemples, toutes les relations possibles entre les variables ont été définies automatiquement.

Bien que vous puissiez les désactiver ou définir des variables spécifiques pour la relation.

Non, ce n'est pas ce que je voulais dire.

Je voulais dire que j'ai entraîné xgboost sur d'autres caractéristiques pour obtenir akurasi 0,83 sur de nouvelles données.

J'ai construit les traits à partir de OHLC et d'un autre indicateur

selon le principe

O[i] - H[i-1]

L[i-5]-indic[i-10]

........

....

..

et donc toutes les combinaisons possibles (tous avec tous).

J'ai obtenu environ 10 000 traits.

300 d'entre eux sont utiles.

Le modèle a donné 0,83 sur les nouvelles données.

===========

Je ne comprends pas bien ce que vous entendez par un constructeur automatique de traits ?

Je veux automatiser ce qui est décrit ci-dessus pour que l'ordinateur construise lui-même les caractéristiques, et il n'y aura pas 10k caractéristiques à choisir, mais un milliard par exemple....

Recherche automatique des caractéristiques elles-mêmes, ou recherche automatique des dépendances entre les caractéristiques disponibles ?

création/construction automatique de caractéristiques ---> test d'adéquation ---> sélection des meilleures ---> éventuellement mutation des meilleures à la recherche de caractéristiques encore meilleures ....

Et tout cela est automatique.

Basé sur MSUA, si vous l'avez lu... mais seulement basé sur MSUA....

Il y a beaucoup de paramètres différents dans le prog, mais je ne comprends pas très bien comment les utiliser.

J'étudie les fonctionnalités moi-même depuis hier ))

Et votre ensemble de données, juste en passant, pour étudier les fonctionnalités, eh bien, peut-être quelque chose et tirer parti de vos données.

Quel est ce programme ?

lire les probabilitésgéométriques

C'est une vraie souche, qui s'accroche à chaque mot.

Vous souffrez d'une dystrophie cognitive totale, comment pouvez-vous discuter de quoi que ce soit ?