Aprendizaje automático en el trading: teoría, práctica, operaciones y más - página 2474

Está perdiendo oportunidades comerciales:

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Registro

Entrada

Usted acepta la política del sitio web y las condiciones de uso

Si no tiene cuenta de usuario, regístrese

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Aquí hay algo de verdad, pero he comprobado mi modelo, lo principal es saber con qué delantero contamos....

No lo entiendo muy bien, pero es mi problema, no he estudiado bien, me fijo un poco en los algoritmos para el trading, más en las reglas asociales y en las reglas de búsqueda genética o en las fórmulas, como la regresión simbólica, etc. Pero si has conseguido hacer funcionar modelos sencillos con datos nuevos, es muy interesante saberlo...

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Gracias por leer...

A mí también me encanta Maitreid, he visto su vídeo probablemente 8 veces, ni una sola palabra de más...

En cuanto a lo del maniquí, creo que es mucho más sencillo: la bolsa vive con la comisión, y si la mayoría de la gente quiere comprar, y esta compra solicita por debajo del precio actual, a la bolsa le sale rentable satisfacer a los compradores porque son más, por lo que la comisión (dinero) puede ganar más, por lo que el precio baja y viceversa con los vendedores...

Cómo lo hace, sólo imprime el precio o manipula el bombo o algo más no lo sé, pero creo que el resultado final es el mismo...

Por eso el precio va en contra de las posiciones de los participantes.

No te entiendo muy bien, pero es mi problema que no estudié bien, miro un poco diferente para los algoritmos de comercio, más hacia las reglas asociales y las reglas de búsqueda genética o fórmulas, como la regresión simbólica, etc. Pero si lograste hacer que los modelos regulares funcionen en nuevos datos, es muy interesante escucharlo.

Sí lo tengo, la calidad no es como en la parcela de formación, pero siempre parte de esa calidad se mantiene, y en mi investigación hacia adelante de 10 años de historia puede ser de hasta un año, en promedio 2-3 meses funciona para una calidad bastante buena, en relación con la parcela de formación por ciento 60-70 en promedio probablemente. Una red neuronal dará mejores resultados, pero ya hay que añadir estos criterios de reentrenamiento, introducir datos combinados algo así como pesos, dar cierto peso a la cantidad de datos, luego calidad del backsest final por ejemplo expectativa o profitka y por supuesto complejidad del algoritmo final, que resultó ( cantidad de todos los pesos de todos los perceptrones por ejemplo). Para conseguirlo en una red neuronal, el tipo de neuronas debe ser lo más diferente posible, y el número de capas y su composición deben ser arbitrarios, en ese caso es posible. Básicamente todo el mundo utiliza redes neuronales de arquitectura fija, pero por alguna razón no entienden que la arquitectura también debe ser flexible, al destruir esta flexibilidad destruimos la posibilidad de minimizar el reentrenamiento. En general, el mismo criterio se puede aplicar, por supuesto, a los modelos simples, incluso es necesario, entonces usted va a obtener un buen avance, mi modelo da un par de meses de beneficio por delante y los ajustes pueden ser actualizados en un día. Uno de los principales trucos es tomar la mayor cantidad de datos posible (10 años de historia o más), en este caso se buscan patrones globales, y se basan en la física del mercado y en la mayoría de los casos siguen funcionando durante mucho tiempo.

Lo hice, la calidad no es.....

Necesito hierro fuerte, tengo el techo de hierro, pero hay una solución a este problema.

Si no lo has leído, te gustará, seguro que tiene ideas interesantes sobre los criterios de calidad del modelo.

Necesito hierro fuerte, yo también tengo problemas con el hardware, pero hay una solución a este problema.

Realmente necesito servidores) pero no los tengo (acabo de hacer todo esto en netbook muerto), necesito mucho y doloroso tiempo para leer. Pero en sí mismo no hay otra manera, o se toma el poder de alguna parte y se cargan con fuerza, en este caso, usted tiene que comprobar 20-30 configuraciones por lo menos, y mejor cerca de cien, y para cada señal de colgar y monitorear, más estable que pasará una selección natural y salir, a continuación, tratar de añadir más potencia. No hay otro camino, de lo contrario es sólo un camino a ninguna parte, como muchos ya han escrito aquí... Realmente puede extenderse durante muchos años sin saber dónde cavar. La alternativa es una licenciatura en ciencias del foro y charlar sobre las fases de la luna y su influencia en el mercado en el espíritu de los espectáculos de Prokopenko ))). ¿Cuál es la solución si no es un secreto?

¿Cuál es la solución, si no es un secreto?

En el libro que he enlazado, la solución se describe de forma más inteligente... Realmente recomiendo su lectura...

En términos sencillos, la solución es elemental: hay que dividir el problema, por ejemplo, agrupar los datos y entrenar modelos diferentes para cada grupo.

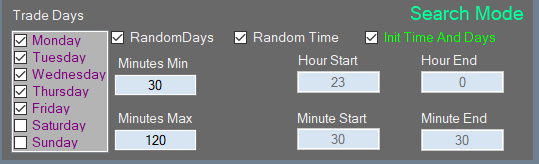

O un ejemplo aún más simple: Hay 5 días de negociación en una semana, por lo que entrenamos un modelo diariamente para los lunes, el segundo para los martes, etc. Entonces hemos reducido la muestra de entrenamiento 5 veces y tenemos 2 años de entrenamiento, no 10 años, y así depende de nuestra imaginación.

El libro que he enlazado describe esta solución de forma más inteligente... Realmente recomiendo su lectura...

En términos sencillos, la solución es elemental: hay que dividir el problema, por ejemplo, agrupar los datos y entrenar modelos diferentes para cada grupo.

O incluso un ejemplo más simple: en una semana de 5 días de negociación, entrenamos un modelo estrictamente para los lunes, el segundo para los martes, etc. Resultó reducir la muestra de entrenamiento de 5 veces y ya 10 años, y 2 años de entrenamiento, y así sucesivamente es la imaginación ...

No lo he leído, pero está todo implementado, yo lo hice por la misma razón, necesitaba reducir el tamaño de la muestra pero poder analizar en profundidad la historia, pero lo hice experimentalmente cuando entendí que no soy lo suficientemente fuerte en mi ordenador y puedo hacerlo mejor )))), además de multithreading y cosas así... todo para sacarle el máximo partido.

No lo he leído, pero ya está implementado en mi casa. Yo lo hice por la misma razón, tenía que reducir el muestreo de alguna manera, pero seguir pudiendo analizar en profundidad la historia, pero llegué a ello experimentalmente cuando me di cuenta de que mi ordenador no es lo suficientemente potente y puedo hacerlo mejor )))), además de multithreading y cosas así... todo para sacarle el máximo partido.

entonces

)))

=====

En serio, el libro describe cómo descargar de forma más eficiente sin pérdida de calidad, pero es poco probable que salve ... Creo que es hora de cambiar a algoritmos eurísticos...

o algo como una base de conocimiento, esta es la división más pequeña, mis ideas y pensamientos van en esta dirección, ya que las variantes de eventos y signos serán para decenas de gigabytes, y un modelo con 20 millones de signos no puede ser entrenado...)) por lo que una base de conocimiento parece una manera de salir de la "maldición de la dimensión" para mí

o algo así como una base de conocimientos, eso es lo más pequeño, mis ideas y pensamientos van en esa dirección, ya que habrá decenas de gigabytes de variantes de eventos y signos, y un modelo con 20 millones de signos no puede ser entrenado...)

Olvídate de los carteles. A mi modo de ver, es una cantidad escalar (o lo que es lo mismo, una expresión matemática, aunque sea lógica, se puede reducir a matemática, sólo que la precisión se resentirá). Todos estos valores escalares o lógicos se derivan del precio, porque no tenemos otros datos, y tratar de utilizar datos adicionales puede simplemente empeorar la previsión, porque los datos son diferentes y pueden ser de distintas fuentes, en cuyo caso no está claro qué datos deben priorizarse. Cualquier serie numérica puede contener todas las demás series numéricas dentro de ella, si se utilizan todas las formas posibles de transformar esa serie... intenta entender esto. En este caso, no hay que dar al algoritmo este espacio de características, sino dejar que encuentre estas características por sí mismo... no necesitas ninguna base, necesitas poder. Si hay un sistema y funciona al menos parcialmente, el siguiente paso es la descentralización de los cálculos. Los trabajadores tienen que estar conectados en red y la base de datos ayudaría, pero tiene que actuar como un depósito de resultados comunes. Esto ya suena a minería.

Olvídate de los atributos. Lo que yo entiendo es que es una cantidad escalar (o lo que es lo mismo, una expresión matemática, aunque sea lógica, se puede reducir a matemática, sólo que la precisión se resentirá). Todos estos valores escalares o lógicos se derivan del precio, porque no tenemos otros datos y tratar de usar datos adicionales puede simplemente empeorar la previsión, porque los datos son diferentes y pueden ser de diferentes fuentes, en cuyo caso no está claro qué datos deben priorizarse. Cualquier serie numérica puede contener todas las demás series numéricas dentro de ella, si se utilizan todas las formas posibles de transformar esa serie... intenta entender esto. En este caso no hay que darle al algoritmo este espacio de características, hay que dejar que encuentre estas características por sí mismo... no necesitas ninguna base, necesitas poder. Si hay un sistema y funciona al menos parcialmente, el siguiente paso es la descentralización de los cálculos. Los trabajadores tienen que estar conectados en red y la base de datos ayudaría, pero tiene que actuar como un depósito de resultados comunes. Esto ya suena a minería.

No entiendo muy bien tu visión, así que no voy a discutir...

Veo mi algoritmo como una secuencia de eventos, el evento es una regla de registro, la secuencia no está cronometrada, está o no está.

(como un comerciante que fija un nivel, el precio puede alcanzarlo en 5 minutos o en un día, pero la situación es la misma)

Así que el conjunto de tales secuencias de trabajo será TS.

Pero para encontrar esas secuencias "adimensionales" hay que pasar por trillones de variantes, la solución que veo - crear una base de conocimientos en tu disco duro...

Creo que todos los entrenamientos "típicos" de cualquier algoritmo en una ventana móvil no son variantes de trabajo, ya que el mercado no es estable. La salida será una media móvil con memoria del pasado, que nunca se repetirá en el futuro debido a la no estacionariedad...