- 4.2.4.1 Построение тестовой рекуррентной модели Python

4.Построение тестовой рекуррентной модели Python

Для построения тестовых рекуррентных моделей на языке Python воспользуемся разработанным ранее шаблоном. Более того, мы возьмем файл скрипта convolution.py, который мы использовали при тестровании сверточных моделей. Создадим его копию с именем файла lstm.py. В созданной копии мы оставим модель перцептрона и лучшую сверточную модель, удалив остальные. Такой подход позволит нам сравнить работу новых моделей с рассмотренными ранее архитектурными решениями.

# Создание модели перцептрона с тремя скрытыми слоями и регуляризацией

|

# Модель с 2-мерным сверточным слоем

|

После этого мы создадим три новых модели с использованием рекуррентного LSTM-блока. Вначале мы возьмем модель сверточной нейронной сети и заменим в ней сверточный и подвыборочный слои на один рекуррентный слой с 40 нейронами на выходе. Здесь надо сказать, что на вход рекуррентного LSTM-блока должен подаваться трехмерный тензор формата [batch, timesteps, feature]. Как и в случае сверточного слоя, при задании размерности слоя в модели мы не указываем измерение batch, так как значение берется из размерности пакета исходных данных.

# Добавляем в модель LSTM-блок

|

В данной модели мы указали параметр return_sequences=False, который указывает рекуррентному слою выдавать результат только после обработки полного пакета. В таком варианте наш LSTM-слой возвращает двухмерный тензор в формате [batch, feature]. При этом размерность измерения feature будет равна количеству нейронов, которое мы указали во время создания рекуррентного слоя. Тензор такой же размерности требуется на вход полносвязного нейронного слоя. Следовательно, от нас не требуется дополнительное переформатирование данных, и мы можем использовать полносвязный нейронный слой.

keras.layers.Dense(40, activation=tf.nn.swish,

|

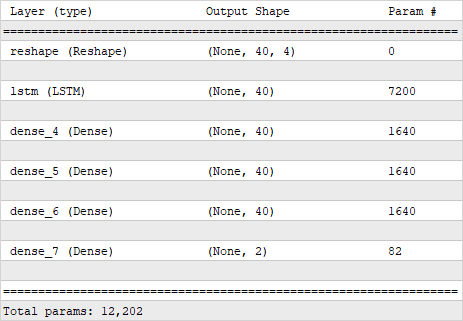

Структура рекуррентной модели с четырьмя полносвязными слоями

В такой реализации мы используем рекуррентный слой для предварительной обработки данных, а принятие решения в модели осуществляется несколькими полносвязными слоями перцептрона, следующими за рекуррентным слоем. В итоге мы получили модель с 12 202 параметрами.

Компилировать все нейронные модели мы будем с одинаковыми параметрами. Используем метод оптимизации Adam, а в качестве ошибки сети используем среднеквадратичное отклонение. Также добавляем дополнительную метрику accuracy.

model2.compile(optimizer='Adam',

|

С такими же параметрами мы компилировали модели нейронных сетей и ранее.

Следует обратить внимание еще на один момент. Рекуррентные модели чувствительны к последовательности подаваемого на вход сигнала. Поэтому при обучении нейронной сети в отличи от ранее рассмотренных моделей нельзя перемешивать исходные данные. Именно с этой целью при запуске обучения модели мы укажем значение False для параметра shuffle. Остальные параметры обучения модели остаются без изменений.

history2 = model2.fit(train_data, train_target,

|

В первой модели мы использовали рекуррентный слой для предварительной обработки данных перед использованием полносвязного перцептрона для принятия решения. Однако возможно использование рекуррентных нейронных слоев в чистом виде, без последующего использования полносвязных слоев. Именно такую реализацию я предлагаю рассмотреть в качестве второй модели. В ней мы просто все полносвязные слои заменяем одним рекуррентным слоем, а размер слоя указываем равным требуемому размеру выхода нейронной сети.

Следует обратить внимание, что на вход рекуррентного нейронного слоя требуется подать трехмерный тензор, в то время как на выходе из предыдущего рекуррентного слоя мы получили двухмерный. Поэтому перед передачей информации на вход следующего рекуррентного слоя нам нужно переформатировать данные. В данной реализации мы делаем последнее изменение равным двум, а размер измерения временных меток оставляем для расчета модели. Какого-либо искажения данных от такого переформатирования мы не ожидаем, так как мы группируем последовательные данные и, таким образом, просто укрупняем временной интервал. В то же время временной интервал между любыми двумя последующими элементами новой таймсерии остается постоянным.

# Модель LSTM-блок без полносвязных слоев

|

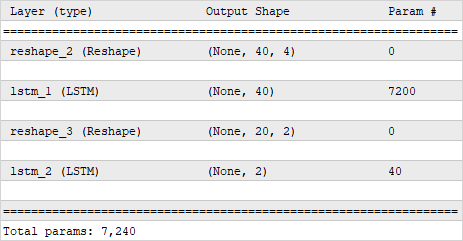

Теперь мы получили нейронную сеть, в которой первый рекуррентный слой осуществляет предварительную обработку данных, а второй рекуррентный слой генерирует результат работы нейронной сети. За счет отказа от использования перцептрона мы сократили количество нейронных слоев в сети и, соответственно, общее количество параметров, которое в новой модели составило 7 240 параметров.

Структура рекуррентной нейронной сети без использования полносвязных слоёв

Компилирование и обучение модели мы осуществляем с теми же параметрами, как и все предыдущие модели.

model4.compile(optimizer='Adam',

|

history4 = model4.fit(train_data, train_target,

|

Во второй рекуррентной модели для создания тензора исходных данных второму LSTM-слою мы переформатировали тензор результатов предыдущего слоя. Библиотека Keras дает нам возможность и другого варианта. Мы можем в первом LSTM-слое указать параметр return_sequences=True, который переводит рекуррентный слой в режим работы с выводом результатов на каждой итерации. В результате такого действия, на выходе рекуррентного слоя мы сразу получаем трехмерный тензор формата [batch, timesteps, feature]. Это позволит нам отказаться от переформатирования данных перед вторым рекуррентным слоем.

# Модель LSTM блок без полносвязных слоев

|

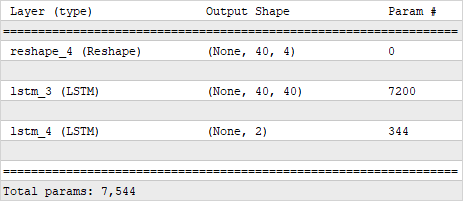

Структура рекуррентной нейронной сети без использования полносвязных слоёв

Как можно заметить, при таком построении модели изменилась размерность тензора на выходе первого рекуррентного слоя. Как следствие, немного выросло количество параметров во втором рекуррентном слое. Это дало общее увеличение параметров во всей модели до 7 544 параметров. Тем не менее, это меньше общего количества параметров первой рекуррентной модели с использованием перцептрона для принятия решения.

Дополним блок построения графиков новыми моделями.

# отрисовка результатов обучения моделей

|

plt.figure()

|

Кроме того, добавим новые модели в блок проверки работоспособности моделей на тестовой выборке и вывод результатов.

# Проверка результатов моделей на тестовой выборке

|

print('LSTM model')

|

print('LSTM only model')

|

print('LSTM sequences model')

|

В данном разделе мы подготовили скрипт на языке Python, в котором создается в общей сложности 5 моделей нейронных сетей:

- полносвязный перцептрон,

- сверточная модель,

- 3 модели рекуррентных нейронных сетей.

При выполнении скрипта мы проведем небольшое обучение всех пяти моделей на одном наборе исходных данных и сравним результаты работы обученных моделей на одном наборе тестовых данных. Это даст нам возможность сравнить работу различных архитектурных решений на реальных данных. Результаты тестов будут даны в следующей главе.