L'apprentissage automatique dans la négociation : théorie, modèles, pratique et algo-trading - page 2474

Vous manquez des opportunités de trading :

- Applications de trading gratuites

- Plus de 8 000 signaux à copier

- Actualités économiques pour explorer les marchés financiers

Inscription

Se connecter

Vous acceptez la politique du site Web et les conditions d'utilisation

Si vous n'avez pas de compte, veuillez vous inscrire

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Il y a une part de vérité ici, mais j'ai vérifié mon modèle, l'essentiel est de savoir sur quelle avancée nous comptons.....

Je ne comprends pas vraiment, mais c'est mon problème, je n'ai pas bien étudié, je regarde un peu différemment les algorithmes pour le trading, plus les règles asociales et les règles de recherche génétique ou les formules, comme la régression symbolique etc... Mais si vous avez réussi à faire fonctionner des modèles simples avec de nouvelles données, c'est très intéressant d'en entendre parler....

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Merci de lire...

J'aime aussi Maitreid, j'ai regardé sa vidéo probablement 8 fois, pas un seul mot de trop...

Quant au leurre, je pense que c'est beaucoup plus simple : la bourse vit avec la commission, et si la plupart des gens veulent acheter, et que cette demande d'achat est inférieure au prix actuel, la bourse a intérêt à satisfaire les acheteurs car ils sont plus nombreux, donc la commission (l'argent) peut gagner plus, donc le prix baisse et vice versa avec les vendeurs....

Je ne sais pas comment il le fait, il imprime simplement le prix ou manipule le tumbler ou autre chose, mais je pense que le résultat est le même...

C'est pourquoi le prix va à l'encontre des positions des participants.

Je ne vous comprends pas vraiment, mais c'est mon problème que je n'ai pas bien étudié, je regarde un peu différemment pour les algorithmes de trading, plus vers les règles asociales et les règles de recherche génétique ou les formules, comme la régression symbolique etc... Mais si vous avez réussi à faire fonctionner des modèles réguliers sur de nouvelles données, c'est très intéressant d'en entendre parler.

Oui, je l'ai, la qualité n'est pas aussi bonne que sur la parcelle d'entraînement mais une partie de cette qualité est toujours conservée, et ma recherche a pris 10 ans d'histoire en avant, peut-être jusqu'à un an, en moyenne 2-3 mois, cela fonctionne pour une assez bonne qualité, par rapport à la parcelle d'entraînement pour un pourcentage de 60-70 en moyenne probablement. Un réseau neuronal donnera de meilleurs résultats, mais il faut déjà ajouter ces critères de recyclage, pour entrer les données combinées quelque chose comme des poids, pour donner un certain poids à la quantité de données, puis la qualité du backsest final par exemple l'espérance ou le profitka et bien sûr la complexité de l'algorithme final, qui s'est avéré (quantité de tous les poids de tous les perceptrons par exemple). Pour y parvenir dans un réseau neuronal, il faut que le type de neurones soit aussi différent que possible, et que le nombre de couches et leur composition soient arbitraires, dans ce cas c'est possible. Fondamentalement, tout le monde utilise des réseaux neuronaux à architecture fixe, mais pour une raison quelconque, ils ne comprennent pas que l'architecture doit également être flexible. En détruisant cette flexibilité, nous détruisons la possibilité de minimiser le recyclage. En général, les mêmes critères peuvent bien sûr être appliqués à des modèles simples, même si c'est nécessaire, alors vous obtiendrez un bon résultat, mon modèle donne un bénéfice de quelques mois à l'avance et les paramètres peuvent être mis à jour en une journée. L'une des principales astuces consiste à prendre le plus de données possible (10 ans d'historique ou plus). Dans ce cas, nous recherchons des modèles globaux, qui sont basés sur la physique du marché et qui, dans la plupart des cas, fonctionnent sur une très longue période.

Je l'ai fait, la qualité n'est pas.....

J'ai besoin de fer fort, j'ai le plafond de fer, mais il y a une solution à ce problème.

Si vous ne l'avez pas lu, vous l'aimerez, je suis sûr qu'il contient des idées intéressantes sur les critères de qualité du modèle.

J'ai besoin de fer fort, moi aussi j'ai des problèmes avec le matériel, mais il y a une solution à ce problème.

J'ai vraiment besoin de serveurs) mais je ne les ai pas (je viens de faire tout cela sur un netbook mort), j'ai besoin de temps long et douloureux pour lire. Mais en soi, il n'y a pas d'autre moyen, ou vous prenez de la puissance de quelque part et les charger dur, dans ce cas, vous devez vérifier 20-30 configurations au moins, et mieux près de cent, et pour chaque signal accrocher et de surveiller, la plus stable qui va passer une sélection naturelle et de quitter, puis essayer d'ajouter plus de puissance. Il n'y a pas d'autre moyen, sinon ce n'est qu'une route vers nulle part, comme beaucoup l'ont déjà écrit ici... il peut vraiment s'étendre sur de nombreuses années sans savoir où creuser. L'alternative est un diplôme en sciences du forum et un bavardage sur les phases de la lune et leur influence sur le marché dans l'esprit des spectacles de Prokopenko ;))). Quelle est la solution si ce n'est un secret?

Quelle est la solution, si ce n'est pas un secret?

Dans le livre dont j'ai donné le lien, la solution est décrite de manière plus intelligente... Je recommande vraiment de le lire...

En termes simples, la solution est élémentaire : vous devez diviser le problème, par exemple en regroupant les données et en formant des modèles différents pour chaque groupe.

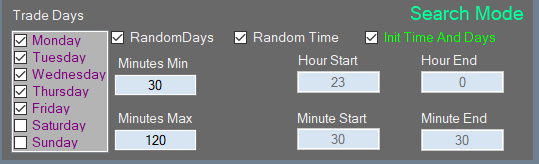

Ou un exemple encore plus simple : il y a 5 jours de bourse dans une semaine, donc nous entraînons un modèle quotidiennement pour les lundis, le second pour les mardis, etc. Nous avons donc réduit l'échantillon d'entraînement 5 fois et avons 2 ans d'entraînement, et non 10 ans, et ainsi de suite, cela dépend de notre imagination.

Le livre dont j'ai donné le lien décrit cette solution de manière plus intelligente... Je recommande vraiment de le lire...

En termes simples, la solution est élémentaire : il faut diviser le problème, par exemple regrouper les données et former des modèles différents pour chaque groupe.

Ou encore un exemple plus simple : dans une semaine de 5 jours de trading, nous formons un modèle strictement pour les lundis, le second pour les mardis, etc. Il s'est avéré de réduire l'échantillon de formation de 5 fois et déjà 10 ans, et 2 ans de formation, et ainsi de suite est l'imagination ...

Je ne l'ai pas lu, mais tout a été implémenté, je l'ai fait pour la même raison, j'avais besoin de réduire la taille de l'échantillon tout en étant capable d'analyser profondément dans l'histoire, mais je l'ai fait expérimentalement quand j'ai compris que je ne suis pas assez fort dans mon ordinateur et que je peux le faire mieux )))), plus le multithreading et des trucs comme ça... tous pour en tirer le meilleur parti.

Je ne l'ai pas lu, mais il a déjà été mis en œuvre chez moi. Je l'ai fait pour la même raison, je devais réduire l'échantillonnage d'une manière ou d'une autre, tout en étant capable d'analyser en profondeur l'histoire, mais j'y suis venu expérimentalement quand j'ai réalisé que mon ordinateur n'est pas assez puissant et que je peux le faire mieux )))), plus le multithreading et des trucs comme ça... tous pour en tirer le meilleur parti.

alors

)))

=====

Sérieusement, le livre décrit comment télécharger plus efficacement sans perte de qualité, mais il est peu probable qu'il permette de sauver ... Je pense qu'il est temps de passer aux algorithmes euristiques...

ou quelque chose comme une base de connaissances, c'est la plus petite division, mes idées et mes pensées vont dans cette direction, car les variantes d'événements et de signes seront pour des dizaines de gigaoctets, et un modèle avec 20 millions de signes ne peut pas être formé...)) donc une base de connaissances ressemble à un moyen de sortir de la "malédiction de la dimension" pour moi.

ou quelque chose comme une base de connaissances, c'est la plus petite béguine, mes idées et pensées vont dans cette direction, car il y aura des dizaines de gigaoctets de variantes d'événements et de signes, et un modèle avec 20 millions de signes ne peut être entraîné...))

Oubliez les panneaux. De la façon dont je le vois, c'est une quantité scalaire (ou en d'autres termes une expression mathématique, même si elle est logique, elle peut être réduite à une expression mathématique, seule la précision en souffrira). Toutes ces valeurs scalaires ou logiques sont dérivées du prix, parce que nous n'avons pas d'autres données et que tenter d'utiliser des données supplémentaires peut simplement aggraver la prévision, parce que les données sont différentes et peuvent provenir de sources différentes, auquel cas il n'est pas clair quelles données doivent être prioritaires. Toute série numérique peut contenir toutes les autres séries numériques en son sein, si toutes les façons possibles de transformer cette série sont utilisées... essayez de comprendre cela. Dans ce cas, ne donnez pas à l'algorithme cet espace de caractéristiques mais laissez-le trouver ces caractéristiques par lui-même... vous n'avez pas besoin de base, vous avez besoin de puissance. S'il existe un système et qu'il fonctionne au moins partiellement, l'étape suivante est la décentralisation des calculs. Les travailleurs doivent être mis en réseau et la base de données y contribuerait, mais elle doit servir de référentiel pour les résultats communs. Ça ressemble déjà à de l'exploitation minière.

Oubliez les attributs. D'après ce que j'ai compris, il s'agit d'une quantité scalaire (ou en d'autres termes d'une expression mathématique, même si elle est logique, elle peut être réduite à une expression mathématique, seule la précision en souffrira). Toutes ces valeurs scalaires ou logiques sont dérivées du prix, parce que nous n'avons pas d'autres données et que tenter d'utiliser des données supplémentaires peut simplement aggraver la prévision, parce que les données sont différentes et peuvent provenir de sources différentes, auquel cas il n'est pas clair quelles données doivent être prioritaires. Toute série numérique peut contenir toutes les autres séries numériques en son sein, si toutes les façons possibles de transformer cette série sont utilisées... essayez de comprendre cela. Dans ce cas, ne donnez pas à l'algorithme cet espace de caractéristiques mais laissez-le trouver ces caractéristiques par lui-même... vous n'avez pas besoin de base, vous avez besoin de puissance. S'il existe un système et qu'il fonctionne au moins partiellement, l'étape suivante est la décentralisation des calculs. Les travailleurs doivent être mis en réseau et la base de données y contribuerait, mais elle doit servir de référentiel pour les résultats communs. Cela ressemble déjà à de l'exploitation minière.

Je ne comprends pas très bien votre vision, alors je ne discuterai pas...

Je vois mon algorithme comme une séquence d'événements, l'événement est une règle du journal, la séquence n'est pas minutée, elle est là ou pas.

(comme un trader qui fixe un niveau, le prix peut l'atteindre en 5 minutes ou en un jour, mais la situation est la même).

Ainsi, l'ensemble de ces séquences de travail sera TS.

Mais pour trouver de telles séquences "non dimensionnelles", nous devons passer par des trillions de variantes, la solution que je vois - créer une base de connaissances sur un disque dur....

Je pense que tous les entraînements "typiques" de n'importe quel algorithme dans une fenêtre mobile ne fonctionnent pas les variantes, puisque le marché n'est pas stable, la sortie sera une moyenne mobile avec une mémoire du passé, qui ne se répétera jamais dans le futur à cause de la non-stationnarité....