Машинное обучение в трейдинге: теория, модели, практика и алготорговля - страница 623

Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

Нет, ява не интерпретируемый язык, а транслируемый, как и C#, трансляция происходит один раз, результат - "байт код", который исполняется виртуальной машиной, ява и сишарп медленнее С++ не существенно, в 1-2 раза, в зависимости от алгоритма, оптимизация только на низком(unsafe) уровне, за счет работы с указателями и грамотного размещения в памяти, при работе с высокоуровневыми стандартными абстракциями такими как вектор, список и тд. производительность сравнимая c java\c#. А пайтон и R проигрывают в десятки раз, бывает в сотни, если писать нативные алгоритмы, интерпретация происходит во время выполнения каждый раз.

Feature selection

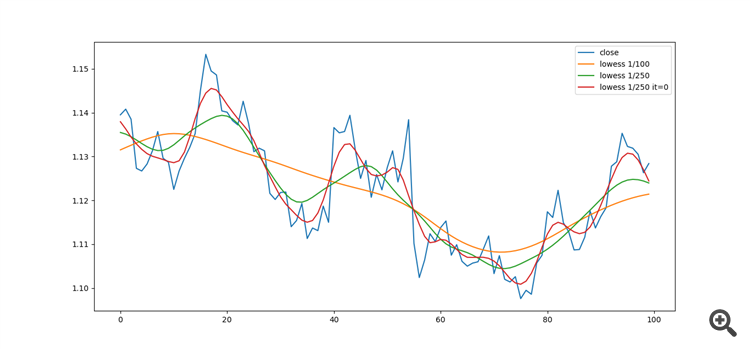

Применение сглаживающего алгоритма Lowess:Для фильтрации выбросов на данных.

Дельта, производная, log производная, детрендинг с ema и lowess:

Yuriy Asaulenko:

Интересно, почему не Питон? М.б. тот-же R? Ни фига не понимаю.

toxic:

Не стану говорить за Михаила, он сам в состоянии аргументировать свой выбор, но могу предположить наверно потому что python и R интерпретирующие высокоуровневые языки, они как матлаб или "математика" скорее интерфейс к набору библиотек, как командная строка, чем собственно языки, для ознакомления это очень круто, но в продакшине когда нужно бороться с эксклюзивными алгоритмами, нет шансов, это как на самокате победить формулу 1

Джава язык универсальный, на нем можно написать новый метатрейдер или матлаб, а пайтон или R, только для эксперементов и статистики, когда эксперементы закончатся и нужно будет писать продакшн код, то джава или с++, поэтому это скорее вопрос наличия времени, так как плюсы или джаву изучать придется так и так, а пайтон с R только "для души".

https://medium.com/deep-learning-turkey/google-colab-free-gpu-tutorial-e113627b9f5d

Искать надо VAR, VECM, пакет vars, в нем, как всегда, ссылки. Границы входа по SETAR

Прицепил, а так гугл в помощь - литературы и конкретных применений ....

Если преодолеете спред, то может быть поделитесь. Без спреда такая красота, просто глаз не отвести.

почитал, в общем я такое (подобное) уже делал и показывал приращения. но делал через RF. Там остатки получаются реально меньше спреда, зачастую. Через LR остатки должны быть посерьезнее (в пунктах), т.к. RF слишком мощно запоминает все зависимости. Но сама по себе тема интересная, я к ней пришел интуитивно, не зная что такие модели уже придуманы :)

И примеры сделок, чисто визуально (ботом еще не проверял)

остатки, похоже, распределены нормально, но некоторая цикличность не полностью выбрана

а вот так модель ломается на ООС.. пересчитывается каждые 50 баров и снова ломается, почти сразу же :)

Вы почему-то игнорируете тесты, а коинтеграция не мыслима без них. Ведь главная идея коинтеграции - это принятие торговых решений на СТАЦИОНАРНОМ ряде, а такой ряд прогнозируется, в отличие от НЕ стационарного. Тест позволит на истории получить доказательства прогнозируемости.

ну и смотрите в видосе как СТАЦИОНАРНЫЙ ряд на обучающей выборке превращается в нестационарный на форварде. Зачем кучу тестов клепать, когда и так все видно

там же выведено в стандартных отклонениях. На новых данных появляется много 3+ отклонений, что говорит о том что векторная модель не работает так же как обычная

чуть позже сделаю другое представление, на нем все выглядит уже несколько интереснее :)

Вы почему-то игнорируете тесты, а коинтеграция не мыслима без них. Ведь главная идея коинтеграции - это принятие торговых решений на СТАЦИОНАРНОМ ряде, а такой ряд прогнозируется, в отличие от НЕ стационарного. Тест позволит на истории получить доказательства прогнозируемости.

Давайте так:

На скрине красным- это просто приращения с лагом 55 текущей пары, зеленым - аппроксимация.. хмм.. назовем ее векторной нелинейной авторегрессией (используются приращения текущей пары и другой валютной пары (GBPUSD), несколько штук разных). прогнозируемое приращение с лагом 55 текущей пары, на вход модели, естественно, не подается, а только на выход.

На истории все выглядит замечательно.

Далее посмотрим на видосе как модель отрабатывает на форварде.

В предыдущем видосе со стандартными отклонениями было не очень наглядно: бралась разница между 2-мя кривыми, по ней считались отклонения.