Машинное обучение в трейдинге: теория, модели, практика и алготорговля - страница 626

Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

почему, нет, там с избытком деревьев взято.. он и с 10-ю нормально выдавал ответы (уже не помню сколько ставил)

500 это оооочень много, хватит на любой датасет

тогда почему такие ошибки на дробных числах были? .. странно, ожидал что машина точь в точь сможет обучиться.. Получается исходя из того что в случае паттернов ( на форексе) их вид далеко не однозначный (как в таблице умножения) то хорошо если получишь справедливые предсказания в 60% случаев.

ошибки были потому что r параметр стоял низкий, это значит что только половина примеров использовалась для обучения, и эта половина обучалась на половине деревьев :) а примеров то мало там

что бы точь в точь это надо r~1 ставить. Используется для псевдорегуляризации и для тестов на out of bag выборках

просто этот механизмъ надо уметь настраивать, в случае с лесом всего 2 настройки получается

надо еще понимать, что НС(RF)это не куркулятор, а она аппроксимирует(приближает) ф-ю, и для многих задач слишком высокая точность это даже больше плохо чем хорошо

Боюсь, что регрессия/прогноз на сети выдаст примерно то же, что и поиск похожих участков/шаблонов в истории (чем занимался 3 мес. назад):

ошибки были потому что r параметр стоял низкий, это значит что только половина примеров использовалась для обучения, и эта половина обучалась на половине деревьев :) а примеров то мало там

что бы точь в точь это надо r~1 ставить. Используется для псевдорегуляризации и для тестов на out of bag выборках

просто этот механизмъ надо уметь настраивать, в случае с лесом всего 2 настройки получается

тоесть если r поставить 1 то будет обучаться на всех примерах. в принципе это и нужно, иначе зачем было примеры собирать и показывать. а вот как дальше будет на то есть форвард проверка.

все равно не на всех, не все признаки будут использоваться, что бы вообще на всех там есть модификация модели, где можно задать что бы на всех. Но это уже не очень рекомендуется т.к. лес тупо запомнит все варианты

а подбор настроек это вещь такая субъективная зачастую, надо эксперементировать

если меньше 1, то на оставшхся пимерах модель валидируется (оценивается модель на данных, которые не попали в обучающую выборку). по классике r ставится 0.67, на остальных 33% валидируется. Конечно, это актуально на больших выборках, на маленьких как с таблицей умножения смысла нет, лучше 1 поставить.

все равно не на всех, не все признаки будут использоваться, что бы вообще на всех там есть модификация модели, где можно задать что бы на всех. Но это уже не очень рекомендуется т.к. лес тупо запомнит все варианты

а подбор настроек это вещь такая субъективная зачастую, надо эксперементировать

если меньше 1, то на оставшхся пимерах модель валидируется (оценивается модель на данных, которые не попали в обучающую выборку). по классике r ставится 0.67, на остальных 33% валидируется

Features selection

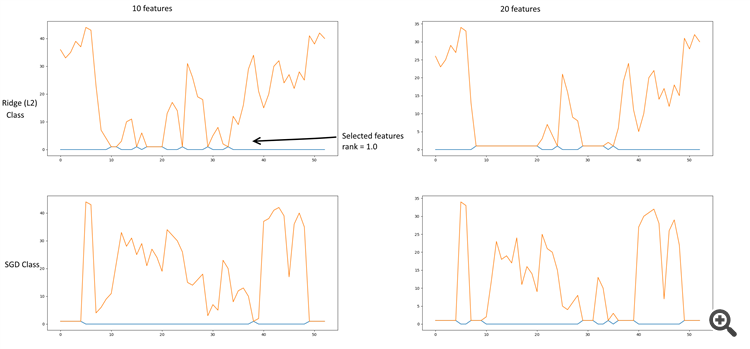

Немного датамайнинга. Отбор признаков делал через Chi^2 + KBest, RFE (Recursive feature elimination) + (SGDClassifier, RidgeClassifier), L2 (Ridge, RidgeClassifier), L1 (Lasso). Более вменяемые результаты дает Ridge регуляризация.

Немного графиков:

RFE + Ridge & SGD

Ridge regressor (L2)

Ridge classifier (L2)

В файле таблица значений параметров, и их выборка по отбору признаков.

Наиболее значимые коэффициенты оказались:

- 10, 11 - Close, Delta(Open-Close)

- 18-20 - Derivative High, Low, Close

- 24 - Log derivative Close

- 29, 30 - Lowess

- 33 - Detranding Close - Lowess

- 35 - EMA 26 (13 как вариант)

- 40 - Derivative EMA 13

PS. Строка Ridge Classifier в таблице основана на одном классе, она не отражает зависимости параметров на другие классы.Ссылка на скрипт.

набросал новую схемку сети, это первое описание. Потом будет продолжение (надеюсь)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

набросал новую схемку сети, это первое описание. Потом будет продолжение (надеюсь)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

А я думаю, чего первый пост удалил. Он схему в блог завел. =)