L'apprendimento automatico nel trading: teoria, modelli, pratica e algo-trading - pagina 626

Ti stai perdendo delle opportunità di trading:

- App di trading gratuite

- Oltre 8.000 segnali per il copy trading

- Notizie economiche per esplorare i mercati finanziari

Registrazione

Accedi

Accetti la politica del sito e le condizioni d’uso

Se non hai un account, registrati

Perché, no, ci sono troppi alberi... andava bene anche con 10 (non ricordo quanti ne ho impostati)

500 è molto, abbastanza per qualsiasi set di dati

Perché tali errori si sono verificati con i numeri frazionari? ... strano, mi aspettavo che la macchina può imparare esattamente... Quindi, nel caso di modelli (nel forex) la loro forma è tutt'altro che chiara (come la tabella di moltiplicazione) è bene se si ottengono previsioni corrette nel 60% dei casi.

Gli errori si sono verificati perché il parametro r era basso, il che significa che solo metà degli esempi sono stati utilizzati per l'addestramento, e questa metà è stata addestrata su metà degli alberi :) e ci sono pochi esempi

dovete impostare r~1 per essere esatti. Utilizzato per la pseudoregolarizzazione e per test su campioni fuori sacco

è solo che questo meccanismo deve essere regolato, nel caso della foresta, ci sono solo 2 impostazioni

Dovreste anche capire che NS (RF) non è una calcolatrice, ma approssima una funzione, e una precisione troppo alta è più cattiva che buona per molti compiti.

Temo che la regressione/previsione in rete produrrà più o meno la stessa cosa che cercare siti/modelli simili nella storia (cosa che ho fatto 3 mesi fa):

Gli errori si sono verificati perché il parametro r era basso, il che significa che solo metà degli esempi sono stati utilizzati per l'addestramento, e questa metà è stata addestrata su metà degli alberi :) e ci sono pochi esempi

dovete impostare r~1 per essere esatti. Utilizzato per la pseudoregolarizzazione e per test su campioni fuori sacco

Bisogna solo sapere come sintonizzare questo meccanismo, nel caso della foresta, ci sono solo 2 impostazioni

Cioè se impostate r a 1, allora sarà addestrato su tutti i campioni.

La foresta non userà comunque tutti gli attributi, quindi c'è una modifica del modello in cui si può impostare l'uso di tutti gli attributi. Ma questo non è raccomandato perché la foresta ricorderà tutte le opzioni

e la selezione delle impostazioni è spesso una cosa così soggettiva che bisogna sperimentare

se meno di 1, allora sui campioni rimanenti il modello è convalidato (il modello è stimato sui dati che non sono stati presi dal campione di allenamento). r classico è 0,67, sul restante 33% il modello è convalidato. Naturalmente, questo è vero per i campioni grandi, per quelli piccoli è proprio come con la tabella di moltiplicazione - è meglio impostare 1.

La foresta non userà comunque tutti gli attributi, quindi c'è una modifica del modello in cui si può impostare l'uso di tutti gli attributi. Ma questo non è raccomandato perché la foresta ricorderà tutte le opzioni

e la selezione delle impostazioni è spesso una cosa così soggettiva che bisogna sperimentare

Se è inferiore a 1, allora sui campioni rimanenti il modello è convalidato (il modello è stimato sui dati che non sono stati presi nel campione di formazione). Secondo il classico r è impostato a 0,67, sul restante 33% il modello è convalidato

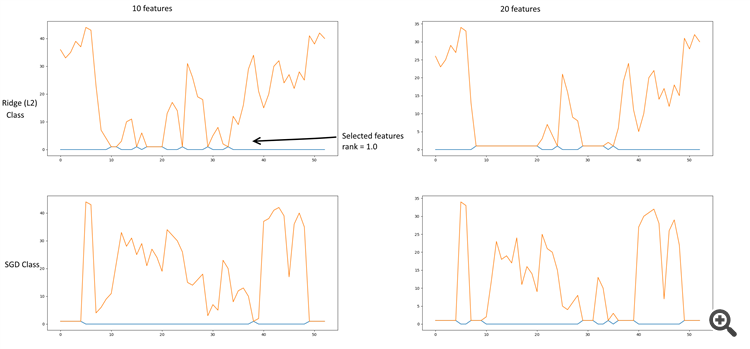

Selezione delle caratteristiche

Un po' di datamining. Stavo facendo la selezione delle caratteristiche tramite Chi^2 + KBest, RFE (eliminazione ricorsiva delle caratteristiche) + (SGDClassifier, RidgeClassifier), L2 (Ridge, RidgeClassifier), L1 (Lasso). La regolarizzazione della cresta dà risultati più sani.

Alcuni grafici:

RFE + Ridge & SGD

Regressore di cresta (L2).

Classificatore di cresta (L2)

Il file contiene una tabella dei valori dei parametri e il loro campionamento in base alla selezione delle caratteristiche.

I coefficienti più significativi sono risultati essere:

- 10, 11 - Chiudere, Delta (aprire-chiudere)

- 18-20 - Derivato Alto, Basso, Chiusura

- 24 - Chiudere il derivato del registro

- 29, 30 - Lowess

- 33 - Vicino a Detranding - Lowess

- 35 - EMA 26 (13 come opzione)

- 40 - Derivato EMA 13

PS. La linea Ridge Classifier nella tabella è basata su una classe, non riflette le dipendenze dei parametri da altre classi.Riferimento allo script.

ha abbozzato un nuovo diagramma di rete, questa è la prima descrizione. Ci sarà più tardi (si spera)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

ha abbozzato un nuovo diagramma di rete, questa è la prima descrizione. Ci sarà più tardi (si spera)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

Mi chiedo perché il primo post sia stato cancellato. Ha bloggato lo schema. =)