Регрессионные модели библиотеки Scikit-learn и их экспорт в ONNX

MetaQuotes | 8 ноября, 2023

ONNX (Open Neural Network Exchange) представляет собой формат для описания и обмена моделями машинного обучения, обеспечивая возможность переноса моделей между различными фреймворками машинного обучения. В глубоком обучении и нейронных сетях часто используются числа типа данных float32. Они широко применяются, поскольку обычно обеспечивают приемлемую точность и эффективность для обучения моделей глубокого обучения.

Некоторые классические модели машинного обучения трудно представить в виде ONNX-операторов, поэтому для их реализации в ONNX были введены дополнительные ML-операторы (ai.onnx.ml). Следует отметить, что согласно спецификации ONNX, ключевые операторы из этого набора (LinearRegressor, SVMRegressor, TreeEnsembleRegressor) могут принимать различные типы входных данных(tensor(float), tensor(double), tensor(int64), tensor(int32)), но на выходе всегда возвращают тип tensor(float). При этом параметризация этих операторов также производится при помощи чисел float, что может ограничивать точность вычислений, особенно если для определения параметров оригинальной модели использовались числа double.

Это может привести к потере точности при преобразовании моделей или использовании различных типов данных в процессе конвертации и обработки данных в ONNX. Здесь многое зависит от конвертера, как мы увидим далее, для некоторых моделей удается обойти эти ограничения и обеспечить полную переносимость ONNX-моделей и работать с ними в double без потери точности. Важно учитывать эти особенности при работе с моделями и их представлении в ONNX, особенно в случаях, когда точность представления данных имеет значение.

Scikit-learn является одной из наиболее популярных и широко используемых библиотек для машинного обучения в сообществе Python. Она предлагает широкий выбор алгоритмов, простой в использовании интерфейс и хорошую документацию. В предыдущей статье "Классификационные модели библиотеки Scikit-learn и их экспорт в ONNX" рассматривались модели классификации.

В данной статье мы рассмотрим применение регрессионных моделей пакета Scikit-learn, рассчитаем их параметры с точностью double для тестового набора данных, попробуем их сконвертировать в ONNX-формат для float и double и использовать полученные модели в программах на MQL5. Также мы сравним точность работы оригинальных моделей и их ONNX-версий для float и double. Кроме того, мы рассмотрим ONNX-представление регресионных моделей, это позволит лучше понять их внутреннее устройство и принцип работы.

Содержание

- If it bothers you, welcome to contribute

- 1. Тестовый набор данных

Скрипт отображения тестового набора данных - 2. Модели регрессии

2.0. Список моделей регрессии пакета Scikit-learn - 2.1. Регрессионные модели библиотеки Scikit-learn, которые конвертируются в ONNX-модели float и double

- 2.1.1. sklearn.linear_model.ARDRegression

2.1.1.1. Код создания модели ARDRegression

2.1.1.2. Код на MQL5 для исполнения ONNX-моделей

2.1.1.3. ONNX-представление моделей ard_regression_float.onnx и ard_regression_double.onnx - 2.1.2. sklearn.linear_model.BayesianRidge

2.1.2.1. Код создания модели BayesianRidge и ее экспорта в ONNX для float и double

2.1.2.2. Код на MQL5 для исполнения ONNX-моделей

2.1.2.3. ONNX-представление моделей bayesian_ridge_float.onnx и bayesian_ridge_double.onnx - 2.1.3. sklearn.linear_model.ElasticNet

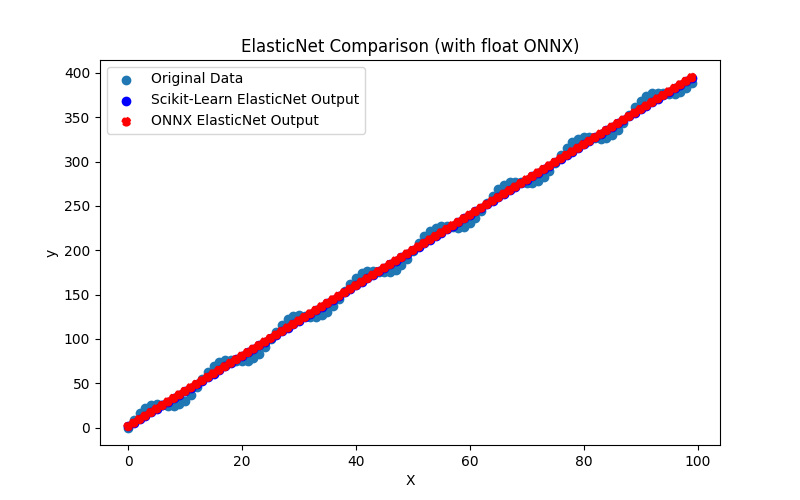

2.1.3.1. Код создания модели ElasticNet и ее экспорта в ONNX для float и double

2.1.3.2. Код на MQL5 для исполнения ONNX-моделей

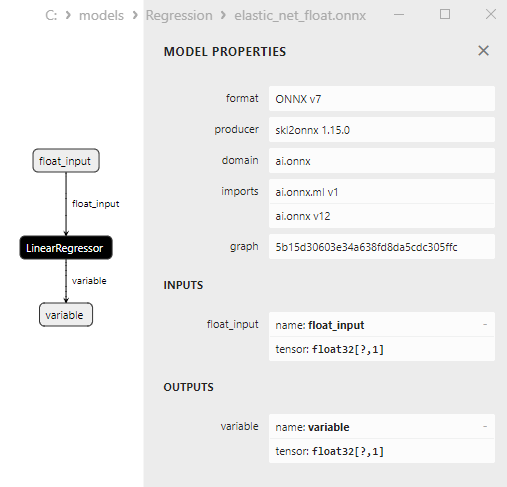

2.1.3.3. ONNX-представление моделей elastic_net_float.onnx и elastic_net_double.onnx - 2.1.4. sklearn.linear_model.ElasticNetCV

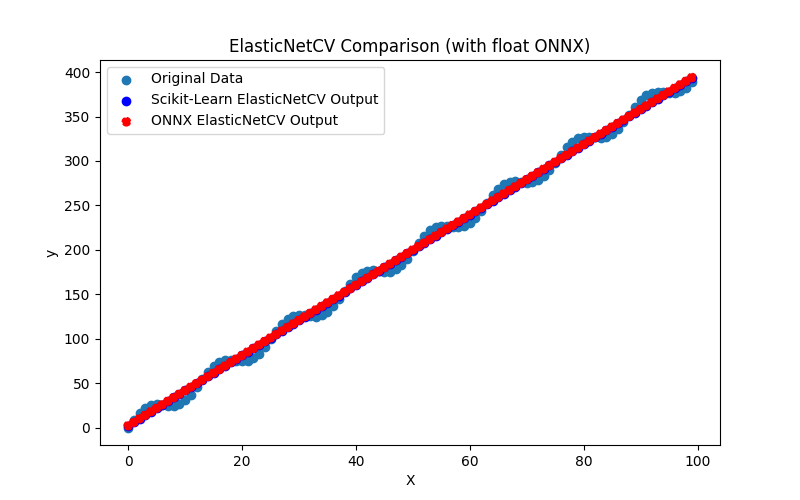

2.1.4.1. Код создания модели ElasticNet и ее экспорта в ONNX для float и double

2.1.4.2. Код на MQL5 для исполнения ONNX-моделей

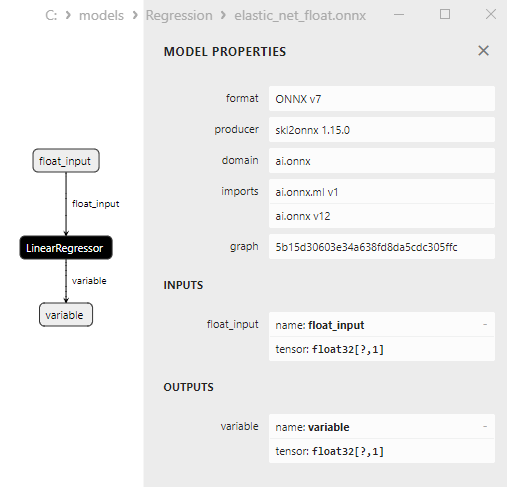

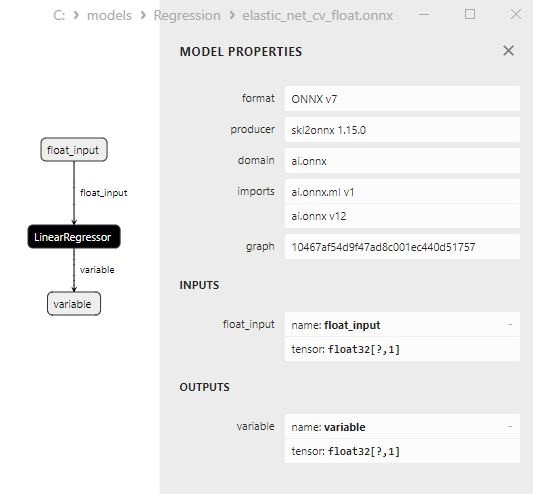

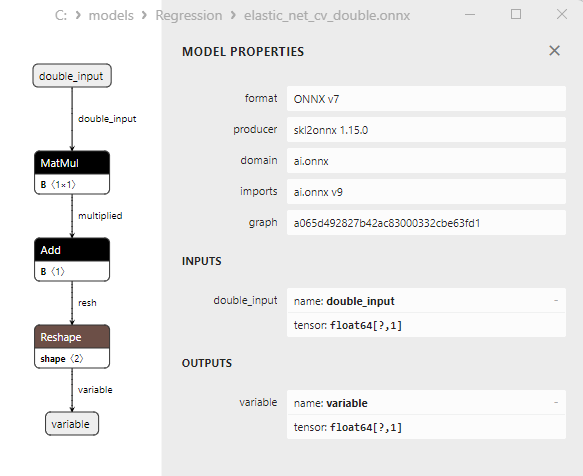

2.1.4.3. ONNX-представление моделей elastic_net_cv_float.onnx и elastic_net_cv_double.onnx - 2.1.5. sklearn.linear_model.HuberRegressor

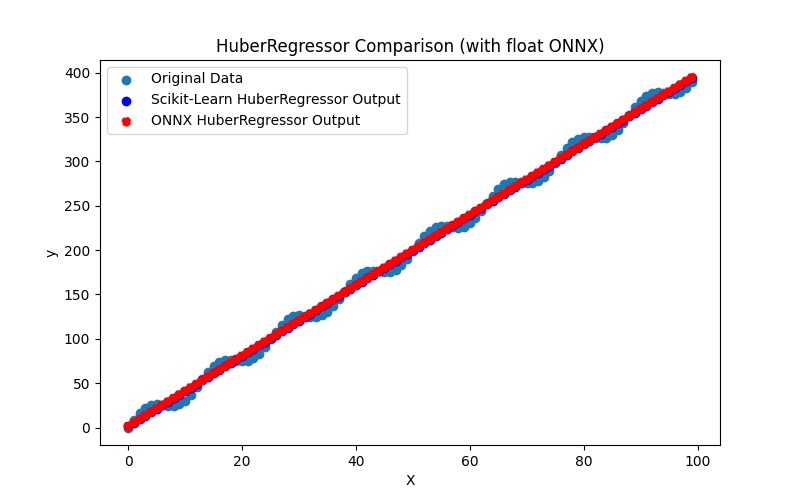

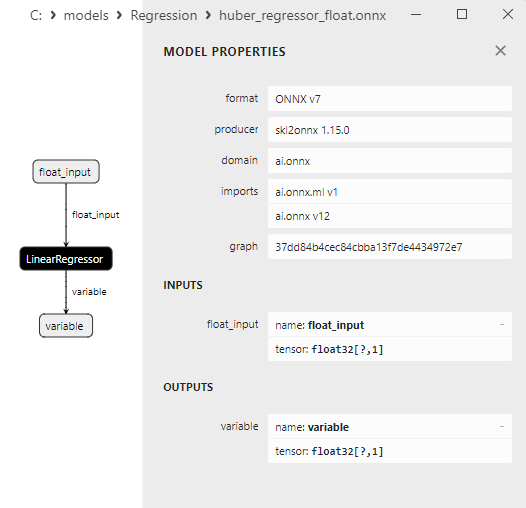

2.1.5.1. Код создания модели HuberRegressor и ее экспорта в ONNX для float и double

2.1.5.2. Код на MQL5 для исполнения ONNX-моделей

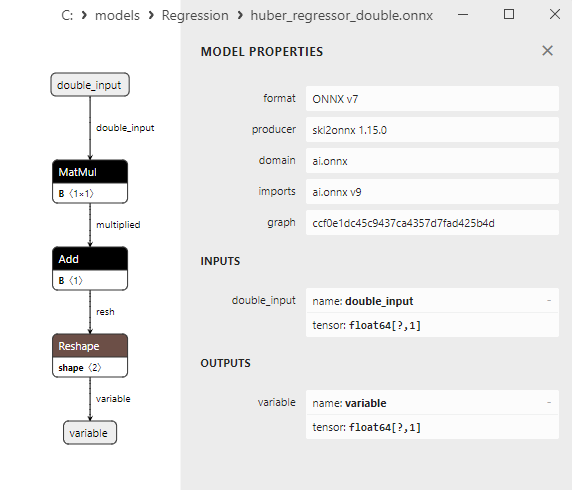

2.1.5.3. ONNX-представление моделей huber_regressor_float.onnx и huber_regressor_double.onnx - 2.1.6. sklearn.linear_model.Lars

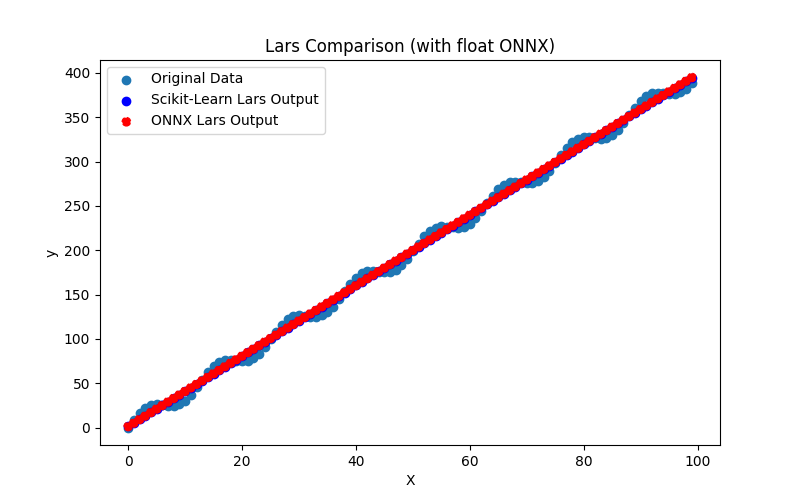

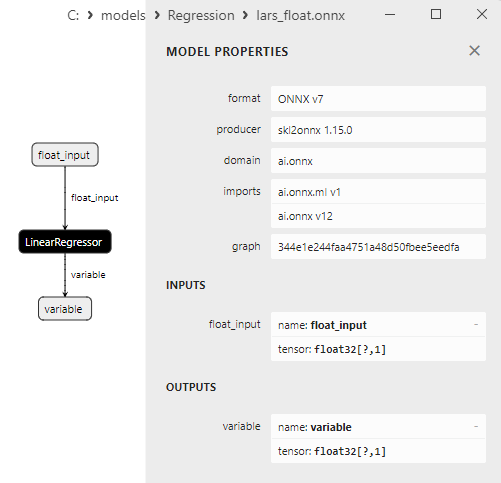

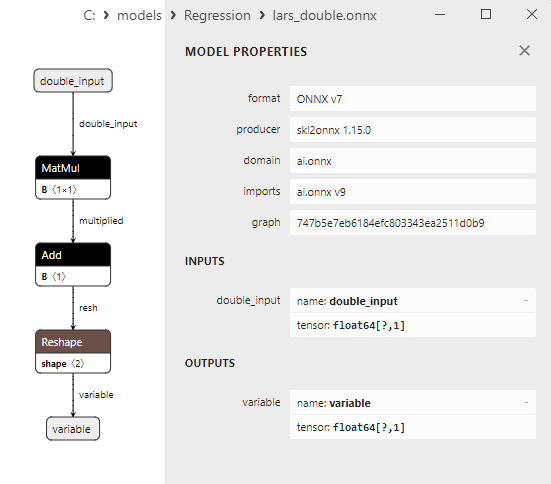

2.1.6.1. Код создания модели Lars и ее экспорта в ONNX для float и double

2.1.6.2. Код на MQL5 для исполнения ONNX-моделей

2.1.6.3. ONNX-представление моделей lars_float.onnx и lars_double.onnx - 2.1.7. sklearn.linear_model.LarsCV

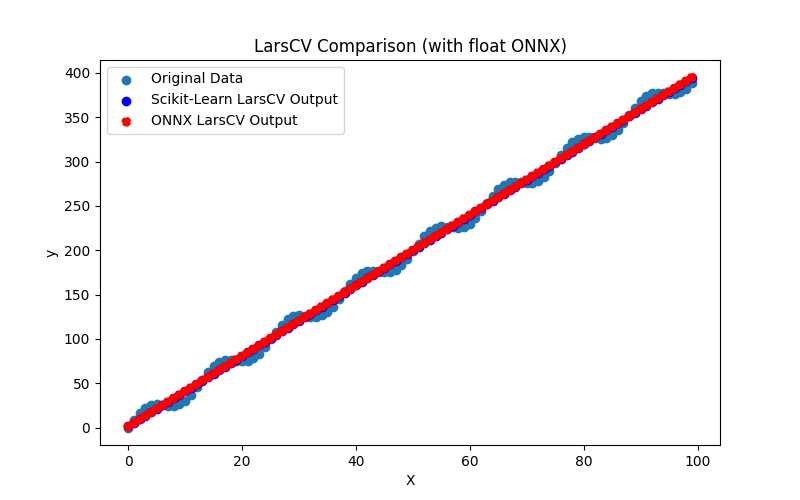

2.1.7.1. Код создания модели LarsCV и ее экспорта в ONNX для float и double

2.1.7.2. Код на MQL5 для исполнения ONNX-моделей

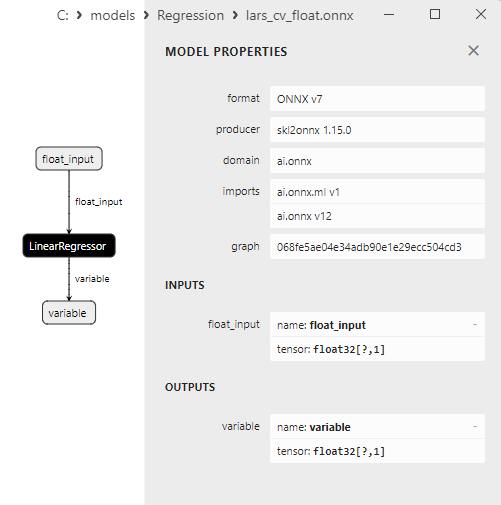

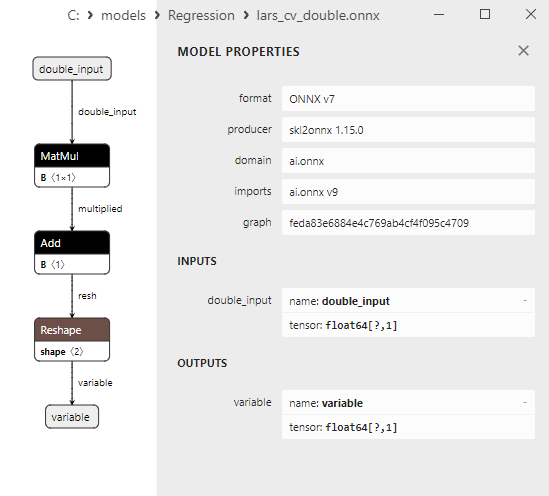

2.1.7.3. ONNX-представление моделей lars_cv_float.onnx и lars_cv_double.onnx - 2.1.8. sklearn.linear_model.Lasso

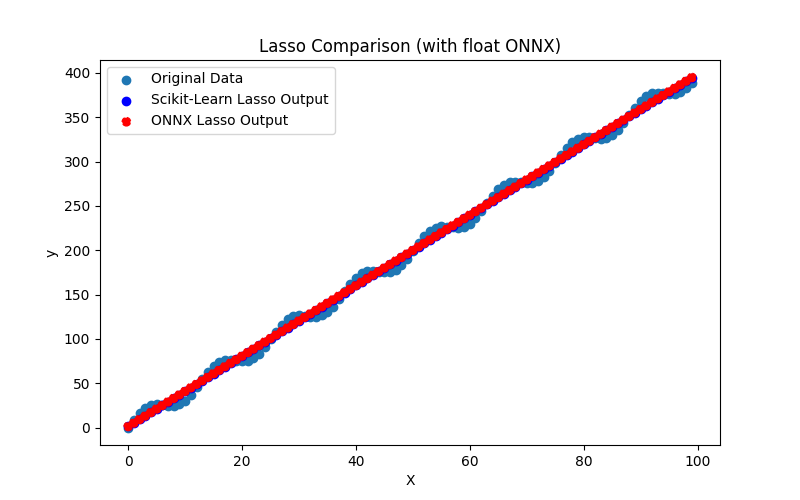

2.1.8.1. Код создания модели Lasso и ее экспорта в ONNX для float и double

2.1.8.2. Код на MQL5 для исполнения ONNX-моделей

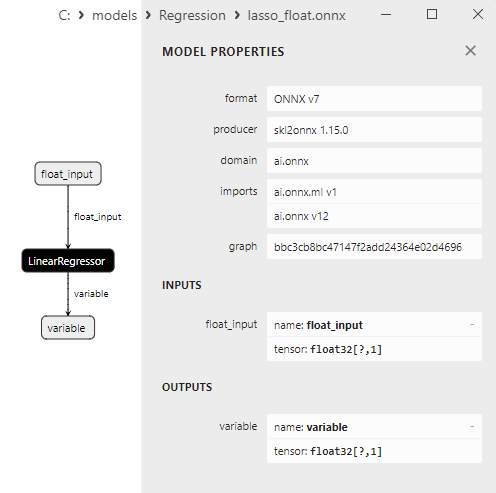

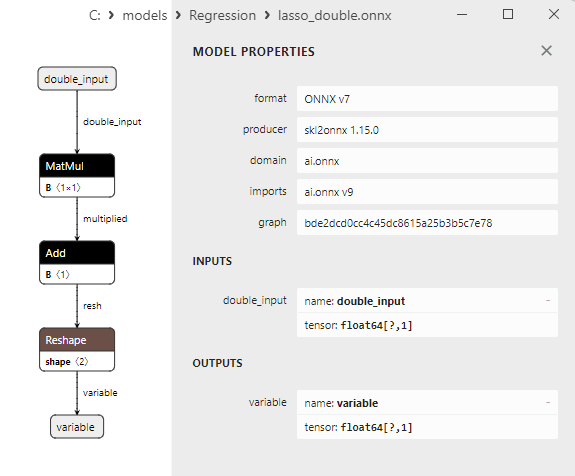

2.1.8.3. ONNX-представление моделей lasso_float.onnx и lasso_double.onnx - 2.1.9. sklearn.linear_model.LassoCV

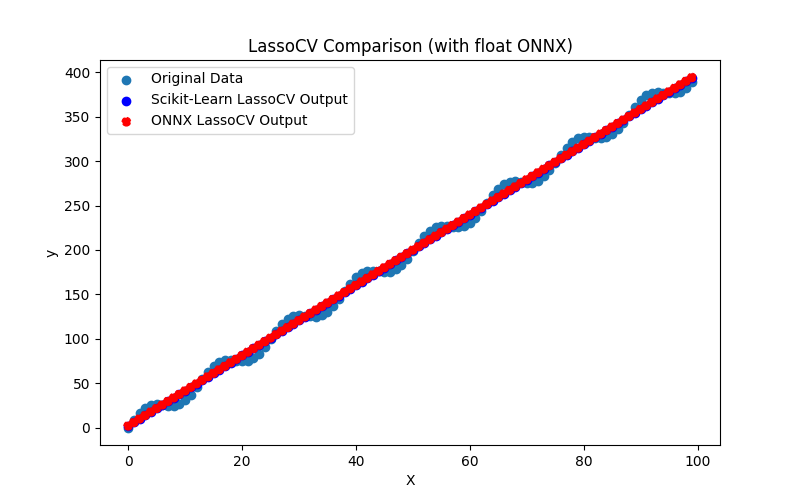

2.1.9.1. Код создания модели LassoCV и ее экспорта в ONNX для float и double

2.1.9.2. Код на MQL5 для исполнения ONNX-моделей

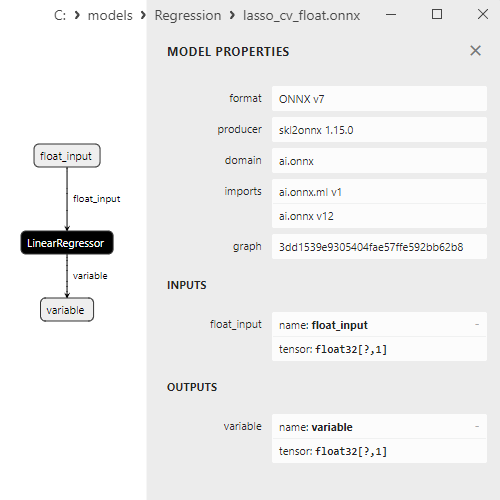

2.1.9.3. ONNX-представление моделей lasso_cv_float.onnx и lasso_cv_double.onnx - 2.1.10. sklearn.linear_model.LassoLars

2.1.10.1. Код создания модели LassoLars и ее экспорта в ONNX для float и double

2.1.10.2. Код на MQL5 для исполнения ONNX-моделей

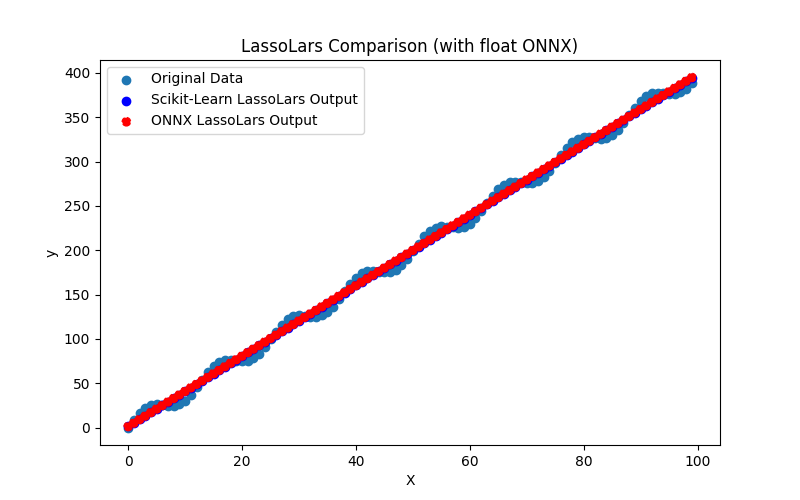

2.1.10.3. ONNX-представление моделей lasso_lars_float.onnx и lasso_lars_double.onnx - 2.1.11. sklearn.linear_model.LassoLarsCV

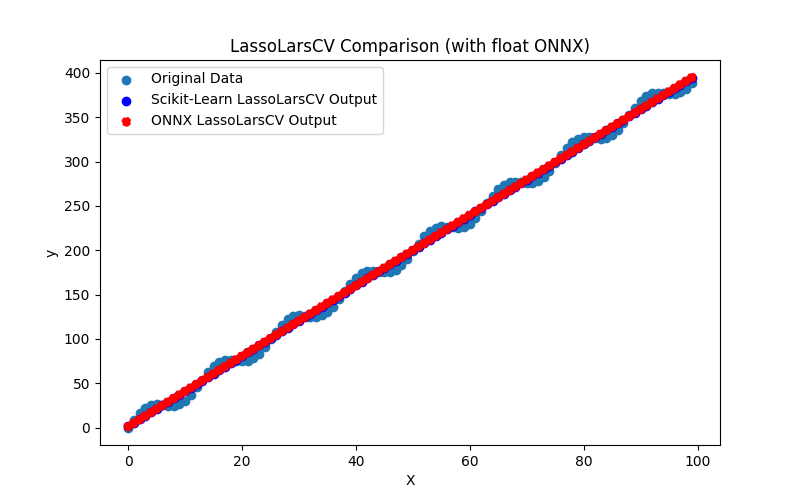

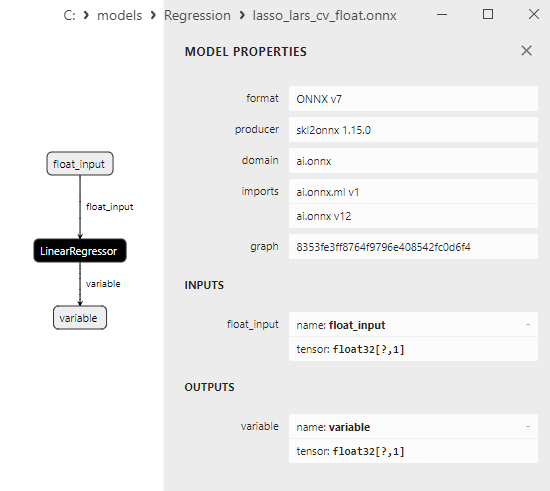

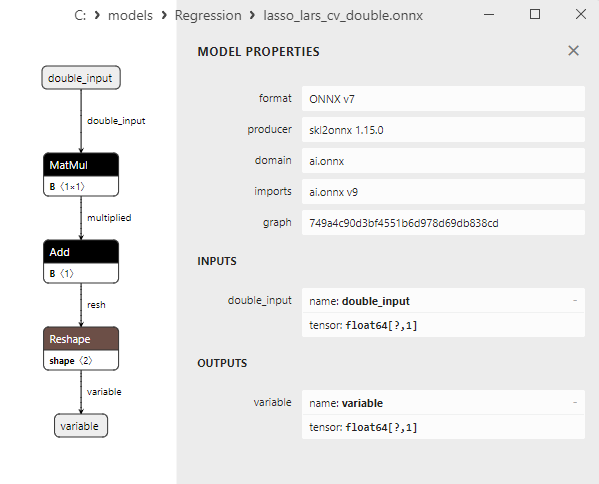

2.1.11.1. Код создания модели LassoLarsCV и ее экспорта в ONNX для float и double

2.1.11.2. Код на MQL5 для исполнения ONNX-моделей

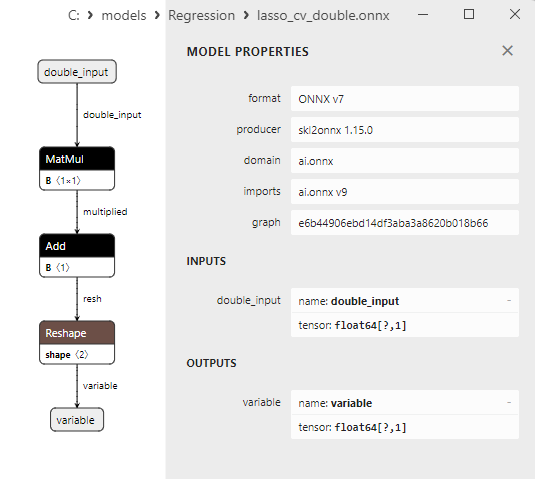

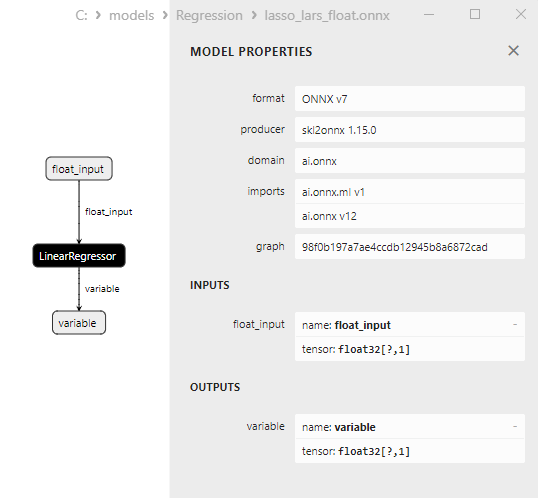

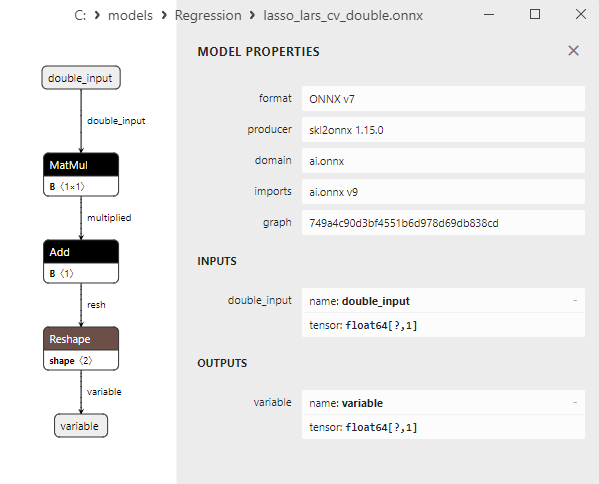

2.1.11.3. ONNX-представление моделей lasso_lars_cv_float.onnx и lasso_lars_cv_double.onnx - 2.1.12. sklearn.linear_model.LassoLarsIC

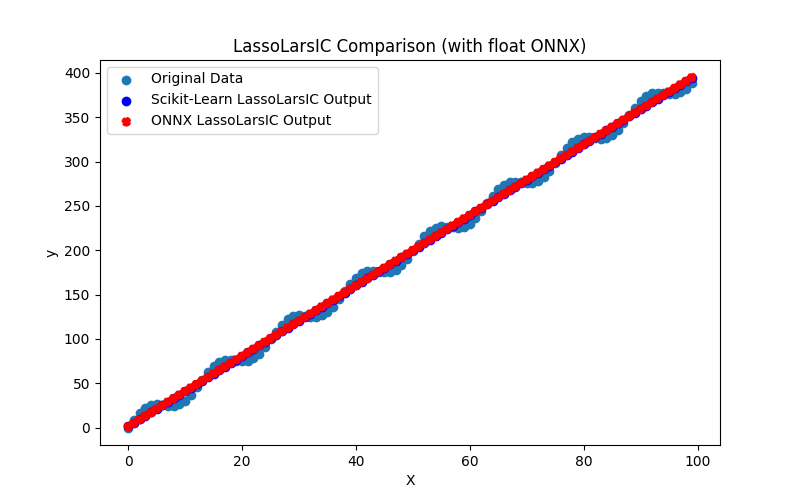

2.1.12.1. Код создания модели LassoLarsIC и ее экспорта в ONNX для float и double

2.1.12.2. Код на MQL5 для исполнения ONNX-моделей

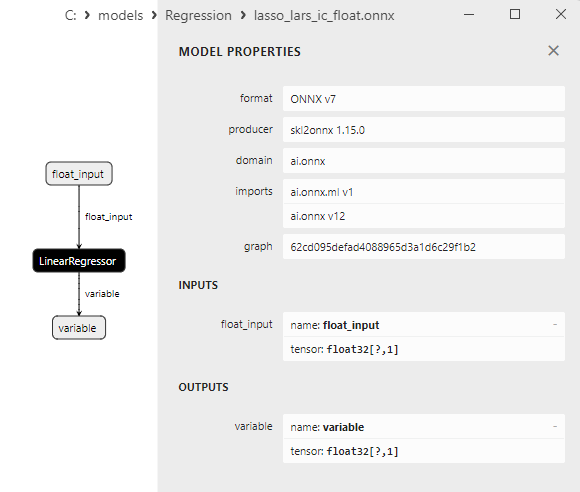

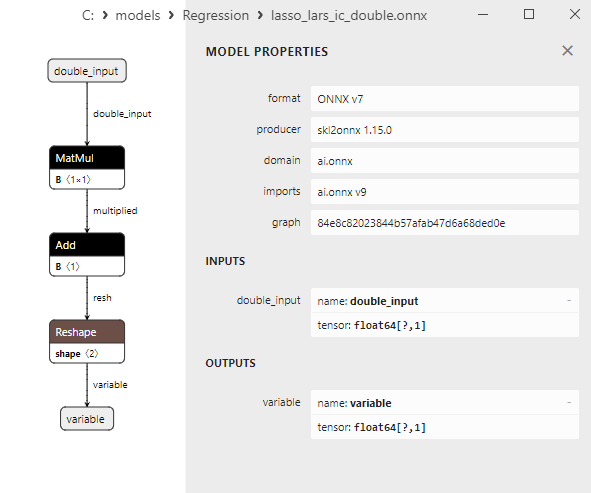

2.1.12.3. ONNX-представление моделей lasso_lars_ic_float.onnx и lasso_lars_ic_double.onnx - 2.1.13. sklearn.linear_model.LinearRegression

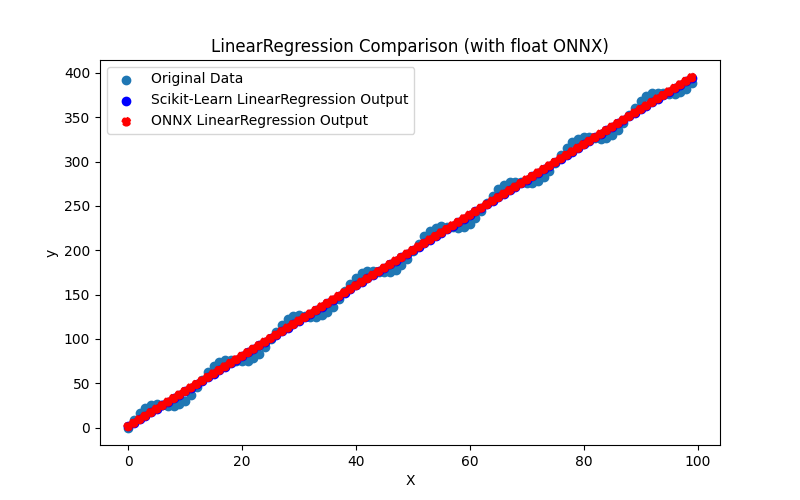

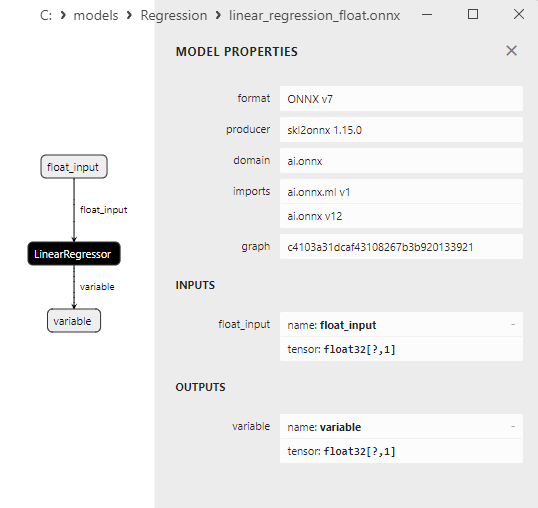

2.1.13.1. Код создания модели LinearRegression и ее экспорта в ONNX для float и double

2.1.13.2. Код на MQL5 для исполнения ONNX-моделей

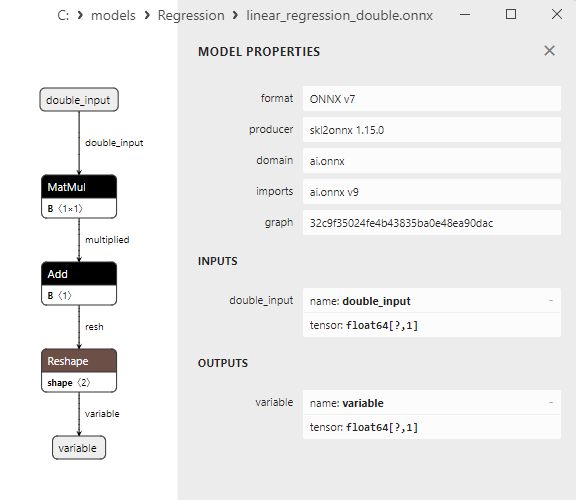

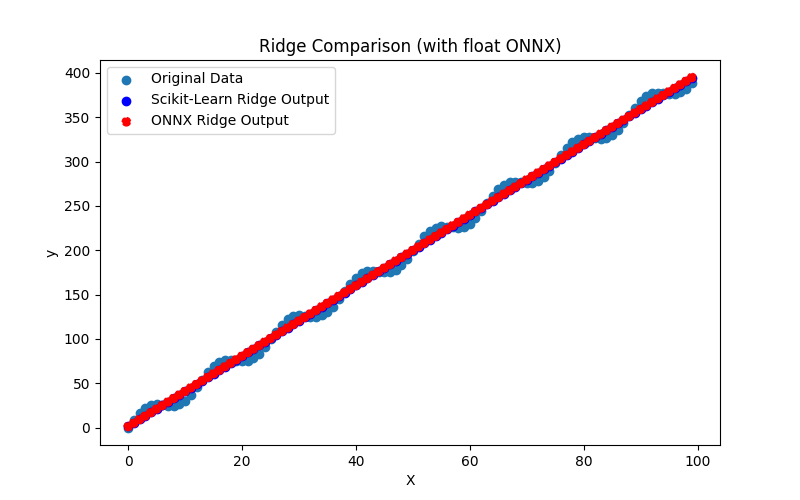

2.1.13.3. ONNX-представление моделей linear_regression_float.onnx и linear_regression_double.onnx - 2.1.14. sklearn.linear_model.Ridge

2.1.14.1. Код создания модели Ridge и ее экспорта в ONNX для float и double

2.1.14.2. Код на MQL5 для исполнения ONNX-моделей

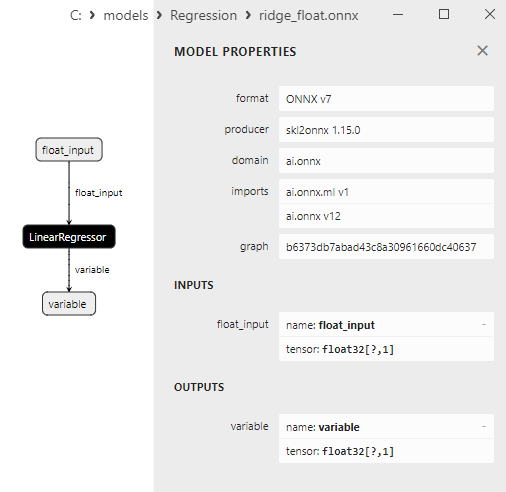

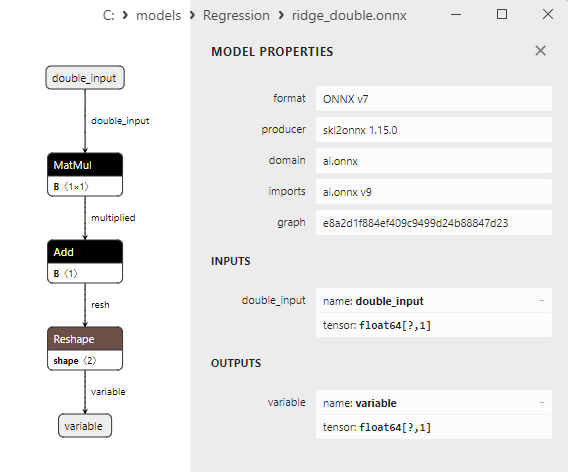

2.1.14.3. ONNX-представление моделей ridge_float.onnx и ridge_double.onnx - 2.1.15. sklearn.linear_model.RidgeCV

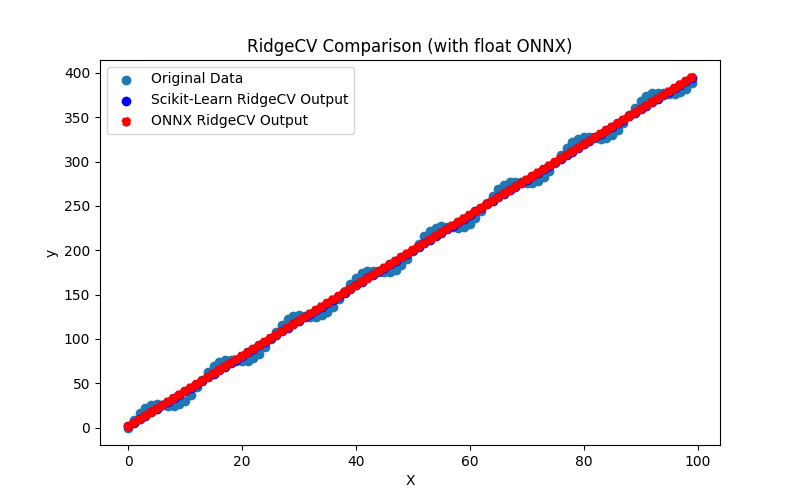

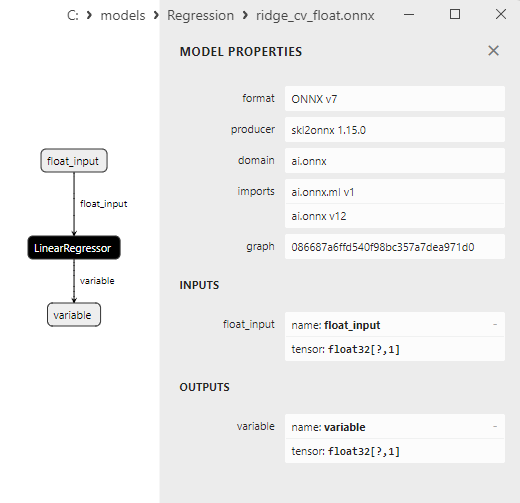

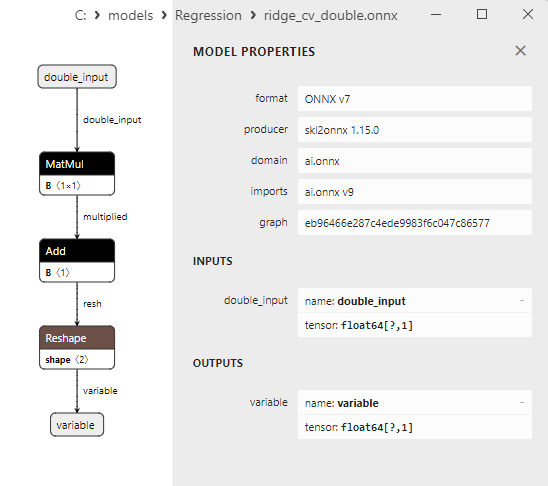

2.1.15.1. Код создания модели RidgeCV и ее экспорта в ONNX для float и double

2.1.15.2. Код на MQL5 для исполнения ONNX-моделей

2.1.15.3. ONNX-представление моделей ridge_cv_float.onnx и ridge_cv_double.onnx - 2.1.16. sklearn.linear_model.OrthogonalMatchingPursuit

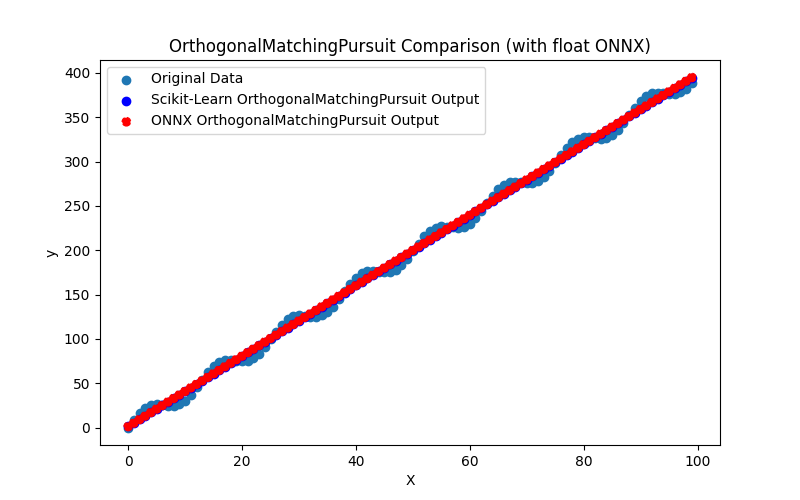

2.1.16.1. Код создания модели OrthogonalMatchingPursuit и ее экспорта в ONNX для float и double

2.1.16.2. Код на MQL5 для исполнения ONNX-моделей

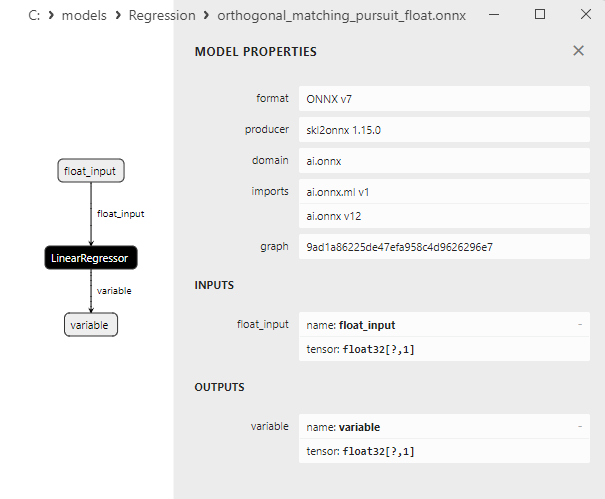

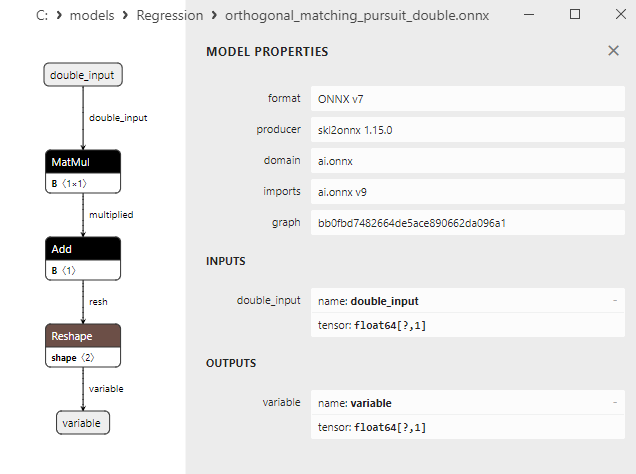

2.1.16.3. ONNX-представление моделей orthogonal_matching_pursuit_float.onnx и orthogonal_matching_pursuit_double.onnx - 2.1.17. sklearn.linear_model.PassiveAggressiveRegressor

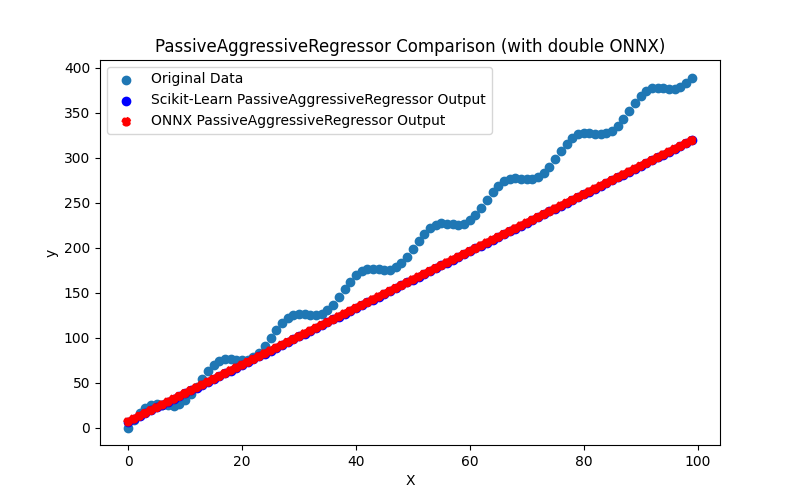

2.1.17.1. Код создания модели PassiveAggressiveRegressor и ее экспорта в ONNX для float и double

2.1.17.2. Код на MQL5 для исполнения ONNX-моделей

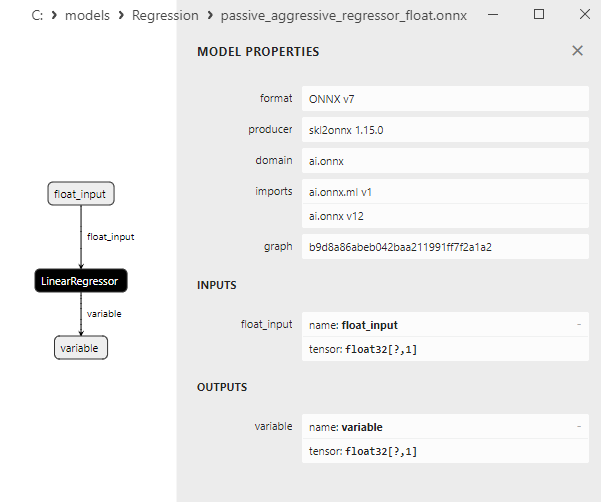

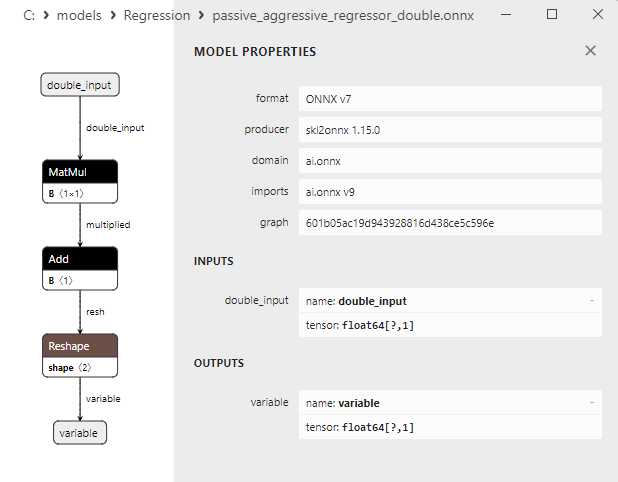

2.1.17.3. ONNX-представление моделей passive_aggressive_regressor_float.onnx и passive_aggressive_regressor_double.onnx - 2.1.18. sklearn.linear_model.QuantileRegressor

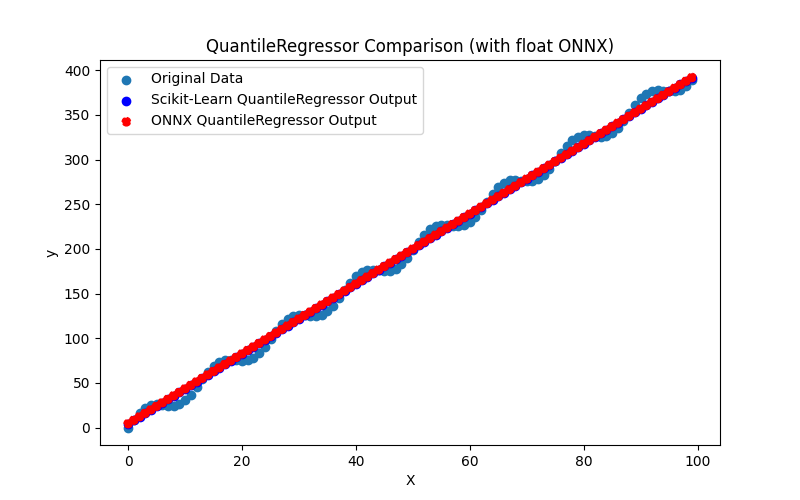

2.1.18.1. Код создания модели QuantileRegressor и ее экспорта в ONNX для float и double

2.1.18.2. Код на MQL5 для исполнения ONNX-моделей

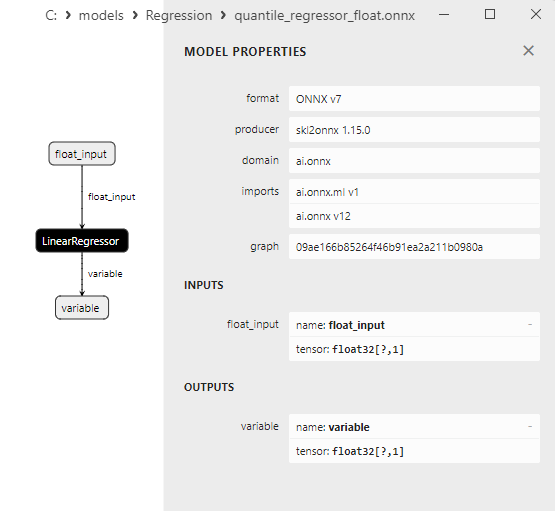

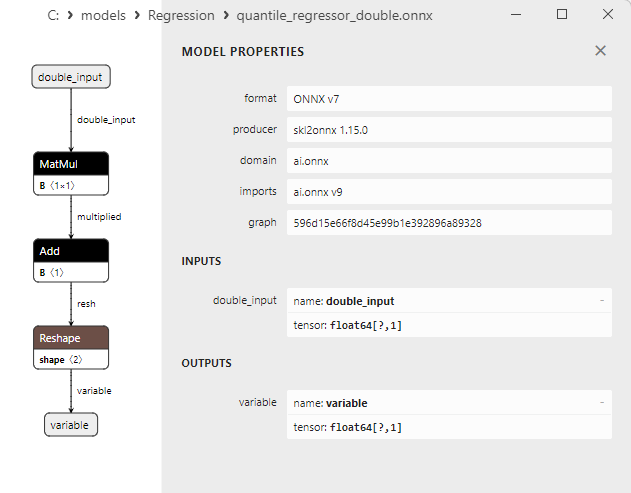

2.1.18.3. ONNX-представление моделей quantile_regressor_float.onnx и quantile_regressor_double.onnx - 2.1.19. sklearn.linear_model.RANSACRegressor

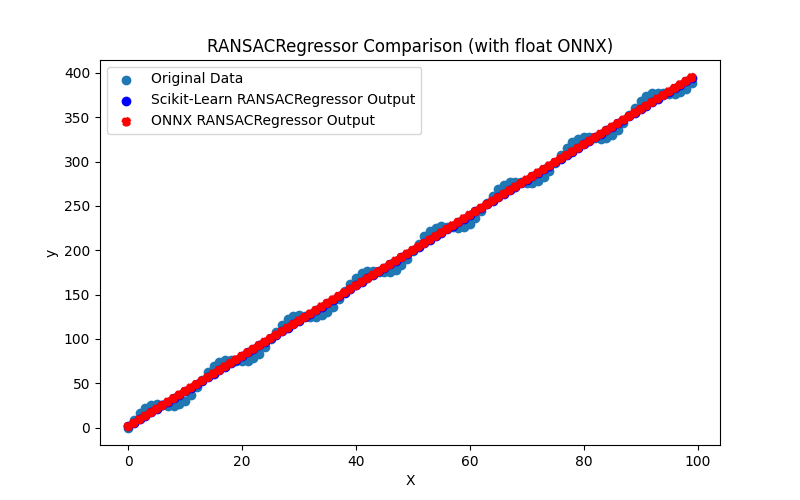

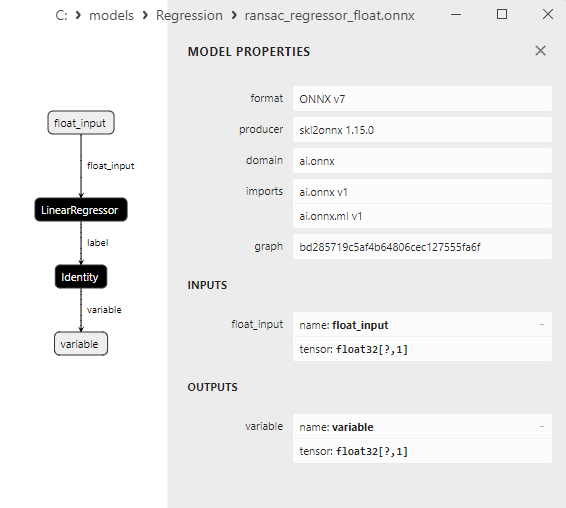

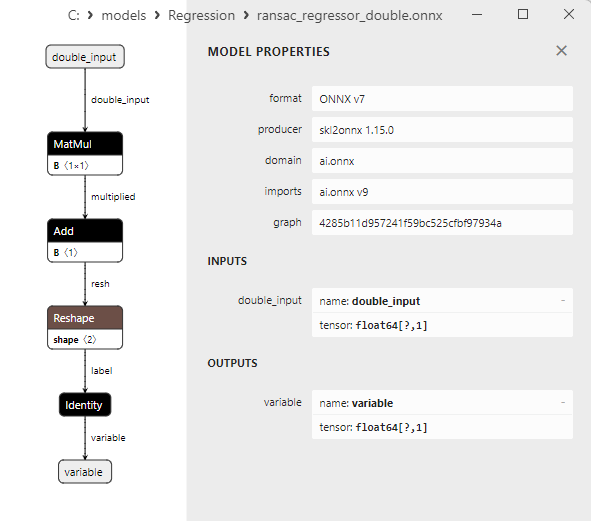

2.1.19.1. Код создания модели RANSACRegressor и ее экспорта в ONNX для float и double

2.1.19.2. Код на MQL5 для исполнения ONNX-моделей

2.1.19.3. ONNX-представление моделей ransac_regressor_float.onnx и ransac_regressor_double.onnx - 2.1.20. sklearn.linear_model.TheilSenRegressor

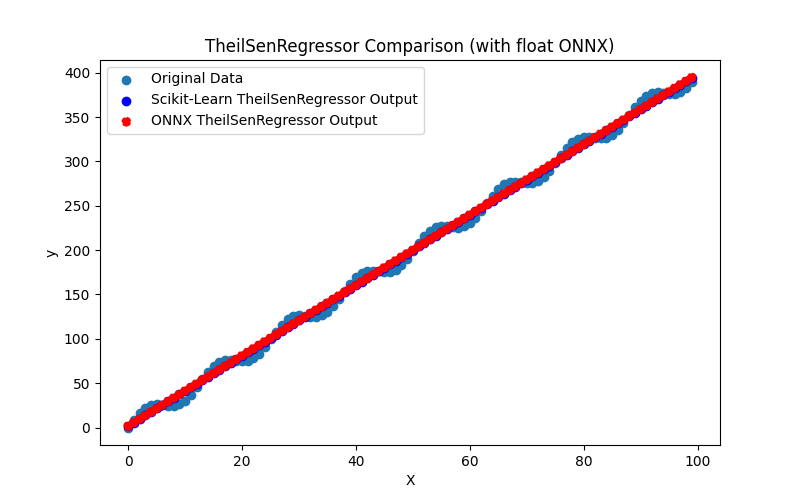

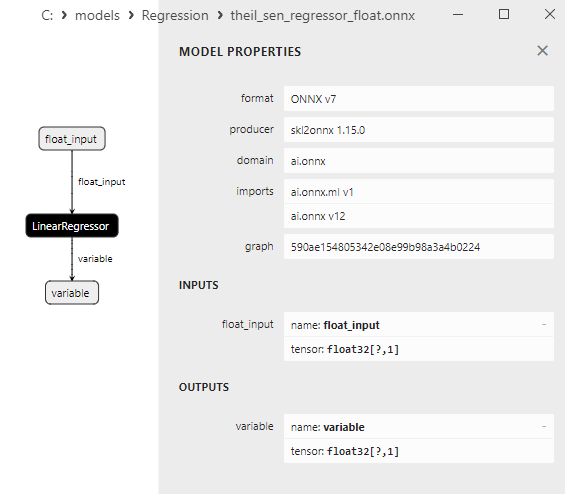

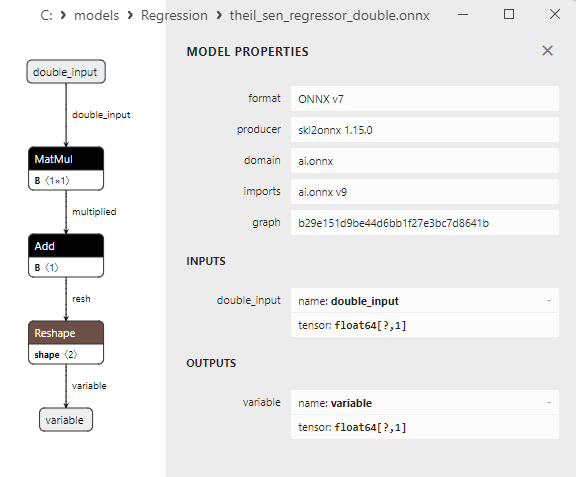

2.1.20.1. Код создания модели TheilSenRegressorи ее экспорта в ONNX для float и double

2.1.20.2. Код на MQL5 для исполнения ONNX-моделей

2.1.20.3. ONNX-представление моделей theil_sen_regressor_float.onnx и theil_sen_regressor_double.onnx - 2.1.21. sklearn.linear_model.LinearSVR

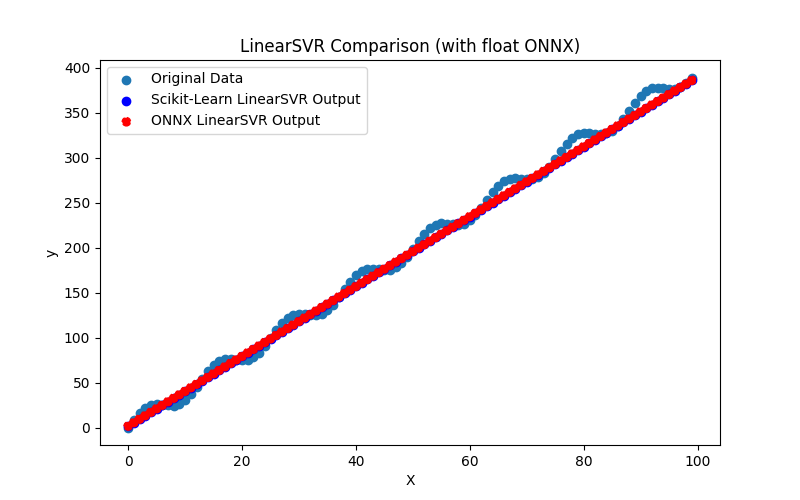

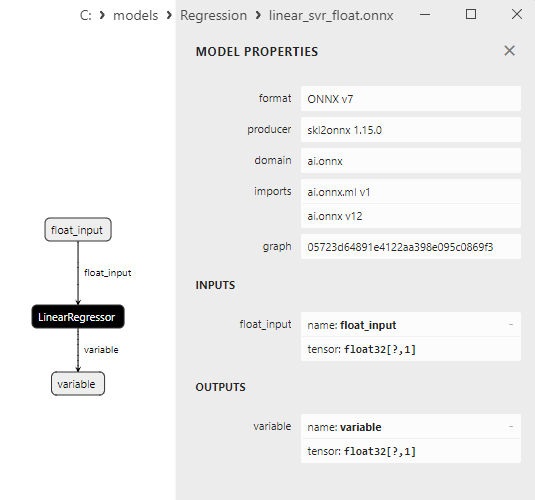

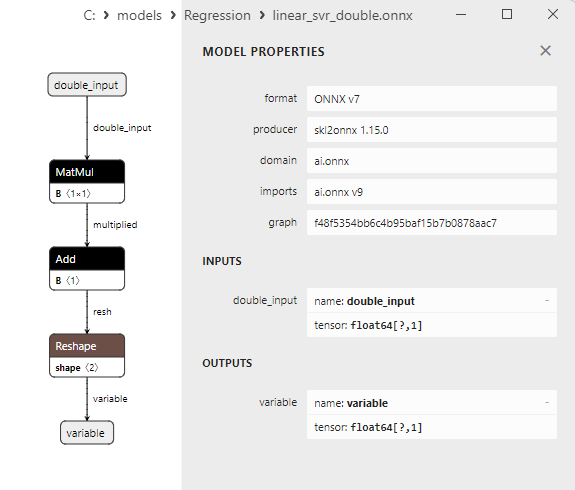

2.1.21.1. Код создания модели LinearSVR и ее экспорта в ONNX для float и double

2.1.21.2. Код на MQL5 для исполнения ONNX-моделей

2.1.21.3. ONNX-представление моделей linear_svr_float.onnx и linear_svr_double.onnx - 2.1.22. sklearn.linear_model.MLPRegressor

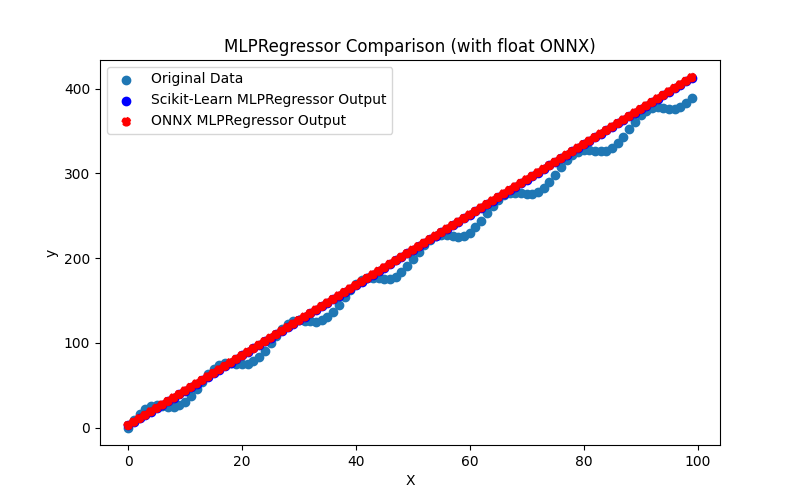

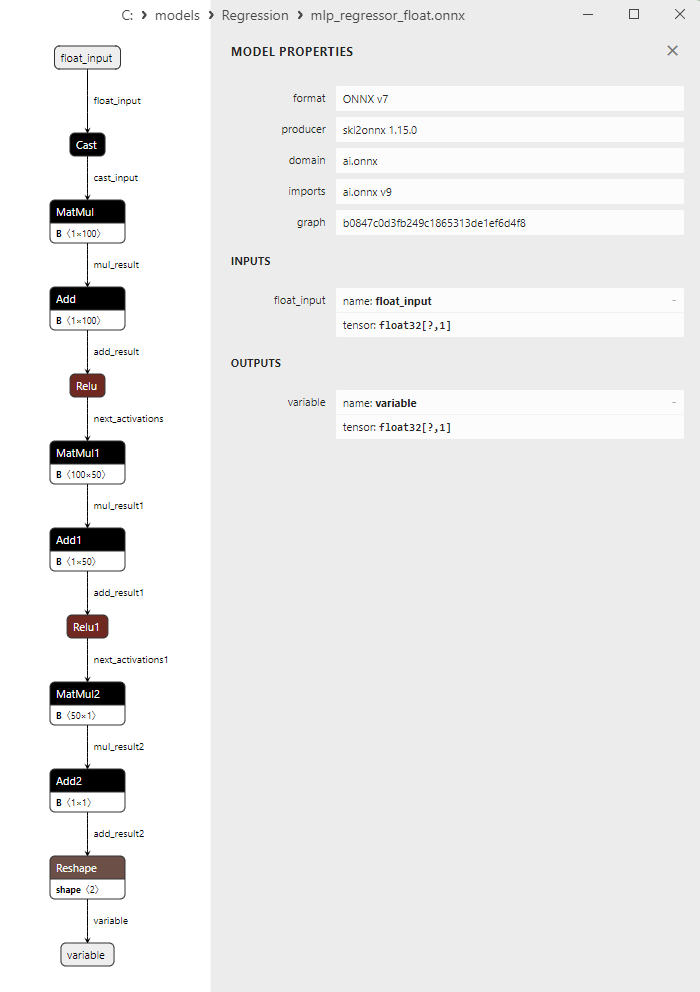

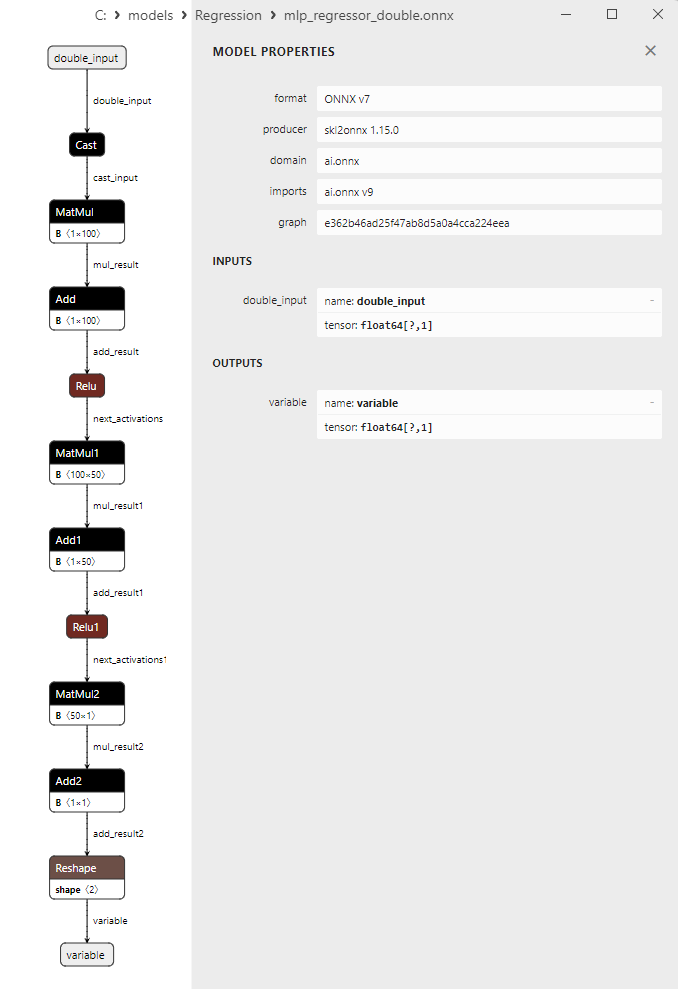

2.1.22.1. Код создания модели MLPRegressor и ее экспорта в ONNX для float и double

2.1.22.2. Код на MQL5 для исполнения ONNX-моделей

2.1.22.3. ONNX-представление моделей mlp_regressor_float.onnx и mlp_regressor_double.onnx - 2.1.23. sklearn.cross_decomposition.PLSRegression

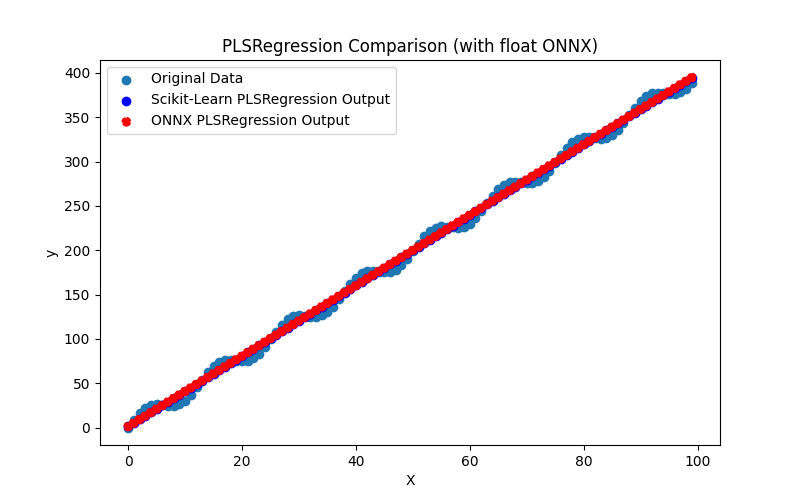

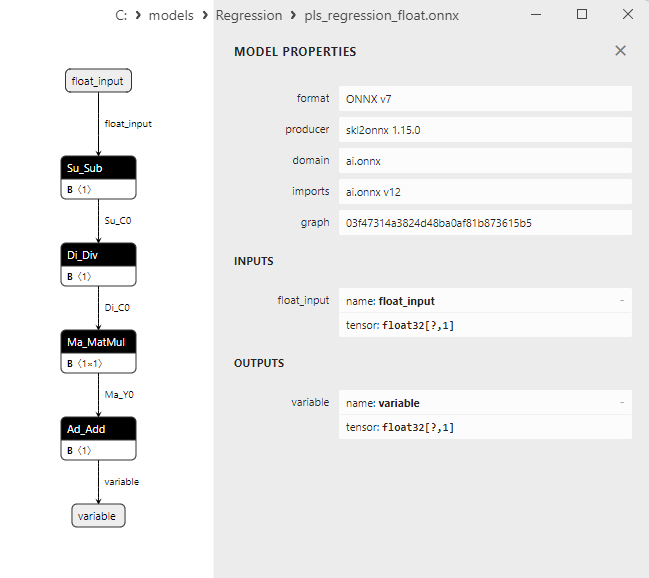

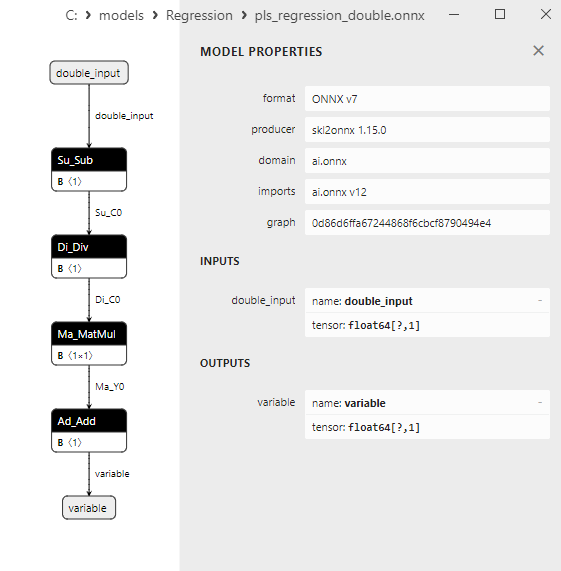

2.1.23.1. Код создания модели PLSRegression и ее экспорта в ONNX для float и double

2.1.23.2. Код на MQL5 для исполнения ONNX-моделей

2.1.23.3. ONNX-представление моделей pls_regression_float.onnx и pls_regression_double.onnx - 2.1.24. sklearn.linear_model.TweedieRegressor

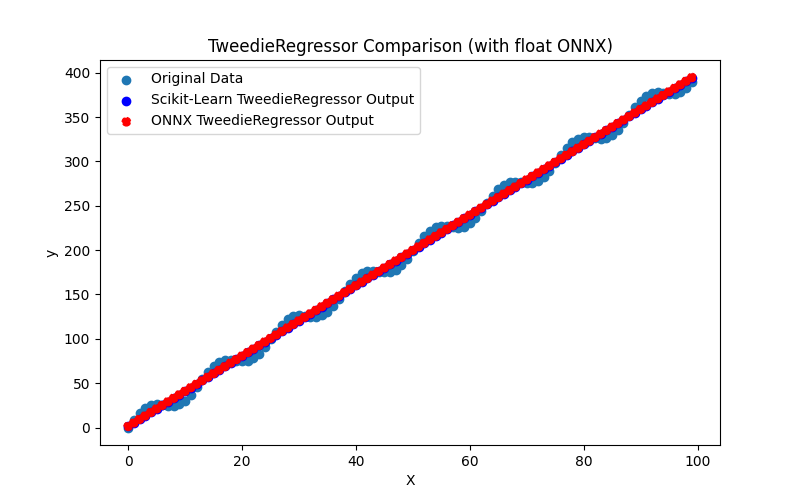

2.1.24.1. Код создания модели TweedieRegressor и ее экспорта в ONNX для float и double

2.1.24.2. Код на MQL5 для исполнения ONNX-моделей

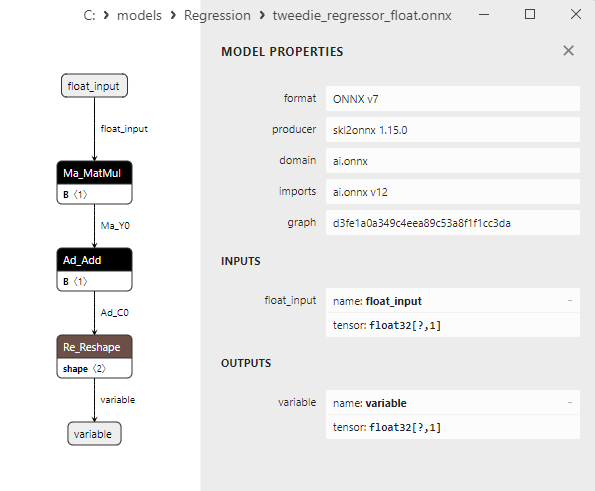

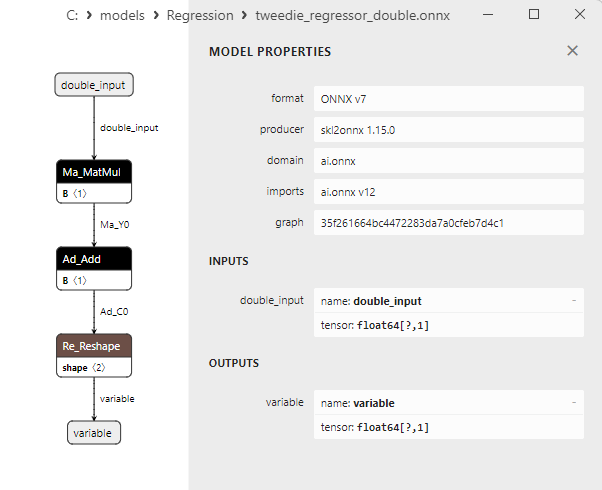

2.1.24.3. ONNX-представление моделей tweedie_regressor_float.onnx и tweedie_regressor_double.onnx - 2.1.25. sklearn.linear_model.PoissonRegressor

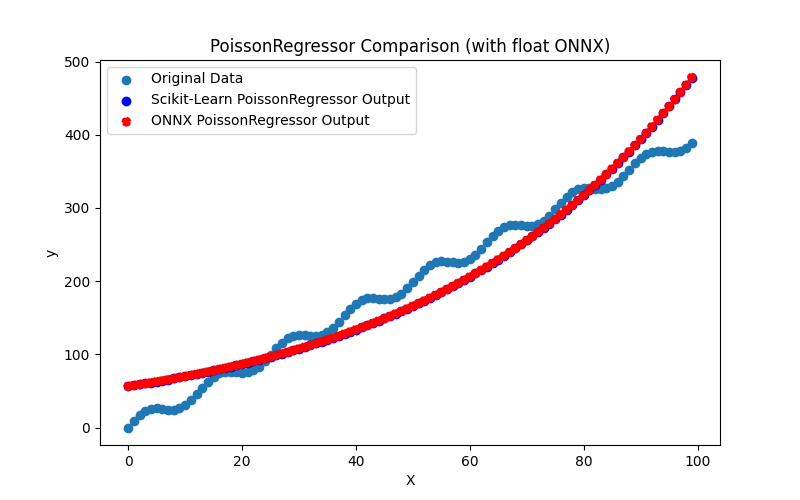

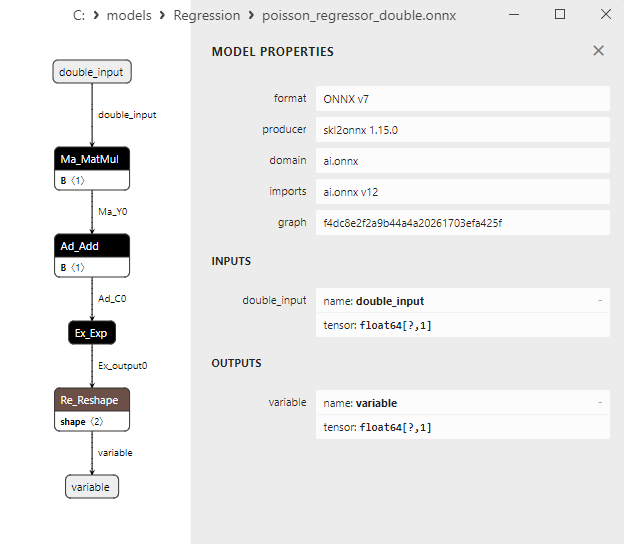

2.1.25.1. Код создания модели PoissonRegressor и ее экспорта в ONNX для float и double

2.1.25.2. Код на MQL5 для исполнения ONNX-моделей

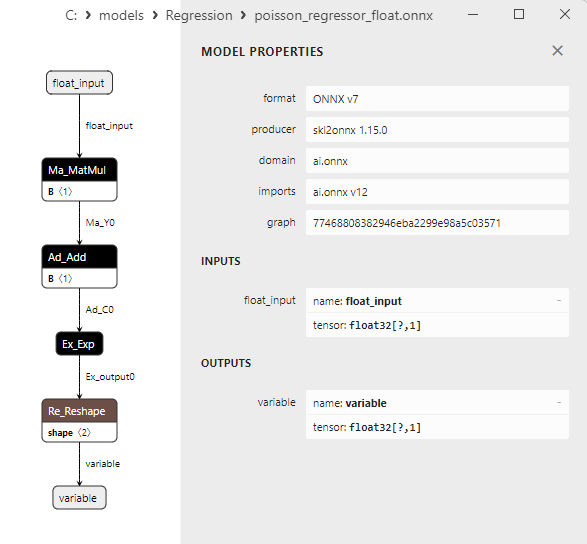

2.1.25.3. ONNX-представление моделей poisson_regressor_float.onnx и poisson_regressor_double.onnx - 2.1.26. sklearn.neighbors.RadiusNeighborsRegressor

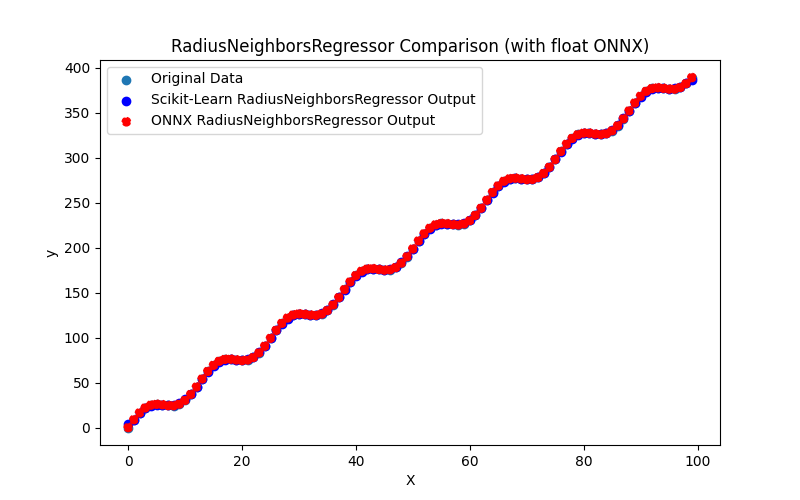

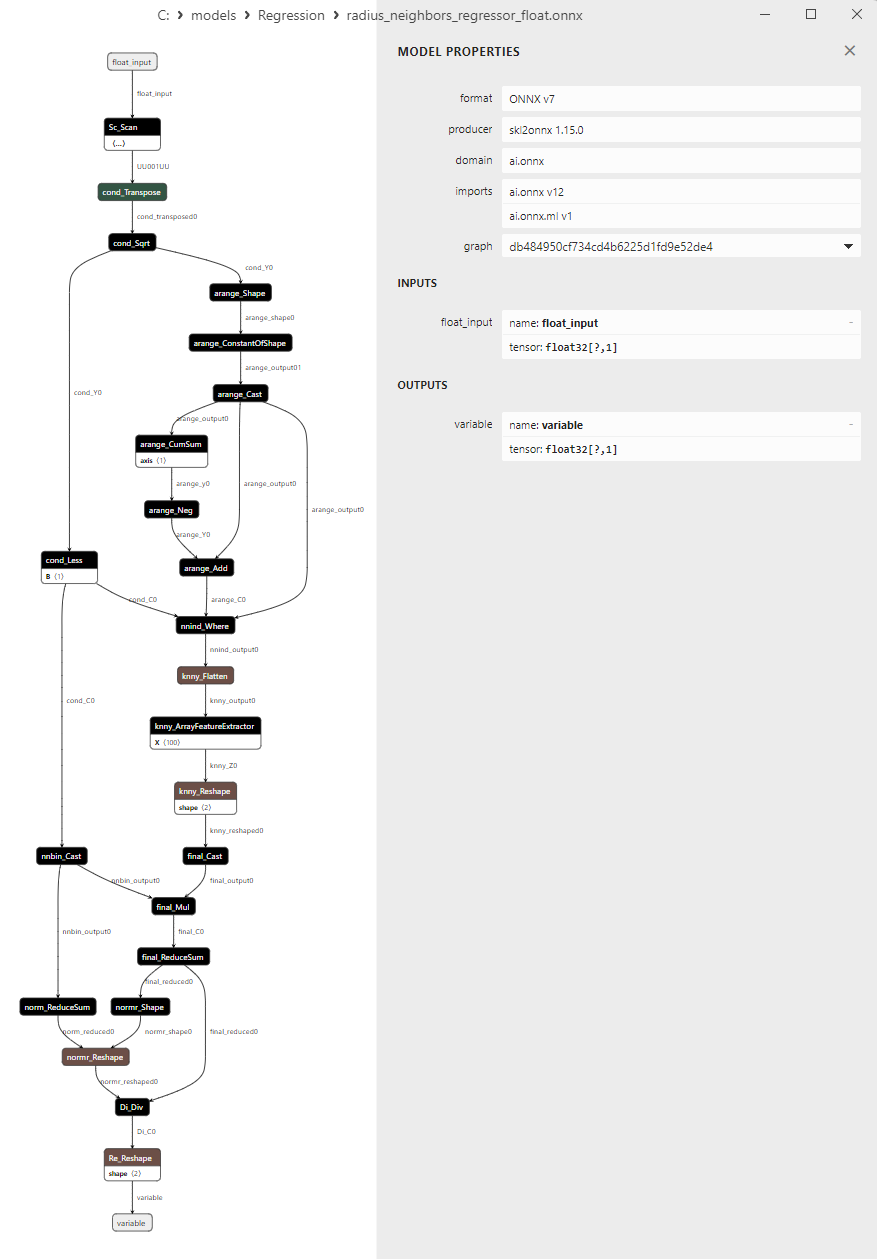

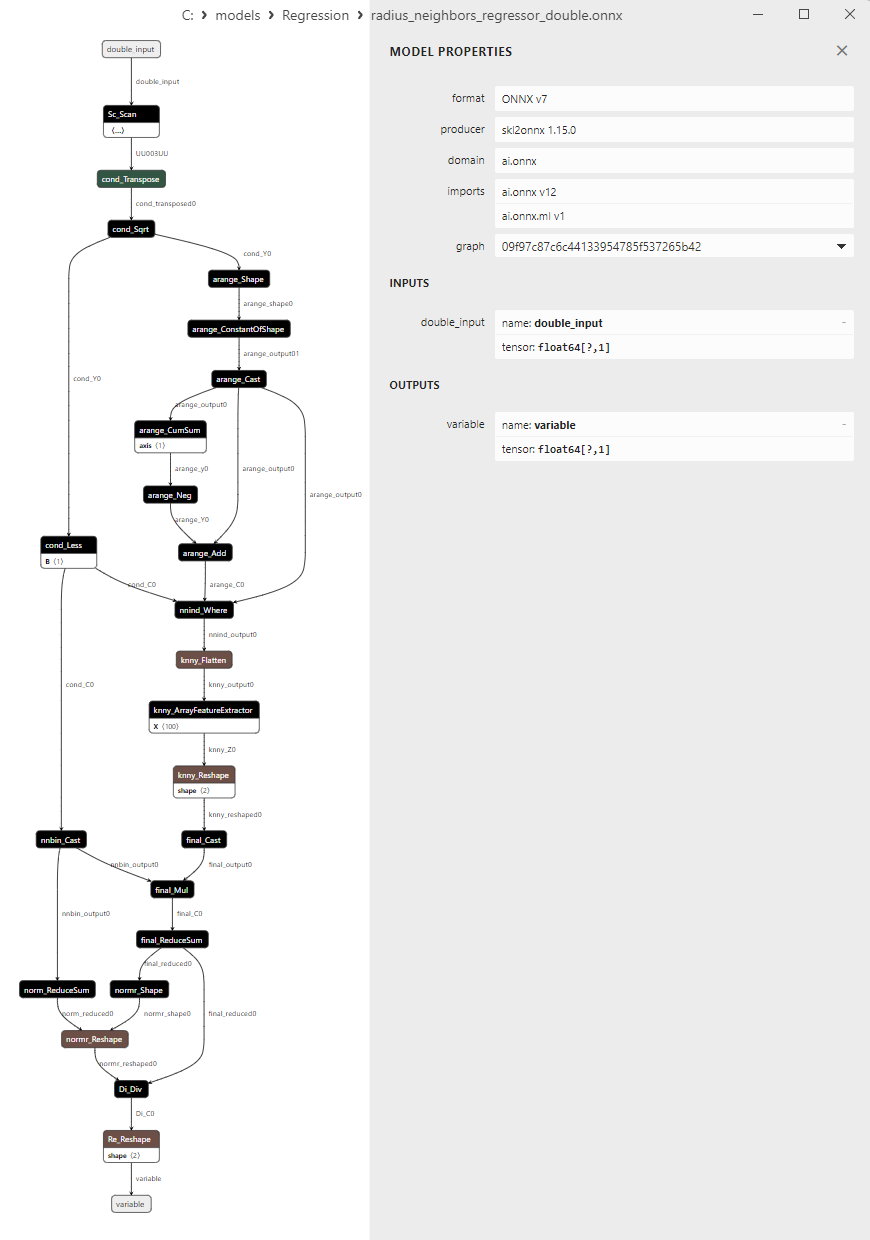

2.1.26.1. Код создания модели RadiusNeighborsRegressor и ее экспорта в ONNX для float и double

2.1.26.2. Код на MQL5 для исполнения ONNX-моделей

2.1.26.3. ONNX-представление моделей radius_neighbors_regressor_float.onnx и radius_neighbors_regressor_double.onnx - 2.1.27. sklearn.neighbors.KNeighborsRegressor

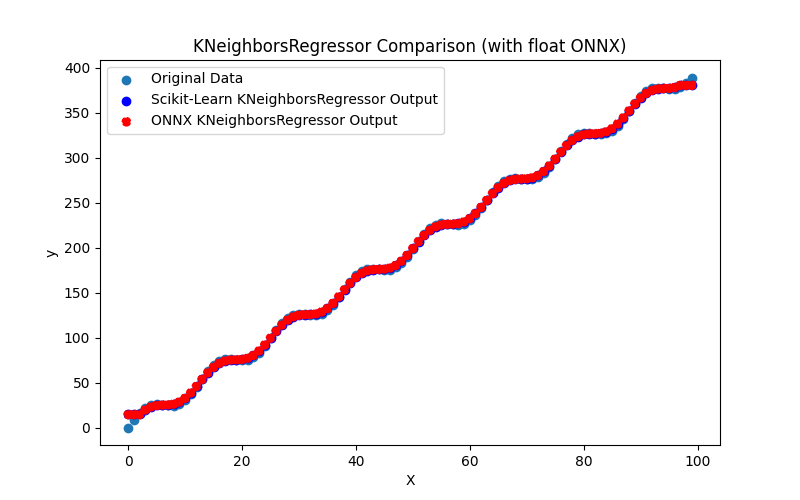

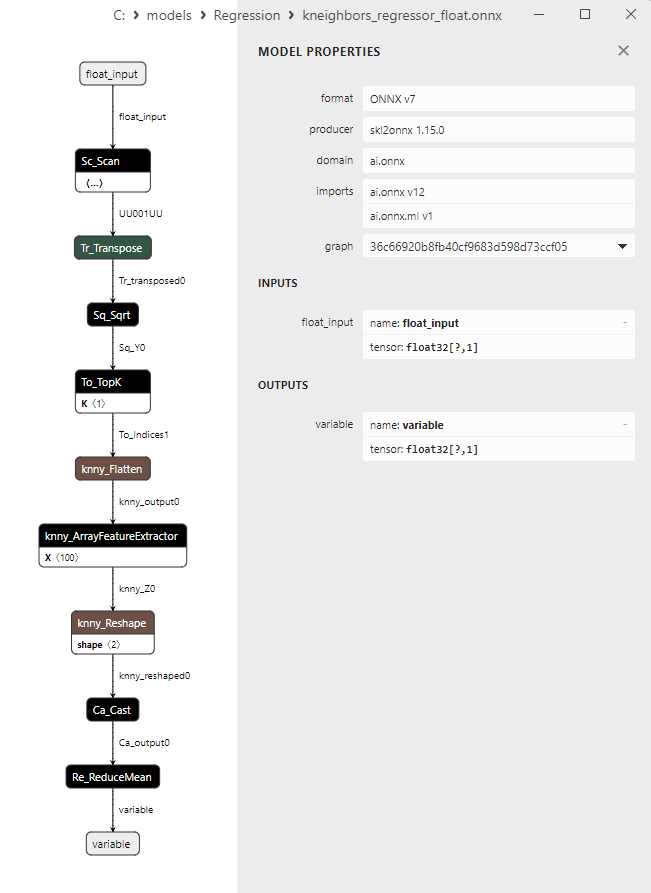

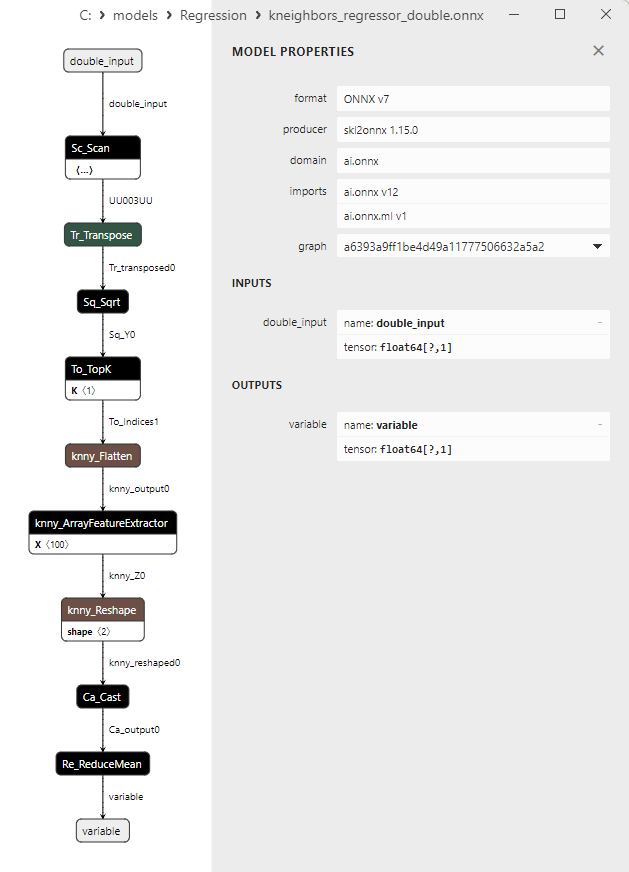

2.1.27.1. Код создания модели KNeighborsRegressor и ее экспорта в ONNX для float и double

2.1.27.2. Код на MQL5 для исполнения ONNX-моделей

2.1.27.3. ONNX-представление моделей kneighbors_regressor_float.onnx и kneighbors_regressor_double.onnx

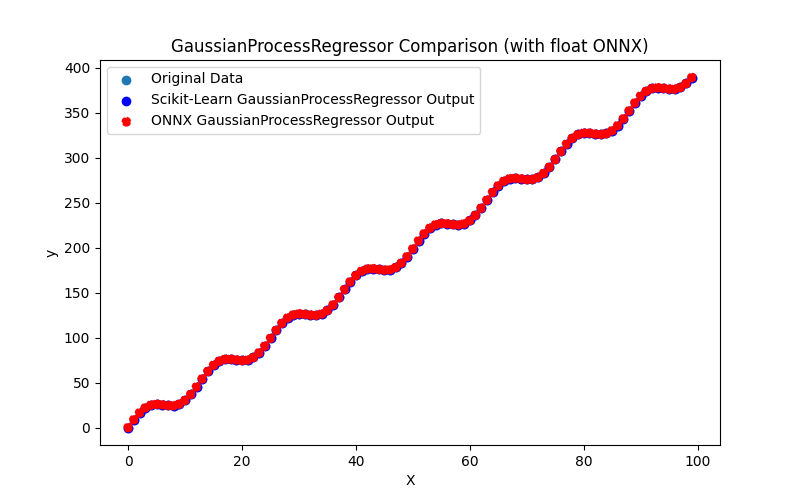

- 2.1.28. sklearn.gaussian_process.GaussianProcessRegressor

2.1.28.1. Код создания модели GaussianProcessRegressor и ее экспорта в ONNX для float и double

2.1.28.2. Код на MQL5 для исполнения ONNX-моделей

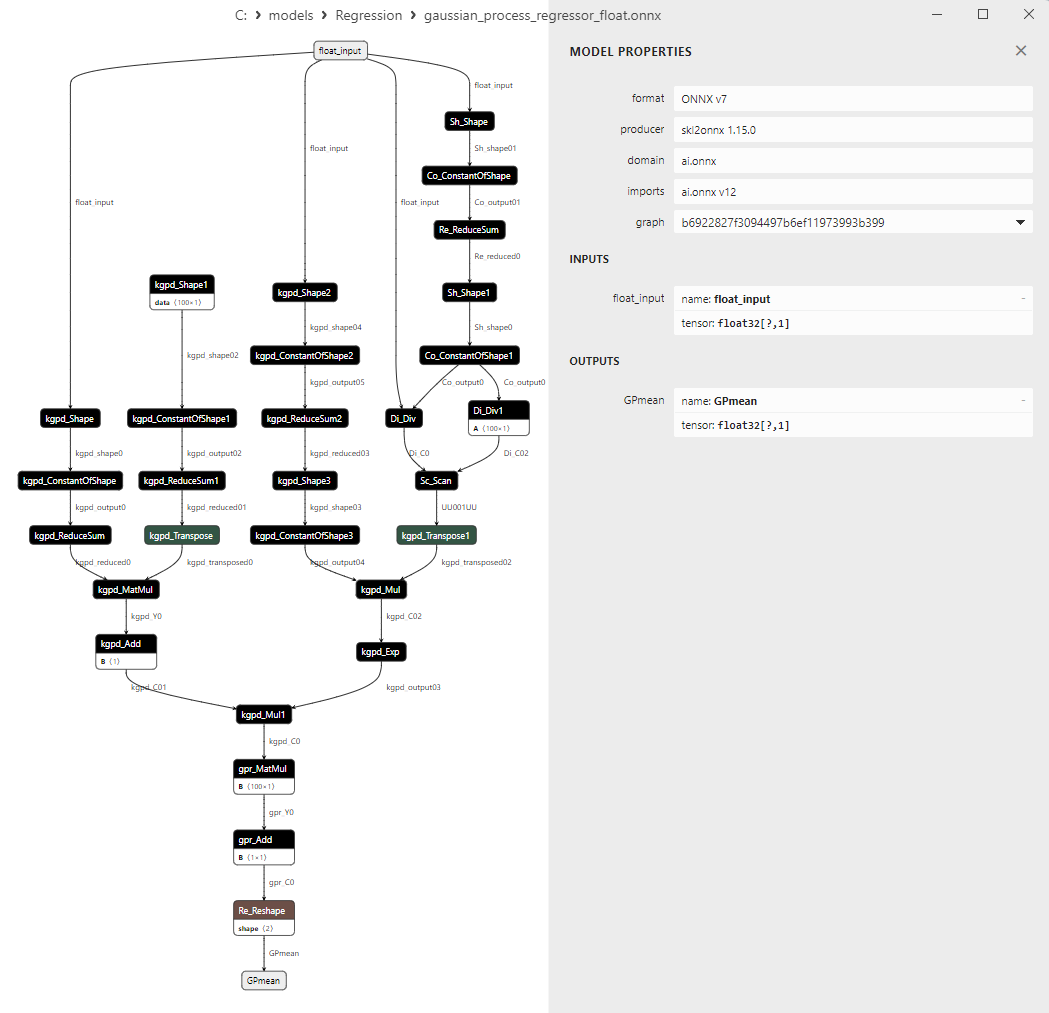

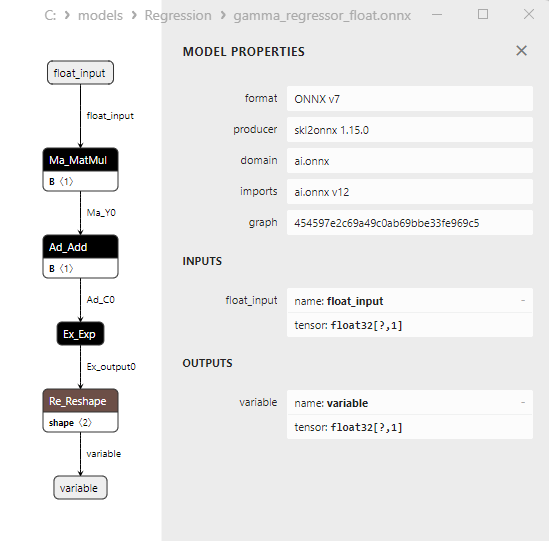

2.1.28.3. ONNX-представление моделей gaussian_process_regressor_float.onnx и gaussian_process_regressor_double.onnx

- 2.1.29. sklearn.linear_model.GammaRegressor

2.1.29.1. Код создания модели GammaRegressor и ее экспорта в ONNX для float и double

2.1.29.2. Код на MQL5 для исполнения ONNX-моделей

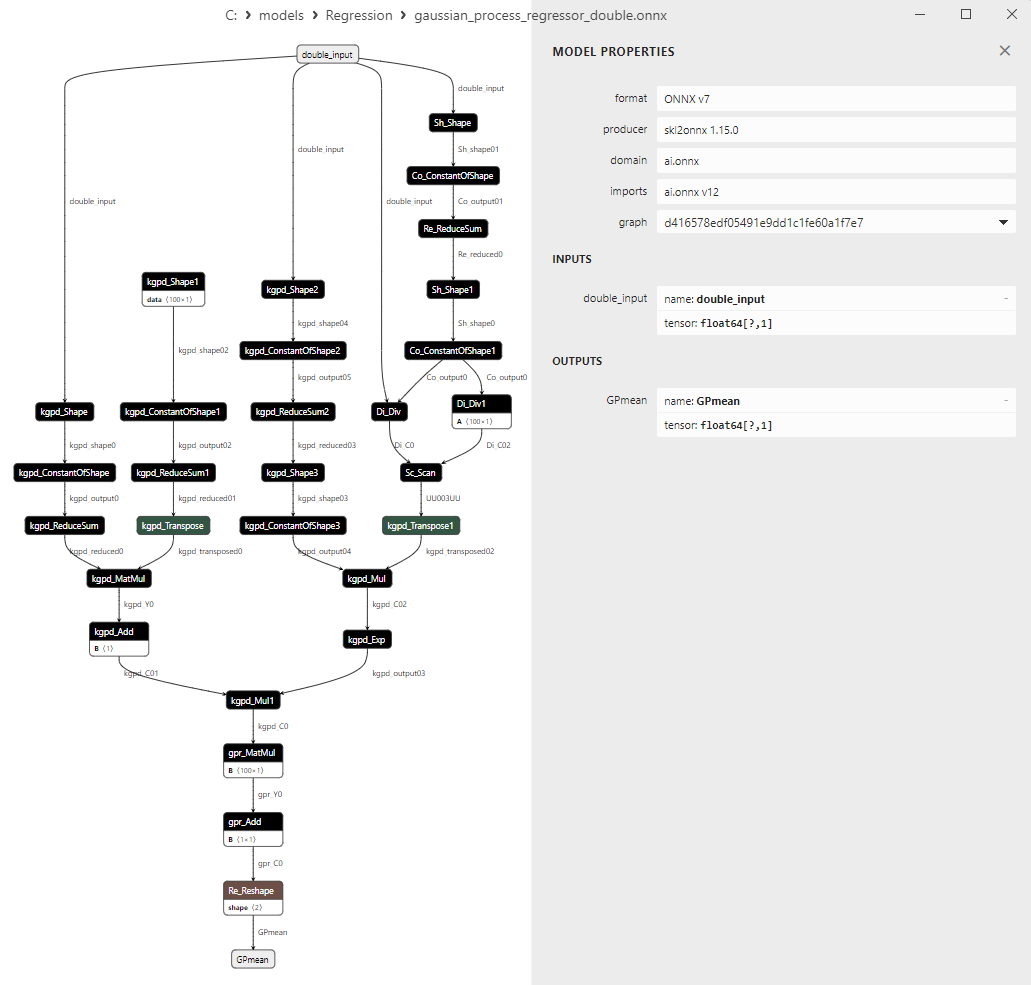

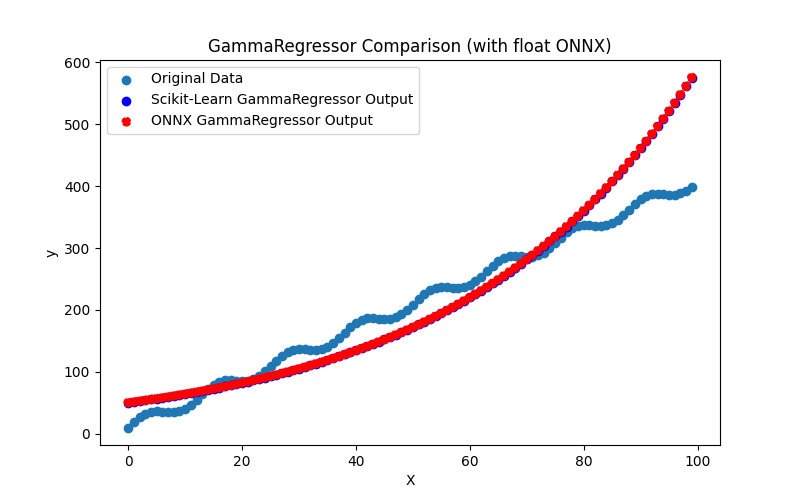

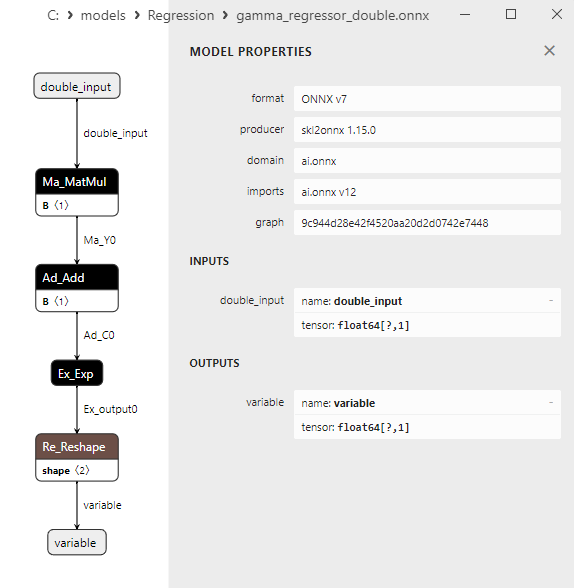

2.1.29.3. ONNX-представление моделей gamma_regressor_float.onnx и gamma_regressor_double.onnx - 2.1.30. sklearn.linear_model.SGDRegressor

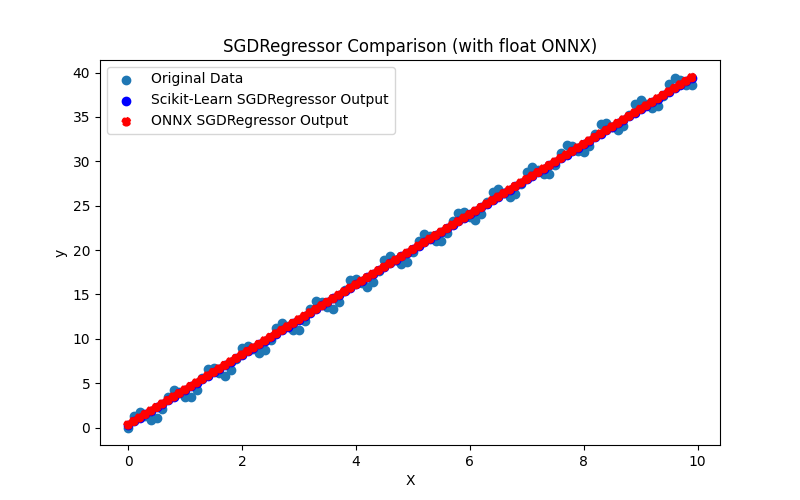

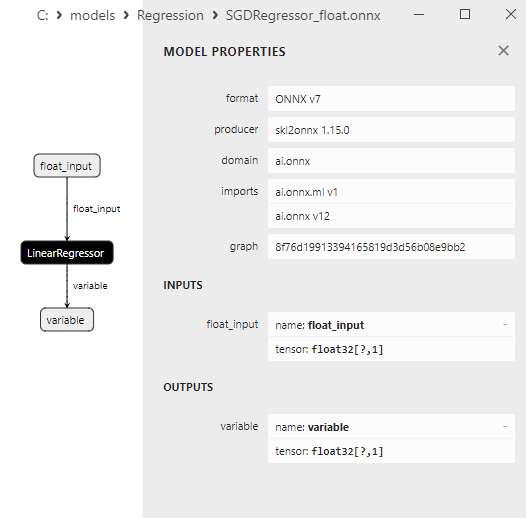

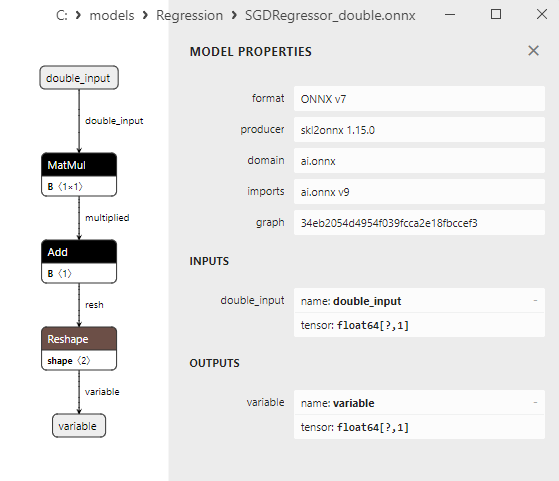

2.1.30.1. Код создания модели SGDRegressor и ее экспорта в ONNX для float и double

2.1.30.2. Код на MQL5 для исполнения ONNX-моделей

2.1.30.3. ONNX-представление моделей sgd_regressor_float.onnx и sgd_rgressor_double.onnx

- 2.2. Регрессионные модели библиотеки Scikit-learn, которые конвертируются только во float ONNX-модели

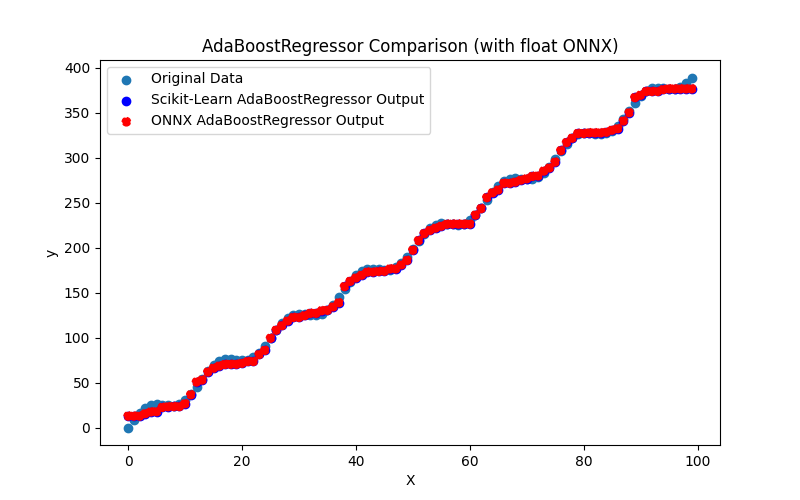

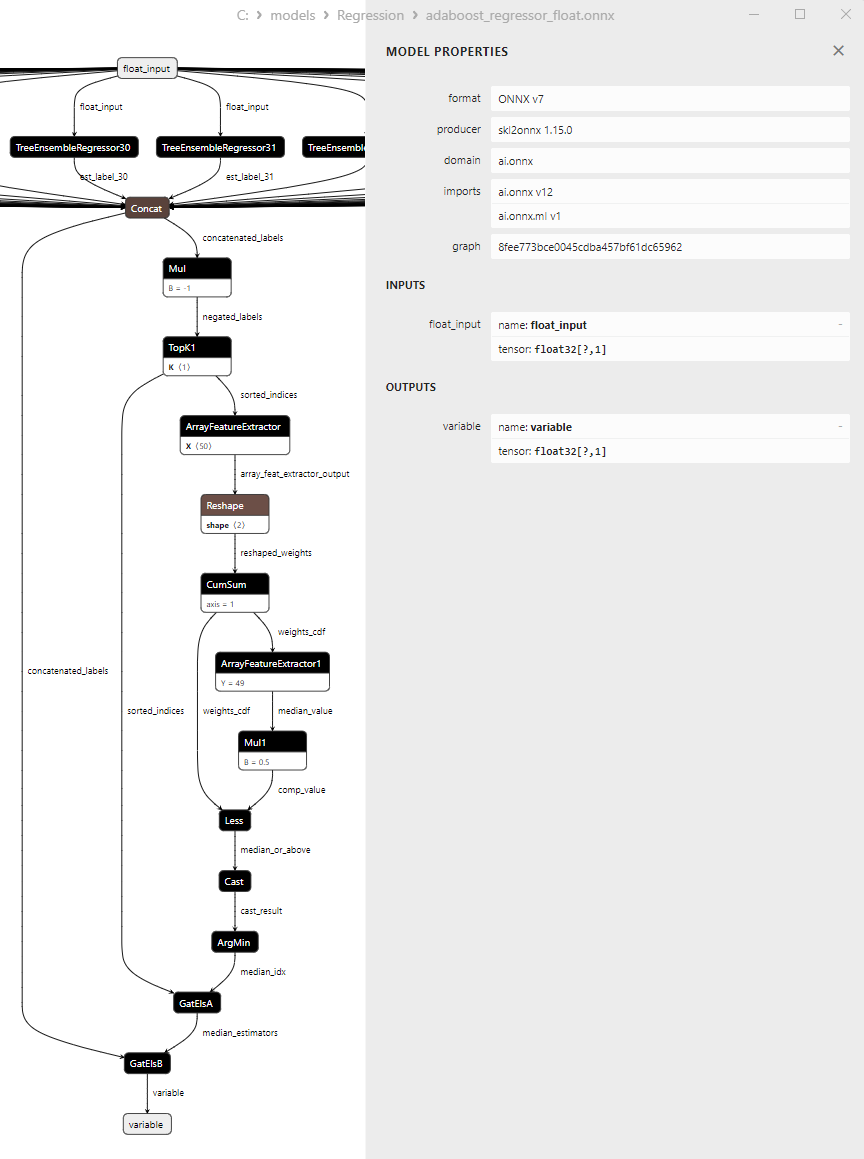

- 2.2.1. sklearn.linear_model.AdaBoostRegressor

2.2.1.1. Код создания модели AdaBoostRegressor и ее экспорта в ONNX для float и double

2.2.1.2. Код на MQL5 для исполнения ONNX-моделей

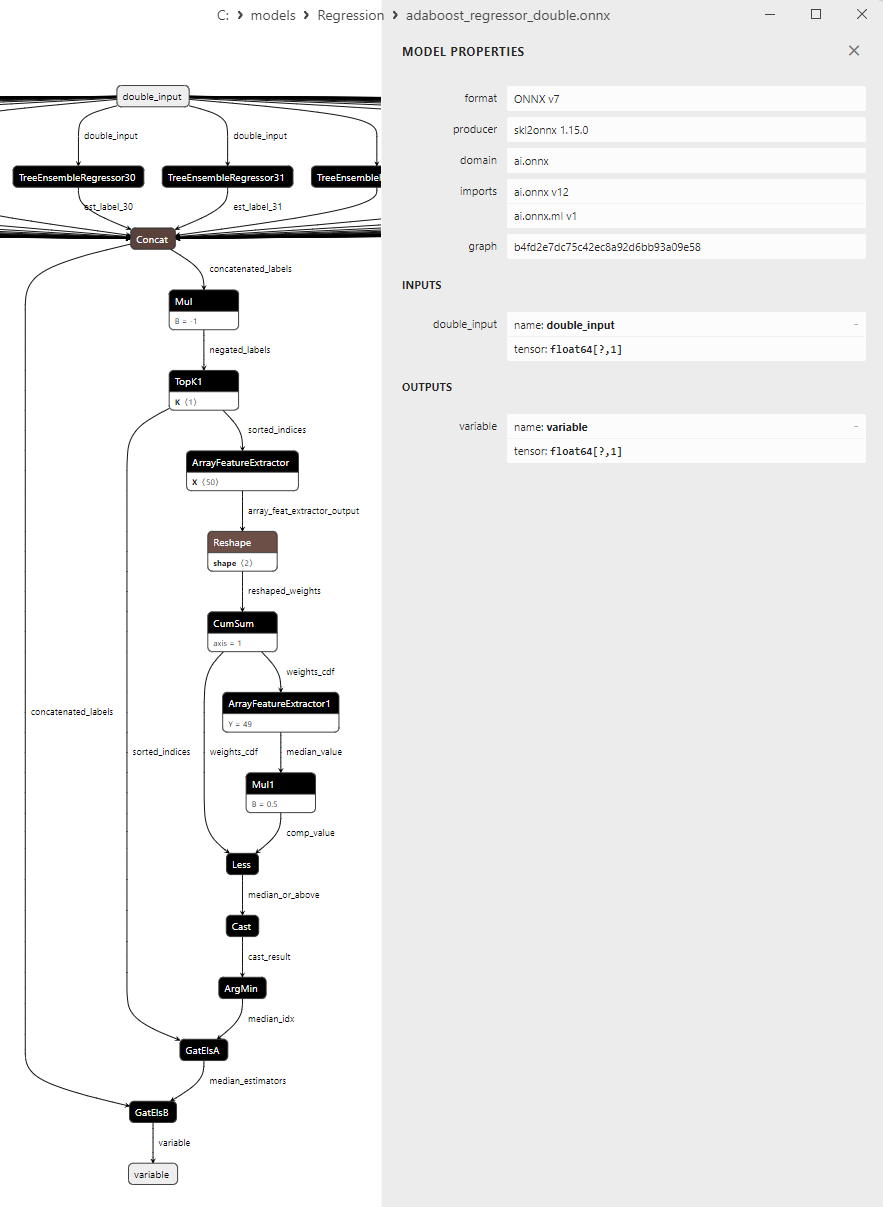

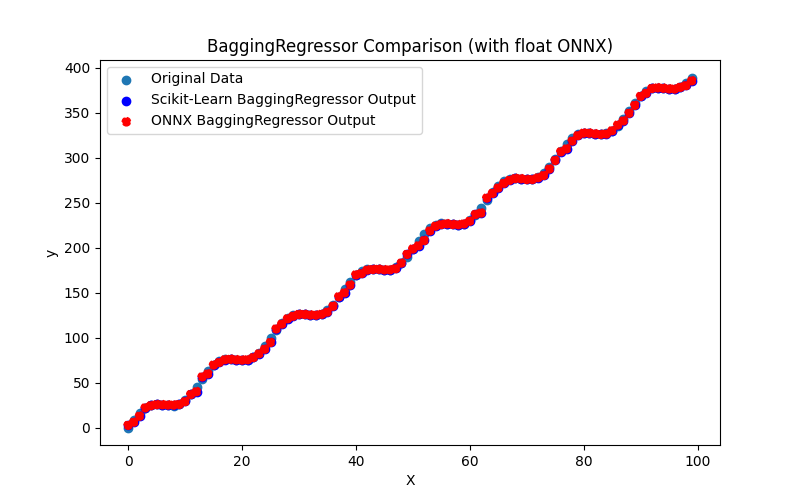

2.2.1.3. ONNX-представление моделей adaboost_regressor_float.onnx и adaboost_regressor_double.onnx - 2.2.2. sklearn.linear_model.BaggingRegressor

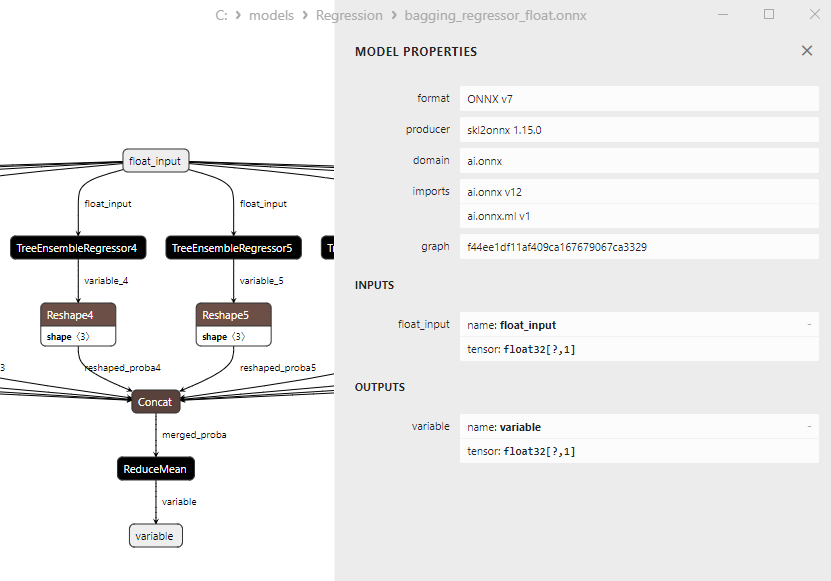

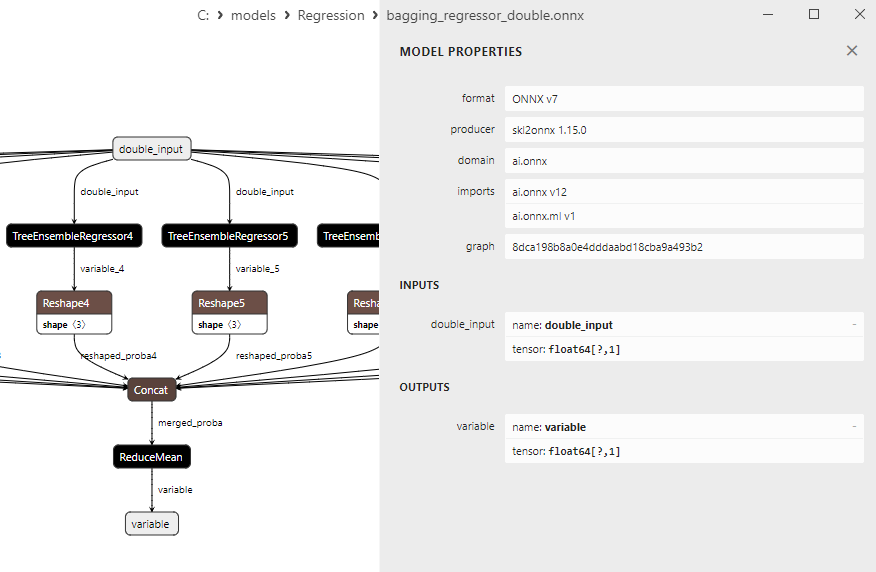

2.2.2.1. Код создания модели BaggingRegressor и ее экспорта в ONNX для float и double

2.2.2.2. Код на MQL5 для исполнения ONNX-моделей

2.2.2.3. ONNX-представление моделей bagging_regressor_float.onnx и bagging_regressor_double.onnx - 2.2.3. sklearn.linear_model.DecisionTreeRegressor

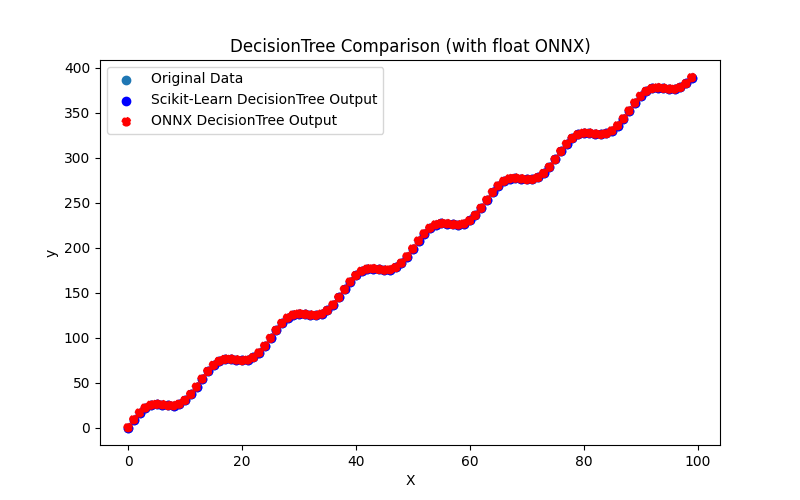

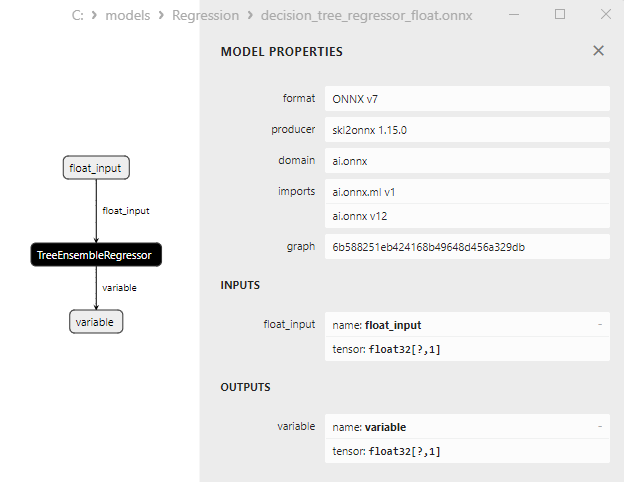

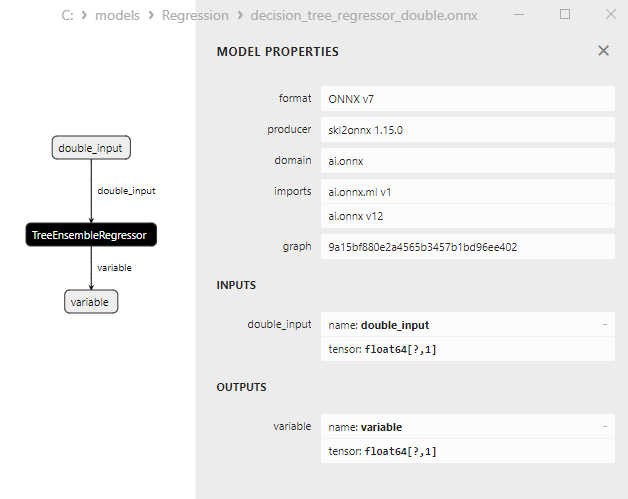

2.2.3.1. Код создания модели DecisionTreeRegressor и ее экспорта в ONNX для float и double

2.2.3.2. Код на MQL5 для исполнения ONNX-моделей

2.2.3.3. ONNX-представление моделей decision_tree_regressor_float.onnx и decision_tree_regressor_double.onnx - 2.2.4. sklearn.linear_model.ExtraTreeRegressor

2.2.4.1. Код создания модели ExtraTreeRegressor и ее экспорта в ONNX для float и double

2.2.4.2. Код на MQL5 для исполнения ONNX-моделей

2.2.4.3. ONNX-представление моделей extra_tree_regressor_float.onnx и extra_tree_regressor_double.onnx - 2.2.5. sklearn.ensemble.ExtraTreesRegressor

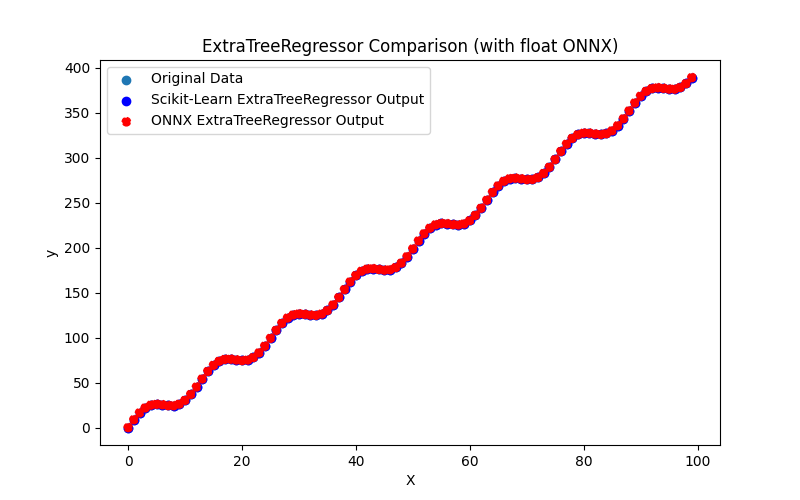

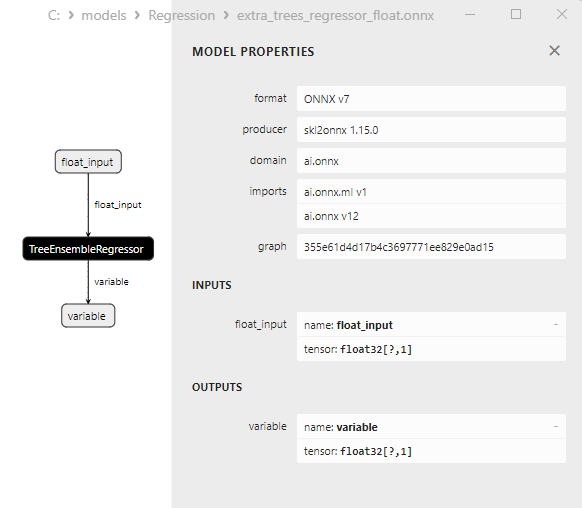

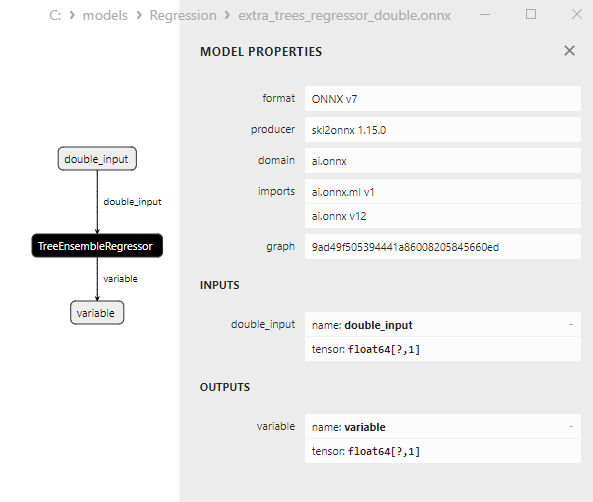

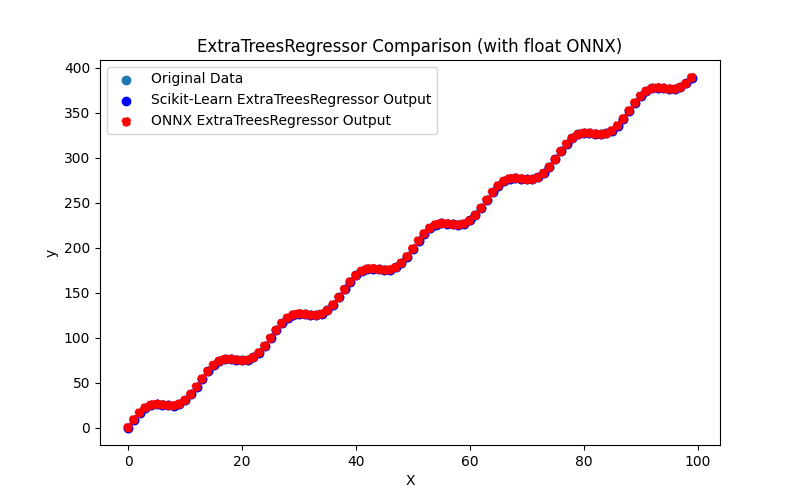

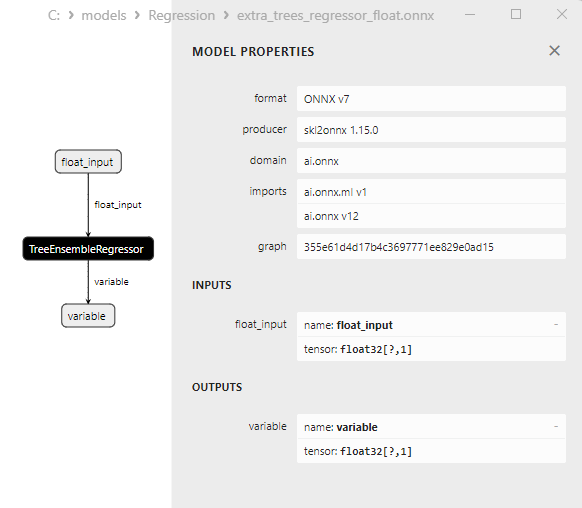

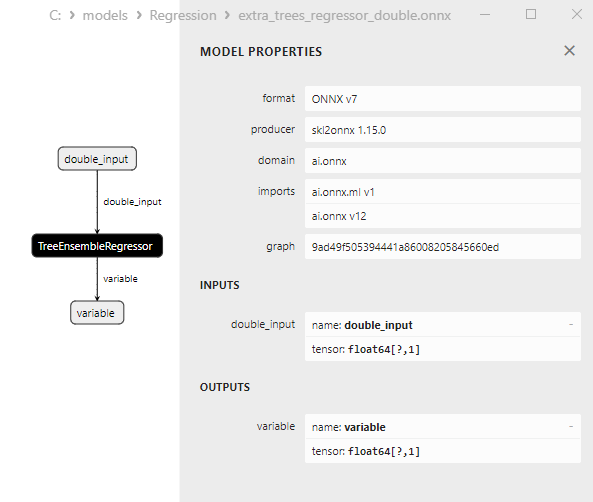

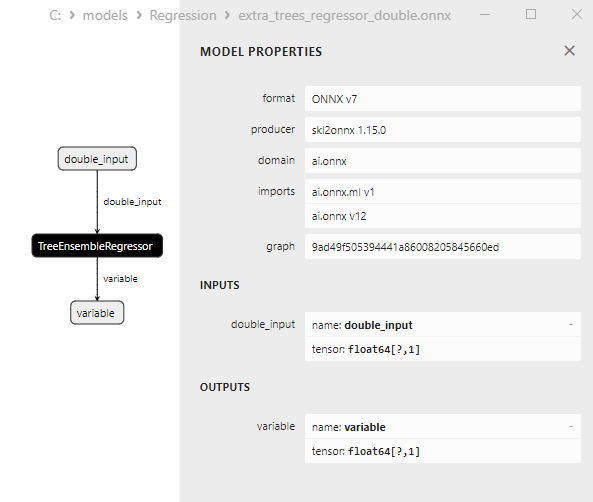

2.2.5.1. Код создания модели ExtraTreesRegressor и ее экспорта в ONNX для float и double

2.2.5.2. Код на MQL5 для исполнения ONNX-моделей

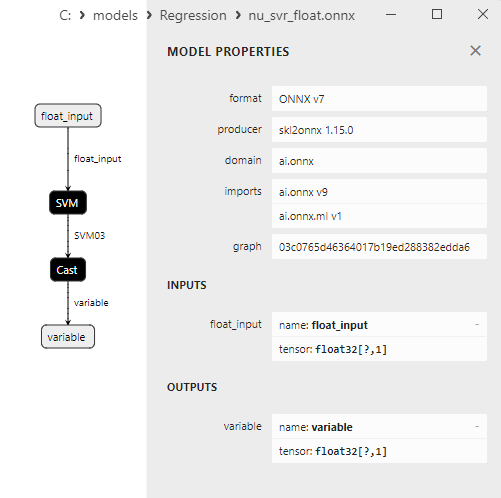

2.2.5.3. ONNX-представление моделей extra_trees_regressor_float.onnx и extra_trees_regressor_double.onnx - 2.2.6. sklearn.svm.NuSVR

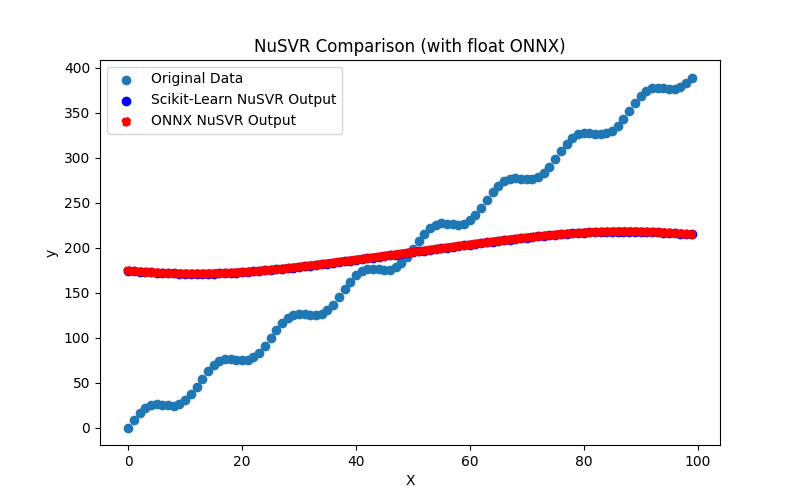

2.2.6.1. Код создания модели NuSVR и ее экспорта в ONNX для float и double

2.2.6.2. Код на MQL5 для исполнения ONNX-моделей

2.2.6.3. ONNX-представление моделей nu_svr_float.onnx и nu_svr_double.onnx - 2.2.7. sklearn.ensemble.RandomForestRegressor

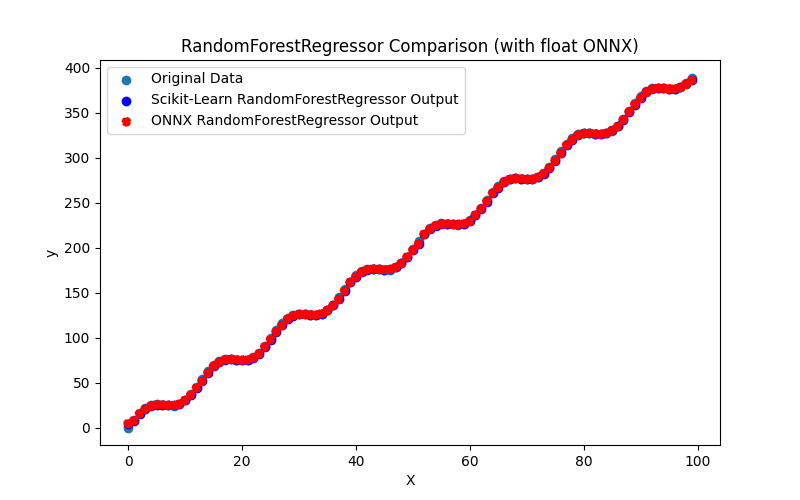

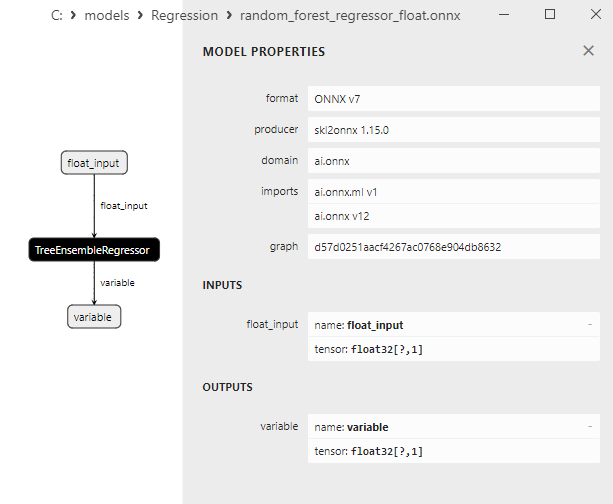

2.2.7.1. Код создания модели RandomForestRegressor и ее экспорта в ONNX для float и double

2.2.7.2. Код на MQL5 для исполнения ONNX-моделей

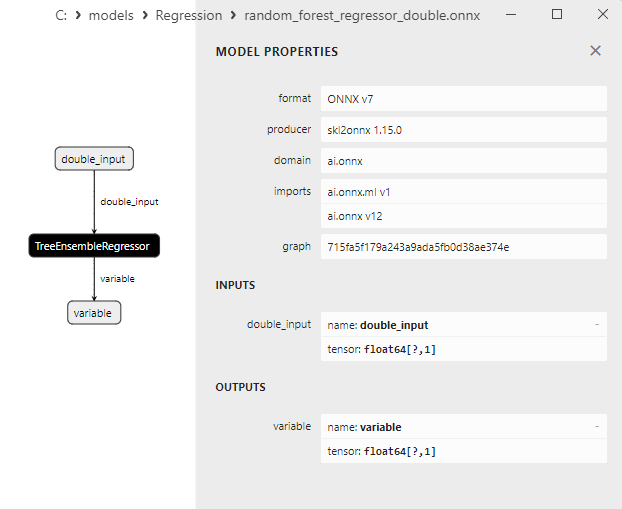

2.2.7.3. ONNX-представление моделей random_forest_regressor_float.onnx и random_forest_regressor_double.onnx

- 2.2.8. sklearn.ensemble.GradientBoostingRegressor

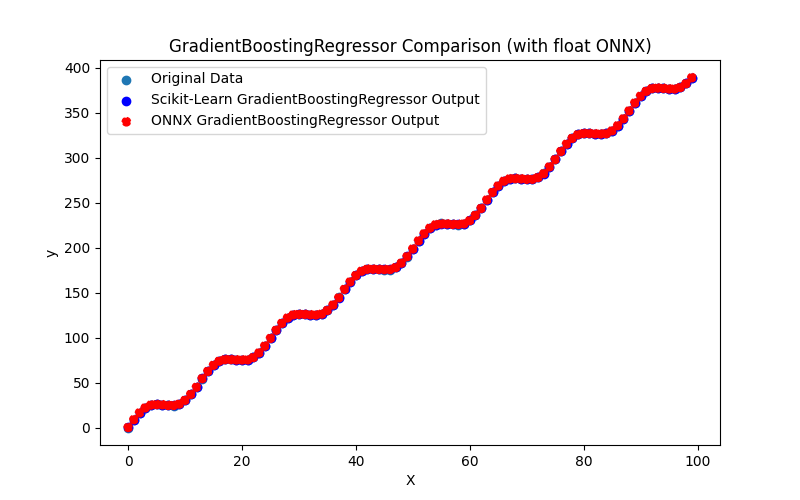

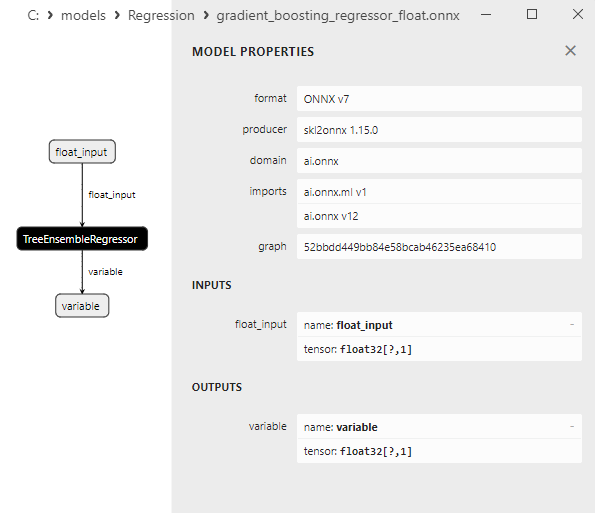

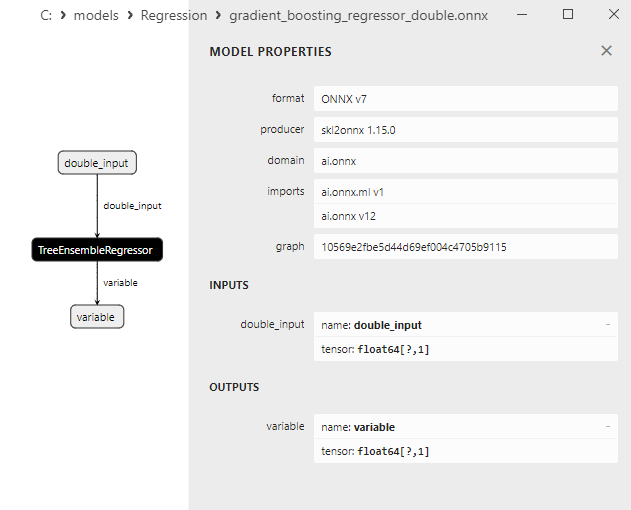

2.2.8.1. Код создания модели GradientBoostingRegressor и ее экспорта в ONNX для float и double

2.2.8.2. Код на MQL5 для исполнения ONNX-моделей

2.2.8.3. ONNX-представление моделей gradient_boosting_regressor_float.onnx и gradient_boosting_regressor_double.onnx

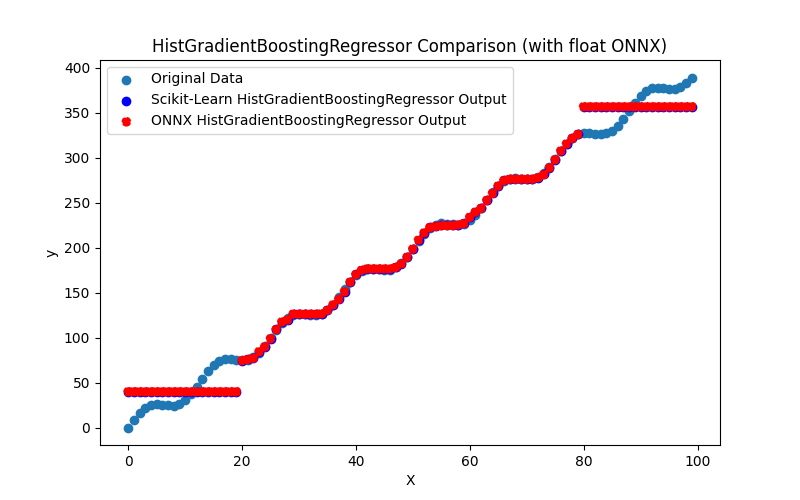

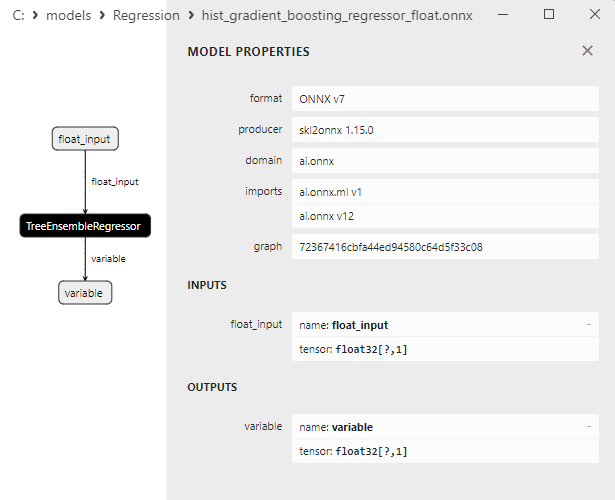

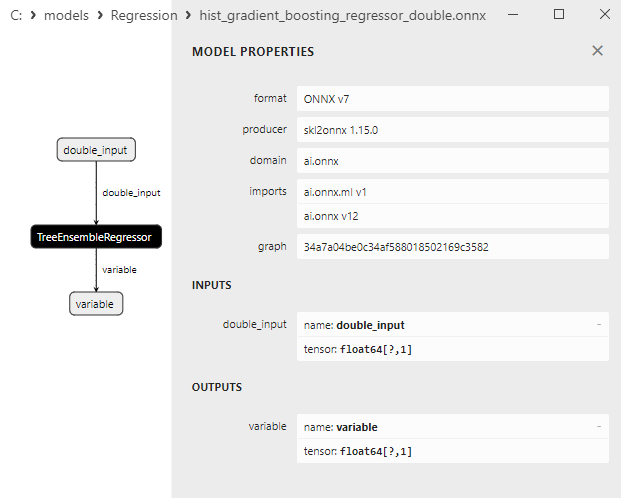

- 2.2.9. sklearn.ensemble.HistGradientBoostingRegressor

2.2.9.1. Код создания модели HistGradientBoostingRegressor и ее экспорта в ONNX для float и double

2.2.9.2. Код на MQL5 для исполнения ONNX-моделей

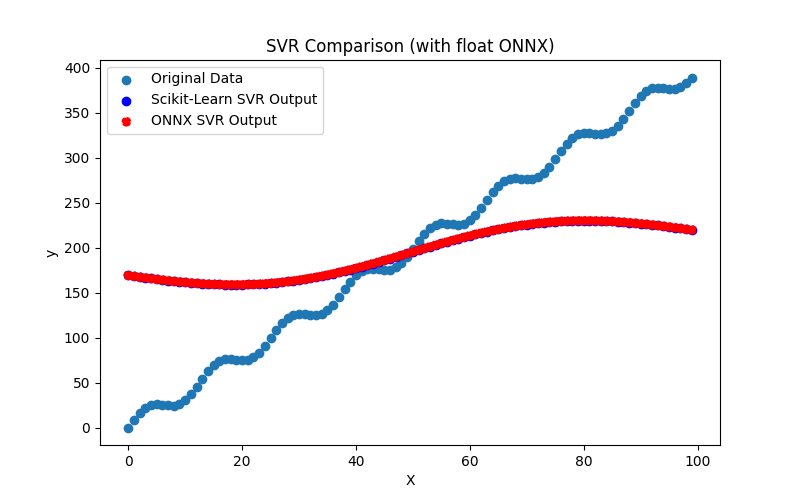

2.2.9.3. ONNX-представление моделей hist_gradient_boosting_regressor_float.onnx и hist_gradient_boosting_regressor_double.onnx - 2.2.10. sklearn.svm.SVR

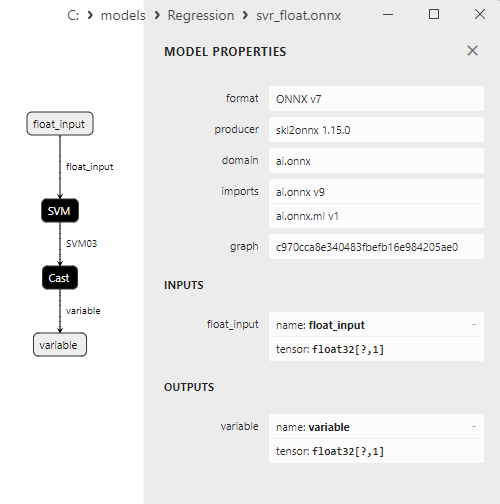

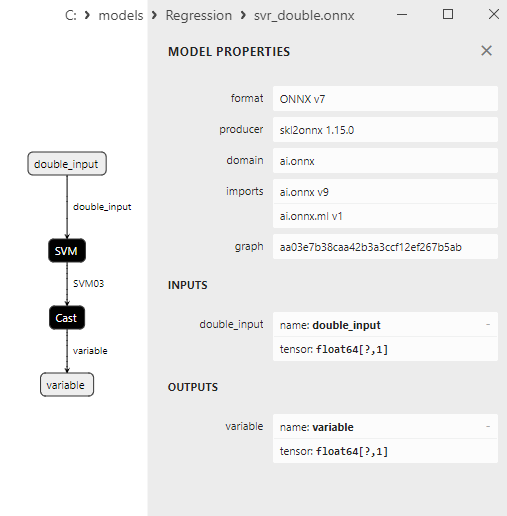

2.2.10.1. Код создания модели SVR и ее экспорта в ONNX для float и double

2.2.10.2. Код на MQL5 для исполнения ONNX-моделей

2.2.10.3. ONNX-представление моделей svr_float.onnx и svr_double.onnx

- 2.3. Регрессионные модели библиотеки Scikit-learn, которые столкнулись с проблемами при конвертации в ONNX

- 2.3.1. sklearn.dummy.DummyRegressor

Код создания модели DummyRegressor - 2.3.2. sklearn.kernel_ridge.KernelRidge

Код создания модели KernelRidge - 2.3.3. sklearn.isotonic.IsotonicRegression

Код создания модели IsotonicRegression - 2.3.4. sklearn.cross_decomposition.PLSCanonical

Код создания модели PLSCanonical -

2.3.5. sklearn.cross_decomposition.CCA

Код создания модели CCA - Выводы

- Заключение

If it bothers you, welcome to contribute

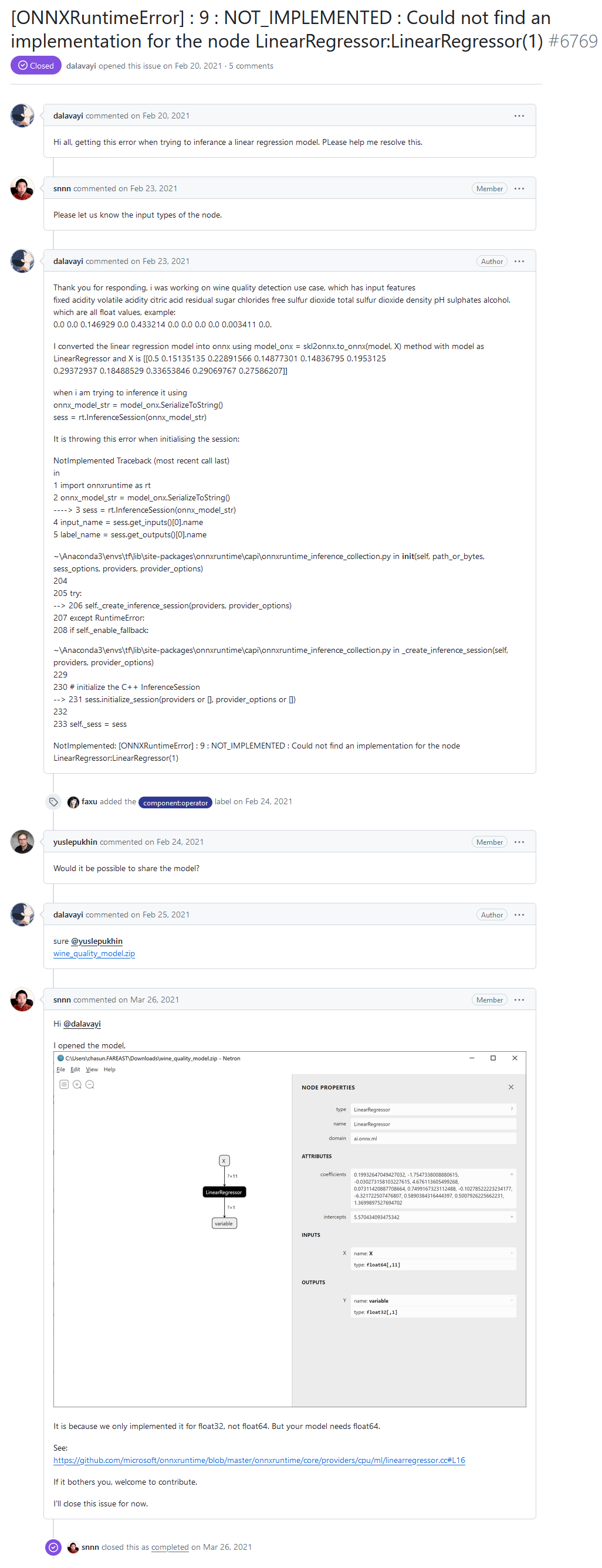

На форуме разработчиков ONNX Runtime один из пользователей сообщил о том, что при исполнении модели через ONNX Runtime он столкнулся с ошибкой "[ONNXRuntimeError] : 9 : NOT_IMPLEMENTED : Could not find an implementation for the node LinearRegressor:LinearRegressor(1)":

Hi all, getting this error when trying to inferance a linear regression model. PLease help me resolve this.

Сообщение об ошибке "NOT_IMPLEMENTED : Could not find an implementation for the node LinearRegressor:LinearRegressor(1)" с форума разработчиков ONNX Runtime

Ответ разработчика:

It is because we only implemented it for float32, not float64. But your model needs float64.

See:

https://github.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16

If it bothers you, welcome to contribute.

В ONNX-модели пользователя вызывается оператор ai.onnx.ml.LinearRegressor с double (float64), и сообщение об ошибке возникает из-за того, что в ONNX Runtime поддержка оператора LinearRegressor() с double не реализована.

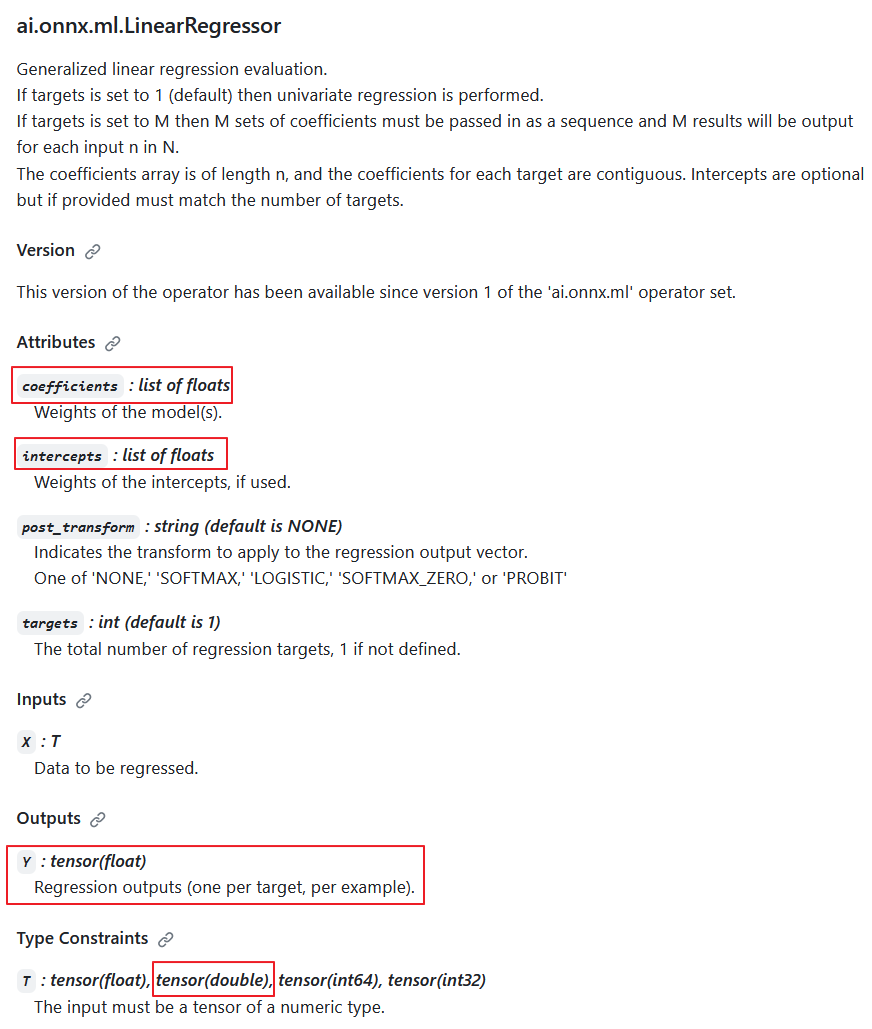

Согласно спецификации оператора ai.onnx.ml.LinearRegressor, входной тип данных double возможен (T: tensor(float), tensor(double), tensor(int64), tensor(int32)), однако разработчики сознательно отказались от его реализации.

Причина в том, что на выходе всегда возвращается значение Y : tensor(float). Более того, расчетные параметры задаются в числах float (coefficients : list of floats, intercepts : list of floats).

Получается, что при расчетах в double этот оператор понижает точность до float и его реализация в расчетах на double имеет сомнительную ценность.

Описание оператора ai.onnx.ml.LinearRegressor

Таким образом, понижение точности до float в параметрах и выходном значении делают невозможной полноценную работу ai.onnx.ml.LinearRegressor с числами double (float64). Вероятно, по этой причине разработчики ONNXRuntime решили отказаться от его реализации для типа double.

Способ "добавления поддержки double" разработчики показали в комментариях к коду (выделено желтым).

В ONNX Runtime его расчет производится при помощи класса LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.h).

Параметры оператора coefficients_ и intercepts_ храняться в виде std::vector<float>:

#pragma once #include "core/common/common.h" #include "core/framework/op_kernel.h" #include "core/util/math_cpuonly.h" #include "ml_common.h" namespace onnxruntime { namespace ml { class LinearRegressor final : public OpKernel { public: LinearRegressor(const OpKernelInfo& info); Status Compute(OpKernelContext* context) const override; private: int64_t num_targets_; std::vector<float> coefficients_; std::vector<float> intercepts_; bool use_intercepts_; POST_EVAL_TRANSFORM post_transform_; }; } // namespace ml } // namespace onnxruntimeРеализация расчета LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.cc)

// Copyright (c) Microsoft Corporation. All rights reserved. // Licensed under the MIT License. #include "core/providers/cpu/ml/linearregressor.h" #include "core/common/narrow.h" #include "core/providers/cpu/math/gemm.h" namespace onnxruntime { namespace ml { ONNX_CPU_OPERATOR_ML_KERNEL( LinearRegressor, 1, // KernelDefBuilder().TypeConstraint("T", std::vector<MLDataType>{ // DataTypeImpl::GetTensorType<float>(), // DataTypeImpl::GetTensorType<double>()}), KernelDefBuilder().TypeConstraint("T", DataTypeImpl::GetTensorType<float>()), LinearRegressor); LinearRegressor::LinearRegressor(const OpKernelInfo& info) : OpKernel(info), intercepts_(info.GetAttrsOrDefault<float>("intercepts")), post_transform_(MakeTransform(info.GetAttrOrDefault<std::string>("post_transform", "NONE"))) { ORT_ENFORCE(info.GetAttr<int64_t>("targets", &num_targets_).IsOK()); ORT_ENFORCE(info.GetAttrs<float>("coefficients", coefficients_).IsOK()); // use the intercepts_ if they're valid use_intercepts_ = intercepts_.size() == static_cast<size_t>(num_targets_); } // Use GEMM for the calculations, with broadcasting of intercepts // https://github.com/onnx/onnx/blob/main/docs/Operators.md#Gemm // // X: [num_batches, num_features] // coefficients_: [num_targets, num_features] // intercepts_: optional [num_targets]. // Output: X * coefficients_^T + intercepts_: [num_batches, num_targets] template <typename T> static Status ComputeImpl(const Tensor& input, ptrdiff_t num_batches, ptrdiff_t num_features, ptrdiff_t num_targets, const std::vector<float>& coefficients, const std::vector<float>* intercepts, Tensor& output, POST_EVAL_TRANSFORM post_transform, concurrency::ThreadPool* threadpool) { const T* input_data = input.Data<T>(); T* output_data = output.MutableData<T>(); if (intercepts != nullptr) { TensorShape intercepts_shape({num_targets}); onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, intercepts->data(), &intercepts_shape, output_data, threadpool); } else { onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, nullptr, nullptr, output_data, threadpool); } if (post_transform != POST_EVAL_TRANSFORM::NONE) { ml::batched_update_scores_inplace(gsl::make_span(output_data, SafeInt<size_t>(num_batches) * num_targets), num_batches, num_targets, post_transform, -1, false, threadpool); } return Status::OK(); } Status LinearRegressor::Compute(OpKernelContext* ctx) const { Status status = Status::OK(); const auto& X = *ctx->Input<Tensor>(0); const auto& input_shape = X.Shape(); if (input_shape.NumDimensions() > 2) { return ORT_MAKE_STATUS(ONNXRUNTIME, INVALID_ARGUMENT, "Input shape had more than 2 dimension. Dims=", input_shape.NumDimensions()); } ptrdiff_t num_batches = input_shape.NumDimensions() <= 1 ? 1 : narrow<ptrdiff_t>(input_shape[0]); ptrdiff_t num_features = input_shape.NumDimensions() <= 1 ? narrow<ptrdiff_t>(input_shape.Size()) : narrow<ptrdiff_t>(input_shape[1]); Tensor& Y = *ctx->Output(0, {num_batches, num_targets_}); concurrency::ThreadPool* tp = ctx->GetOperatorThreadPool(); auto element_type = X.GetElementType(); switch (element_type) { case ONNX_NAMESPACE::TensorProto_DataType_FLOAT: { status = ComputeImpl<float>(X, num_batches, num_features, narrow<ptrdiff_t>(num_targets_), coefficients_, use_intercepts_ ? &intercepts_ : nullptr, Y, post_transform_, tp); break; } case ONNX_NAMESPACE::TensorProto_DataType_DOUBLE: { // TODO: Add support for 'double' to the scoring functions in ml_common.h // once that is done we can just call ComputeImpl<double>... // Alternatively we could cast the input to float. } default: status = ORT_MAKE_STATUS(ONNXRUNTIME, FAIL, "Unsupported data type of ", element_type); } return status; } } // namespace ml } // namespace onnxruntime

Получается, что есть вариант использовать числа double как входные значения и расчет оператора производить c float параметрами. Также можно было бы понизить точность входных данных до float. Однако все эти варианты нельзя считать нормальным решением.

Спецификация оператора ai.onnx.ml.LinearRegressor ограничивает возможность полноценной работы с числами double, поскольку параметры и выходное значение ограничены типом float.

Аналогичная ситуация и с другими ML-операторами ONNX, например ai.onnx.ml.SVMRegressor и ai.onnx.ml.TreeEnsembleRegressor.

Таким образом, все разработчики сред исполнения ONNX-моделей в double сталкиваются с этим ограничением спецификации. Вариантом решения может быть расширение спецификации ONNX (или добавление аналогичных операторов LinearRegressor64, SVMRegressor64 и TreeEnsembleRegressor64 с параметрами и выходными значениями double), однако пока эта проблема остается нерешенной.

Здесь многое зависит от конвертера в ONNX, для моделей с расчетом в double лучше отказаться от использования этих операторов (однако это возможно не всегда), в данном случае с моделью пользователя конвертер в ONNX сработал не лучшим образом.

Как мы увидим далее, конвертеру sklearn-onnx удается обойти ограничение LinearRegressor: для ONNX-моделей double вместо него используются ONNX-операторы MatMul() и Add(). Благодаря такому способу множество регрессионных моделей библиотеки Scikit-learn удается успешно конвертировать в ONNX-модели с расчетом в double, и эти модели показывают сохранение точности оригинальных моделей в double.

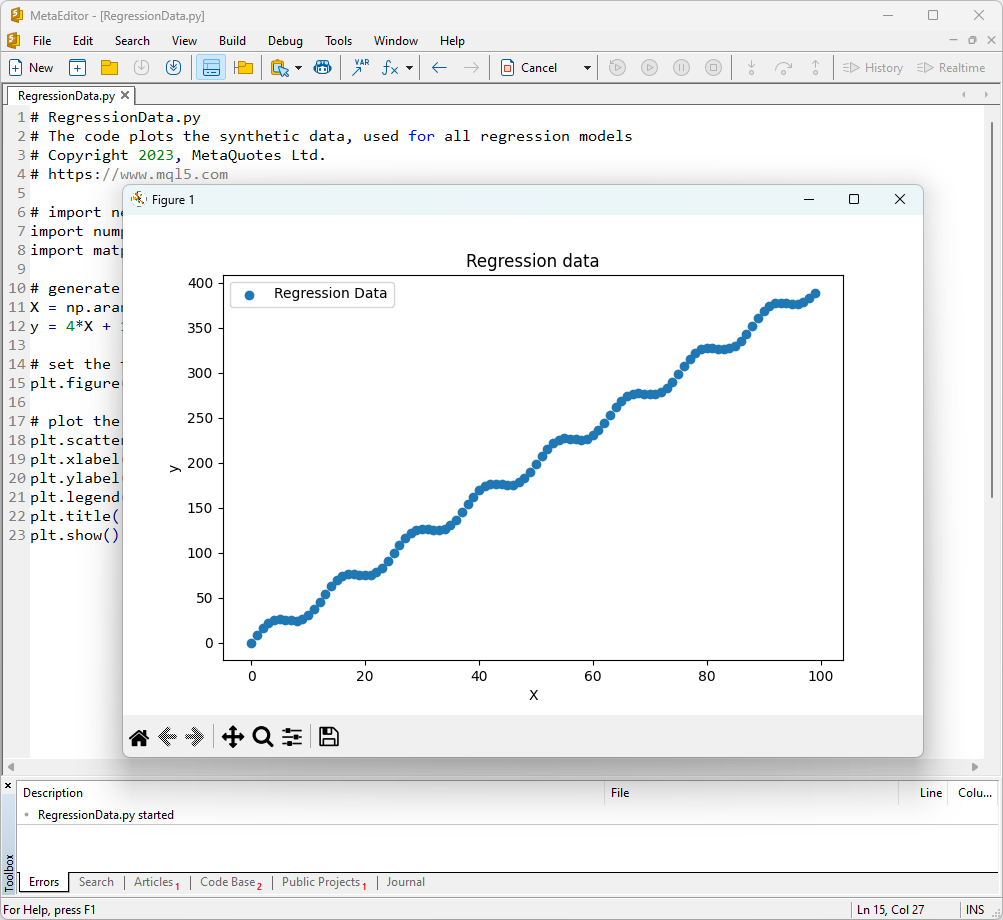

1. Тестовый набор данных

Для запуска примеров понадобится установить Python (мы использовали версию 3.10.8), дополнительные библиотеки (pip install -U scikit-learn numpy matplotlib onnx onnxruntime skl2onnx) и указать путь к Python в редакторе MetaEditor (в меню Tools->Options->Compilers->Python).

В качестве тестового набора данных будем использовать сгенерированные значения функции y = 4*X + 10*sin(X*0.5).

Для отображения графика подобной функции откроем MetaEditor, создадим файл RegressionData.py, скопируем текст скрипта и запустим его, нажав на кнопку "Compile".

Скрипт отображения тестового набора данных

# RegressionData.py # The code plots the synthetic data, used for all regression models # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # import necessary libraries import numpy as np import matplotlib.pyplot as plt # generate synthetic data for regression X = np.arange(0,100,1).reshape(-1,1) y = 4*X + 10*np.sin(X*0.5) # set the figure size plt.figure(figsize=(8,5)) # plot the initial data for regression plt.scatter(X, y, label='Regression Data', marker='o') plt.xlabel('X') plt.ylabel('y') plt.legend() plt.title('Regression data') plt.show()

В результате будет выведен график функции, которую мы будем использовать для проверки методов регрессии.

Рис.1. Функция для тестирования методов регрессии

2. Модели регрессии

Цель задачи регрессии заключается в поиске такой математической функции или модели, которая наилучшим образом описывает зависимость между признаками и целевой переменной, чтобы предсказать числовое значение для новых данных. Это позволяет сделать прогнозы, оптимизировать решения и принимать информированные решения на основе данных.

Рассмотрим основные модели регресии пакета scikit-learn.

2.0. Список моделей регрессии пакета Scikit-learn

Для вывода списка доступных моделей регрессии Scikit-learn можно использовать скрипт:

# ScikitLearnRegressors.py # The script lists all the regression algorithms available inb scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn regression models from sklearn.utils import all_estimators regressors = all_estimators(type_filter='regressor') for index, (name, RegressorClass) in enumerate(regressors, start=1): print(f"Regressor {index}: {name}")

Результат:

The scikit-learn version is 1.3.2.

Regressor 1: ARDRegression

Regressor 2: AdaBoostRegressor

Regressor 3: BaggingRegressor

Regressor 4: BayesianRidge

Regressor 5: CCA

Regressor 6: DecisionTreeRegressor

Regressor 7: DummyRegressor

Regressor 8: ElasticNet

Regressor 9: ElasticNetCV

Regressor 10: ExtraTreeRegressor

Regressor 11: ExtraTreesRegressor

Regressor 12: GammaRegressor

Regressor 13: GaussianProcessRegressor

Regressor 14: GradientBoostingRegressor

Regressor 15: HistGradientBoostingRegressor

Regressor 16: HuberRegressor

Regressor 17: IsotonicRegression

Regressor 18: KNeighborsRegressor

Regressor 19: KernelRidge

Regressor 20: Lars

Regressor 21: LarsCV

Regressor 22: Lasso

Regressor 23: LassoCV

Regressor 24: LassoLars

Regressor 25: LassoLarsCV

Regressor 26: LassoLarsIC

Regressor 27: LinearRegression

Regressor 28: LinearSVR

Regressor 29: MLPRegressor

Regressor 30: MultiOutputRegressor

Regressor 31: MultiTaskElasticNet

Regressor 32: MultiTaskElasticNetCV

Regressor 33: MultiTaskLasso

Regressor 34: MultiTaskLassoCV

Regressor 35: NuSVR

Regressor 36: OrthogonalMatchingPursuit

Regressor 37: OrthogonalMatchingPursuitCV

Regressor 38: PLSCanonical

Regressor 39: PLSRegression

Regressor 40: PassiveAggressiveRegressor

Regressor 41: PoissonRegressor

Regressor 42: QuantileRegressor

Regressor 43: RANSACRegressor

Regressor 44: RadiusNeighborsRegressor

Regressor 45: RandomForestRegressor

Regressor 46: RegressorChain

Regressor 47: Ridge

Regressor 48: RidgeCV

Regressor 49: SGDRegressor

Regressor 50: SVR

Regressor 51: StackingRegressor

Regressor 52: TheilSenRegressor

Regressor 53: TransformedTargetRegressor

Regressor 54: TweedieRegressor

Regressor 55: VotingRegressor

Для удобства в этом списке моделей регрессии они выделены разными цветами. Модели, которые требуют базовых моделей, выделены серым цветом, в то время как остальные модели могут использоваться самостоятельно. Отметим, что зеленым цветом отмечены модели, которые удалось успешно экспортировать в формат ONNX, красным цветом отмечены модели, при конвертации которых в текущей версии scikit-learn 1.2.2 возникают ошибки. Синим цветом выделены методы, которые не подходят для рассматриваемой нами тестовой задачи.

Для анализа качества моделей используются метрики регрессии, это функции от истинных и предсказанных значений. В языке MQL5 доступно несколько различных метрик, подробнее о них в статье "Оценка ONNX-моделей при помощи регрессионных метрик".

В этой статье для сравнения качества различных моделей будут использоваться 3 метрики:

- Коэффициент детерминации R-квадрат (R-squared, R2);

- Средняя абсолютная ошибка (Mean Absolute Error, MAE);

- Среднеквадратичная ошибка (Mean Squared Error, MSE).

2.1. Регрессионные модели библиотеки Scikit-learn, которые конвертируются в ONNX-модели float и double

В этом разделе приводятся модели регрессии, которые успешно конвертируются в ONNX в форматах float и double.

Все рассматриваемые далее регрессионные модели приведены в виде:

- Описание модели, принцип работы, преимущества и ограничения

- Скрипт на Python для создания модели, ее экспорта в ONNX-файлы в форматах float и double, и исполнения полученных моделей через ONNX Runtime в Python. Для оценки качества оригинальной и ONNX-моделей используются метрики R^2, MAE, MSE, рассчитываемые при помощи sklearn.metrics.

- Скрипт MQL5 для исполнения ONNX-моделей (float и double) через ONNX Runtime, метрики рассчитываются через RegressionMetric().

- ONNX-представление моделей в Netron для float и double.

2.1.1. sklearn.linear_model.ARDRegression

ARDRegression (Automatic Relevance Determination Regression) - это метод регрессии, который предназначен для решения задачи регрессии, при этом автоматически определяет важность (релевантность) признаков и устанавливает их веса в процессе обучения модели.

ARDRegression позволяет обнаруживать и использовать только наиболее важные признаки для построения регрессионной модели, что может быть полезным в случаях, когда имеется большое количество признаков.

Принцип работы ARDRegression:

- Линейная регрессия: ARDRegression основана на линейной регрессии, где предполагается линейная зависимость между независимыми переменными (признаками) и целевой переменной.

- Автоматическое определение важности признаков: Основное отличие ARDRegression заключается в том, что он автоматически определяет, какие признаки наиболее важны для предсказания целевой переменной. Это достигается путем введения априорных распределений (регуляризации) над весами которые позволяют модели автоматически установить нулевые веса для малозначимых признаков.

- Оценка апостериорных вероятностей: ARDRegression вычисляет апостериорные вероятности для каждого признака, что позволяет определить их важность. Признаки с высокими апостериорными вероятностями считаются релевантными и получают ненулевые веса, в то время как признаки с низкими апостериорными вероятностями получают нулевые веса.

- Снижение размерности: Таким образом, ARDRegression может привести к снижению размерности данных, удаляя незначимые признаки.

Преимущества ARDRegression:

- Автоматическое определение важных признаков: Метод автоматически определяет и использует только наиболее важные признаки, что может улучшить производительность модели и снизить риск переобучения.

- Устойчивость к мультиколлинеарности: ARDRegression хорошо справляется с мультиколлинеарностью, когда признаки сильно коррелированы между собой.

Ограничения ARDRegression:

- Требует выбора априорных распределений: Выбор подходящих априорных распределений может потребовать экспериментов.

- Вычислительная сложность: Обучение ARDRegression может быть вычислительно затратным, особенно для больших наборов данных.

ARDRegression - это метод регрессии, который автоматически определяет важность признаков и устанавливает их веса на основе апостериорных вероятностей. Этот метод полезен, когда требуется учитывать только важные признаки для построения регрессионной модели и снижения размерности данных.

2.1.1.1. Код создания модели ARDRegression и ее экспорта в ONNX для float и double

Этот код создает модель sklearn.linear_model.ARDRegression, обучает ее на синтетических данных, сохраняет модель в формате ONNX и выполняет предсказания с использованием как float, так и double входных данных. Также он оценивает точность как исходной модели, так и моделей, экспортированных в ONNX.

# The code demonstrates the process of training ARDRegressor model, exporting it to ONNX format (both float and double), and making predictions using the ONNX models.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# function to compare matching decimal places

def compare_decimal_places(value1, value2):

# convert both values to strings

str_value1 = str(value1)

str_value2 = str(value2)

# find the positions of the decimal points in the strings

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# if one of the values doesn't have a decimal point, return 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calculate the number of decimal places

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# find the minimum of the two decimal places counts

min_decimal_places = min(decimal_places1, decimal_places2)

# initialize a count for matching decimal places

matching_count = 0

# compare characters after the decimal point

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ARDRegression

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# define the path for saving the model

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generate synthetic data for regression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name="ARDRegression"

onnx_model_filename = data_path + "ard_regression"

# create an ARDRegression model

regression_model = ARDRegression()

# fit the model to the data

regression_model.fit(X, y.ravel())

# predict values for the entire dataset

y_pred = regression_model.predict(X)

# evaluate the model's performance

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convert to ONNX-model (float)

# define the input data type as FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as FloatTensorType

initial_type_float = X.astype(np.float32)

# predict values for the entire dataset using ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# set the figure size

plt.figure(figsize=(8, 5))

# plot the original data and the regression data

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convert to ONNX-model (double)

# define the input data type as DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as DoubleTensorType

initial_type_double = X.astype(np.float64)

# predict values for the entire dataset using ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# set the figure size

plt.figure(figsize=(8, 5))

# plot the original data and the regression line

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

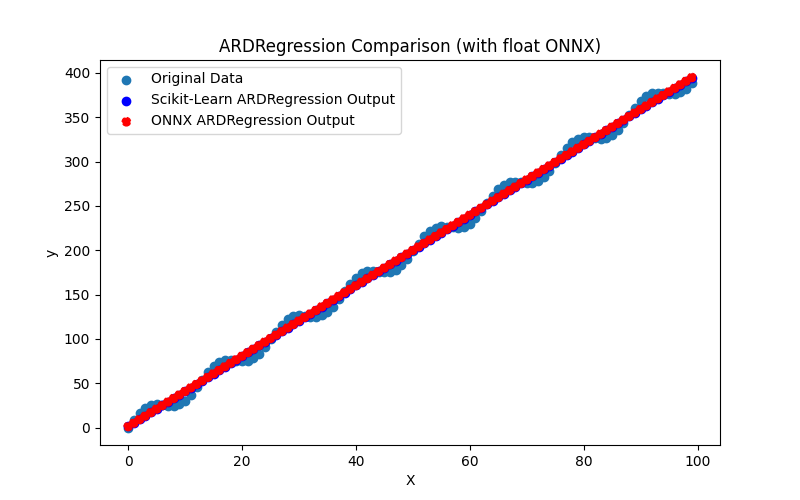

Скрипт создает и обучает модель sklearn.linear_model.ARDRegression (оригинальная модель считается в double), затем производится экспорт модели в ONNX для float и double (ard_regression_float.onnx и ard_regression_double.onnx) и сравнивается точность ее работы.

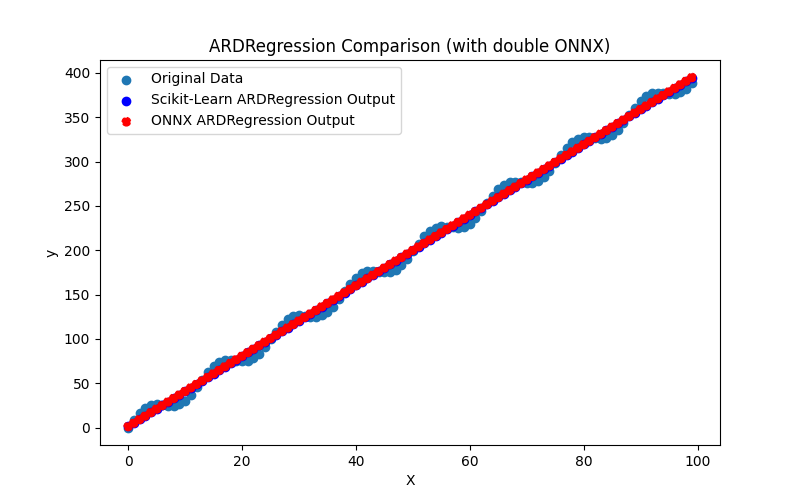

Он также создает файлы ARDRegression_plot_float.png и ARDRegression_plot_double.png, позволяющие визуально оценить результаты работы ONNX-моделей для float и double (рис. 2-3).

Рис.2. Результат работы скрипта ARDRegression.py (float)

Рис.3. Результат работы скрипта ARDRegression.py (double)

Визуально ONNX-модели для float и double выглядят одинаково (рис.2-3), во вкладке Journal можно посмотреть детали:

Python ARDRegression Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python Python ARDRegression ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python ONNX: MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python ARDRegression ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

В данном примере оригинальная модель считалась в double, затем она была экспортирована в ONNX-модели ard_regression_float.onnx и ard_regression_double.onnx для float и double соответственно.

Если точность модели оценивать по порядку средней абсолютной ошибки (Mean Absolute Error), то точность ONNX-модели для float составляет не более 6 знаков после запятой, ONNX-модель с использованием double показала сохранение точности в 15 знаков после запятой в соответствии с точностью оригинальной модели.

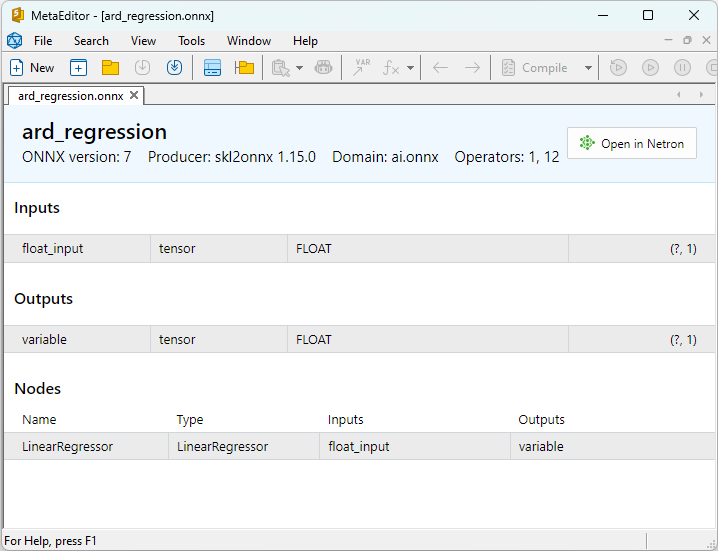

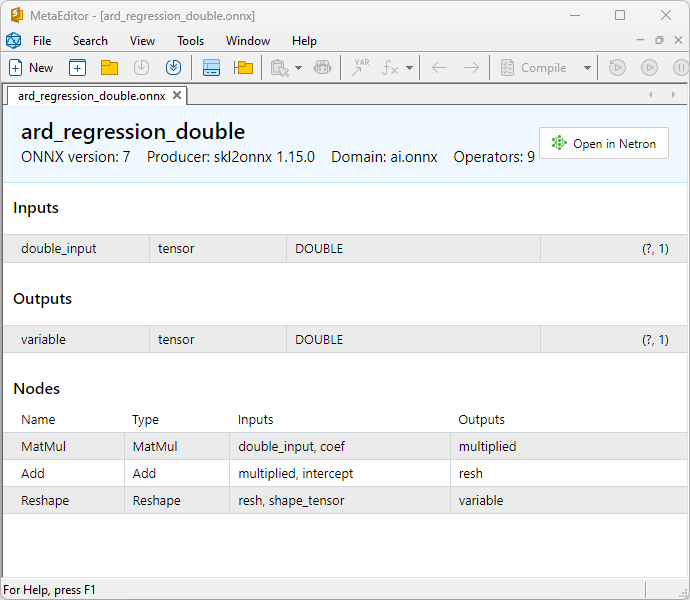

Свойства ONNX-моделей можно посмотреть в MetaEditor (рис.4-5).

Рис.4. ONNX-модель ard_regression_float.onnx в MetaEditor

Рис.5. ONNX-модель ard_regression_double.onnx в MetaEditor

Сравнение float и double ONNX-моделей показывает, что в данном случае расчет ONNX-моделей ARDRegression происходит по-разному: для чисел float используется оператор LinearRegressor() из ONNX-ML, для чисел double используются ONNX-операторы MatMul(), Add() и Reshape().

Реализация модели в ONNX зависит от конвертера, в примерах для экспорта в ONNX будет использоваться функция skl2onnx.convert_sklearn() библиотеки skl2onnx.

2.1.1.2. Код на MQL5 для исполнения ONNX-моделей

Этот код исполняет сохраненные ONNX-модели ard_regression_float.onnx и ard_regression_double.onnx и демонстрирует использование регрессионных метрик в MQL5.

//+------------------------------------------------------------------+ //| ARDRegression.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "ARDRegression" #define ONNXFilenameFloat "ard_regression_float.onnx" #define ONNXFilenameDouble "ard_regression_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Результат:

ARDRegression (EURUSD,H1) Testing ONNX float: ARDRegression (ard_regression_float.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 ARDRegression (EURUSD,H1) ARDRegression (EURUSD,H1) Testing ONNX double: ARDRegression (ard_regression_double.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537597 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128795

Сравнение с оргинальной моделью double в Python:

Testing ONNX float: ARDRegression (ard_regression_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: ARDRegression (ard_regression_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537597

Точность MAE ONNX float: 6 знаков после запятой, точность MAE ONNX double 14 знаков после запятой.

2.1.1.3. ONNX-представление моделей ard_regression_float.onnx и ard_regression_double.onnx

Netron (web-версия) - это инструмент для визуализации моделей и анализа графов вычислений, который может использоваться для моделей формата ONNX (Open Neural Network Exchange).

Netron представляет графы моделей и их архитектуру в наглядной и интерактивной форме, позволяя исследовать структуру и параметры моделей глубокого обучения, включая модели, созданные с использованием ONNX.

Основные возможности Netron включают:

- Визуализацию графов: Netron отображает архитектуру модели в виде графа, позволяя вам видеть слои, операции и связи между ними. Вы можете легко понять структуру и поток данных внутри модели.

- Интерактивное исследование: Вы можете выбирать узлы в графе, чтобы получить дополнительную информацию о каждом операторе и его параметрах.

- Поддержка различных форматов: Netron поддерживает множество форматов моделей глубокого обучения, включая ONNX, TensorFlow, PyTorch, CoreML и другие.

- Возможность анализа параметров: Вы можете просматривать параметры и веса модели, что полезно для понимания, какие значения используются в различных частях модели.

Netron удобен для разработчиков и исследователей в области машинного обучения и глубокого обучения, так как он облегчает визуализацию и анализ моделей, что помогает в понимании и отладке сложных нейронных сетей.

Этот инструмент позволяет быстро посмотреть модели, исследовать их структуру и параметры, что упрощает работу с глубокими нейронными сетями.

Подробнее про Netron в статьях: Visualizing your Neural Network with Netron и Visualize Keras Neural Networks with Netron.

Видео про Netron:

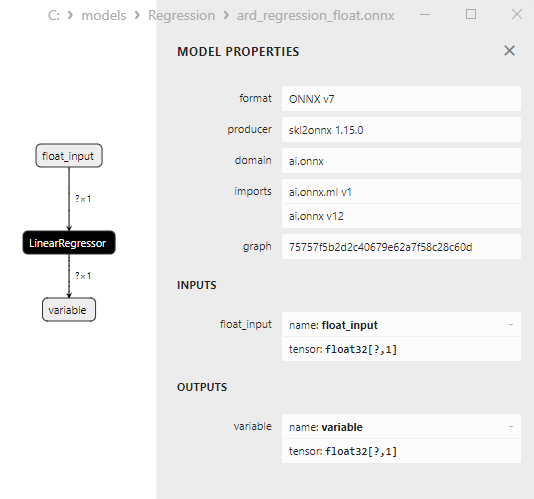

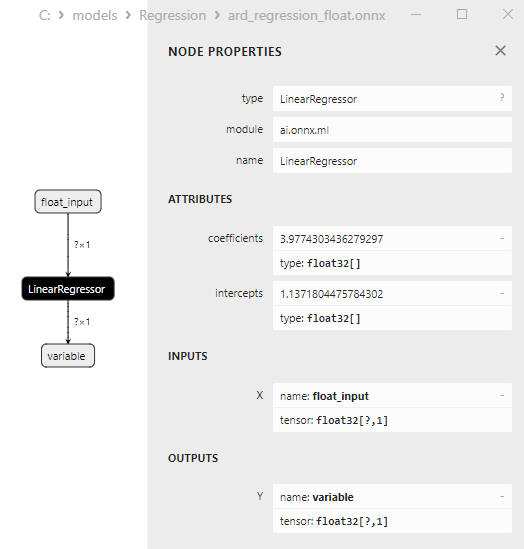

ONNX-модель ard_regression_float.onnx представлена на рис.6:

Рис.6. ONNX-представление модели ard_regression_float.onnx в Netron

ONNX-оператор ai.onnx.ml LinearRegressor() представляет собой часть стандарта ONNX, который описывает модель для задачи регрессии. Этот оператор применяется для выполнения регрессии, то есть предсказания числовых значений (непрерывных) на основе входных признаков.

Он принимает на вход параметры модели, такие как веса и смещение, а также входные признаки, и выполняет линейную регрессию. Линейная регрессия оценивает параметры (веса) для каждого входного признака и затем выполняет линейную комбинацию этих признаков с весами для получения предсказания.

Этот оператор выполняет следующие шаги:

- Принимает веса и смещение модели, а также входные признаки.

- Для каждого примера входных данных выполняет линейную комбинацию весов с соответствующими признаками.

- Добавляет смещение к полученному значению.

Результат представляет собой прогноз целевой переменной в задаче регрессии.

Параметры оператора LinearRegressor() представлены на рис.7.

Рис.7. Свойства оператора LinearRegressor() модели ard_regression_float.onnx в Netron

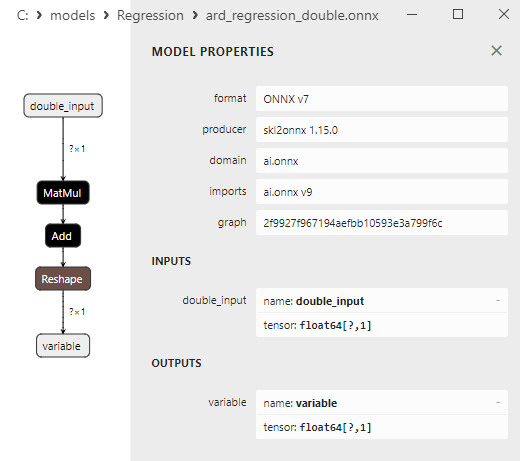

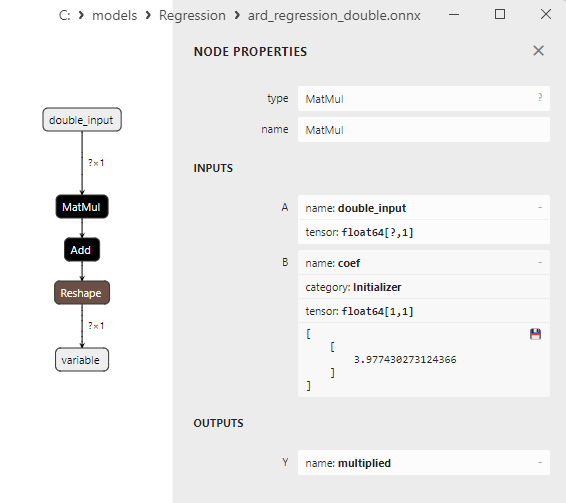

Рис.8. ONNX-представление модели ard_regression_double.onnx в Netron

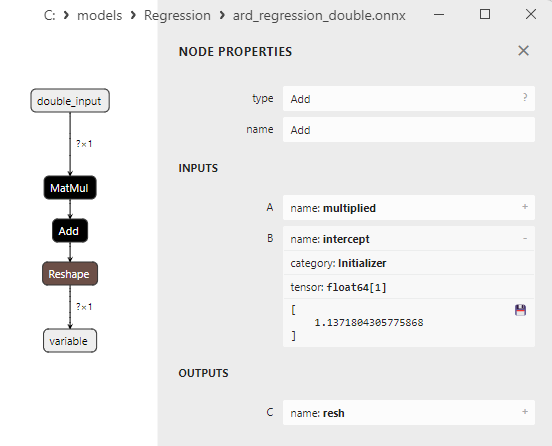

Параметры ONNX-операторов MatMul(), Add() и Reshape() приведены на рис.9-11.

Рис.9. Свойства оператора MatMul модели ard_regression_double.onnx в Netron

ONNX-оператор MatMul (матричное умножение) выполняет умножение двух матриц.

Он принимает два входа: две матрицы и возвращает их матричное произведение.

Если у вас есть две матрицы A и B, то результат Matmul(A, B) - это матрица C, где каждый элемент C[i][j] вычисляется как сумма произведений элементов строки i матрицы A на элементы столбца j матрицы B.

Рис.10. Свойства оператора Add модели ard_regression_double.onnx в Netron

ONNX-оператор Add (сложение) выполняет покомпонентное сложение двух тензоров или массивов одинаковой формы.

Он принимает два входа и возвращает результат, где каждый элемент результирующего тензора равен сумме соответствующих элементов входных тензоров.

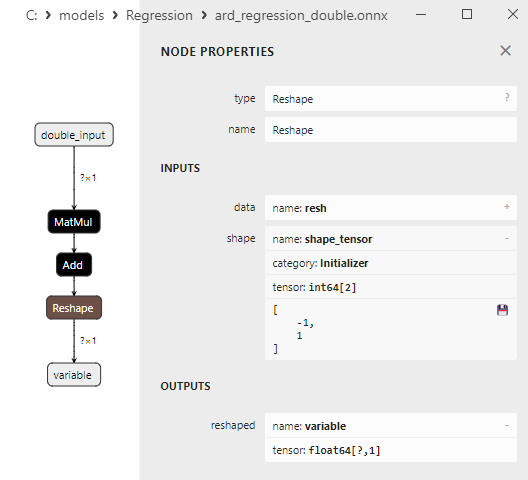

Рис.11. Свойства оператора Reshape модели ard_regression_double.onnx в Netron

ONNX-оператор Reshape(-1,1) используется для изменения формы (или размерности) входных данных. В этом операторе значение -1 для размерности означает, что размер данной размерности должен быть автоматически вычислен на основе остальных размерностей, чтобы обеспечить согласованность данных.

Значение 1 второй размерности указывает, что после преобразования формы каждый элемент будет иметь одну единственную подразмерность.

2.1.2. sklearn.linear_model.BayesianRidge

BayesianRidge - это метод регрессии, который использует байесовский подход для оценки параметров модели. Этот метод позволяет моделировать априорное распределение параметров и обновлять его с учетом данных, чтобы получить апостериорное распределение параметров.

BayesianRidge представляет собой байесовский метод регрессии, предназначенный для предсказания зависимой переменной на основе одной или нескольких независимых переменных.

Принцип работы BayesianRidge:

- Априорное распределение параметров: Начинается с определения априорного распределения параметров модели. Это распределение представляет собой априорные знания или предположения о параметрах модели до учета данных. В случае BayesianRidge используются априорные распределения с Гауссовской формой.

- Обновление распределения параметров: После того как априорное распределение параметров задано, оно обновляется на основе данных. Это делается с использованием метода байесовской теории, где апостериорное распределение параметров вычисляется с учетом данных. Важным аспектом является оценка гиперпараметров, которые влияют на форму апостериорного распределения.

- Предсказание: После оценки апостериорного распределения параметров, можно делать предсказания для новых наблюдений. В результате получается распределение прогнозов, а не просто одно точечное значение, что позволяет учесть неопределенность в предсказаниях.

Преимущества BayesianRidge:

- Учет неопределенности: BayesianRidge позволяет учитывать неопределенность в параметрах и предсказаниях модели. Вместо точечных прогнозов предоставляются доверительные интервалы.

- Регуляризация: Байесовский метод регрессии может быть полезен для регуляризации моделей, что помогает предотвратить переобучение.

- Автоматический отбор признаков: BayesianRidge может автоматически определять важность признаков, уменьшая веса незначительных признаков.

Ограничения BayesianRidge:

- Вычислительная сложность: Метод требует вычислительных ресурсов для оценки параметров и вычисления апостериорного распределения.

- Высокий уровень абстракции: Для понимания и использования BayesianRidge может потребоваться более глубокое понимание байесовской статистики.

- Не всегда наилучший выбор: BayesianRidge может быть не самым подходящим методом в некоторых задачах регрессии, особенно если данных мало.

BayesianRidge полезен в задачах регрессии, где неопределенность параметров и предсказаний важна, и в случаях, когда требуется регуляризация модели.

2.1.2.1. Код создания модели BayesianRidge и ее экспорта в ONNX для float и double

Этот код создает модель sklearn.linear_model.BayesianRidge, обучает ее на синтетических данных, сохраняет модель в формате ONNX и выполняет предсказания с использованием как float, так и double входных данных. Также он оценивает точность как исходной модели, так и моделей, экспортированных в ONNX.

# The code demonstrates the process of training BayesianRidge model, exporting it to ONNX format (both float and double), and making predictions using the ONNX models.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# function to compare matching decimal places

def compare_decimal_places(value1, value2):

# convert both values to strings

str_value1 = str(value1)

str_value2 = str(value2)

# find the positions of the decimal points in the strings

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# if one of the values doesn't have a decimal point, return 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calculate the number of decimal places

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# find the minimum of the two decimal places counts

min_decimal_places = min(decimal_places1, decimal_places2)

# initialize a count for matching decimal places

matching_count = 0

# compare characters after the decimal point

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# import necessary libraries

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import BayesianRidge

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# define the path for saving the model

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# generate synthetic data for regression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name = "BayesianRidge"

onnx_model_filename = data_path + "bayesian_ridge"

# create a Bayesian Ridge regression model

regression_model = BayesianRidge()

# fit the model to the data

regression_model.fit(X, y.ravel())

# predict values for the entire dataset

y_pred = regression_model.predict(X)

# evaluate the model's performance

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convert to ONNX-model (float)

# define the input data type as FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as FloatTensorType

initial_type_float = X.astype(np.float32)

# predict values for the entire dataset using ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# set the figure size

plt.figure(figsize=(8,5))

# plot the original data and the regression data

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convert to ONNX-model (double)

# define the input data type as DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# export the model to ONNX format

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# save the model to a file

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# print model path

print(f"ONNX model saved to {onnx_filename}")

# load the ONNX model and make predictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# display information about input tensors in ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# display information about output tensors in ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# define the input data type as DoubleTensorType

initial_type_double = X.astype(np.float64)

# predict values for the entire dataset using ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calculate and display the errors for the original and ONNX models

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# set the figure size

plt.figure(figsize=(8,5))

# plot the original data and the regression line

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

Результат:

Python BayesianRidge Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python Python BayesianRidge ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python BayesianRidge ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

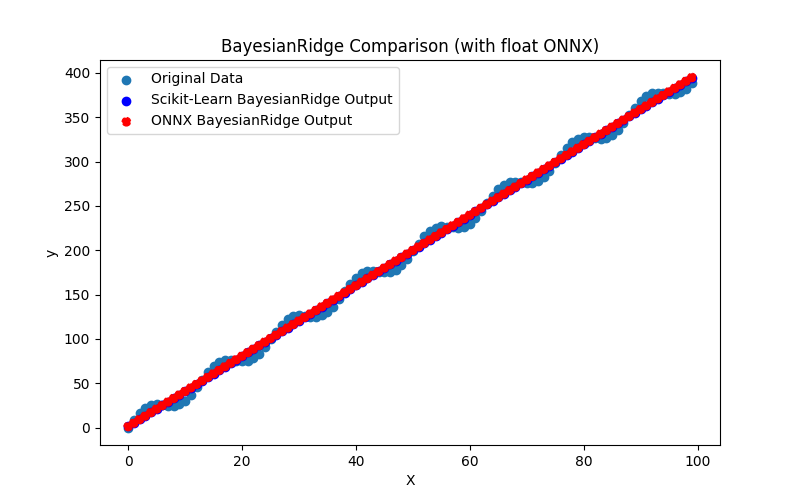

Рис.12. Результат работы скрипта BayesianRidge.py (float ONNX)

2.1.2.2. Код на MQL5 для исполнения ONNX-моделей

Этот код исполняет сохраненные ONNX-модели bayesian_ridge_float.onnx и bayesian_ridge_double.onnx и демонстрирует использование регрессионных метрик в MQL5.

//+------------------------------------------------------------------+ //| BayesianRidge.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "BayesianRidge" #define ONNXFilenameFloat "bayesian_ridge_float.onnx" #define ONNXFilenameDouble "bayesian_ridge_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Результат:

BayesianRidge (EURUSD,H1) Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 BayesianRidge (EURUSD,H1) BayesianRidge (EURUSD,H1) Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537624 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128866

Сравнение с оригинальной моделью:

Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537624

Точность MAE ONNX float: 6 знаков после запятой, точность MAE ONNX double 13 знаков после запятой.

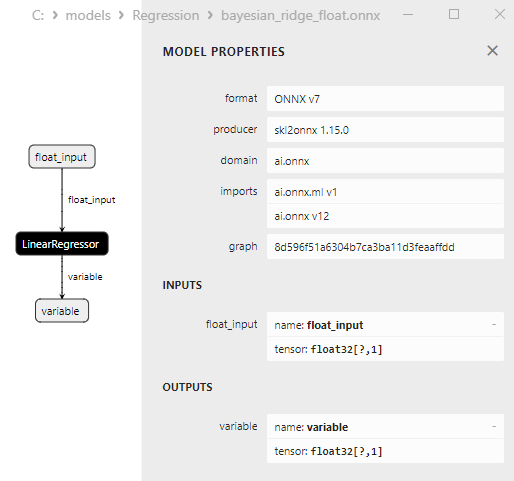

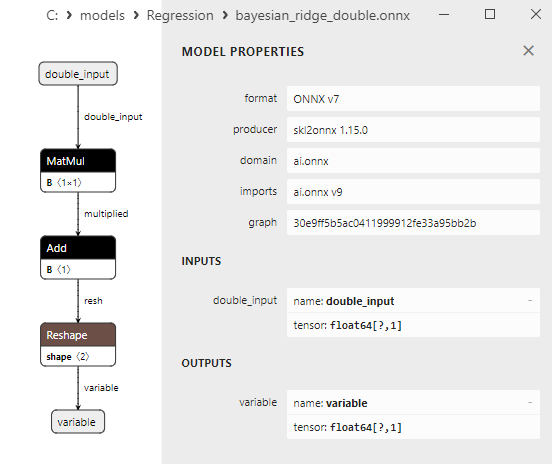

2.1.2.3. ONNX-представление моделей bayesian_ridge_float.onnx и bayesian_ridge_double.onnx

Рис.13. ONNX-представление модели bayesian_ridge_float.onnx в Netron

Рис.14. ONNX-представление модели bayesian_ridge_double.onnx в Netron

Примечание к методам ElasticNet и ElasticNetCV

ElasticNet и ElasticNetCV - это два связанных метода в машинном обучении, используемые для регуляризации моделей регрессии, особенно линейной регрессии. Они имеют общий функционал, но есть различия в способе использования и применения.

ElasticNet (Elastic Net Regression):

- Принцип работы: ElasticNet - это метод регрессии, который объединяет в себе регуляризацию Лассо (L1-регуляризация) и регуляризацию Риджа (L2-регуляризация). Он добавляет к функции потерь два компонента регуляризации: один, который штрафует модель за большие абсолютные значения коэффициентов (как Лассо), и другой, который штрафует модель за большие квадраты коэффициентов (как Ридж).

- Преимущества: ElasticNet обычно используется, когда в данных присутствует мультиколлинеарность (когда признаки сильно коррелированы) и когда необходимо сокращение размерности, а также контроль над значениями коэффициентов.

ElasticNetCV (Elastic Net Cross-Validation):

- Принцип работы: ElasticNetCV - это расширение ElasticNet, которое включает в себя автоматический подбор оптимальных гиперпараметров альфа (коэффициент смешивания между L1 и L2 регуляризацией) и лямбда (сила регуляризации) с использованием кросс-валидации. Он выполняет перебор различных значений альфа и лямбда и выбирает комбинацию, которая дает наилучшую производительность на кросс-валидации.

- Преимущества: ElasticNetCV автоматически настраивает параметры модели на основе кросс-валидации, что позволяет выбрать оптимальные значения гиперпараметров без необходимости ручной настройки. Это делает его более удобным для использования и помогает предотвратить переобучение модели.

Итак, основное отличие между ElasticNet и ElasticNetCV заключается в том, что ElasticNet - это сам метод регрессии, который применяется к данным, а ElasticNetCV - это инструмент, который автоматически находит оптимальные значения гиперпараметров для модели ElasticNet с использованием кросс-валидации. ElasticNetCV полезен, когда вам нужно найти лучшие параметры модели и сделать процесс настройки более автоматизированным.

2.1.3. sklearn.linear_model.ElasticNet